MiniMax-M2.1は実務で使えるのか?マルチ言語対応LLMを実装・検証して分かったこと

- マルチプログラミング言語対応を前提にした設計で実務の複雑な開発環境に適応

- 長文かつ多段階タスクへの強さにより業務フロー全体を支援可能

- 開発用途とオフィス業務を両立できる汎用性の高いモデル特性

2025年12月、新たなLLMがリリースされました!

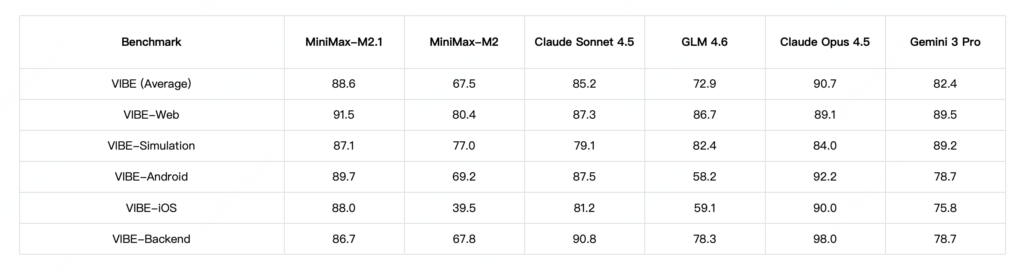

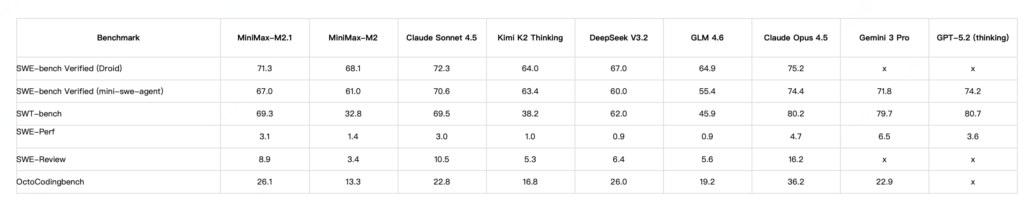

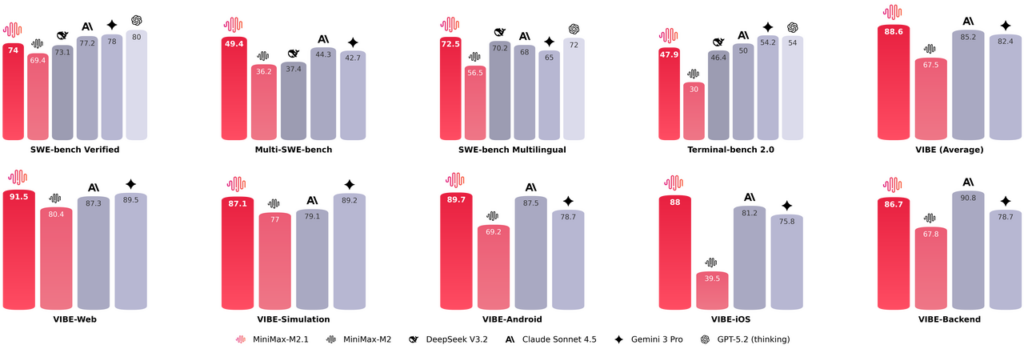

今回リリースされた「MiniMax-M2.1」は複数のプログラミング言語に対応しており、複雑な開発にも対応します。多言語環境では優れた性能を発揮し、Claude Sonnet 4.5を上回り、Claude Opus 4.5に迫るパフォーマンスを発揮。

本記事ではMiniMax-M2.1の概要から仕組み、実際の実装方法について解説をします。

本記事を最後までお読みいただければ理解が深まり、ご自身の開発環境でもMiniMax-M2.1を使うことができます。ぜひ最後までお読みください!

\生成AIを活用して業務プロセスを自動化/

MiniMax M2.1の概要

MiniMax M2.1は、複雑なタスクに向けて性能を強化したモデルアップデートです。

M2ではコストやアクセシビリティに焦点を当てていたのに対し、MiniMax M2.1は「実務で使える」方向へアップデートされています。特に、より多くのプログラミング言語とオフィスシナリオでの使いやすさが焦点。

アップデート内で挙げられているのは、Python偏重になりがちな課題への対応であり、Rust、Java、Golang、C++、Kotlin、Objective-C、TypeScript、JavaScriptなどを含むマルチ言語環境での性能を高めています。※1

また、Web/Appシナリオではデザイン理解や美的表現も含めた改善がされています。

MiniMax M2.1の仕組み

ここでは、MiniMax M2.1がどのような考え方で設計され、入力から出力までを処理しているのかを解説します。

MiniMax M2.1は「実務での複雑な指示を破綻なく処理する」をテーマとしており、大規模言語モデルを基盤としつつ、複数のプログラミング言語や業務文脈を同時に扱う前提で設計。

単一言語に最適化するのではなく、Python、Java、Rust、Golangなど異なる言語特性を横断的に理解できるよう最適化が行われました。この設計により、言語ごとの文法差異や慣習を踏まえた対応が可能です。

また、コード生成だけでなく、仕様理解や制約条件の整理も含めて一連の処理として扱います。処理フローとしては、まずユーザー入力を解析し、タスクの種類や必要な言語要素を内部的に整理。

その上で、複数の制約や条件を統合しながら回答を生成する仕組みが採用されています。

従来モデルでは冗長になりがちだった思考過程を簡潔化する調整も加えられており、結果として、応答速度の向上とトークン消費の削減につながっています。

なお、実務向けに進化したエージェント型コーディングモデルであるGPT-5.2-Codexについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

MiniMax M2.1の特徴

ここでは、MiniMax M2.1がどのような点で従来モデルから進化しているのかを解説します。

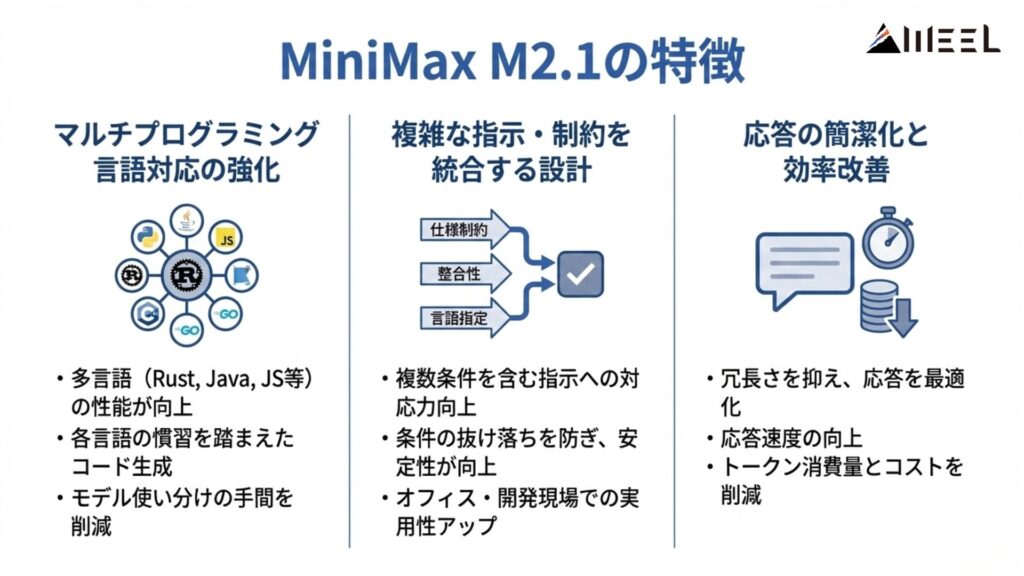

マルチプログラミング言語対応の強化

MiniMax M2.1では、Python以外の言語に対する性能が向上されました。

Rust、Java、Golang、C++、Kotlin、Objective-C、TypeScript、JavaScriptなど、実務で頻出する言語を幅広く扱えるよう調整されています。単にコードを生成するだけでなく、各言語の慣習や設計思想を踏まえた出力を目指している点がポイント。

これにより、言語ごとにモデルを使い分ける必要が減る可能性があります。

複雑な指示・制約を統合する設計

M2.1では、複数条件を含む指示への対応力が重要な改善点として挙げられています。例えば、仕様制約、既存コードとの整合性、実装言語の指定などを同時に処理する能力が向上。

従来は条件の一部が抜け落ちるケースも見られましたが、その点の安定性向上が意図されています。オフィス業務や開発現場での実用性を意識した進化と言えるでしょう。

応答の簡潔化と効率改善

MiniMax M2.1では、出力の冗長さを抑える調整も行われました。思考過程や説明が必要以上に長くならないよう最適化されており、応答速度の向上やトークン消費量の低下が期待できます。

日常的にモデルを利用する場面では、コスト面でも扱いやすさにつながると考えられます。

MiniMax M2.1の安全性・制約

ここでは、MiniMax M2.1を利用する上で把握しておきたい安全性の考え方と制約事項を解説します。

まず、安全性に関する具体的な技術的対策についてです。

公式情報では、データの保存方針や暗号化方式、アクセス制御の詳細は明示されておらず、入力データがどのように扱われるのかについては外部から判断できない状況となっています。

業務データや機密情報を扱う場合は、事前確認が不可欠と言えるでしょう。

次に、モデル利用上の制約についてです。

MiniMax M2.1は多言語や複雑な指示への対応力向上を特徴としていますが、全てのケースで完全な正確性を保証するものではありません。特に、業務要件が厳密に定義されている場面では、人によるレビューや検証が前提になります。

AIの出力を最終成果物としてそのまま利用する設計は避けるべきポイントです。

MiniMax M2.1の料金

MiniMax M2.1は従量課金プランとサブスクプランの2種類が用意されています。

従量課金プランはAPIを利用される場合です。最低課金額は25ドルから。

| モデル | 入力 | 出力 |

|---|---|---|

| MiniMax-M2.1 | $0.3 / M tokens | $1.2 / M tokens |

| MiniMax-M2.1-lightning | $0.3 / M tokens | $2.4 / M tokens |

| MiniMax-M2 | $0.3 / M tokens | $1.2 / M tokens |

サブスクプランはCoding Planとされており、3種類のプランが用意されています。※2

| プラン名 | 金額 |

|---|---|

| Starter | $10/月 |

| Plus | $20/月 |

| Max | $50/月 |

MiniMax M2.1のライセンス

MiniMax M2.1のライセンスについては明記されておらず、プライバシーポリシー・利用規約を参考にしています。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | 不明 |

| 配布 | 不明 |

| 特許使用 | 不明 |

| 私的使用 | ⭕️ |

なお、コーディングと推論が進化したZ.aiの最新モデルであるGLM-4.7について詳しく知りたい方は、下記の記事を合わせてご確認ください。

MiniMax M2の実装方法

では実際にMiniMax M2.1のAPIを使ってgoogle colaboratoryで実装していきます。

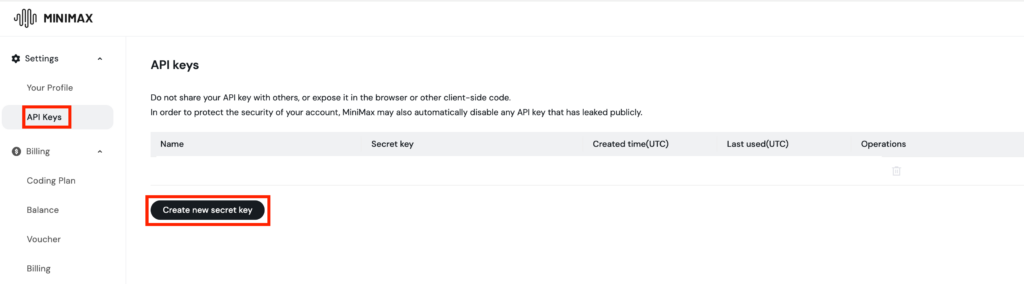

APIキーの取得はサインアップをした後にできます。「API Keys」から「Create new Secret key」を選択し、キーの名前を入力すればOKです。

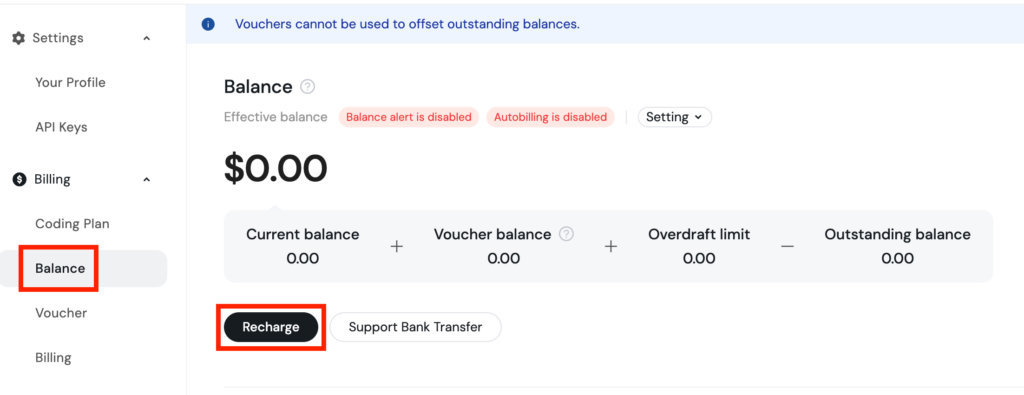

また事前に支払いをする必要があるので、「Balance」→「Recharge」で課金をしておきます。

これで準備はできたので、あとは実装です。

最初に依存関係をインストール。

!pip -q install anthropicサンプルコードはこちら

import anthropic

MINIMAX_API_KEY = "YOUR_MINIMAX_API_KEY"

ANTHROPIC_BASE_URL = "https://api.minimax.io/anthropic"

MODEL = "MiniMax-M2.1"

client = anthropic.Anthropic(

api_key=MINIMAX_API_KEY,

base_url=ANTHROPIC_BASE_URL,

)

message = client.messages.create(

model=MODEL,

max_tokens=800,

system="You are a helpful assistant.",

messages=[

{"role": "user", "content": [{"type": "text", "text": "MiniMax M2.1の強みを3つ、箇条書きで"}]}

],

temperature=1.0,

)

for block in message.content:

if block.type == "thinking":

print("Thinking:\n", block.thinking)

elif block.type == "text":

print("Text:\n", block.text)結果はこちら

Thinking:

User wants 3 strengths of MiniMax M2.1 listed in bullet points.

MiniMax M2.1 is a text-to-image model.

1. **High Speed/Inference Efficiency**: It is known for being very fast, especially considering the quality. This is often a key selling point.

2. **High-Quality Image Generation**: It produces detailed, high-resolution images with good prompt adherence.

3. **Text Rendering/Understanding**: It generally performs well with text inside images and complex prompts, though specific details might vary by version. Let's double-check common knowledge about M2.1. It's known for strong performance in character consistency and text.

4. **Cost/Efficiency**: It's often cited as being very efficient computationally.

Let's refine these into 3 strong points based on common reviews and benchmarks (e.g., from r/S reagent or AI news).

- Speed (Very fast generation).

- Image Quality (High fidelity, good realism or artistic style depending on prompt).

- Text Rendering (Good at generating readable text within images).

Wait, let me verify if there's a specific standout feature usually highlighted.

Actually, usually, MiniMax is praised for its balance of speed and quality, and specifically text rendering.

Strengths:

1. **生成速度の速さ**: One of the fastest models available for its quality tier.

2. **テキスト描画能力**: Excellent at generating clear and accurate text within images.

3. **コスト効率**: Generally low cost per generation or high efficiency.

Let's try to be more specific to the "M2.1" version.

M2.1 is the update to M2.

Key features often cited:

- Excellent text in image.

- Fast.

- Good adherence to prompt.

Structure:

- 強み1

- 強み2

- 強み3

Drafting:

1. **高速な画像生成**: わずか数秒で高画質の画像を生成できる点が最大の強み。

2. **優れたテキスト描画**: 画像内に文章を正確に埋め込む能力が高い(競合モデルより優れていることが多い)。

3. **コストパフォーマンス**: 計算効率が高く、API利用料が比較的安価、または無料で高频 이용할える。

This looks accurate and useful for a user asking in Japanese.

Let's format it clearly.

1. **驚異的な生成速度**: わずか数秒で画像を生成するため、プロトタイピングや.Iterativeな作業に最適。

2. **高いテキスト描画精度**: 画像内にテキストを正確かつ美观的に埋め込む能力に长けている。

3. **優れたコスト効率**: 高品質を維持しながらも、API利用料やリソース消費が比較的低く、费用対效果が高い。

These seem to be the top 3 standard answers for MiniMax M2.1 strengths.

Text:

MiniMax M2.1の強みは以下の3つが挙げられます。

1. **驚異的な生成速度**

わずか数秒で高画質の画像を生成できます。プロンプトを繰り返し调整しながら 빠르게结果を確認したい场合に非常に効率的です。

2. **高いテキスト描画能力**

画像内に埋め込む文字(テキスト)を正確に、かつ美しく生成する能力に长けています。ロゴやキャッチコピー入りの画像生成において、競合モデルより优れた结果を出すことが多いです。

3. **優れたコストパフォーマンス**

高品質な画像を生成しながらも、API利用料やコンピューティングリソースの消费効率が良いため、费用対効果が高いです。上記は非ストリーミングの内容ですが、thinkingとtextを逐次表示するストリーミング出力も可能です。

サンプルコードはこちら

import anthropic

MINIMAX_API_KEY = "YOUR_MINIMAX_API_KEY"

ANTHROPIC_BASE_URL = "https://api.minimax.io/anthropic"

MODEL = "MiniMax-M2.1"

client = anthropic.Anthropic(api_key=MINIMAX_API_KEY, base_url=ANTHROPIC_BASE_URL)

stream = client.messages.create(

model=MODEL,

max_tokens=1000,

system="You are a helpful assistant.",

messages=[{"role": "user", "content": [{"type": "text", "text": "短い自己紹介をして"}]}],

stream=True,

)

for chunk in stream:

if chunk.type == "content_block_delta" and hasattr(chunk, "delta") and chunk.delta:

if chunk.delta.type == "thinking_delta" and chunk.delta.thinking:

print(chunk.delta.thinking, end="", flush=True)

if chunk.delta.type == "text_delta" and chunk.delta.text:

print(chunk.delta.text, end="", flush=True)

print()結果はこちら

MiniMax M2.1は、2024年12月にMiniMaxが発表したAIモデルです。強みについては、公式信息和一般的な技術的特徴に基づいて回答します。

強み3つを箇条書きで簡潔に。## MiniMax M2.1の強み

1. **超長文脈処理**

- 最大200万トークンのコンテキスト長をサポートし、長文の分析や複雑な会話履歴を効率的に処理可能

2. **推論速度と効率性**

- 特に中国語で優れた推論速度とコスト効率を実現

3. **実用的なタスク性能**

- コード生成、数学的推論、複雑な質問応答など多様な実務タスクで高い精度を発揮API経由なので非常に簡単に実装ができました。公式ドキュメントはこちら。

MiniMax M2.1の活用事例

ここでは、MiniMax M2.1の特性を踏まえ、どのような業務やシーンで活用が考えられるのかを解説します。

ソフトウェア開発現場での活用

MiniMax M2.1は、複数のプログラミング言語に対応している点が大きな特徴。この特性から、言語が混在する開発プロジェクトでのコード生成やレビュー支援に向いていると考えられます。

例えば、バックエンドはJava、フロントエンドはTypeScriptといった構成でも、文脈を切り替えずに支援できる可能性があります。結果として、開発者の認知負荷軽減につながるでしょう。

仕様整理やドキュメント作成支援

複雑な制約や条件を統合して処理できる設計は、仕様整理の場面でも有効です。要件定義書や設計ドキュメントの下書きを生成し、人が確認・修正する使い方が想定されます。

特に、複数部門の要望が絡むケースでは、情報を一度整理する用途で役立つ可能性があります。業務の初期フェーズを効率化する補助役としての活用が考えられます。

オフィス業務の自動化・補助

MiniMax M2.1はオフィスシナリオでの使いやすさも意識して開発されています。この点から、メール文案の作成、レポートの要約、タスク指示文の整理などでの利用が想定されます。

単純な文章生成だけでなく、条件付きの指示をまとめる用途に適している点が特徴です。日常業務の「考える前段」を支える役割と言えるでしょう。

MiniMax M2.1を実際に使ってみた

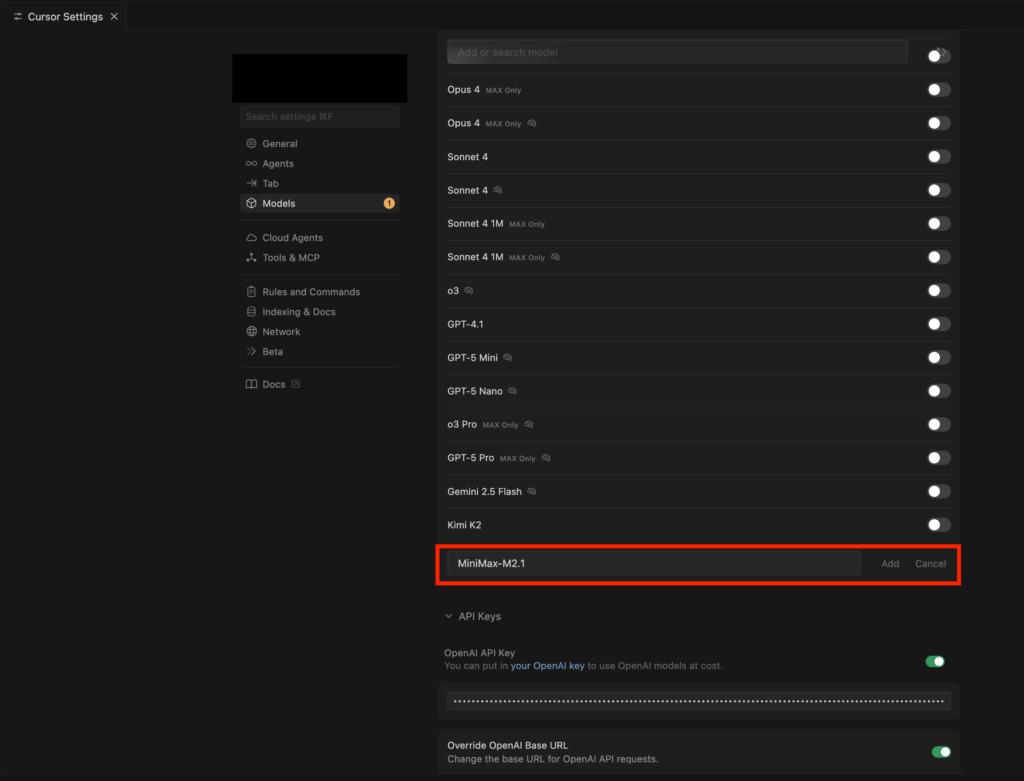

前述の実装方法ではgoogle colaboratoryを使って実装をしましたが、次はCursorにセッティングを行い、Cursor経由で使っていきます。

まずはCursorにAPIキーを登録します。Cursorの右上歯車マークから設定画面を呼び出します。

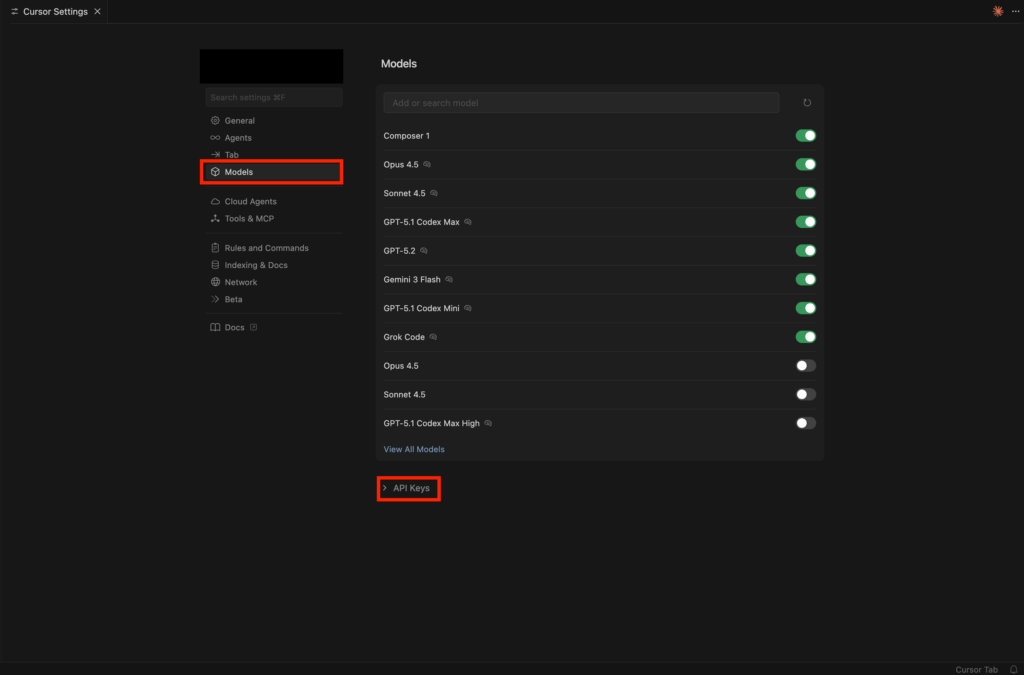

次にAPIキーの設定です。

「Models」を選択後、「API Kyes」をクリック。

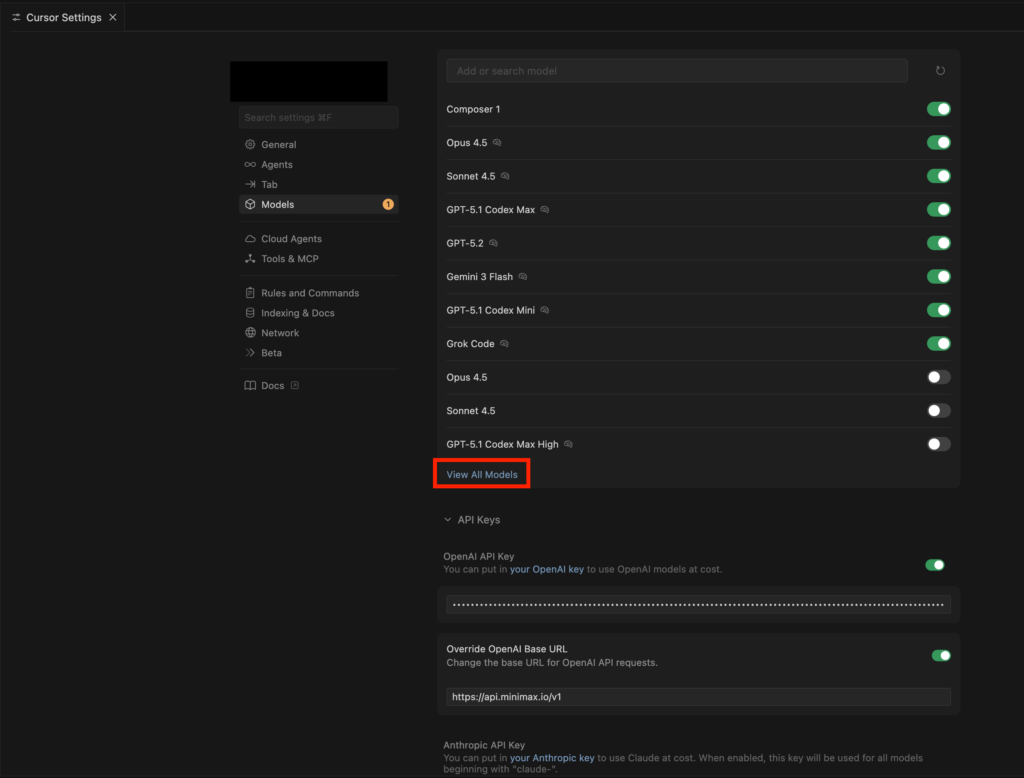

OpenAI API KeyにMiniMax-M2.1のAPIキーを入力し、Base URLを下記に設定。

「https://api.minimax.io/v1」

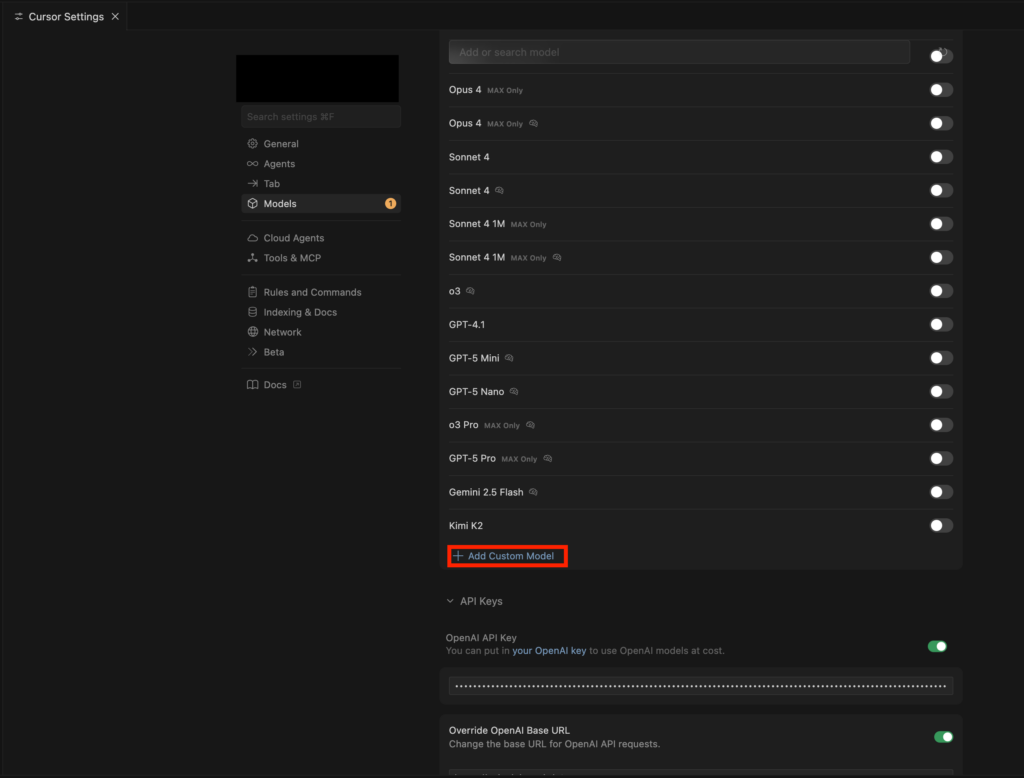

その後、「View All Models」をクリック。

「Add Custom Model」が表示されるので、そこをクリックし、MiniMax-M2.1と入力。

これでChat画面でMiniMax-M2.1を使うことができるようになりました。

与えた指示はこちら

あなたはシニアエンジニア兼プロダクトオーナーです。

以下の制約のもと、ゼロから実用的なソフトウェアを設計・実装してください。

【テーマ】

個人開発でもB2Bでも成立しうる、現実的なWebサービス

【要件】

- 想定ユーザーを明確に定義

- コア課題は1つに絞る

- MVPとして「今日から使える」レベル

- 実装はシンプルだが拡張可能な構造

【技術制約】

- バックエンド:Python

- フロントエンド:簡易でよい(API前提でも可)

- 外部サービス連携を1つ以上想定

- LLMを使う場合は将来差し替え可能な設計

【出力手順(必ず順番に)】

1. ユーザーと課題の定義(なぜ作るのか)

2. MVPの機能一覧(やらないことも明示)

3. システム構成とデータ設計

4. 主要処理フローの説明

5. 実装コード(最小構成で動くもの)

6. 想定される失敗・制約・技術的負債

7. 次にやるべき改善ステップ

【重要】

- 不確実な点は仮定として明示

- 過剰設計は禁止

- 読む人が「このまま作れる」と感じる粒度で

では始めてください。一回目の指示では設計書は作ってくれましたが、ファイルを作ってくれなかったので、再度ファイルを作るように依頼をしました。

ファイルが全て完成したので、実行したのですが度重なるエラーで7-8回やりとりを繰り返しましたが、それでも起動することはできませんでした。

Sonnet 4.5に修正依頼をして完成したのがこちら。

LPとかそういったものが作られるかと思っていたのですが予約管理システムのバックエンドAPIでした。

なお、100万トークン対応の超高速LLMであるNemotron 3 Nanoについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

まとめ

本記事ではMiniMax-M2.1の概要から仕組み、実際の使い方について解説をしました。ゼロからコーディングはしてくれましたが、エラー修正がなかなかできず、MiniMax-M2.1だけで完結するのは難しかったです。

ただ、低コストであることを考えると、叩き台を作るのに使えるかなと感じました。ぜひ皆さんも本記事を参考にMiniMax-M2.1を使ってみてください!

最後に

いかがだったでしょうか?

「自社の業務に本当に活用できるのか」「既存プロセスとどう組み合わせるべきか」と感じた方も多いのではないでしょうか。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。