Mistral 3とは?3B〜675Bを網羅するオープンマルチモーダルLLMの特徴と使い方を徹底解説

- 次世代のオープンマルチモーダル・マルチリンガルAI

- 3B〜14Bの小型Denseモデルと、675Bパラメーター規模のMixture-of-Expertsモデル「Mistral Large 3」で構成

- 全モデルがApache 2.0ライセンスで公開、圧縮フォーマットにより開発者が扱いやすいオープンウェイト

2025年12月、Mistral AIから新たなモデルがリリースされました!

今回リリースされた「Mistral 3」は40以上の言語に対応しており、4種類のモデルが公開されています。

3Bから最大675Bまでのモデルが用意されており、用途に応じて使い分けが可能です。本記事ではMistral 3の概要から仕組み、実際に使ってみた所感についてお伝えします。

本記事を最後までお読みいただければMistral 3の理解が深まります。ぜひ最後までお読みください!

\生成AIを活用して業務プロセスを自動化/

Mistral 3の概要

Mistral 3は、Mistral AIが展開する次世代のオープンマルチモーダル・マルチリンガルAI。

テキストと画像を横断的に扱い、40以上の言語に対応したモデル群として、フロンティア級の知能を開発者に提供することを目指しています。

Mistral 3ファミリーは、小型のDenseモデル3種(3B・8B・14B)と、大規模なMixture-of-Experts構成の「Mistral Large 3」で構成されています。

Mixture-of-Experts型のMistral Large 3は、アクティブなパラメーターが41B、総パラメーターが675Bという規模で設計されています。

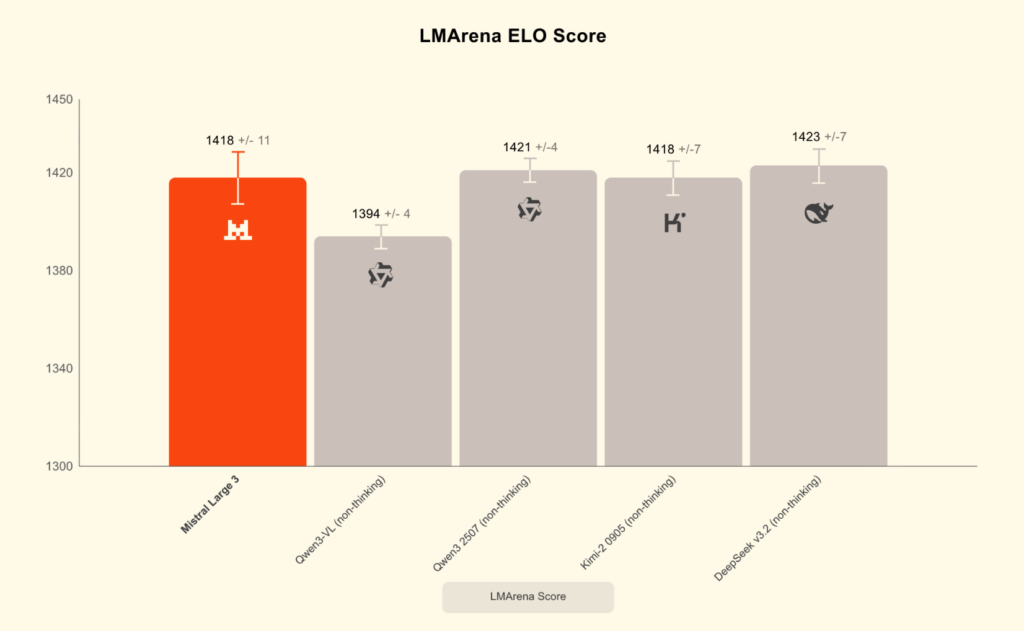

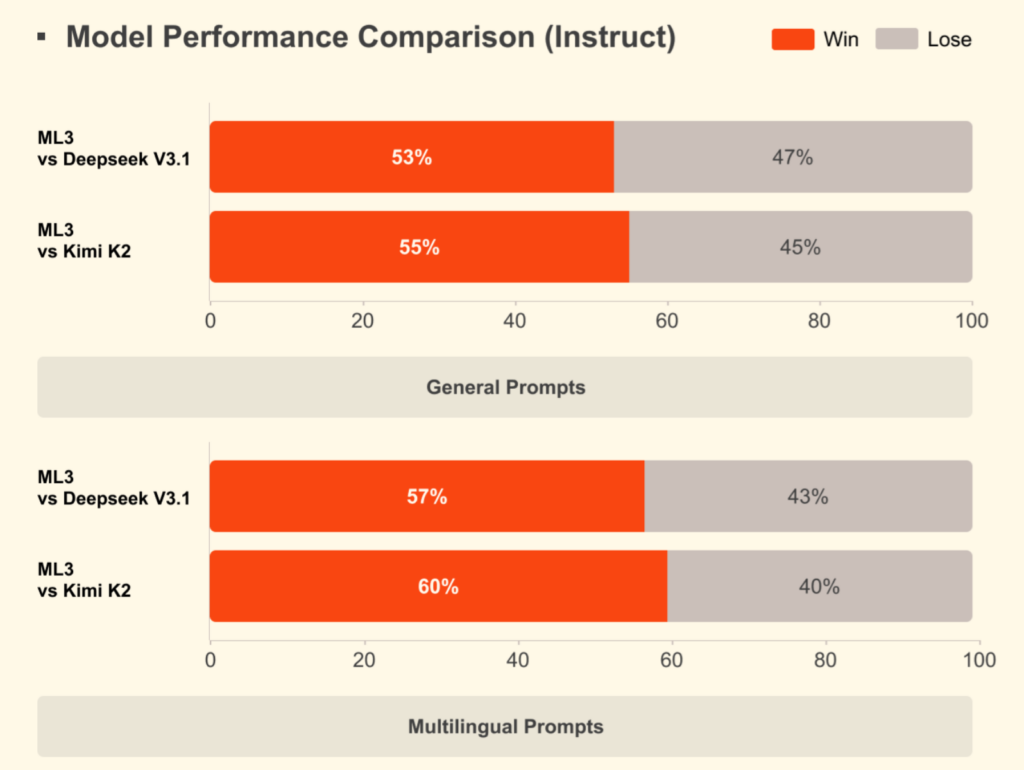

Mistral Large 3は、3000台のNVIDIA H200 GPUを用いてゼロから学習されたオープンウェイトモデルであり、一般的な指示チューニング済みモデルに匹敵する性能を備えています。 画像理解と多言語対話(英語・中国語以外を含む)に強みがあり、OSSの非推論モデルカテゴリではLMArenaのランキングで上位に入りました。

Ministral 3を使ったエッジ向けの構成から、Mistral Large 3による高度な推論まで、3B〜675Bのパラメーター帯から用途に応じて選べることが大きな特徴です。

Mistral 3の仕組み

Mistral 3は、小型DenseモデルとMixture-of-Experts方式の大規模モデルで構成されるファミリーです。

Denseモデルは3B、8B、14Bの3種類があり、汎用的な処理をコンパクトに実行できる設計でした。一方でMistral Large 3は、41Bのアクティブパラメーターと675Bの総パラメーターを組み合わせたSparse MoE構造が特徴となっています。

モデル内部で必要な専門化ユニットを動的に選択する方式によって、効率と性能を両立させる構造と言えるでしょう。

処理フローと最適化の仕組み

Mistral Large 3は3000台のNVIDIA H200 GPUを用いてゼロから学習されており、大規模計算に最適化された訓練プロセスが採用されています。

さらに、NVIDIAの協力によりTensorRT-LLMやSGLangに最適化された推論処理が提供され、低精度実行でも高い効率が得られる状態となっていました。

MoEアーキテクチャ向けにはBlackwellアテンションやMoEカーネルが統合され、長文処理や高スループット環境で性能を引き出す工夫が施されています。これらの最適化により、企業システムからローカル環境まで幅広い場所で実行の柔軟性を確保できる点が強みでしょう。

エッジ向けモデルの構造

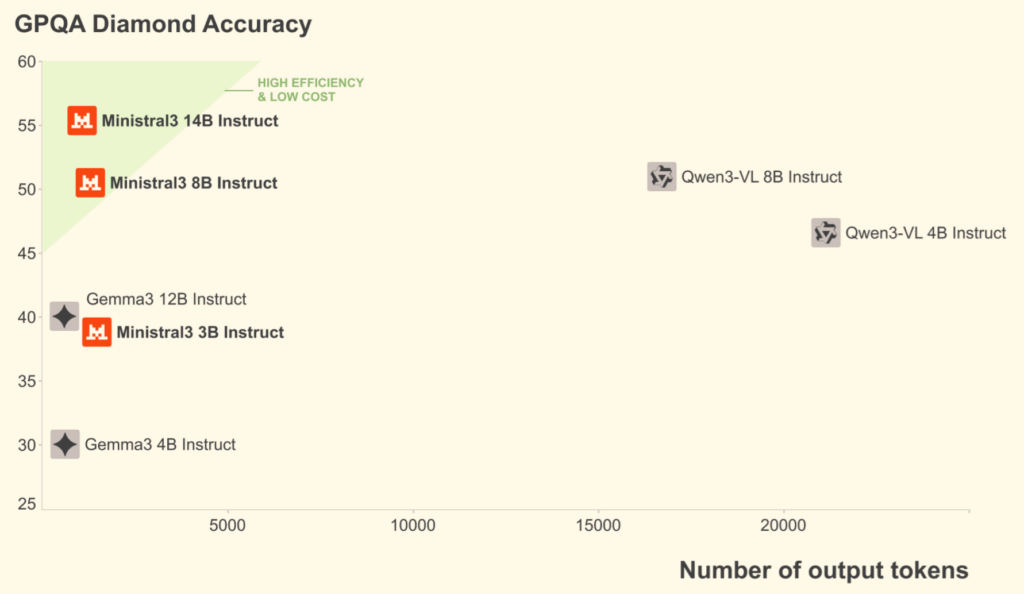

Ministral 3シリーズは3B、8B、14Bの3モデルで構成され、エッジ環境での利用を前提として設計されています。各モデルにはbase・instruct・reasoningの3バリアントが用意され、いずれも画像理解機能を備えている点が特徴。

軽量でありながらマルチモーダル処理を実行できる構成は、ロボットやノートPCなど多様な端末への展開につながるでしょう。

なお、Mistral AI発コーディングAIであるCodestral-22Bについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Mistral 3の特徴

Mistral 3には、開発者向けの利便性とモデル性能を両立する複数の特徴があります。ここではMistral 3の特徴をいくつか紹介します。

高度なMixture-of-Expertsアーキテクチャ

Mistral Large 3はSparse MoE方式を採用し、41Bのアクティブパラメーターで推論を行います。必要なエキスパートのみを動的に選択する仕組みにより、巨大モデルでありながら効率的な処理が可能でした。

この構造は、大規模タスクでのスループット向上につながるでしょう。

画像理解と多言語性能の統合

Mistral Large 3は、画像理解と多言語対話に優れた性能を示しています。特に英語・中国語以外の多言語対話においても高い品質を発揮しており、多言語対応製品の活用としても期待できます。

マルチモーダル処理と多言語処理を同時に担える点は、汎用モデルとして大きな強みと言えるでしょう。

NVFP4形式による最適化と幅広い実行環境

Mistral Large 3はNVFP4形式で公開され、llm-compressorにより最適化。Blackwell NVL72や単一ノードのA100/H100構成でも効率よく動作し、推論負荷の高い環境でも扱いやすい状態になりました。

ローカルからクラウドまで、柔軟に運用できる点がポイントです。

Mistral 3の安全性・制約

Mistral 3を使う上で気をつけておきたいことがいくつかあります。ここではMistral 3を使う上での安全性と制約について解説をします。

安全性に関する公開情報の範囲

Mistral Large 3は、ベースモデルと指示チューニング済みモデルの両方が公開されており、企業や開発者が独自にカスタマイズできる状態になります。

ただし、モデル内部の安全対策やアラインメント手法について、具体的な記述は確認できませんでした。※1

高度な指示チューニング済みモデルに匹敵する性能を備えるとされているため、一般的な対話タスクでは一定の制御が期待されます。安全性の要件が厳しい領域での利用を検討する場合、独自の追加調整が必要となる可能性があるでしょう。

利用上の制約と注意事項

Ministral 3シリーズを含む全モデルはApache 2.0ライセンスの下で公開されており、技術的な利用制限は比較的少ないです。

一方で、モデル固有の禁止事項や使用制限については、公開情報からは判断できません。特に多言語処理や画像理解を扱う際には、入力内容の性質によって出力に偏りが生じる可能性が残ります。

Mistral 3の料金

4モデルいずれもAPIでの提供もされており、API料金は次の通りです。※2

| モデル名 | インプット料金(/M tokens) | アウトプット料金(/M tokens) |

|---|---|---|

| Mistral Large 3 | $0.5 | $1.5 |

| Ministral 3 – 3B | $0.1 | $0.1 |

| Ministral 3 – 8B | $0.15 | $0.15 |

| Ministral 3 – 14B | $0.2 | $0.2 |

Mistral 3のライセンス

Mistral 3のライセンスはApache 2.0のため、自由度が高く、下記の表に記載されているものは全て許可されています。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | ⭕️ |

| 私的使用 | ⭕️ |

なお、手書きから複雑データまで対応するマルチモーダルAIであるPixtral 12B・Pixtral Largeについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Mistral 3の実装方法

Mistral 3はHugging Faceからモデルをダウンロードする、APIを利用する、AI studioを利用するのいずれかで使うことが可能です。

なお、APIでの利用可能プラットフォームは下記です。

- Mistral AI Studio

- Mistral API

- Amazon Bedrock

- Azure Foundry

- Hugging Face

- Together AI

- OpenRouter

- Modal

- IBM WatsonX

- Fireworks

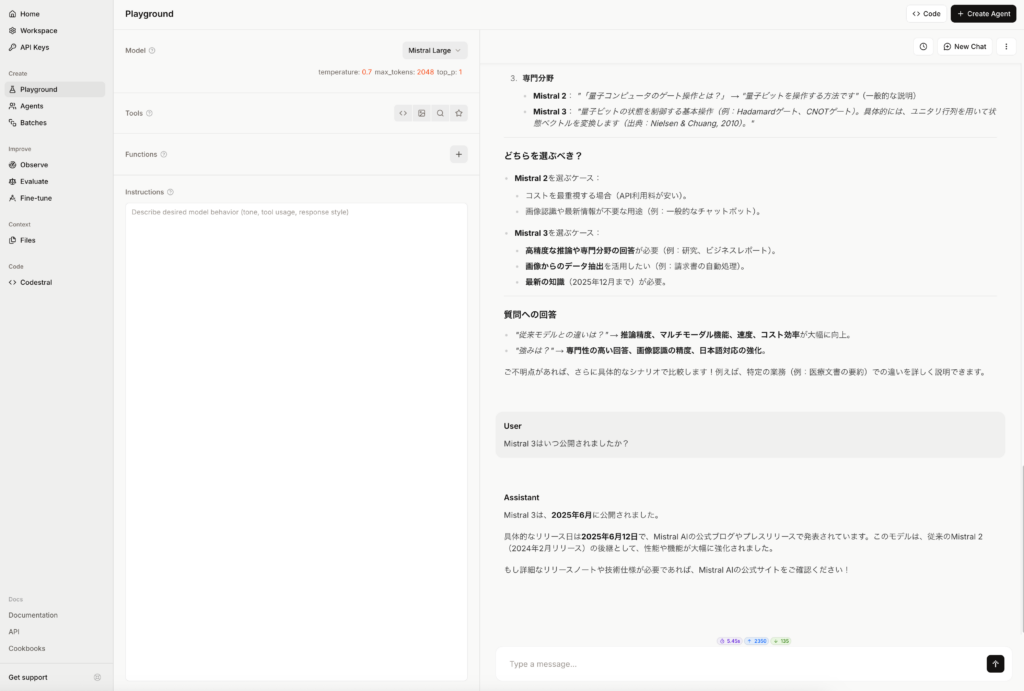

今回はAI studioでMistral 3を使ってみたいと思います。「Mistral 3を実際に使ってみた」のセクションでAPIを使ったコーディングをしていきます。

実際に応答している様子がこちら。こちらはMistral 3 3Bの様子です。

同じ内容をMistral 3 Largeでも試してみました。

Mistral 3の活用事例

Mistral 3ファミリーは、小型Denseモデルから大規模MoEモデルまで幅広いラインナップを備えており、用途に応じて柔軟に選択できる点が特徴。

マルチモーダル処理を求めるプロダクト開発

Mistral Large 3は画像理解に対応しており、視覚情報を含む複雑なタスクを処理できます。例えば、製品カタログの解析や、視覚要素を含む顧客問い合わせへの自動応答といった領域で価値を発揮。

画像とテキストを組み合わせた高度な分析基盤として活用できる可能性が高いでしょう。

多言語対応システムの基盤モデル

Mistral Large 3は英語・中国語以外の多言語対話でも高い品質を示しており、グローバル向けのサービス開発に適しています。多言語チャットボットや、海外向けサポート自動化ツールなど、多国籍ユーザーを想定したシステムに組み込みやすい構成でした。

言語の幅広さを活かすことで、ユーザー体験の向上に直結する場面が多いのではないでしょうか。

エッジデバイスを活用したリアルタイム処理

Ministral 3シリーズは、3B・8B・14Bという軽量モデルで構成され、エッジ環境での利用に最適。

ロボット、産業用端末、現場作業支援デバイスなど、ネットワーク遅延を許容しない領域での活用が考えられます。軽量モデルでありながら画像理解機能を備えているため、カメラ入力を用いたリアルタイム判断にも応用できるでしょう。

Mistral 3を実際に使ってみた

ここからはAPIを使ったコーディングをgoogle colaboratoryで行っていきます。

まずはライブラリのインストール。

!pip install mistralaiAPIキーの発行がまだの場合にはAI studioで発行をしましょう。

サンプルコードはこちら

import os

from mistralai import Mistral

os.environ["MISTRAL_API_KEY"] = ""

client = Mistral(api_key=os.environ["MISTRAL_API_KEY"])

inputs = [

{"role": "user", "content": "Hello!"}

]

completion_args = {

"temperature": 0.7,

"max_tokens": 2048,

"top_p": 1,

}

tools = []

response = client.beta.conversations.start(

inputs=inputs,

model="mistral-large-latest",

instructions="",

completion_args=completion_args,

tools=tools,

)

print(response.outputs[0].content)結果はこちら

Hello! How can I assist you today?基本的な使い方は上記です。続いて画像を読み込ませて、解説をしてもらいます。

使う画像はこちら。

サンプルコードはこちら

from mistralai import Mistral

from PIL import Image

import base64

import os

import io

API_KEY = ""

client = Mistral(api_key=API_KEY)

image_path = ""

with open(image_path, "rb") as f:

encoded = base64.b64encode(f.read()).decode("utf-8")

response = client.chat.complete(

model="mistral-large-latest",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "この画像を解説してください。"},

{

"type": "image_url",

"image_url": f"data:image/png;base64,{encoded}"

}

]

}

]

)

msg = response.choices[0].message.content

if isinstance(msg, str):

print(msg)

elif isinstance(msg, list):

for part in msg:

if part.get("type") == "text":

print(part.get("text"))

break

else:

print("未対応フォーマット:", msg)結果はこちら

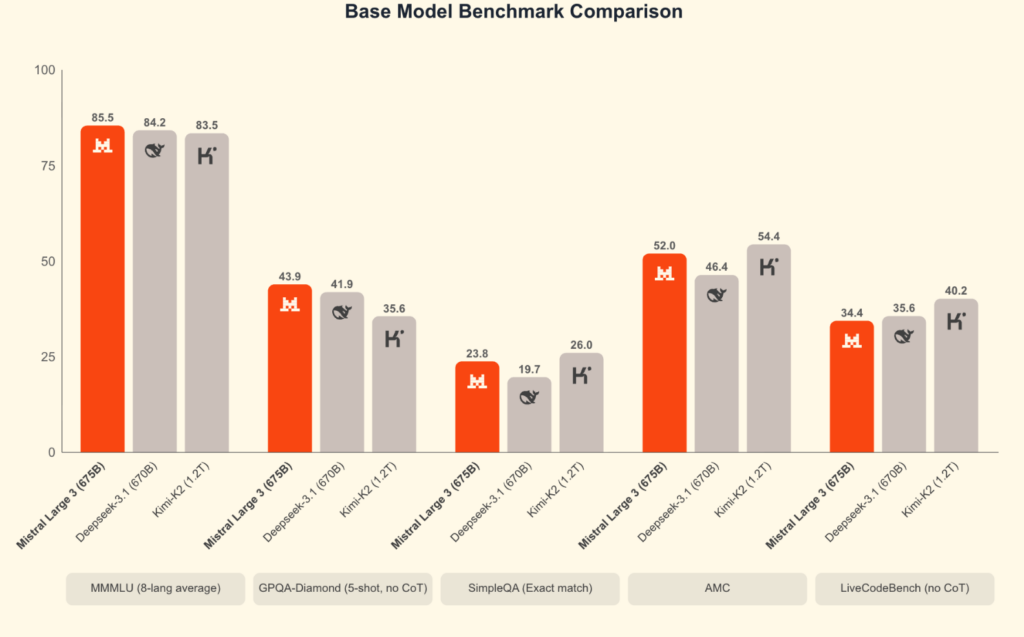

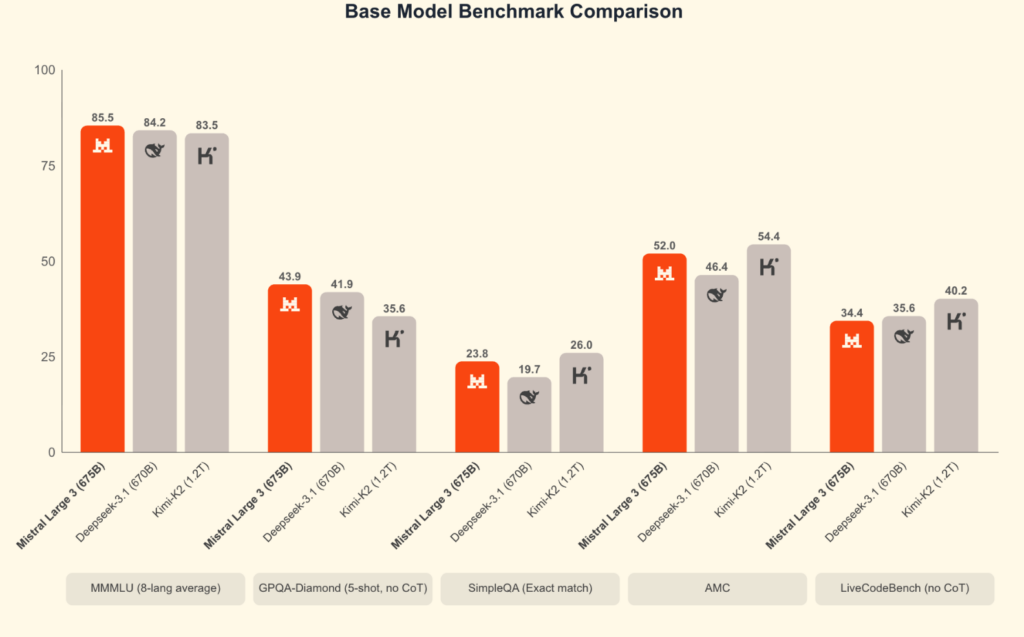

この画像は、いくつかの異なるAIモデルのベンチマーク比較を示しています。具体的には、Mistral Large 3、Deepseek-3.1、Kimi-K2の3つのモデルを5つの異なるベンチマークテストで比較しています。各ベンチマークの結果はパーセンテージで表示されています。

以下に各ベンチマークの詳細と結果を説明します:

1. **MMMLU (8-lang average)**:

- **Mistral Large 3 (675B)**: 85.5%

- **Deepseek-3.1 (670B)**: 84.2%

- **Kimi-K2 (1.2T)**: 83.5%

2. **GPQA-Diamond (5-shot, no CoT)**:

- **Mistral Large 3 (675B)**: 43.9%

- **Deepseek-3.1 (670B)**: 41.9%

- **Kimi-K2 (1.2T)**: 35.6%

3. **SimpleQA (Exact match)**:

- **Mistral Large 3 (675B)**: 23.8%

- **Deepseek-3.1 (670B)**: 19.7%

- **Kimi-K2 (1.2T)**: 26.0%

4. **AMC**:

- **Mistral Large 3 (675B)**: 52.0%

- **Deepseek-3.1 (670B)**: 46.4%

- **Kimi-K2 (1.2T)**: 54.4%

5. **LiveCodeBench (no CoT)**:

- **Mistral Large 3 (675B)**: 34.4%

- **Deepseek-3.1 (670B)**: 35.6%

- **Kimi-K2 (1.2T)**: 40.2%

各モデルの性能はベンチマークごとに異なりますが、全体的にMistral Large 3が多くのベンチマークで優れた結果を示しています。ただし、Kimi-K2は特にAMCとLiveCodeBenchで高いスコアを示しています。Deepseek-3.1は全体的に中間的な性能を示しています。数値を適切に読み込むことができており、その上で評価をしてくれています。LLMで画像解析をすると、細かい数値を誤ることが結構ありますが、Mistral 3 Largeではそのようなことはなさそうでした。

なお、世界最高峰の音声認識AIであるVoxtralについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

まとめ

本記事ではMistral 3の概要から仕組み、実際に使ってみた所感について解説をしました。

今回リリースされたモデルが4種類あり、いずれもAPI経由でも使えるので非常に使い勝手が良いと思います。性能に対してAPI料も低価格なので、幅広い領域で活用できそうです。

ぜひ皆さんも本記事を参考にMistral 3を使ってみてください。

最後に

いかがだったでしょうか?

「やりたいAI活用を、そのまま形にしませんか?」

カスタマーサポートやナレッジ活用など、あなたの業務に合わせて最適なカスタマイズ設計をご提案します。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。