ChatGPT「Advanced Voice Mode」でAIと会話!使い方と活用法を徹底解説!

WEELメディア事業部AIライターの2scです。

みなさん!2024年5月にアナウンスされていたChatGPTの音声会話機能「Advanced Voice Mode」が、ついに登場しました。

OpenAIによると、この待望の機能は日本語を含む50以上の言語に対応し、新たに5種類の音声も追加されています。まるで人間と話しているかのような、自然で感情豊かな会話体験が現実のものとなりました。

当記事では、そんなChatGPTのAdvanced Voice Modeを徹底解説します。同機能でできることや注意点、使い方はもちろん、実際に使ってみた結果や活用事例など余すところなくお届けします。

この記事を読み終える頃には、あなたもきっとChatGPTともっと語り合いたくなるはずです。ぜひ最後までお付き合いください。

\生成AIを活用して業務プロセスを自動化/

ChatGPTの音声会話機能「Advanced Voice Mode」とは?

2024年9月25日、OpenAIはChatGPTのスマートフォン向けアプリ版の有料プランに高度な音声会話機能「Advanced Voice Mode」を解放しました。

これは、同年5月13日の発表から4ヶ月以上を経ての実装となり、多くのユーザーが待ち望んでいたアップデートです。主な仕様は以下の通りです。

● 音声・画像の入力から音声での応答までを「GPT-4o」1モデルでスムーズに実行

● 抑揚のある感情豊かな音声で、自然な会話体験を実現

● 日本語を含む50以上の言語に対応

● 発表済の音声4種に加え、音声5種が新規追加

以上のように、AIチャットとしてのChatGPTの魅力がさらにUPしています。

そんなAdvanced Voice Modeは日本でもリリースされていて、すでに利用可能ですが、実装直後はいくつかの制約事項がありました。現時点(2025年8月)では、対応プラットフォームや地域も拡大しており、より多くのユーザーに利用できるようになりました。

Advanced Voice Mode に関する最新情報(2025年8月現在)

1. 日本でも利用可能か?

Advanced Voice Mode(現在は「ChatGPT Voice」として統合)は日本でも正式に提供されており、無料ユーザーにも順次拡大中です。

2. 対応言語

以前と変わらず、50以上の言語がサポートされています。

3. 音声のバリエーション

Advanced Voice Modeでは、9種類の個性的な声(Arbor, Breeze, Cove, Ember, Juniper, Maple, Sol, Spruce, Vale)が選択可能です。

4. 利用可能なプラットフォーム

スマートフォンアプリ(iOS / Android)だけでなく、macOSデスクトップアプリやウェブ版でも利用できるようになり、対応プラットフォームが広がっています。

5. 利用可能なプラン

- Plusユーザー:GPT‑4o 音声(GPT‑4o miniへのフォールバックあり)で、ほぼ無制限に利用可能。

- Freeユーザー:GPT‑4o mini を使用し、1日に利用可能な時間が制限されています。

- ProやTeam、Enterprise、Eduプランについても各種強化が順次進行中です。

6. 使用上の制約・制限

- 1日の使用時間制限が依然として存在し、特に無料ユーザーでは差し替えられるモデルがあるなど制限される点が継続しています。

- 画像入力(ビジョン機能)には未対応です(音声モードのみ)。

- EU地域(EEA)、スイス、英国などでは、一部の機能やコネクタ類の提供が制限されています。

- Standard Voice Modeは廃止予定もしくは段階的に終了しつつあり、約30〜60日以内に完全廃止される計画です。

7. 最近の進化点

- 自然さや話し方の多様性が大幅にアップ。イントネーション、間、感情表現(共感、皮肉など)の再現性能が向上しています。

- 無料ユーザーにも同等のアップグレードが順次展開中であり、使いやすさが向上しています。

- GPT‑5への移行により、音声モードがさらに進化し、「リアルタイムのトーンカスタマイズ(速度や温かさの調整など)」が可能になっています

従来の音声モード(Standard Voice)との違いは?

「Advanced Voice Mode」は、従来の「Standard Voice」と何が違うのでしょうか。一番の大きな違いは、会話を処理するAIモデルの仕組みにあります。

| 項目 | Advanced Voice Mode | Standard Voice(従来型) |

|---|---|---|

| 基盤モデル | GPT-4o(単一モデル) | 複数のAIモデルの組み合わせ |

| 処理プロセス | 音声認識・思考・応答を統合処理 | 各プロセスを別々のモデルが担当 |

| 応答速度 | 最短0.232秒、平均0.320秒 | 遅延が発生しやすい |

| 表現力 | 感情、抑揚、笑い声などを表現可能 | 機械的な読み上げに近い |

| 会話の自然さ | 人間との会話に近いスムーズさ | やや途切れがちな会話 |

Standard Voiceが「音声認識モデル」「大規模言語モデル」「音声合成モデル」という3つのモデルを連携させていたのに対し、Advanced Voice ModeはGPT-4oという1つのモデルで全てを完結させます。これにより、モデル間の連携で生じていたタイムラグがなくなり、驚くほどスムーズで自然な会話が実現しました。

ChatGPTのAdvanced Voice Modeでできること

ここからは、アプリ版ChatGPTに新たに加わったAdvanced Voice Modeでできることを、2024年12月13日の追加分も含めて4つご紹介します。まずは、基本のキ「自然な音声会話」から、詳しくみていきましょう!

自然な音声会話

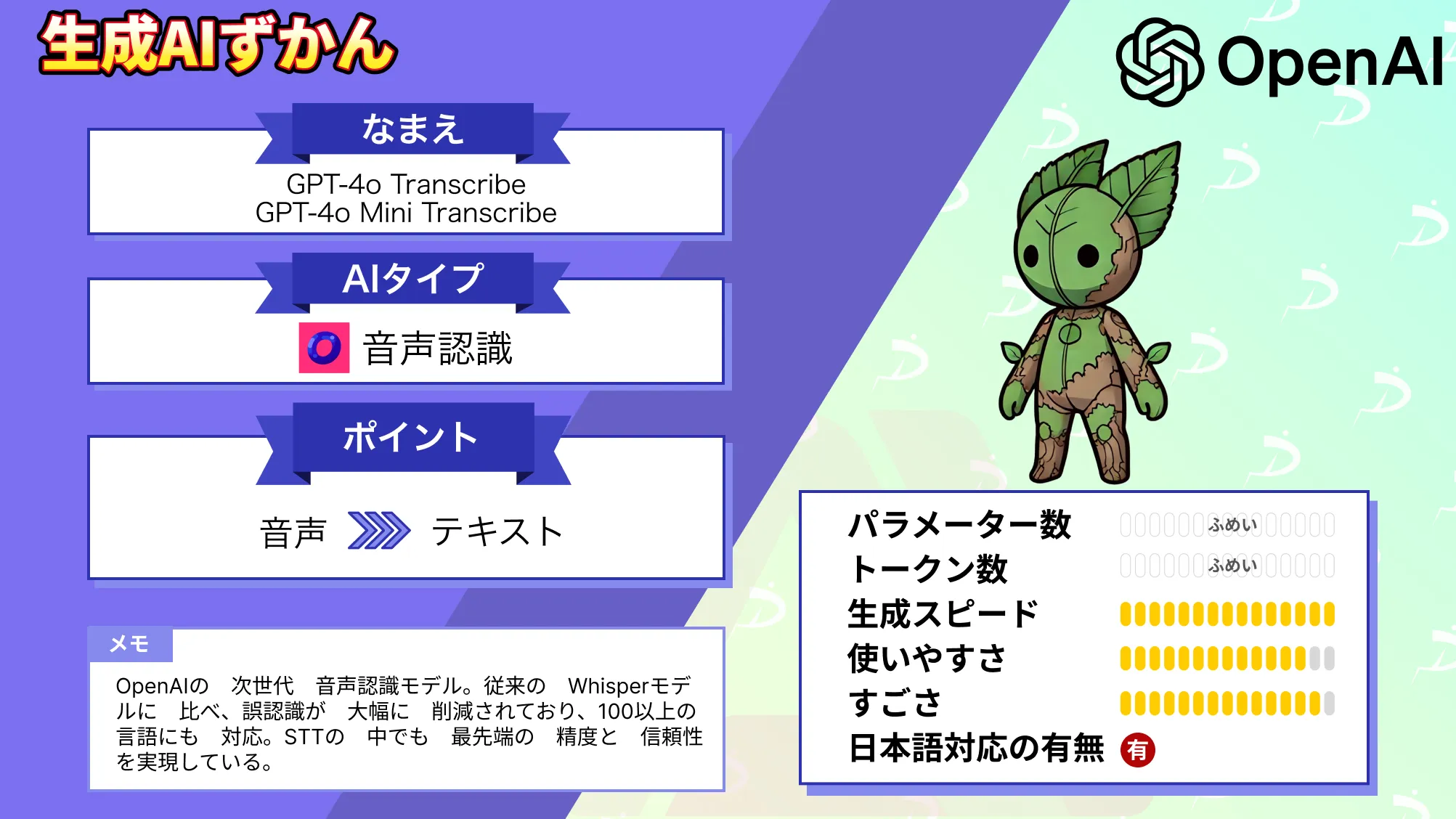

Advanced Voice Modeでは、まるで人間相手のようなテンポ感と抑揚でChatGPTとの音声会話が楽しめます。これを可能にしているのが何といっても、現行型ChatGPTの心臓部である「GPT-4o」です。

そもそもGPT-4oは、テキスト入出力 / 画像入力 / 音声入出力の全て(”o”mni)に1モデルで対応したマルチモーダルLLMです。これは1つのニューラルネットワークで、音声認識・回答生成・読み上げの全工程をスムーズにこなせるのが特徴で、複数のAIモデルを組み合わせた従来の音声会話(Standard Voice)よりも、自然な会話体験が提供できます。

そんなGPT-4oをフルに活用したAdvanced Voice Modeでは、以下のような機能が利用可能です。

GPT-4oによるAdvanced Voice Modeの機能

- 日本語を含む50以上の言語を自動識別し、返答文と音声を生成

- 最短0.232秒、平均0.320秒でのレスポンスが可能

- 笑い声 / 感情 / 抑揚の表現を込めての読み上げも可能

- 会話のトーン / 複数の話者 / 背景騒音の認識も可能

以上のように、会話のトーンや背景のノイズまで認識できるため、これまでのAIアシスタントとは一線を画す会話体験を提供しています。

ビデオ通話&画面共有

日本時間の2024年12月13日からは、カメラ映像&画面を共有できる機能「Advanced voice with video」がAdvanced Voice Modeに実装されています。こちらではChatGPTとビデオ通話を楽しんだり、ChatGPTに画面の内容を質問したりといったことが可能です。

OpenAIが公開したAdvanced voice with videoのデモ動画では、「ChatGPTに自己紹介をして、顔と名前を覚えてもらう」「リアルタイムでドリップコーヒーの作り方を教えてもらう」といったことを実演しています。

ちなみに、Advanced voice with videoの起動はAdvanced Voice Modeの画面左下に新設されたボタンから可能で、これまで以上に臨場感のある会話体験が楽しめそうです。

「Advanced Voice with Video」(ライブ映像+音声対応機能)は、2024年12月12日にモバイルアプリ向けにリリースされました。ユーザーがスマートフォンのカメラ映像をリアルタイムで共有しながらChatGPTと音声対話できるのが特徴で、静止画ではなくライブビデオ映像を活用できる点が大きな魅力です。

一方、日本語版のChatGPT(Team/Plus/Pro)への実装時期については、現時点でOpenAIから公式発表はなく、ChatGPT EnterpriseやEduへの日本語対応に関しても「2025年初頭ごろに予定」といった一部情報もあったようですが、公式な案内は出ておらず、こちらも現時点(2025年8月)では不明となっています。

口調やアクセントの記憶

Advanced Voice Modeは「Custom instructions」に完全対応!口調やキャラクターのほか、アクセント / イントネーション / リズム…etc.についてもChatGPTに記憶させられます。こちらもGPT-4o1モデル化の恩恵ですね。

その方法はこれまでのCustom instructionsと同じで、設定欄からテキストで指定するだけです。これでChatGPTとの会話がますます楽しくなりそうですね!

音声の選択

ChatGPTのAdvanced Voice Modeでは、事前に発表されていた4種類と今回発表された5種類で、合計9種類の音声が選べます。その内訳と概要は以下の通りです

Advanced Voice Modeで選べる音声

- Breeze :活気があり誠実な雰囲気

- Ember:自信に満ち楽観的な雰囲気

- Juniper:オープンで陽気な雰囲気

- Cove:冷静で率直な雰囲気

- Arbor:リラックスして多用途(New)

- Maple:明るく率直(New)

- Vale:明るく好奇心旺盛(New)

- Sol:賢くリラックス(New)

- Spruce:落ち着いていて安心感がある(New)

以上のとおり。「Sky」はお蔵入りになってしまいましたが、9種類もあればさまざまなシチュエーションに対応ができそうです。

Advanced Voice Modeの料金と対応プラン

非常に高性能な Advanced Voice Mode は、ChatGPT の有料プランに加入することで利用可能です。特に、個人ユーザー向けには ChatGPT Plus が月額 約2,960円($20) で提供されており、Advanced Voice Mode もこの料金に含まれています。

一方、ChatGPT Team プランは、月額 約4,440円/人($30、月払い) または 約3,700円/人($25、年払い・2人以上) という設定で、こちらにも Advanced Voice Mode の利用権が含まれます。

さらに、より高度な機能や無制限アクセスを提供する ChatGPT Pro は月額 約29,600円($200) で、こちらも Advanced Voice Mode を完全に利用可能です。(※)

なお、無料版の ChatGPT アプリでは Standard Voice 機能は使用できますが、Advanced Voice Mode のような滑らかで表現力豊かな音声体験は得られません。したがって、この機能を最大限に活用したい方は、上記有料プランへのアップグレードを検討されるのがよいでしょう。

※価格は全て記事執筆時点(2025年8月上旬)の為替レート(1ドル=約148円)に基づいて計算しています。

ChatGPT searchの使用

2024年12月16日、OpenAIはすべてのChatGPTユーザーに向けてWeb検索機能「ChatGPT Search」の提供を開始し、この機能をAdvanced Voice Modeにも統合する計画を明らかにしました。

当時の発表では具体的な実装日程は示されませんでしたが、その後も機能開発が進められており、現時点(2025年8月)でも対応拡大が順次行われている状況です。

実装後は下記のとおり、Advanced Voice Modeから音声会話形式でWeb検索・調べ物ができるようになります。デモ動画では「12月23日・チューリッヒでのイベント」について音声で質問していて……

このように見事、音声で回答が得られていました。今後はAdvanced Voice Mode×ChatGPT searchで、料理中にレシピを調べたり、運転中に観光スポットを調べたりといったことができそうです。

なお、GPT-4oの活用事例について詳しく知りたい方は、下記の記事を合わせてご確認ください。

ChatGPTのAdvanced Voice Modeの注意点

続いては、ChatGPTのAdvanced Voice Modeを使うにあたって注意したい点を4つご紹介します。まずは、新機能の恒例「使用制限」から詳細をどうぞ!

1日の使用量に制限が存在

Advanced Voiceでは、1日の使用量に制限が設けられています。

この制限は決まった回数によるものではなく、日毎に変動する仕様。残りの使用量は掴みづらいですが、アプリ版のChatGPT Plus / ChatGPT Teamの場合、制限の15分前には通知が届くようになっています。

ちなみに制限に達した後も、Standard Voiceで続きの会話が可能です。

StandardからAdvancedへの会話の引き継ぎは不可

先述のとおり、Advanced VoiceからStandard Voiceへの会話の引き継ぎは可能ですが、逆にStandard VoiceからAdvanced Voiceへの引き継ぎは不可。こちらは今後のChatGPTのアップデートを待ちましょう。

歌の生成は不可

GPT-4oはChatGPTでのリリース時に、歌唱能力を備えていることが明かされています。

ですが、Standard VoiceでGPT-4oの歌声を聴くことはできません。アーティストの権利尊重を目的として、歌唱を含む音楽コンテンツの出力が検閲されているとのことです。

GPTsでは未実装

ChatGPT内で作って使えるAIツール「GPTs」はAdvanced Voice Modeに未対応。現時点では、1種類の音声(Shimmer)によるStandard Voiceにのみ対応しています。ロールプレイング・シミュレーション系のGPTsへの実装は今後に期待です。

なお、GPTsについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

ChatGPTのAdvanced Voice Modeの使い方

ここからは、アプリ版ChatGPTでのAdvanced Voice Modeの使い方をお伝えしていきます。手始めに、会話の方法から詳しくみていきましょう!

会話の方法

アプリ版ChatGPT(Plus / Team限定)では、下記の流れでAdvanced Voice Modeによる会話が可能。会話の履歴は他のチャットと同じ一覧から、文字起こしが確認できます。

Advanced Voice Modeでの会話の流れ

- 画面右下の音声アイコンを選択して、中央に青い球体が表示される画面に遷移

- 画面左下マイクアイコンのミュートが解除されているかを確認

- 会話を開始

(以下、同じ流れで会話が続く) - 画面右下の終了アイコンを選択して、会話を終了

なお、Advanced Voice Modeによる会話はときどき、中断してしまうことがあります。その場合は……

- ヘッドフォンを使用する

- 車内Bluetooth・スピーカーフォンでの会話は避ける

- (iPhoneの場合)「声を分離」を有効にする

- ChatGPTのアプリを閉じて再起動する

- ChatGPTの音量を上げる

- 静かな環境に移動する

などの対策が有効です。

音声の選択

ChatGPTのAdvanced Voice / Standard Voiceを初めて使用する際には、返答時の音声を下記9種から1つ選べます。

- Breeze :活気があり誠実な雰囲気

- Ember:自信に満ち楽観的な雰囲気

- Juniper:オープンで陽気な雰囲気

- Cove:冷静で率直な雰囲気

- Arbor:リラックスして多用途

- Maple:明るく率直

- Vale:明るく好奇心旺盛

- Sol:賢くリラックス

- Spruce:落ち着いていて安心感がある

こちらは後からカスタマイズメニューで変更することも可能ですので、直感で選びましょう。

バックグラウンド会話

ChatGPTのAdvanced Voice / Standard Voiceでは、他のアプリ・電話の画面に遷移した状態でも会話(バックグラウンド会話)ができます。この機能を使いたい場合は、設定欄から「バックグラウンド会話」をオンにするだけでOKです。

ChatGPTのAdvanced Voice Modeの性能を検証してみた!

さて、ここからはお待ちかねの「Advanced Voice Mode」の検証に入ります。今回はAdvanced Voice Modeの実力を測るために……

- ロールプレイング

- 同音異義語を含む会話

- 方言の判別

の3つをアプリ版ChatGPTで試してみました。それではまず、ロールプレイングでの結果からご覧ください!

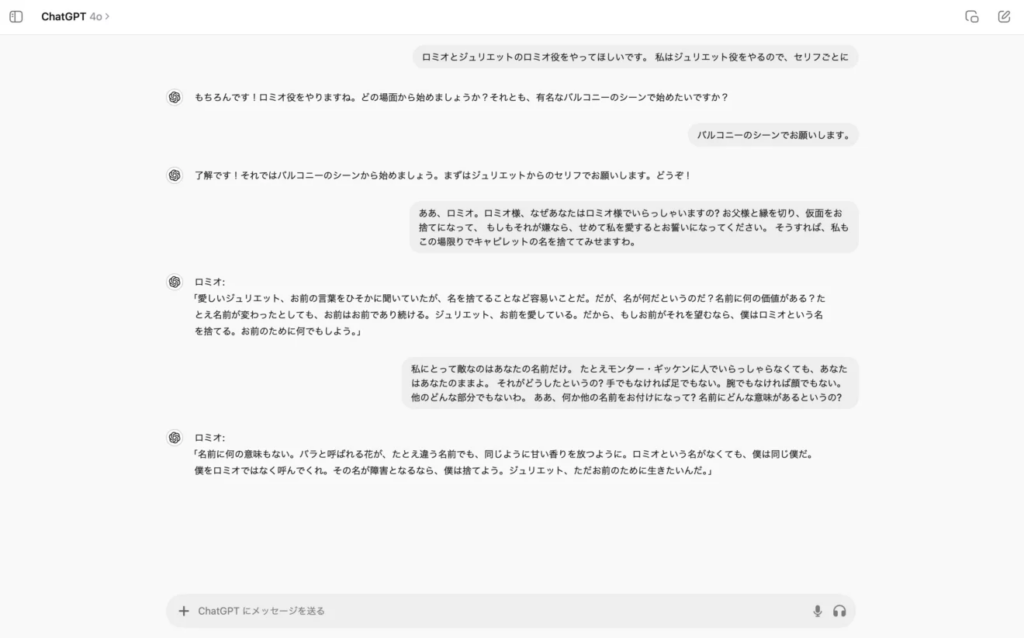

ロールプレイング

まずは、Advanced Voiceのお手並みを拝見!リサーチャーとChatGPTとで、『ロミオとジュリエット』からバルコニーのシーンをロールプレイングしてみます。ChatGPTをロミオ役に任命して、会話を始めてみると……

おっと……「愛しい / いとしい」が「あいしい」になっているなどなど、読み方のミスが目立ちます。それと、レスポンスの速度も若干遅れ気味です。日本語対応はまだまだ、なのかもしれませんね。

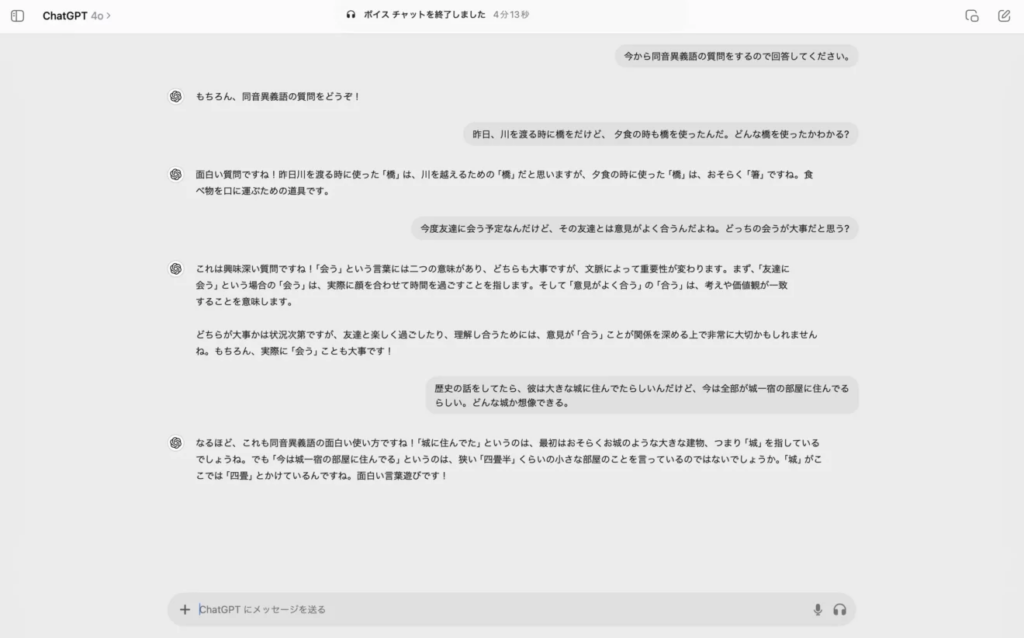

同音異義語を含む会話

続いては、読みは同じなのに意味は別物の「同音異義語」をAdvanced Voiceに聞き分けてもらいます。まずは、以下を含む例文について、それぞれChatGPTに語りかけてみましょう!

- はし:橋 / 箸

- あう:会う / 合う

- しろ:城 / 白

なるほど!ChatGPTのAdvanced Voiceは、回答生成時に文字起こしでのミスを補ってくれました。これはWhisper単体では実現できなかった夢の機能ですね。

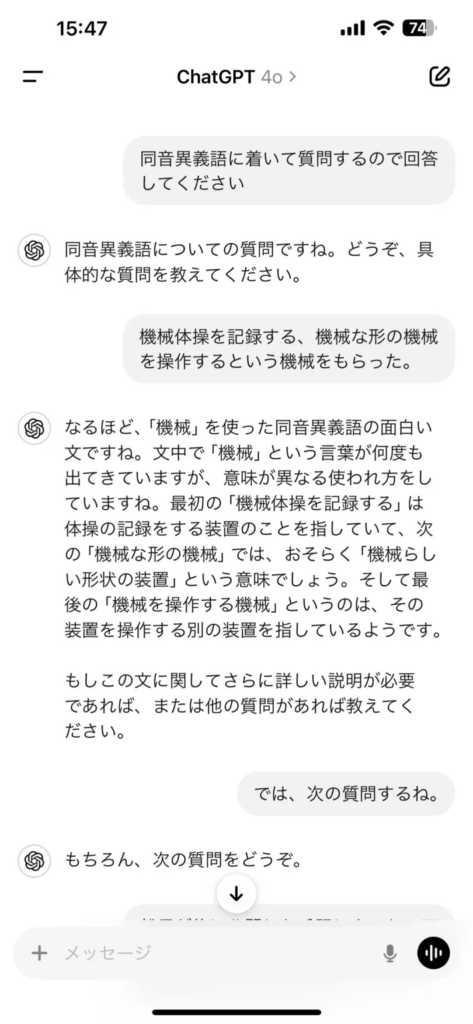

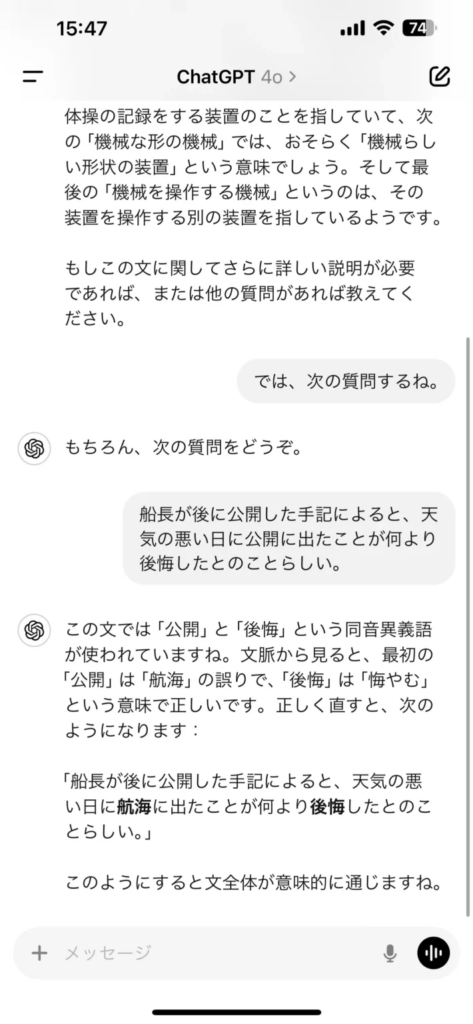

さて、今度は以下の同音異義語もAdvanced Voiceに識別してもらいます。気になる結果は……

- きかい:器械(体操)/ 奇怪 / 機械 / 機会

- こうかい:公開 / 航海 / 後悔

以上のとおり。「きかい」の判別には失敗していますが、「こうかい」はしっかり判別できています。これなら今後、GPT-4o搭載のインテリジェントな文字起こしAIツールが出てきてもおかしくはありませんね。

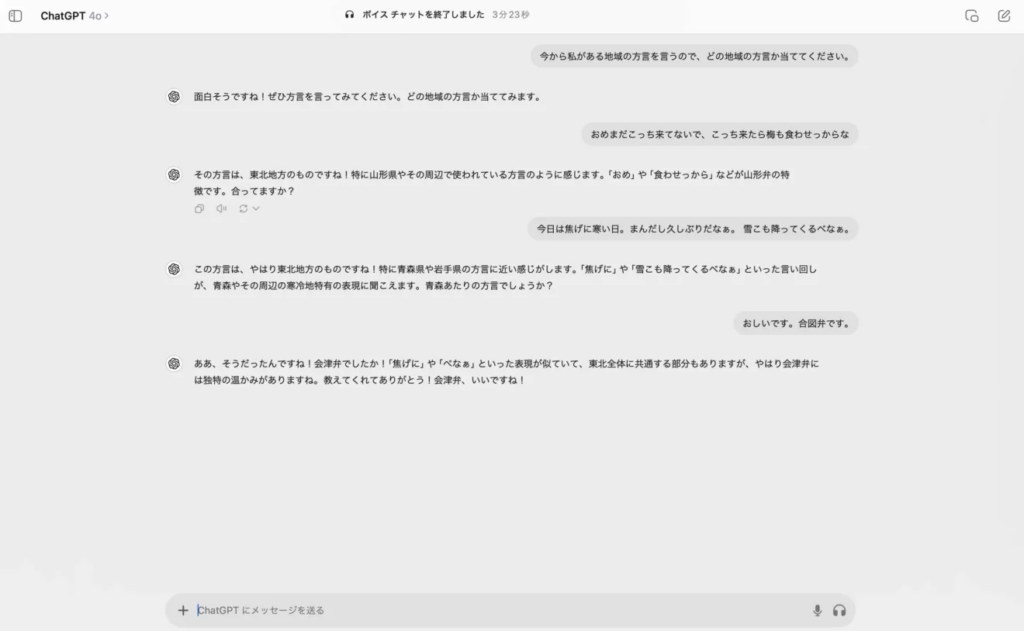

方言の判別

今度は、よりニッチなタスク「日本語の方言の判別」をAdvanced Voiceで試してみます。まずは、地域名を伏せた状態で東北方言(会津弁)をChatGPTに聴かせてみましょう!

お見事です!ChatGPTのAdvanced Voiceは、入力内容が東北地方の方言であることを看破しました。会津弁であることまでは特定できていませんが、それでも標準語以外の日本語までしっかりと理解できている様子です。

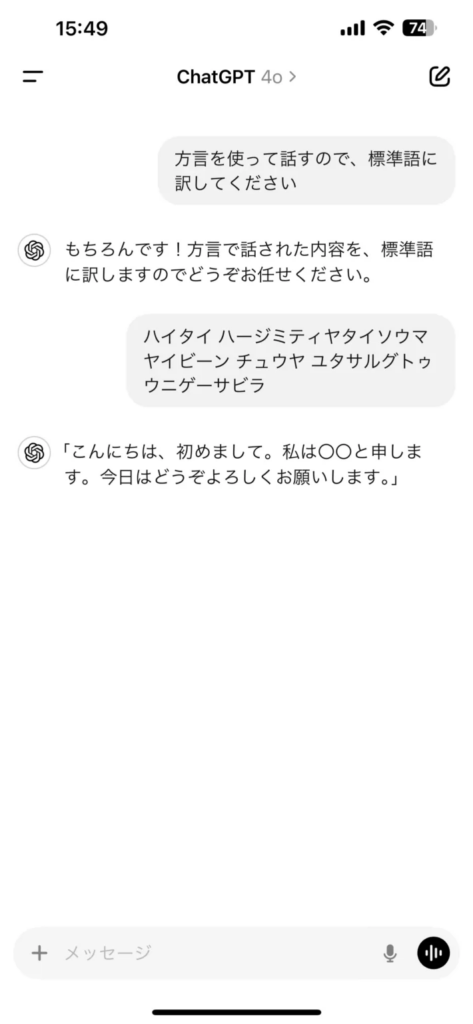

さて続いては、沖縄方言の例文についても地域名を伏せて入力、今度は標準語に訳してもらいます。気になる結果は……

こちらも大体正解。人名までは特定できませんでしたが、それでも非ネイティブの沖縄方言が認識できているのには驚きです!

ChatGPTのAdvanced Voice Modeの活用事例!

最後に、X(旧Twitter)で投稿されたAdvanced Voiceの活用事例をご紹介します。まずは、ChatGPTの開発元・OpenAIの投稿から、詳しくみていきましょう!

50以上の言語で「遅れてごめんなさい」

OpenAIは、ユーモアたっぷりなAdvanced Voiceの活用事例を投稿しています。

冒頭で述べたとおり、ChatGPTのAdvanced Voiceは発表後4ヶ月以上経ってからリリースがなされました。待ちに待っていた方も多いはずですよね。

その期待を受けてOpenAIは、Advanced Voice実装の告知に「50以上の言語で遅れてごめんなさいが言える」と添えています。デモ動画の内容もそれに準拠していて……

音声文字起こし&和訳

以上のとおり、ChatGPTの口から「遅れてごめんなさい」が聞けちゃうんです!何ともにくい演出ですね。

英語の訛りにも対応

続いては、英語圏の方言の事例です。以下の投稿では、ChatGPTのAdvanced Voiceにアイルランド訛りやアメリカ南部訛り、インド訛りの英語を喋らせています。気になるその結果は……

音声文字起こし&和訳

お見事!非英語話者のリサーチャーが聞いてもわかるほどに訛りが表現できています。

特に、インド訛りの事例では”Goverment”が「ガバルメン」となっており、インド特有の巻き舌で読む「R」が再現されていました。見知らぬ国でも、ChatGPTを使えば通訳ができちゃう……かもですね!

ビジネスシーンでの活用法

1. ブレインストーミングの壁打ち相手

新しい企画やアイデアに行き詰まった時、Advanced Voice Modeは最高の壁打ち相手になります。思いついたことを口頭で話すだけで、ChatGPTが即座にフィードバックをくれたり、別の視点を提供してくれたりします。思考を止めずにアイデアを深掘りできるため、創造的な作業の効率が格段に向上します。

2. プレゼンテーションや面接の練習

人前で話す練習にも最適です。プレゼンの内容をChatGPTに聞いてもらい、フィードバックを求めることができます。また、面接官役を依頼すれば、本番さながらの質疑応答のシミュレーションが可能です。AI相手なので、何度失敗しても気兼ねなく練習できるのが大きなメリットです。

3. 外国語での会議シミュレーション

海外の取引先との英語会議を控えている場合、ChatGPTを相手に予行演習ができます。「英語が堪能なビジネスパートナー」といった役割を設定し、会議の議題についてディスカッションすることで、専門用語の使い方や自然な言い回しを実践的に学ぶことができます。

よくある質問(FAQ)

最後に、Advanced Voice Modeに関してよく寄せられる質問にお答えします。

なお、superwhisperについて詳しく知りたい方は、下記の記事も合わせてご確認ください。

ChatGPT「Advanced Voice Mode」なら、自然な会話ができるかも!

当記事では、アプリ版ChatGPTの有料プラン限定で使える音声会話機能「Advanced Voice Mode」についてご紹介しました。

Advanced Voiceは、音声認識・回答生成・読み上げを1モデルでこなせるGPT-4oによって、従来のStandard Voice以上の会話体験をユーザーに提供しています。具体的にできることとしては……

ChatGPTの「Advanced Voice Mode」でできること

- 自然な音声会話

- 口調やアクセントの記憶

- 音声の選択

以上のとおり。ロールプレイングやシミュレーション等、エンタメ方面でのさらなる活躍が期待できそうです。

有料版ChatGPT(Plus / Team)ユーザーの方はぜひぜひ、このAdvanced Voiceを試してみてくださいね!

最後に

いかがだったでしょうか?

ChatGPTの音声会話機能をビジネス活用することで、顧客体験や業務効率を大幅に変革できます。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、通勤時間に読めるメルマガを配信しています。

最新のAI情報を日本最速で受け取りたい方は、以下からご登録ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。