Meta、画像理解可能なLlama 3.2を発表

Metaは、最新の大規模言語モデル「Llama 3.2」を発表しました。

この新モデルは、画像とテキストを同時に理解する能力を持ち、視覚的な情報処理を強化しています。

- Metaが画像理解可能なLlama 3.2を発表。

- 視覚理解に強く、多様な環境で利用可能。

- 音声機能強化で自然なAI対話を提供。

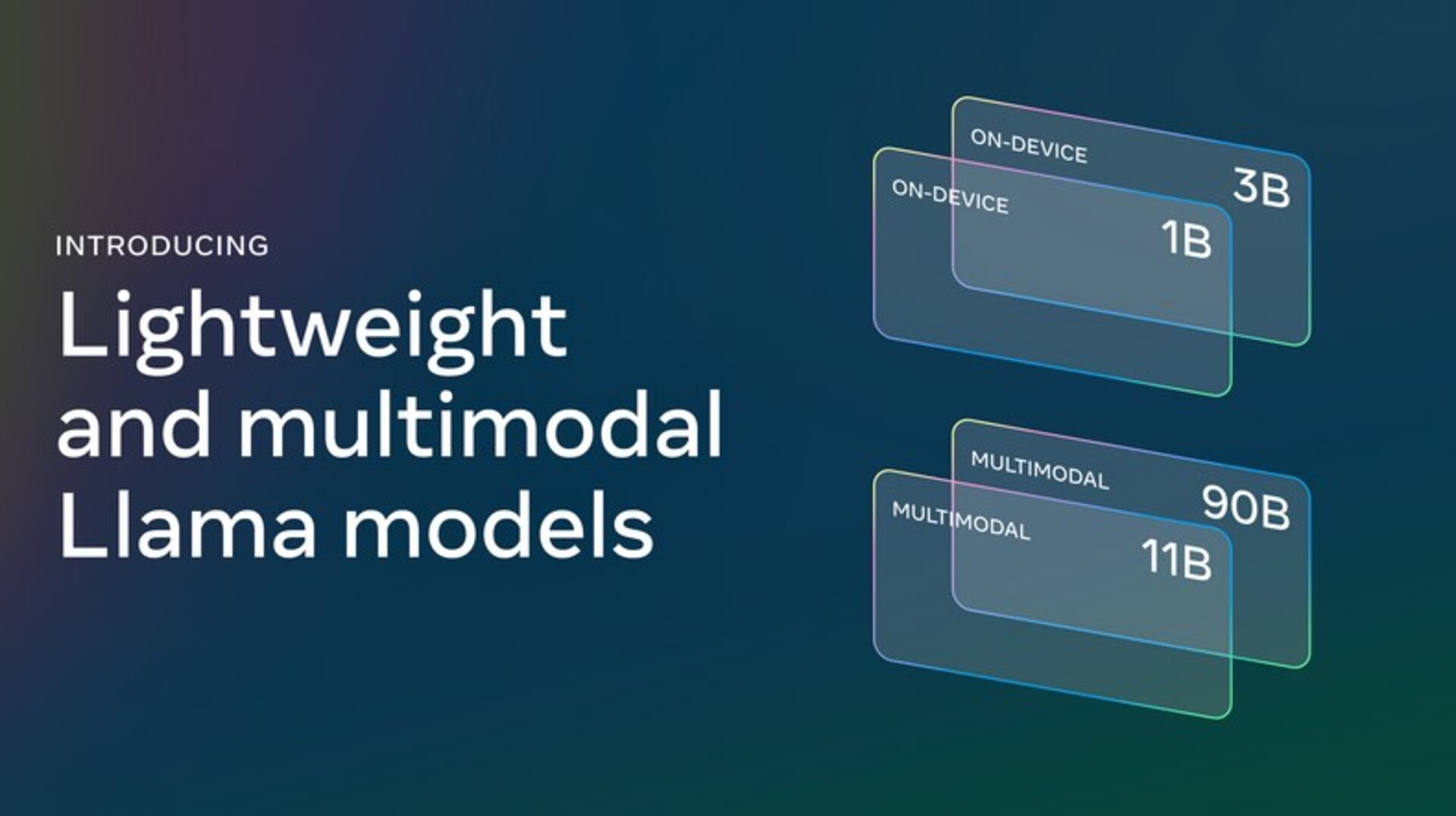

Llama 3.2には11Bと90Bのパラメーターを持つ中型モデルと、1Bおよび3Bパラメーターの軽量モデルが含まれ、さまざまなデバイスや環境で使用可能です。

これにより、視覚理解が求められるアプリケーションの幅が広がることが期待されています。

MetaのCEOであるマーク・ザッカーバーグ氏は、今回のモデルを「オープンソースのマルチモーダルモデル」として位置づけており、特にコスト効率やカスタマイズ性、信頼性の面で優れていると強調しました。

Llama 3.2は128,000トークンのコンテキスト長を持ち、より複雑なタスクに対応できる能力を備えています。

これにより、数百ページ規模のテキストを入力しても処理が可能です。

さらに、Metaは初めてLlamaスタックの公式配布を開始し、オンプレミスやクラウドなど多様な環境での開発を支援しており、同社はこのモデルがAI業界の標準となる可能性があると見ています。

Llama 3.2の中でも、11Bと90Bの大型モデルは、チャートやグラフの理解、画像のキャプション作成など、視覚情報の処理に特化しており、特定の月の売上パフォーマンスをグラフから分析するなどの高度な機能を提供します。

また、軽量モデルはプライベート環境でのエージェントアプリの開発を支援し、個別のメッセージ要約やスケジュール管理などに役立つでしょう。

Metaによると、Llama 3.2はAnthropicのClaude 3 HaikuやOpenAIのGPT4o-miniに対抗する性能を持ち、特に画像認識や視覚理解の分野で競争力があります。

Llama 3.2はllama.comやHugging Faceでダウンロードが可能で、多くの開発者に利用されています。

また、Metaは音声機能を強化し、有名人の声で応答する新機能も提供しています。Meta AIはこれにより、より自然なコミュニケーション手段を提供し、WhatsAppやMessengerなどのプラットフォームでの利便性を向上させています。

ザッカーバーグ氏は、音声がテキストよりも直感的なAIとのやり取りの手段になると述べました。

参考記事:Meta

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、朝の通勤時間に読めるメルマガを配信しています。

最新のAI情報を日本最速で受け取りたい方は、以下からご登録ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。