Gemini Deep Research agentとは?並列探索で調査精度を高めるGoogleのリサーチ特化AI

- 「即答」ではなく、並列探索と検証を前提に精度を最大化する設計

- 調査系ベンチマークでは、汎用LLMよりも情報収集・統合タスクに強みを示す

- 時間をかけるほど正解率が向上するため、レポートや意思決定用途に適している

2025年12月、Googleから新たなAIサービスが登場!

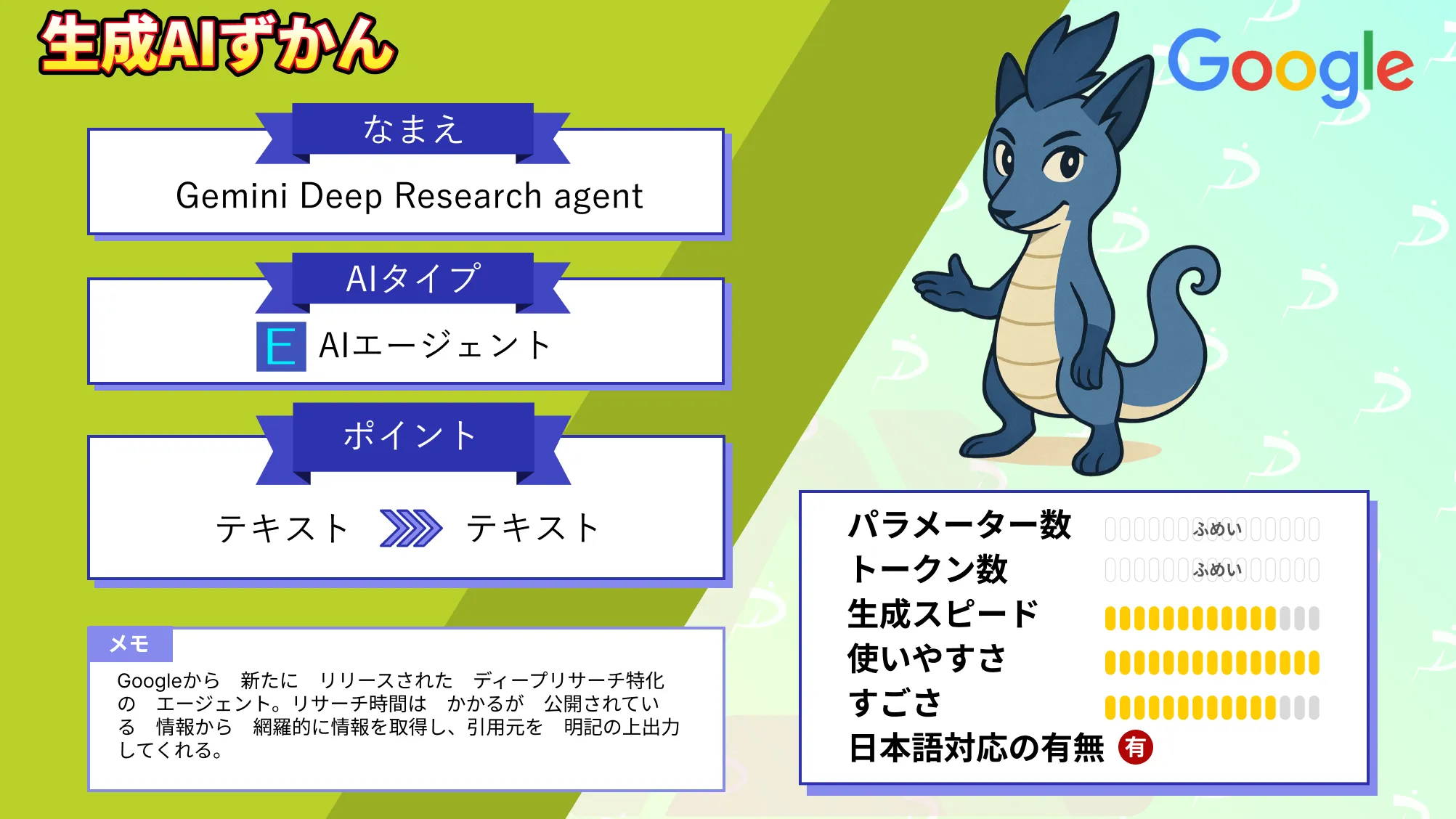

今回リリースされた「Gemini Deep Research agent」は長時間のリサーチ・レポート作成・引用資料添付、というリサーチに特化したサービスです。

本記事ではGemini Deep Research agentの概要から仕組み、実際に使ってみた所感について解説をします。本記事を最後までお読みいただければ、Gemini Deep Research agentの理解が深まります。

ぜひ最後までお読みください!

\生成AIを活用して業務プロセスを自動化/

Gemini Deep Research agentの概要

Gemini Deep Research agentは、複数ステップのリサーチタスクを自律的に計画し、実行から統合まで進めるエージェントです。 長時間の情報収集と要点の統合に最適化されており、「調べてまとめる」をアプリケーション側へ組み込みやすくなったと言えるでしょう。さらにレポートは引用文献付きで出力可能。

「人が何時間もかけて一次情報を読み込む工程」を短縮したい場面で、検討対象に入ってくるのではないでしょうか。

Gemini Deep Research agentはGemini 3 Proを搭載し、Web検索とユーザーのデータを使って複雑な情報をリサーチしてくれます。リサーチでは反復的な検索と読み取りが走り、完了までは数分かかるため、バックグラウンド実行で開始し、結果をポーリングして受け取る運用が前提になります。

Gemini Deep Research agentの仕組み

Gemini Deep Research agentは単一の生成処理ではなく、計画と実行を分離した設計が採用されており、「入力して即応答」という従来のLLM利用とは異なります。

まずGemini Deep Research agentの中心となるのは、ユーザーから与えられた調査テーマを複数のサブタスクへ分解するプロセスです。

エージェントは最初にリサーチ計画を立案し、どの順序で情報を集めるかを内部的に決定。この段階で検索クエリの生成や参照先の整理が行われ、以降の処理の土台となります。このフェーズは、人がリサーチメモを作ってから検索を始める工程を、自動化した構造と言えるでしょう。

次に、実行フェーズではWeb検索やURLコンテキストを使い、公開情報の取得と読み込みが繰り返されます。この処理は一度で終わらず、必要に応じて再検索や追加調査が走る設計です。そのため、レスポンスは即時ではなく、バックグラウンド実行として開始される形になっています。

処理完了後は、ポーリングによって結果を取得する方式が採られています。収集された情報は、そのまま列挙されるわけではありません。Gemini Deep Research agentは、得られた複数の情報源を統合し、レポート形式へまとめ上げます。

この際、参照した情報源が引用として付与される点も特徴的。根拠を確認できるアウトプットが前提となっていることが、業務用途では重要なポイントでしょう。

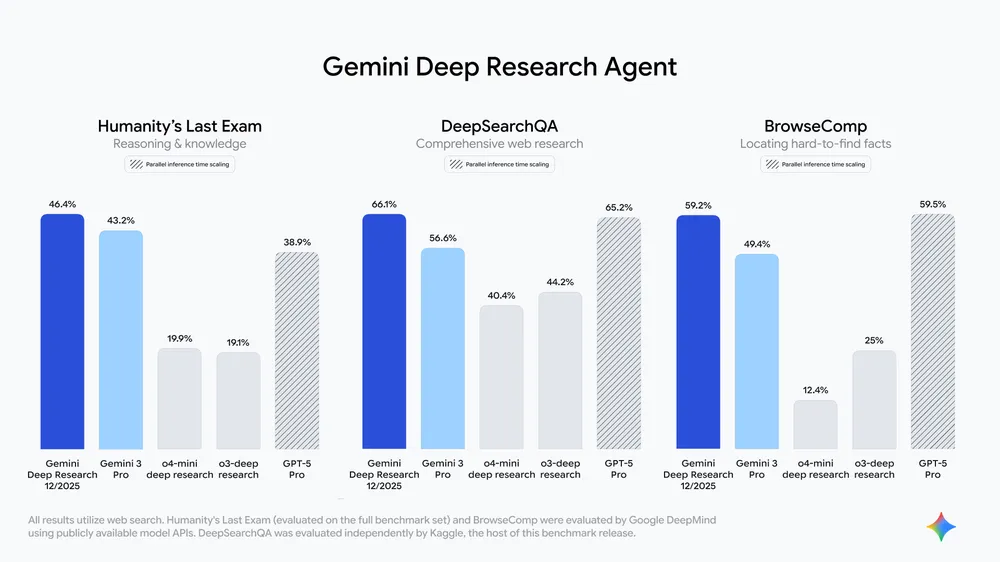

また、下記のグラフが示しているように、Deep Research専用エージェントが、調査タスクで最も高い精度を出しており、特にWebを横断して複数情報を突き合わせ1つの結論にまとめるというタイプのベンチマークで優れていることがわかります。

さらに、独自データを扱う場合の拡張も用意されています。

file_searchツールを追加することで、ユーザーが指定したファイルを調査対象に含めることが可能です。ただし、Deep Researchにおけるfile_searchの利用は試験的な位置付けとなっています。社内文書を横断的に調べさせたいケースでは、この制約を踏まえた設計判断が求められると考えられます。

なお、AIエージェントで業務を自動化するGoogle Workspace Studioについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Gemini Deep Research agentの特徴

Gemini Deep Research agentは単なるテキスト生成ではなく「調査エージェント」として設計されています。

特に、長時間かつ多段階の情報探索を前提にした設計です。

複数ステップの自律的リサーチ設計

Gemini Deep Research agentの大きな特徴は、リサーチ計画から実行までを自律的に進める点。ユーザーはリサーチテーマを与えるだけでよく、細かな検索指示を逐一指定する必要はありませんでした。

エージェント自身がタスクを分解し、必要な情報収集を反復的に行う構成となっています。この仕組みにより、人手による調査工数を大幅に削減できる可能性があります。

引用付きレポートの自動生成

調査結果は、単なる文章生成ではなく、引用元を明示したレポート形式で出力されます。

どの情報がどのソースに基づいているかを確認できる設計が採用され、内容の妥当性を検証しながら利用できます。このように引用付きレポートが出力されることで、意思決定や社内共有資料として使いやすいアウトプットになります。

バックグラウンド実行を前提とした処理モデル

Gemini Deep Research agentは即時応答型ではなく、バックグラウンドでの長時間処理を前提としています。

調査の開始後、完了までに数分を要するケースがあるとされています。このため、非同期実行とポーリングによる結果取得が標準的な利用方法となっています。

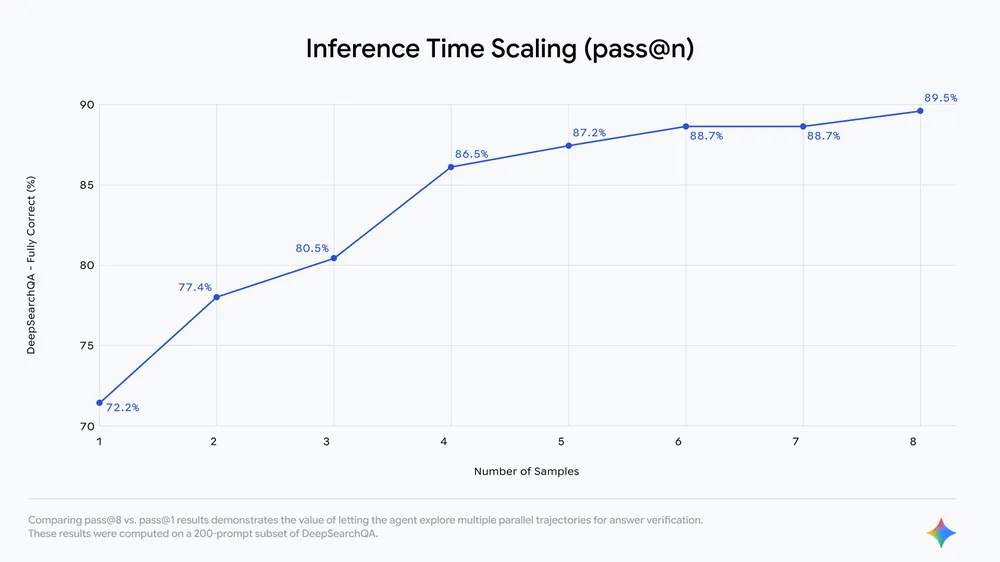

時間はかかってしまいますが、上記グラフのように1回で答えを出すより、複数の調査ルートを並行探索した方が精度が上がることがわかっています。そのため、リアルタイム性よりも調査の網羅性を重視した設計がポイントです。

Web情報への標準アクセス

デフォルト設定では、google_searchやurl_contextを利用し、公開Web上の情報を調査対象とします。

これにより、特定分野に限定されない幅広い情報収集が可能になりました。一方で、情報源は公開Webが中心となるため、非公開情報は含まれません。公開情報を横断的に整理したい用途に適していると考えられます。

独自データ連携の拡張余地

追加設定としてfile_searchツールを利用すれば、ユーザーが指定したファイルも調査対象に含められます。

社内資料や独自ドキュメントを横断的に調べる使い方が想定されています。ただし、Deep Researchでのfile_searchは試験運用版という位置付けです。本格的な業務利用では、この点を踏まえた検証が必要になるでしょう。

Gemini Deep Research agentの安全性・制約

Gemini Deep Research agentは高機能なリサーチエージェントである一方、万能ではない点を理解しておくことが重要です。

導入判断では「何ができるか」だけでなく「どこに限界があるか」にも目を向ける必要があるでしょう。

まず、安全性の観点では、Deep Research agentがアクセスする情報源が明確に定義されています。デフォルトでは公開Web上の情報を対象としており、google_searchやurl_contextを通じてデータを取得します。そのため、クローズドなデータベースや認証が必要な情報には直接アクセスしません。

意図しない内部情報の取得を防ぐ設計が前提になっている点がポイントです。

データの取り扱いについても、一定の制約があります。

エージェントは調査を実行する過程で外部情報を参照しますが、取得した内容を恒久的に保存する仕組みについては公式情報では明らかにされていません。このため、機密性の高い情報をそのまま入力する使い方には注意が必要です。

機能面での制約として、処理が非同期である点も押さえておくべき要素です。Gemini Deep Research agentは即時応答を保証するものではなく、調査完了までに数分を要する場合があります。そのため、バッチ処理やレポート生成向けの用途に適した機能と言えるでしょう。

Gemini Deep Research agentの料金

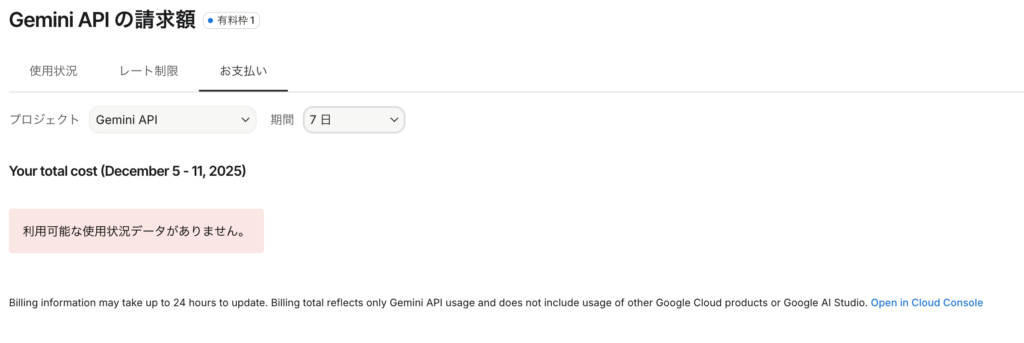

本記事執筆(2025年12月)時点で、Gemini Deep Research agentはプレビュー版として提供されています。

具体的なAPI料については記載を見つけることができませんでした。

APIは呼ばれてはいるものの、課金されていないのでもしかしたらプレビュー版は無料で使えるのか、反映が遅いのかもしれません。

Gemini Deep Research agentのライセンス

Gemini Deep Research agentのライセンスについて、明示されている文章を見つけることはできませんでしたが、プライバシーポリシーと利用規約から以下のように考えられます。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | ❌ |

| 配布 | ❌ |

| 特許使用 | 明示的には記載なし |

| 私的使用 | ⭕️ |

なお、エージェント主導の次世代IDEであるGoogle Antigravityについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Gemini Deep Research agentの実装方法

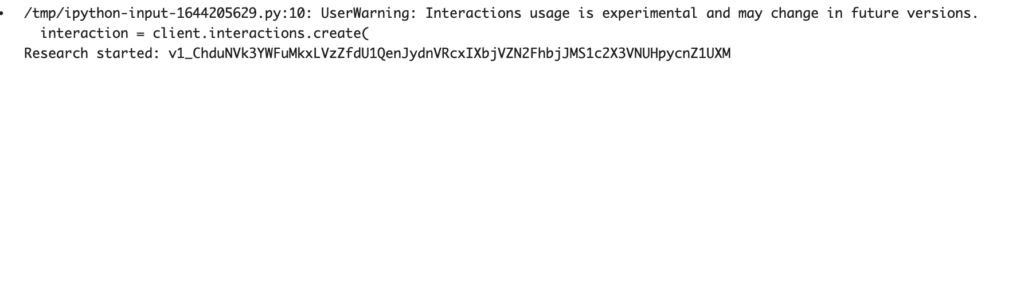

では実際にGemini Deep Research agentを実装していきます。Interactions API経由での利用となります。

まずは必要ライブラリのインストール。

!pip -q install -U google-genaiコードを実行するにあたり、GEMINIのAPIキーが必要になるので、まだ取得していない場合にはGoogle AI Studioから取得してください。

サンプルコードはこちら

import time

from google import genai

API_KEY = "YOUR_GEMINI_API_KEY_HERE"

client = genai.Client(api_key=API_KEY)

interaction = client.interactions.create(

input="Research the history of Google TPUs.",

agent="deep-research-pro-preview-12-2025",

background=True

)

print("Research started:", interaction.id)

while True:

interaction = client.interactions.get(interaction.id)

if interaction.status == "completed":

print(interaction.outputs[-1].text)

break

if interaction.status == "failed":

print("Research failed:", interaction.error)

break

time.sleep(10)結果はこちら

/tmp/ipython-input-1644205629.py:10: UserWarning: Interactions usage is experimental and may change in future versions.

interaction = client.interactions.create(

Research started: v1_ChduNVk3YWFuMkxLVzZfdU1QenJydnVRcxIXbjVZN2FhbjJMS1c2X3VNUHpycnZ1UXM

# The History and Evolution of Google Tensor Processing Units (TPUs): From Internal Crisis to the Age of Inference

### Key Points

* **Origins in Necessity:** The TPU project was initiated in 2013 after Jeff Dean calculated that enabling voice search for all Android users would require doubling Google's global data center footprint if relying on standard CPUs.

* **Architectural Divergence:** Unlike GPUs, which rely on massive parallel threading (SIMT), TPUs utilize **systolic arrays**, a design that mimics the flow of blood through the heart to maximize data reuse and minimize memory access energy costs.

* **Generational Trajectory:** The lineage began with **TPU v1 (2015)** strictly for inference, pivoted to training with **TPU v2 (2017)** and **v3 (2018)**, introduced optical switching in **TPU v4 (2021)**, and bifurcated into efficiency and performance lines with **TPU v5 (2023)**.

* **Recent Innovations:** The **TPU v6 (Trillium)** and **TPU v7 (Ironwood)** represent a return to inference optimization ("The Age of Inference"), featuring massive High Bandwidth Memory (HBM) capacities and native FP8 support to handle generative AI models.

* **Ecosystem Impact:** The development of the TPU necessitated the creation of the **bfloat16** numerical format, now an industry standard, and the XLA (Accelerated Linear Algebra) compiler.

---

## 1. Introduction: The Computational Crisis of 2013

The history of the Google Tensor Processing Unit (TPU) is not merely a story of silicon fabrication, but a narrative of architectural survival. By the early 2010s, the slowing of Moore’s Law collided violently with the explosive computational demands of deep learning.

In 2013, a pivotal internal projection catalyzed Google's hardware strategy. Jeff Dean, a Google Senior Fellow, and his team performed a "back-of-the-envelope" calculation regarding the company's emerging voice search capabilities. They estimated that if every Android user utilized voice search for just three minutes per day, the computational load of the requisite speech recognition models would compel Google to double its global data center capacity [cite: 1, 2].

This projection revealed that General Purpose Graphics Processing Units (GPGPUs) and Central Processing Units (CPUs) were insufficient for the specific mathematics of deep learning at Google's scale. CPUs were too slow due to the Von Neumann bottleneck, and GPUs, while powerful, consumed excessive energy for the specific matrix operations required by TensorFlow. Consequently, Google initiated a secretive "crash program" to design a Domain Specific Architecture (DSA) optimized exclusively for machine learning [cite: 3, 4]. The result was the TPU, an Application-Specific Integrated Circuit (ASIC) that would remain a trade secret until its unveiling in 2016.

---

## 2. Architectural Philosophy: The Systolic Array

To understand the evolution of the TPU, one must understand the fundamental divergence in its design philosophy compared to CPUs and GPUs. The core innovation of the TPU is the **Systolic Array**.

### 2.1 The Von Neumann Bottleneck vs. Systolic Execution

In traditional CPU and GPU architectures, the Arithmetic Logic Units (ALUs) fetch data from memory, perform an operation, and write the result back to memory (registers or cache). For matrix multiplication—the primary operation in neural networks—this results in a massive "Von Neumann bottleneck," where energy and time are wasted moving data back and forth.

The TPU utilizes a systolic array architecture, a concept dating back to HTK and Charles's 1983 patent and research by H.T. Kung [cite: 5, 6]. In a systolic array, data flows through a grid of ALUs like blood through a heart (hence "systolic").

* **Weight Stationary:** Model weights are pre-loaded into the array and stay stationary.

* **Data Flow:** Activation data flows in from one direction, interacts with the weights, and partial sums are passed directly to the next ALU in the sequence without writing back to memory [cite: 4, 7].

This design allows the TPU to perform tens of thousands of multiply-accumulate (MAC) operations per cycle with significantly reduced power consumption compared to the "fetch-decode-execute" cycle of general-purpose processors [cite: 6].

---

## 3. TPU v1: The Inference Pioneer (2015–2016)

**Status:** Inference Only

**Process:** 28nm

**Clock Speed:** 700 MHz

Deployed internally in 2015 and announced at Google I/O 2016, the first-generation TPU was a single-purpose accelerator designed strictly for **inference**—the process of running a trained model to make predictions [cite: 8, 9].

### 3.1 Specifications and Performance

The TPU v1 was built on a 28nm process and ran at 700 MHz. It featured a massive **256 × 256 systolic array** capable of performing 8-bit integer (INT8) operations.

* **Throughput:** It could execute 65,536 multiply-accumulate operations per cycle, translating to approximately **92 TeraOps/second (TOPS)** [cite: 6].

* **Memory:** It utilized 28 MiB of on-chip software-managed memory (Unified Buffer) to minimize off-chip access.

* **Interface:** It connected to the host server via a PCIe Gen3 x16 bus, functioning as a coprocessor similar to a floating-point unit (FPU) [cite: 10].

### 3.2 Impact

The TPU v1 was instrumental in Google's dominance in AI services. It powered Google Search (RankBrain), Google Translate, and the AlphaGo system that defeated Lee Sedol in 2016 [cite: 11]. In production workloads, it demonstrated **15x to 30x faster performance** and **30x to 80x better performance-per-watt** than contemporary CPUs (Haswell) and GPUs (NVIDIA K80) [cite: 12, 13].

---

## 4. TPU v2: The Training Pivot (2017)

**Status:** Training and Inference

**Introduction:** Cloud TPU

**Key Innovation:** bfloat16, HBM

While v1 solved the inference crisis, training large models remained a bottleneck. Training requires higher precision than inference (to capture gradient descent nuances) and significantly more memory bandwidth. In 2017, Google unveiled TPU v2, a complete redesign aimed at training [cite: 13].

### 4.1 Architecture Changes

* **Floating Point Support:** Unlike v1's integer-only math, v2 introduced support for floating-point calculations.

* **bfloat16 (Brain Floating Point):** Google introduced a custom numerical format, bfloat16. It retained the range of a standard 32-bit float (FP32) but reduced the precision (mantissa) to 16 bits. This allowed for the speed of half-precision computing without the loss of dynamic range that often caused training to diverge in standard FP16 [cite: 13].

* **Systolic Array Reconfiguration:** The single 256x256 array of v1 was replaced by **two 128x128 MXUs (Matrix Multiply Units)** per core. This provided better utilization for smaller batch sizes [cite: 13].

* **High Bandwidth Memory (HBM):** To feed the training workload, v2 incorporated 16 GB of HBM per chip, providing 600 GB/s of bandwidth [cite: 3, 10].

### 4.2 The TPU Pod

TPU v2 introduced the concept of the **TPU Pod**. Using a custom Inter-Chip Interconnect (ICI), 64 TPU v2 devices (256 chips) could be connected into a 2D torus topology, functioning as a single supercomputer with 11.5 petaFLOPS of performance [cite: 10]. This allowed Google to offer "Cloud TPUs" to external customers for the first time.

---

## 5. TPU v3: Liquid Cooling and Density (2018)

**Status:** High-Performance Training

**Key Innovation:** Liquid Cooling

Announced in May 2018, TPU v3 was an evolutionary step focused on power density and thermal management. As Moore's Law slowed, increasing performance required pushing power limits.

### 5.1 Specifications

* **Performance:** TPU v3 delivered roughly **2x the performance** of v2, achieving roughly 100 petaFLOPS per pod [cite: 14].

* **Memory:** HBM capacity was doubled to 32 GB per chip.

* **Thermal Engineering:** The chips ran so hot that Google implemented **liquid cooling** directly to the chip within the data center racks—a first for Google's massive-scale infrastructure [cite: 8, 14].

### 5.2 Pod Scaling

The v3 Pods were scaled up to **1,024 chips**, offering an 8-fold increase in total system performance compared to v2 Pods [cite: 10]. This generation solidified the TPU's role in training massive models like BERT.

---

## 6. TPU v4: The Optical Revolution (2021)

**Status:** Warehouse-Scale Supercomputing

**Key Innovation:** Optical Circuit Switching (OCS), SparseCores

TPU v4, announced in 2021, marked a radical shift in data center networking. It was designed to solve the connectivity bottlenecks inherent in scaling to thousands of chips.

### 6.1 Optical Circuit Switching (OCS)

Previous TPU generations used electrical cables for the Inter-Chip Interconnect (ICI). TPU v4 introduced **Optical Circuit Switches (OCS)**. These MEMS-based mirrors could physically reconfigure the network topology in milliseconds [cite: 13, 15].

* **Dynamic Topology:** The OCS allowed the system to route around failed chips dynamically and change the topology (e.g., 3D torus, twisted torus) to suit specific model architectures [cite: 15, 16].

* **Scale:** A single v4 Pod contained **4,096 chips**, delivering over 1 exaFLOP of compute power [cite: 14].

### 6.2 SparseCores

TPU v4 publicly disclosed the existence of **SparseCores**—specialized dataflow processors integrated into the TPU die. While present since v2, they were formally detailed with v4. SparseCores are optimized for **embeddings** (common in recommendation systems), accelerating these specific workloads by 5x–7x while occupying only ~5% of the die area [cite: 15].

### 6.3 Performance

TPU v4 offered a 2.1x performance increase over v3 and a 2.7x improvement in performance-per-watt [cite: 15]. It was manufactured on a 7nm process node [cite: 10].

---

## 7. TPU v5: Bifurcation and Specialization (2023)

In 2023, Google acknowledged that the AI market had split into two distinct needs: cost-effective training/inference and massive-scale frontier model training. Consequently, the TPU line bifurcated.

### 7.1 TPU v5e (Efficiency)

Launched to target the "efficiency" segment, TPU v5e was optimized for performance-per-dollar.

* **Design:** It returned to a smaller physical footprint with **one TensorCore per chip** (down from two in v4) and utilized a 2D torus topology [cite: 13].

* **Specs:** 197 TFLOPS (BF16) and 16 GB HBM2 [cite: 17, 18].

* **Use Case:** Ideal for inference and training mid-sized models where cost is the primary constraint.

### 7.2 TPU v5p (Performance)

Announced later in 2023, v5p was the "performance" variant designed to compete with the NVIDIA H100.

* **Specs:** 459 TFLOPS (BF16) and **95 GB of HBM** per chip [cite: 19].

* **Scaling:** It supported massive scalability, with pods containing up to **8,960 chips** [cite: 13].

* **Interconnect:** It utilized a high-speed 3D torus topology with 4,800 Gbps of ICI bandwidth per chip [cite: 13].

---

## 8. TPU v6 (Trillium): The Efficiency Powerhouse (2024)

Announced in May 2024, the sixth generation, codenamed **Trillium** (also referred to as v6e), focused on maximizing the "bang for the buck" and energy efficiency for the Gemini era.

### 8.1 Key Specifications

* **Performance:** Trillium delivers a **4.7x increase in peak compute performance** per chip compared to TPU v5e [cite: 17, 20].

* **Memory:** HBM capacity and bandwidth were doubled compared to v5e (32 GB HBM per chip) [cite: 17, 21].

* **Matrix Units:** Trillium expanded the MXU size back to **256 x 256**, quadrupling the FLOPs per cycle compared to the 128x128 design of v5e [cite: 13].

* **Energy:** It achieved a 67% increase in energy efficiency over v5e [cite: 20].

Trillium was designed to be the "most flop-dense TPU to date," capable of scaling to building-scale supercomputers using Google's Jupiter data center network [cite: 20].

---

## 9. TPU v7 (Ironwood): The Age of Inference (2025)

Unveiled in April 2025, TPU v7, codenamed **Ironwood**, marks a strategic pivot back to the roots of the TPU: inference. However, unlike v1, Ironwood is designed for *generative* inference—running massive "thinking models" like Gemini 2.5 and Claude [cite: 22, 23].

### 9.1 The "Age of Inference"

Google executives described Ironwood as the hardware for the "Age of Inference," where AI agents proactively generate insights rather than just responding to queries. This requires massive memory and low latency [cite: 23, 24].

### 9.2 Technical Specifications

* **Memory:** A staggering **192 GB of HBM** per chip (6x that of Trillium) [cite: 25, 26]. This allows entire large language models to fit on fewer chips, reducing latency.

* **Compute:** 4,614 TFLOPS (FP8) per chip [cite: 19, 25].

* **Precision:** Ironwood is the first TPU to feature native **FP8 (8-bit floating point)** support, optimizing for the lower precision requirements of inference without sacrificing model quality [cite: 3, 27].

* **Power Efficiency:** 2x performance-per-watt compared to Trillium [cite: 22].

* **Scale:** Ironwood pods can scale to **9,216 chips**, delivering 42.5 ExaFLOPS of FP8 compute [cite: 23].

### 9.3 SparseCore Evolution

Ironwood includes 3rd-generation SparseCores (4 per chip) to handle the embedding-heavy workloads of recommendation systems and large vocabulary LLMs [cite: 19].

---

## 10. Edge TPU: AI for the IoT (2018–Present)

While Cloud TPUs dominated the data center, Google identified a need for local processing on Internet of Things (IoT) devices.

* **Launch:** Announced in July 2018 under the **Coral** brand [cite: 10].

* **Specs:** The Edge TPU is a small ASIC capable of **4 TOPS** (trillion operations per second) while consuming only **2 Watts** of power [cite: 10].

* **Application:** It allows devices (cameras, sensors, Raspberry Pis) to run TensorFlow Lite models locally, preserving privacy and reducing latency by avoiding cloud round-trips [cite: 28, 29].

---

## 11. Comparative Analysis: TPU Generations

The following table summarizes the evolution of the Cloud TPU specifications.

| Feature | TPU v1 | TPU v2 | TPU v3 | TPU v4 | TPU v5p | Trillium (v6e) | Ironwood (v7) |

| :--- | :--- | :--- | :--- | :--- | :--- | :--- | :--- |

| **Year** | 2015 | 2017 | 2018 | 2021 | 2023 | 2024 | 2025 |

| **Primary Focus** | Inference | Training | Training | Scale | Performance | Efficiency | Inference |

| **MXU Size** | 256x256 | 128x128 (x2) | 128x128 (x2) | 128x128 (x4) | 128x128 (x2) | 256x256 | 256x256 |

| **Precision** | INT8 | BF16 | BF16 | BF16 | BF16 | BF16 | FP8 / BF16 |

| **HBM/Chip** | N/A (SRAM) | 8 GB | 16 GB | 32 GB | 95 GB | 32 GB | 192 GB |

| **Peak TFLOPS** | 92 (TOPS) | 45 | 123 | 275 | 459 | 918 | 4,614 (FP8) |

| **Interconnect** | PCIe | 2D Torus | 2D Torus | 3D Torus (OCS) | 3D Torus | 2D Torus | 3D Mesh |

| **Max Pod Size** | N/A | 256 chips | 1,024 chips | 4,096 chips | 8,960 chips | 256 chips | 9,216 chips |

*Note: Data compiled from sources [cite: 8, 10, 13, 19, 20, 25]. TFLOPS values refer to bfloat16 unless otherwise noted.*

---

## 12. Software Ecosystem: The Hidden Half

The hardware evolution of the TPU is inextricably linked to its software. The complexity of the systolic array required a compiler capable of managing data flow with extreme precision.

* **XLA (Accelerated Linear Algebra):** A domain-specific compiler that optimizes linear algebra computations. It "fuses" operations to prevent the TPU from writing intermediate results to memory, maximizing the efficiency of the systolic array [cite: 30].

* **Frameworks:** Initially built for **TensorFlow**, the TPU ecosystem has expanded to support **JAX** and **PyTorch** (via PyTorch/XLA), broadening its adoption among researchers [cite: 10, 31].

---

## 13. Conclusion

The history of the Google TPU is a testament to the power of vertical integration. By controlling the entire stack—from the datacenter architecture (liquid cooling, OCS) to the chip design (systolic arrays, SparseCores) and the software (TensorFlow, XLA)—Google successfully navigated the end of Moore's Law.

From the crisis-driven inception of **TPU v1** to the massive, inference-optimized **Ironwood (v7)**, the TPU has evolved from a niche accelerator into the backbone of the modern AI economy. As generative AI models continue to grow in size and complexity, the TPU's trajectory suggests a continued focus on memory bandwidth, optical interconnectivity, and specialized precision formats like FP8 to sustain the "Age of Inference."

**Sources:**

1. [uncoveralpha.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFnDez5HJvxAnuuP1sLMTu0-TMoqfTFNGo1sj5B5ZJfKPcyjv-EUKdlpgPaDX_c1UUIVj9hPwnaHL1vbeP7F8CmiMxOsJJunF1tJB2TMqqsNQU7FSh4q_kWfCmhkVudGibcyB9wdhe--rnyvduygz7SVH5rVzGcbQ==)

2. [github.io](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQH6jMBhxH42J63iRgEhS37aT3YMQsDPvA-2hn-faUZUYJ8ajNP85Qp91GfUt847YwFC9o5Flud_IqRE1C3SiTjtcqpUF7FfYhkGph2tfODdsLhspMVXebpIcEdX5Ff2E7S_wErNplfb-_JYeU174EDT3LBlxfJji92U2NZ93VUvLpVVN4k2Ng-Sg9k=)

3. [wain.tokyo](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQF6B6ONtItm0vE1PZeHfU8mV1xHwbYpMhjjPvlAfcda5Hg8xKCihxqvON3w0NYLMevFebv_JcLo14HwazYaSi1LDEFAk4gZbe5kfGZrlSFE_VnfofxEwjX0nhscn28pPkouWyg2NW5DjZZDC_Npyq-PSQ==)

4. [youtube.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFeKP4ZlqxJ13h-Eg9b6V9AwUoT8yaZJNlqgTxy1xh32W_jkcc_41Oqq8Bs5ye-1LYvLkxduW_PTp8G9LtES8vNaxjUT-fh3zN9ipTQzUEnQchbEPmk-5J8wXBuaV9Nm0DP)

5. [medium.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFs5U2HhEXKuoSfU84307cVSPsdF-e8gWbhI-Wj8GtAaWvQ9BHmDpVxxJ0ovfuStPHkC9_-nyFAZwenayEP5e5RwAhCtT4EpcSU2o9W79EH3KIpKe1OUAnSwQY23Gr2Ysb17yEosN28CfkpW6nJFWv1kEMLeHVzOGkbeuSQsRYir1ENrcEg8aHSfNBftUT78vJd--JxqhLu)

6. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGR74PCzHB0WlDCEsBXJtXAAnYvvo821FbPQtDL0e2TVFB-9KL_GVwF6tD7FRn4MyyX4ytTR2rapTznEKJgG-_YSQD62yg5om4YLDp4YcQl5znBy18JD44FbExChIPHrdYeqGxr3KO3_ocumLVDJ5td9xtrdXOhtpEUdFM1ySUiobaaBoQJXUgB4Md8BmgUZ0hdqgHlBS4VhFrWlnd2sxu1xVkOl_qpQ4-9CAaHcw==)

7. [github.io](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHhWunuogCwiKz6R4kDzHwXXEKf2SfrzdnMBl3mNYEZP5PWG0hIHwK-I0fHazoL-r-Wc-hoXS7rhYW4PQB6-wSezTsvll-KrUkcaHh3FYvg6x07hQY9QkUNpLZ-qmTvPR8lm6Dp)

8. [cloudoptimo.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHWUnxSewVkQ_vrcQRs2rD1hJphCkB-K5-hdv0yg70al0833T8YvEQpuOWY-47PpSl3hy62xmhSIBP3w2_a6PAnrZUzy_Z3GX_rnN1Mh7Mb3_Lxf2Ik5-IhRR9nVaqqkm7ZUWralqSn_4apW_wQjy3wr8PoDztNwVLPt6jXlu5DRPk=)

9. [orhanergun.net](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFAH8AVWB9ceOOdLqD6RPPOS0yJBwy1cJqD7lyJh8TtXM9L5kiTAWWuzGphip7DSDPcExhTs5ybQ_KWP3W8W6RKYaSsrQQANdpFhM9ui8wJfSEEUuk19u5kH-J_TZHBL9_-GSNiZPCmJE1EJOCAoM9wxWg3NLcTDcty6JHhUvDPBk3fuY3-)

10. [wikipedia.org](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQELvxBVIKwQ80fA5vOLgwBmdI5pPeEKBmISjbaG7g-tzYNt_Ywhqx4usMOeTQWKvBOYoPCCYW2qsG0oJvIckqdCX3PetPrkGvLOHDSCdpzsLOsRhyp86UMUjCTvo0bs7x7aTaH1OlMomhIk)

11. [medium.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFa7yaiN-5QzxBGxfTUVL6A21hvzmqHGuDz-MDF6Ep6wfH8U6-8dhku0uCVE28zO1J2UOJEqGymEcgrWlZ7S4Tv82J-3nt_LNyCfNPKpOJ2QloXeDx3LHUQ70CciX7C95wICVs9YNB0fH8t4OScOgaXZrausWI=)

12. [tomshardware.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHPioC8_X8h2X5YsPEQoySY_wH87mVu4OQGsEhMvmgJX6KxBKWlKgBvJNJfVKSR5Tjny2nW6I2DcPFI7l7vUJa3GITlGJxJEFMZPmveqaFvI2jrez8MM0Ya65VaQO_lbThBWk5M7tqZNe968UhM8gVXeqWt-3butQuzHfzAZOIqlT5pO9_Dq5xqSARh-3eWe-XRog==)

13. [introl.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEr5uC5s9oQwFUgj3_skhD8oG7oWQDsIvq2Ody20SuqcbosSytQi9p-ZCNM8FBMrUaJ6LlmNXU4YWj1eJhZohJ8agHtIEArXJARBzPJFmRn4w7WQ2QJpunkvvsGnRaSwsxm91qtQEsmtOEZB29w1v5vl-R9Si5wuvVlJHHL7LlH8CvV)

14. [youtube.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQF4dH2B5w7anpsf8DkUnDvFhwcYsmCFvreP90FepWv9MS0sD2FmDEutbLqPGKtlxvWptnBm7lxNFi40VmvgZGGxqOHfjnCF9fxvkXXuyjEwrCWCf_CclfQp1a9vTQ0vFv8R)

15. [arxiv.org](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGrTqNiFRE4LFpH0_G8Uyfc35tTJeHTDaEpBpxfpZjzzOq_NB9NaFB3sC1CpqRhnp36f8f6eyZawAjDl7w-iW718Rbj-SCrYMYMhwDruGpNbT8iFZAJGw==)

16. [syncedreview.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGuUW7dVVJnZNTtNdjiAAV_tYcLFKKbLZIVJdJLdbciUSVmNS0PxX9EchmbDTA6YjmivZwMlGcDKEQJKIUHG6qQQ56B89-Cec8J25s-UaryCIDlrLloP-U_XlBCKl00Sfpgad2YHb3s2O82SQ_cN_V5HomIWLQplIF_BX_rcTVzo526l6caf_IQ4VwXGKtoOTx4hxnlDUCO1qBx1VU6j9yvnjV2DPbSBrdR7BrPwkjpLOEwhLDdeU84FMR8l5vXJYPizR4u)

17. [hpcwire.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQH02UtWEvvCoyNNDMj28UxnpOES0Zk6NGTwWhIt2tfk_qkyzxXphXOhGSD-B8eS3GMBAkgSq9sEMsfm7whZCwJdU44WhJC9bAIuFAnntUb69wFcwTJLbZaNsmqWO1Get3WT0RsUAizT4OlHAsY7M-rUeEd8RsMA_1dQhoXKaFkmaUNE3b2wBiL8lz6rqm36D0OKI9GNrCKCEPBWY96Q_k9o)

18. [hpcwire.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEhfNQLRddZ_efP0gSpVAWY1MCA57JbP_Mk4YXa6fzdtUhiQsyZhXqbiy5HlWwT98OBqN_xpeWrg34Dei5NaQRDpqvjDJmJM3SZjC8BZpTZJwkny7JZNZCk3oSwKTKBOibmsEx9eK5mF1nYPj6yEbJS4RRaJ5u-LCXYnYLY4nVIEY7VVlmMCzIVSvcJmioA0BLQ13xi43PsSZ8=)

19. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGpn0k7zqO0yrMityVvSErBtb0_5kzGMicTY5bctSMvZVRjZckln4Vi4NeRCHsKPEzZN72p_cryf7agiD0DCubGGZGMIlxUfrshpK79OCk6tXdM3QTw_Cs5TUxvYhlrRZNTkA==)

20. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQENCjo7XSxz4Sc4HZAARHFN8bi6zNbQLE9pMoledY_8rY-LXt817OZabzZOge2tUO8GahrQH1erZzZOBWNwmVe5fIzJ5slLFraYyU9_4vtLOFyxasqs2qoIq1eWsE3SiyKs-p3KcocJ3nuO4-n7eHkxadzhzfi8BHwoqFY35gCHOWIwlAxXihgKzeQIzijypQ0=)

21. [reddit.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHGhXmIOy5Y8ZC8GqJgEYhtipkzV36n1_bybnxV75OJPZq-ux85dmcvUkYnyc1FEJs9C0DPwuqpHOvqDp_oKQlL7dORAq3RWwXuEu0VYWlBvQKuObJrCSb1Y2j-u2p66yZGhzUQBGrqL8_5JmBKFHStXLdSJmnCzRn63DVUzl5i-LVU9Z-_lTDPlGyb8iCsmpU=)

22. [creativestrategies.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEMn6h4m2f0ww8-DMGoBwB1L68IzhYg-mev0e6_cGxIVDJFx_t-1_eIACVg_Z0kZI3TAo_R6jZJETSbp3aYBve4CPNv5ZgHpGOQe8JLoOVyIq9vtyO9bZpJX7nVq12ZwqtZAm0ardQ4u4RAzjLxHM-14ldmYVvuzIrQ4ZS9rQ7zddxRqOUQSGHbdsZeUzB0DUuQd5cROEPMjjB0H261tqdEktT6RtRhxzNLijzLk8kpyQ==)

23. [blog.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQF1tdGp1tS3tKFOL7imMGNYK5reIlN7v_DJKbKard8wdygPy2NXheMAakJ7EoiARI35qSEJylngUGefYiroq3mef325u8labMxiBe2dHuL6Qur8U7fZghjtEFZeHIJpYMZGYjhByw2YjqDvoex48rBZWNjHB7zRXzf94I5H9Z4=)

24. [workmind.ai](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHDDFqpd_fvrcFmaiQC8BvX1EaqM7Mk8r8DhznIViUfrF702upiOpt2-Ez0q3WaT0Wv7365_E0ekMq0KBUECfQo75mQq4rMeSEEo94F6EgVrDpD88HoDGaDwMqrr-Zsmo19bZO55NaYR-ej9bPbyBjeGBP-UhP1lKVcgQ22grcBheNdP-I4gA==)

25. [insidehpc.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE1INUE1jWqlcuB8BB3CuHSKR4hsIbiaKkDYDnH9d0ElUpNDaYwUGPzXGSlc6uJlAxh1eqnwcOWauUxNzDBU-am2ml7aZC_8RsDeL0A8DEcIOwVtunhfB-I-8_EeZ76pJrm65SRcE1Ggacv9SV5nipPRGsa9fFeYJOb)

26. [techpowerup.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE8-qc0lIjhLmWHwfjpy3m33ugc5W5BIvxA9bNOGlmuoDLQtzysc_PA-p-B9Fg3qCpNo0A4U-gDy0tdAv4yWZAxTY98pEkHiuijikBOgibxNRJYdFJG5J3mF_rIMqS3eB6XsuEtl1PBZogihpTX6kaf5uG27H_pT8nu182zyCNls1K748dvZMOSbiJmXgyY1fY=)

27. [nextplatform.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE_NdTFiL3OijlTUOK5WYg_4HHs44AZEmUjDlUk5pLNSsxuRNz_0phHDRnMOTC4uF4W70nRLuZifX9ZzE_Ymc8i2m2xO2HnA_IcrtHwVolq6C6dL2x0vVC1lbFXM_vDXsiiSVdXNw3R1Jj8mKRQJUFNKe62klOQS5jkgYrmvHiMSe8ODsU7S6mTkKSdeolSiWtNX-K2dfQfvyN-MWuCmg==)

28. [viso.ai](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHauwKcTMEgNKVyvaduhhrU_xFPb-sCcV5g9iDrJzCKoaSAPA1KE3G2-QA5gUwU70c7NBtKph_NgP_zgoV91daXeHbwRFrG26Fg8z71P1msZibXnet0pZ7UK_q9)

29. [assured-systems.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQF4St0UVZpk0CN4ylSY6EJJPzP7u6eeVoPnwdpfVlRTiQELl7HrWcl5vOpjS3j0HaQywc3SZMIHziYhOyIq2O89TJ2mBq4gdycVETeLUW4orIbIrhaXtuIP_eYkX_5L42OMYLtFw9M9DweKEC1JRS98zUuSl2fw6EBXkvoygQyn7vOhr4li3A==)

30. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGrTiW5zOaLlOGhQ0NNlyi_woe_9o13A92aj2sQOtAd32NLeA0qi-QwJedOIf7t5CUx2Ry-Z1o1gUc_2a5P9XS6asLzpjgeUdwREv2eLjQZEnXyvL0fEPqv1c6dewpV7Ug4S-N-6dcDuYKtx24UxAzUtALd0hNZGg==)

31. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEKkgG06JD25q_dbdfmkbXqGaWnc08TRKrD47OvjTX_l2QWG11K-d1EoPsehgTebk4JHq8mWQ5iOMIzGk94ksobj4yOZMN6RGFrjVw8PYshImZITPGyYrViPswreFBndxtc5zSkcIUsrRo=)

結構な量の参考サイトが挙げられており、これらをまとめたものが出力されました。

バックグラウンド処理をさせているので、実行中の様子はありませんが、リサーチを開始すると以下のような画面になります。

Gemini Deep Research agentの活用事例

ここではGemini Deep Research agentの特性から、どういった使い方ができるかを考えてみました。

技術調査・技術選定での活用

Gemini Deep Research agentは、特定技術に関する情報収集と整理を自動化できそうです。

例えば、新しいフレームワークやAPIを採用する際の比較調査が挙げられます。複数の情報源を横断的に調べ、引用付きで整理されたレポートを生成できる点が強みです。エンジニアの事前調査時間を短縮する用途での活用が期待されます。

市場調査・競合分析への応用

公開Web情報を対象にした調査が可能なことから、市場動向や競合サービスの整理にも向いています。

製品カテゴリごとの動向や、各社の特徴をまとめたレポートを自動生成する使い方です。人手で行うと時間がかかる初期調査を、一定レベルまで自動化できる可能性があります。企画や事業検討の初期フェーズで役立つでしょう。

レポート作成業務の効率化

Gemini Deep Research agentは、情報収集から統合までを一貫して行えます。この特性を生かし、調査レポートやホワイトペーパーの下書きを生成する用途も考えられます。引用元が明示されるため、後続のファクトチェックや加筆修正が行いやすい点も利点です。

なお、Google DeepMindの次世代AIエージェントであるSIMA 2について詳しく知りたい方は、下記の記事を合わせてご確認ください。

Gemini Deep Research agentを実際に使ってみた

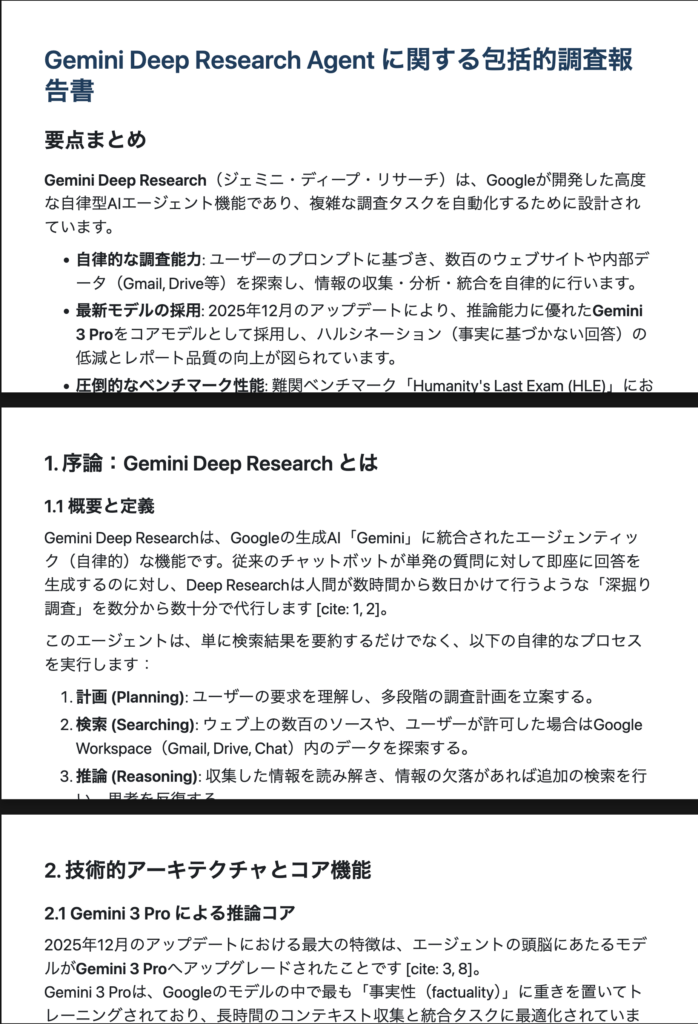

先ほどの使い方では英語の指示を与えたので、今度は日本語で最新のトピックに対応できるのかを確認してみたいと思います。調べる内容は「Gemini Deep Research agent」についてです。

サンプルコードはこちら

import time

from google import genai

API_KEY = ""

client = genai.Client(api_key=API_KEY)

interaction = client.interactions.create(

input="Gemini Deep Research agentについて調べた上で、日本語でまとめて.",

agent="deep-research-pro-preview-12-2025",

background=True

)

print("Research started:", interaction.id)

while True:

interaction = client.interactions.get(interaction.id)

if interaction.status == "completed":

print(interaction.outputs[-1].text)

break

if interaction.status == "failed":

print("Research failed:", interaction.error)

break

time.sleep(10)結果はこちら

/tmp/ipython-input-2933502043.py:10: UserWarning: Interactions usage is experimental and may change in future versions.

interaction = client.interactions.create(

Research started: v1_ChdwSnM3YWZpVEt0QzZfdU1QbDlyTXFRcxIXcEpzN2FmaVRLdEM2X3VNUGw5ck1xUXM

# Gemini Deep Research Agentに関する包括的分析報告書

## 要約と重要ポイント

**Gemini Deep Research**は、Googleが開発した高度な自律型AIリサーチエージェントであり、従来の検索エンジンやチャットボットとは一線を画す、複雑で多段階にわたる調査タスクを自律的に実行するシステムです。最新の**Gemini 3 Pro**モデルを推論コアとして採用しており、数百のソースを分析し、数十分から数時間を要する調査を数分で完了させ、引用付きの包括的なレポートを作成します。

**重要なポイント:**

* **自律的な深層調査:** ユーザーの漠然とした問いに対し、自ら調査計画を立案し、検索、閲覧、情報の統合、不足情報の再検索というサイクル(反復ループ)を自律的に繰り返します [cite: 1]。

* **圧倒的なパフォーマンス:** 新たなベンチマーク「Humanity's Last Exam (HLE)」や「DeepSearchQA」において、競合であるOpenAIのGPT-5 Proを上回るスコアを記録したと報告されています [cite: 2, 3]。

* **統合されたワークフロー:** Google Workspace(Docs, Drive, Gmail)と連携し、内部データと外部のWeb情報を統合したレポート作成が可能です [cite: 4, 5]。

* **開発者向けAPI:** 「Interactions API」を通じて提供され、開発者はこの自律調査機能を自身のアプリケーションに組み込むことができます [cite: 1, 6]。

* **日本語対応:** 日本語環境においても高い精度の分析とレポート生成が可能であり、国内のWebサイト分析や市場調査に有用性が確認されています [cite: 7, 8]。

---

## 1. 序論:Gemini Deep Researchの定義と背景

### 1.1 Gemini Deep Researchとは何か

Gemini Deep Researchは、単なる質問応答システムではなく、長時間のコンテキスト収集と情報の統合タスクに最適化された「エージェント」です。2024年12月にGemini 2.0の一部として初期リリースされ、その後2025年後半にかけてGemini 3 Proをベースとした大幅なアップデートが行われました [cite: 1, 9]。このシステムは、人間が数時間から数日かけて行うような文献レビュー、競合分析、デューデリジェンス(適正評価手続き)などのタスクを、自律的に遂行するように設計されています。

### 1.2 技術的基盤:Gemini 3 Proと推論コア

本エージェントの中核には、Googleの最先端モデルである**Gemini 3 Pro**が採用されています。このモデルは「推論コア(Reasoning Core)」として機能し、複雑なタスクにおけるハルシネーション(事実に基づかない情報の生成)を低減し、レポートの品質を最大化するように特別にトレーニングされています [cite: 1]。また、100万トークンを超えるコンテキストウィンドウを活用し、大量のドキュメントや検索結果を一度に処理することが可能です [cite: 9, 10]。

### 1.3 従来型AI検索との違い

Perplexity AIや従来のChatGPT(SearchGPT)などの「AI検索ツール」が、主に単発の検索クエリに対する即時回答を重視しているのに対し、Gemini Deep Researchは「反復的な調査プロセス」を重視しています。

* **従来型:** クエリ入力 → 検索 → 要約回答(数秒〜数十秒)

* **Deep Research:** クエリ入力 → 調査計画の立案 → 複数回の検索と読み込み → 知識ギャップの特定 → 再検索 → 統合レポート作成(数分〜数十分) [cite: 1, 9]。

---

## 2. アーキテクチャと動作原理

### 2.1 自律的エージェントワークフロー

Gemini Deep Researchの最大の特徴は、その「エージェンティック(Agentic)」な挙動にあります。ユーザーからのプロンプトを受け取ると、システムは以下のステップを自律的に実行します。

1. **計画立案 (Planning):** 調査が必要なトピックを特定し、具体的な調査計画を生成します。ユーザーはこの段階で計画を確認・修正することが可能です [cite: 9, 11]。

2. **反復的実行 (Iterative Execution):**

* **クエリ作成:** 必要な情報を得るための検索クエリを作成します。

* **情報の取得と読解:** Webページやアップロードされたドキュメントを読み込みます。

* **ギャップ分析:** 得られた情報で十分か判断し、不足している場合は新たな角度から検索を行います(Iterative searching) [cite: 1]。

3. **統合と執筆 (Synthesis & Reporting):** 収集した情報を構造化し、引用元を明記した詳細なレポートを作成します。

### 2.2 マルチステップ強化学習

Googleはこのエージェントのために、検索行動に対する「マルチステップ強化学習(Multi-step Reinforcement Learning)」をスケーリングさせました。これにより、エージェントは複雑な情報のランドスケープ(Web上の情報の分布)を高精度でナビゲートし、SEOスパムや無関係な情報を回避しながら、深い階層にある特定のデータに到達する能力を向上させています [cite: 1]。

### 2.3 統合情報合成 (Unified Information Synthesis)

Deep Researchは、Web上の公開情報だけでなく、ユーザーが保有するプライベートデータも統合して分析します。

* **File Upload / File Search Tool:** PDF、CSV、Google Docsなどのドキュメントをアップロードし、それらをWeb検索結果と組み合わせて分析できます [cite: 1, 5]。

* **Workspace連携:** Gmail、Drive、ChatなどのGoogle Workspaceアプリ内のコンテンツにセキュアにアクセスし、社内文書と市場データを突き合わせた競合レポートなどを作成可能です [cite: 4, 5]。

---

## 3. ベンチマークと性能評価

GoogleはGemini Deep Researchのリリースに合わせて、新たな評価指標(ベンチマーク)を公開し、その優位性を主張しています。これらは、従来の単発的な事実確認テストとは異なり、エージェントの総合的な調査能力を測定するものです。

### 3.1 主要ベンチマークスコア

2025年12月時点での主要なベンチマーク結果は以下の通りです。特にOpenAIのGPT-5 Proとの比較において高い数値を記録しています。

| ベンチマーク | Gemini Deep Research | GPT-5 Pro | 概要 |

| :--- | :--- | :--- | :--- |

| **Humanity's Last Exam (HLE)** | **46.4%** | 38.9% | 専門家レベルの推論と問題解決能力をテストする高難易度ベンチマーク [cite: 2, 3]。 |

| **DeepSearchQA** | **66.1%** | 65.2% | 900のタスクからなる、Web調査の網羅性をテストするベンチマーク [cite: 2, 3]。 |

| **BrowseComp** | 59.2% | **59.5%** | Web上の見つけにくい事実を特定する能力。GPT-5 Proとほぼ互角 [cite: 3, 12]。 |

| **FACTS Benchmark** | **68.8%** (Gemini 3 Pro) | 61.8% | 事実性(Factuality)を測定するGoogle DeepMind製のベンチマーク [cite: 13]。 |

### 3.2 DeepSearchQAと評価の公平性に関する議論

Googleは「DeepSearchQA」をオープンソース化しましたが、一部の専門家からは「Googleが自社のアーキテクチャの強みに合わせて設計した定規で測定している」という批判も存在します [cite: 14]。

* **因果連鎖タスク:** DeepSearchQAは、前のステップの分析結果に基づいて次の検索を行う必要がある「因果連鎖(Causal Chain)」タスクを含んでおり、これは検索インフラと密接に統合されたGeminiに有利に働く可能性があります [cite: 14]。

* **検索インフラの統合:** Claudeなどのモデルは、統合された検索インフラを持たないため、この種のベンチマークではスコアが低くなる傾向があります(Claude Opus 4.5はDeepSearchQAで24.0%) [cite: 14]。

### 3.3 事実性(Factuality)の課題

Google DeepMindが発表したFACTSベンチマークにおいて、Gemini 3 Proはトップスコア(68.8%)を記録しましたが、それでも約30%のエラー率が存在します [cite: 13, 14]。これは、依然としてAIが生成するレポートには人間の検証が必要であることを示唆しており、特に金融や医療などのハイステークスな分野での利用には注意が必要です。

---

## 4. 競合比較:Gemini vs. GPT-5 vs. Claude

### 4.1 対 GPT-5 Pro (OpenAI)

* **推論能力:** 一般的な推論タスクやコーディングにおいては、GPT-5 Proが「思考モード(Thinking Mode)」を使用した場合に優位性を示すケースがあります(例:AIME数学テストでGPT-5.2は100%を記録) [cite: 15, 16]。

* **調査能力:** 長時間のコンテキスト収集とレポート作成(Deep Researchタスク)においては、GeminiがHLEやDeepSearchQAのスコアで上回っており、Googleの検索インデックスへの直接アクセスという強みが活かされています [cite: 2, 3]。

* **ユーザー体験:** GPT-5は「スマートなタスクマネージャー」として、ユーザーの意図に応じてモデルを自動で切り替えるシームレスな体験を提供しますが、Gemini Deep Researchはより明示的に「調査エージェント」としてのワークフロー(計画確認など)を提示します [cite: 16]。

### 4.2 対 Claude (Anthropic)

* **コーディング:** Claude Opus 4.5はSWE-bench(ソフトウェアエンジニアリング)などで依然として高い評価を得ていますが、Web検索を伴う自律調査においては、検索基盤を持たないためGeminiに大きく遅れをとっています [cite: 14, 15]。

---

## 5. 実用的な機能とユースケース

### 5.1 レポート生成とエクスポート

Gemini Deep Researchが生成するレポートは、単なるテキストの羅列ではなく、構造化されたドキュメントです。

* **Google Docs形式:** 生成されたレポートは、引用、表、グラフを含んだ状態でGoogle Docsとしてエクスポートでき、即座に編集や共有が可能です [cite: 9, 17]。

* **Audio Overviews:** レポートの内容をポッドキャスト風の音声会話に変換して聴くことができる機能も提供されています [cite: 11, 18]。

### 5.2 主なユースケース

Googleおよび初期ユーザーからの報告によると、以下の分野で特に効果を発揮しています。

1. **市場調査・競合分析:** 数百のWebサイトを分析し、競合他社の製品機能、価格戦略、市場トレンドをまとめる [cite: 9, 19]。

2. **デューデリジェンス:** 金融サービスにおいて、投資先の初期調査を自動化し、数日かかる作業を数時間に短縮する [cite: 1, 9]。

3. **学術文献レビュー:** 関連する論文や記事を広範囲に探索し、要約を作成する(ただし、専門性の高い分野では限界も指摘されている) [cite: 7, 9]。

4. **技術文書・ベストプラクティス調査:** 特定の技術トピックに関するドキュメントやフォーラムを横断検索し、解決策を提示する [cite: 9]。

### 5.3 日本語環境での利用

日本語対応も進んでおり、日本のユーザーによるテストでは、企業のホームページ分析や改善案の提示において「的確で具体的」との評価が得られています [cite: 7]。ただし、非常に専門的なニッチ分野や、日本語の学術情報がWeb上に少ないトピックに関しては、情報の網羅性に課題が残る場合もあります [cite: 7]。

---

## 6. 制限事項と批判的分析

### 6.1 処理時間とコスト

Deep Researchは「Deep(深層)」な調査を行うため、回答までに数分から15分以上かかる場合があります [cite: 9, 14]。これは即時性を求めるチャットボットとは異なる利用体験です。また、API経由での利用はトークン課金となるため、複雑な推論と大量の検索を行う過程でコストが増加する可能性があります [cite: 14]。

### 6.2 ハルシネーションとバイアス

* **ハルシネーション:** Gemini 3 Proは事実性を向上させていますが、それでも完全に誤情報を排除できているわけではありません。特に、存在しない情報源を引用するリスクは依然として残っています [cite: 20, 21]。

* **検索バイアス:** Googleの検索ランキングに依存するため、SEO対策された人気サイトやスパム的なコンテンツが上位に来やすく、真に権威あるが検索順位の低いソースが見落とされる可能性があります [cite: 22]。

* **人文科学分野での弱点:** 信頼できる学術ソースと、一般的なWeb記事やRedditのような掲示板の情報を区別できず、質の低いレポート(Garbage In, Garbage Out)を生成する場合があるとの指摘があります [cite: 23]。

---

## 7. 開発者向けエコシステム:Interactions API

Googleは、Gemini Deep Researchを単なるアプリ機能としてだけでなく、開発者が利用可能なインフラとして開放しています。

### 7.1 Interactions APIの概要

「Interactions API」は、モデル(Gemini 3 Proなど)とエージェント(Deep Research)を統一的に扱うための新しいインターフェースです [cite: 1, 6]。

* **非同期実行:** 調査タスクは長時間実行されるため、`background=True`を設定して非同期で実行し、ポーリングによって結果を取得する仕組みになっています [cite: 14, 24]。

* **ツール統合:** 開発者は、Google検索ツールだけでなく、独自のデータソース(File Search)をエージェントに接続することができます [cite: 1, 24]。

### 7.2 導入のメリット

企業は自社のアプリケーション内に「自律型リサーチ機能」を組み込むことができ、例えば社内ナレッジベースと外部Web情報を組み合わせた高度な検索システムや、自動レポート生成ツールを構築することが可能になります [cite: 1]。

---

## 8. 結論

Gemini Deep Research Agentは、生成AIを「チャットボット」から「自律的なリサーチパートナー」へと進化させる重要なステップです。Gemini 3 Proの推論能力とGoogleの検索インフラを統合することで、情報の収集・分析・統合というナレッジワークの核心部分を自動化する強力な能力を持っています。

特に、**HLE**や**DeepSearchQA**などのベンチマークでの高スコアは、その推論能力と網羅性の高さを示唆しています。一方で、事実性の担保(ハルシネーションの抑制)や、検索ソースの質的判断といった課題も残されており、現段階では「人間の専門家による最終確認」を前提とした利用が推奨されます。

日本語環境においてもその有用性は確認されており、ビジネスにおける市場調査や競合分析、あるいは開発者によるアプリケーションへの統合など、多岐にわたる活用が期待される技術です。

**Sources:**

1. [blog.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHmdcxmnRyN7NGTd88qbbWo9KPg5Xlg1CJoL5lov0vYBP_Ce-25x0k1NThN93QSDkoWgGKISrMvCvhv_GwW956HJBWbCvnJZhoyIDDovc051opVTOChj-_k7WTO9F5DFsx2rEZyWKRtp2N48YZPwU2CDAfOovorOBuEQsjv5KuN)

2. [reddit.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHf1k8V8gG61I3YwfgTesLoRMCc_yAD6kluPjqwHRGcqoQKv-Qn97zvX777hqptJN3gbSfuV8Bn7CNHyvZNgStvwutmTj35hrtMxOMXsigH42D7LIw8wyv5VR5oXkfwEcA24vIFmnzu-zPpoYoRhL4aNad3aAgyCN6xZLpunW3cJC9465KfMXBQhqVVMKF3FqoAo0vhMtDy-sxGXoYJ)

3. [analyticsindiamag.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFGE_SDbUrfzWiGv6A-HnKKCfSl5mhgVBdjFXErCfgPWCnRcYyjykhVpb2Fm_JHSBXUd1hekvJnYCo-kB6K2MeGGHQkO3vnebz-2No0m_X0awQZFCZx_-RM9XIlbJYcaCGiakgIqB_hMzQRAko63eXurQYQAF3OwXEXnb-wRAfRIn6b7Eu9fbJ65wCQWdt-tmZxWAXtPtdQd5s7jPC6eFSyX-dDejjA)

4. [googleblog.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGepsLytO6VkJO6FMQV3CD_ClyJwg5OwrXv_Rrdf-0QfkslDdVW0LfvGc9l5wR9LDSfyYxmQ86heoO_HPv_YAny2wNnHxUg7b6ospiOYfuaZM3LdkQIyi1Hki-nM1R8TAMDLbaQQAlfL1CPVPz6uq9fzVnXPCUMnVbzJE9s5dD6VR1ACm2WycpMkix8i5pVA9o4C8I1mBtoeWeju_4=)

5. [blog.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGrukBfSXWNDGEo2OIHQkIOQPotk4u-dJjHQSmXO9DKz7VdrqITHyDu6VMdfydFBfhCulX02uDztRpDPQvSSwONQCdF2qOFCldAaa110pfJLZyslrq990qRBO8DkdsYeK5eOUaHsLRDcGpqgsvrBPCZlChmD_3YBDkUzzfa2N4CFRYX)

6. [9to5google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGj8bvab8bp1CutJjJZ8szge2jMYjUQ9jYQacoI5ivnibY8rqRm5Gvil-D7Dj1ousOtm_k3Lt-qCyTweCqcVGK8gIObF5UnKOAIrE6DrgasjIhCP-8963XH0rBbryvMdOEOwYZrjgrtvjIGW6wpOZCsUTnb)

7. [ai-box.biz](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFywT8CRi6TElZ9d6hTeraggLeuwG8dFvRXN03UlSHDy_JIE9-Vf-BYvCqe67Rjop1wOS7p8bUDwdAiWFMqJk7uponUUEeesWKNogNWDKPsrYYj_R-ivpT7EJ39__I6NheZEpJmZoL-mBxHF04G)

8. [note.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHi_75UQY-MS4Ixj_iRzZwUzCqXtr1XQp1IJ6Xh2tamFl9luuZcp7Qg4PhbJGNuc_do9nW40WTCgTXDtQKPjWAfjPEv9tladYgoeN9F50liO5Mvo4mmkjBiu7aID4Q=)

9. [digitalapplied.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHnEH92vQ_yutt_sDP-pvBELZxSaCVo9899j_RL6UOZoglpXIL3voN3VRmwb0ep7iEHAp6TYDX6TAzKq9-dOx5lecvKGdwES0Serf_drmbyCshwBvyHTtJXLbd3mxnKnFnGP1A8QqW7ryTFZ7nnbWzGdkpp2gGxrkoHTjo=)

10. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHLAVh6hcv4cDT8dLZ4I1YWeVmxfhw7Hng8mot3ywMS1bkpaCEEClUbvNOPXQt_T_3ReqdqnIYM-dxhvgKDYMVS3OidR0Poq9cCwndN7ZhlC65Mb35G6w0mrD2vQnmh-6RTuCQlJptYv4vbR1We9adpwN8y7V7RRaszKgyN2JfRyUTL2PY=)

11. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGharqH2DzvxjHemVxDWRHtCHaWqwe8pU6wUow-l-s_L2cVBeD7R6f7y6gFjEhHzoMTcmyM79_4ESjDcz0ECAZzok7bb469nCOsbNdeKzADIXHlozCta2KIBR-VTxeGZbs4LpO3D2RQ1n7OwEyGLVXXUd1i3aoUitubIIL9wA==)

12. [winbuzzer.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEgqFKTTrzJQZI9znaOgRpOCP9VqB62D8QLZYwghZxQMUNhAmFBKehkKemAQBMrw6Px5Hg_iiTEPed3PgWkJDh6NMppXgJN-J1injtZwJanKsscaoaLW1XUaw30wqvqdFKhTJ05nY6aexWpL0-IW4x8Vq_ySpbphG-oCu1L8B5IG71_rMBKHozNxyOzL-o17KstOwl38-w4ipNf3LNgUoY-xF7Ve9iKG_L-)

13. [reddit.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEXttQFnm3z0n8sYNIa1yIR8SxhyUTwLOBJmkE6bwwd3MJszz5h-AZdSQRorDgjzQsTGyTZZch3WBTtkwG_sxWuMug6maGRyQhrjHgpRpt9U0kC2NiqhxqOEWiPYRNFCRUTPwues_Zc9ICibeb8xv4f3H-McG8sD4vSek5QOUvF3-ak1pVpv1D42BIAcWo3BvBJr4sqd4A17rTNXw==)

14. [implicator.ai](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEWK7fwDbG1JgrSnZpKDVzLQZZPnXaBE-2_gt8uKkNMjIk3qE0pxV2-h8axoq6tFC90CvNxmXr5sCkrHQuR495-noNDj87S0YP_RJDSBL5zUcq2Eb4VvJE6MkO5bx5pGf1LA86epkXxnwfRPUXfAP-XlOahEVtMLqLturPmLM9z0wpUQmwSxU5BqPeHUI_QqwP4V9f7XiGeQpC1NyAtWEIkfksPmTIK)

15. [rdworldonline.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQF3pOpJZIat9roNiIQaYgQwiQBkXBy--znfx1hAijmVduNo9qPk9RxJK6AsJ3OS3F3GWrfqszHTPZZIzQlgAesMtNYAmydAGEeutR4GyidD0AocJBLeQ5vlCyHNJeCFxRBblU_lSyQvygdFWbq48AFSiaY2GE3fw_HO3BPJzTQrSBGWMFD0gHg1cbNyvJH2Ew5e)

16. [towardsai.net](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHGUkU4uoUQtc0htIHCO4Gxx5iyUqd6PiQ2PgdhSFgAqBBmNofYn59847EaKju9IfvWvtJl5Ilrm7cHXE--xx8U3rLXOek3iZqIipEmfBv1XlaOmWXPO4H3GS1a0dwvglUGwlka1zego2-gacxBe4z2zRLYgg==)

17. [youtube.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE3qcx15Sr6y0Rg68ZBNY06NpE9Uh2VV8n98vTV3Btbuxfar9Alc4OevThisXJo01CbTDisZedbWgwbraXn_LWzfmpqVPLN1FkYbumcrFC0Fx_nFlnxfp5s8jXX7MsJrwZ1)

18. [blog.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQForUY92ihhYuXaVQKGRZP4UjPwPIYnWb692tJEZlnluoYStbU0DcXyW-hMgnhFQc0ceQKOmRly7ptWIivWN2aiXPJk1m2Tl90ukc8e85CzMwl2x3i58TddjF4343_bTNLf08gfpM3X9Ru6DVbELmzMGnlzM83p7IOzrP8B5Fi5WM7E2Vs=)

19. [st-hakky.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEVL_gwGPHe6qQU6BwPRpiTiGMot7IUmTKTqQoF7vuKHpYtwi8DgKLBGueJNiacZN5LzgkPN6LTD0SWgCR-lR_dx1nF4f0oPfJPmhKrJhUH02Zfr390UwrMVc1Y_u5qG7EGUnL-FOSmeGlw3lMB8mKahyoMXSYXfYWUzzKX)

20. [dev.to](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQECsAQTEu7PNgmg42LuVI12Acdpty-ZxHVp9t2rKOj2Y1VlU87ar4GVJM2xc1tOcS9_12zmHquyMlnyYqpLte8ZLosybBvMVkWLtsgbDuKIz58SAvD2FcOe0k7hoPjZ3Un_jsvzcHADyWiNarBwNQ--jrgaEUcrL0G7TnHfBGdTQw==)

21. [the-decoder.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQH5DkTt0AkJET_ggiRewlCnCrgQar1ak0ZwMDro5Ffng6RrMc5O1exjofX3Lx9RbahAUCgnOhFTXHG2IWBT4DlGrL5OcFKWdNNdkVAtsv6KxqMzZ6S9SE8UUAoH_RS2PbcU8H95ZXVR2Nu1GbqxhZpAnmR6xcTWQMIdLOqPtBEaWWYmm57FatwYrdIieXzsTur_)

22. [substack.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE92aHfF0SeKd5HRViW3oxfw5Sud3mVP-n3UhBTNUbB2jF3gYtHj2CvlnWFkE6PVu7NTrsLQl1jCH4Go81CCfXiyEQe3NzrOzpL5NGuWA5ADdkkmRGoOXwQMfbxIW26lVmW7ezQo2zd2mxgXE0ujxi297jAHMuj8-f2rpc=)

23. [medium.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE6tQ6AzavjBWeNXFTcjEKldOpIy4NvxkABCcNcIoFuvAGJO9PUC2cXqNTwzeUhpG6fgKtCWdsKYrwXkY37XkrQvY0eZwj-x11xmiOh90ufk_czoW0Bz52mI7YMwnFzXsN5wLChIkYuor-VrPZXdqpN3Oo2kW4zi_W78Zm4FP5cgtogkDDnMtBNSVICeA710wgWShBnwYNoCj8rAEa8JVvTiTbXn11Nvq9768MhWOQI1F9AooVW72xZ8A==)

24. [google.dev](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGJIohvAJxP0ywKqmdvg5QH6X0yvggJudVWnXoGteI0kcOD40JUWtO4FB-mvjgPxzsKW5Zodq6bXVd2bIsAkD9wGV5wO9_FQfD_LNIU2vNJXB9fg45M_udv2RZYs894hwKooaVljh3n2j4=)

Deep Researchなだけはあって、最新トピックについても綺麗にまとめてくれました。

ちなみにマークダウンでまとめてと指示を与えたら下記のように出力してくれました。

マークダウン出力結果はこちら

/tmp/ipython-input-2399738774.py:10: UserWarning: Interactions usage is experimental and may change in future versions.

interaction = client.interactions.create(

Research started: v1_Chd4NmM3YVpfbERmTDJqckVQaThLRG9BbxIXeDZjN2FaX2xEZkwyanJFUGk4S0RvQW8

# Gemini Deep Research Agent に関する包括的調査報告書

## 要点まとめ

**Gemini Deep Research**(ジェミニ・ディープ・リサーチ)は、Googleが開発した高度な自律型AIエージェント機能であり、複雑な調査タスクを自動化するために設計されています。

* **自律的な調査能力**: ユーザーのプロンプトに基づき、数百のウェブサイトや内部データ(Gmail, Drive等)を探索し、情報の収集・分析・統合を自律的に行います。

* **最新モデルの採用**: 2025年12月のアップデートにより、推論能力に優れた**Gemini 3 Pro**をコアモデルとして採用し、ハルシネーション(事実に基づかない回答)の低減とレポート品質の向上が図られています。

* **圧倒的なベンチマーク性能**: 難関ベンチマーク「Humanity's Last Exam (HLE)」において46.4%のスコアを記録し、競合であるGPT-5 Proを上回る性能を示しました。

* **開発者向けAPIの提供**: 新たな「Interactions API」を通じて開発者に開放されており、外部アプリケーションへの組み込みが可能となっています。

* **日本語対応**: 2025年1月より日本語環境でも利用可能となっており、日本のビジネスや学術研究の現場での活用が進んでいます。

---

## 1. 序論:Gemini Deep Research とは

### 1.1 概要と定義

Gemini Deep Researchは、Googleの生成AI「Gemini」に統合されたエージェンティック(自律的)な機能です。従来のチャットボットが単発の質問に対して即座に回答を生成するのに対し、Deep Researchは人間が数時間から数日かけて行うような「深掘り調査」を数分から数十分で代行します [cite: 1, 2]。

このエージェントは、単に検索結果を要約するだけでなく、以下の自律的なプロセスを実行します:

1. **計画 (Planning)**: ユーザーの要求を理解し、多段階の調査計画を立案する。

2. **検索 (Searching)**: ウェブ上の数百のソースや、ユーザーが許可した場合はGoogle Workspace(Gmail, Drive, Chat)内のデータを探索する。

3. **推論 (Reasoning)**: 収集した情報を読み解き、情報の欠落があれば追加の検索を行い、思考を反復する。

4. **報告 (Reporting)**: 調査結果を統合し、引用元を明記した包括的なレポート(数ページに及ぶこともある)を作成する [cite: 1, 3]。

### 1.2 開発の背景と進化

Googleは、AIを単なるチャットボットから、ユーザーの代わりに複雑なタスクを完遂できる「エージェント」へと進化させることを目指しています。

* **初期リリース (2024年12月)**: Gemini 1.5 ProやGemini 2.0 Flashをベースに、Gemini Advancedの機能としてリリースされました [cite: 2, 4]。

* **日本語対応 (2025年1月)**: 日本語を含む多言語への対応が開始され、国内ユーザーも利用可能になりました [cite: 5, 6]。

* **Gemini 3 Proへの移行 (2025年12月)**: 推論能力と事実性を大幅に強化した「Gemini 3 Pro」をバックボーンとする新しいエージェントが発表され、開発者向けにAPIが公開されました [cite: 3, 7]。

---

## 2. 技術的アーキテクチャとコア機能

### 2.1 Gemini 3 Pro による推論コア

2025年12月のアップデートにおける最大の特徴は、エージェントの頭脳にあたるモデルが**Gemini 3 Pro**へアップグレードされたことです [cite: 3, 8]。

Gemini 3 Proは、Googleのモデルの中で最も「事実性(factuality)」に重きを置いてトレーニングされており、長時間のコンテキスト収集と統合タスクに最適化されています。

* **強化学習の拡張**: 検索のための多段階強化学習(Reinforcement Learning)をスケーリングすることで、複雑な情報環境を高精度でナビゲートする能力が向上しています [cite: 3]。

* **思考プロセス (Thinking)**: エージェントは行動を起こす前に「思考」を行い、その思考プロセスをユーザーに可視化することも可能です(Thinking summaries機能)[cite: 1, 8]。

### 2.2 自律的リサーチ・ワークフロー

Deep Researchは、以下の反復的なループを通じてタスクを遂行します。

1. **クエリの策定**: ユーザーのプロンプトから、具体的な検索クエリを複数生成します。

2. **情報の取得と読解**: 検索結果やドキュメントを読み込みます。

3. **ギャップの特定**: 現在の情報で十分か、何が不足しているかを判断します。

4. **再検索**: 不足情報を補うために新たな角度から検索を行います。

5. **統合**: 全ての情報を統合し、回答を生成します [cite: 3, 9]。

このプロセスは、従来のLLM(大規模言語モデル)の単一ターンでの回答生成とは根本的に異なり、人間が試行錯誤しながら調査するプロセスを模倣・高速化したものです。

### 2.3 マルチモーダルとWorkspace統合

Gemini Deep Researchはテキスト情報だけでなく、PDFや画像などのマルチモーダルデータの処理も可能です [cite: 2, 10]。

また、Google Workspaceとの深い統合が強みであり、ユーザーが許可すれば以下のプライベートデータも調査対象に含めることができます [cite: 1, 11]。

* **Gmail**: 過去のメールのやり取り。

* **Google Drive**: ドキュメント、スプレッドシート、PDFファイル。

* **Google Chat**: チーム内のチャット履歴。

これにより、「競合他社の公開情報と、社内の戦略メモを突き合わせてレポートを作成する」といった高度なタスクが可能になります [cite: 1]。

---

## 3. 性能評価とベンチマーク

2025年12月に発表されたGemini Deep Researchエージェントは、主要なAIベンチマークにおいて世界最高レベル(State-of-the-Art: SOTA)の結果を記録しています。

### 3.1 Humanity's Last Exam (HLE)

「Humanity's Last Exam」は、AIの推論能力と専門知識を測るための極めて難易度の高いベンチマークです。

* **Gemini Deep Research**: **46.4%**

* **GPT-5 Pro**: 38.9%

* **Gemini 3 Pro (単体)**: 43.2%

この結果は、Deep Researchが単なるモデルの性能を超え、エージェントとしての自律的な調査能力によって、より難解な問題を解決できることを示しています [cite: 3, 7, 12, 13]。

### 3.2 DeepSearchQA

Googleは、エージェントのウェブ調査能力を測るための新しいベンチマーク「DeepSearchQA」をオープンソース化しました。これは900の複雑なタスクから構成され、情報の網羅性を評価します。

* **Gemini Deep Research**: **66.1%**

* **GPT-5 Pro**: 65.2%

このベンチマークでは、単に事実を当てるだけでなく、関連する情報をどれだけ網羅的に収集できたかが問われます [cite: 12, 13, 14]。

### 3.3 BrowseComp

ウェブブラウザ上の操作や情報特定能力を測る「BrowseComp」においても、高いスコアを記録しています。

* **Gemini Deep Research**: **59.2%**

* **GPT-5 Pro**: 59.5% (ほぼ同等)

これにより、Gemini Deep Researchが「見つけにくい事実」を特定する能力において、競合の最上位モデルと互角以上の性能を持つことが証明されました [cite: 7, 12, 13]。

---

## 4. 開発者向けエコシステム:Interactions API

2025年12月、GoogleはDeep Researchエージェントをサードパーティ開発者が利用できるようにするための新しいインターフェース「**Interactions API**」を発表しました [cite: 3, 15]。

### 4.1 Interactions API の特徴

従来の `generateContent` APIが単純なテキスト生成向けだったのに対し、Interactions APIはステートフル(状態保持可能)なエージェントワークフローのために設計されています。

* **統一インターフェース**: GeminiモデルとDeep Researchエージェントの両方を、単一のエンドポイント(`/interactions`)から利用可能です [cite: 15]。

* **長時間実行タスクのサポート**: リサーチタスクは数分かかる場合があるため、非同期実行(`background=True`)とポーリングによる結果取得をサポートしています [cite: 8]。

* **サーバーサイドの状態管理**: 会話履歴やツールの実行状態をサーバー側で管理し、クライアントコードの複雑さを軽減します [cite: 15]。

### 4.2 実装例

開発者はGoogle AI StudioでAPIキーを取得し、以下のようなコードでDeep Researchエージェントを呼び出すことができます(Python SDKの例)[cite: 8, 15]。

```python

from google import genai

client = genai.Client()

interaction = client.interactions.create(

agent="deep-research-pro-preview-12-2025",

input="Google TPUの歴史について調査してください。",

background=True

)

# その後、interaction.id を使用して結果をポーリングする

```

### 4.3 独自のデータソースとの連携

デフォルトのGoogle検索に加え、`File Search`ツールを使用することで、ユーザー独自のデータ(PDF, CSV, ドキュメント等)をアップロードし、それをリサーチの対象に含めることが可能です [cite: 3, 8]。

---

## 5. 競合比較:Gemini vs. OpenAI Deep Research

AIによる深層調査(Deep Research)の分野では、GoogleのGeminiとOpenAIのDeep Research(ChatGPT統合)が主要な競合となっています。それぞれの特徴と強みを比較します。

### 5.1 アプローチの違い

* **Gemini Deep Research**:

* **強み**: **「幅広さ」と「スピード」**、そして**「計画性」**。ユーザーに対して事前にリサーチプランを提示し、フィードバックを受け付けるインタラクティブなプロセスを重視しています [cite: 16, 17]。

* **統合**: Google Workspace(Docs, Gmail)との連携が強力で、既存の業務フローに組み込みやすい [cite: 1, 11]。

* **マルチモーダル**: ネイティブなマルチモーダル理解により、多様なデータ形式の統合に優れています [cite: 18, 19]。

* **OpenAI Deep Research**:

* **強み**: **「深さ」と「学術的厳密さ」**。より時間をかけて(10〜20分以上)、多数の引用を含む学術論文のようなレポートを作成することに長けています [cite: 16]。

* **スタイル**: リアルタイムでリサーチパスを調整する傾向があり、Geminiほど事前の構造化されたプランニングを強調しません [cite: 17]。

### 5.2 ユーザー体験の比較

一部のレビューでは、Geminiの方が「リサーチプランの提示」や「Googleドキュメントへのエクスポート」機能により、ビジネスユーザーにとって使いやすい(コントロールしやすい)と評価されています [cite: 17, 20]。一方で、純粋な情報の正確性や詳細さにおいてはOpenAIが優れているとする意見もあり、用途によって使い分けが推奨されています [cite: 16]。

---

## 6. 具体的な活用事例

Gemini Deep Researchは、その高い自律性により、様々な業界で「リサーチアシスタント」として活用されています。

### 6.1 ビジネス・市場調査

* **競合分析**: 競合他社の製品機能、価格戦略、市場シェアに関する公開情報を収集し、自社の内部資料と比較したレポートを作成する [cite: 1, 2]。

* **デューデリジェンス**: 投資対象企業の財務状況、法的リスク、市場の評判などを広範囲に調査し、初期評価を自動化する [cite: 1, 3]。

### 6.2 学術・技術研究

* **文献レビュー**: 特定のトピック(例:「AGIの実現可能性」)に関する最新の論文や記事を数百件規模で調査し、要約を作成する [cite: 20]。

* **技術文書作成**: 新しいプログラミングフレームワークや技術トレンド(例:「Google TPUの歴史」)について、正確な時系列と技術的詳細をまとめる [cite: 8]。

### 6.3 日常業務の効率化

* **製品比較**: 「MBAプログラムの比較」や「モバイルバンキングアプリのUX改善案」など、意思決定に必要な情報を表形式でまとめる [cite: 6, 21]。

* **プレゼン資料の準備**: 調査結果をGoogleドキュメントやスライドにエクスポートし、資料作成の時間を短縮する [cite: 20]。

---

## 7. 制限事項と今後の展望

### 7.1 現在の制限

* **実行時間**: 複雑なタスクの場合、完了までに数分から数十分かかることがあり、即時性が求められるチャットには向きません [cite: 8, 16]。

* **ハルシネーション**: Gemini 3 Proで大幅に改善されたとはいえ、AIが誤った情報を生成するリスクはゼロではありません。特に専門的な分野では、引用元の確認(ファクトチェック)が依然として重要です [cite: 3, 20]。

* **コスト**: 高度な推論と大量の検索を行うため、API利用時のコストは通常のモデル呼び出しよりも高くなる傾向があります(Gemini 3 Proと同等の価格設定)[cite: 13]。

### 7.2 今後の展望

Googleは、Deep Researchエージェントをさらに多くのGoogle製品(Google検索、NotebookLM、Google Finance)に統合する予定です [cite: 3, 5]。また、Interactions APIを通じて、サードパーティ製アプリ内での「自律型リサーチ機能」の実装が加速すると予想されます。

さらに、DeepSearchQAベンチマークのオープンソース化により、研究コミュニティ全体でのエージェント性能の向上が期待されています [cite: 3]。

---

## 8. 結論

Gemini Deep Researchエージェントは、生成AIの活用フェーズを「チャット(対話)」から「エージェント(代行)」へと引き上げる重要なマイルストーンです。Gemini 3 Proという強力な基盤モデルと、Googleの検索技術・Workspaceエコシステムを融合させることで、ビジネスや研究における情報収集のあり方を根本から変革する可能性を秘めています。

特に、HLEやDeepSearchQAでの高いベンチマーク結果は、このエージェントが単なる便利ツールを超え、専門家レベルの推論と調査能力を備えつつあることを示唆しています。開発者にとっては、Interactions APIを通じてこの強力な機能を自社サービスに組み込めるようになったことが、2025年以降のAIアプリケーション開発における大きな転換点となるでしょう。

**Sources:**

1. [gemini.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQERfKxu2pozmoxK2vlFjmSu-wh03u9Ja-rK9SSvYSYxqBe1D1AlQQRIktPGeVBxs6Tfm6JgeIzr349DsOC4GfhroIdlbQgKnwzxVv4etjbXoeuL92bPZoORxFOT15w0mQTAjYM=)

2. [digitalapplied.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGfAyhRiRp7WpbpeSvdlpEOB1nrH0WaQsSDwhrIhCV3kvGFmuZEq_v1ak5Gh1qPOEMnDXiZyuxWLtyP5BtbgyDiY5hHt81-CYOzHZNZT9YfRDRrNXs4g6ZtAsQnuFJ059ELRAlgqpVn79ordvLwjnmw64UTXGVlzmNEcEM=)

3. [blog.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFFP8ECIokkgf8TZiIf8_HZgsekNFXYJMXVnWy-giYYWjLOS7gOHxJ9WIdgH6v46EXfNz3_wR-lEORquYqvIzqIR2yU_DF1a1ytwRBh5aMVaYrttDcX5QKFan11WLHiJm1UKbzjpKW9QcdJn3K3J_vGK_7MDH1uyKk6-lb9IIDQ)

4. [gemini.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFXhsDTTb9RHnc5tH73o6BR5uqBf23fArirCaeZK8NC1YD_QJmUMp01ZCr6Zw5lAx_0uhl7MttbRxiNgkpDiBLbWKnBREolC_FkODacmKFgRyIu3Cnfu4CABal0Ltv-8bkLf-jSSL0UFpj6L3w=)

5. [gigazine.net](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQG0-fuXN2kw4QeOi6IdCZrLTqWX20h8B9xf7s2GyBARSXk77yWrX034Bl3I83RenwB_Uq8uBkCSJ6kZcgJvGXmTO1ygK0NbtxE5STM3myLeoPiPCUxzGG5z2vWStkYzWiAure7_pf0iT51OeX25CA==)

6. [blog.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE0JQka_pKCCu1X6qE3qUYttEcTNi0fIele7wjAjVbDl7oF2GMmQFCEi3qbp9KaOV6FqREsef7MDz47mjEQbV5dTILjFCCYBjiwMG3Y0beFS795959CV4xQL6u1eyrH6dLwy3UqxFcNyeqaq916ylVd3NqIRk1B5meStcDzO04coFlIhK45mDyE_JO_)

7. [9to5google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQF6ByrIDuGoFACOhbe2OqJ1PLvOeL5MydE58C5di1e36u7qSNcKZQq9UBxL0OvfS7IZzMawwyAMpg7Nkfrp0NKg4MOVvaRbUxm4QGpA-56YHQ6Vt0qqPRxhiH60UGHdQ9s1Jko9ljt_XWeArownB02Z9cfV)

8. [google.dev](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHY8MUO4fWLda0wt1L6xAnDAnIVceV9QEaq5txudZ21C_laNdfSHpK7BjoPDsvbWuadSmvIoncjtn3_ecoBPfu-V9gxLOIIbilKM3obA00DUfOvjFR8TNNoIq9PMrZ9uO7WpsMy_wBze3s=)

9. [the-decoder.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEg05lD1w-NOpQzVPi6HdDJ6P5hJ4RbjBcL3RBsg7G43rTlSyzAM6nFuowoiDAh8K0rhKOnC82_3olHrKoUFNCxFEEhJNHeBXuqSj25AGt2lny6LLW5LsxjFytIsAKXxfN5MytCK5M1N2yCWchNP20fh0rtSg5-cNycbzPQjLj26UQoOS7RPHdeXaPRaKxW4EDmcg==)

10. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGzkit1VXnPecK7IXbDrs6z5p00O9X-dWE2aZeMFg7oYG7Ahjb7CYFwTDPumxhnZR8JQ-vYvf0CXLvaMDtFSAxwfKh3SUjsLUS2_IjkMJKO9qtH5EdnR2m-FXze8GfurcbPZY2oIm2KFUf1ORNUhjXNSH7AEy8WBor3j8BoC4es6HjXu5k=)

11. [theregister.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE-JwFT7chnEYko5wAGPdQ0W2pPiw1YZK7jVRsm20j9ufqGUIVEIm6umdut9ktBg--8ldVS-hWwsB-qw9gjD4BSj8F_qdbW8JdFiLC-HP2itInFhhIr-C0kgh5idzjVg55pwH9zOPAEvedMlo6CaCFGyQJmaulE_w9zvg==)

12. [reddit.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQF0gj7eh8UXDAfwJ5z0_De5uSRO44_rZpWHkusADZHOqmEEqtlAoJ4k0UgQKSUm2DLUhSH8YYHJtaxvjMy9v2EyKof6hRU1CxWXdYeB7aGAj4S4x2-JYYrisNd8LiNGTH0oMc4TRm-vR8dMVPJuIJFFs6idba4kSAMG6IdEJxFmU4sQKbcinI0h5t0r7jP_o41-ShJHZon6oLisJlzb)

13. [analyticsindiamag.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFxq-t7to3nPQcZxGHKAcPcAweFy0JBo0PYGskivZ-a5ViTJHHLXELHdR-y5CxIeNqEbxWaCA4wiO2Xwq9zv_NgvsU-Vj05TLEb3fO55z2GSS1WO8zFx_RxtHLGqDvBeh34-A_F2_qd5fWDwgLHjwsqfwDpC7C95vV1Gt5V1cuI5kwgsM8obJsDvXtnagUCPu-KmWqevoOfV5DF_UuY-B8uohY46vsU)

14. [kaggle.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQFSQOyHWfmnKHPWlzWaxZ-8lriCTn3MwzAnTl2UIG3IR3QZix0OCiVr-wnm473xekoCgdMkp_GHr9cyYIkyPd4cy7YRBXbbxeLTwGL3yswPnXj8f8D0bU_dTg75vqJb-b9pgDvjQqBjrNzlo-sEGKA=)

15. [blog.google](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHar7IyYAqRuE3WRpy35LD27mO1E9UXZoy9c9zNeCuGhBliDFVKPF09MHJuyfJ0FmhK60rf-wl-CJwBxaawtXWzECATJhRNXtkBRXK5qDybszRUKW1aR-vh635oLcgmvpurQEn07lQq3KAyXlRLs5f5Ag==)

16. [7minute.ai](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE2xIwQGLpfabNi224PhjFfGpU0DB2dJ5oQ-y7ds_8fc_T7NeL5ecXlPWz3b8c3KjAo3Myz6SyHR9kRJfOifT9xLsHfljfNIXnZ3D9neC1jwd2jDRmBu843ccKmnc9qFe2Re7jO5elGlEf3B2jg3QbsCRsHksq8)

17. [sectionai.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQE7hKS_r9N9NS94GXF75SmiadVvne8kI5JiibqchapgoH2TIDM6nZ2KFEqKIeOCo-hrjph8KLMIBBTOVPFjNECdv4RxBehvN17obTii1i_xQ67ICKteWmtKXX-gszfAdJu-ENwzHgKgCqchxoASC-ds98njyw==)

18. [geeksforgeeks.org](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQEiEM-JvKOpXaHKNuTabCBLyZIEg2oGsk2VShwdOC_fqYyD5E0IWFLWkzIvBWXG0I9sj3Tv8y1J7ItxKhq1ujwRiFt63WP-y8lVLjYZJdFvEIMhVcYNifZcdezRuyhSaGpgYnAOm_rgoeAZ6MHyagniydfBRXxSn0DRDcS5vLTQBWSe_3VjSDDSvZPjbVYVEzA17egYpf_oiGkZUCcCvnw=)

19. [reelmind.ai](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQGLU8JuSovN-hWi9mc0Ttf_L9_oO0VoTyeEIoGtJyX8RhYLmZXDYPxTCuHpxwYHNypgQqd3bZlHgH3cdFF90PBibNSxRy5psL2VtkxUX5vIbFDdQ_UZoRkKP9ttOfuoZU5Z-JhntMEe6q5lQLmuLcrfaxKngWiq7eA_5Q6ExNWITkO0m7Yg50hGoCWzwelifin21_jekdZ_aoLD_9j6Og==)

20. [philipptarohiltl.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQF97onBwPzz2TgQlNEWcHwwq9GNsxyOmRj3DUL_uLpGEHMaNIoIQNuiEoTSFSYORSzO8yTSTdV9s8dSNp8DTl-iVGFhsW0UY_SIS4JVqwAOZNLBBn3cro6t9G-7QNpj_scOEOiHaBt1CSApW_2PRvrQBwXN703Evk8q7YL5g5IizdzK)

21. [google.com](https://vertexaisearch.cloud.google.com/grounding-api-redirect/AUZIYQHT-6ZhB2Qstgke37a0knLBU7UgDzX2TAZ02o5zbZ1errsABtiXJS2a_CNK6hIpZyh5OEKMEV2TKYSITTedhZbgu9zzHkYlLc6vUfmYWhKTj96ldxPvoNgpk1LKXKaQTVwR8OYCEDWvg3ZW8NjHqS2wXyqG2lBG0D4XK2gH6g==)

そして上記をMarpでスライドにしてみると…

レイアウトなどを整えていないので、見た目はイマイチな感じですが、Marpのレイアウトを作っておき、Gemini Deep Research agentに与えるプロンプトももう少し工夫をすれば、資料作成があっという間に終わりそうです。

まとめ

本記事ではGemini Deep Research agentの概要から仕組み、実際に使ってみた所感について解説をしました。これまでGeminiはあまりリサーチ系が得意ではない…といった声が聞かれていましたが、Gemini Deep Research agentによって、リサーチもGeminiに任せられるようになるかもしれませんね。

ぜひ皆さんも本記事を参考にGemini Deep Research agentを使ってみてください!

最後に

いかがだったでしょうか?

リサーチや調査レポートの精度を高めたい方は、Gemini Deep Research agentの活用してみてはいかがでしょうか。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。