【HY-Motion 1.0】Tencentのテキストだけで3Dモーション生成ができるAIモデルを徹底解説!

- 自然言語の指示から高品質で滑らかな3Dキャラクターの動作を生成できる画期的なAIモデル

- パラメータ規模は10億(1B)にも上り、同種のモデルとしては世界初の大規模オープンソース化

- 標準版の「HY-Motion-1.0」(パラメータ数1.0B)と、軽量版の「HY-Motion-1.0-Lite」(パラメータ数0.46B)の2種類のモデルが搭載されている

2025年12月30日、Tencentの混元(フンユエン)チームは、自然言語の指示から高品質で滑らかな3Dキャラクターの動作を生成できる画期的なAIモデル「HY-Motion 1.0」を公開しました!

パラメータ規模は10億(1B)にも上り、同種のモデルとしては世界初の大規模オープンソース化となりました。

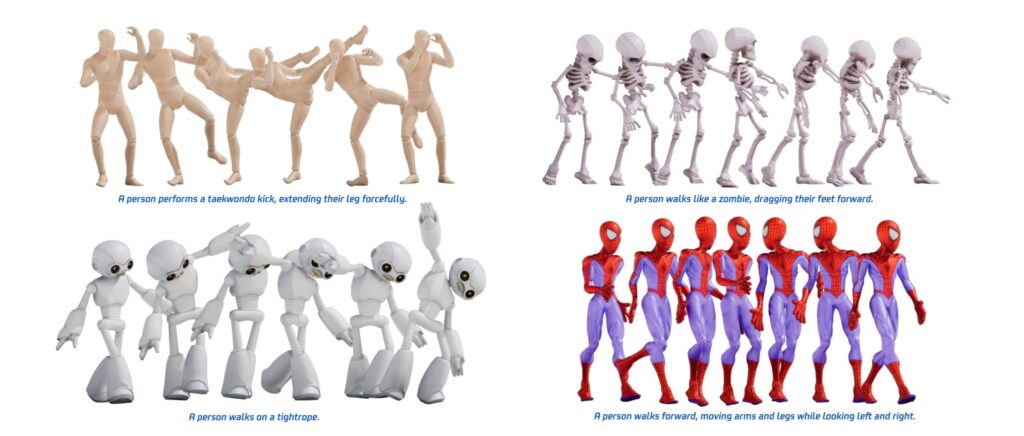

例えば、「椅子に腰掛ける」「両脚で2回ジャンプする」「ゾンビのように歩く」といった簡易な日本語または英語の説明文を与えるだけで、対応する人型キャラクターの骨格アニメーションを自動的に作り出すことができます。

本記事では、このTencent HY-Motion 1.0について、その概要・特徴から性能評価、ライセンスや具体的な使い方をご紹介します。

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

HY-Motion 1.0の概要

Tencent HY-Motion 1.0は、テキストから3Dヒューマンモーションを生成するための最先端AIモデルです。

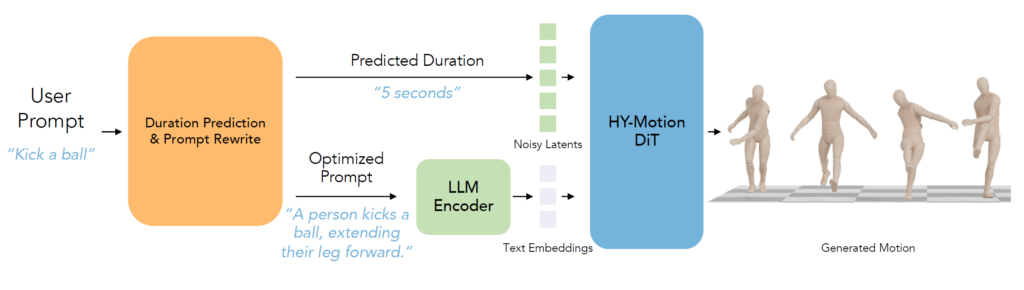

内部的にはDiffusion Transformer(DiT)という拡散モデルベースのTransformerアーキテクチャと、Flow Matchingという学習手法を組み合わせていて、このアプローチをモーション生成分野で初めて10億パラメータ規模にスケールさせた点が大きな特徴です。

入力として与えられた自然言語のプロンプトと、希望する時間から、SMPL-Hフォーマットの3D骨格モーションデータを出力するものとなっています。

生成されたモーションデータは人型キャラクターのボーンに対応しており、そのままBlenderやUnity、Unreal Engineなどにインポートして再生させることも可能です。

HY-Motion 1.0は、2種類のモデルが公開されており、標準版の「HY-Motion-1.0」(パラメータ数1.0B)と、軽量版の「HY-Motion-1.0-Lite」(パラメータ数0.46B)があります。

どちらも基本的な機能は同じで、簡単なテキストからキャラクターの動作を生成できますが、Lite版はモデルサイズが約半分な分、若干出力の表現力が抑えられる可能性がある代わりに、動作に必要なGPUメモリが少なく済みます。

HY-Motion 1.0の性能

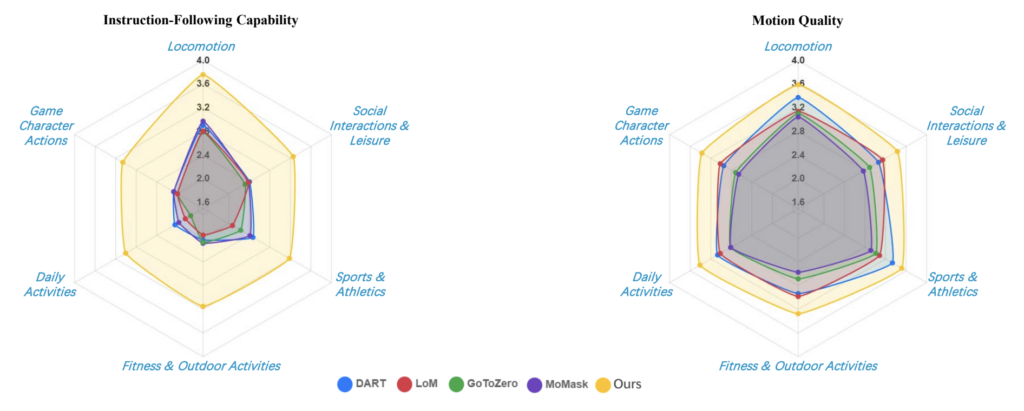

Tencent HY-Motion 1.0の性能は、公開されたベンチマーク結果によると、現行のオープンソースモデルの中でもトップクラスです。

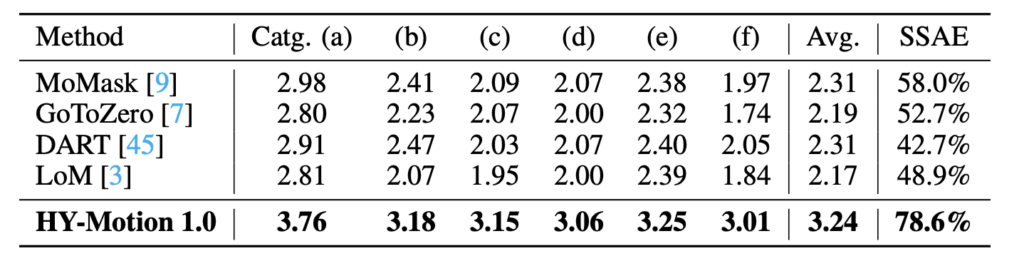

開発チームは、6カテゴリーにまたがる2,000以上の多様なプロンプトからなるテストセットを用意し、各モデルが指示に忠実な動きを生成できているか、および動きの品質(自然さ、滑らかさなど)を5段階評価でスコアリングしたそうです。

その結果、HY-Motion 1.0の指示遵守性は、平均3.24点(5点満点)、またSSAE(指示どおり動けている割合を示す指標)は78.6%に達しました。

一方、比較対象となる既存のオープンソースのモーション生成モデル(例えばDARTやLoM、GoToZero、MoMaskといった手法)は、指示遵守性スコアがいずれも2.1~2.3点程度、SSAEも42.7~58.0%程度に留まっていて、HY-Motion 1.0は指示どおりに動きを再現する正確さの面で他を大きく引き離しています。

生成されるモーションの質についても、HY-Motion 1.0は平均3.43点を記録し、ベースラインの中で1番良かったモデル(平均約3.11点)を上回りました。

総合的に見て、HY-Motion 1.0は、複雑な指示への対応力や多様な動きカテゴリの網羅性において特に優れていて、公開済みの他モデルでは対応が難しかった同時動作の組み合わせ指令などでも高いスコアを誇っています。

HY-Motion 1.0のライセンス

Tencent HY-Motion 1.0はオープンソースとして公開されていますが、そのライセンス形態は、一般的なMITやApache 2.0とは異なり、Tencent独自の「Hunyuan Community License」が適用されています。

これは、近年増えている大規模AIモデル用の独自ライセンスの一種で、基本的には、研究目的や非営利・商用を問わずコミュニティ内での自由な利用・改変・再配布を認めつつ、特定の用途に関する使用制限や一定以上の大規模利用時の追加条件などが定められているのが特徴です。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | ⭕️ | |

| 改変 | ⭕️ | |

| 配布 | ⭕️ | |

| 特許使用 | ⭕️ | |

| 私的使用 | ⭕️ |

HY-Motion 1.0はオープンソースとして公開されていますが、その著作権およびモデル自体の所有権はTencentに帰属しています。

上記のように商用利用も含め基本的な利用は許可されていますが、ライセンス条文に沿って適切に扱う必要があります。

HY-Motion 1.0の料金

HY-Motion 1.0自体の利用料金は無料です。

オープンソースとして公開されているので、モデルのコードや学習済みウェイトをダウンロードして自前の環境で動かす分にはライセンス料やサブスクリプション料金は一切かかりません。

ユーザーに求められるのは計算リソース(GPUなど)だけで、モデルそのものはTencentから無償提供されています。

HY-Motion 1.0の使い方

HY-Motion 1.0は、オープンソースモデルということもあり、利用方法も柔軟です。

手っ取り早く試してみたい場合には、公式のWebデモ(Hugging Face Space上のアプリ)を使うのが簡単ですし、開発用途でしっかり使いたい場合には、自分のPCやサーバーにモデルをインストールして実行することもできます。

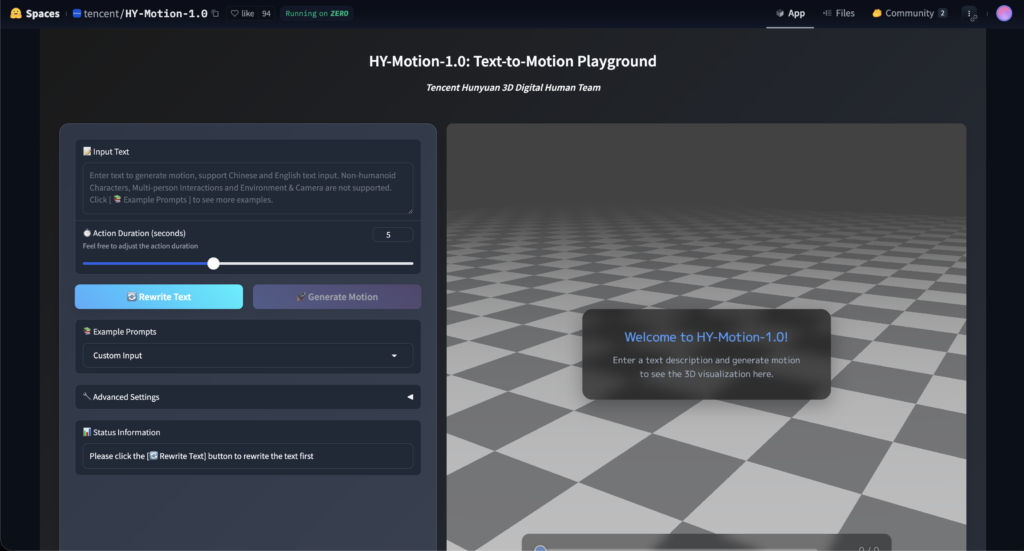

公式デモ

Tencentが公開しているHuggingFace上のデモサイトを開くと、テキストボックスや実行ボタンが用意されたインターフェースが表示されます。

使い方はシンプルで、まずテキストボックスに英語でキャラクターにさせたい動作を入力します。

例えば “A person jumps upward with both legs twice.” のように、できるだけ具体的に動きを文章で記述します。続いて、生成したいモーションの長さ(時間)を指定します(例: “5 seconds” や “3秒” など)。

準備ができたら実行ボタンを押すと、モデルがサーバー上で動作し、指定した動作の3Dアニメーションを生成します。完了すると、画面上に簡易な3Dビューワが表示され、人型のボーンモデルが入力した指示どおりの動きを再現するはずです。

ローカル環境へダウンロード

本格的にHY-Motion 1.0を使い込む場合や、生成結果の細かな調整・大量のバッチ処理などを行いたい場合は、モデルをローカル環境(手元のPCやサーバー)にセットアップする方法がおすすめです。

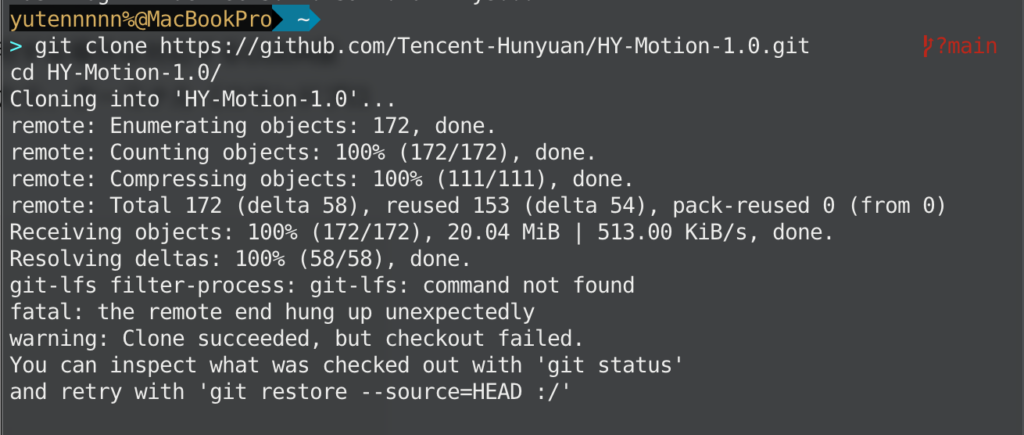

まず、実行環境としてPython 3系とPyTorchが動作するマシンが必要です(GPUを使用する場合は対応するCUDA版PyTorchをインストール)。UbuntuやWindows/Linux環境でGPUが使えるPCを用意したら、ターミナル(コマンドプロンプト)を開き、以下のようにリポジトリをクローンします。

git clone https://github.com/Tencent-Hunyuan/HY-Motion-1.0.git

cd HY-Motion-1.0/

# 大きなファイルを扱うので外部拡張git-lfsをインストールしておくとベター

git lfs pull

pip install -r requirements.txt

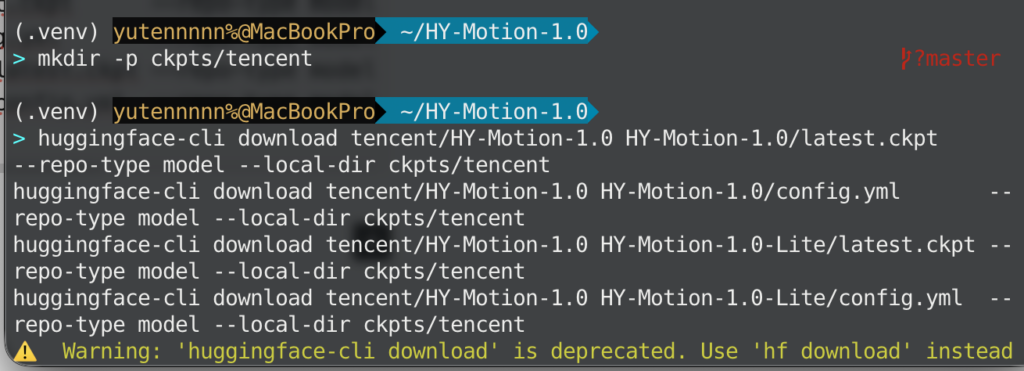

コードのセットアップができたら、次に学習済みモデル(ウェイト)のデータを入手します。

Hugging Faceのtencent/HY-Motion-1.0から**「HY-Motion-1.0本体」と「HY-Motion-1.0-Lite」**それぞれのモデルファイルを取得し、HY-Motion-1.0/ckpts/tencent/ディレクトリ以下に配置します。

# リポジトリ直下で実行(HY-Motion-1.0/ の中で)

mkdir -p ckpts/tencent

# 4ファイルだけ(本体+Liteの ckpt と config)

huggingface-cli download tencent/HY-Motion-1.0 HY-Motion-1.0/latest.ckpt --repo-type model --local-dir ckpts/tencent

huggingface-cli download tencent/HY-Motion-1.0 HY-Motion-1.0/config.yml --repo-type model --local-dir ckpts/tencent

huggingface-cli download tencent/HY-Motion-1.0 HY-Motion-1.0-Lite/latest.ckpt --repo-type model --local-dir ckpts/tencent

huggingface-cli download tencent/HY-Motion-1.0 HY-Motion-1.0-Lite/config.yml --repo-type model --local-dir ckpts/tencent

ダウンロードにはある程度時間がかかるかと思います。

セットアップが完了したら、いよいよモデルを使ってモーションを生成してみましょう。

# 標準モデル(1.0B)を使う場合

python3 local_infer.py --model_path ckpts/tencent/HY-Motion-1.0

# Liteモデル(0.46B)を使う場合

python3 local_infer.py --model_path ckpts/tencent/HY-Motion-1.0-Lite初回実行時にはモデルデータの読み込みに少し時間がかかります。

実行がスタートすると、デフォルトではinput_textディレクトリ内にあるテキストファイルが順次読み込まれ、対応する動作が生成されます。生成された結果のモーションデータは、標準ではoutput/local_inferディレクトリ配下に出力されます。

また、コードを実行して結果ファイルを得るだけでなく、もっとかんたんに対話的にモーション生成を試したい場合は、用意されているGradioベースの簡易Webアプリを使う方法があります。

リポジトリ内にgradio_app.pyというスクリプトがあり、これを実行するとローカルマシン上でブラウザ経由のインターフェースが立ち上がります。

python3 gradio_app.py実行後、ブラウザでhttp://localhost:7860にアクセスすると、Hugging Face上のデモと似た画面が表示されるかと思います。

以上、主な使い方のご紹介でした。

HY-Motion 1.0を使ってみた

それでは実際に、デモサイト上でHY-Motion 1.0を試してみましょう。

まずは、映画『マトリックス』で有名な「弾丸をよける動作」を以下プロンプトで表現して実行しました。

A person bends backwards in slow motion to dodge a bullet, then stands back up.なんとなく特徴は捉えてくれていますが、スローモーション感やのけぞる動きは表現できませんでした。(プロンプト次第では再現できるかもしれません)

続いて、少し複雑な連続動作も試してみます。

A person jumps up twice with both legs, then does a quick bow.

(両足で2回ジャンプしてから素早くおじぎをする)多少やる気のないおじぎですが、最後のジャンプ後に素早くおじぎ動作に入っています。このあたりは指示追従性の高さが確認できますね。

使ってみた印象は「期待以上に実用的で面白い」と感じました。

生成系AIというと、ときに不安定だったり設定が難しかったりするイメージもあるかと思いますが、このモデルに関しては、事前準備さえ整えれば操作自体は直観的で、出てくる結果も一貫して質が高いものでした。

もちろん万能ではなく不得意な領域もありますが、それを差し引いても、3Dアニメーション制作のあり方を変える可能性を感じさせるに十分なクオリティだと思います。

気になる方は、ぜひ一度試してみてください!

まとめ

HY-Motion 1.0は、テキスト指示から3Dキャラクターの動きを生み出すという新分野において、画期的なモデルだと思います。

専門的な知識や機材がなくても、テキストプロンプトだけで直感的に多彩なアニメーションを得られるので、ゲーム開発やCG制作のプロセスに大きな変革をもたらす可能性がありそうです。

気になった方は一度試してみてください。

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。