【Kimi K2.5】エージェント指向マルチモーダルLLM!Moonshot発オープンソースモデルの強みと使い方を徹底解説

- Moonshot AI発、約1兆パラメータのMoE構造を持つオープンソースのマルチモーダルエージェントAIモデル

- 基盤モデルに約15兆トークンの追加学習がなされ、ビジョンと自然言語の理解をシームレスに統合

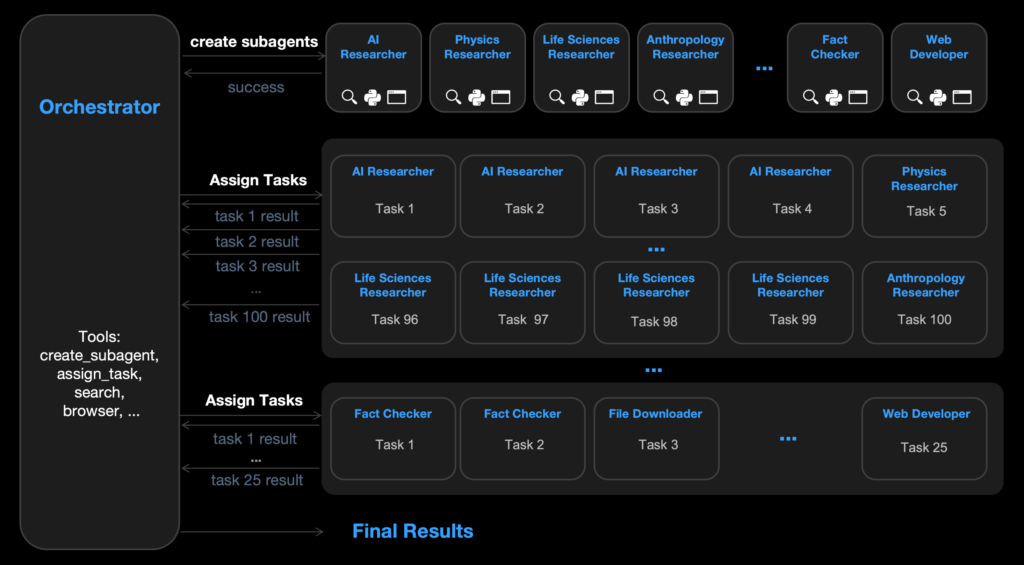

- 最大100体のサブエージェントを自動生成して並列実行する「Agent Swarm」機能

2026年1月27日、中国のAIスタートアップMoonshot AIは、約1兆パラメータのMixture-of-Experts構造を持つオープンソースのマルチモーダルエージェントAIモデル「Kimi K2.5」を発表しました!

Kimi K2.5は、テキスト・画像・動画をネイティブに理解できる上に、高度なエージェント能力を備えており、即時応答(Instant)モードと推論重視(Thinking)モードの両方をサポートしています。

基盤となるK2-Base上に、約15兆トークン(テキストと視覚情報の混合データ)で追加学習されており、ビジョンと自然言語の理解をシームレスに統合しています。

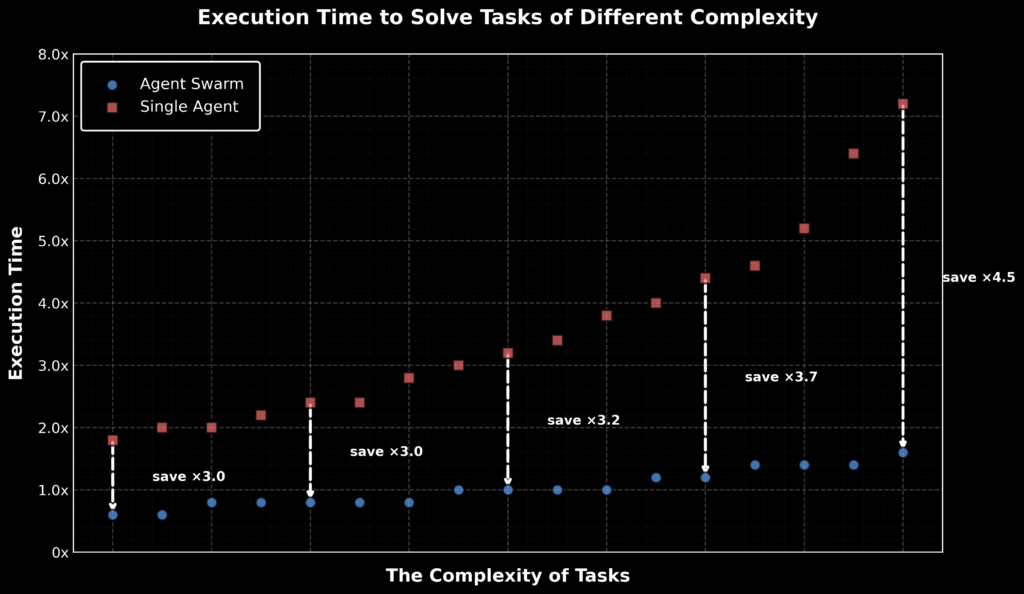

さらに、複雑なタスクを処理する際には、最大100体のサブエージェントを自動生成して並列実行する「Agent Swarm」機能を備えており、これにより一つの作業を分割して効率的に高速処理できます。

K2.5はコーディング支援にも強く、たとえばUIデザイン画像を入力するだけで対応するHTML/CSS/JavaScriptコードを生成することも可能とのことです。

そこで本記事では、Kimi K2.5の概要や性能、使い方を徹底的に解説します。

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

Kimi K2.5の概要

Kimi K2.5は、Moonshot AIが公開した視覚とエージェント能力を前提に設計された、オープンソースのネイティブ・マルチモーダルモデルです。

テキストだけでなく画像や動画もそのまま理解し、会話の流れの中で見たものを根拠に推論したり、コード生成やデバッグに繋げたりすることができます。

基盤モデルKimi K2をベースに、視覚とテキストを混ぜた大規模データで継続事前学習(約15Tトークン)を行ったことで、ビジョン能力とテキスト能力をトレードオフにせず、両方伸ばしているそうです。

1番特徴的なのは「Coding with Vision」です。フロントエンド開発が強く意識されていて、会話だけでUIを組み立てたり、画像・動画を見せて「この見た目を再現して」「どこが崩れているか原因を突き止めて」といったケースでも処理することができます。

さらに、複雑なタスクにおいては、モデル自身がタスクを分割し、最大100のサブエージェントを自律的に編成して並列実行する「Agent Swarm」機能も備わっています。

また、利用方法としては、Kimi.com/Kimiアプリ/公式API/同時に公開されたKimi Codeなど、複数用意されていて、用途に応じてモードを選べるのもありがたいポイントです。

余談ですが、日本時間 1月28日(水)10:40頃〜11:00頃、Kimi関連サイトが一時ダウンする事象が発生していました。Kimi K2.5のリリースはSNS上でかなり注目を集めており、アクセス負荷がかかった可能性も原因の1つとしてあるのかもしれません。(※現在は復旧しています)

なお、Kimi K2について詳しく知りたい方は、以下の記事も参考にしてみてください。

Kimi K2.5の性能

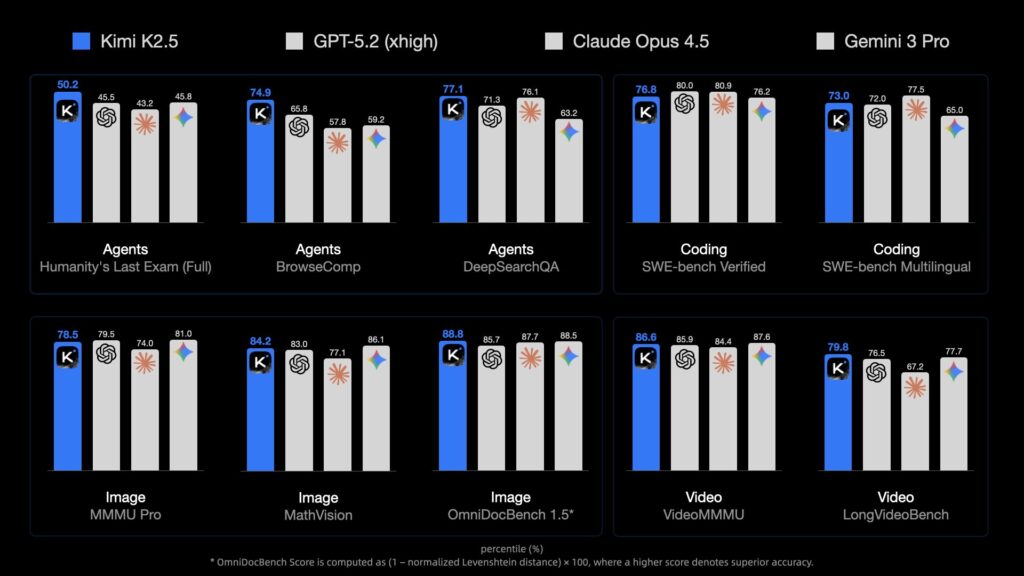

Kimi K2.5は各種ベンチマークで高い性能結果を残しています。

ベンチマーク結果では、エージェントタスク(Humanities Last ExamやBrowseCompなど)において、GPT-5.2やClaude 4.5 Opusを上回る成績を記録し、「オープンソースモデルでありながらエージェント性能で上回る点が最大の特徴」だと報告されています。

テッククランチの記事でも、Kimi K2.5は、コーディングタスク(SWE-Bench Verified)でGemini 3 Proを上回り、VideoMMMUと呼ばれる動画理解ベンチマークでは、GPT-5.2やClaude Opus 4.5を圧倒していると伝えられています。

また、Agent Swarmの活用により、従来の単体エージェント処理と比較して最大4.5倍の高速化(総処理時間は約80%短縮)を実現できるとされています。

Moonshot AI公式のリリースノートでも、「いくつかのエージェントベンチマークで優れた性能を低コストで達成した」と報告されています。

Kimi K2.5のライセンス

Kimi K2.5は、Modified MITライセンスのもとで公開されています。

基本的には、MITライセンスと同様に商用・私的利用、改変、再配布が可能です。ただし追加条件として、「月間アクティブユーザーが1億人を超える、もしくは月間収益が2,000万米ドルを超える場合、製品UI上に『Kimi K2.5』と明示する必要がある」と定められています。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | ⭕️ | 大規模商用時はUIに「Kimi K2.5」表記が必要 |

| 改変 | ⭕️ | |

| 配布 | ⭕️ | |

| 特許使用 | ⭕️ | |

| 私的使用 | ⭕️ |

Kimi K2.5の料金

MoonshotのAPIプラットフォームでは、トークン利用量に応じた従量課金制となっています。

Kimi K2.5モデルでは、入力トークン料金は100万トークンあたり$0.60、キャッシュヒット時は$0.10、出力トークン料金は100万トークンあたり$3.00に設定されています。コンテキスト長の上限は約262,144トークンです。

これらの価格は、他の大型モデルと比べても割安な水準とされていて、ローンチキャンペーンでの優遇措置も行われています。

Kimi K2.5の使い方

Kimi K2.5の主な利用方法は、①公式Webチャット、②API経由、③Kimi Codeなどがあります。

①公式Webチャット

1番お手軽なのはこちらの公式Webチャット経由での利用です。

Webチャットページにアクセスし、必要に応じてアカウント登録を済ませると、チャットを利用できるようになります。

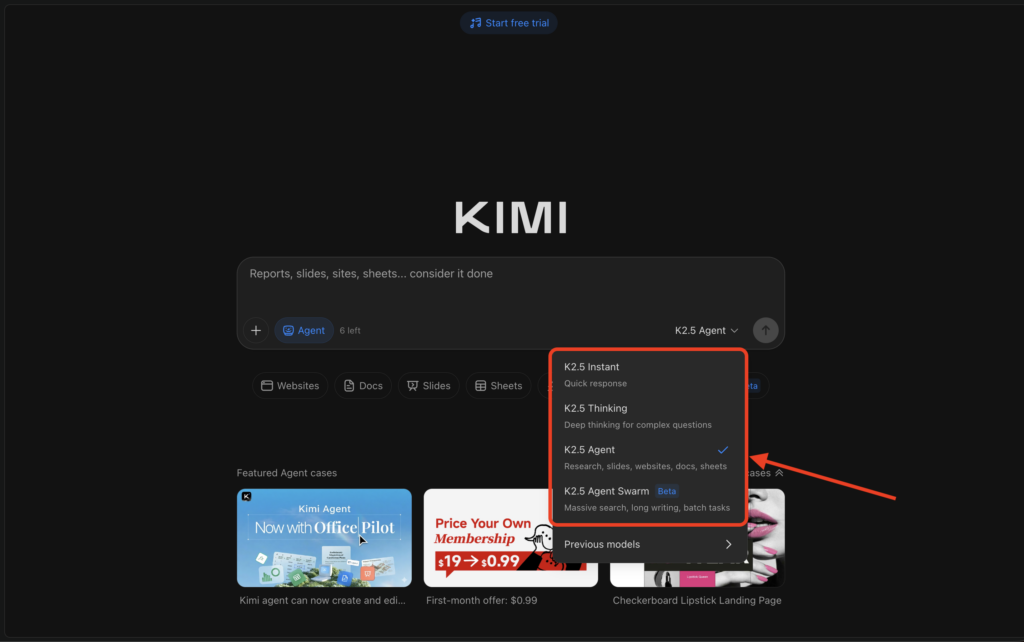

即時応答(Instant)モード、推論(Thinking)モード、エージェント(Agent)モード、並列実行(Agent Swarm)モードの4つが搭載されていることが分かります。

用途に応じて好きなモードを選択して、チャットをするだけでモデルを試すことができます。

②API経由

K2.5はMoonshot公式プラットフォームのAPIで利用可能です。OpenAI互換のインターフェースが提供されており、PythonのOpenAIライブラリなどで呼び出せます。利用例として、以下のようなPythonコードでチャットを行うことができます。

import openai

# Moonshot APIのエンドポイントとAPIキーを設定

client = openai.OpenAI(

base_url="https://api.moonshot.ai/v1",

api_key="YOUR_API_KEY"

)

messages = [

{'role': 'system', 'content': 'You are Kimi, an AI assistant created by Moonshot AI.'},

{'role': 'user', 'content': '9.11と9.9、どちらの数値が大きいか答えてください。'}

]

response = client.chat.completions.create(

model="kimi-k2.5", messages=messages, max_tokens=512

)

print("回答:", response.choices[0].message.content)上記では「Thinkingモード」で回答が返ります。即時応答の「Instantモード」に切り替えるには、リクエスト時にパラメータ{'thinking': {'type':'disabled'}}を追加します。

なお、Kimi K2.5は、画像・動画入力にも対応しているので、ビジュアル入力時は以下のように画像をBase64エンコードして渡すことで実行できます。

import base64, requests

url = 'https://huggingface.co/moonshotai/Kimi-K2.5/resolve/main/figures/kimi-logo.png'

image_base64 = base64.b64encode(requests.get(url).content).decode()

messages = [{

'role': 'user',

'content': [

{'type': 'text', 'text': 'この画像の内容を説明してください。'},

{'type': 'image_url', 'image_url': {'url': f'data:image/png;base64,{image_base64}'}}

]

}]

response = client.chat.completions.create(model="kimi-k2.5", messages=messages, max_tokens=512)

print("画像への回答:", response.choices[0].message.content)③Kimi Code

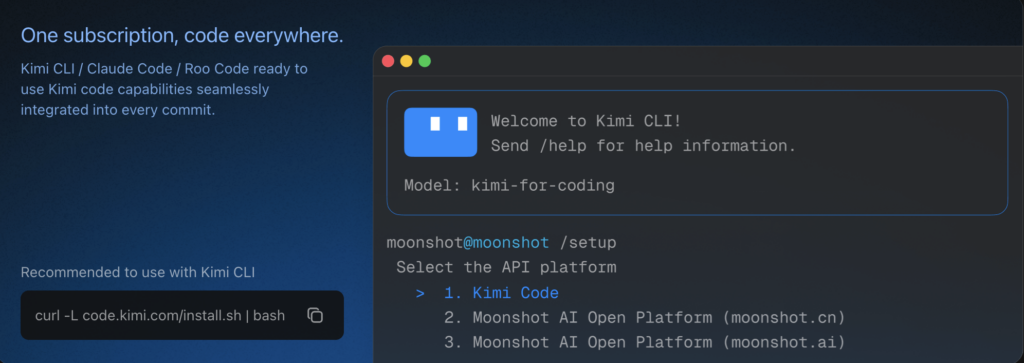

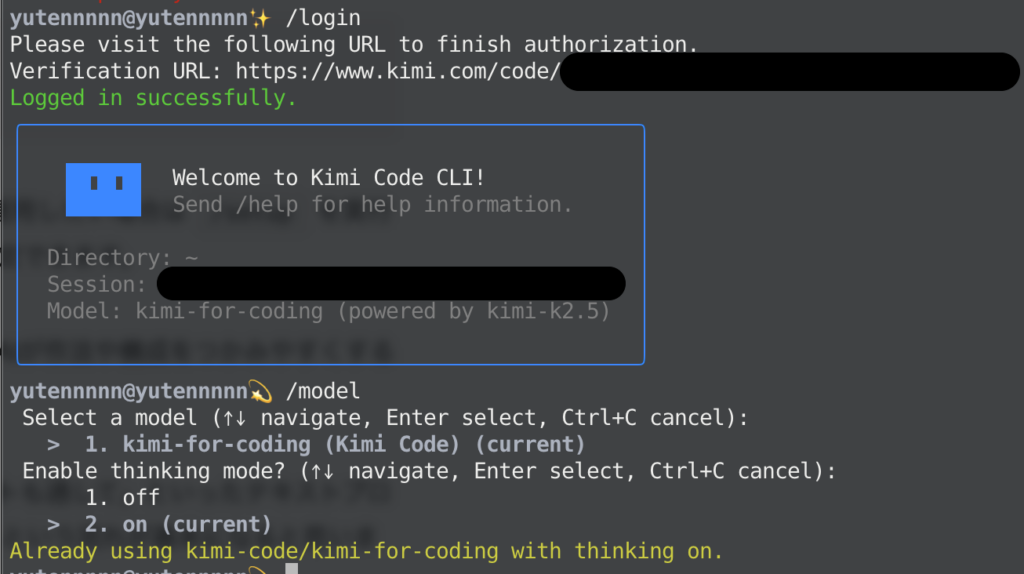

Kimi Codeは、ターミナル上で動く開発者向けのAIエージェントです。プロジェクトのコードを読み、修正案を出し、必要に応じてコマンド実行まで含めて一連の作業を進めることができます。

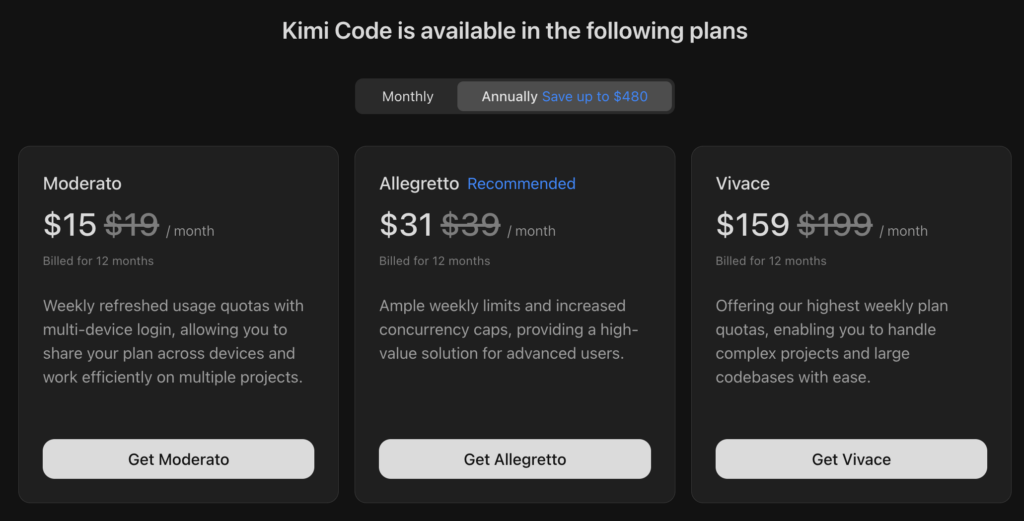

利用には、以下の3つの有料プランのいずれかに加入する必要があります。

curl -LsSf https://code.kimi.com/install.sh | bash

# インストール確認

kimi --versionもし既にuvが入っているなら、次のようにCLIだけ入れることもできます(Python 3.13推奨、3.12〜3.14対応)

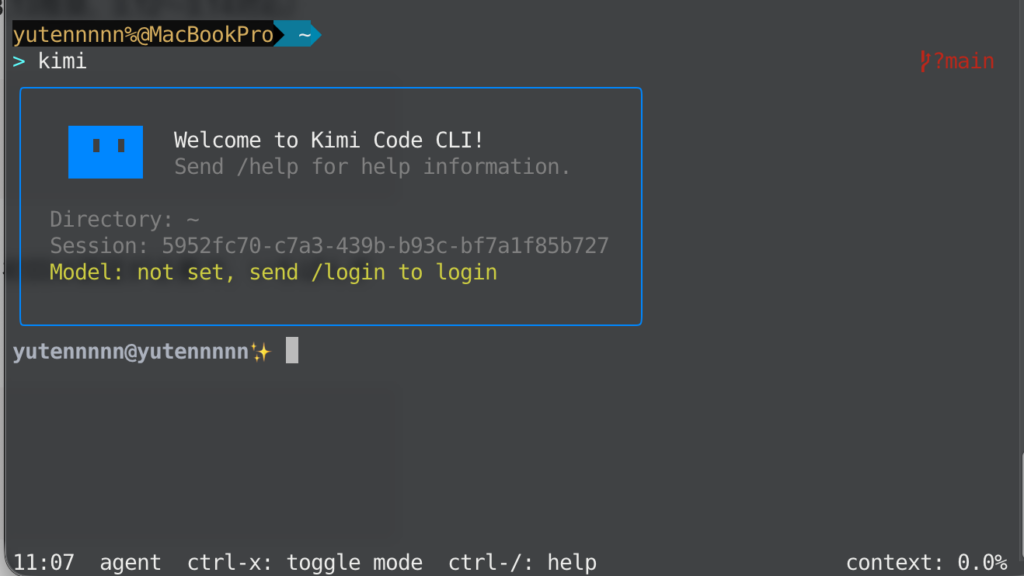

uv tool install --python 3.13 kimi-cliあとは、作業したいプロジェクトのディレクトリで kimi を実行するだけです。初回は認証が必要で、いちばん手軽なのは/loginでKimiアカウントにログインする方法があります。

cd your-project

kimi

/loginブラウザが開いて認可が終わると、CLI側の設定が自動で反映されます。APIキーで運用したい場合は/setupを実行すると、利用するAPIプラットフォームやキー、モデル選択までウィザード形式で設定できます。

使い始めとしておすすめなのが/initコマンドです。プロジェクトを解析して、AIが作法や構成をつかみやすくするためのAGENTS.mdを生成できます。

以降は「このバグの原因を調べて修正案を出して」「この関数をリファクタしてテストも通して」といったテキストプロンプトで依頼して、必要に応じて/helpでコマンド一覧を確認しながら進める、という流れが基本になると思います。

Kimi ChatとKimi Code CLIで使ってみた

それでは、実際にKimi K2.5(Agentモード)を試してみましょう。

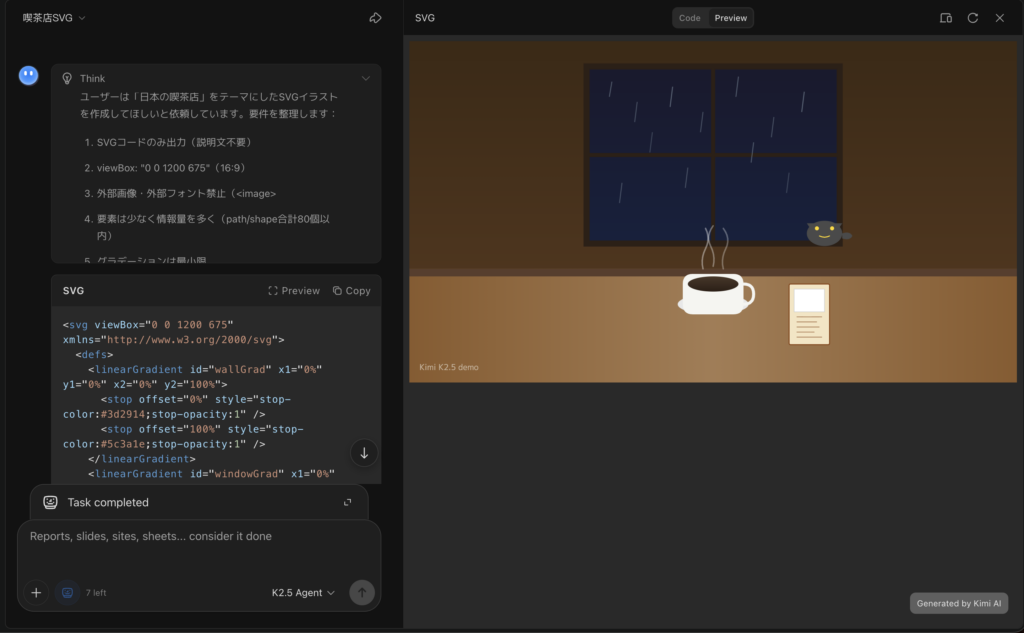

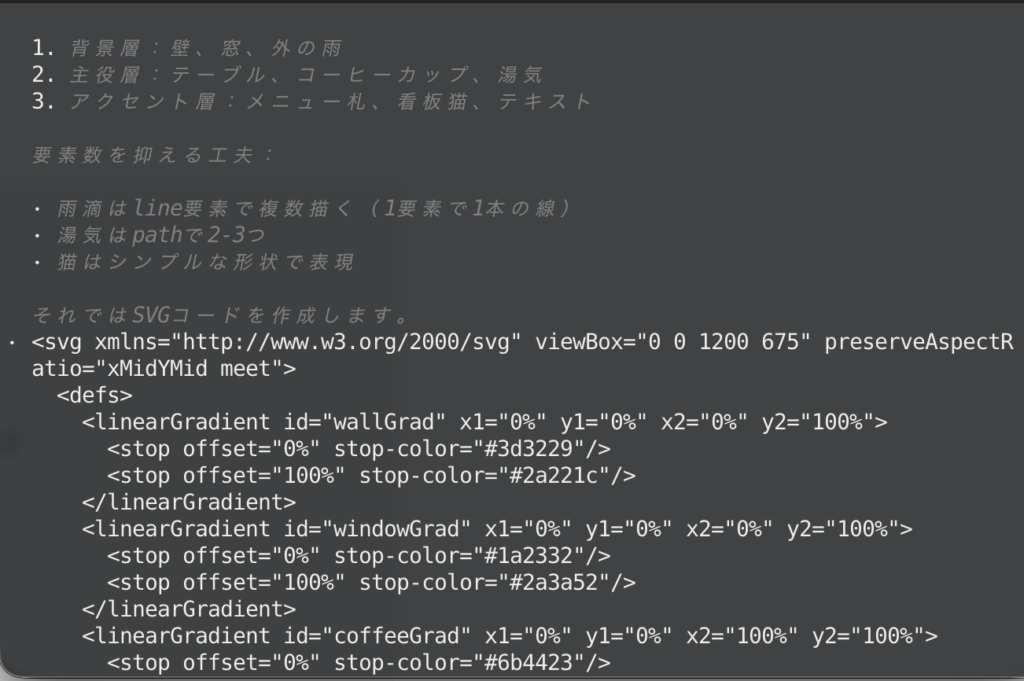

SVG生成

プロンプトはこちら

あなたはプロのSVGイラストレーターです。

「日本の喫茶店」をテーマに、1枚絵のSVGを生成してください。

【要件】

- 出力はSVGコード“のみ”(前後の説明文は不要)

- viewBoxは "0 0 1200 675"(16:9)

- 外部画像や外部フォントは使わない(<image>禁止、テキストはパス化するか最小限に)

- なるべく少ない要素で“情報量が多い”絵にする(目安:path/shape合計80個以内)

- グラデーションは使っても良いが、重くならないよう最小限

- 背景、主役、アクセントの3層構造で、見て楽しい構図にする

- 画面左下に小さく “Kimi K2.5 demo” の表記を入れる(視認性重視)

【描いてほしい要素】

- 木のテーブル、湯気の立つコーヒーカップ、レトロなメニュー札

- 窓の外に雨粒(雨の日の雰囲気)

- どこかに小さな看板猫(かわいすぎない、喫茶店らしく)

【品質チェック】

- ブラウザに貼るだけで表示できる完成品にする

- 余計なXML宣言やコメントは不要Kimi Chatでの出力結果はこちら

Kimi Code CLIでの出力結果はこちら

どちらも同じようなテイストで仕上げてくれていますが、Kimi Codeのほうが細部までこだわり抜いたデザイン性などで優位な気がしますね。

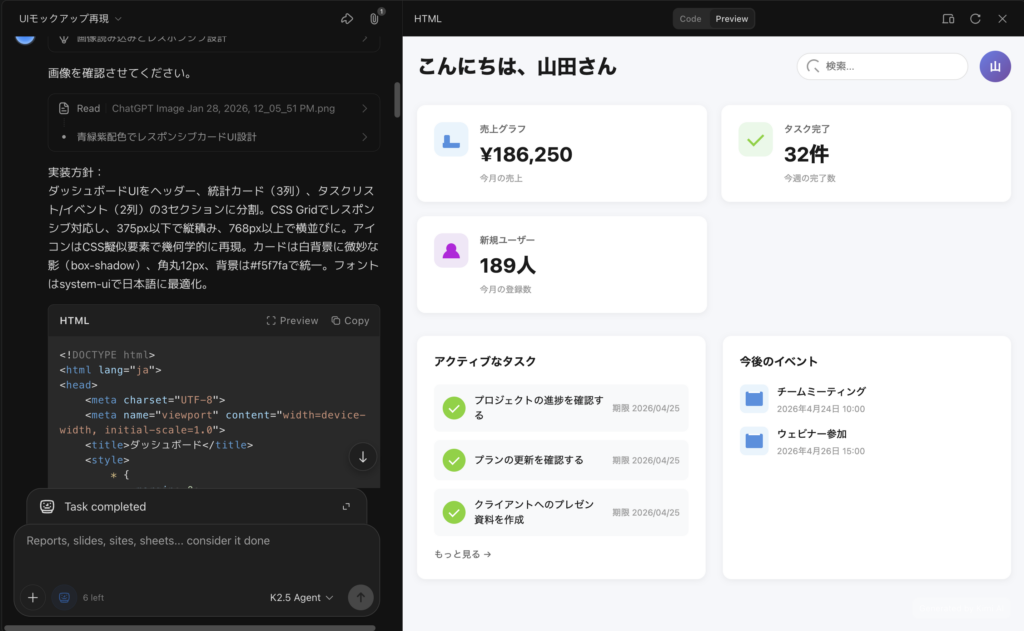

UIデザイン生成

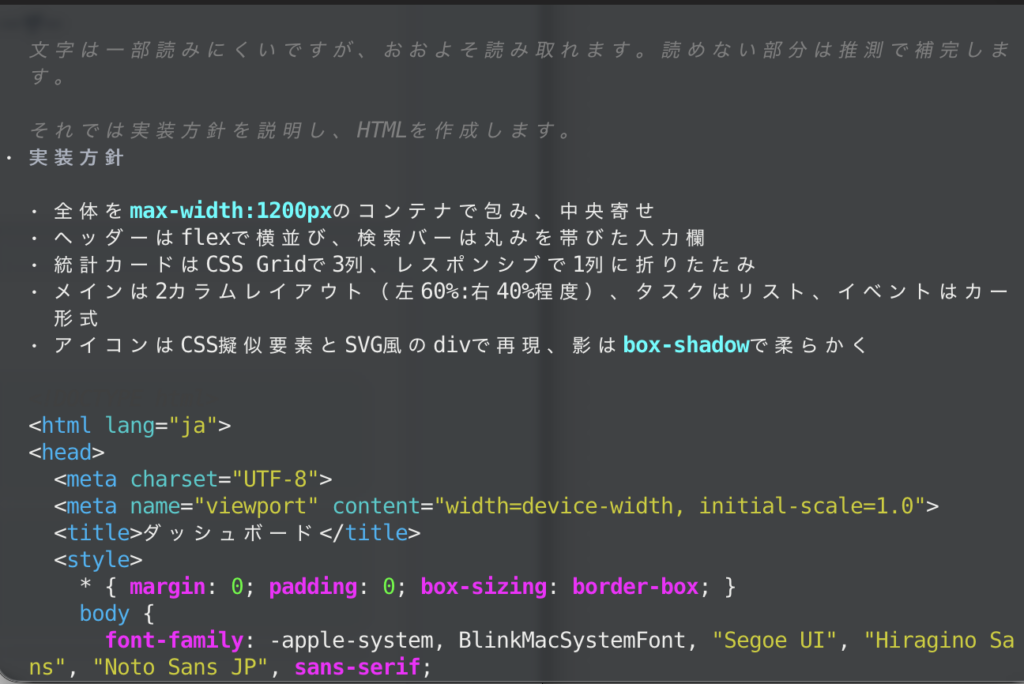

入力プロンプトと画像はこちら

これからUIモックアップ画像を添付します。

あなたはフロントエンドエンジニアとして、画像の見た目を可能な限り忠実に再現してください。

【出力形式】

- まず「実装方針」を短く説明(3〜6行)

- その後、1ファイル完結のHTML(CSSは<style>、JSは<script>に内包)を提示

- コード以外の文章は最小限に(コピペで動くことを優先)

【再現の要件】

- レイアウト:余白、行間、角丸、影、ボタンサイズ、カードの比率を意識して再現

- タイポ:見出し・本文・補足の階層が分かるようにサイズと太さを調整

- カラー:画像から近い色を推定(完璧一致でなくてよいが“違和感がない”こと)

- レスポンシブ:幅375px〜1200pxで破綻しないように(主にflex/gridで対応)

- 画像内にアイコンがある場合、外部ライブラリは使わずCSSで簡易的に再現してOK

【やってほしいこと】

1) 画像を見て、UIを構造化(セクションやコンポーネントの切り分け)してから実装

2) 画像内のテキストは、読み取れる範囲でそのまま。読めない部分は自然な日本語で補完

3) 最後に「差分が出やすいポイント(3つ)」だけ述べて、調整のコツも一言添える

Kimi Chatでの出力結果はこちら

Kimi Code CLIでの出力結果はこちら

元画像の文字が潰れている箇所がありましたが、いずれもテキスト補完をした上で、全体デザインを仕上げてくれました。

細かい部分のデザイン性や、再現性といった観点では、やはりKimi Code CLIのほうが品質は高い印象を受けました。

いずれにせよKimi K2.5の性能自体は高いと思います。用途によっても強みや弱みを確認できると思いますので、気になる方は試してみてください!

まとめ

Kimi K2.5は、ビジョンと言語を統合しつつ、セルフエージェント機能を備えた最先端のオープンソースLLMです。

従来の大型モデルに迫る高性能を維持しながらも低価格で提供されていて、商用利用も基本的にはOKとされています。

現在はMoonshot公式サイトやAPIで試用が可能で、今後も改良やKimi Codeなどの周辺ツールの発展が期待されています。

気になる方は、ぜひ試してみてください!

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。