LFM2-2.6B-Expとは?軽量モデルで命令追従と数学推論が強化されたLiquid AIの最新モデルを徹底解説

- Liquid AI発、Liquid Foundation Model 2 (LFM2)シリーズの最新実験モデル

- 26億パラメータのモデルをベースに、強化学習を用いた後処理により性能をさらに向上させた点が特徴

- 命令応答や知識・数学問題への対応力に優れている

2025年12月25日、Liquid AIがLiquid Foundation Model 2 (LFM2)シリーズの最新実験モデル「LFM2-2.6B-Exp」を公開しました!

LFM2-2.6B-Expは、26億のパラメータを持つモデルをベースに、強化学習を用いた後処理により性能をさらに向上させた点が特徴のモデルとなっています。

命令応答や知識・数学問題への対応力に優れ、同規模の他モデルを大きく上回る結果を出しているようです。そこで本記事では、LFM2-2.6B-Expの概要や性能、使い方まで徹底的に解説します。

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

LFM2-2.6B-Expの概要

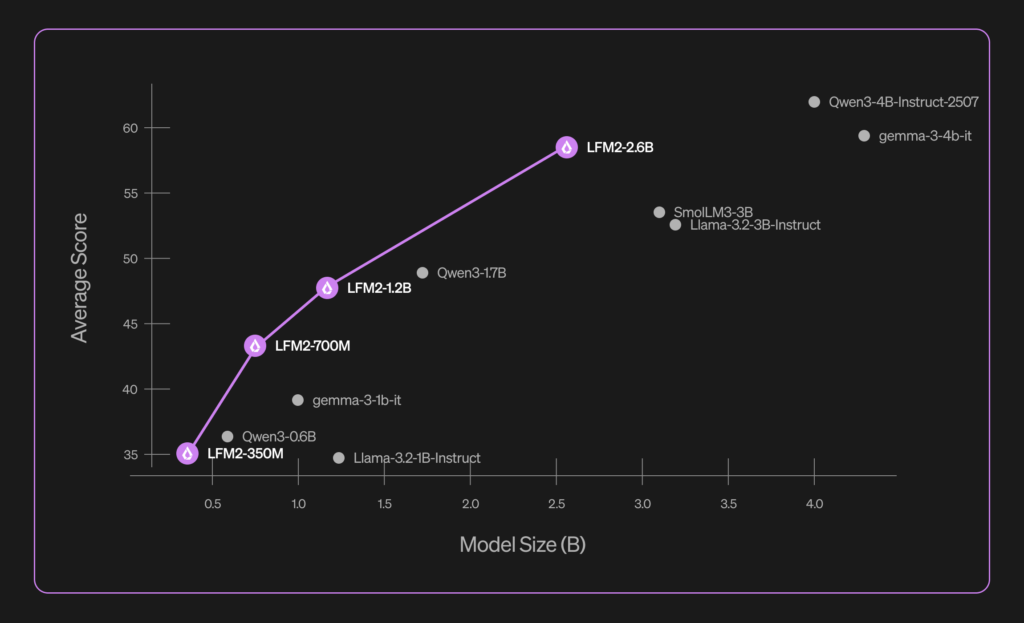

LFM2-2.6B-Expは、Liquid AIのLFM2ファミリーにおける現行最大規模のモデルで、シリーズの350M/700M/1.2Bモデルの延長線上に位置します。

わずか26億パラメータながら、大規模モデルに匹敵する性能を発揮するよう設計されています。

トレーニングには、約10兆トークンを使用し、多言語対応能力も高められました。

Liquidの公式発表によると、日本語と英語に特化チューニングされつつ、フランス語・スペイン語・中国語など多言語でも強力な性能を維持しているそうです。

モデルは、Liquid AI独自の「マルチゲート畳み込み」と、「Grouped Query Attention」を組み合わせたハイブリッド構造を採用していて、推論時の高速化とメモリ効率化を同時に実現しています。

このため、CPUやスマートフォン上でも高い応答速度を確保し、大規模な計算資源がなくとも高品質な生成が可能です。

LFM2-2.6B-Expの性能

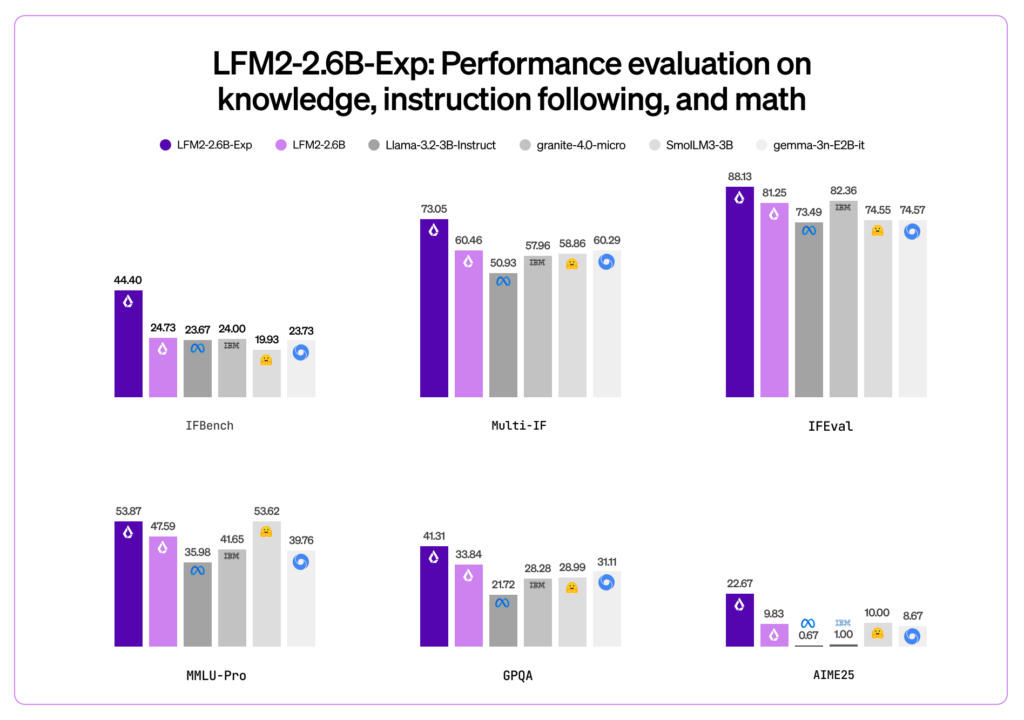

LFM2-2.6B-Expは、命令対応能力や知識応答、数学的推論で非常に優れた結果を出しています。

推論能力と知識応用力をより正確に評価するMMLU-Proでは53.87%、IFEval(命令応答タスク)では88.13%という高得点を達成していて、これらは同規模(3B前後)の既存モデルを上回っています。

特に、独自ベンチマークのIFBenchでは、液体AIが示すDeepSeek R1-0528(推定5500億パラメータ)を超えるスコアを記録するなど、263倍のパラメータ差を跳ね除ける優秀さを見せています。

また、ハイブリッド構造の採用により推論速度も大幅に向上していて、一般的なアテンションモデルと比べて推論時のレイテンシが短縮されています。

LFM2-2.6B-Expのライセンス

LFM2-2.6B-Expは、Liquid AIのLFMオープンライセンスv1.0で提供されています。

このライセンスは、Apache 2.0をベースにしていて、著作権・特許について広範な利用権が与えられています。

ただし、商用利用は、企業の年間売上が1,000万米ドル以下の場合に無償で許可されており、これを超える場合はLiquid AIとの商用契約が必要になります。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | 🔺 | 年商1,000万ドル以下までは無償利用可能 |

| 改変 | ⭕️ | |

| 配布 | ⭕️ | |

| 特許使用 | ⭕️ | |

| 私的使用 | ⭕️ |

LFM2-2.6B-Expの料金

Liquid AIは、LFM2モデル本体と開発プラットフォームを基本無償で提供しています。

モデルの重みはHugging Face上で公開されていて、LFMオープンライセンスの範囲内で無償で入手して利用できます。

また、開発用プラットフォームであるLEAPおよびモバイルアプリApolloも、コア機能は恒久的に無料で利用できます。

| 提供形態・プラン | 料金 | 備考 |

|---|---|---|

| Hugging Face配布モデル | 無料 | LFMオープンライセンスに基づき無償で利用可能 |

| LEAPプラットフォーム | 無料 | モデル検索・ファインチューニング等、全機能を永続提供 |

| Apolioモバイルアプリ | 無料 | iOS/Android向けアプリでいつでも利用可能 |

| 商用ライセンス(年商1,000万ドル超過時) | 要問い合わせ | 収益超過時は商用契約料が発生 |

LFM2-2.6B-Expの使い方

LFM2-2.6B-Expの使い方には、主に、①Webチャット、②ローカルダウンロードの2つの方法があります。

①Webチャット

1番お手軽に試すならLiquid Playgroundのチャットがおすすめです。

Liquid Playgroundのチャット画面でモデルを「LFM2-2.6B-Exp」に切り替え、プロンプトを送るだけで試すことができます。

②ローカルダウンロード

次に、ローカルPCで動かす最短ルートとして「Transformers」を使う方法があります。

流れはシンプルで、①Transformersを最新版(v4.55以上)に更新、②モデルとトークナイザーを読み込み、③apply_chat_template()でChatML風の入力形式に整える、④実行、という流れです。

LFM2は推奨の生成パラメータ(temperature=0.3 / min_p=0.15 / repetition_penalty=1.05)が公開されているので、最初はそれをそのまま使うのが良いかと思います。

pip install -U transformersfrom transformers import AutoModelForCausalLM, AutoTokenizer

model_id = "LiquidAI/LFM2-2.6B-Exp"

model = AutoModelForCausalLM.from_pretrained(

model_id,

device_map="auto",

torch_dtype="bfloat16",

)

tokenizer = AutoTokenizer.from_pretrained(model_id)

prompt = "日本語で、LFM2-2.6B-Expの強みを1文で教えてください。"

input_ids = tokenizer.apply_chat_template(

[{"role": "user", "content": prompt}],

add_generation_prompt=True,

return_tensors="pt",

tokenize=True,

).to(model.device)

output = model.generate(

input_ids,

do_sample=True,

temperature=0.3,

min_p=0.15,

repetition_penalty=1.05,

max_new_tokens=256,

)

print(tokenizer.decode(output[0], skip_special_tokens=False))慣れてきて、同じPCで大量実行したい・速く回したいとなったら、vLLM(v0.10.2以上)での推論が公式に案内されています。

さらに、ローカル実行の選択肢として、GGUFチェックポイントを使ってllama.cppで動かす方法も用意されているので、気になる方はこちらを参考にしてみてください。

LFM2-2.6B-Expを使ってみた

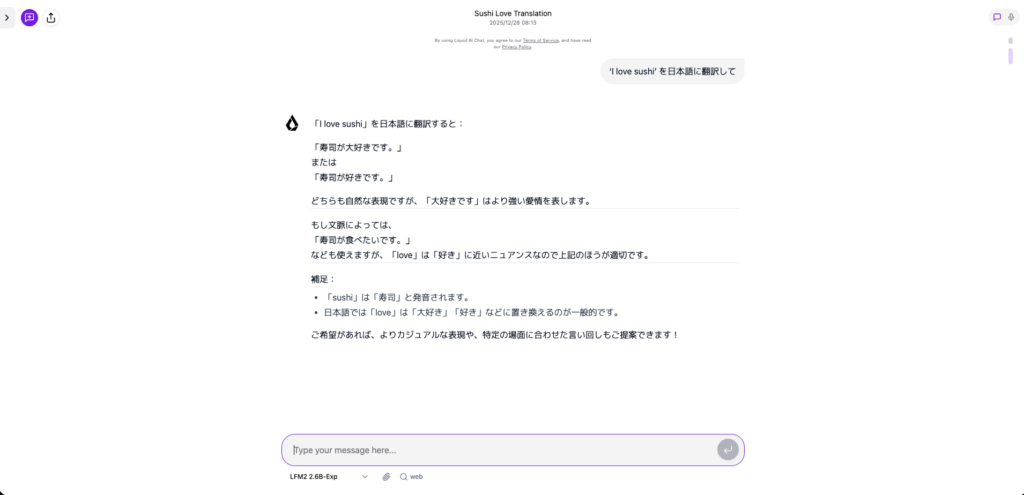

それでは実際に、LFM2-2.6B-ExpをLiquid Playgroundで試してみます。

基本的なQAタスク

プロンプトはこちら

‘I love sushi’ を日本語に翻訳して出力結果はこちら

プロンプトはこちら

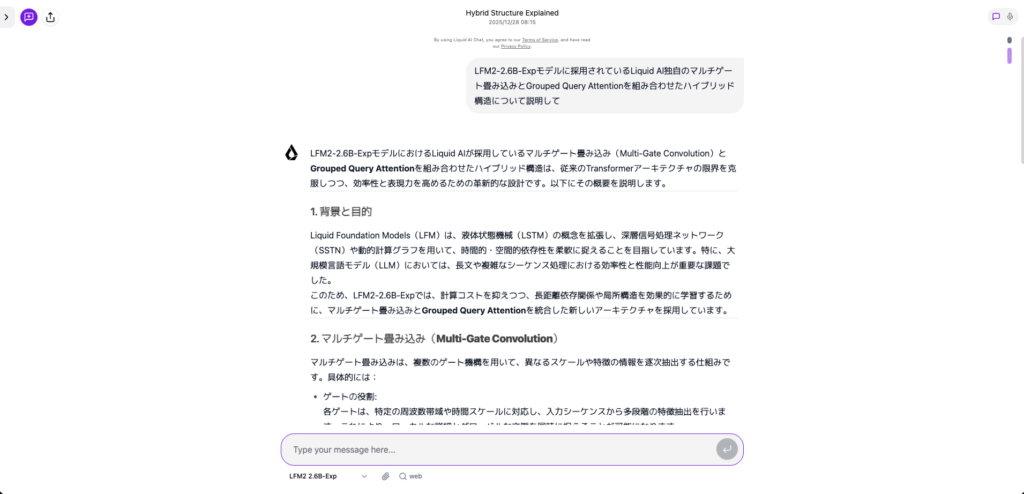

LFM2-2.6B-Expモデルに採用されているLiquid AI独自のマルチゲート畳み込みとGrouped Query Attentionを組み合わせたハイブリッド構造について説明して出力結果はこちら

LFM2-2.6B-ExpモデルにおけるLiquid AIが採用しているマルチゲート畳み込み(Multi-Gate Convolution)とGrouped Query Attentionを組み合わせたハイブリッド構造は、従来のTransformerアーキテクチャの限界を克服しつつ、効率性と表現力を高めるための革新的な設計です。以下にその概要を説明します。

1. 背景と目的

Liquid Foundation Models(LFM)は、液体状態機械(LSTM)の概念を拡張し、深層信号処理ネットワーク(SSTN)や動的計算グラフを用いて、時間的・空間的依存性を柔軟に捉えることを目指しています。特に、大規模言語モデル(LLM)においては、長文や複雑なシーケンス処理における効率性と性能向上が重要な課題でした。

このため、LFM2-2.6B-Expでは、計算コストを抑えつつ、長距離依存関係や局所構造を効果的に学習するために、マルチゲート畳み込みとGrouped Query Attentionを統合した新しいアーキテクチャを採用しています。

2. マルチゲート畳み込み(Multi-Gate Convolution)

マルチゲート畳み込みは、複数のゲート機構を用いて、異なるスケールや特徴の情報を逐次抽出する仕組みです。具体的には:

ゲートの役割:

各ゲートは、特定の周波数帯域や時間スケールに対応し、入力シーケンスから多段階の特徴抽出を行います。これにより、ローカルな詳細とグローバルな文脈を同時に捉えることが可能になります。

畳み込みの利点:

畳み込み演算は並列処理に適しており、計算効率が高く、長いシーケンスでも高速に処理できます。マルチゲート版では、各ゲートが独立して畳み込みを実行し、階層的な表現学習を実現します。

Liquidへの適応:

LFMでは、この畳み込み層が非線形活性化関数と組み合わさり、複雑なパターンを学習します。また、動的ゲート選択により、入力データに応じてどのゲートを強調するかを調整できます。

3. Grouped Query Attention

Grouped Query Attentionは、クエリとキーの結合方法を工夫したアテンション機構です。従来のアテンションとは異なり、以下のような特徴があります:

グループ化されたクエリ:

入力の類似した要素をグループ化し、1つのクエリで集約することで、計算量を削減します。これにより、全要素間のアテンションを避けつつ、関連性の高い部分に焦点を当てられます。

効率的な長距離依存:

グループ化により、遠く離れた要素間の関係も効果的に捉えられ、長文や複雑な依存構造を扱う際の性能が向上します。

Liquidとの統合:

Grouped Query Attentionは、マルチゲート畳み込みの出力と連携し、階層的な注意メカニズムを形成します。これにより、局所的な特徴抽出とグローバルな文脈理解をバランスよく実現します。

4. ハイブリッド構造の全体像

両者の組み合わせにより、以下のような利点が得られます:

計算効率:

マルチゲート畳み込みの並列性とGrouped Query Attentionのグループ化により、大規模データに対する高速処理が可能になります。

表現力の向上:

異なるスケールの特徴を抽出し、階層的なアテンションで文脈を統合することで、複雑な言語構造や時系列データの理解が深まります。

柔軟性:

ゲート機構とグループ化戦略により、タスクやデータに応じたアーキテクチャの調整が容易です。

5. LFM2-2.6B-Expへの応用

LFM2-2.6B-Expでは、このハイブリッド構造が**大規模なパラメータ数(2.6B)**と組み合わさることで、以下のような性能を発揮します:

長文処理:

マルチゲート畳み込みによる効率的なシーケンス圧縮と、Grouped Query Attentionによる長距離依存の捉え方で、数万トークンの文脈を保持可能です。

低遅延推論:

並列化可能な畳み込みとグループ化アテンションにより、リアルタイムアプリケーションにも対応します。

汎用性:

自然言語処理だけでなく、音声、画像、時系列データなど、多様なモダリティへの拡張性があります。

まとめ

LFM2-2.6B-Expにおけるマルチゲート畳み込みとGrouped Query Attentionのハイブリッド構造は、計算効率と表現力の両立を目指した革新的な設計です。この組み合わせにより、Liquid AIは、大規模言語モデルとしての性能を最大限に引き出しつつ、実用的な推論速度を実現しています。基本的なQAは問題なさそうですね。想像以上に出力生成スピードも速い印象です。

数学タスク

プロンプトはこちら

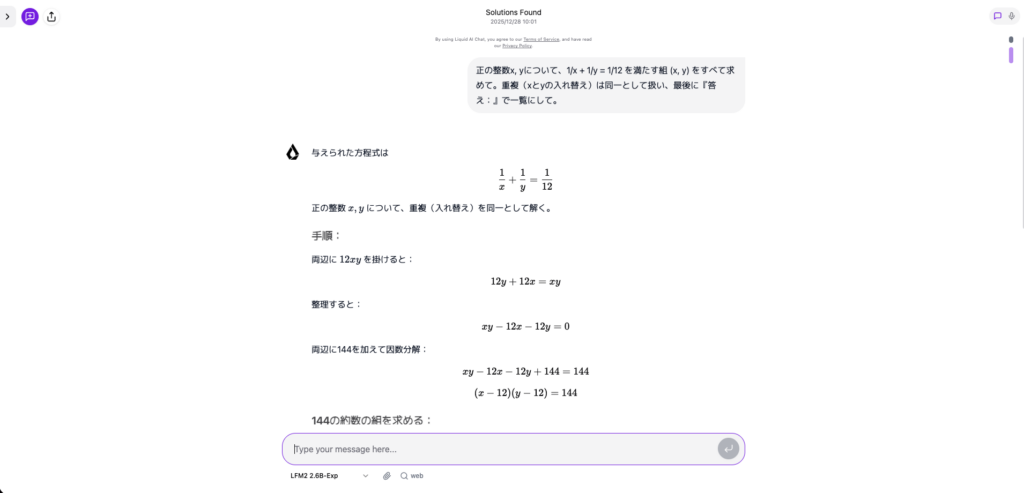

正の整数x, yについて、1/x + 1/y = 1/12 を満たす組 (x, y) をすべて求めて。重複(xとyの入れ替え)は同一として扱い、最後に『答え:』で一覧にして。出力結果はこちら

えられた方程式は

1

x

+

1

y

=

1

12

x

1

+

y

1

=

12

1

正の整数

x

,

y

x,y について、重複(入れ替え)を同一として解く。

手順:

両辺に

12

x

y

12xy を掛けると:

12

y

+

12

x

=

x

y

12y+12x=xy

整理すると:

x

y

−

12

x

−

12

y

=

0

xy−12x−12y=0

両辺に144を加えて因数分解:

x

y

−

12

x

−

12

y

+

144

=

144

xy−12x−12y+144=144

(

x

−

12

)

(

y

−

12

)

=

144

(x−12)(y−12)=144

144の約数の組を求める:

144の正の約数の組

(

a

,

b

)

(a,b) で

a

=

x

−

12

a=x−12,

b

=

y

−

12

b=y−12 とおくと、

(

x

,

y

)

=

(

a

+

12

,

b

+

12

)

(x,y)=(a+12,b+12)

144の約数の組は以下(順序を考慮せず、重複なし):

(1,144), (2,72), (3,48), (4,36), (6,24), (8,18), (9,16), (12,12),

およびそれらの逆も含むが、重複は同一とする。

各組から

(

x

,

y

)

(x,y) を列挙:

(13, 156)

(14, 84)

(15, 60)

(16, 48)

(18, 36)

(20, 30)

(21, 28)

(24, 24)

これらはすべて異なる組(入れ替えは同一とみなす)。

答え:

答え:(13, 156), (14, 84), (15, 60), (16, 48), (18, 36), (20, 30), (21, 28), (24, 24)

答え:

(13, 156), (14, 84), (15, 60), (16, 48), (18, 36), (20, 30), (21, 28), (24, 24)プロンプトはこちら

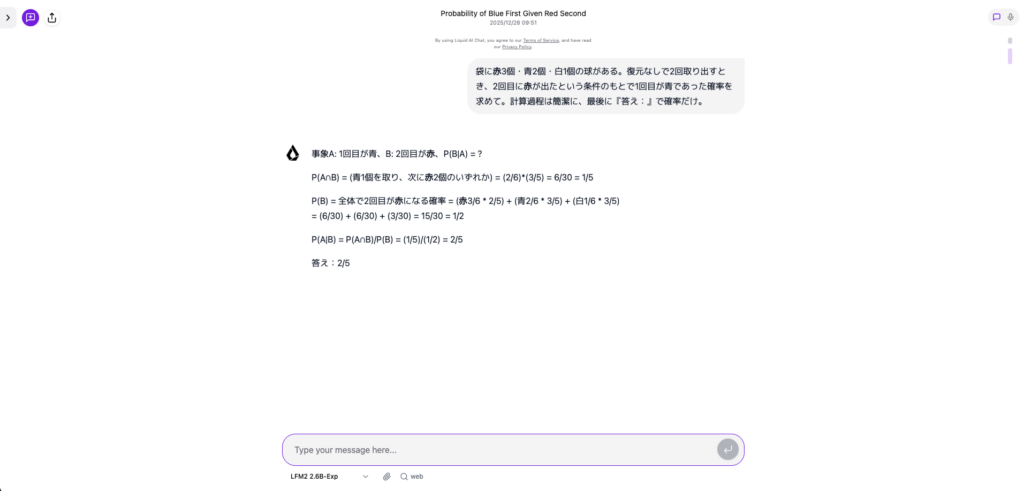

袋に赤3個・青2個・白1個の球がある。復元なしで2回取り出すとき、2回目に赤が出たという条件のもとで1回目が青であった確率を求めて。計算過程は簡潔に、最後に『答え:』で確率だけ。出力結果はこちら

数学タスクも問題なく正解を出してくれました。こちらも思考時間が短く、出力まで数秒で完了したので、生成スピードに強みがありそうだと感じました。

また、SNS上でも、LFM2-2.6B-Expの高性能ぶりに注目が集まっています。

開発者やインフルエンサーの中には、スマートフォン上で軽快に動作する点や、従来の大規模モデルに迫る応答精度を評価する声が上がっています。

このように、多様なタスクで実際に試してみると、LFM2-2.6B-Expが効率的かつ強力なアシスタントツールであることを実感できると思いますので、ぜひ一度試してみてください。

まとめ

LFM2-2.6B-Expは、小さいけれど実用的といったLiquid AIの理念を具現化したモデルです。

強化学習でさらに性能がアップした2.6Bパラメータモデルは、数値的な性能指標やベンチマークで他社の大規模モデルを圧倒しつつ、オンデバイスでの実用性も兼ね備えています。

今後もこのシリーズは進化を続け、小規模モデルでもエンタープライズ級の性能を発揮する方向で進むと期待されています。

気になる方は、ぜひ一度試してみてください!

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。