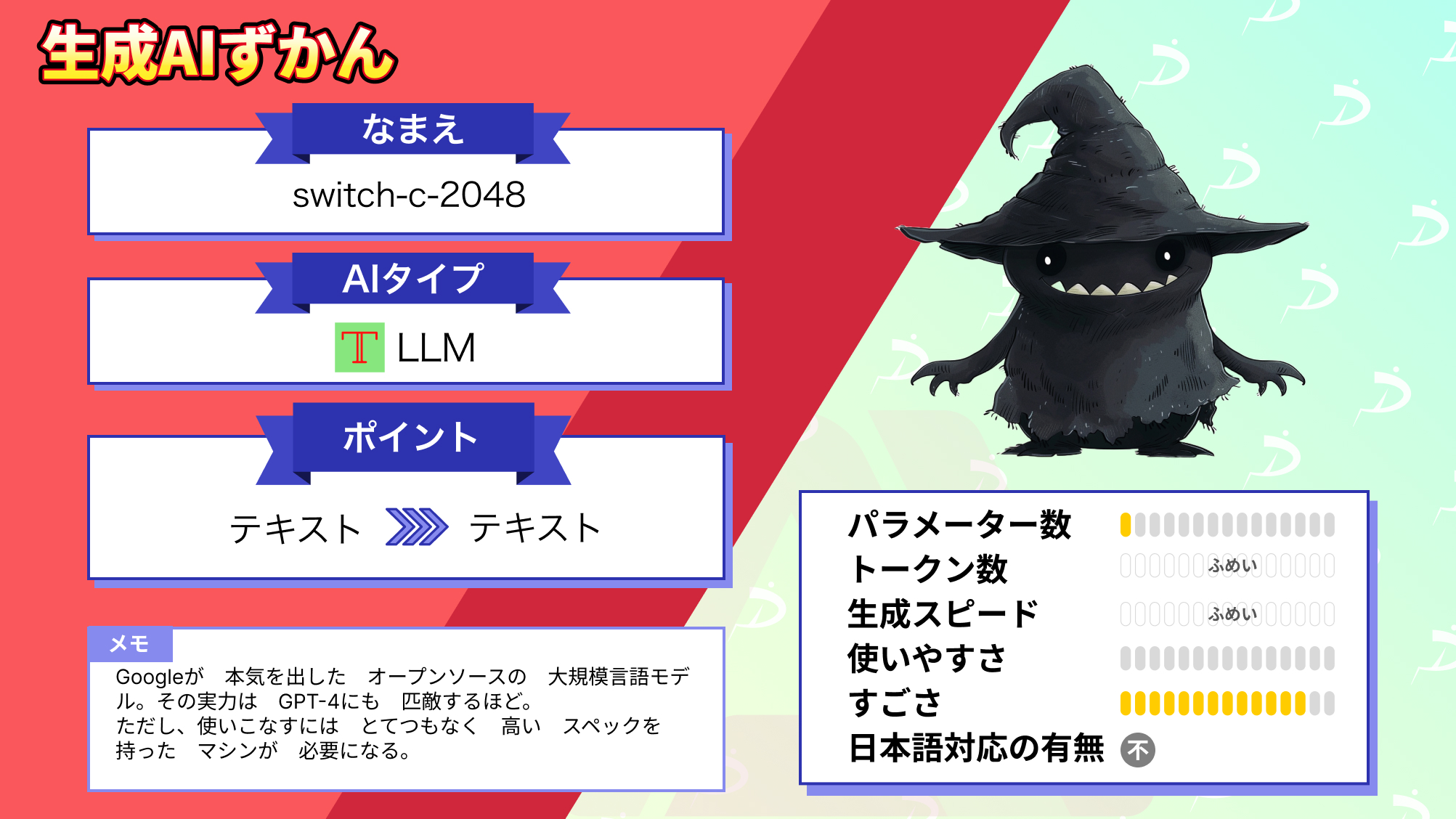

【switch-c-2048】GoogleがついにGPT-4レベルのLLMをオープンソースで公開!概要〜使い方まで

メディア事業部リサーチャーのいつきとメディア事業部LLMリサーチャーの藤崎です。この記事は専門的な内容を含むため、AIスペシャリストとの共同執筆となっています。

今回ご紹介するのは、Googleがオープンソース化したMOEモデルの「switch-c-2048」について。

なんと、こちらのMOEモデルは、1.6兆個のパラメーターと3.1TBサイズのデータでトレーニングされた大規模言語モデルで、あの「GPT 4」と同等のサイズだと話題になっています!

switch-c-2048を使用すれば、より高速な学習が可能になるとのことですが、新しく公開されたモデルなので使い方がわからないという方も多いでしょう。

そこで今回の記事では、switch-c-2048の概要や使い方について、筆者本人が使用した上で徹底的に解説します。

最後まで目を通していただくと、switch-c-2048の使い方はもちろん、GPT 4との違いを理解していただけます!

ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

switch-c-2048の概要

switch-c-2048は、Googleがオープンソース化したMOEモデルです。なんと、1.6兆個のパラメーターと3.1TBサイズのデータでトレーニングされており、言語モデルとしての規模はChatGPTで有名な「GPT 4」と同等と言われています。

switch-c-2048について記載した論文によると、switch-c-2048は今までよりも高速なトレーニング (スケーリング特性) を可能にするほか、同時に微調整されたタスクではT5の速度を上回るとのことです。

参考記事:Model Card for Switch Transformers C – 2048 experts (1.6T parameters for 3.1 TB)

switch-c-2048の料金体系

switch-c-2048はOSS(Apache 2.0)であるため無料で使用できます。

なお、BLOOMというパラメーター数1760億のLLMについて知りたい方はこちらをご覧ください。

→【BLOOM】大規模言語モデルの原点!?世界60カ国、1,000人以上の研究者による珠玉のLLMを使ってみた

switch-c-2048の使い方

switch-c-2048は大規模な言語モデルのため非常に高スペックのマシンが必要になります。

試しにGoogleColabでモデルをロードしてみたのですが1時間以上経っても終わりませんでした。。。(そもそもColabだと容量が足りない)

ここでは公式に記載されているコードをもとに、switch-c-2048の使い方をご説明します。

まず、下記コードを実行して必要なライブラリをイントールします。

pip install transformers次にtransformersライブラリを使用してswitch-c-2048モデルをロードします。

かなり大きなモデルなのでロードに時間がかかりますのでご注意ください。

from transformers import AutoTokenizer, AutoModelForCausalLM

# トークナイザとモデルのロード

tokenizer = AutoTokenizer.from_pretrained("google/switch-c-2048")

model = AutoModelForCausalLM.from_pretrained("google/switch-c-2048")以上で準備は完了です。

簡単なテキスト生成を行ってみましょう。

# 入力テキストのエンコード

input_text = "ここに入力テキストを置きます。"

input_ids = tokenizer.encode(input_text, return_tensors='pt')

# 予測の生成

output = model.generate(input_ids, max_length=50)

# 生成されたテキストのデコード

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)switch-c-2048を利用すれば簡単なテキストを作るだけでなく、その膨大なパラメータ数によって他のLLMでもできることを、より高精度なレベルで生成することが可能です。

- テキスト生成

詩、コード、スクリプト、音楽作品、電子メール、手紙など、創造的なテキストを生成することができます。 - 翻訳

英語から日本語への翻訳、日本語から英語への翻訳など、異なる言語間の翻訳が可能です。 - 要約

ニュース記事、論文、ウェブサイトなど、長いテキストを短く要約することができます。 - 質問応答

事実に関する質問、推論に関する質問など、さまざまな質問に答えることができます。

switch-c-2048とGPTの比較

| switch-c-2048 | GPT 3.5 | GPT 4 | |

|---|---|---|---|

| パラメーター数 | 1.6T | 175B | 1.5T(推定) |

| トークン数 | 不明 | 2,048(5,000文字) | 32,768(25,000文字) |

| 開発会社 | OpenAI | OpenAI | |

| 商用利用 | 可 | 可 | 可 |

| ライセンス | Apache 2.0 | プロプライエタリソフトウェア | プロプライエタリソフトウェア |

| 日本語対応 | 不明 | 可 | 可 |

パラメータ数だけで比較すればGPT 4よりもswitch-c-2048が上回っていますが、互いに日々進化しているので単純に数値だだけで優劣をつけるのは難しいですね。

ただ、使いやすさとしてはやはりGPT 4に軍配があがります。

いくらswitch-c-2048がオープンソースでGPT 4に匹敵する能力を持っているとしても、動作するスペックのマシンを用意するのが大変ですからね・・・

switch-c-2048はかなり利用シーンが限られるLLMと言えるでしょう。

なお、Googleの数学特化型AIについて知りたい方はこちらの記事をご覧ください。

→【AlphaGeometry】Googleが数学オリンピック優勝レベルの難問を解く生成AIを公開!実際に使ってみた

まとめ

switch-c-2048は、1.6兆個のパラメーターと3.1TBサイズのデータでトレーニングされた大規模なMOEモデルです。T5の速度を上回るほどに高速なトレーニングが可能になるので、必要なマシンを用意することができれば、これまでよりもAI開発を効率よく行えることが期待できます。

今後もswitch-c-2048のように、さまざまなトレーニングを詰んだMOEモデルがリリースされていくと思うので、AI開発にかかる時間はさらに短くなっていきそうですね!

本記事で紹介したswitch-c-2048の使い方を参考にしながら、ぜひAI開発を行なってみてください。

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。