【SAM2】生成AIを使ってミーム無限生成!Metaの最強AIの性能を徹底解説

SAM 2(Segment Anything Model 2)は、Meta社が2024年7月29日に公開した画像・動画セグメンテーションモデルです。

このモデルは、前モデルのMeta Segment Anything Model(SAM)の次世代版であり、動画に対してもセグメンテーションできるようになっています。

また、任意のフレームでのプロンプト(クリック、ボックス、マスク)を使用して、対象のオブジェクトを簡単に選択でき、学習していない画像や動画もセグメンテーションできます。

今回は、SAM 2の概要や使ってみた感想をお伝えします。

是非最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

SAM 2の概要

SAM 2は、Meta社が2024年7月29日に公開した画像および動画のオブジェクトを一貫してセグメント化する「画像・動画セグメンテーションモデル」です。

このモデルは、任意のフレームでのプロンプト(クリック、ボックス、マスク)を使用して対象のオブジェクトを簡単に選択でき、このように非常に高い精度で選択したオブジェクトを追跡できます。

SAM 2の特徴を以下にまとめます。

- 大規模データセット: SAM 2は、50,000本以上の動画と3,550万のセグメントマスクを含むSA-Vデータセットを使用してトレーニングされています。

- リアルタイム処理: シンプルなトランスフォーマーアーキテクチャを使用し、リアルタイムで動画フレームを処理するストリーミングメモリを備えています。

- メモリエンコーダー:過去のフレームの特徴と現在のフレームの情報を組み合わせてメモリ特徴量を生成します。

- メモリバンク:生成したメモリ特徴量を保持し、一貫したリアルタイムセグメンテーションに活用します。

- インタラクティブな修正: SAM 2は、追加のフレームでプロンプトを提供することで、セグメントの修正をインタラクティブに行うことができ、ユーザーがモデルの誤りを簡単に修正できます。

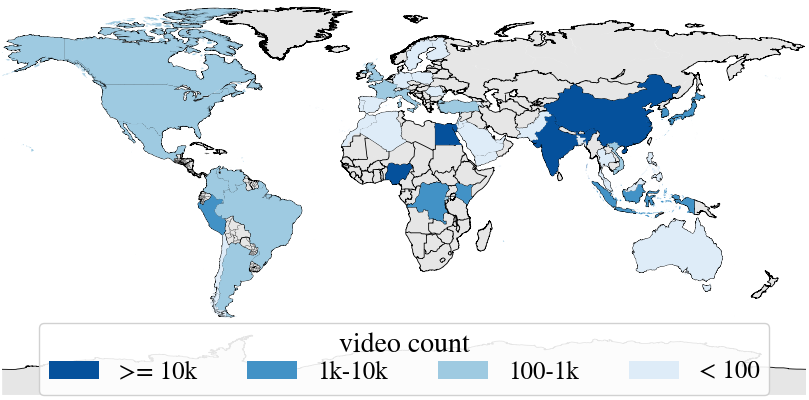

SAM 2の学習に使用されたSA-Vデータセットは、CC BY 4.0ライセンスの下で公開されており、既存の最大のビデオ セグメンテーションデータセットよりも4.5倍多くのビデオを含んでおり、53倍多くアノテーションされています。

実際の動画データの内容は、54%が屋内、46%が屋外シーンで、多様な日常のシナリオをカバーしておりモデルがさまざまな状況に対応できるように設計されています 。

SA-Vデータセットに含まれる動画は、世界47カ国で収集された動画であり、契約したサードパーティ企業を通じて収集されたそうです。

SAM 2は、学習していない新しい画像や動画に対してもセグメンテーションが可能です。

これは、SAM 2がモデルが事前に学習していない新しいデータ(画像や動画)に対しても高精度で適応できる「ゼロショット能力」を有していることが一番の理由です。

これ以外にも、前述したSA-Vデータセットでの大規模なトレーニングによる、幅広い状況に対応できる汎用性を備えていることや、メモリ機能を用いて、過去のフレーム情報を新しい動画のセグメンテーションに活用していることも挙げられます。

ここからは、SAM 2の使い方を解説します。

なお、Metaが開発した最新のLLMであるLlama 3.1について詳しく知りたい方はこちらの記事をご覧ください。

SAM 2のライセンス

SAM 2は、Apache-2.0 licenseのもとで提供されているため、商用利用や再配布等が可能になっています。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | ⭕️ |

| 私的使用 | ⭕️ |

SAM 2の使い方

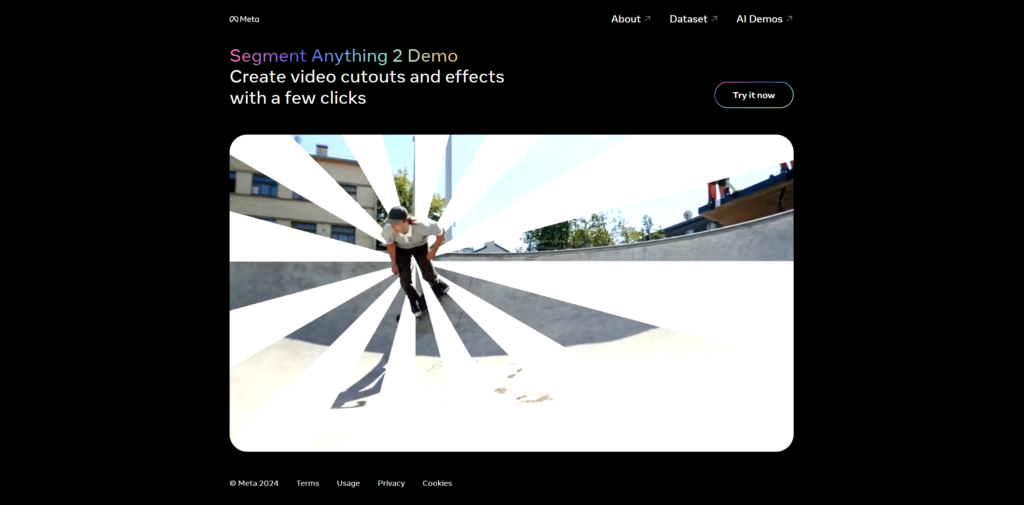

SAM 2は、以下のリンク先からデモを試すことができます。

アクセスするとこのような画面になるので、「Try it now」をクリックします。

利用規約への同意が求められるので同意してください。

なお、このデモで出力された結果を商用利用することはできない点や、デモの利用データはMetaに収集される点に注意が必要です。

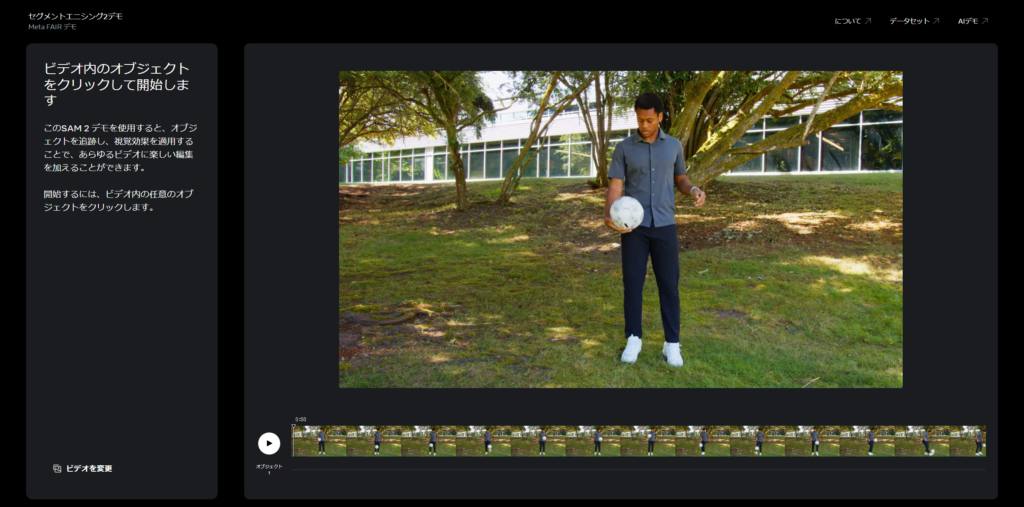

同意が完了すると以下のような画面になります。

これで、任意のビデオを入力して追跡したいオブジェクトを選択すると、セグメンテーションが開始されます。

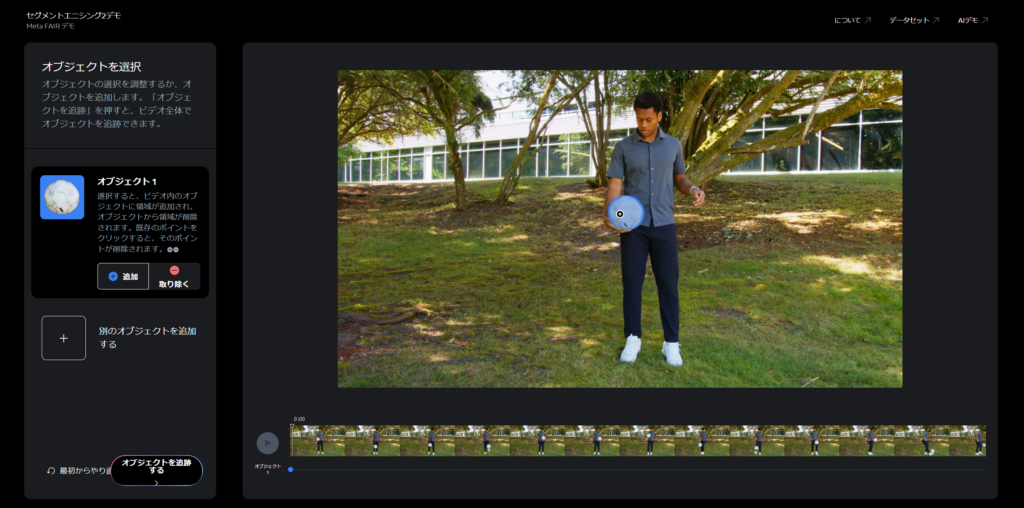

今回はあらかじめ入力されていた動画を利用して試しにサッカーボールをセグメンテーションしてみたいと思います。

SAM 2を実際に使ってみた

サッカーボールをクリックすると、このように高い精度でサッカーボールを識別してくれます。

これでオブジェクトの追跡を開始してみましょう。

すると、1秒ほどでセグメンテーションが完了し、このようになりました。

非常に高精度にオブジェクトの追跡ができていますよね!

ここからは、もっと多様な動画に対してセグメンテーションを行っていきます。

SAM 2のセグメンテーション能力をさらに深堀してみた!

ここからは、SAM 2のセグメンテーション能力をさらに検証するために、いくつかの異なる場面の動画を入力して、セグメンテーションをさせてみます。

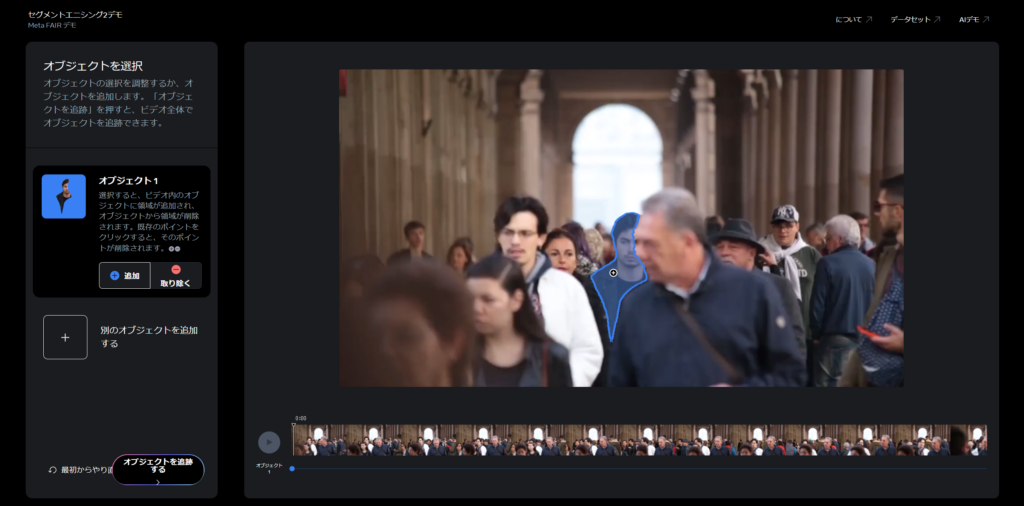

人混みの中

まずは以下の動画を入力として、特定の人物を追跡させます。

このように、動画の開始時点で全体が映っておらず、動画後半に完全に姿が映らなくなる男性を選択して追跡させてみます。

結果はこのようになりました。

最初は非常に高い精度で追跡できていましたが、前の人と被って完全に隠れてしまった後、再度映った際の追跡ができていません。

このようにモデルが正しくオブジェクトを追跡できていない場合は、そのシーンで再度ユーザー側でオブジェクトを指定することで修正できます。

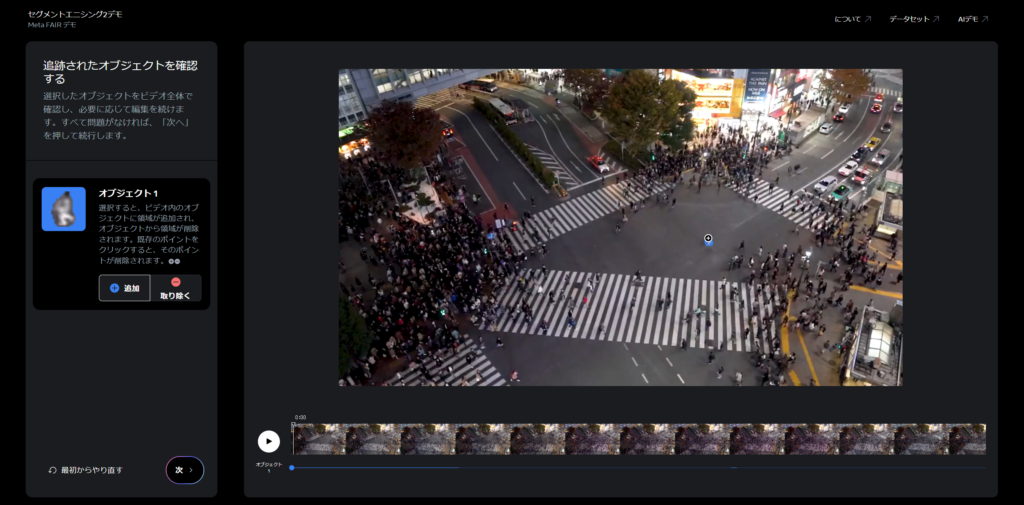

スクランブル交差点

次に、さらに多くの人が歩いている夜のスクランブル交差点の動画から特定の人物が追跡できるかやってみましょう。

こちらは対象がかなり小さく、解像度も高くないので、正しく追跡できるでしょうか。

オブジェクトをこのように指定して実行します。

結果はこのようになりました。

最初は正しく追跡できていましたが、反対側の人混みとぶつかったタイミングで見失ってしまいました。

さすがにここまで小さな対象かつ大勢の人がすれ違う複雑な動画だとまだまだ厳しいのかもしれません。

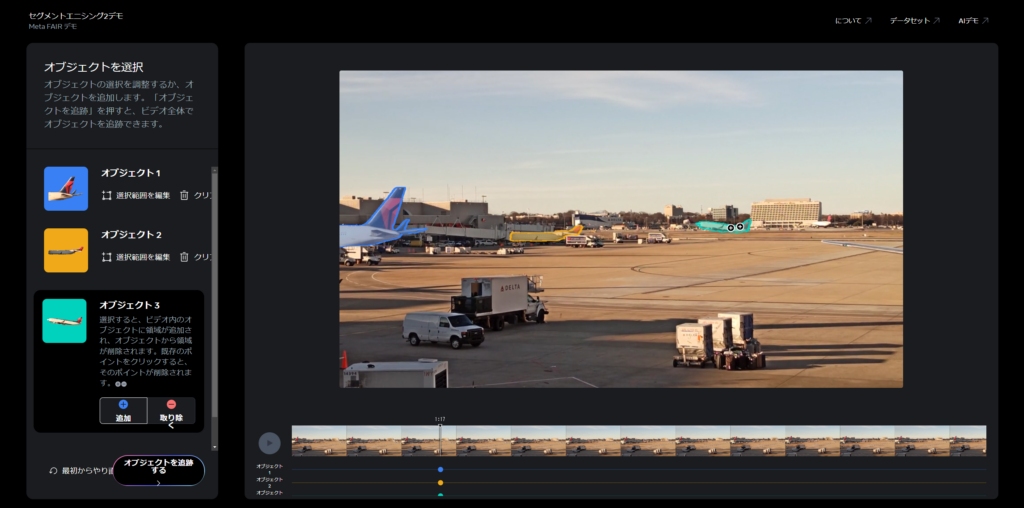

空港の飛行機

最後に、空港に駐機されている飛行機や、離陸する飛行機を追跡させてみます。

ここでは、複数のオブジェクトを指定します。

結果はこのようになりました。

駐機している飛行機と離陸している飛行機を高い精度で追跡しています。

離陸する飛行機は、建物の陰に隠れてしまった後は追跡されなくなってしまっていますが、こちらは先ほどと同じように手動での修正で対応できます。

将来的にSAM 2を空港の運用・管制業務に活用すれば、業務がさらに効率化するだけでなく、2024年の初めに羽田空港で起きたような事故を未然に防ぐことができる可能性を秘めています。

SAM 2の検証結果

今回の検証の結果、SAM 2は非常に高い精度で指定したオブジェクトを追跡してくれることが確認できました。

しかし、対象が一度隠れてしまったり、小さくなったりすると追跡が外れてしまうことがあり、手動で簡単に修正できるとはいえ、さらに改善の余地はあると感じました。

将来的には、今回紹介したような空港運用業務での活用のほかに、自動運転技術や環境モニタリング、もっと身近なところだと動画編集作業の効率化等に活用できると考えらえれます。

実際に、このポストで紹介されているように、アニメの特定のキャラを切り抜いて、背景をグリーンバックにすることもできるようです。

今後様々な活用方法が考案されることが考えられ、その動向に目が離せません!

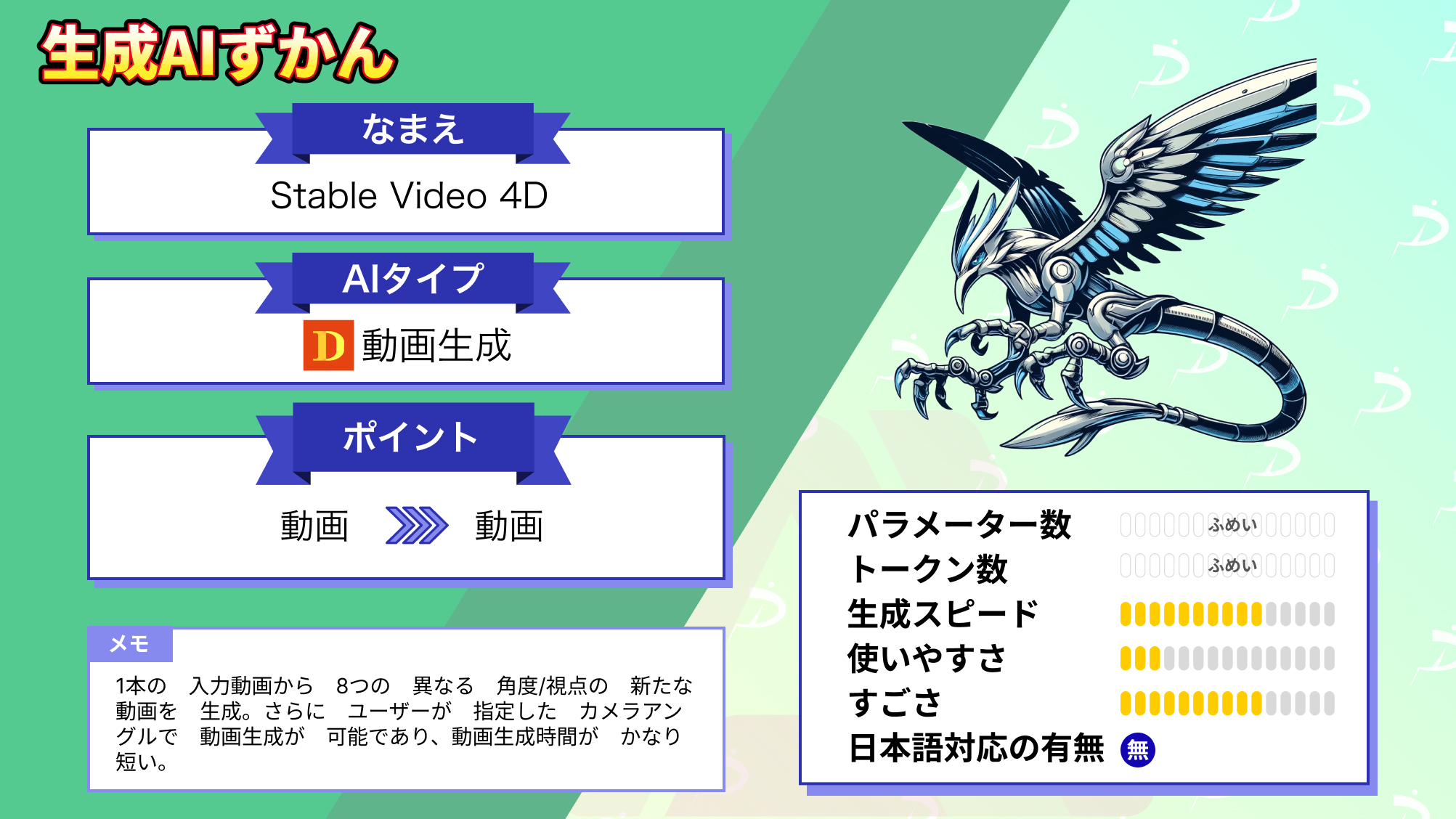

なお、Stability AIが開発した1つの動画からマルチアングルやビューを生成するモデルについて詳しく知りたい方はこちらの記事をご覧ください。

SAM 2は唯一無二の画像・動画セグメンテーションモデル

SAM 2は、Meta社が2024年7月29日に公開した画像および動画のオブジェクトを一貫してセグメント化する「画像・動画セグメンテーションモデル」です。

このモデルは、任意のフレームでのプロンプト(クリック、ボックス、マスク)を使用して対象のオブジェクトを簡単に選択でき、非常に高い精度で選択したオブジェクトを追跡できます。

SAM 2は、「SA-Vデータセット」という既存の最大のビデオ セグメンテーションデータセットよりも4.5倍多くのビデオを含み、53倍多くアノテーションされてるデータセットで学習されています。

また、ゼロショット能力や過去のフレームデータを保持するメモリ機能を備えており、学習していない画像や動画に対しても高精度なオブジェクト追跡が可能になっています。

実際に使用したところ、確かに指定したオブジェクトを高い精度で追跡してくれますが、対象が一度隠れてしまったり、小さくなったりすると追跡が外れてしまうことがありました。

外れてしまった追跡をユーザーが簡単に修正できる機能があるとはいえ、この点は改善の余地があると感じます。

SAM 2は、画像および動画のセグメンテーションモデルの限界を超え、様々な分野で応用できる可能性を広げる強力なモデルです。

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。