【Chat with RTX】NVIDIA版ChatGPTが無料公開!高速出力かつオフラインで使えるAIチャットボット

WEELメディア事業部LLMライターのゆうやです。

2023年2月13日、NVIDIAがGeForce RTX GPUで動作する「Chat With RTX」というチャットボットをリリースしました!

Chat With RTXを使うことで、MistralやLlama2といった大規模言語モデルが高速かつ簡単に使用できるほか、ローカルにあるファイルや、YouTube上の動画などをデータセットとして、要約や検索したい事項を抽出できます。(日本語未対応)

以下の動画はChat with RTXの紹介動画です。

Chat With RTXは、VRAMが8GB以上のRTX 30シリーズ以降のGPUと16GB以上のRAMに加えて、Windows11とバージョン535.11以上のドライバーが必要です。

今回は、Chat With RTXの概要や使ってみた感想をお伝えします。

是非最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

Chat with RTXの概要

Chat with RTXは、2023年2月13日にNVIDIAが公開した、GeForce RTX GPUを用いてローカル環境で動作するAIチャットボットアプリです。

このアプリでは、MistralとLlama2の2種類のオープンソース大規模言語モデル(LLM)を迅速かつ簡単に使用でき、ローカルにあるファイルや、YouTube上の動画などをデータセットとして、その知識をクエリに統合できます。

対応ファイル形式は、.txt、.pdf、.doc/.docx、.xml などのさまざまな形式を対応しており、Chat with RTXではそれらを数秒でロードしてライブラリに追加してくれます。

ただ、現時点では日本語に対応していないので、その点は注意が必要です。

次に、Chat with RTXのローカル環境における高速かつ簡単なLLMの使用を可能にしている技術を紹介します。

- Retrieval-Augmented Generation (RAG):情報検索(Retrieval)と生成(Generation)を組み合わせた自然言語処理(NLP)技術で、データベースから情報を検索し、その情報を基にテキストを生成します。

- TensorRT-LLM:NVIDIAが開発した大規模言語モデル(LLM)を高速化するためのライブラリで、これを使用することでLLMの応答時間を短縮し、リソースの消費を抑えることができます。

- RTXアクセラレーション:NVIDIAのRTXテクノロジーに基づく、グラフィックスおよび計算処理の加速技術で、リアルタイムレイトレーシングや深層学習におけるテンソル演算の高速化など、高度なグラフィックス処理とAI演算に特化しています。

Chat with RTXは、これらの技術を組み合わせることで高速かつ精度の高いレスポンスを提供することを可能にしています。

ここからは、Chat with RTXを実際に使用してその機能や性能を確かめていこうと思います。

なお、NVIDIAが開発したStable-Diffusion-WebUIを高速化するツールについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【TensorRT】Stable Diffusion Web UIを倍速にできるNVIDIA製の神AIツール!使い方〜実践まで

Chat with RTXの使い方

Chat with RTXは、先ほど紹介した技術を使用していることもあり、かなりハイスペックPCが必要です。

その必要要件から説明します。

必要スペック

Chat with RTXを動作させるには、以下の要件を満たす必要があります。

- OS:Windows11

- GPU:RTX 30以上 or NVIDIA RTX™ Ampere or Ada Generation GPU

- VRAM:8GB

- RAM:16GB以上

- Driver:535.11以上

RTX20シリーズについては、公式から特に言及されていないので、使用できないと思われます。

次に、実装方法を紹介します。

実装方法

まずは、以下のリンクにアクセスし、NVIDIA_ChatWithRTX_Demo.zipをダウンロードします。

このファイルは35GBほどあるので、環境によってはダウンロードに時間がかかることがあります。

ダウンロードが完了したら、解凍し、setup.exeを実行します。

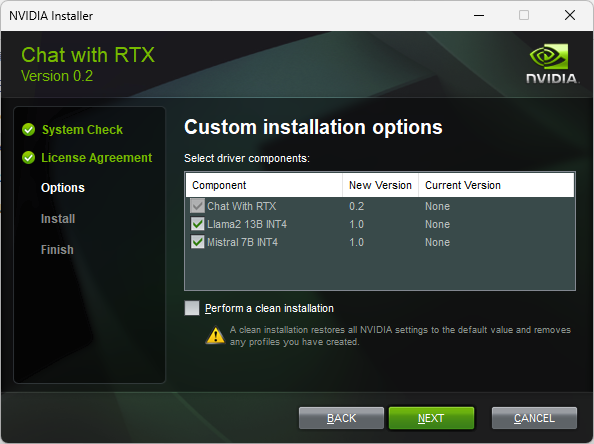

すると、このような画面になるので、画面に従って順に設定、インストールしていってください。

Optionsで、インストールするコンポーネントを選択できますが、基本的にはすべてインストールしてしまって大丈夫です。

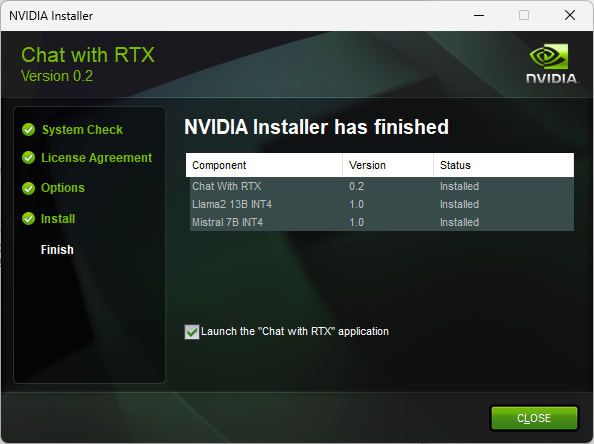

インストールを開始して、すべてInstalledになったら完了です。

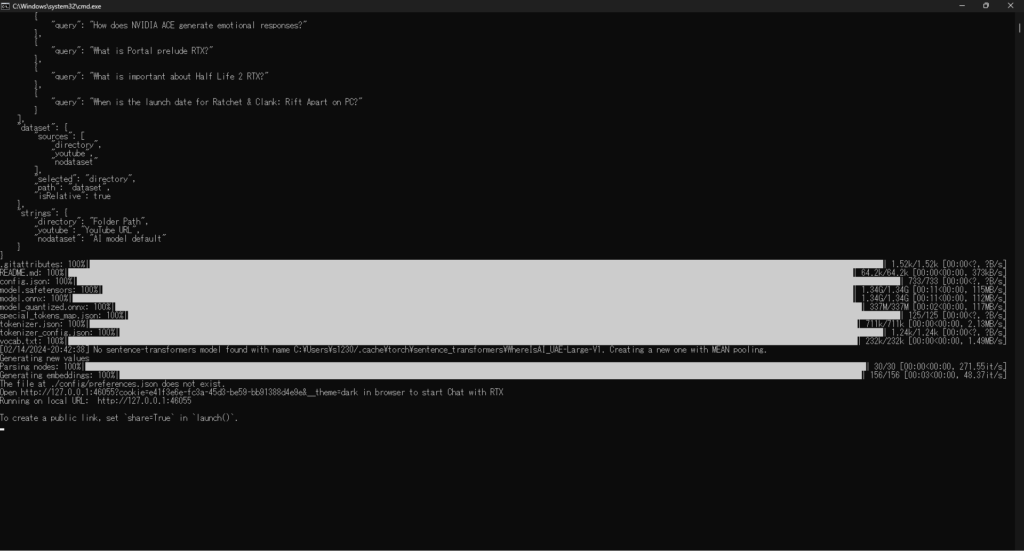

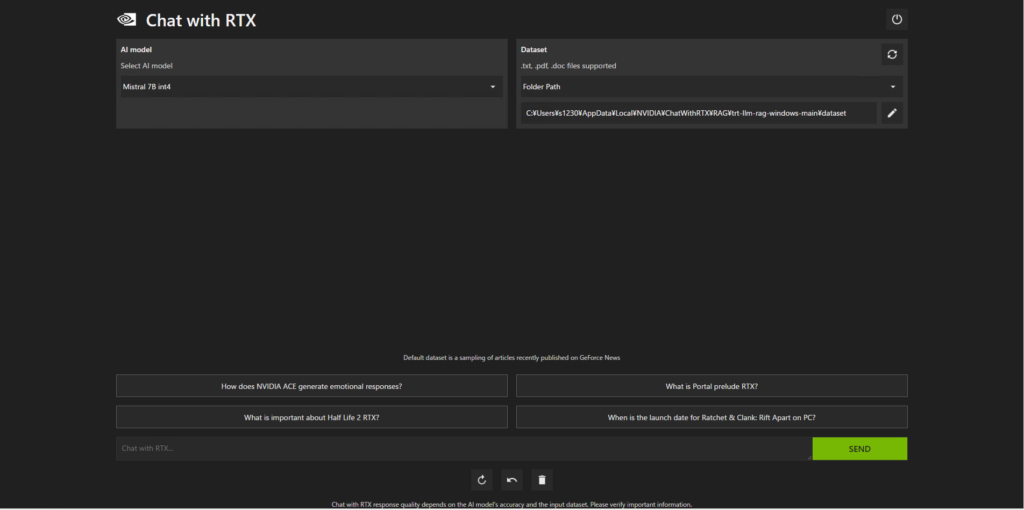

Launch the “Chat with RTX” applicationにチェックを入れてCloseをクリックすると、Chat with RTXが起動して以下のような画面になります。

ここで表示されているURLにアクセスすることで、Chat with RTXを使用できるようになります。

これで実装は完了です。

試しに、Mistral 7b int4にGeForce RTXについて質問してみましょう。

以下のプロンプトを入力します。

What is GeForce RTX?GeForce RTXとはなんですか?

わずか4秒ほどで以下の回答を出力しました。

GeForce RTX is a technology developed by NVIDIA that improves the performance and visual quality of computer games.

It uses a combination of technologies such as NVIDIA RTX IO, GDeflate, and Microsoft DirectStorage for Windows to enable faster loading times, near-photorealistic environments, and rapid texture loading.

GeForce RTX is available on various NVIDIA GPUs, including the GeForce RTX 4090, and can be experienced at events such as LTX 2023 and QuakeCon 2023.

Reference files:

portal-prelude-rtx-available-now-for-free.txtGeForce RTXは、NVIDIAが開発した、コンピュータゲームのパフォーマンスとビジュアル品質を向上させる技術です。

NVIDIA RTX IO、GDeflate、Microsoft DirectStorage for Windowsなどの技術を組み合わせて使用し、より高速なローディング時間、フォトリアリスティックに近い環境、迅速なテクスチャローディングを可能にします。

GeForce RTXは、GeForce RTX 4090を含む様々なNVIDIA GPUで利用可能であり、LTX 2023やQuakeCon 2023などのイベントで体験することができます。

参考ファイル

portal-prelude-rtx-available-now-for-free.txt

GeForce RTXの概要を正しく出力してくれました。

ここからは、Chat with RTXの機能や性能についてさらに深堀りしていきます。

Chat with RTXの推しポイントである高速推論や高い柔軟性は本当なのか検証してみた

ここからは、Chat with RTXの性能や機能をさらに深堀していこうと思います。

推論速度検証

推しポイントの一つである推論速度を、GPT-4とLM StudioでインストールしたLlama2 13B Chat.Q4_0.ggufと比較していきます。

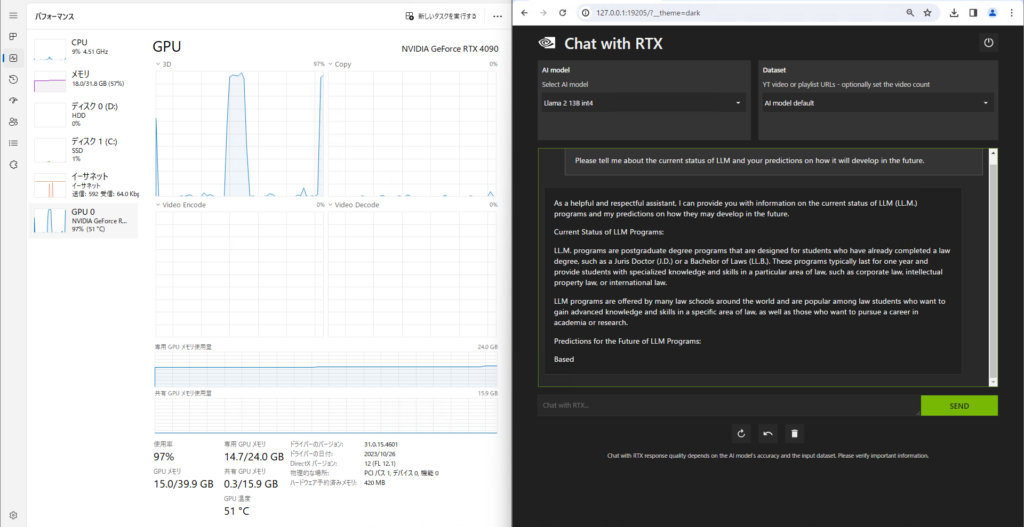

まずは、LM StudioでLlama2 13Bを使用した場合との比較です。

なお、LM Studioでインストールするモデルは、Chat with RTXで使用できるLlama2 13B int4と同じく4bit化された、Llama2 13B Chat.Q4_0.ggufを使用します。

以下のプロンプトを入力して、回答の出力が終わるまでの時間を比較します。

Please tell me about the current status of LLM and your predictions on how it will develop in the future.LLMについて、現状と今後どのように発展していくか、あなたの予想を教えてください

結果はこのようになりました。

このように同じモデルでも、Chat with RTXを使用した方が数倍速く動作することが分かります。

ただ、Chat With RTXは、以下のように推論を開始した直後にGPU使用率が97%まで跳ね上がります。

一瞬だけなので動作が重くなったりはしませんが、Llama2 13Bを動かす場合、VRAMは16GB以上はあった方が良いでしょう。

続いて、GPT-4との速度比較です。

先ほどと同じプロンプトを入力します。

結果はこのようになりました。

こちらもChat with RTXの方が1.5倍程度速いという結果になりました。

このように、Chat with RTXを使用すれば非常に高速でストレスフリーなモデルとの対話が実現できます。

ここからは、Chat with RTX独自の機能について検証します。

機能検証

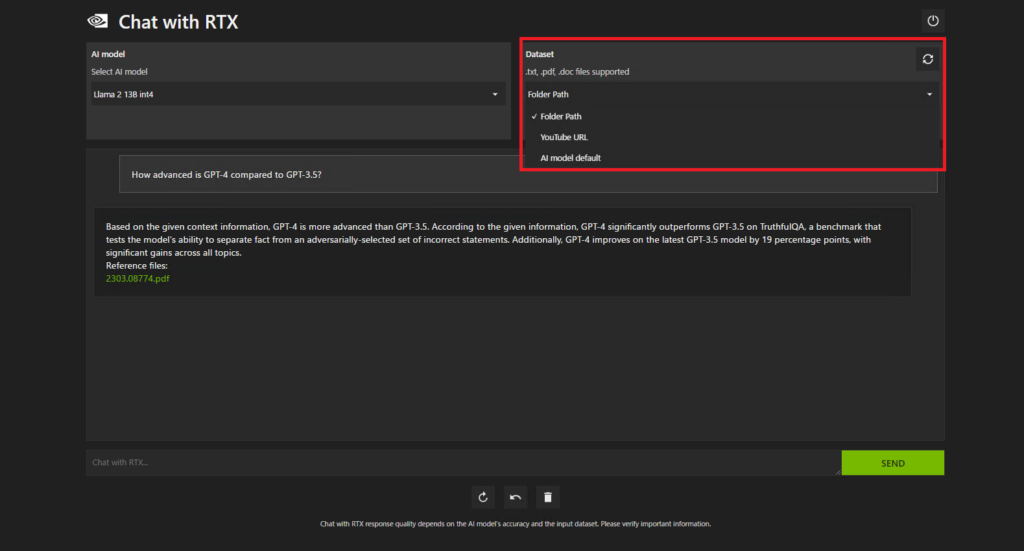

Chat with RTXには、ローカルにあるファイルや、Youtube上の動画などをデータセットとして、その知識をクエリに統合する機能があります。

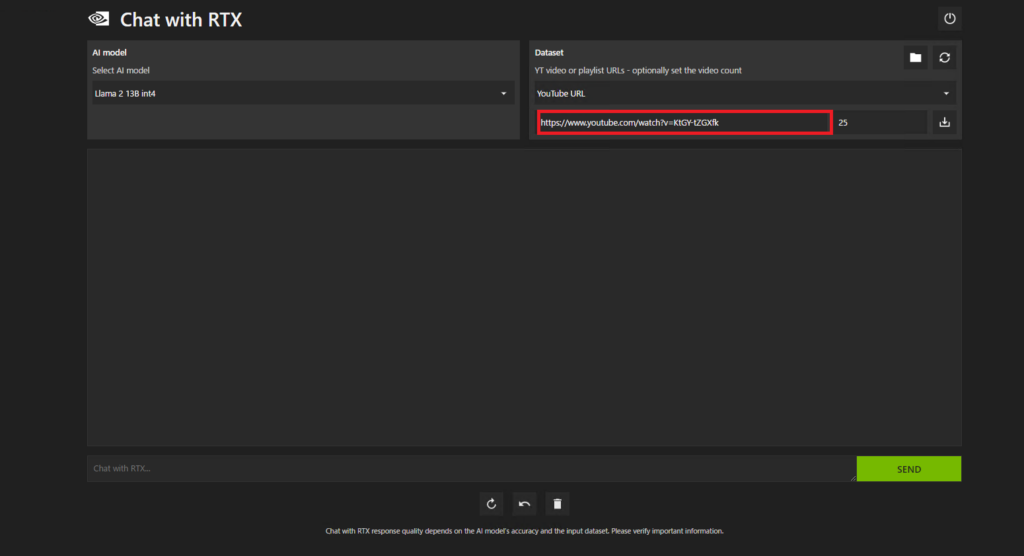

参照するデータセットは、画像の赤枠の部分で変更でき、ローカルファイルの場合は「Forder Path」、YouTube上の動画の場合は「YouTube URL」、何も参照させない場合は「AI model default」を選択します。

これらの機能を一つずつ試してみましょう!

Forder Path

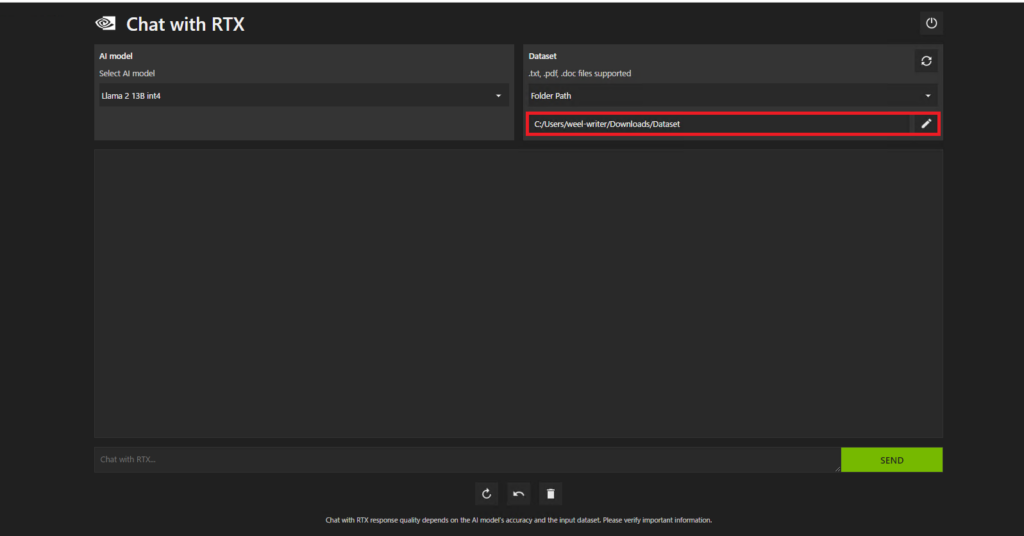

以下のGPT-4の論文のPDFをデータセットとしてロードさせます。

PDFをフォルダに格納し、そのパスを画像の赤枠部分に貼り付けます。

これで準備は完了です。

以下のプロンプトを入力してみましょう。

How advanced is GPT-4 compared to GPT-3.5?GPT-4はGPT-3.5と比較してどれくらい進化したの?

結果はこのようになりました。

Based on the given context information, GPT-4 is more advanced than GPT-3.5. According to the given information, GPT-4 significantly outperforms GPT-3.5 on TruthfulQA, a benchmark that tests the model's ability to separate fact from an adversarially-selected set of incorrect statements.

Additionally, GPT-4 improves on the latest GPT-3.5 model by 19 percentage points, with significant gains across all topics.

Reference files:

2303.08774.pdf与えられた文脈情報に基づくと、GPT-4はGPT-3.5よりも進んでいる。与えられた情報によると、GPT-4はTruthfulQAにおいてGPT-3.5を大幅に上回っています。TruthfulQAは、敵対的に選択された誤った発言の集合から事実を分離するモデルの能力をテストするベンチマークです。さらに、GPT-4は最新のGPT-3.5モデルを19ポイント改善し、すべてのトピックで有意な改善を示しています。

しっかりと論文を参照して、情報を提供してくれました。

この機能を使うことで、論文の要約や理解といったタスクが格段に効率化できそうですね!

YouTube URL

続いて、以下のCES2024でのNVIDIAのSpecial Address動画をロードしてその内容について質問します。

YouTube上の動画をロードするには、画像の赤枠の部分にURLを貼り付け、右側のDownloadボタンをクリックしてください。

以下のプロンプトを入力します。

Tell me about what NVIDIA announced at CES 2024.CES2024でNVIDIAが発表したものについて教えて

結果はこのようになりました。

Sure, I'd be happy to help! Based on the context information provided, it appears that NVIDIA announced several new products and features at CES 2024, including:

New RTX laptops from every major OEM, with more powerful RT and Tensor Cores for AI-ready gaming and creative workflows.

The RTX 4080 Super and RTX 4070 Ti Super desktop GPUs, which offer more performance and support for generative AI.

The RTX 4070 Super, which is 1.6x faster than the RTX 3070 Ti and offers 20% more cores.

The RTX 4040, which is 2.5x faster with DLSS 3 and offers 16GB of memory.

The RTX 4090, which is the most powerful laptop GPU ever made and offers 16GB of memory.

The RTX 4080, which is 1.5x faster than the RTX 3080 and offers 20% more cores.

The RTX 4070, which is 2.5x faster with DLSS 3 and offers 16GB of memory.

The RTX 4060, which is 1.6x faster than the RTX 3060 and offers 16GB of memory.

The RTX 4050, which is 2.5x faster with DLSS 3 and offers 16GB of memory.

The RTX 4040, which is 1.6x faster than the RTX 3040 and offers 16GB of memory.

It's worth noting that some of these products and features were announced as "coming soon" or "launching in the future," so it's possible that they may not be available yet or may have been released since the context information was provided.

Reference files:

Title: GeForce at CES 2024 | Special Address

Channel: NVIDIA GeForce

Upload Date: 2024-01-08もちろん、喜んでお手伝いしますよ!提供されたコンテキスト情報によると、NVIDIAはCES 2024で以下のようないくつかの新製品や新機能を発表したようだ:

各主要OEMからの新しいRTXラップトップは、AI対応のゲームやクリエイティブなワークフロー向けに、より強力なRTコアとテンソルコアを搭載しています。

RTX 4080 SuperおよびRTX 4070 Ti SuperデスクトップGPUは、より高い性能とジェネレーティブAIをサポートします。

RTX 4070 Superは、RTX 3070 Tiより1.6倍高速で、コア数が20%増加しています。

RTX 4040はDLSS 3により2.5倍高速で、16GBのメモリを提供する。

RTX 4090は、これまで製造されたラップトップGPUの中で最も強力で、16GBのメモリを搭載しています。

RTX 4080はRTX 3080の1.5倍高速で、コアが20%増加しています。

RTX 4070は、DLSS 3により2.5倍高速で、16GBのメモリを提供します。

RTX 4060はRTX 3060より1.6倍高速で、16GBのメモリを搭載。

RTX 4050は、DLSS 3により2.5倍高速で、16GBのメモリを提供します。

RTX 4040はRTX 3040の1.6倍高速で、16GBのメモリを搭載しています。

注目に値するのは、これらの製品や機能のいくつかは「近日発売」または「将来発売」とアナウンスされたため、まだ発売されていないか、またはコンテキスト情報が提供された後にリリースされた可能性があることだ。

結果は、ロードしたYouTube上の動画を参照して回答を出力してくれていますが、動画上では言及されていない情報や、RTX4040などの存在しない製品を、あたかも存在しているかのように紹介しています。

ハルネーションを起こしてしまっており、良い結果とは言えません。

この原因が、Chat with RTX側にあるのかモデル側にあるのかは分かりませんが、この点は改善が必要そうです。

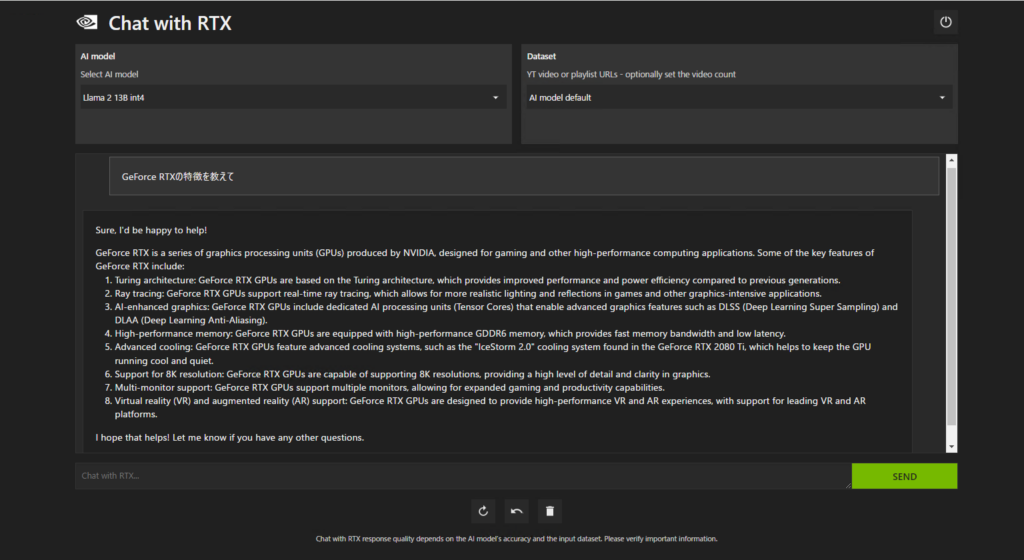

日本語対応

最後におまけとして、日本語に対応しているのか検証します。

以下のプロンプトを入力します。

GeForce RTXの特徴を教えて結果はこのように、日本語入力を理解して英語で回答を出力しました。

Sure, I'd be happy to help!

GeForce RTX is a series of graphics processing units (GPUs) produced by NVIDIA, designed for gaming and other high-performance computing applications. Some of the key features of GeForce RTX include:

Turing architecture: GeForce RTX GPUs are based on the Turing architecture, which provides improved performance and power efficiency compared to previous generations.

Ray tracing: GeForce RTX GPUs support real-time ray tracing, which allows for more realistic lighting and reflections in games and other graphics-intensive applications.

AI-enhanced graphics: GeForce RTX GPUs include dedicated AI processing units (Tensor Cores) that enable advanced graphics features such as DLSS (Deep Learning Super Sampling) and DLAA (Deep Learning Anti-Aliasing).

High-performance memory: GeForce RTX GPUs are equipped with high-performance GDDR6 memory, which provides fast memory bandwidth and low latency.

Advanced cooling: GeForce RTX GPUs feature advanced cooling systems, such as the "IceStorm 2.0" cooling system found in the GeForce RTX 2080 Ti, which helps to keep the GPU running cool and quiet.

Support for 8K resolution: GeForce RTX GPUs are capable of supporting 8K resolutions, providing a high level of detail and clarity in graphics.

Multi-monitor support: GeForce RTX GPUs support multiple monitors, allowing for expanded gaming and productivity capabilities.

Virtual reality (VR) and augmented reality (AR) support: GeForce RTX GPUs are designed to provide high-performance VR and AR experiences, with support for leading VR and AR platforms.

I hope that helps! Let me know if you have any other questions.もちろん、喜んでお手伝いしますよ!

GeForce RTXは、NVIDIAによって製造されたグラフィックス・プロセッシング・ユニット(GPU)のシリーズで、ゲームやその他の高性能コンピューティング・アプリケーション向けに設計されています。GeForce RTXの主な特徴は以下の通りです:

チューリングアーキテクチャ: GeForce RTX GPUはTuringアーキテクチャをベースとしており、前世代と比較して性能と電力効率が向上しています。

レイトレーシング: GeForce RTX GPUはリアルタイムのレイトレーシングをサポートしており、ゲームやその他のグラフィックスを多用するアプリケーションにおいて、よりリアルなライティングや反射を可能にします。

AI強化グラフィックス: GeForce RTX GPUは、DLSS(ディープラーニング・スーパーサンプリング)やDLAA(ディープラーニング・アンチエイリアシング)などの高度なグラフィックス機能を可能にする専用のAI処理ユニット(テンソルコア)を搭載しています。

高性能メモリ: GeForce RTX GPUは、高速なメモリ帯域幅と低レイテンシを実現する高性能GDDR6メモリを搭載しています。

高度な冷却: GeForce RTX GPUは、GeForce RTX 2080 Tiに搭載されている「IceStorm 2.0」冷却システムなど、高度な冷却システムを搭載しており、GPUの冷却と静音性を保つことができます。

8K解像度のサポート: GeForce RTX GPUは8K解像度をサポートすることができ、グラフィックスに高いレベルのディテールと鮮明さを提供します。

マルチモニター対応: GeForce RTX GPUはマルチモニターをサポートしており、ゲームや生産性の向上が可能です。

仮想現実(VR)と拡張現実(AR)のサポート: GeForce RTX GPUは、主要なVRおよびARプラットフォームをサポートし、高性能なVRおよびAR体験を提供するように設計されています。

お役に立てれば幸いです!他に質問があれば教えてください。

どうやら入力は日本語に対応していますが、出力は対応していないようです。

まとめ

今回の検証の結果、判明したChat with RTXの良い点と悪い点をまとめます。

良い点

- 推論速度が超高速

- 動作が安定していて重くなることがない

- PDFファイル等をデータセットとしてクエリに統合できる

- YouTube上の動画もロードして参照できる

- ローカル環境で動作するのでインターネット接続がいらない

- 日本語入力に対応している(出力は未対応)

悪い点

- YouTube上の動画を参照した際、動画で言及されていない情報や存在しない情報を提供することがある

- 必要スペックがかなり高い(Llama2 13Bを動かす場合、最低でもVRAM16GBは必要そう)

- 一瞬ではあるが、GPU使用率が跳ね上がる(RTX 4090で97%まで上昇)

悪い点に関しては、機能面はYouTube動画を参照した際のハルネーションのみで、総合すると良い点が悪い点を大幅に上回っていると感じます。

必要要件が高くて試せない方もいらっしゃるかもしれませんが、この記事を読んで気になった方は是非試してみて下さい!

なお、今回主に使用したモデルであるLlama2 13Bについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【Llama 2】オープンソース版ChatGPTの使い方〜ChatGPTとの比較まで

Chat with RTXで自分専用にカスタマイズ可能なチャットボットを作成しよう!

Chat with RTXは、2023年2月13日にNVIDIAが公開した、GeForce RTX GPUを用いてローカル環境で動作するAIチャットボットアプリです。

このアプリでは、MistralとLlama2の2種類のオープンソース大規模言語モデル(LLM)を迅速かつ簡単に使用でき、ローカルにあるファイルや、YouTube上の動画などをデータセットとして、その知識をクエリに統合できます。

つまり、ローカル環境に自分専用の超高速チャットボットが作成できるということです!

実際に使用してみたところ、GPT-4やローカルでLM Studioを用いて同じモデルを実行した際と比較して、数倍程度速い推論速度でした。

また、実際にローカルのファイルやYouTube上の動画を参照して質問に答えてくれることも確認しましたが、その回答精度はまだまだ改善が必要だと感じました。

必要スペックはかなり高いですが、もし環境のある方は是非試してみてください!

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。