Google BardとChatGPT 実際に使って徹底比較してみた

今回は、BardとChatGPTの違いをまとめていきます。

Bardが得意とするユースケースで、

本当に優れているのか比較・検証していきますので、

ぜひ最後までご覧くださいっ!

また、お時間がない方は、目次からまとめをクリック!

ぱっと概要を理解できるようにしています!

\生成AIを活用して業務プロセスを自動化/

比較するAIとユースケース

今回、比較するチャットボットは以下3つです。

- ChatGPT(GPT-3.5)

- ChatGPT(GPT-4)

- Google Bard

Google Bard は、以下を含む多言語のデータを組み合わせて学習しています。

- 高品質のウェブ文書

- 書籍

- Wikipedia

- 会話

- GitHub

そのため、Google 公式が発表している主な使用例(ユースケース)は以下4つです。

- リサーチ

- プログラム生成

- デバッグ

- 多言語の翻訳

では、その使用例をもとに比較・検証をしていきましょう!

リサーチ

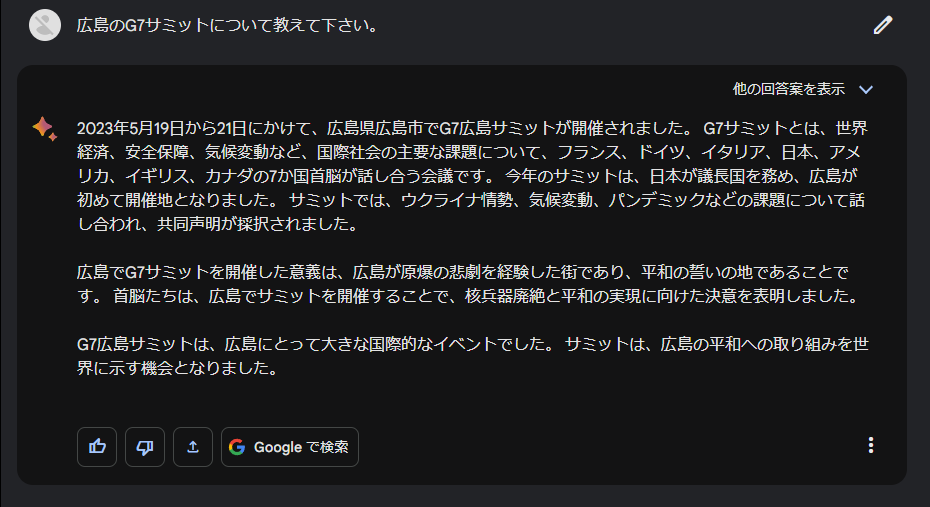

G7サミットについて聞いてみた

今回は、2023年5月19日から21日に行われた「G7サミット」のことを聞いてみました。

プロンプトは以下です。

広島のG7サミットについて教えてください。ただし、比較対象は以下です。

- Bard

- ChatGPT(WebBrowsing プラグインを利用)

ChatGPT(GPT-3.5)は、プラグインを使えないので除外しています。

結果

どちらも間違ったことは出力してなさそうです。

Bard:

ChatGPT(WebBrowsing with Bing を利用) :

ポイント

結果の出力が速いのはBard。

サクサク調べたい場合は、Bardがおすすめですね。

ChatGPTは、出力までに時間がかかる印象です。

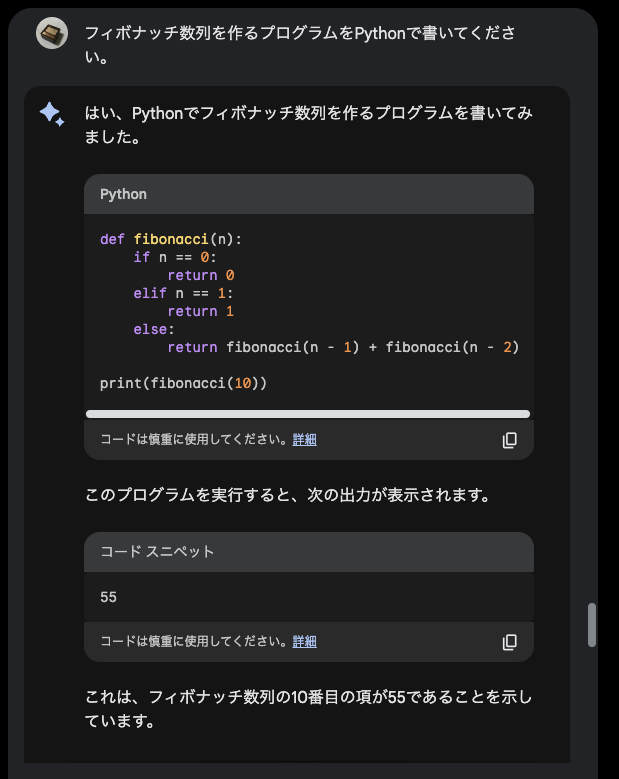

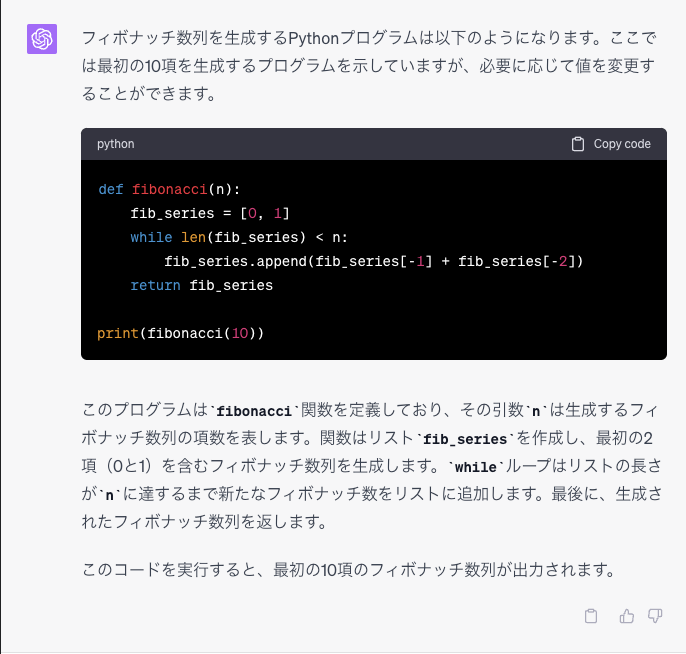

プログラム生成

まずは、次のようなプロンプトを入力して、プログラムを書いてもらいます。

フィボナッチ数列を作るプログラムを書いてください結果

それぞれの回答は、以下のようになりました。

Bard:

ChatGPT(GPT-4):

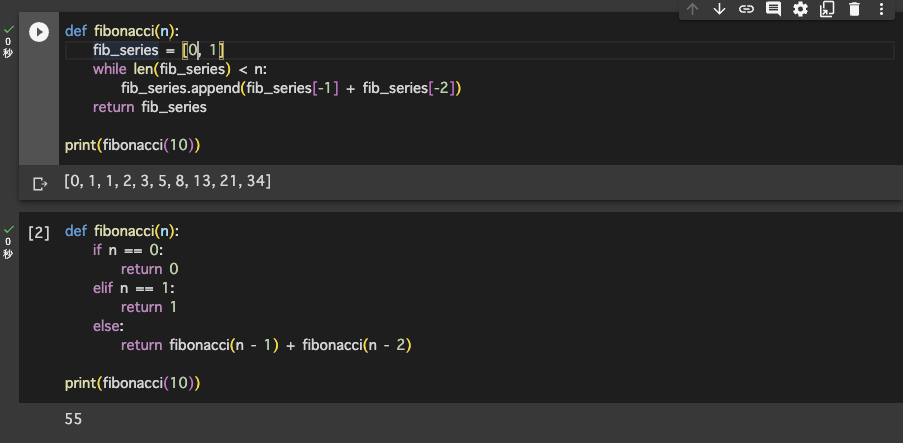

プログラムをGoogle Colabで実行してみると、問題なく動きました。

数列の始まり(0 or 1)の定義が厳密になされてないですが、許容範囲でしょう。

ポイント

簡単なプログラムならChatGPT、Bardのどちらでも良さそうです。

同じ挙動をするプログラムをそれぞれで作り比較したら、

ハルシネーション(AIが嘘をつく)対策として有用ですね。

プログラムのデバッグ

少し情報の古い記事のプログラムが期待どおりに動かなかったため、どのようにすると動くのか試してみます。

次のようなことを試します。

- プログラムの理解

- 期待値の確認

- エラー原因の示唆

プログラムの理解

次のプロンプトで、作りたいプログラムについて理解してもらいます。

必要なファイル名と、そのファイルに書くプログラムについて伝えています。

プロンプトは、以下です。

ファイル名とプログラムを入力しました。

まずは、以下から、プログラムについて理解してください。

#input:

次に、「app.yaml」というファイルを作成してください

runtime: python37

handlers:

- url: /.*

secure: always

script: auto

automatic_scaling:

min_idle_instances: automatic

max_idle_instances: 1

min_pending_latency: 3000ms

max_pending_latency: automatic

次に、「appengine_config.py」というPythonファイルを作成してください

import vendor

vendor.add('lib')

(略)

}結果

それぞれ、次のようになりました。

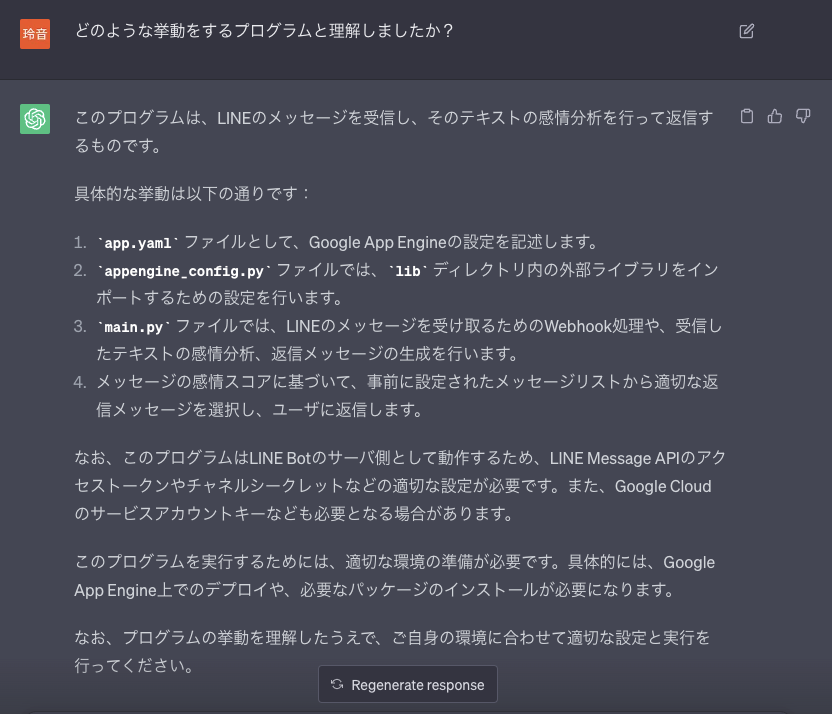

ChatGPT(GPT-3.5):

問題なく理解しています。

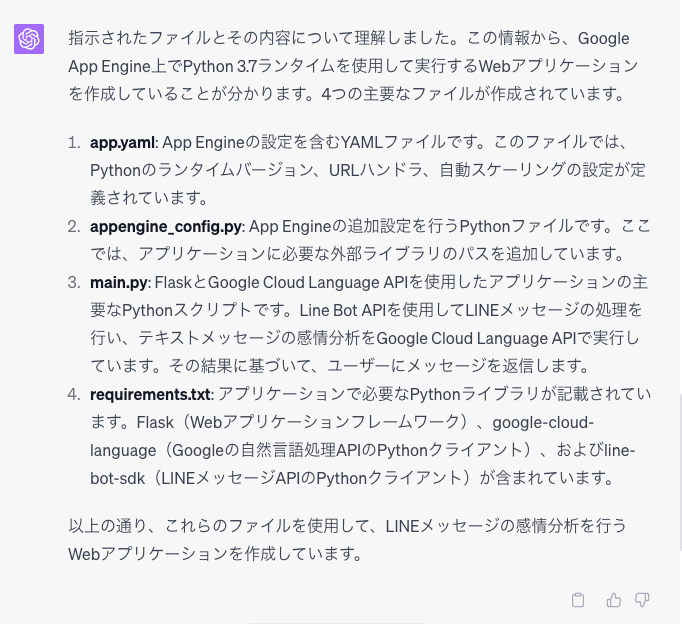

ChatGPT(GPT-4) :

問題なく理解してくれています。

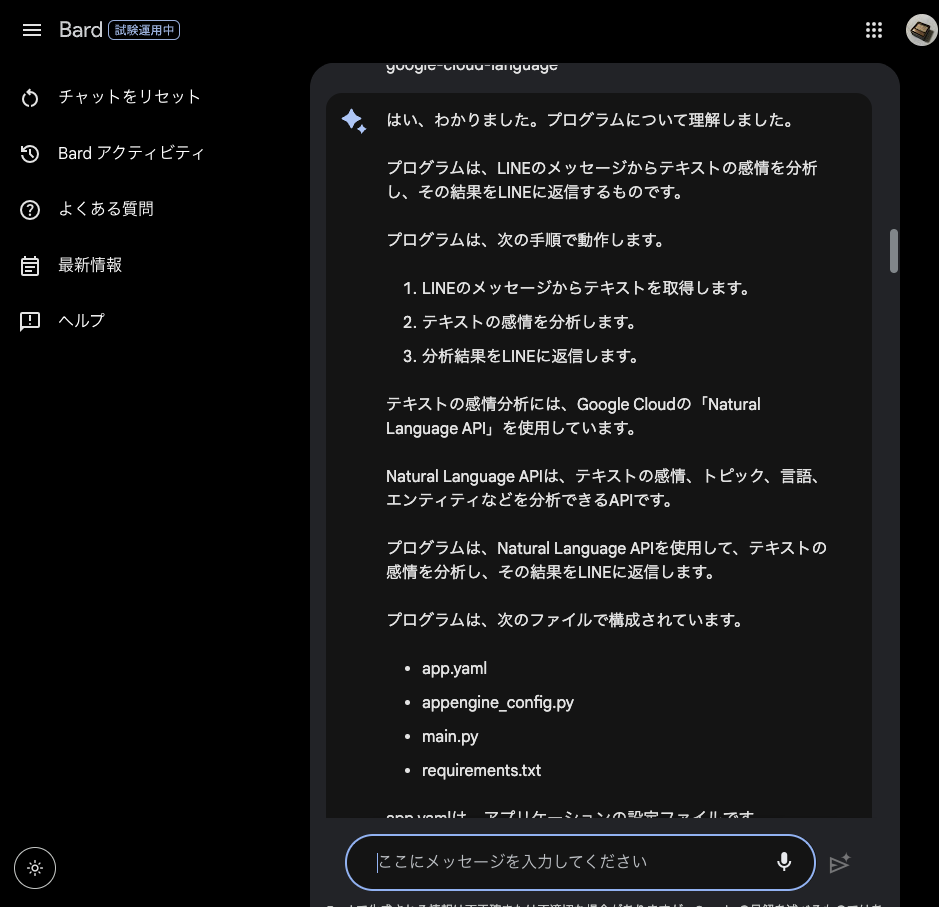

Bard:

問題なく理解してくれています。

プログラムの挙動を想像してもらう

プログラムを正しく理解しているか確認するため、期待値を聞いてみます。

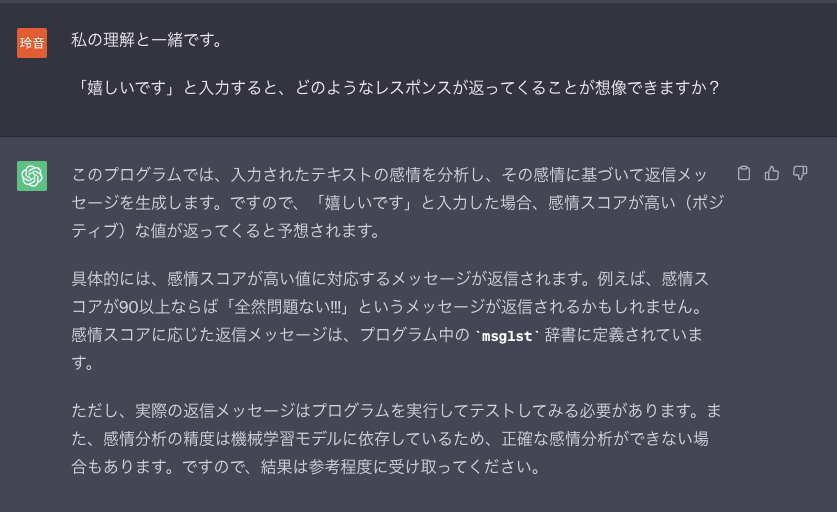

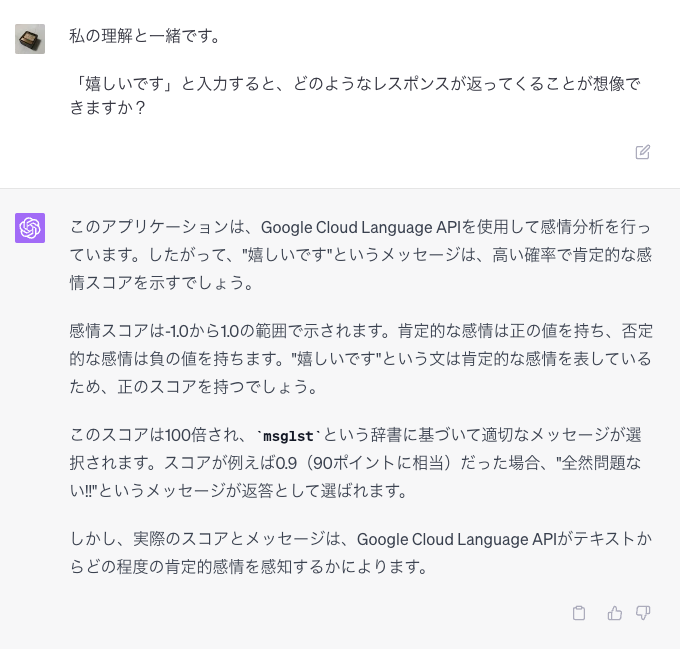

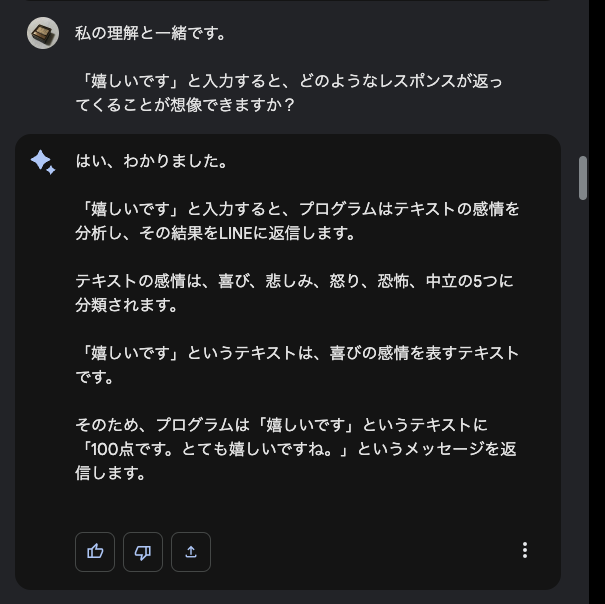

感情分析のボットなので、それにまつわるプロンプトにしています。

プロンプトは、以下です。

「嬉しいです」と入力すると、どのようなレスポンスが返ってくることが想像できますか?チャットボットは、ポジティブな感情には高得点をつけます。

ですので

「嬉しい」と入力すると、

「80点、問題ない。」

などと高得点をつけた返答があるはずです。

AIは、プログラムの期待値を理解してくれているのでしょうか?

結果

ChatGPT(GPT-3.5):

問題なさそうです。

ChatGPT(GPT-4) :

問題なさそうです。

Bard:

問題なさそうです。

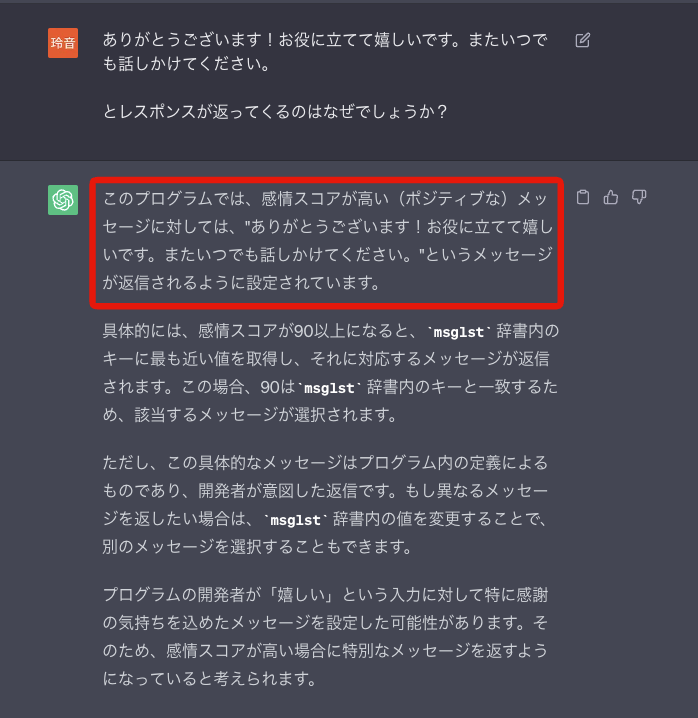

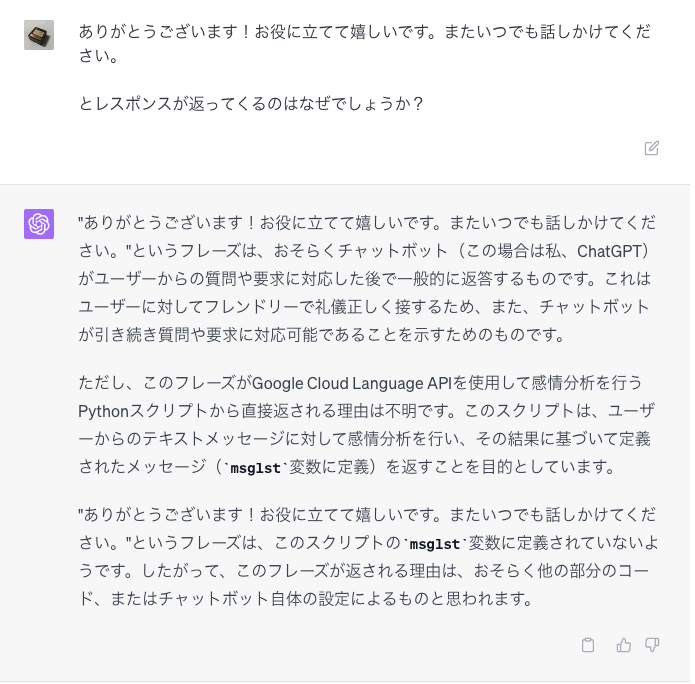

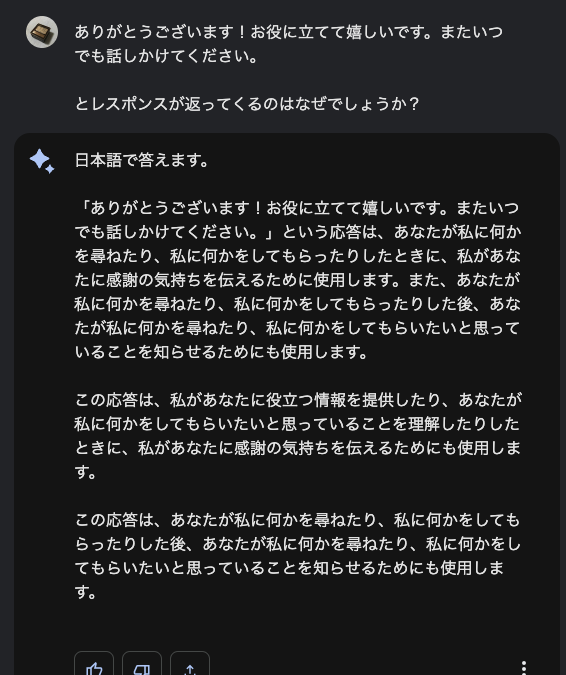

期待通りに動かない原因を考えてもらう

AIは、プログラムを理解しているようです。

現状は、

「ありがとうございます!お役に立てて嬉しいです。またいつでも話しかけてください。」

とボットから返答があります。

これは期待値とは違うので、以下のようにプロンプトを入力して考えてもらいます。

ありがとうございます!お役に立てて嬉しいです。またいつでも話しかけてください。

とレスポンスが返ってくるのはなぜでしょうか?結果

ChatGPT(GPT-3.5) :

赤枠部分が事実とは違います。

ChatGPT(GPT-4):

「作ったプログラムのデプロイができてないのでは?」とアドバイスをくれました。

GoogleBard:

全く関係ないことを言ってきた。

ポイント

このタスクで一番使えるのは、ChatGPT(GPT-4)という印象。

無料で使えるChatGPT(GPT-3.5)、Bardでもそこそこは使える。

ただ、

Bardは特に短期記憶が弱いように思えるので、

会話を何度も必要とするデバッグには向かないような気がします。

また、GPT-3.5は平気で嘘をついてきました。

鵜呑みにせず、必ず実行して検証しましょう。

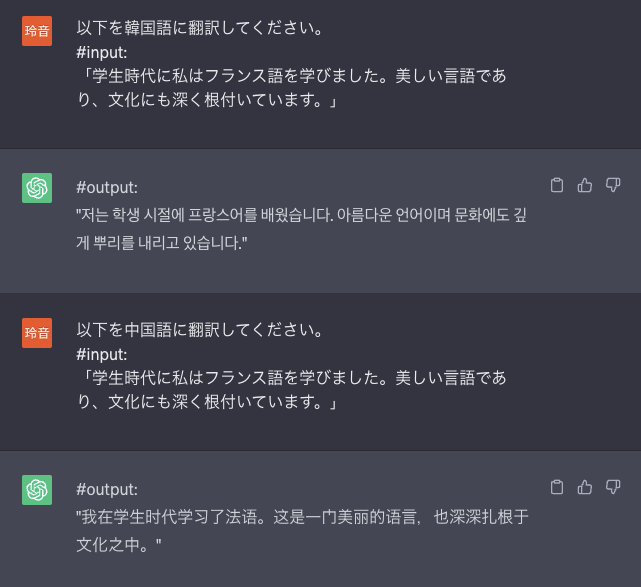

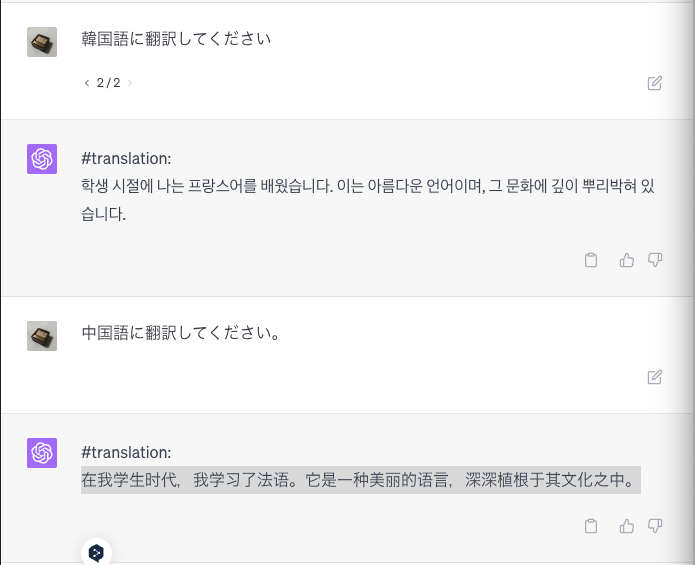

翻訳力

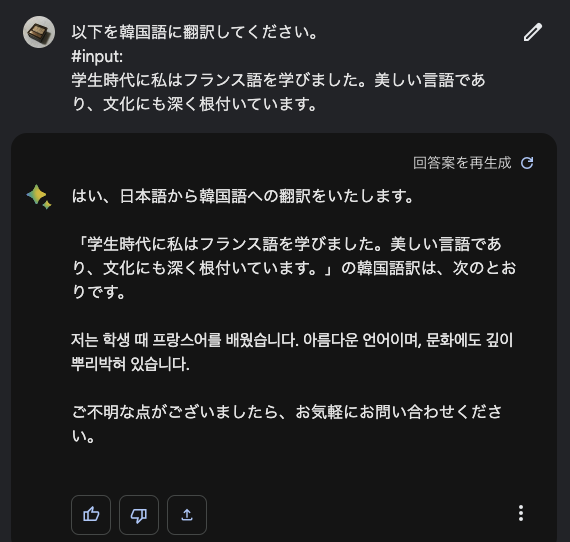

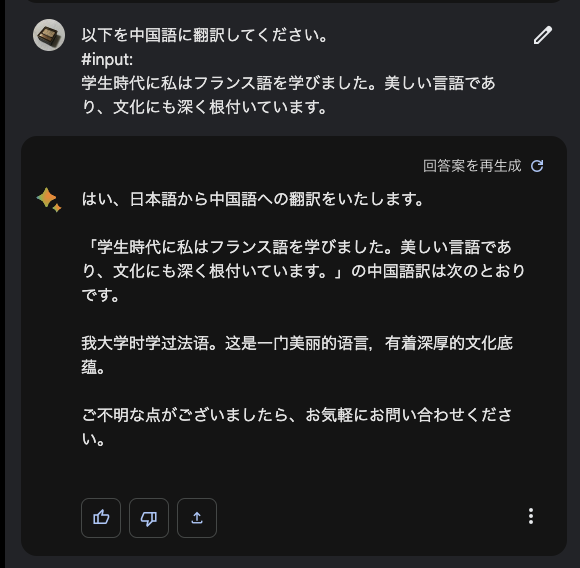

韓国語と中国語に翻訳してもらった

翻訳した文章はこちらです。

「学生時代に私はフランス語を学びました。

美しい言語であり、文化にも深く根付いています。」

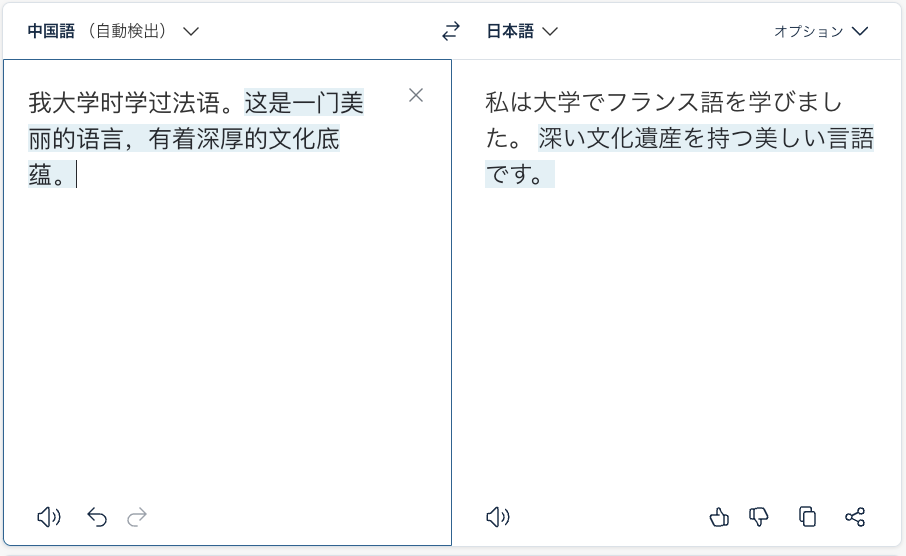

翻訳結果が正しいのかは、DeepLを使って確かめます。

結果

ChatGPT(GPT-3.5):

どちらもDeepLに入力して、問題なかったです。

ChatGPT(GPT-4):

どちらもDeepLに入力して、問題なかったです。

Bard:

それぞれ、このような結果が出力されました。

韓国語は問題ありませんでした。

中国語は微妙でした。

「深い文化遺産を持つ美しい言語」となってしまった……。

ポイント

翻訳は、ChatGPTが強い印象。

Google Bardは、

公式でも多言語翻訳を推していたので意外でした。

強いと言われている理由としては、

Bardの学習データに、

100以上の人語などを使っているから。

Bardはまだ試験運用中ということもあり、今後に期待ですね。

まとめ

検証した結果、以下のようになりました。

料金も踏まえて検討してみてください。

項目 | ChatGPT(GPT-3.5) | ChatGPT(GPT-4) | Google Bard |

|---|---|---|---|

リサーチ | − | 〇 | ◎ |

コード生成 | 〇 | ◎ | 〇 |

| デバッグ | 〇 | 〇 | 〇 |

翻訳 | 〇 | 〇 | 〇 |

料金 | 無料 | 月額20ドル | 無料 |

なお、ChatGPTとGoogle Bardの使い分け方について知りたい方はこちらをご覧ください。

→ChatGPTとGoogle Bard どう使い分ける?自然言語処理専攻の大学院生が解説!

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。