【Genie】Googleが公開した仮想世界を作り出す「世界創造モデル」の仕組みを徹底解剖

WEELメディア事業部LLMリサーチャーの中田です。

2024年2月23日、GoogleのDeepMindから「Genie」というゲーム生成AIモデルが公開されました!

このモデルによって、1つの画像からゲームを生成できるようになりました。

Genie関連のXでの投稿のいいね数は、すでに2,000を超えており、注目の高さをうかがえます。

この記事では、Genieの技術的な部分を徹底的に解説します。本記事を熟読することで、Genieの内部構造をより理解でき、一般公開が待ち遠しくなるでしょう。

ぜひ、最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Genieの概要

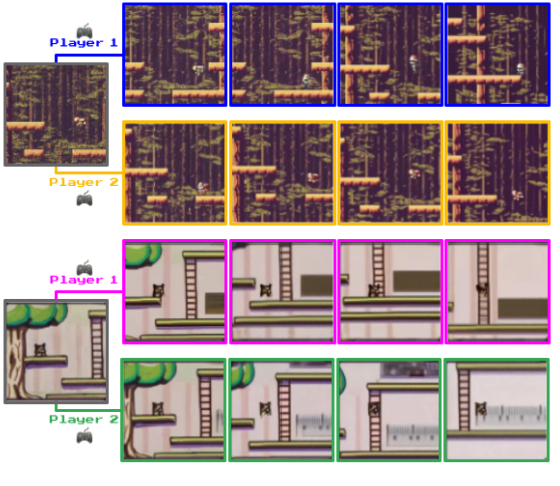

Genieは、Google DeepMindが開発したゲーム生成AI技術で、単一の画像からビデオゲームのような環境を作り出せます。入力画像には、以下のようなものが想定されています。

- Text-to-Imageで生成された画像

- 実際の写真

- 手描きのスケッチ

それら画像プロンプトをGenieに入力し、生成されたゲーム環境では、左・右への動きやジャンプといった操作が可能になるのです。

また、Genieは20万時間分のインターネット上のゲーム動画データを用いて教師なし学習がされ、ジャンプアクションなどの操作に関する情報がなくても、自由にプレーできるゲームの世界を生成できます。

加えて、Genieは11Bのパラメータを持つモデルで、論文内では「a foundation world model」と表現されています。そして、ゲーム制作やAIエージェントの開発などに、利用される可能性があるとのこと。

Genieによって実際に生成されたゲームについては、Genieのプロジェクトページで確認できます。

なお、Googleの国際数学オリンピックレベルの難題を解決できるAIについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【AlphaGeometry】Googleが数学オリンピック優勝レベルの難問を解く生成AIを公開!実際に使ってみた

Genieで用いられている技術

Genieの技術的な詳細は、DeepMindの論文に記載されています。

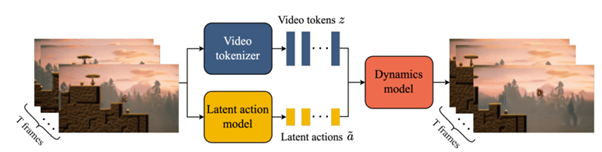

Genieの学習過程は、以下の通りです。

- フレーム数Tの動画データが入力される

- Video tokenizerによって、離散ビデオトークンzにトークン化される

- Latent action modelによって、各フレーム間での行動を予測

- 2~3の情報をDynamics modelに送り、それをもとに次のフレームTを予測

この手順を繰り返します。

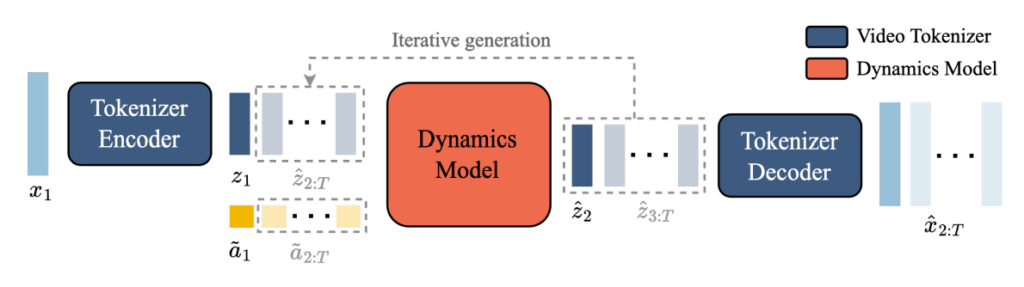

そして、推論過程では、以下の手順をたどります。

- ユーザーがモデルに対して入力画像をプロンプトとして入力

- この画像をVideo Tokenizerによってトークン化

- ユーザーがアクションを指定

- Dynamics Modelが、フレームトークンとそれに対応する潜在アクションを入力に取る

- VQコードブックを通じて、離散的な入力から得られた潜在アクションで、次のフレームトークンを予測

- Video tokenizerのデコーダーによりビデオフレームを出力

学習ではモデルに動画を入力し、推論では画像を入力する点に、注意してください。

この時、Genieでは主に以下の3つの技術を構成しています。

- Latent Action Model

- Video Tokenizer

- Dynamics Model

次のセクション以降では、3つの構成要素について、それぞれ詳しく見ていきます。

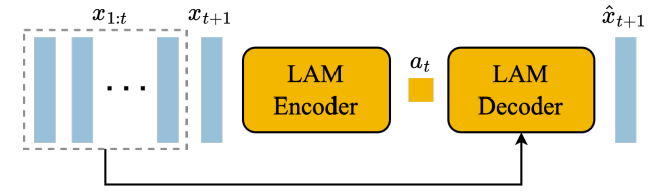

Latent Action Model

Latent Action Model(LAM)は、ビデオの次のフレームを予測する際に、過去のフレームで行われた行動に基づいて「未来にとるべき行動」を予測する技術です。インターネット上のビデオは、このような行動に関するラベル情報をほとんど含まないため、LAMは教師なし学習を通じて潜在的な行動情報を予測します。

訓練では、VQ-VAEを基にした方法を用いて、予測される行動の種類を限定した小さなセットに限定します。このアプローチにより、ユーザーは容易に操作できるようになります(例として、アクションの種類を、「横移動」や「ジャンプ」などに限定)。

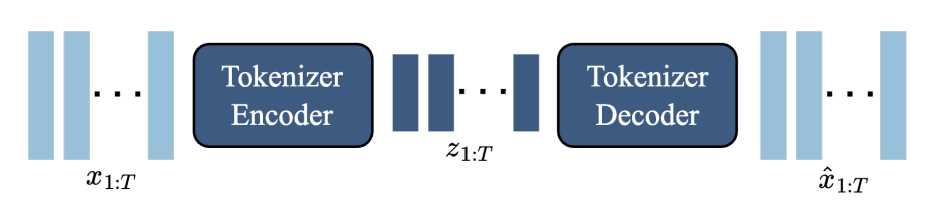

Video Tokenizer

Video Tokenizerは、ビデオを離散的なトークンに圧縮し、次元を減らすことで、より効率よく高品質なビデオ生成を可能にする技術です。このプロセスでは、VQ-VAEを使用して、ビデオフレームを入力として受け取り、それぞれのフレームに対して離散的な潜在表現(動画の内容に関する情報を圧縮したもの)を生成します。

これにより、後続のモデルコンポーネント、特にDynamics Modelが、より効率的に、そしてより正確に次のフレームを予測するための情報を利用できるようになります。

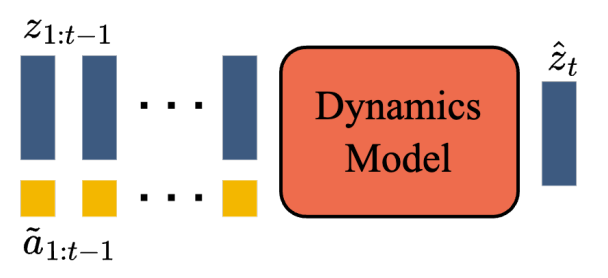

Dynamics Model

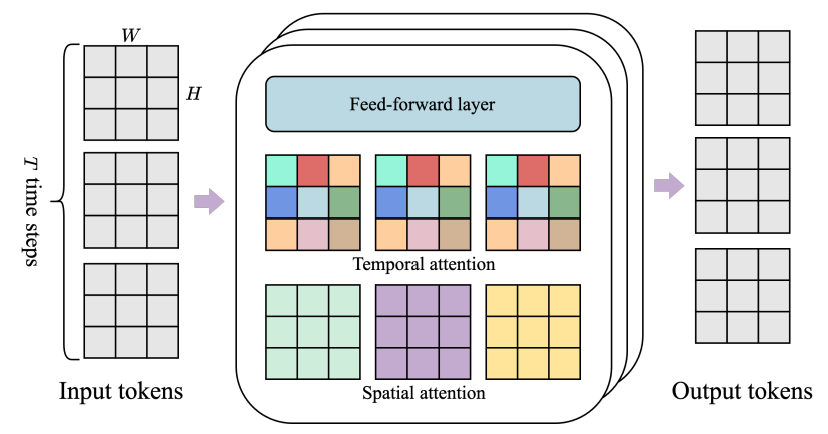

Dynamics Modelは、MaskGIT(Chang et al. 2022)を用いた「デコーダーのみのトランスフォーマーモデル」です。

具体的には、各タイムステップで、トークン化されたビデオとLatent Action Modelで処理された潜在アクションを入力として受け取り、自己回帰的に次のフレームのトークンを予測します。

このモデルでは、STトランスフォーマーの因果構造を活用し、すべてのフレームと潜在アクションから次のフレームの予測を生成します。

学習では、予測されたトークンと真のトークンとの間のクロスエントロピー誤差を計算します。また、入力トークンをベルヌーイ分布のマスキング率(0.5から1の間で一様にサンプリング)に従って、ランダムにマスクします。

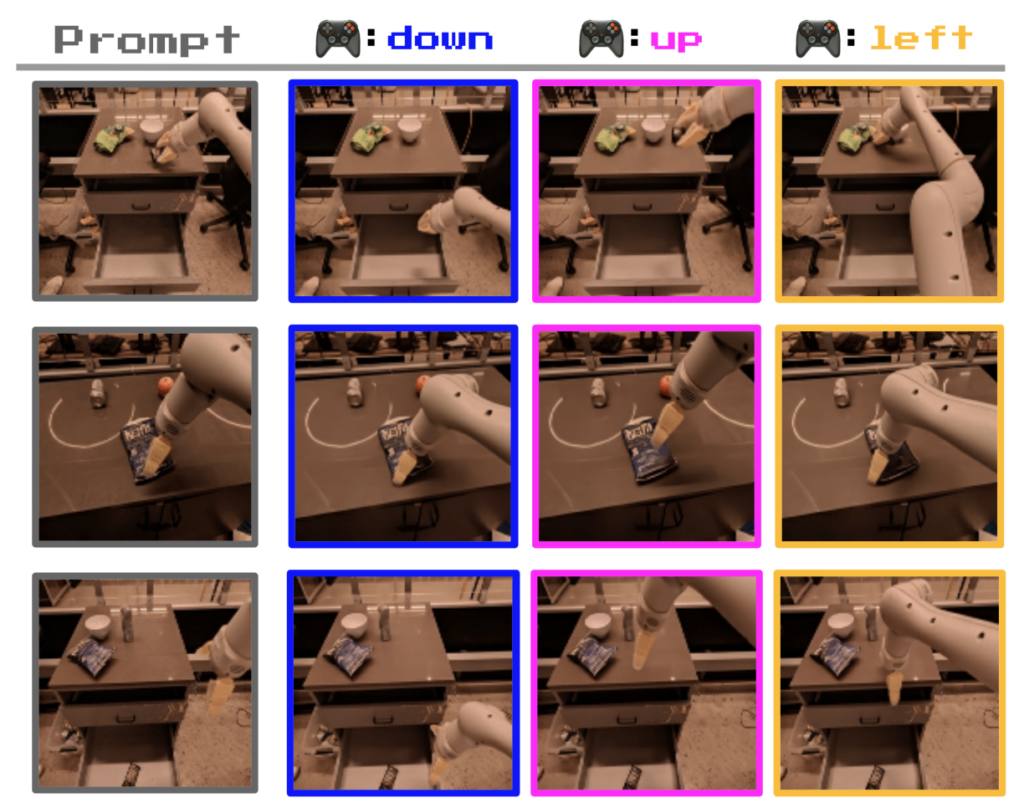

Genieを使ってできること

まず思い浮かぶのは、ゲームやコンテンツの制作への活用です。特に、昨今の画像・動画生成AIと組み合わせることで、より高品質なコンテンツを、誰でも簡単に作れるようになるでしょう。例えば、Midjourneyなどの最先端のText-to-Imageで入力画像フレームを生成し、Genieで動きを付けることだってできるのです。

その他、本研究では、ロボットの制御シミュレーションでも、有用性が認められています。特に、ロボットの腕の操作だけではなく、さまざまな物体のやりとりや形状の変化も理解できるようになったそう。

これにより、インターネット上の大規模なビデオデータセットを活用し、ロボティクスにおける多様なシミュレーションが可能になるでしょう。

それに加えてX上の投稿では、AGIのベース技術となり得るとされています。

なお、GoogleのオープンソースLLMについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【Gemma】”Llama 2超え”と噂のGoogleのオープンソースLLMの性能を徹底比較してみた

Genieの研究課題

論文内では、「Genieには、他のトランスフォーマーモデルと同じ弱点があり、非現実的な未来を予測することがある」と述べられています。要するに、ChatGPTなどと同じように、ハルシネーションを起こすという事です。特に、動画生成におけるハルシネーションというと、物理的・現実的にに有り得ない現象が起こるなどを指します。

また、現在は16フレームのメモリに限定されているため、長い時間の動画において、一貫性を保つことが困難だそう。さらに、現在の動作速度が1FPSであるため、現代のゲームの画面に比べて、かなりカクカクした動きになります。

なお、GPT-4と同等のサイズのLLMについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【switch-c-2048】GoogleがついにGPT-4レベルのLLMをオープンソースで公開!概要〜使い方まで

今後のゲーム生成AIの動向に注目

本記事では、Google DeepMindによって公開された、ゲーム生成AIの「Genie」について、技術的な観点からご紹介しました。Genieによって、単一の画像を入力するだけで、ゲームを生成できます。

Genieのモデルは、まだ一般公開されていないですが、もし公開されれば、世の中に大きな影響を及ぼすでしょう。もし、OpenAIの動画生成AIのSoraが一般公開されれば、Sora×Genieで、クオリティの高いゲームが量産されるかもしれません。

ちなみに、「Genieに乗じて、OpenAIからもゲーム生成が公開されるかもしれない」という旨のツイートも見受けられます。

Soraの公開以来、ますますOpenAIの期待が高まっている状況なので、もしかしたら近いうちに革命的なゲーム生成AIが登場するかもしれません。

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。