【AI彼女】AIでエロが叶うハイパーポルノでAI彼女を作ってみた!

皆さん、ハイパーポルノという言葉をご存知ですか?生成AI時代のエロのことで、自分好みにエロをなんでも作れてしまうことを指します。すでに海外では、『This Girl Next Door Does Not Exist』というサイトがあり、西洋美女の画像や映像がたくさん公開されているのです!

今回はご存じない方のために、ハイパーポルノの概要と実際の作り方について紹介します。この記事を最後まで読むと、可愛いAI彼女を生成できるようになるので、ぜひ最後までご覧ください!

ハイパーポルノとは?

ハイパーポルノとは、生成AI時代の新しいポルノのことです。顔や体、声など、自分好みのコンテンツを無限に作れるため、ポルノはますます加速しています。

海外ではすでに『This Girl Next Door Does Not Exist』というサイトがあり、ミンディという西洋美女の画像や、映像がたくさん!全て生成AIによるものというのですから、驚きですよね。

※リンクを開くときは十分にお気をつけくださいませ。

https://thisgirlnextdoordoesnotexist.net/

エロ文化で世界に負けてられない!ということで、実際に作ってみました。彼女や彼氏を”自作”したい皆様に捧げますので、作り方をみていきましょう!

なお、より詳しくハイパーポルノについて知りたい方はこちらをご覧ください。

ハイパーポルノでAI彼女を実際に作ってみた

今回は、生成AIを使いこのような可愛いAI彼女を作りました!使ったサービスは以下の3つです。

- Stable Diffusion

- CoeFont

- Sad Talker

大まかなAI彼女の作り方は以下の通りです。

- Civit AIで作りたい画像を探す

- Stable Diffusionで画像を生成する

- Coe Fontで話させたい音声を作る

- Sad Talkerで、画像と音声を合成する

それでは詳しく見ていきましょう。

Civit AIで作りたい画像を探す

まず、Stable Diffusionを使う準備として、CivitAIで参考になる画像を探します。Civit AIは、Stable Diffusionで生成した画像やチェックポイントが共有されているサイトです。

アクセスすると、このように個人が作ったものを確認できます。

私はモデル(CheckpointやLoRA)を探してから作業するので、最初にModelsを検索するのがおすすめです。

画像を探すときは、Images を使うと良いでしょう。

ワクワクしながら探していると、こちらのチェックポイントが気になりました。刺激的な画像が多いので、周りをよく確認してからリンクを開いてください。

https://civitai.com/models/69158/meichidarkmix

その中でも、この画像が可愛かったため、プロンプトなどの生成に必要な情報を確認します。

これらは、Civit AIのサイト上で確認できるので、赤枠内にあるプロンプト(Prompt / Negative prompt)やサンプラー(Sampler)・サンプル回数(Steps)をメモしておきましょう。

ちなみに、このプロンプトは以下です。

a japanese woman walking in the city, buildings, plants ,smile, mixed korean,blur background,

focus, cinematic lighting, (((masterpiece))), ((best quality)), ((intricate detailed)), ((Hyperrealistic)),

absurd res, milf, mature woman, perspective, highly detailed, illustration, 1girl, (big breasts),

beautiful detailed eyes, short hair, dark hair, purple eyes, (casual outfit:1.2), jacket, turtle neck sweater,

skirt, black choker, earrings, high heels, detailed background, perfect eyes, seductive eyes, looking at the viewer,

from front <lora:odanon-lora-v1-128dim-4ep-novae:0.5>

Negative prompt: easynegative, badhandv4, (low quality, worst quality:1.4), poorly drawn hands, bad anatomy,

monochrome, { long body }, bad anatomy , liquid body, malformed, mutated, anatomical nonsense ,bad proportions,

uncoordinated body, unnatural body, disfigured, ugly, gross proportions ,mutation, disfigured, deformed, { mutation},

{poorlydrawn} , bad hand, mutated hand, bad fingers, mutated fingers, badhandv4 ,liquid tongue, long neck,

fused ears, bad ears, poorly drawn ears, extra ears, liquid ears, heavy ears, missing ears, fused animal ears,

bad animal ears, poorly drawn animal ears, extra animal ears, liquid animal ears, heavy animal ears,

missing animal ears, bad hairs, poorly drawn hairs, fused hairs, bad face, fused face, poorly drawn face,

cloned face, big face, long face, bad eyes, fused eyes poorly drawn eyes, extra eyes, bad mouth, fused mouth,

poorly drawn mouth, bad tongue, big mouth, bad perspective, bad objects placement

Steps: 40, Size: 512x768, Seed: 1168656867, Model: Only Meichi real, Version: v1.3.0, Sampler: DPM++ SDE Karras,

CFG scale: 7, Clip skip: 2, Model hash: c7f2cae17c, (monochrome: 1.1), Hires steps: 15, (bad-hands-5: 1.1),

lowres,(Bored pose), static pose, busty bad hands, lowers, long body, disfigured, ugly, cross eyed, squinting,

grain, Deformed, blurry, bad anatomy, poorly drawn face, mutation, mutated, extra limb, ugly, poorly drawn hands,

missing limb, floating limbs, disconnected limbs, malformed hands, blur, out of focus, long neck, disgusting,

poorly drawn, mutilated, ((text)), ((centered shot)), ((symetric pose)), ((symetric)), multiple views,

multiple panels, blurry, multiple panels, blurry, watermark, letterbox, text, easynegative, asian, loli, ,

child, childish", "(low quality: 1.4), Hires upscale: 2, (worst quality: 1.4), Hires upscaler: R-ESRGAN 4x+ Anime6B,

ADetailer model: face_yolov8n.pt, ADetailer prompt: "(((masterpiece))), (((best result))), (((best quality))),

ultra-detailed, beautiful eyes, beautiful face, smiling, blush, ", Noise multiplier: 0, ADetailer version: 23.7.1,

Denoising strength: 0.4, ADetailer mask blur: 4, (bad_prompt_version2: 0.8), ADetailer confidence: 0.3,

ADetailer dilate/erode: 32, ADetailer inpaint padding: 0, ADetailer denoising strength: 0.4,

ADetailer inpaint only masked: True, odanon-lora-v1-128dim-4ep-novae: dbbcb38d0ce9また、Stable Diffusionでチェックポイントを使うのでダウンロードします。このファイルは後続の作業のため、Google Driveに移動しました。

ほかにも、今回はBlueberrymixというチェックポイントをダウンロードしています。

https://civitai.com/models/14323/blueberrymix

また、ネガティブプロンプトで使うためのエンベディング用ファイルもダウンロードしましょう。

https://civitai.com/models/16993/badhandv4-animeillustdiffusion

これで、Stable Diffusionに入力する情報はゲットできました。次は、Stable Diffusionを立ち上げます。

Stable Diffusionで画像生成する

次に、Stable Diffusionを使って画像を生成しましょう。Stable Diffusionとは、ユーザーが入力したテキストをベースに自分好みの画像を生成できるサービスです。

Stable Diffusionを使うには、Google Colabを使いましょう。まずは、こちらのGoogle Colabにアクセスしてください。

https://colab.research.google.com/drive/1Ohn8R6UKvAq1w-tDaiTun3PzIoTJl_Z2?hl=ja

まずは、Web UI を使うためにこちらのリポジトリをクローンします。

!git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

%cd /content/stable-diffusion-webui次に、先ほどダウンロードしたチェックポイントをGoogle Driveに移動させるために以下を実行します。

from google.colab import drive

drive.mount('/content/drive')チェックポイントは、stable-diffusion-webui/models/Stable-diffusion/ というディレクトリに置く必要があります。そのため、Google Driveから、cp コマンドを使ってコピーします。(一例であるため、ご自身の環境に合わせてコマンドを変更ください。)

!cp /content/drive/MyDrive/stablediffusion/xxmix9realisticsdxl_testV20.safetensors /content/stable-diffusion-webui/models/Stable-diffusion/

!cp /content/drive/MyDrive/stablediffusion/chilloutrealistic_v21.safetensors /content/stable-diffusion-webui/models/Stable-diffusion/

!cp /content/drive/MyDrive/stablediffusion/meichidarkMix_meichidarkV45.safetensors /content/stable-diffusion-webui/models/Stable-diffusion/次は、エンべディング用のファイルです。

こちらは、/content/stable-diffusion-webui/embeddings/ にコピーします。

!cp /content/drive/MyDrive/stablediffusion/embedding/* /content/stable-diffusion-webui/embeddings/それぞれ終わったら、Web UIを立ち上げるために以下のコマンドを実行しましょう。

!python launch.py --share --xformers --enable-insecure-extension-accessしばらく時間が経つと、以下のようなURLが出力されます。

クリックすると、このようにWeb UIが立ち上がりました。

先ほどのチェックポイントもしっかり読み込まれていますね!

エンベディング用ファイルの読み込みも確認できました。

このあとは、プロンプトを入力します。まずは、プロンプトはこちら。

a japanese woman walking in the city, buildings, plants ,smile, mixed korean,blur background , focus,

cinematic lighting,(((masterpiece))), ((best quality)), ((intricate detailed)), ((Hyperrealistic)),

absurd res, milf, mature woman, perspective, highly detailed, illustration, 1girl, (big breasts),

beautiful detailed eyes, short hair, dark hair, purple eyes, (casual outfit:1.2), jacket, turtle neck sweater,

skirt, black choker, earrings, high heels, detailed background, perfect eyes, seductive eyes, looking at the viewer,

from frontちなみに、<lora:odanon-lora-v1-128dim-4ep-novae:0.5> という部分は、特定のLoRAでしかプロンプトが効かないので削除しています。また、「()」を使っているのは、重みづけのためです。

このプロンプトだと、(((masterpiece)))をものすごく強調していることになります。先ほどのプロンプトを以下のように貼り付けます。

次は、ネガティブプロンプトを入力します。

badhandv4, (low quality, worst quality:1.4), poorly drawn hands, bad anatomy, monochrome, { long body },

bad anatomy , liquid body, malformed, mutated, anatomical nonsense ,bad proportions, uncoordinated body,

unnatural body, disfigured, ugly, gross proportions ,mutation, disfigured, deformed, { mutation}, {poorlydrawn} ,

bad hand, mutated hand, bad fingers, mutated finger, liquid tongue, long neck, fused ears, bad ears,

poorly drawn ears, extra ears, liquid ears, heavy ears, missing ears, fused animal ears, bad animal ears,

poorly drawn animal ears, extra animal ears, liquid animal ears, heavy animal ears, missing animal ears,

bad hairs, poorly drawn hairs, fused hairs, bad face, fused face, poorly drawn face, cloned face, big face,

long face, bad eyes, fused eyes poorly drawn eyes, extra eyes, bad mouth, fused mouth, poorly drawn mouth,

bad tongue, big mouth, bad perspective, bad objects placementネガティブプロンプトに、badhand-v4というものがあります。これは指が不自然なものにならないように書くものです。先ほどダウンロードしたエンベディング用ファイルがあれば効果を発揮するプロンプトであり、アウトプットに悪影響なので注意しましょう。

そして、このように貼り付けてください。

ちなみに、これが「badhand ってネガティブプロンプトでも手が一向に直らない」と思いながら作った画像です!

プロンプトは一度しっかり目を通して、何を書いているか理解しないとだめですね!そのほかにも、パラメータを以下のように設定しGenerateをクリックしましょう。

- サンプリング回数(Steps):40

- サンプル方法(Sampler):DPM++ SDE Karras

- シード値(Seed):-1

すると、以下のように画像が作られます。

ちなみに、この画像を作るまで、色々試しました。一発でうまく生成するのは難しいと思います。私がやったこととしては、以下です。

- シード値を−1のままたくさん作る

- ある程度可愛いものができたらシード値を固定する。すると、画像の大枠はそのままに調整ができる

- 調整のためにCFG scale(プロンプトへの誠実さ)やsample stepsを少しずつ変更する

例えば、ネガティブプロンプトが効いておらず目がおかしい画像が出力されたとします。

このような画像を、微調整しようとするのは個人的に難しかったです。最初から、出来栄えがいいものを整える方が作業効率はいいように感じました。

いい画像が作れるまで、色々試してみましょう!荒技にはなりますが、ときどきチェックポイントを変更するのもおすすめです!偶然いいものができるので、好奇心も大事だと思います。

Coe Fontで話させたい音声を作る

次に、Coe Fontで話させたい音声を作りましょう。「AIひろゆき」で有名なCoe Fontとは、AI音声の生成ができるサービスです。

https://coefont.cloud/coefonts

まずは、ログインします。次に、作品を新規作成をクリック。

様々な音声があるので、使いたい音声を選んで、完了をクリックします。

その後、喋ってもらいたい言葉を入力すると完成します。今回は、「五等分の花嫁」という作品から「あんたを好きって言ったのよ」というセリフをお借りしました。

何もしないでただ入力しただけの音声がこちらです。デフォルトのままだと嫌だったので、「、」や音程・話すスピードなどを調整して完成。

では、先ほどの画像と音声を合成しましょう。

Sad Talkerで、画像と音声を合成する。

画像と音声の合成には、Sad Talker を使いましょう。Sad Talkerとは、画像と音声から会話するムービーを作成できるサービスです。

https://huggingface.co/spaces/vinthony/SadTalker

まずは、上記のページをクリックして画像と音声ファイルを入れ、「Generate」をクリックしてください。

するとこのようにリップシンクした動画が出てきます!ちなみに、このHugging Face Spaceで作ることもできますが、「Too busy」と出てアプリが動かない場合もあるので注意してください。

そんな時は、以下のレポジトリをクローンしてプログラムを書く方法を試してみましょう。

https://github.com/OpenTalker/SadTalker

私はLinux環境を使ったので、まずは以下のコマンドを実行しました。

git clone https://github.com/OpenTalker/SadTalker.git

cd SadTalker

conda create -n sadtalker python=3.8

conda activate sadtalker

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

conda install ffmpeg

pip install -r requirements.txtそのあとは、モデルをダウンロードするために、以下のコマンドを実行しています。

bash scripts/download_models.sh最後に、Hugging Faceで動かしていたアプリをローカルで動かす場合は、以下のコマンドを実行してください。

python app_sadtalker.pyもしくは、コマンドの実行だけで作りたい場合は、以下の文法に沿ったものを実行します。

python3.8 inference.py --driven_audio <audio.wav> \

--source_image <video.mp4 or picture.png> \

--enhancer gfpgan私は以下のコマンドで試しましたので、よければご参考になさってください。

python3.8 inference.py --driven_audio ./examples/driven_audio/RD_Radio31_000.wav \

--source_image ./examples/source_image/full13.png \

--result_dir ./results --still --preprocess full --enhancer gfpganまた、Sad talkerの開発元が公開しているGoogle Colabファイルはうまく動きませんでした。ちゃんと動くGoogle Colabファイルを作って後日共有しますので、お待ちください。

以上で、ハイパーポルノ実行編を終了します。皆様、ぜひAI彼女を作ってみてください!!

なお、Stable LMについて知りたい方はこちらをご覧ください。

生成AI時代のハイパーポルノで理想のAI彼女を作ろう!

ハイパーポルノとは生成AI時代の新しいポルノであり、顔や体・声などを自分好みに設定してAI彼女を作れます。

今回は以下の手順で理想のAI彼女を作ってみました。

- Civit AIで作りたい画像を探す

- Stable Diffusionで画像生成する

- Coe Fontで話させたい音声を作る

- Sad Talkerで、画像と音声を合成する

ぜひ自分でも作り方を試してみて、ハイパーポルノでAI彼女を作成しましょう!

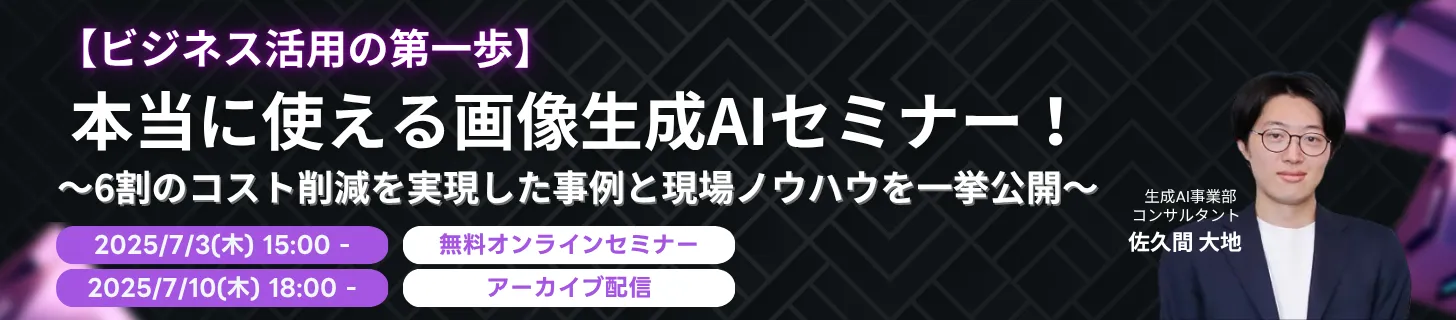

生成系AIの業務活用なら!

・生成系AIを活用したPoC開発

・生成系AIのコンサルティング

・システム間API連携

最後に

いかがだったでしょうか?

ChatGPTやStable Diffusionなど使い勝手の良いAIサービスは沢山あります。1度使ってみて、もっとこうしたい、こう言った使い方をしたいと言った方に向けてカスタマイズを勧めております。

もし、自社で生成AIを活用したいという場合は

1. 汎用的な生成AIツールを導入し、定着させる

2. 業務を生成AIに解けるタスクまで分解し、自動化する

のどちらかが良いと思います。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。