【創作の常識を変える】Stable Diffusion XL(SDXL)とは?導入方法や使い方を徹底解説

- プロンプトの理解力が向上し、意図通りの画像を生成可能

- 従来のモデルと比べて2倍以上のパラメーター数で複雑なタスクに対応

- 繊細なライティングやシャドウ表現でリアルな仕上がりに

みなさんは、Stable Diffusion XL(SDXL)についてご存知でしょうか?Stable Diffusion XLとは、Stability AI社が開発した画像生成AIで、SDXLとも略されています。

旧モデルに比べて出力精度や解像度が大きく進化し、商用利用やアニメ・イラスト制作にも活用可能です。本記事では、SDXLの特徴・旧モデルとの違い・導入方法・使い方・注意点を分かりやすく解説します。

最後までご覧いただくと、自分の環境でSDXLを活用できるようになります。

\生成AIを活用して業務プロセスを自動化/

Stable Diffusion XLとは

Stable Diffusion XL(SDXL)とは、Stability AI社が2023年にリリースした高性能な画像生成AIモデルです。従来のStable Diffusionシリーズに比べて、プロンプトの解釈力や出力精度が大きく進化しており、複雑な構図や自然なライティング・シャドウ表現にも対応できます。色彩や質感の再現度も高く、フォトリアルな表現からアートスタイルまで幅広い生成が可能です。

また、SDXLはパラメータ数が旧モデルの2倍以上に増加しており、より豊かな表現力を実現しています。生成可能な画像サイズも最大1,024×1,024ピクセルまで拡大され、高解像度の出力に対応しています。推奨環境としては8GB以上のVRAMを備えたGPUが望ましく、大規模モデルを快適に動かすためには12GB以上が推奨です。

オープンソースで提供されているため、研究利用から商用利用まで幅広く活用できるのも大きな特徴です。

なお、Stable Diffusionについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusion XLと旧モデル(Stable Diffusion 1.5・2.1)との違い

Stable Diffusion XLと旧モデルのStable Diffusion 1.5との違いをまとめました。

- 複雑な構図で画像生成が可能

- パラメータ数が従来のモデルの2倍以上

- 出力精度が上がった

- 最大1,024×1,024の画像が生成可能

特に、画像の出力精度や画質が向上している点が大きな違いです。Stable Diffusion XLの特徴を詳しく解説していくので、ぜひ参考にしてみてください。

実は、Stable Diffusion XLの登場以降も、より高速・高精度な生成を目的とした新モデルが登場しています。

- SDXL Turbo(少ないステップ数でも高品質な画像生成が可能)

- Stable Diffusion 3.5(より高解像度・大規模パラメータを採用)

ただし、現時点では「対応ツールの多さ」「カスタムモデルの充実度」という点で、Stable Diffusion XLは依然として実用性の高い主力モデルといえます。

複雑な構図や背景表現が可能に

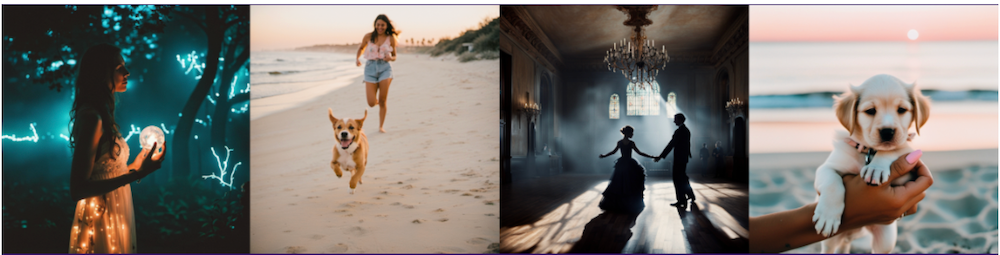

Stable Diffusion XLは、旧モデルと比較して、複雑な構図での画像生成が可能になりました。手やテキストを綺麗に表現できるほか、上記画像の犬を追いかける女性といった空間的に配置された構図を表現できるのが特徴です。

画像モデルがレンダリングしにくかった概念を生成できるようになったので、画像生成の幅が広がっています。

パラメータ数は旧モデル比で2倍以上に増加

Stable Diffusion XLは、旧モデルのStable Diffusion 1.5と比較してパラメータ数が2倍以上になっています。パラメータ数とは機械学習モデルが学習中に最適化する変数の数を表しており、数値が大きいほど複雑なタスクを高精度でこなせます。

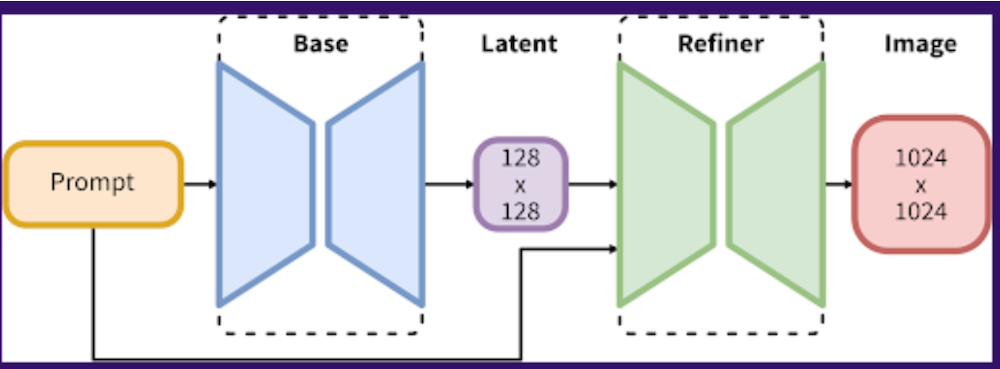

なお、Stable Diffusion XLは、3.5BのBaseモデルと6.6BのRefinerモデルの2種類で構成されているのが特徴です。Baseモデルが潜在情報を生成したあと、Refinerモデルがノイズ除去を実行して効率よく画像を生成できます。

プロンプト理解力の向上

Stable Diffusion XLでは、入力したプロンプトの理解力が大幅に向上しました。旧モデルでは複雑な指示や長文プロンプトを使うと意図通りに反映されにくいことがありましたが、SDXLでは細かなニュアンスまで反映されやすくなっています。

たとえば「夕暮れの街並みを背景にした人物イラスト」といった複合的な要素も正確に組み合わせて描写できるため、クリエイターのイメージにより近い画像生成が可能になりました。

テキスト生成精度の改善(文字が読める画像)

Stable Diffusion XLでは、画像内に表示されるテキストの精度が大幅に改善されています。旧モデルでは英数字や単語が崩れたり、意味のない文字列になることが多く、ポスターやロゴ風デザインには不向きでした。

SDXLでは文字の形状が安定し、シンプルな単語や短いフレーズであれば読み取れるレベルの画像を生成できます。これにより、広告風のビジュアルや同人誌の表紙デザインなど、文字要素を含む用途にも活用の幅が広がりました。

出力精度が上がった

Stable Diffusion XLは、短いプロンプトからでも高画質画像の出力が可能になりました。単語を詳しく説明する修飾語を使わずとも、ユーザーの意図を理解した画像を作成できます。

「The Red Square」と「(a) red square」のように、概念の違いも理解できるようになったので、画像生成の利便性も向上しています。

最大1,024×1,024の画像が生成可能

Stable Diffusion XLでは、最大1,024×1,024の解像度で画像を生成できます。旧モデルのStable Diffusion 1.5が最大512×512だったため、2倍の大きさになりました。

画像サイズのアップに伴い、コントラスト・ライティング・シャドウなどの表現も向上しているので、色彩豊かで美しい画像を作成できるようになっています。

Stable Diffusion XLの導入方法

Stable Diffusion XLの導入手順を以下にまとめました。

- Stable Diffusion Web UIをインストール

- 必要なファイルをダウンロード

- ファイルを適切な場所に格納

- Stable Diffusion Web UIを起動してモデルを切り替え

導入するまでの手順が複雑ですが、以下で詳しく解説していくので、参考にしてみてください。

Stable Diffusion Web UIをインストール

まずは、Stable Diffusion Web UIをインストールします。すでにローカルPCにインストール済みの方は、この手順を飛ばして問題ありません。

Stable Diffusion Web UIをインストールする際は、PythonやGitなどの必要なファイルをいくつもダウンロードする必要があります。

インストール方法について詳しくは以下の記事をご覧ください。

必要なファイルをダウンロード

Stable Diffusion XLを導入するには、Baseモデル・Refinerモデル・VAEの3つのファイルをダウンロードする必要があります。

RefinerモデルとVAEはダウンロードしなくてもStable Diffusion XLを使えますが、生成画像を高画質化させる重要な役割を担っているのでダウンロード推奨です。

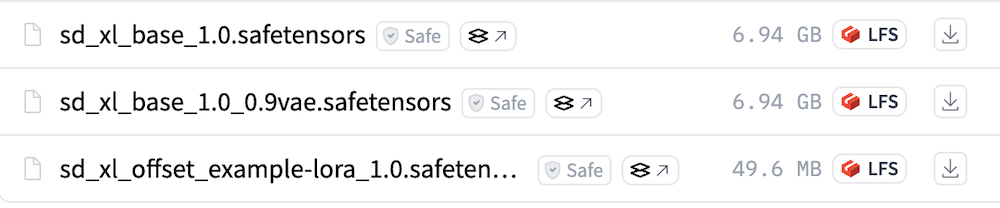

まずは、Hugging FaceからBaseモデルのダウンロードページにアクセスしてください。

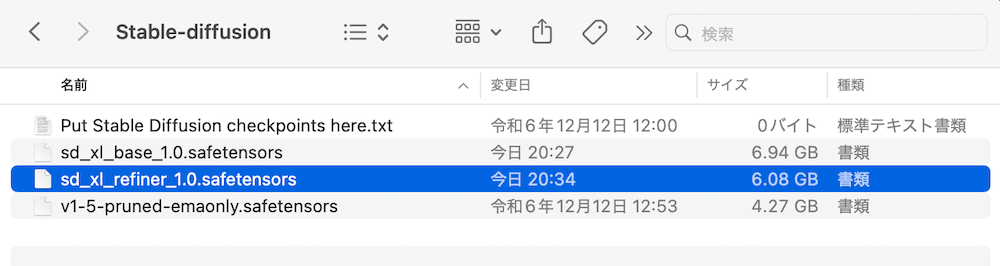

上記画像のうち、1番上の「sd_xl_base_1.0.safetensors」をダウンロードします。

次はRefinerモデルをダウンロードします。

Hugging FaceのRefinerモデルのダウンロードページにアクセスして、上記画像にもある「sd_xl_refiner_1.0.safetensors」をダウンロードします。

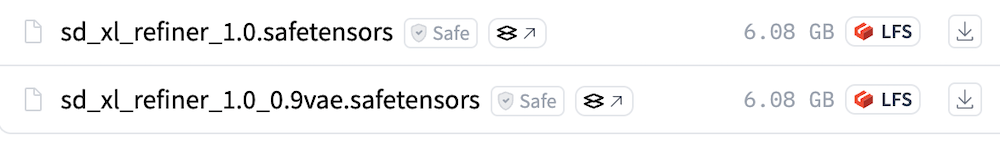

最後にVAEです。

Hugging FaceのVAEのダウンロードページにアクセスして、上記画像にもある「sdxl_vae.safetensors」をダウンロードします。

これで必要なファイルのダウンロードは完了です。

ファイルを適切な場所に格納

ダウンロードしたBaseモデル・Refinerモデル・VAEの3つをそれぞれ適切な場所に格納します。

- BaseモデルとRefinerモデル:「stable-diffusion-webui」→「models」→「Stable-diffusion」

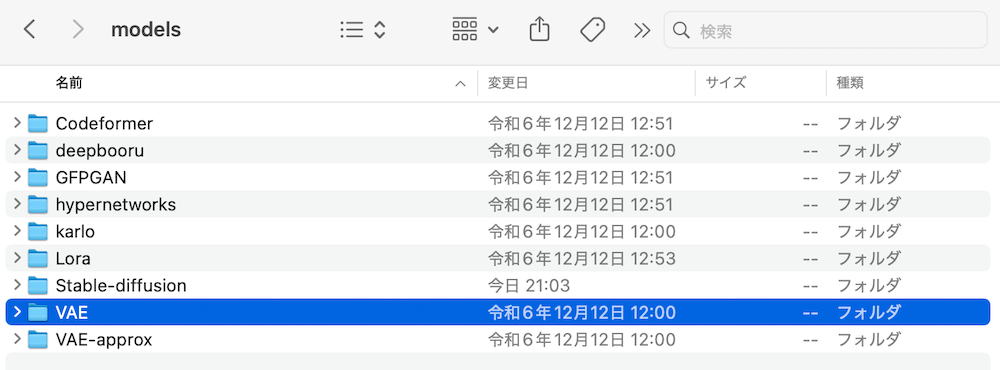

- VAE:「stable-diffusion-webui」→「models」→「VAE」

筆者はMacを使用しているので、Macの手順を解説します。

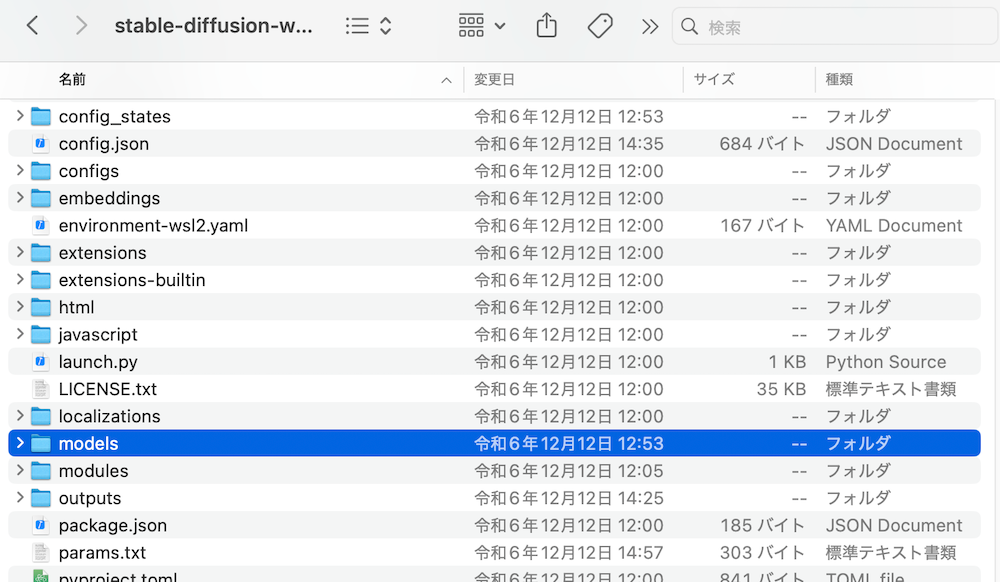

まずはFinderを開いて、「stable-diffusion-webui」のファイルを検索して見つけ出します。

検索しても出てこない場合は、Stable Diffusion Web UIをインストールできていないので、「Stable Diffusion Web UIをインストール」の手順に戻ってください。

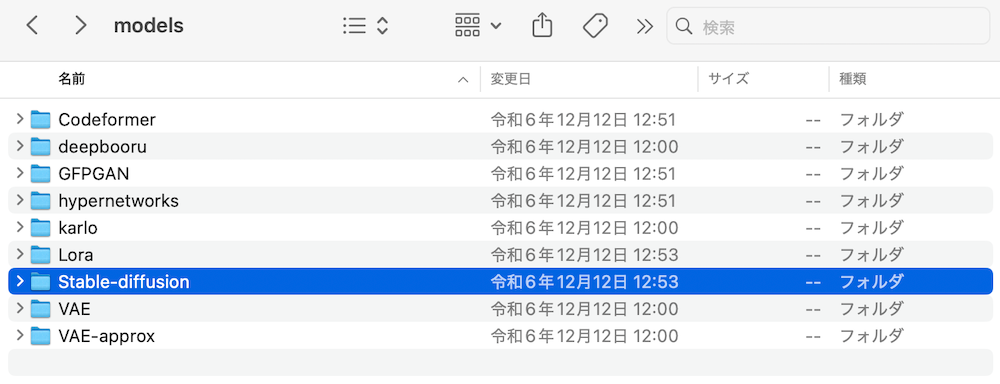

「stable-diffusion-webui」→「models」の順に開きます。

「models」→「Stable-diffusion」の順に開いたら、ここにBaseモデルとRefinerモデルのファイルを格納してください。

VAEも同じ要領で「models」→「VAE」に格納します。

これでファイルの格納は完了です。

Stable Diffusion Web UIを起動してモデルを切り替え

Macの場合はターミナルで以下のコマンドを実行して、Stable Diffusion Web UIを起動します。

bash stable-diffusion-webui/webui.sh

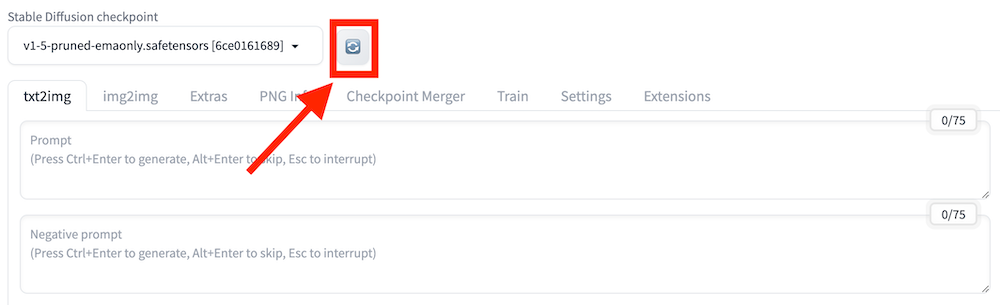

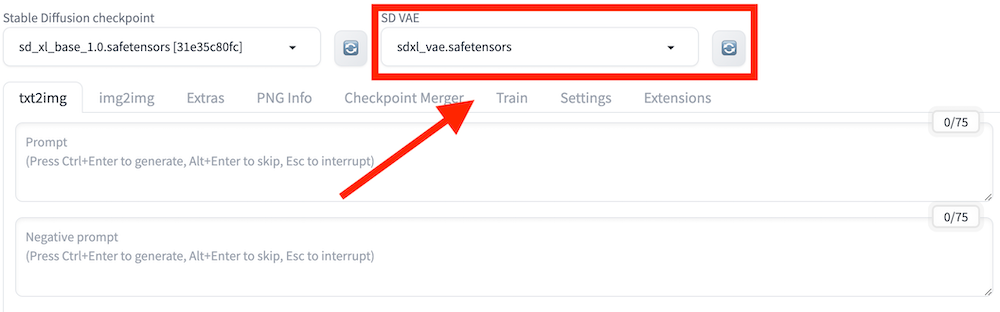

起動後は上記の更新ボタンを押したあと、ダウンロードした「sd_xl_base_1.0.safetensors」を選択してモデルを切り替えてください。

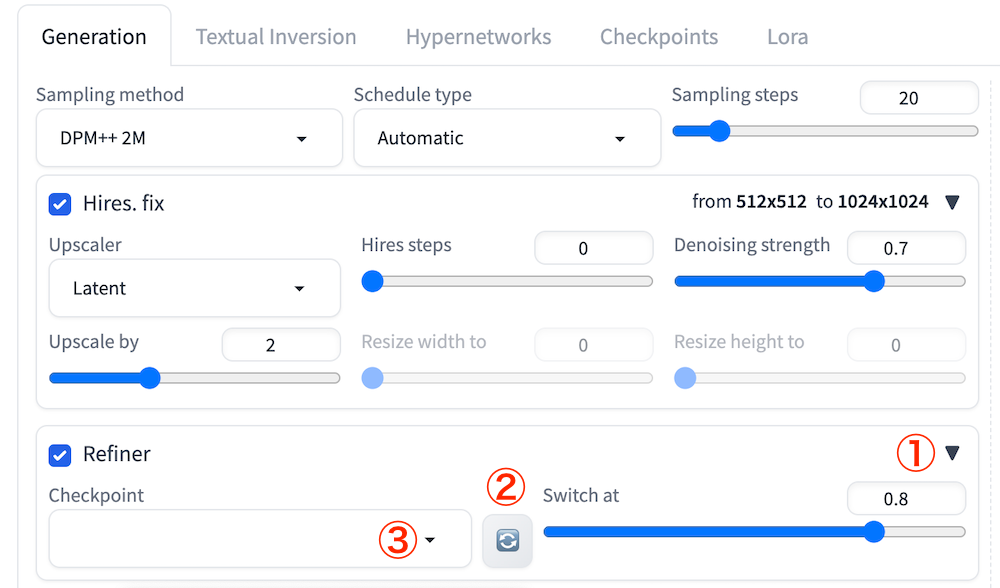

続いて、「txt2img」タブの下部にある「Refiner」横の三角アイコンをクリックします。

「Checkpoint」の更新ボタンを押してから、プルダウン内で「sd_xl_refiner_1.0.safetensors」を選択してください。

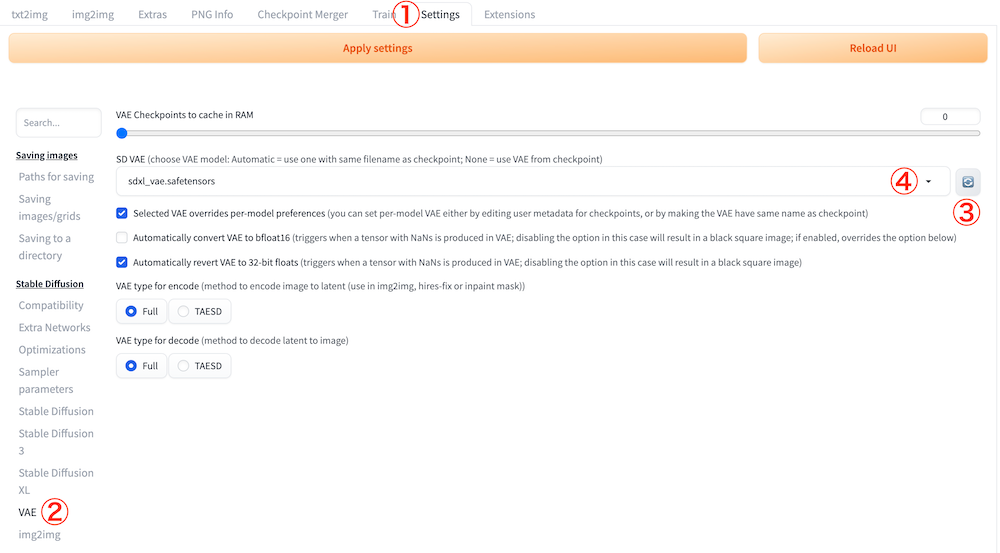

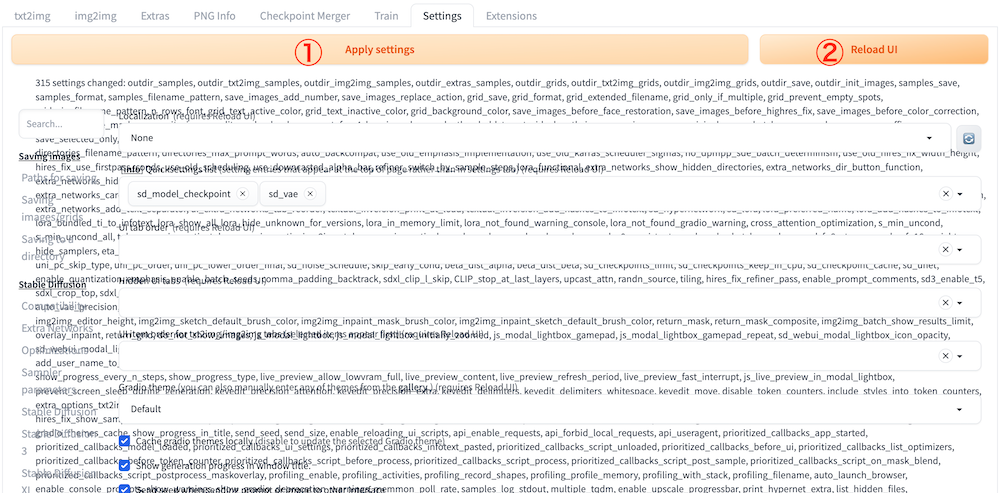

次は「Settings」タブを開いたあと、サイドバーの「VAE」を開きます。その後、「SD VAE」から「sdxl_vae.safetensors」を選択してください。

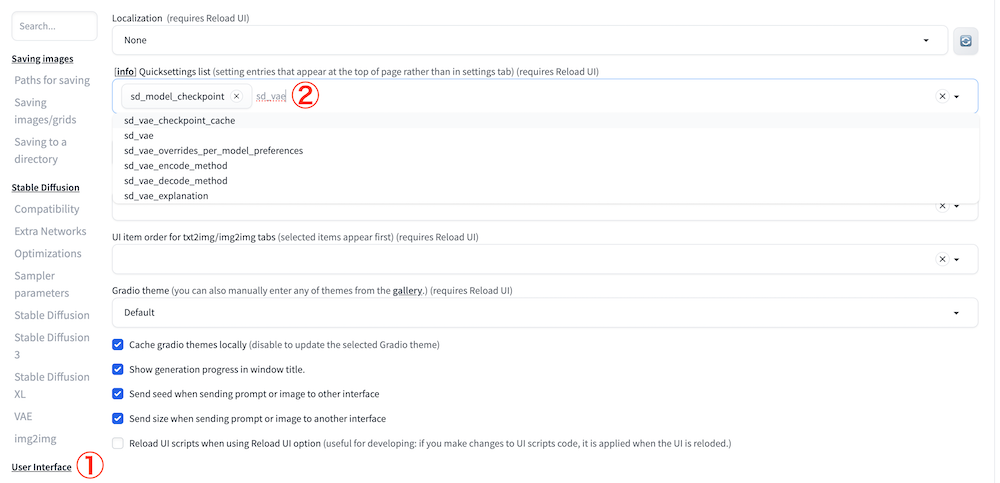

サイドバーの「User interface」を開きます。

上記画像の②の場所にカーソルを合わせて「sd_vae」と入力して、候補に出てくる「sd_vae」をクリックしてください。

次は「Apply Settings」をクリックして設定内容を保存したあと、「Reload UI」をクリックしてWeb UIをリロードします。

「Apply Settings」をクリックしたあとに一瞬表示がおかしくなりましたが、「Reload UI」でリロードしたあとは解決しました。

リロード後の画面上部に「SD VAE」が追加されていれば、Stable Diffusion XLを導入する一連の作業は完了です。

なお、Stable Diffusionのプロンプト例やテンプレ集について詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusion XLを使って画像を生成してみた

実際にStable Diffusion XLを使って、画像を生成してみました。まずは、以下のシンプルなプロンプトを入れてみます。

Beautiful girl in white dress.(白いドレスを着た美少女)ネガティブプロンプトには「low quality(低い画質)」を入れてみました。

生成された画像がこちらです。

仕上がりはだいぶ微妙ですね…。頭の上に変な物体がありますし、目の表現も綺麗ではありません。今度はノイズの除去回数を示す「Sampling steps」を22に上げてみました。

プロンプトをしっかり把握できており、人物も綺麗な見た目になりましたね。

このように同じプロンプトでも設定をいじるだけで画像の出力精度が変わってきます。まだまだ改善の余地があるので、実際にStable Diffusion XLを利用する際は、色々な設定を試してみてください。

Stable Diffusion XLの活用事例

Stable Diffusion XLは、ただ高精度な画像を作れるだけでなく、使い方の自由度が高いのも魅力です。X(旧Twitter)では、イラスト風の作品から写真のようなリアルな画像、複雑なワークフローの共有まで、多くのユーザーが活用方法を発信しています。ここでは、実際に投稿された事例をいくつか紹介します。

4コマ漫画の自動生成:思い通りの仕上がりに驚きの声

こちらの投稿では、4コマ漫画を自動で作っています。

使われたのはStable Diffusion XLと「Nano Banana Pro」という画像編集ツール。吹き出しの配置やセリフの日本語も自然で、投稿者は「ほとんど思った通りにできた」とコメントしています。手間をかけずに形になるので、気軽に作品づくりを楽しみたい人にとって、参考になる内容です。

写真のようなリアル画像が手軽に作れる新ツールセット

別の投稿では、13種類の新しい写真用ツールセットが紹介されていました。

これを使うと、まるでプロのカメラマンが撮影したようなリアルな画像が生成できるとのことです。細かいプロンプトを工夫しなくても、それなりに自然な仕上がりになるのがポイント。特に初心者には嬉しい機能で、「リアル画像が簡単に作れる」といった声も見られました。

独創的な表現スタイル

この投稿では、Stable Diffusion XLを使った画像をRedditで共有していました。

使われているのはComfyUIというツールで、安定した出力と柔軟な設定が特徴です。生成された画像はどれも個性的で、海外のアーティストのような雰囲気を感じさせます。リアルな写真表現よりも、独自の世界観や芸術性を重視したい人に特に人気があるようです。

SDXLの持つ高い表現力と自由度が活かされており、創作ツールとしての奥深さを感じます。

広告・SNSクリエイティブの背景差し替えを自動化

Shopifyが公開したSDXLの背景置換デモは、商品や人物写真をそのままに、プロンプト指定だけで背景を差し替えられる点が注目されています。

撮影コストを抑えつつ、季節・地域・世界観に合わせた広告用ビジュアルを量産できるため、ECやSNS広告との相性は抜群です。

一方で、最終的なブランド表現の統一や不自然な合成のチェックは人が行い、商用利用時は権利・媒体ポリシーの確認が欠かせません。

プレゼン資料用のイラスト作成

SDXLは特定の人物像や映画キャラクターの特徴を捉えやすくしており、プレゼン資料用のイメージ作成にも活用できます。

例えば「Doc風」のキャラクターを使えば、専門的な内容でも親しみやすく伝えることが可能です。

文章だけでは伝わりにくい概念を補足するビジュアルを短時間で用意できる点は大きな利点ですが、著作権やキャラクター利用の可否を確認し、あくまで説明補助として使う配慮が求められます。

ゲーム・ノベル作品の世界観とビジュアル制作に活用

SDXLは、ノベルゲームやインディーゲーム制作において、世界観構築やビジュアル素材の生成に大きな力を発揮します。

こちらの投稿のように、ChatGPTやDALL·E 3、SDXLなど複数の生成AIを組み合わせることで、背景ビジュアルやキャラクターイメージを効率よく用意でき、少人数でも表現力の高い作品制作が可能になります。

最終的なアートの統一感や権利面の確認は人の判断が欠かせませんが、試作やコンセプト設計段階での活用価値は高いと言えるでしょう。

用途別におすすめのStable Diffusion XLモデル

| 項目 | AAM XL | Juggernaut XL | Hyper-SDXL |

|---|---|---|---|

| 得意ジャンル | アニメ・イラスト | フォトリアル〜汎用 | 軽量・高速生成向き |

| 推奨スペック目安 | VRAM 8GB以上(12GB推奨) | VRAM 8〜12GB | VRAM 6〜8GBでも比較的動かしやすい |

| 学習ベース・特徴 | SDXL派生・アニメ調に最適化 | SDXL派生・バランス型で安定性が高い | 高速生成向けに調整されたSDXL系モデル |

Stable Diffusion XLには用途や作風に特化した派生モデルが多数存在し、目的に合ったモデルを選ぶことで生成品質と作業効率を大きく高められます。

ここでは、特に利用者が多く実用性の高いSDXLモデルを用途別に紹介します。

アニメ・イラストなら「AAM XL」

AAM XLは、アニメ調・イラスト表現に特化したStable Diffusion XL系モデルで、キャラクターデザインやイラスト制作を目的とするユーザーから高い評価を得ています。

線の輪郭が安定しており、色使いも鮮やかなため、日本のアニメやライトノベル風のビジュアルと相性が良いのが特徴です。

向いているシーン

- 同人誌・イラスト集用のキャラクターイラスト制作

- SNS(X / Instagram)向けのアニメ調ビジュアル投稿

- ゲームやVTuber用の立ち絵・キービジュアル作成

プロンプト例

anime style illustration, young female character, colorful hair, detailed eyes, soft lighting, clean line art, high quality写真・汎用用途なら「Juggernaut XL」

Juggernaut XLは、フォトリアルな人物写真からイラスト寄りの表現まで幅広く対応できる、汎用性の高いSDXLモデルです。

人物の質感や光の表現が自然で、広告用ビジュアルやWebサイトのメイン画像など、実写寄りの表現を求める用途に適しています。

向いているシーン

- WebサイトやLP用の人物・背景ビジュアル作成

- 広告・バナー・SNSクリエイティブの素材生成

- プレゼン資料や企画書用のリアル寄りイメージ作成

プロンプト例

photorealistic portrait of a young woman, natural skin texture, soft daylight, shallow depth of field, high detail, 35mm photography軽量・高速重視なら「Hyper-SDXL」

Hyper-SDXLは、生成速度と軽量性を重視して設計されたSDXL派生モデルで、GPU性能に余裕がない環境でも比較的快適に動作するのが特徴です。

ステップ数を少なくしても破綻しにくく、ラフ案やアイデア出しを短時間で行いたい場面に適しています。

向いているシーン

- デザインラフや構図検討用の高速アウトプット

- アイデア出し・ブレインストーミング用途

- GPU性能が限られた環境での試作・検証

プロンプト例

concept art, futuristic cityscape, wide angle, dynamic composition, simple lighting, high contrastStable Diffusion XL対応ツール・サービス一覧

Stable Diffusion XLは、さまざまなツールやクラウドサービスで利用可能です。ローカルでじっくり使いたい人から、クラウドで手軽に試したい人まで、目的に合った使い方が選べます。

以下に、SDXLに対応している主要ツール・サービスを、用途別にまとめました。

ローカルGUIツール(PCにインストールして使う)

| 名称 | SDXL対応 | 日本語対応 | 商用利用可否の目安 |

|---|---|---|---|

| AUTOMATIC1111 Web UI | ◯ | △(UIは英語) | ◯ |

| ComfyUI | ◯ | △ | ◯ |

| InvokeAI | ◯ | △ | ◯ |

| Fooocus | ◯ | △ | ◯ |

ローカルGUIはカスタマイズ性が高く、LoRAやControlNetなど高度な機能を自由に使えるのが強みです。業務利用では、社内環境で完結できる点がセキュリティ面でも評価されています。

クラウドサービス(ブラウザで利用)

| 名称 | SDXL対応 | 日本語対応 | 商用利用可否の目安 |

|---|---|---|---|

| DreamStudio | ◯ | △ | ◯ |

| Leonardo.ai | ◯ | △ | ◯(プランにより制限あり) |

| Mage.space | ◯ | △ | ◯ |

| ClipDrop | ◯(SDXL Turbo含む) | △ | ◯ |

クラウド型はGPU環境を用意せずに試せるのが利点です。一方で、生成回数や解像度に制限がある場合が多く、業務で使う際は利用規約やデータの取り扱い条件を必ず確認しましょう。

モバイルアプリ(スマホ・タブレット)

| 名称 | SDXL対応 | 日本語対応 | 商用利用可否の目安 |

|---|---|---|---|

| Draw Things(iOS) | ◯ | △ | ◯ |

| Stable Diffusion AI | ◯ | △ | ◯ |

モバイルアプリは手軽に試せる反面、解像度や拡張機能に制限があります。ラフ作成や簡易生成向けと割り切るのが現実的です。

Stable Diffusion XLは、使う環境によって性能や操作感が大きく変わります。

- 自分のPCで細かく調整したい人は ComfyUIやWeb UI

- PCスペックに不安がある人は Google ColabやHugging Face

- インストールなしで使いたい人は DreamStudio、Mage.space

- スマホで画像生成したい人はDraw Things

Stable Diffusion XLを利用する際の注意点とトラブル対策

Stable Diffusion XLを利用する際には、高精度で便利な反面、初心者がつまずきやすいポイントも存在します。特に次の4点には注意が必要です。

- 初心者がつまずきやすい導入の壁

- GPUメモリ不足エラーと対処法

- 商用利用・著作権の注意点

- 動作が重いときの改善策

これらを理解しておくことで、トラブルを未然に防ぎ、安定してSDXLを活用できるようになります。

初心者がつまずきやすい導入の壁

Stable Diffusion XLを導入するには、WebUIの環境構築やモデルファイルの配置が必要です。初心者にとっては少し複雑で、手順を誤ると正常に起動しないケースもあります。

公式手順や当記事で紹介している情報を参考にしながら、一つひとつ確実に進めるのがポイントです。

GPUメモリ不足エラーと対処法

Stable Diffusion XLは高度な画像を生成できる分、GPUメモリの消費量が激しいです。GPUが搭載されていないPCでも動作はしますが、画像生成に多くの時間がかかります。

PCのスペック的にローカル環境へのインストールが厳しい場合は、Google Colab上で利用するか、DreamStudioなどのオンライン上で利用する方法を検討してみてください。

SDXLは高精度な分、GPUメモリを大量に消費します。特にVRAMが8GB未満の環境では「out of memory」エラーが発生することがあります。

解像度を下げたり、バッチサイズを小さくすることで改善でき、クラウドGPUの活用も有効な手段です。

商用利用・著作権の注意点

Stable Diffusion XLはCreativeML OpenRAIL++-M ライセンスのもとで公開されており、生成画像の商用利用自体は原則可能です。ただし、利用にあたってはいくつか重要な注意点があります。

- 禁止用途の遵守が必須

- 版権キャラクター・著名人の扱いに注意

- 生成画像の権利は原則ユーザー側

- モデル再配布・有料提供は別途条件あり

企業・業務利用では、公式ライセンス文書の確認に加え、社内規程・取引先ガイドライン・広告媒体のポリシーも併せてチェックしたうえで運用することが重要です。

動作が重いときの改善策

| 対策内容 | 効果 | おすすめ設定 |

|---|---|---|

| 画像解像度を下げる | VRAM消費を大幅に削減、生成速度向上 | まずは768×768、厳しければ 512×512 |

| バッチサイズを減らす | メモリ負荷を軽減し安定性向上 | Batch sizeは「1」固定が基本 |

| Refinerモデルをオフにする | VRAM・処理負荷を削減 | 低VRAM環境ではRefiner無効 |

| ステップ数を減らす | 生成時間を短縮 | 通常20〜30 steps、高速モデルは10前後 |

| 軽量化モデルを使用する(SDXL Turbo / Lightning) | 高速生成・低メモリ化 | ラフ出し・量産用途で活用 |

| サンプラーを変更する | 生成速度の改善 | 高速重視ならEuler / Euler a |

| CFG Scaleを下げる | 計算負荷を軽減 | SDXLでは5〜7が目安 |

| xFormers / 最適化オプションを有効化 | VRAM使用量削減 | AUTOMATIC1111でxFormers有効 |

| ControlNet・LoRAを外す | VRAM消費を大きく削減 | ラフ生成時はOFF、本生成のみON |

| GPU使用状況を整理する | 突然のメモリ不足を防止 | Chrome・OBSなど常駐アプリ停止 |

| クラウドGPUを利用する | ローカル制限を回避 | Google Colab 等を用途別に併用 |

SDXLは旧モデルに比べて動作が重くなる傾向があります。生成時間が長い場合は、解像度の調整やRefinerモデルをオフにする、軽量化モデルを選択するなどの工夫で改善可能です。

さらに、バッチサイズを小さくすることでVRAMの負荷を軽減できます。加えて、クラウドGPUサービスを活用すれば、ローカル環境よりも快適に動作させることができます。

Stable Diffusion XLは無料でも使える?有料版との違いは?

Stable Diffusion XLは、基本的には無料で使えるオープンソースの画像生成AIです。ただし、使い方や使うサービスによってはお金がかかる場合もあります。例えば、「DreamStudio」というサイトでは、最初に少しだけ無料で使える枠がありますが、それを超えるとクレジットを購入して使う仕組みです。

Stable Diffusion XLに関するよくある質問

なお、Stable Diffusionが使えるWebアプリについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusion XLで高精度な画像生成にチャレンジしよう

Stable Diffusion XLは、プロンプトの理解力や出力する画像の精度が向上しているので、ユーザーニーズに沿った綺麗な画像を出力できます。

特に、旧モデルと比較して、以下の点が大きく異なるのが特徴です。

- 複雑な構図で画像生成が可能

- パラメーター数が従来のモデルの2倍以上

- 出力精度が上がった

- 最大1,024×1,024の画像が生成可能

導入までの手順は複雑ですが、当記事でも詳しく解説しています。

うまく使いこなせれば、高精度かつ自由度の高い画像を生成できるようになるので、ぜひ利用してみてください。

最後に

いかがだったでしょうか?

Stable Diffusionなどの画像生成AIを活用し、高精度な画像生成で広告バナーやSNS投稿用ビジュアルを迅速に作成。さらに、製品デザインのモックアップ作成を効率化し、時間とコストを削減しませんか?

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。