【Athene-V2】GPT-4oやLlama 3.1 405Bと競合する驚異の72B言語モデル

2024/11/15、NexusflowがAthene-V2をリリース!

Athene-V2は、Athene-V2-ChatとAthene-V2-Agentの2種類用意されており、Athene-V2-Agentは複雑な依存関係やツール使用が必要な環境で動作可能なエージェントモデルでGPT-4を上回る性能を誇ります。

本記事ではAthene-V2でどういったことができるのか、実装するにはどうすればいいのかお伝えします!本記事を最後まで読むことで、Athene-V2を実装できるようになり、複雑な操作を簡単に自動化ができるでしょう。

ぜひ最後までお読みください!

\生成AIを活用して業務プロセスを自動化/

Athene-V2の概要

Athene-V2は、Qwen 2.5 72Bをベースにファインチューニングされた最新の72Bモデルシリーズ

このモデルは、綿密に設計されたデータとRLHF(強化学習による人間のフィードバック)のパイプラインを活用し、主要な機能でGPT-4oと同等の性能を持っています

またAthene-V2は、Athene-V2-ChatとAthene-V2-Agentの2種類が用意されており、概要は以下です

Athene-V2-Chat:チャットや会話型AI、会話の自然さ、数学、コード補完に優れる

Athene-V2-Agent:ツール利用、エージェントタスク エージェントとしての複雑な操作や関数呼び出しが得意

Athene-V2-Chatの概要

Athene-V2-Chatは、カスタマイズによって特定のスキルやユースケースに細かく最適化されたモデル

主な特徴は以下の通りです

- チャットの有用性:Arena-HardベンチマークでGPT-4oを上回る高い有用性を発揮

- コード補完:bigcode-bench-hardで2位にランクインするコード補完能力

- 数学的処理:MATHベンチマークで高い性能を記録

- 長文のログ抽出: 長いログを高精度で処理し、必要な情報を抽出

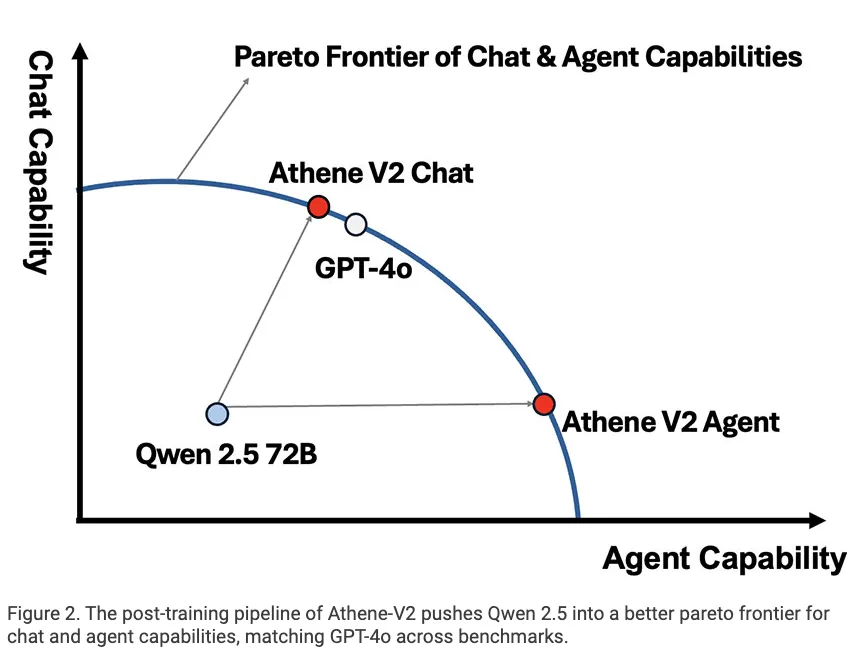

Athene-V2モデルは、LLMの事後学習における「パレートフロンティア(複数の性能指標をバランスよく最適化した状態)」の概念に基づいて設計されています

パレートフロンティア:複数の性能指標を最大限に向上させた場合の最適なバランス点を示す概念。Athene-V2モデルでは、「チャット能力」と「エージェント能力」の2つの性能指標が対象です。フロンティア上に位置する点は、片方の能力を向上させるために、もう片方の能力をある程度犠牲にしなければならないというトレードオフの関係を表します

このパレートフロンティアを超えて性能をさらに向上させるには、特定の能力を磨き上げることが重要です。

そのためには、他の能力を多少犠牲にしてでも、特定の分野に焦点を絞った強化が必要であり、Athene-V2-Chatは「チャット能力」を優先し、エージェント能力をトレードオフしており、Athene-V2-Agentは「エージェント能力」を優先し、チャット能力をトレードオフしています。

上記の画像は、Athene-V2モデルが特化型設計によって、チャットタスクやエージェントタスクのそれぞれで最適化されていることを示しており、用途に応じてどちらのモデルを選択するかの指針にもなります。

Athene-V2-Agentの概要

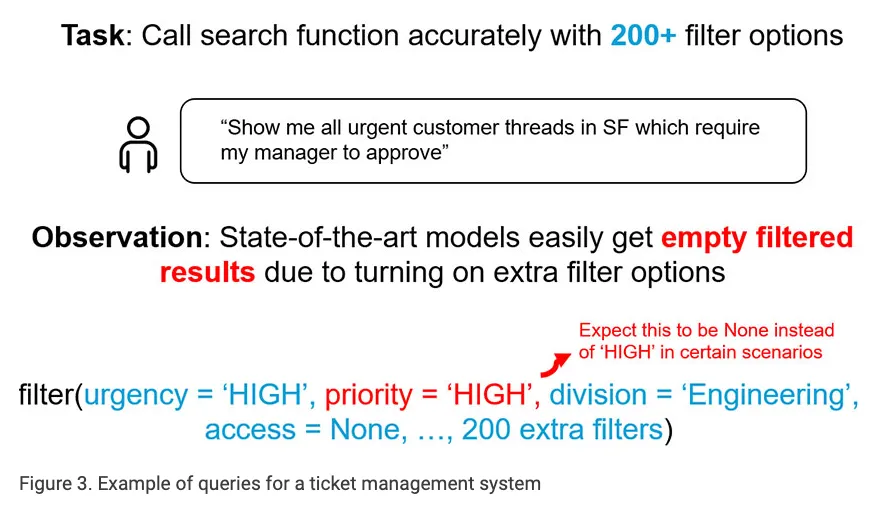

Athene-V2-Agentは、最先端の関数呼び出しとエージェント機能を超えるオープンソースのエージェントLLMです。

Athene-V2-Agentは、多用途なエージェント機能を備えたモデルで、環境との複雑な依存関係に対応し、1つのクエリに答えるために必要な複数のツールを呼び出しながら推論と計画を行うことができます。

また、関数呼び出しタスクにおいて、GPT-4oを関数呼び出しの成功率で18%、エージェントの成功率で17%上回る優れた性能を持っています。

さらに、Athene-V2-Agentは、評価で使用される関数やエージェント設定に基づいてトレーニングされていないにもかかわらず、高い一般化能力を発揮することが特徴です。

Athene-V2-AgentとGPT-4oの違い

Athene-V2-Agentは、関数呼び出しとエージェントの成功率において、GPT-4oを凌駕

具体的には、単一の関数呼び出しタスクにおいて、Athene-V2-AgentはGPT-4oよりも18%高い関数呼び出し成功率を達成し、エージェントの成功率では17%上回っています。

この優れたパフォーマンスは、Athene-V2-Agentが複雑な環境下で動作できるように設計されていること、そして深いネストされた依存関係を持つ環境においても推論と計画を行うことができるためです

さらに、Athene-V2-Agentは、評価で使用された特定の関数やエージェントの設定でトレーニングされていません。 つまり、Athene-V2-Agentは未知の状況にもうまく対応できる能力を持っていることを示唆しています。

関数呼び出し:モデルがユーザーのリクエストに応じて、適切なツールやAPIを正確に呼び出せる能力

エージェント:モデルが複数のタスクやツールを組み合わせて、最終的に正確な答えを提供できる能力

Athene-V2-Agentの想定利用環境

Athene-V2-Agentは、OpenAI APIと互換性のある環境であれば、基本的にどこでも利用可能

特に、VLLM Dockerイメージを使用することで、Athene-V2-Agentを導入できます。

Athene-V2-Agentは、実行可能な呼び出しをモデルの生成された計画から抽出するため、独自の「カスタムプロンプトスタイル」を使用

最適なパフォーマンスを引き出すには、HuggingFaceトークナイザーのチャットテンプレートではなく、提供されたDockerイメージを使用することが推奨されています

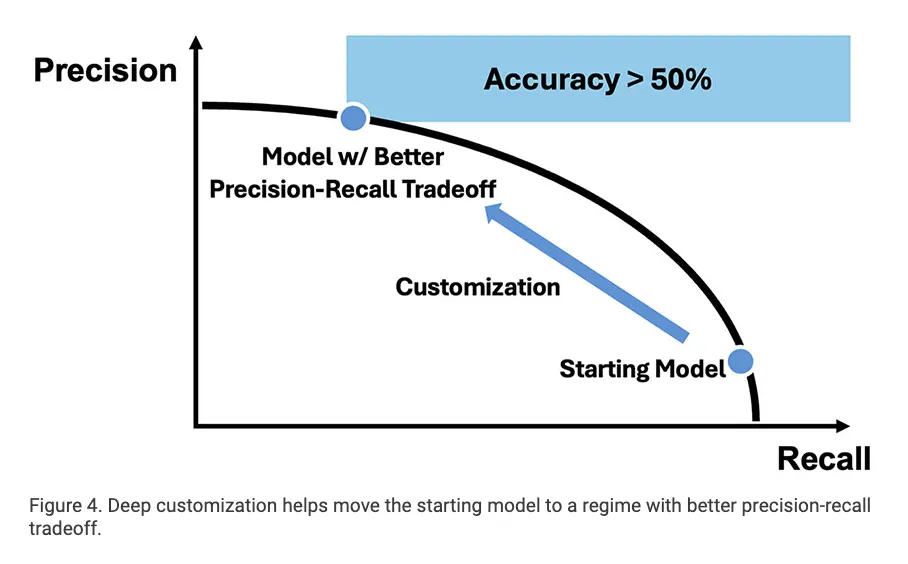

上記の画像は、Athene-V2などのモデルが「カスタマイズによってどのように性能を改善できるか」を視覚的に示しています。特に、精度と再現率の両立が求められるシステムで、このような調整が非常に重要

精度:モデルが返した結果のうち、どれだけ正確(正解)であったかを示す指標。高い精度は「誤検出(False Positive)」を減らすことを意味します

再現率:モデルが返すべき結果をどれだけ網羅的に返せたかを示す指標。高い再現率は「見逃し(False Negative)」を減らすことを意味します。

上記は、Atheneモデルシリーズが、エージェントタスクにおいて他のモデル(Athene-V2 Agent, GPT-4oなど)と比較してどの程度優れた性能を発揮しているかを示したものです

ここでは、特に 関数呼び出し(Function Calling, FC) と検索タスクの性能を評価しており、他のモデルを大きく上回る性能を発揮。

Athene-V2は、特にエージェントタスクの正確性と柔軟性が求められる場面で最適な選択肢

上記の表は、特化型カスタマイズが実運用でのAIモデルの性能向上にどれだけ貢献するかを示す良い例でしょう

Athene-V2のライセンス

Athene-V2のライセンスはNexusflow Research Licenseです

Nexusflow Research Licenseは個人的な利用の範囲内では配布や改変も可能ですが、商用利用は不可

また、Nexusflow Materialsを第三者に配布する場合は、以下の条件を満たす必要があります

- 配布時にこのライセンスのコピーを含めること

- すべてのコピーに適切な帰属情報(Nexusflow.aiに関する著作権表示)を含めること

- 商用活動を伴わない形での配布に限られる

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ❌ |

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | 不明 |

| 私的使用 | ⭕️ |

商用利用やより広範な利用を希望する場合は、Nexusflowに問い合わせて別途ライセンスを取得する必要があるでしょう

なお、プログラミング特化LLMのQwen2.5-Coderについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Athene-V2の使い方

Athene-V2-Agentはgoogle colaboratoryでも動かせますが、HuggingFaceをみると、Dockerからの使用が推奨されています

Hugging Faceを確認すると、Google Colaboratoryでも実装可能とされていますが、こちらも容量が大きすぎるのでA100を使っても実装が難しいです

Hugging Face Inference APIを使って実装も、容量が145GBとかなり大きくなってしまい。エラーになってしまいます

Hugging Face Inference APIを使った例はこちら

import requests

API_TOKEN = "your_api_key" # あなたのAPIトークン

API_URL = "https://api-inference.huggingface.co/models/Nexusflow/Athene-V2-Chat"

headers = {"Authorization": f"Bearer {API_TOKEN}"}

def query(payload):

response = requests.post(API_URL, headers=headers, json=payload)

return response.json()

# 使用例

message = "こんにちは!"

output = query({

"inputs": message,

"parameters": {

"max_new_tokens": 100,

"temperature": 0.7,

}

})

print(output)結果はこちら

{'error': 'The model Nexusflow/Athene-V2-Chat is too large to be loaded automatically (145GB > 10GB). Please use Spaces (https://huggingface.co/spaces) or Inference Endpoints (https://huggingface.co/inference-endpoints).'}Athene-V2-ChatにはSpacesが用意されていたので、そちらを使ってみましょう

Spacesを使ってみましたが、5分ほどしてもレスポンスはありませんでした

Athene-V2の容量が大きすぎて、より小さいサイズを求める声が多いです

Athene-V2の具体的な活用例

Athene-V2-Chatは、自然な会話能力、長文処理力、高精度な情報抽出力、そしてコード補完能力を活かして、カスタマーサポートや会議議事録の要約、プログラミング学習のサポートといったタスクに適しているでしょう

これらのタスクが求める要件とAthene-V2-Chatの特性が一致しているため、実用性が高いと言えます

また、Athene-V2-Agentは、ツール操作やタスクの自動化を必要とする業務で非常に有効

複雑なタスクやエンタープライズ向けの業務において、モデルの特性が求められる要件に完全に一致しているため、業務効率化や高度な自動化を実現する理想的なツールになりえます

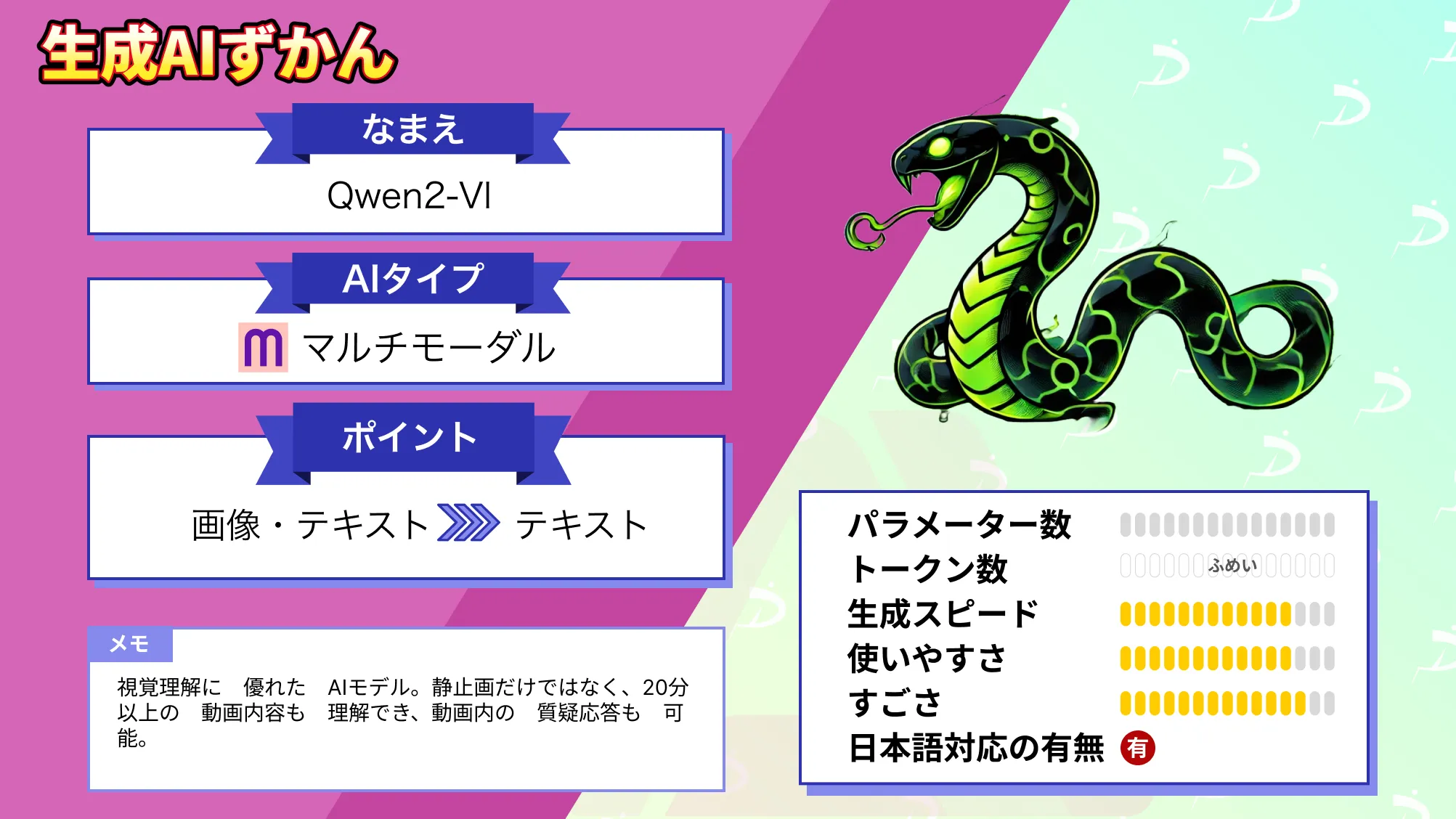

なお、Alibaba Cloudの視覚言語モデルについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

まとめ

本記事ではAthene-V2について紹介をしました。google colaboratoryで実装するには容量が大きすぎるため、実装は不可能でしたが、ご自分の環境で実装できる方はぜひ実装してみてください!

Hugging FaceのCommunityをみると小さいサイズは?というコメントが上がっているので、そのうち32Bなどが登場するかもしれませんね!

最後に

いかがだったでしょうか。

Athene-V2の圧倒的な性能で、複雑なタスクの自動化や業務効率化を実現しませんか?エージェント機能とチャット能力を最大限に活用し、ビジネス競争力を強化しましょう。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。