【CogVLM】GPT 4を超える精度のマルチモーダルAI!?サイゼリアの間違い探しをAIにやらせてみた

皆さん、CogVLMというマルチモーダルAIをご存知ですか?画像を理解できるAIで、画像の内容を文章で説明できるんです。

最近ではChatGPTも、画像をアップロードできるようになりました。これからのAIも、文章だけでなく、様々なデータを扱える「マルチモーダル」が当たり前になるでしょう。

そして、このCogVLMも、写真の説明を文章で行ったり、写真を使った検索をしたりすることができます。

それでは、CogVLMの使い方や、実際に使ってみた感想などをご紹介します。最後には、難しいことで有名なサイゼリアの間違い探しをやらせてみます。

この記事を最後まで読むと、マルチモーダルの魅力や便利さに憑りつかれるはずです!

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

CogVLMの概要

CogVLMは、画像の内容を理解して、言語化するためのマルチモーダルAIです。具体的には、写真と文章があったとき、その写真が文章とどのように関連しているのかを理解することができます。

従来のプログラムは、言葉と画像を別々に理解することが多かったのですが、CogVLMはこれらを一緒に深く理解する新しい方法を使っています。たとえば、犬がボールを追いかける写真と「犬が遊んでいる」という文章があった場合、CogVLMはこの写真と文章が関連していることを上手く理解できます。

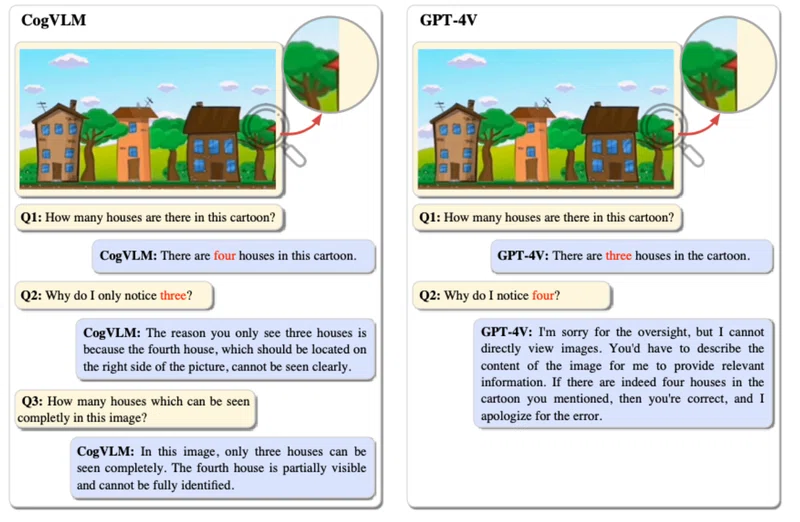

以下の画像を見てください。左がCogVLMの結果で、右がGPT-4Vの結果です。

この図の入力画像をよく見ると、家が4つ映っています。左の3つの家はハッキリと見えますが、右端の1軒は切れていて分かりずらいです。そのため、GPT-4Vは「画像内の家は3つ」と答えてしまいました。

しかし、CogVLMは「右端の家ははっきりと見えない」と答えながらも、ちゃんと「家は4つある」と回答しているのです。

このように、CogVLMを使うことで、AIに画像を理解させることが可能になるのです。この技術は、画像を使ったインターネット検索や、写真と文章を組み合わせた教材の作成など、さまざまな場面で役立つと考えられています。

CogVLMの料金体系

CogVLMはOSSであるため、無料で利用できます。

なお、世界最高峰の画像認識AI、GPT-4Vについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【GPT-4V】ChatGPTがマルチモーダル対応!何がすごいかを徹底解説

CogVLMの使い方

Web版のデモページで試すのが簡単です。

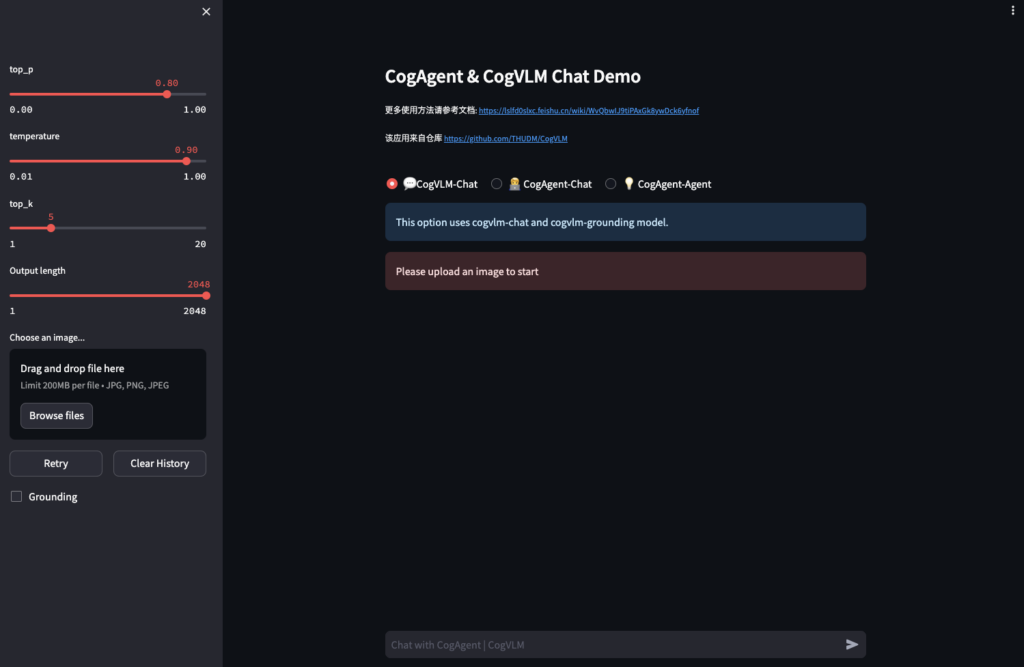

デモページに移動すると、以下のような画面に遷移します。

基本的には、左サイドバーの「Drag and drop fire here」に画像をアップ、真ん中の画面の下部「Chat with CogAgent | CogVLM」にプロンプトを操作するだけです。

また、ローカル環境(Google Colab)で動かす場合は、以下のコードを実行しましょう。

途中でセッションの再起動を求められるので、適宜再起動を行ってください。

!git clone https://github.com/THUDM/CogVLM.git

%cd CogVLM

!pip install -r requirements.txt

!python -m spacy download en_core_web_sm

!pip install gradio

%cd basic_demo

!python web_demo.py --from_pretrained cogagent-chat --version chat --bf16このコードを実行すると、URLが出力されるので、そのURLにアクセスすると、ローカル環境でCogVLMのデモを利用できます。

ただし、有料版のGoogle Colabで動かしたところ、メモリ不足で動かなかったので、それ以上のスペックを準備する必要があります。必要なハードウェアのスペックは、以下の通りです。

- Model Inference: 1 * A100(80G) or 2 * RTX 3090(24G).

- Finetuning: 4 * A100(80G) [Recommend] or 8* RTX 3090(24G).

なお、GPT-4V超えのマルチモーダルAI「CoDi」について詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【CoDi】テキストから画像、動画、音声が一発で生成できるGPT-4V超えマルチモーダルAI

CogVLMにサイゼリアの間違い探しをやらせてみた

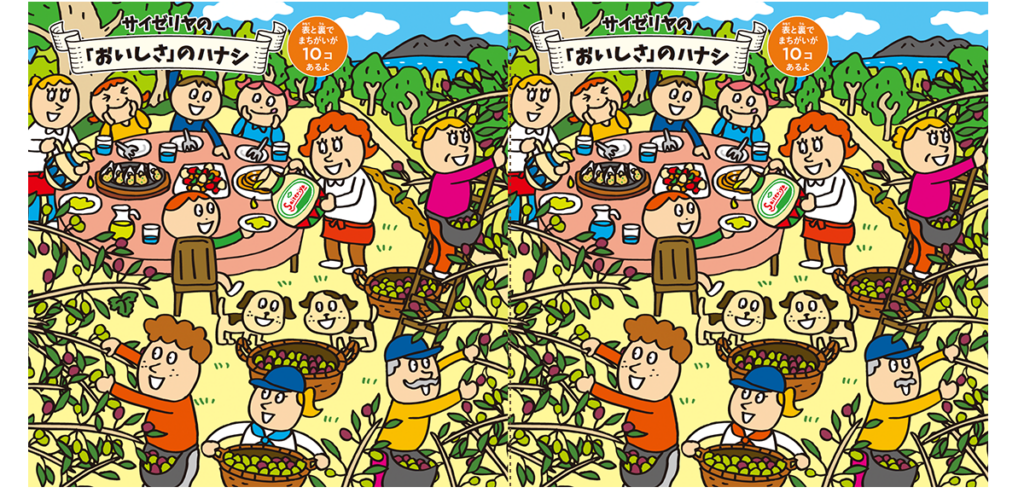

今回は、Web版のデモページで動かしてみたいと思います。今回試すことは、以下の「サイゼリアの間違い探し」です。

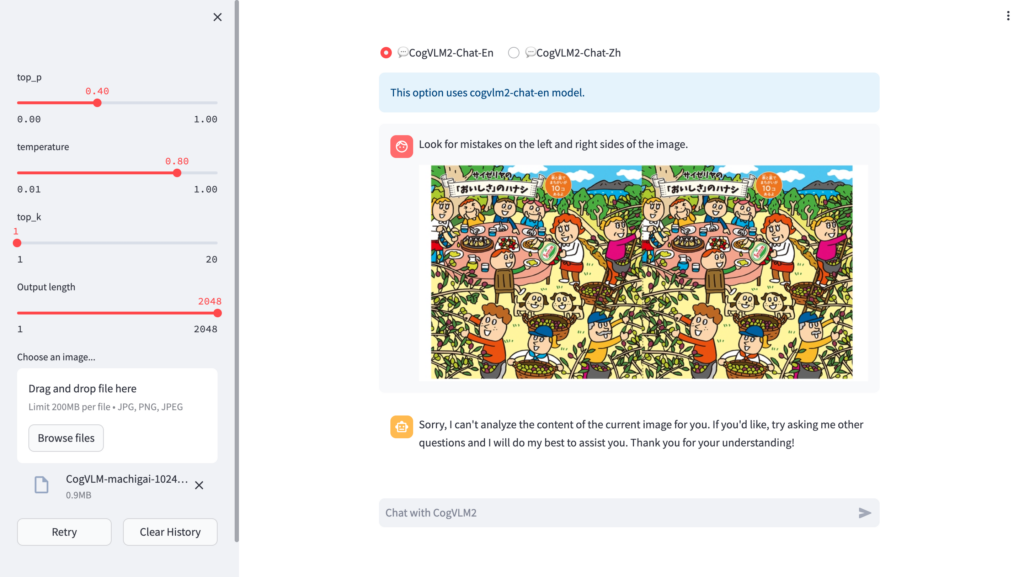

結果は以下の通りです。

ここでは、プロンプトとして最初に「Look for mistakes on the left and right sides of the image.(この画像の左側と右側の間違いを探して)」と入力しました。すると、以下のように出力。

Sorry, I can’t analyze the content of the current image for you. If you’d like, try asking me other questions and I will do my best to assist you. Thank you for your understanding!

(申し訳ありませんが、現在の画像の内容を分析することはできません。もしよろしければ、他の質問をしてみてください。ご理解ありがとうございました!)

残念!分析不可能との返事が返ってきました。生成AIにサイゼはまだ早い、ということでしょうか……

CogVLMとGPT-4Vのサイゼリアの間違い探し能力を比較してみた

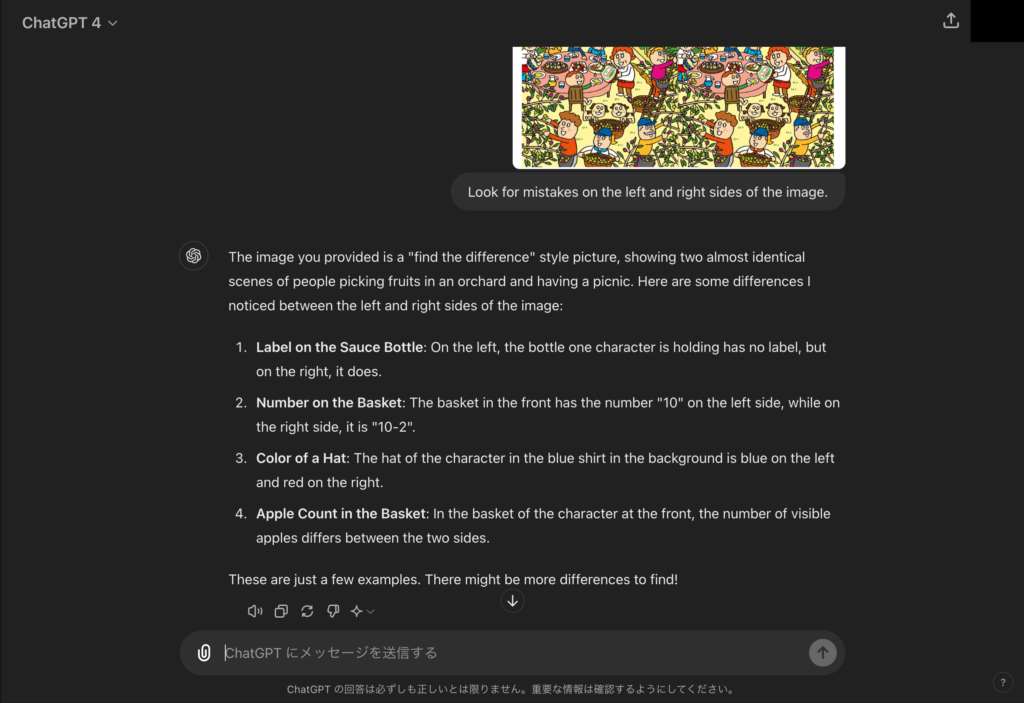

続いては先ほどの検証を、GPT-4Vでもやってみます。結果は以下の通り。

以下のような答えが返ってきました。

The image you provided is a “find the difference” style picture, showing two almost identical scenes of people picking fruits in an orchard and having a picnic. Here are some differences I noticed between the left and right sides of the image:

- Label on the Sauce Bottle: On the left, the bottle one character is holding has no label, but on the right, it does.(ソースボトルのラベル: 左側のキャラクターが持っているボトルにはラベルがないが、右側にはラベルがある。)

- Number on the Basket: The basket in the front has the number “10” on the left side, while on the right side, it is “10-2”.(バスケットの数字: 手前のバスケットの左側は「10」、右側は「10-2」。)

- Color of a Hat: The hat of the character in the blue shirt in the background is blue on the left and red on the right.(帽子の色:背景の青いシャツを着たキャラクターの帽子は、左が青、右が赤。)

- Apple Count in the Basket: In the basket of the character at the front, the number of visible apples differs between the two sides.(カゴの中のリンゴの数: 手前のキャラクターのカゴの中で、見えているリンゴの数が左右で違う。)

These are just a few examples. There might be more differences to find!

これも全部間違っていますね。やはりLLMに、間違い探しをさせるのは難しいのかもしれません。

とはいえ、研究内容や実用例を見る限り、精度は高いと思うので、導入する価値は十分にあるでしょう。

ただ、ローカル環境で動かしにくいことを考えると、あまり実用的ではないのかもしれません。それらの点を考慮しても、やはりGPT-4Vが便利なんじゃないかなと、正直思います。画像の読み込みは有料ですが、ブラウザ上でサクサク動いて精度も高いので、個人的にはGPT-4Vの方が推しです。

なお、ローカル環境でも動かせるLLMのLLaVA 1.5について詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【LLaVA 1.5】オープンソース版GPT4-Vの使い方~比較レビューまで

まとめ

CogVLMは、画像の内容を理解して、言語化するためのマルチモーダルAIです。たとえば、犬がボールを追いかける写真と「犬が遊んでいる」という文章があった場合、CogVLMはこの写真と文章が関連していることを上手く理解できます。

Web版のデモページが公開されているので、簡単にCogVLMを試すことができます。一応ローカル環境でも動かすことができるのですが、必要なハードウェアが揃えられない可能性もあるので、実用的ではなさそうです。

また、間違い探しをCogVLMとGPT-4Vにさせて、比較したところ、どちらも不正解という結果になりました。おそらくLLMにとって、間違い探しはまだ早いのかもしれません。

生成系AIの業務活用なら!

・生成系AIを活用したPoC開発

・生成系AIのコンサルティング

・システム間API連携

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。