【DeepSeek-V3.2 & DeepSeek-V3.2-Speciale】エージェント向けに構築された最新推論モデルを徹底解説!

- DeepSeekからエージェント向けに構築された最新モデルと、その高性能版が同時リリース

- 長文推論能力とエージェント性能を両立させることを目指したモデル

- V3.2は推論ベンチマークでGPT-5相当のスコアを達成、Speciale版はGemini-3.0-Proを上回る成績

2025年12月1日、DeepSeek社は、エージェント向けに構築された最新モデル「DeepSeek-V3.2」とその高性能版「DeepSeek-V3.2-Speciale」をローンチしました!

これらのモデルは、効率的なSparse Attentionや、大規模強化学習などの技術革新を組み合わせて、長文推論能力とエージェント性能を両立させることを目指したモデルです。

DeepSeek-V3.2は、GPT-5相当の性能を持っていて、Speciale版はさらに推論能力が強化されているとのこと。また、対話テンプレートにも新たな工夫が導入され、ツール利用時に「思考モード」を組み込むことで、複雑なタスクへの対応力が強化されているようです。

そこで本記事では、DeepSeek-V3.2とDeepSeek-V3.2-Specialeの違いを押さえながら、その性能や使い方をご紹介していきます。

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

DeepSeek-V3.2 と DeepSeek-V3.2-Specialeの概要

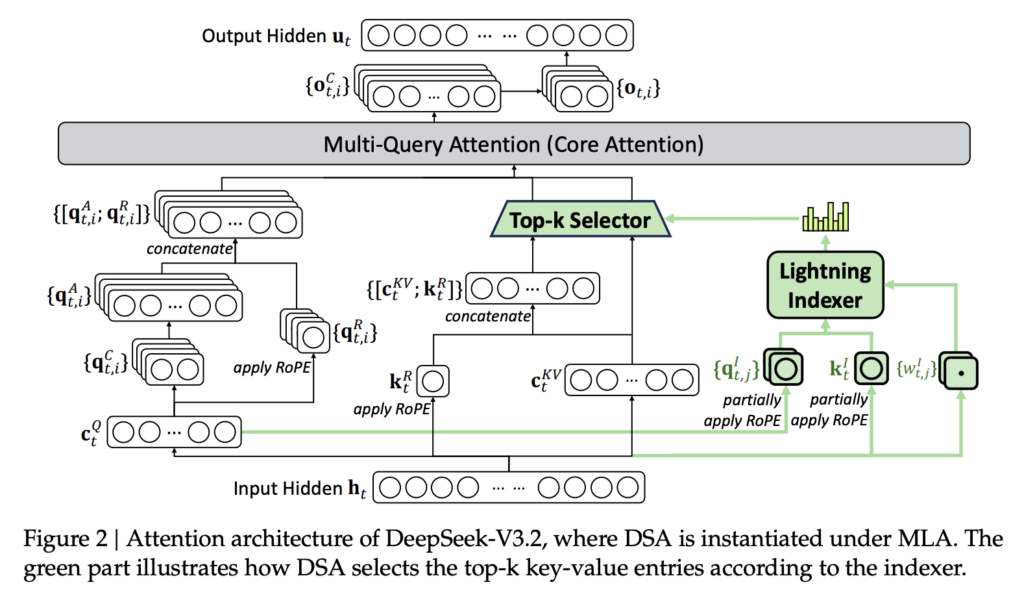

DeepSeek-V3.2は、主に以下の3つの技術的ブレークスルーに基づいています。

まず「DeepSeek Sparse Attention (DSA)」により、長文処理時の計算量を削減し、従来モデルより大幅に効率化されています。

次に、「強化学習を大規模に用いたトレーニングフレームワーク」によって、V3.2は通常動作でもGPT-5並み、Speciale版はGPT-5を上回る高度な推論性能を実現しました。

さらに、1,800以上の環境と、85,000以上の複雑な指示を自動生成する「タスク合成パイプライン」により、ツール利用環境下でも汎用的な思考力を養成しています。

ツール呼び出し時のチャットテンプレートを刷新して、新たに「思考モード(chain-of-thought)」を統合したことで、質問に対して途中計算を返してから、最終回答を出力する設計になっています。

また、このDeepSeek-V3.2系は、最大128Kトークン(約100万文字)もの長文コンテキストに対応し、非常に大規模な入力にも耐えうる点も大きな特徴です。

なお、DeepSeek発の数学問題解答に特化したモデル「DeepSeek-Math-V2」について詳しく知りたい方は、以下の記事も参考にしてみてください。

DeepSeek-V3.2 と DeepSeek-V3.2-Specialeの違い

DeepSeek-V3.2-Specialeは、V3.2標準版の高負荷推論特化型バージョンで、主に計算量を増やした最適化が行われています。

Speciale版は、Gemini-3.0-Proと同等の性能を追求したモデルであるため、応答品質は高い一方で必要なトークン使用量や計算資源も増加します。

提供形態も異なっていて、Speciale版はAPI経由でのみ利用可能(Web/アプリでは提供なし)で、ツール呼び出し機能が無効化されています。

対して、V3.2標準版は、Webやアプリでも使えて、ツール呼び出しを伴うチャットモードにも対応します。

DeepSeek-V3.2 と DeepSeek-V3.2-Specialeの性能

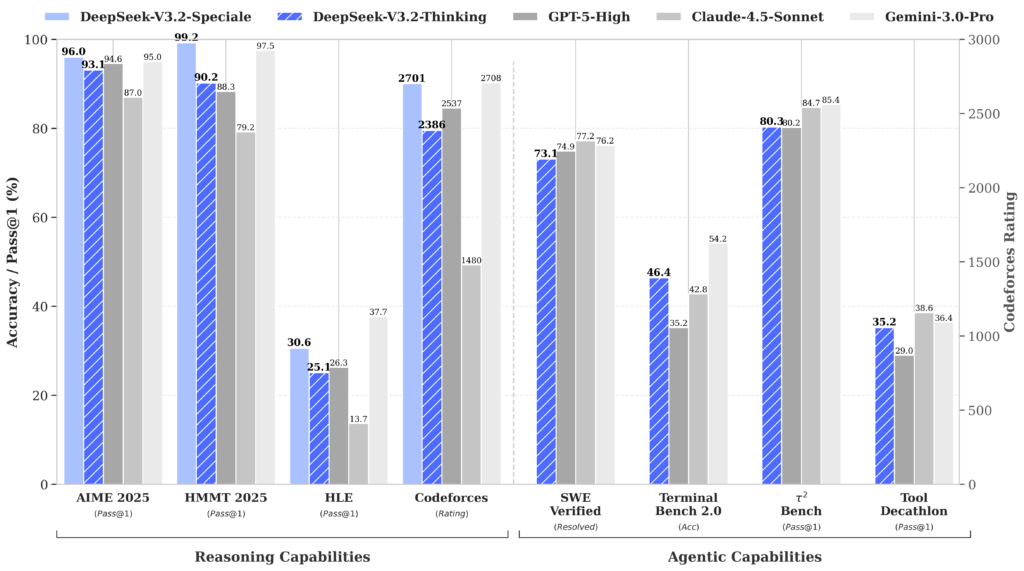

DeepSeek-V3.2系モデルの性能は、現行のLLMトップレベルとなっています。

公式レポートによると、V3.2は、各種推論ベンチマークでGPT-5相当のスコアを達成し、Speciale版は、Gemini-3.0-Proを上回る成績を収めています。

とりわけ、Speciale版は、2025年のIMO・IOI・ICPC世界大会で金メダル級の成績を記録しており、ICPC世界大会では上位2位に、IOIでは上位10位に入るなど「Gold-medal performance」を達成しています。

数学競技AIMEでは正答率96%、ハーバード数学コンテストHMMTでは93%超、Codeforcesの課題ではレーティング約2700に相当するスコアを記録していて、いずれも最先端モデルを圧倒する水準です。

ただしSpeciale版は、最高性能を得る代償としてトークン効率が低く、運用コストとレイテンシにも影響が大きいため、使用時は注意が必要となります。

DeepSeek-V3.2 と DeepSeek-V3.2-Specialeのライセンス

DeepSeek-V3.2およびSpeciale版は、MITライセンスで公開されており、利用制限はほとんどありません。

例えば、商用利用や改変・再配布・私的利用はいずれも許可されていて、自由に利用できます。

一方で、MITライセンスには、特許権の利用に関する明示的な許諾条項が含まれていないため、特許利用については明記されていません。

通常、MITでは暗黙の許可と解釈される場合が多いですが、技術特許に関わる利用には留意が必要です。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | ⭕️ | |

| 改変 | ⭕️ | |

| 配布 | ⭕️ | |

| 特許使用 | 明示的には記載なし | MITでは暗黙的に許可されると解釈できるが要注意 |

| 私的使用 | ⭕️ |

DeepSeek-V3.2 と DeepSeek-V3.2-Specialeの料金

DeepSeek-V3.2系列モデルのAPI利用料金は、割と低めに設定されています。

| モデル | 入力1Mトークン(ミス) | 入力1Mトークン(ヒット) | 出力1Mトークン |

|---|---|---|---|

| DeepSeek-V3.2 / Speciale | $0.28(約42円 ※) | $0.028(約4.2円 ※) | $0.42(約63円) |

※1ドル=150円換算

DeepSeek-V3.2とSpecialeは同一料金体系で提供されていて、いずれも上記の価格で利用できます。

特に、Speciale版は高負荷タスク向けで、計算リソースが大きいので使用トークン数も増加します。

DeepSeek-V3.2 と DeepSeek-V3.2-Specialeの使い方

アプリ版とAPI版の2通りの使い方をご紹介します。

アプリ版

DeepSeek Webアプリサイトでアカウント作成をして、プロンプトを送信するだけで利用できます。

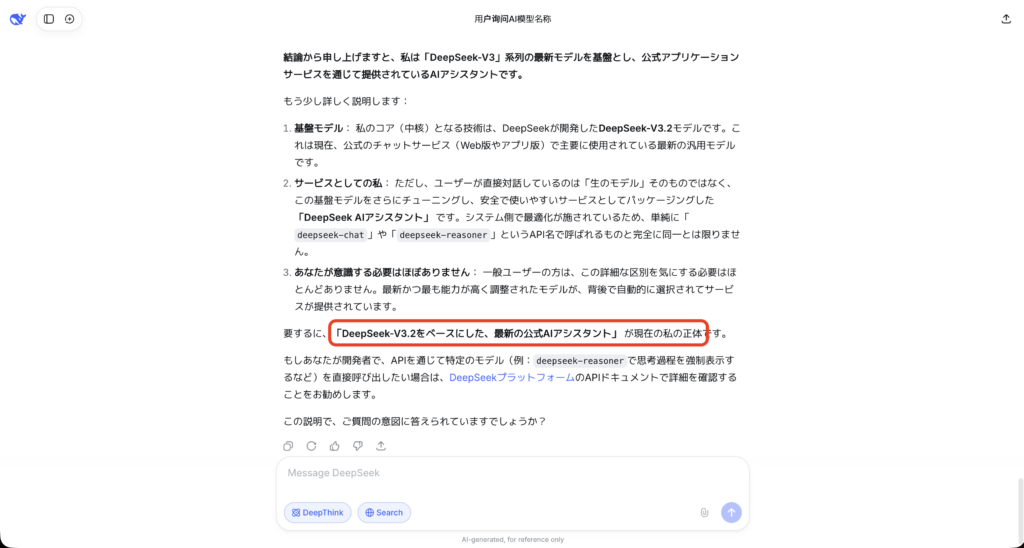

ChatGPTやGemini、Claudeのようなモデル選択画面はありませんが、基本的には最新モデルがベースになっていると思います。念のため、DeepSeek自身に「何モデルなのか」を質問すると以下のような回答が返ってきました。

一応、「DeepSeek-V3.2ベースのアシスタント」と答えてくれましたが、たまにV3.0と言ったり、日本語返答を指示していても中国語で返答されたり、DeepSeekならではの挙動ではありますね。

API版

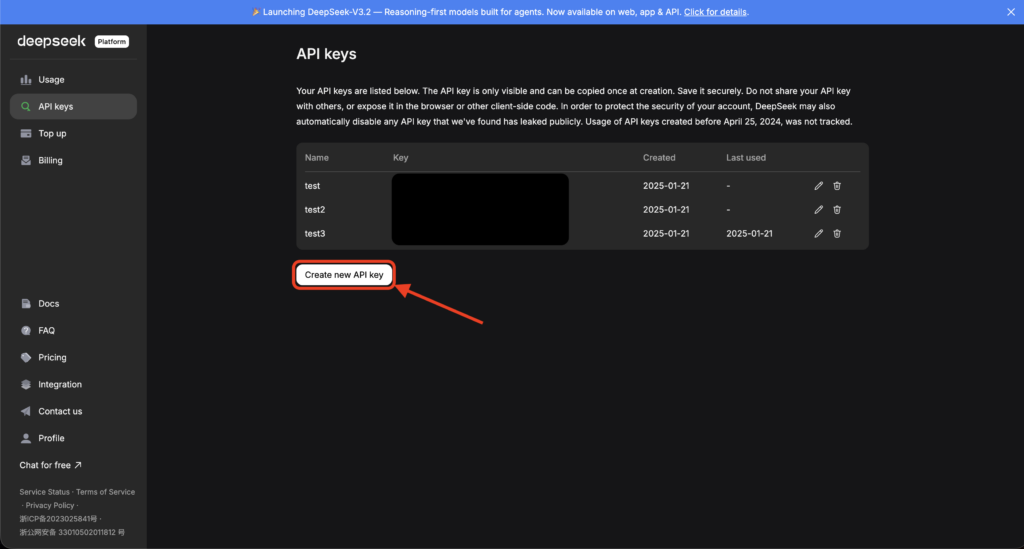

まず、DeepSeekプラットフォームでアカウント作成をして、APIキーを取得します。

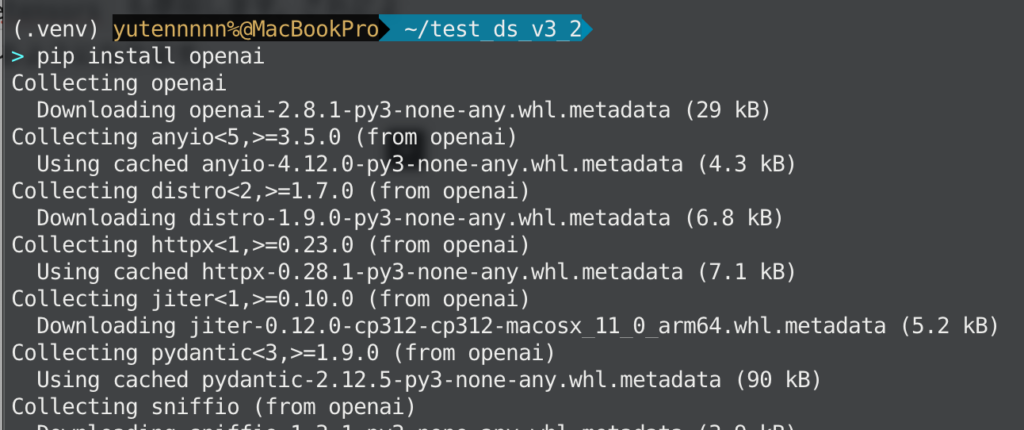

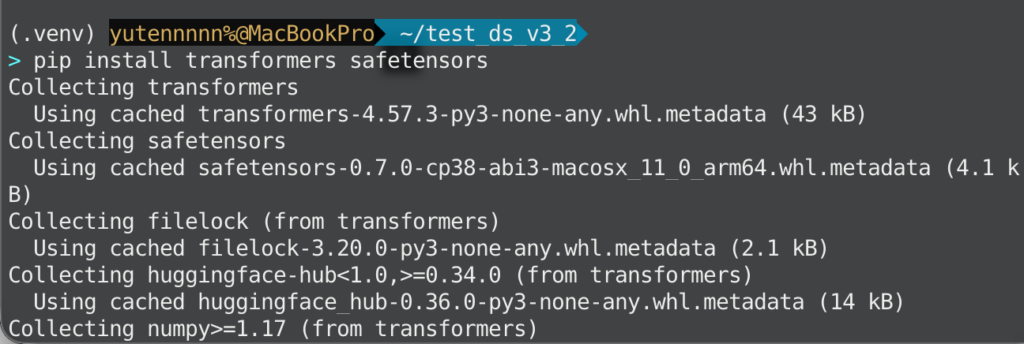

続いて開発環境の準備です。Python環境に、OpenAI互換のAPIクライアント(pip install openai)をインストールします。

Hugging FaceのTransformersで動かす場合はpip install transformers safetensorsも使用します。これによって、DeepSeek-V3.2モデルをローカルでロードしたり、公式APIとやりとりできるようになります。

それでは、モデルを呼び出していきましょう。APIキーとベースURLを指定して、ChatCompletion APIを呼び出します。

通常の会話モードではモデル名に "deepseek-chat" を使いますが、思考モードを有効にするには "deepseek-reasoner" を指定します。例えばPythonでは以下のようになります。

from openai import OpenAI

client = OpenAI(api_key="<ここにAPIキーを入れる>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=[{"role": "user", "content": "複雑な数学問題を解いてください"}]

)

reasoning = response.choices[0].message.reasoning_content

answer = response.choices[0].message.contentこのようにdeepseek-reasonerモデルを使うと、reasoning_contentフィールドに思考過程、contentフィールドに最終回答が返されます。

オプションとして、HuggingFace版の利用方法も簡単にご紹介します。

Hugging Face上のモデルページから重みを取得し、transformersでロードすることも可能です。例えば、以下のようにパイプラインを使ってテキスト生成を試すことができます。

from transformers import pipeline

generator = pipeline("text-generation", model="deepseek-ai/DeepSeek-V3.2")

result = generator("DeepSeekの特徴を説明してください。", max_new_tokens=200)これによって、ローカル環境でモデルを直接動かして応答を得ることができるようになります。

(オプション)LLMプラットフォーム

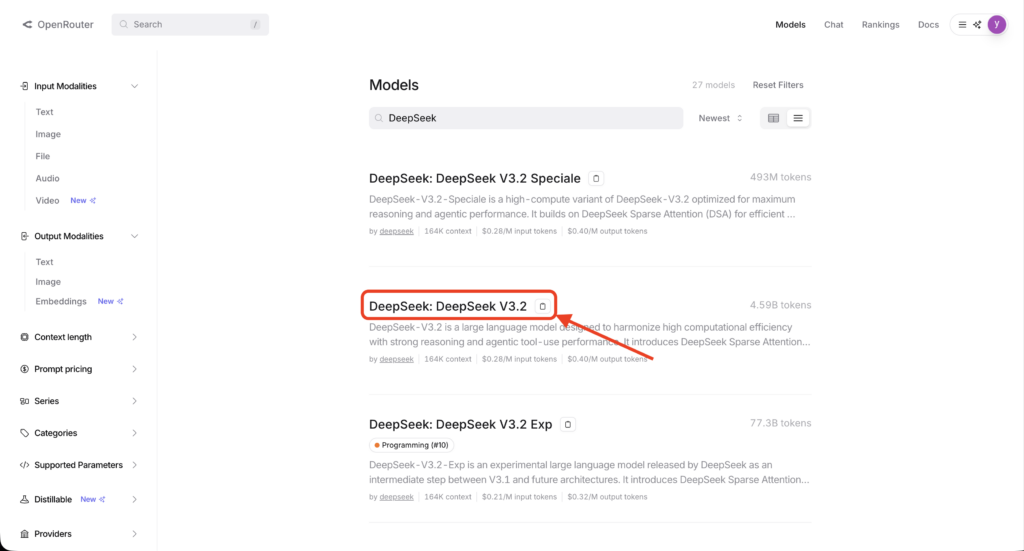

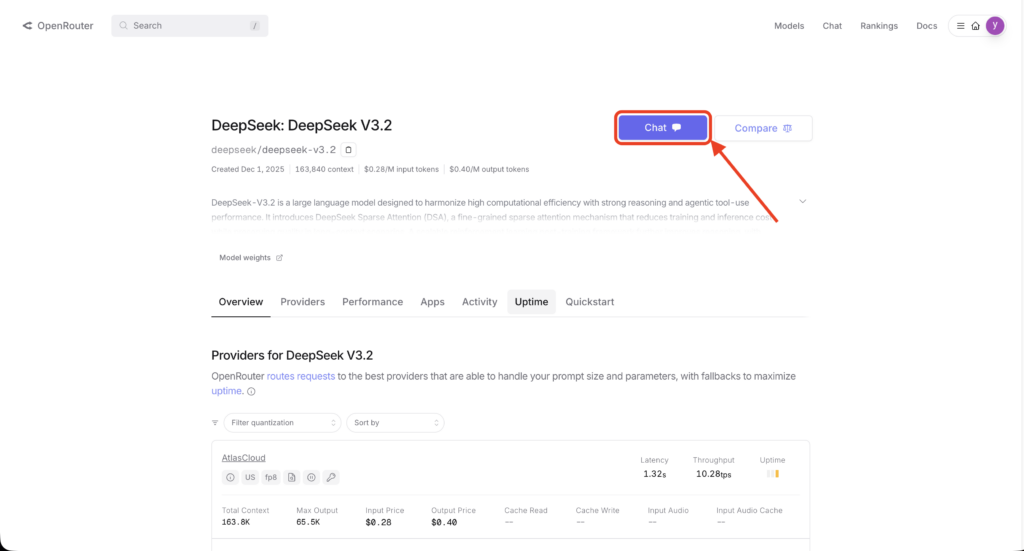

詳細は割愛させていただきますが、OpenRouterに加え、Novita AI経由のHugging Face推論APIなど、各種プラットフォームからDeepSeek-V3.2を呼び出すこともできるので、自前でGPUを用意せずに、本番レベルの推論を試したい方にはおすすめです。

次のセクションでは、OpenRouter上でDeepSeek-V3.2を試していきます。

DeepSeek-V3.2を使ってみた

それでは、OpenRouterのChat画面で、DeepSeek-V3.2を試していきましょう。

プロンプトはこちら:

計算量解析が必要になるような難しめのアルゴリズム問題を一題出題し、その最適解の考え方とPython実装、計算量の根拠を日本語で詳しく説明してください。結果はこちら:

## 問題: スライディングウィンドウの最大値

### 問題文

サイズ $n$ の整数配列 `nums` と整数 $k$ が与えられます。サイズ $k$ のスライディングウィンドウが配列の左端から右端まで移動します。ウィンドウが移動する各位置において、ウィンドウ内の最大値を求めてください。

**例:**

```

入力: nums = [1,3,-1,-3,5,3,6,7], k = 3

出力: [3,3,5,5,6,7]

```

### 最適解の考え方

#### 単純な解法の問題点

各ウィンドウ位置で最大値を求めると、計算量は $O(n \times k)$ となり、$n$ と $k$ が大きい場合に非効率です。

#### 最適解: 両端キューを用いたアプローチ

両端キュー(deque)を使用して、以下の戦略で効率的に解きます:

1. **キューには配列のインデックスを保存**:要素そのものではなく、インデックスを保存することで、ウィンドウ外の要素を特定しやすくします。

2. **キューは単調減少順に維持**:キューの先頭が現在のウィンドウの最大値に対応するようにします。

3. **アルゴリズムの流れ**:

- 現在の要素がキューの末尾の要素より大きい場合、末尾を削除(より小さい値は不要)

- キューの先頭がウィンドウの範囲外の場合、削除

- 現在のインデックスをキューに追加

- ウィンドウが完全に形成されたら(i ≥ k-1)、キューの先頭を結果に追加

このアプローチにより、各要素は最大で1回ずつキューに追加・削除されるため、計算量は $O(n)$ となります。

### Python実装

```python

from collections import deque

def maxSlidingWindow(nums, k):

if not nums or k == 0:

return []

n = len(nums)

if k == 1:

return nums

# 結果を格納するリスト

result = []

# 両端キュー(インデックスを格納)

dq = deque()

for i in range(n):

# ウィンドウの範囲外にあるインデックスをキューから削除

if dq and dq[0] < i - k + 1:

dq.popleft()

# 現在の要素より小さい要素のインデックスをキューから削除

while dq and nums[dq[-1]] < nums[i]:

dq.pop()

# 現在のインデックスをキューに追加

dq.append(i)

# ウィンドウが完全に形成されたら結果を追加

if i >= k - 1:

result.append(nums[dq[0]])

return result

# テスト例

nums = [1,3,-1,-3,5,3,6,7]

k = 3

print(f"入力: nums = {nums}, k = {k}")

print(f"出力: {maxSlidingWindow(nums, k)}")

# 出力: [3, 3, 5, 5, 6, 7]

```

### 計算量の解析

#### 時間計算量: $O(n)$

- **根拠**:

- 各要素は正確に1回ずつキューに追加されます (`dq.append(i)`)

- 各要素は最大で1回ずつキューから削除されます (`dq.popleft()` または `dq.pop()`)

- これらの操作はすべて $O(1)$ 時間で実行可能

- したがって、全体の操作回数は $n$ に比例し、時間計算量は $O(n)$

- **単純解法との比較**:

- 単純解法: $O(n \times k)$

- 最適解法: $O(n)$

- $k$ が大きい場合(例: $k = n/2$)、単純解法は $O(n^2)$ に対して最適解法は $O(n)$ で大幅に高速

#### 空間計算量: $O(k)$

- キューが同時に保持するインデックス数は最大 $k$ 個

- 結果を格納するリストは $O(n-k+1)$ の空間を使用

- 全体として $O(k)$ の補助空間を使用

このアルゴリズムは、スライディングウィンドウの最大値問題に対する最適な解法の一つであり、実際の競技プログラミングやシステム設計でも広く使用されています。問題の意図をちゃんと押さえつつ、愚直解との比較→dequeによる最適解まできれいに橋渡しできていて、とてもバランスの良い解説になっていますね。

まとめ

DeepSeek-V3.2とV3.2-Specialeは、2025年時点で、オープンソース界隈をリードする高度なLLMだと言っても過言ではないと思います。Sparse Attentionや強化学習によって高度な推論力を持ち、Gemini-3.0-Proや、GPT-5を超えるような性能を実現しています。

V3.2標準版は、汎用性の高いチャットエンジンとして、Speciale版は、高度な数学・論理推論タスクで特に力を発揮してくれそうです。

つい先日リリースされたDeepSeek-Math-V2を始めとして、今後のDeepSeekシリーズ動向も要注目です!

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。