【ELYZA-japanese-Llama-2-70b】日本語特化モデル最大級の700億パラメーターLLMを使ってみた

WEELメディア事業部LLMライターのゆうやです。

2024年3月12日、ELYZA-japanese-Llama-2-7bなどの日本語特化LLMを開発してきたELYZA社が、最新の700億パラメータの大規模言語モデル (LLM) である「ELYZA-japanese-Llama-2-70b」を公開しました。

このモデルは、これまでのモデルと同様に、Meta社の「Llama2」をベースに、日本語の追加事前学習と事後学習を行い、Llama2が持つ強力な英語能力を日本語に対する言語能力に拡張させています。

その結果、他の日本語LLMを大きく上回る日本語能力を獲得し、GPT-3.5 TurboやClaude2.1に匹敵するほどの性能になっています!

また、ELYZAは開発した日本語LLMの総称を「ELYZA LLM for JP」とし、API提供に向けた開発も進められています。

今回は、ELYZA-japanese-Llama-2-70bの概要や使ってみた感想をお伝えします。

是非最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

ELYZA-japanese-Llama-2-70bの概要

ELYZA-japanese-Llama-2-70bは、日本のELYZA社によって構築された最新の日本語特化LLMです。

このモデルは、これまでのELYZAが開発した日本語モデルと同様に「Llama2」をベースに、日本語の追加事前学習と事後学習を行い、Llama2が持つ強力な英語能力を日本語に対する言語能力に拡張させています。

その性能は、後ほど詳しく見ていきますが、ELYZA Tasks 100という独自の日本語ベンチマークを用いた性能評価では、既存の日本語LLMを大きく上回っており、GPT-3.5 TurboやClaude 2.1などに匹敵する性能を示しました。

ここからは、これほどまでの日本語能力を獲得したELYZA-japanese-Llama-2-70bの学習手法を解説します。

学習方法

ELYZA-japanese-Llama-2-70bは、Meta社のLlama 2 70bをベースとしており、日本語の追加事前学習と事後学習を行うことで構築されました。

Llama 2 70bはLlama 2シリーズ最大のモデルで、強力な英語能力を有しており、ELYZA-japanese-Llama-2-70bではこの英語に対する言語能力を日本語に対する言語能力に拡張させています。

この手法は、1からモデルを構築するよりも少ないリソースで、より高い性能の日本語モデルを構築できるというメリットがあります。

このモデルの追加事前学習には、約100Bトークンの日本語コーパスが用いられています。

また、事後学習には、日本語での指示追従能力と一般的な知識を向上させることを目的として、ELYZAが独自に構築した高品質なデータセットを用いています。

さらに、今回は学習データの一部として「ichikara-instructionデータ」も使用しています。ichikara-instructionとは、日本語の大規模言語モデルのトレーニングや改善のために必要な指示データを構築、提供するプロジェクトで、ELYZAもこのプロジェクトに参加しています。

ここまで、ELYZA-japanese-Llama-2-70bの学習手法について紹介しましたが、ここからはELYZA-japanese-Llama-2-70bの性能について、公開されている情報から解説します。

性能評価

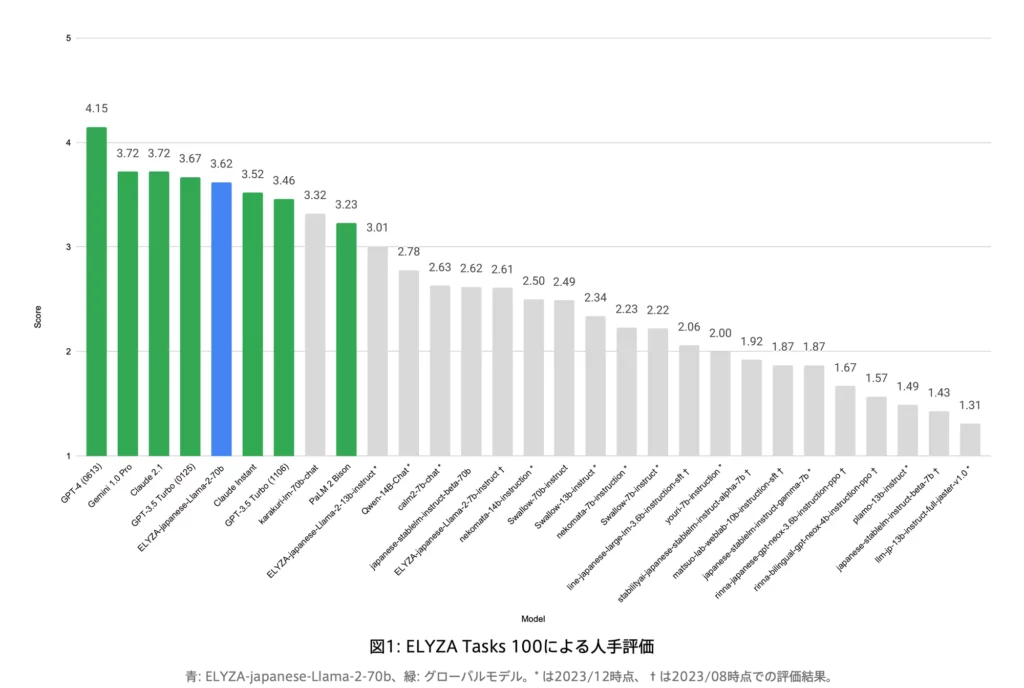

ELYZA-japanese-Llama-2-70bの性能評価は、ELYZA Tasks 100とJapanese MT-Benchを用いた2種類行われています。

まずは、冒頭で紹介したELYZA Tasks 100を用いた性能評価の結果です。

ELYZA Tasks 100

ELYZA Tasks 100は、LLM の指示に従う能力や、ユーザーの役に立つ回答を返す能力を測ることを目的とした日本語ベンチマークです。

このベンチマークを用いた性能評価は、人手で行われており、評価対象のテキストに紐づくモデル名を隠し、シャッフルした状態でのブラインド性能評価を行っています。

また、最終的な評価は、3人の評価者によるスコアを平均したスコアになっています。

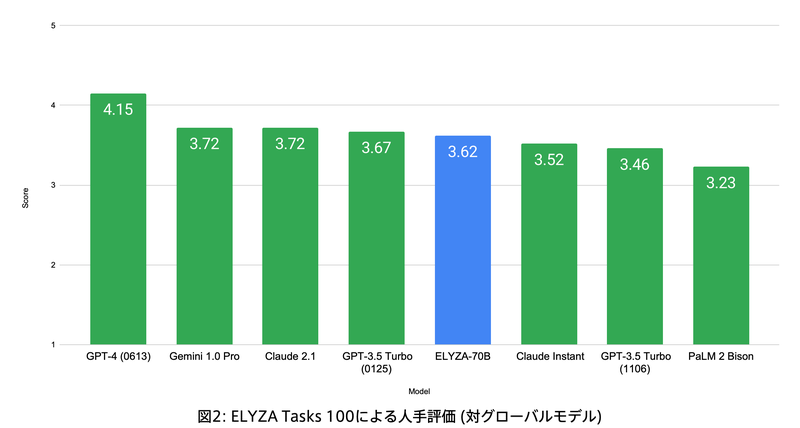

結果は先ほどもグラフを示しましたが、よりGPT 3.5などのグローバルモデルと比較しやすいように拡大されたものを示します。

このように、日本語能力においてはGPT-3.5やClaude2.1、そして比較的新しいGemini 1.0 Proに匹敵する性能を有しています。

また、既存の日本語LLMは、ELYZA-japanese-Llama-2-70bと同じようにLlama 2をベースにしたものが多いですが、それらと比較しても高い性能を示しており、ELYZAの追加事前学習と事後学習の高い効果が伺えます。

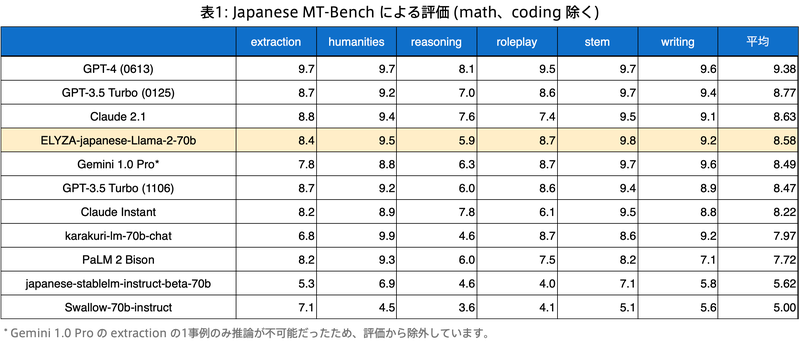

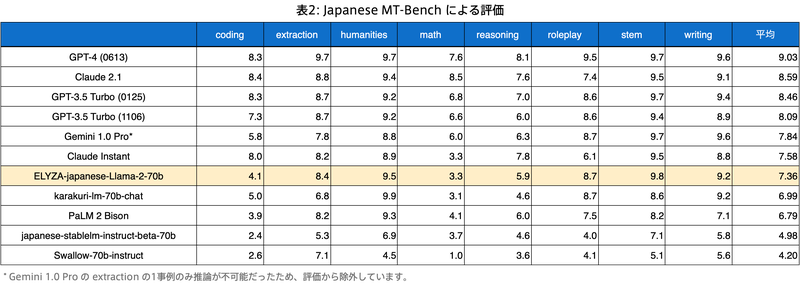

Japanese MT-Bench

Japanese MT-BenchはStability AI社が提供しているベンチマークで、英語のMT-Benchを日本語訳して作られています。

基となったMT-BenchはLLMの対話性能を測るためのベンチマークで、8つのカテゴリに分かれた80件の対話から応答の適切さを評価します。

以下の表は、Japanese MT-Benchでの評価結果です。

まずは、日本語能力の関係ないCodingやmathタスクを除いた結果です。

引用元:https://note.com/elyza/n/n0ea755ca3e7b#95586403-bc59-438a-aebf-b430d9d42b31

ELYZA-japanese-Llama-2-70bは、Gemini 1.0 ProやGPT-3.5 Turbo (1106)を平均スコアで上回るなど、ELYZA Tasks 100での結果と同様にこれらのグローバルモデルと遜色ない性能を有していることが確認できました。

また、humanities, stem, writingタスクでは、GPT-4(0163)と同等のスコアを獲得しています。

続いて、Coddingやmathタスクを含めた結果です。

引用元:https://note.com/elyza/n/n0ea755ca3e7b#95586403-bc59-438a-aebf-b430d9d42b31

日本語能力の関係ないCoddingやmathタスクに関しては、Gemini 1.0 ProやGPT-3.5 Turbo (1106)などと比較して大幅に低いスコアになっているので、この点は改善のする必要がありそうです。

ここからは、実際にELYZA-japanese-Llama-2-70bを使用して、実際の性能を確かめようと思います。

なお、ELYZA-japanese-Llama-2-13bについて知りたい方はこちらの記事をご覧ください。

→【ELYZA-japanese-Llama-2-13b】東大スタートアップがGPT3.5を超えるLLMを開発!使い方〜実践まで

ELYZA-japanese-Llama-2-70bの使い方

ELYZA-japanese-Llama-2-70bは、「ELYZA LLM for JP」という名前でチャットボット形式のデモが公開されており、以下のリンクにアクセスすることで利用できます。

このデモでは、70Bクラスのモデルで問題となる推論速度の低下という問題を解決するため、Speculative Decodingと呼ばれる高速化技術を導入しています。

Speculative Decodingは、自動回帰的翻訳(AT)と非自動回帰翻訳(NAT)の両方の利点を組み合わせることにより、翻訳の速度を損失なしで向上させることを目的とする新しいデコーディングパラダイムです。

この技術の導入により、可能な限り性能を維持しつつ、よりスムーズな応答を実現しています。

それでは、実際に使ってみましょう。

上記のリンクにアクセスすると以下のような画面になります。

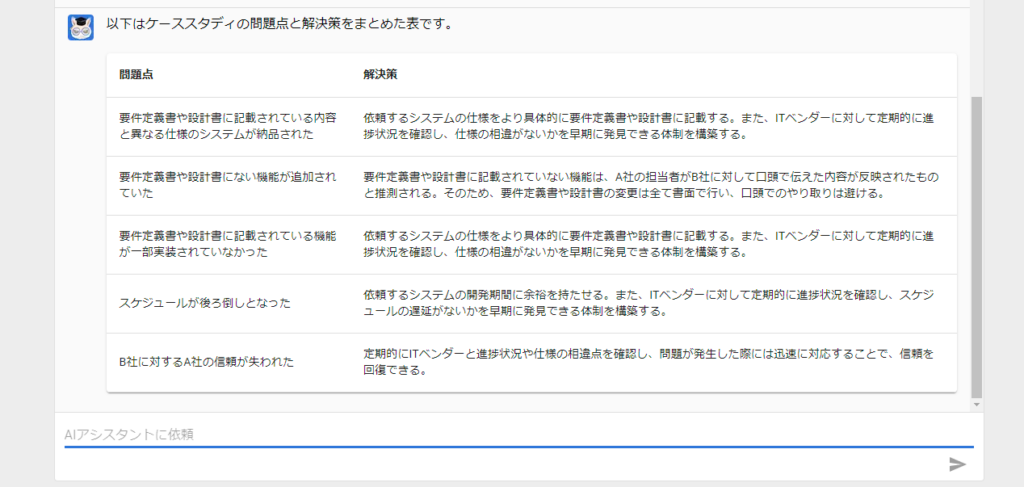

いくつかのサンプルプロンプトが用意されているので、その中の情報処理(表形式)を実行してみましょう。

以下のケーススタディにおける問題点と解決策を表にまとめて。

<ケーススタディ>

A社は自社の基幹システムを刷新するため、ITベンダーのB社にシステム開発を依頼しました。A社はB社に対して要件定義書と設計書を私、3か月後に納品を依頼しました。

しかし、3か月後にB社から納品されたシステムはA社の要件定義書や設計書とは異なる仕様となっていました。A社はB社に対して仕様の相違点を指摘・修正を依頼しました。

その後B社はA社からの指摘事項を修正し、再びシステムを納品しました。しかし今度はA社の要件定義書や設計書にはない機能が追加されていました。A社はB社に対して追加された機能を削除するよう依頼しました。

B社はA社からの依頼通り、追加した機能を削除し、システムを再び納品しました。しかし今度はA社の要件定義書や設計書に記載されている機能が一部実装されていませんでした。A社はB社に対し要件定義書や設計書に記載されている機能を全て実装するよう依頼しました。

このようなやりとりが続き、結果としてA社が想定していたスケジュールは後ろ倒しを余儀なくされ、B社に対するA社の信頼も失われてしまいました。結果はこのようになりました。

以下はケーススタディの問題点と解決策をまとめた表です。

問題点 解決策

要件定義書や設計書に記載されている内容と異なる仕様のシステムが納品された 依頼するシステムの仕様をより具体的に要件定義書や設計書に記載する。また、ITベンダーに対して定期的に進捗状況を確認し、仕様の相違がないかを早期に発見できる体制を構築する。

要件定義書や設計書にない機能が追加されていた 要件定義書や設計書に記載されていない機能は、A社の担当者がB社に対して口頭で伝えた内容が反映されたものと推測される。そのため、要件定義書や設計書の変更は全て書面で行い、口頭でのやり取りは避ける。

要件定義書や設計書に記載されている機能が一部実装されていなかった 依頼するシステムの仕様をより具体的に要件定義書や設計書に記載する。また、ITベンダーに対して定期的に進捗状況を確認し、仕様の相違がないかを早期に発見できる体制を構築する。

スケジュールが後ろ倒しとなった 依頼するシステムの開発期間に余裕を持たせる。また、ITベンダーに対して定期的に進捗状況を確認し、スケジュールの遅延がないかを早期に発見できる体制を構築する。

B社に対するA社の信頼が失われた 定期的にITベンダーと進捗状況や仕様の相違点を確認し、問題が発生した際には迅速に対応することで、信頼を回復できる。与えられたケーススタディから、問題点と解決策が非常によくまとめられており、特に解決策に関してはかなり具体的な施策が提案されています。

また、出力時間はおよそ0.5秒程度であり、しっかりと性能を維持しながら高速化できているようです。

ここからは、ELYZA-japanese-Llama-2-70bの性能をさらに深堀すべく、GPT-4とGPT3.5 Turboとの比較を主に日本語能力の面で行っていきます。

ELYZA-japanese-Llama-2-70bの推しポイントである高い日本語能力は本当なのか検証してみた

ここからは、ELYZA-japanese-Llama-2-70bの性能をさらに深堀りするため、GPT-4 TurboとGPT3.5 Turboとの比較を行っていきます。

前述したベンチマークでは、ELYZA-japanese-Llama-2-70bはGPT3.5 Turboと同等の性能を有していることが示されていましたが、実際にそのような性能を有しているのかこの比較で検証します。

また、現状最強モデルであるGPT-4 Turboに対して、どの程度の出力をしてくれるのかについても比較検証します。

今回は、以下の項目を比較していきます。

・日本語能力(メール作成)

・日本語能力(文章要約)

・知識

・コーディング

早速検証していきましょう!

日本語能力(メール作成)

以下のプロンプトを入力して、出力された回答を比較します。

日本語でクライアントに送信する丁寧語・謙譲語を正しく使用したビジネスメールを作成してください。

結果はこのようになりました。

ELYZA-japanese-Llama-2-70b

[会社名] [部署名]

[相手の名前]

お世話になっております。

[会社名]の[氏名]です。

本日は、[件名]のご連絡をいただきまして

誠にありがとうございます。

[相手の名前]様からいただいたお問い合わせについて、

以下の通り回答いたします。

---------------

[件名]

[相手からの問い合わせ内容]

[会社名]としましては、[内容]と考えております。

ただし、[相手の会社名]様の状況によって

対応が異なる可能性があります。

お手数をおかけし恐縮ですが、

詳細につきましては、別途お問い合わせいただけますと

幸甚に存じます。

---------------

お忙しい中恐れ入りますが、

ご確認の程、よろしくお願いいたします。

ーーーーーーーーーーーーーー

[会社名]

[氏名]

E-mail:[メールアドレス]

TEL:[電話番号]

ーーーーーーーーーーーーーーGPT-4 Turbo

件名:【ご依頼内容の確認及び今後の進行について】

拝啓 春の候、貴社におかれましてはますますご清栄のこととお慶び申し上げます。平素は格別のご高配を賜り、誠にありがとうございます。

さて、先日はご依頼内容に関する詳細なご説明、ならびに貴重なご意見を賜り、ありがとうございました。貴社からのご依頼内容に基づき、弊社での対応策について検討を重ねた結果、ご提案させていただく内容がまとまりましたので、下記の通りご報告申し上げます。

【ご提案内容】

提案事項1:(詳細説明)

提案事項2:(詳細説明)

提案事項3:(詳細説明)

上記の内容につきまして、貴社のご意向を伺いたく存じます。ご確認の上、何かご不明点や追加でご要望がございましたら、お気軽にお申し付けください。また、今後の進行スケジュールに関しましても、貴社のご都合を優先させていただきますので、ご希望の日程等がございましたら、合わせてお知らせいただけますと幸いです。

貴社のさらなる発展とご繁栄を心よりお祈り申し上げます。今後とも変わらぬご支援とご協力を賜りますよう、お願い申し上げます。

敬具

(あなたの名前)

(あなたの役職)

(あなたの連絡先メールアドレス)

(あなたの電話番号)

(会社名)GPT3.5 Turbo

もちろんです。以下はビジネスメールの例です。

件名: お問い合わせへのご返信

拝啓 [クライアント様のお名前] 殿

いつもお世話になっております。[貴社名]の[お名前]でございます。この度は、お問い合わせいただきまして、誠にありがとうございます。

お問い合わせいただきました内容について、以下のようにご案内申し上げます。

[ここにお問い合わせ内容に対する具体的な回答や情報を記入します]

また、お困りの点や疑問点がございましたら、何なりとお申し付けください。お手伝いさせていただければ幸いです。

お忙しい中、お問い合わせいただきまして誠にありがとうございました。今後とも何卒よろしくお願い申し上げます。

敬具

[貴社名] [お名前]

このような形式で、丁寧語と謙譲語を使用して、クライアントに対する適切なビジネスメールを送信することができます。結果は、ELYZA-japanese-Llama-2-70bのものはGPT-4やGPT3.5のものと比較して少しぎこちない感じがします。

妙にメールの本文が区切られており、そのままだと読みにくく感じました。

ただ、文章自体はとても自然で、日本語能力の高さを感じ、GPT-4と比較しても遜色ないレベルだと思います。

日本語能力(文章要約)

ここでは、Gemini Ultraに生成してもらった以下の2000字程度のLLMの動向に関する文章を入力して、要約してもらいます。

近年、LLM(大規模言語モデル)は目覚ましい進歩を遂げています。これは、主に以下の要因によるものです。

1. データ量の増加

LLMは、大量のテキストデータで訓練されます。近年、インターネットの普及により、書籍、記事、ブログ、ソーシャルメディアなど、テキストデータ量が爆発的に増加しています。このデータ量の増加により、LLMはより複雑な言語処理を学習できるようになりました。

2. コンピューティング能力の向上

LLMの訓練には、膨大な計算資源が必要です。近年、GPUなどの高性能なコンピューティングハードウェアの開発が進み、LLMの訓練がより効率的に行えるようになりました。

3. アルゴリズムの改良

LLMの訓練に使用されるアルゴリズムも、近年改良されています。例えば、Transformerと呼ばれるニューラルネットワークアーキテクチャの登場により、LLMの性能が大幅に向上しました。

これらの要因により、近年LLMは以下のような進歩を遂げています。

1. 生成能力の向上

LLMは、より流暢で自然な文章を生成できるようになりました。また、詩、コード、脚本、音楽作品など、さまざまな形式のテキストコンテンツを生成できるようになりました。

2. 理解能力の向上

LLMは、より複雑な文章を理解できるようになりました。また、質問の意図を正確に把握し、適切な回答を提供できるようになりました。

3. 推論能力の向上

LLMは、与えられた情報から論理的に推論できるようになりました。例えば、ある事実と別の事実の関係を理解し、新しい事実を導き出すことができます。

これらの進歩により、LLMはさまざまな分野で活用されるようになっています。

1. 創作活動

LLMは、小説、脚本、音楽作品などの創作活動に活用されています。例えば、LLMを使用して小説の続きを書いたり、脚本のアイデアを生成したり、音楽作品を作曲したりすることができます。

2. 情報検索

LLMは、情報検索の精度向上に活用されています。例えば、LLMを使用して、検索クエリの意図を理解し、関連性の高い情報を提供することができます。

3. 顧客サービス

LLMは、顧客サービスの自動化に活用されています。例えば、LLMを使用して、顧客からの質問に自動的に回答したり、顧客のニーズに合わせた商品を提案したりすることができます。

4. 教育

LLMは、教育分野にも活用されています。例えば、LLMを使用して、生徒一人ひとりに合わせた学習教材を作成したり、学習の進捗状況を管理したりすることができます。

今後の展望

LLMは今後も進歩し続けると予想されます。データ量の増加、コンピューティング能力の向上、アルゴリズムの改良により、LLMはさらに人間に近い能力を獲得するでしょう。

将来的には、LLMは以下のようなことができるようになるかもしれません。

1. 人間との自然な会話

LLMは、人間と自然な会話ができるようになるでしょう。LLMは、人間の感情を理解し、それに応じた適切な反応をすることができるようになります。

2. 創造的な仕事の共同作業

LLMは、人間と共同で創造的な仕事ができるようになるでしょう。LLMは、人間のアイデアを理解し、それを発展させるための提案をすることができます。

3. 複雑な問題の解決

LLMは、人間と協力して複雑な問題を解決できるようになるでしょう。LLMは、膨大な量のデータを分析し、問題解決のための新しいアイデアを見つけることができます。

LLMは、私たちの生活を大きく変える可能性を秘めています。今後もLLMの進歩に注目していきたいと思います。

課題

LLMの発展には、いくつかの課題もあります。

1. バイアス

LLMは、訓練データに含まれるバイアスを反映してしまう可能性があります。そのため、LLMは公平性、倫理性に配慮して開発する必要があります。

2. 説明責任

LLMは、複雑なシステムであり、その動作を説明することが難しい場合があります。そのため、LLMは透明性、説明責任に配慮して開発する必要があります。

3. セキュリティ

LLMは、悪意のある目的で使用される可能性があります。そのため、LLMは安全性、セキュリティに配慮して開発する必要があります。

これらの課題を克服することで、LLMはより社会に貢献できる技術となるでしょう。結果はこのようになりました。

ELYZA-japanese-Llama-2-70b

承知いたしました。与えられた文章を要約します。

要約:

近年、LLM (大規模言語モデル) は目覚ましい進歩を遂げている。これは、データ量の増加、コンピューティング能力の向上、アルゴリズムの改良によるものである。

LLMは、生成能力、理解能力、推論能力などを向上させ、創作活動、情報検索、顧客サービス、教育などの分野に活用されている。今後もLLMは進歩し続け、人間に近い能力を獲得すると予想される。

しかし、LLMの発展には、バイアス、説明責任、セキュリティなどの課題もある。GPT-4 Turbo

近年、大規模言語モデル(LLM)は、インターネット上のテキストデータ量の増加、コンピューティング能力の向上、およびアルゴリズムの改良により目覚ましい進歩を遂げています。

これにより、LLMはより流暢で自然な文章を生成し、複雑な文章の理解や論理的な推論が可能になりました。これらの能力の向上により、創作活動、情報検索、顧客サービス、教育など、様々な分野での活用が進んでいます。

将来的には、人間との自然な会話、創造的な仕事の共同作業、複雑な問題の解決が可能になると期待されています。

しかし、バイアスの反映、説明責任の難しさ、セキュリティ問題など、克服すべき課題も存在します。これらを解決することで、LLMはさらに社会に貢献する技術となるでしょう。GPT3.5 Turbo

近年、LLM(大規模言語モデル)は目覚ましい進歩を遂げています。この進歩は、主に以下の要因によるものです。

第一に、テキストデータ量の増加が挙げられます。近年のインターネットの普及により、テキストデータの量が爆発的に増加し、LLMがより複雑な言語処理を学習できるようになりました。

第二に、コンピューティング能力の向上があります。高性能なコンピューティングハードウェアの開発により、LLMの訓練がより効率的に行われるようになりました。

最後に、アルゴリズムの改良も大きな影響を与えています。例えば、Transformerというニューラルネットワークアーキテクチャの登場により、LLMの性能が大幅に向上しました。

これらの進歩により、LLMは生成能力、理解能力、推論能力が向上し、さまざまな分野で活用されています。創作活動、情報検索、顧客サービス、教育などがその例です。

将来的には、LLMは人間との自然な会話や創造的な仕事の共同作業、複雑な問題の解決など、さらなる進化が期待されます。

ただし、LLMの発展にはいくつかの課題も存在します。その中にはバイアス、説明責任、セキュリティなどがあり、これらを克服することが重要です。これらの結果を比較すると、ELYZA-japanese-Llama-2-70bのものはとても簡潔にまとめられていますが、やや簡略化しすぎている部分もあります。

一方のGPT-4のものは、よくまとめられていると思いますが、逆にやや文章が冗長で結論が弱いといった短所もあり、総合的に見れば、ELYZA-japanese-Llama-2-70bの要約の方が要約として適切だと感じます。

最後のGPT-3.5のものは、こちらもよくまとめられており、文章量的にもバランスがとれており、要約としては一番優れていると感じました。

知識

以下のプロンプトを入力して、正しい情報が出力できるか検証します。

日本の山の標高ランキングTOP5を教えて

結果はこのようになりました。

ELYZA-japanese-Llama-2-70b

日本の山の標高ランキングTOP5は、以下の通りです。

1位: 富士山 (標高3,776m) 静岡県・山梨県

2位: 北岳 (標高3,193m) 山梨県

3位: 剣山 (標高3,003m) 徳島県・香川県

4位: 中岳 (標高2,999m) 山梨県

5位: 間ノ岳 (標高2,932m) 山梨県・静岡県

※標高は、一等三角点の標高を記載しています。

また、同じ標高の山が複数ある場合は、一等三角点の標高が一番高い山を上位としています。GPT-4 Turbo

日本の山の標高ランキングTOP5は以下の通りです:

富士山: 3776メートル

北岳: 3193.2メートル

奥穂高岳: 3190メートル

間ノ岳: 3190メートル

槍ヶ岳: 3180メートル

詳細は、Wikipediaのページでご覧いただけます。GPT3.5 Turbo

2022年1月時点での日本の山の標高ランキングTOP5は以下の通りです:

富士山 - 標高3,776メートル

北岳(剱岳)- 標高3,190メートル

南岳 - 標高3,189メートル

立山 - 標高3,015メートル

御嶽山 - 標高2,999メートル

ただし、山の標高は測量の精度や地形の変化によって変動する可能性があります。結果は、GPT-4のみ正解でした。

日本の山の正しい標高ランキングTOP5は、

- 富士山(3,776m)

- 北岳(3,193m)

- 奥穂高岳(3,190m)

- 間ノ岳(3.190m)

- 槍ヶ岳(3,180m)

です。

ただ、GPT-4はWeb検索機能があり、この出力もWikipediaから拾ってきたもののようなので、実際に正しい知識を持っているかは不明です。

ELYZA-japanese-Llama-2-70bとGPT-3.5に関しては、どちらも正しくない回答を出力し、リストアップされている山も違えば、標高もデタラメなものになっています。

ELYZA-japanese-Llama-2-70bに関しては、知識はLlama2 70bベースなので、GPT-4などと比較すると特に日本に関することの知識は少なくなっているのかと思います。

コーディング

最後に、以下のプロンプトを入力して、簡単なコーディングができるか検証します。

Pythonで回帰分析のコードを書いてください。

ELYZA-japanese-Llama-2-70b

以下はPythonを使った回帰分析の基本的なコードです。

import numpy as np

import pandas as pd

from sklearn import linear_model

データの準備

X = pd.DataFrame(np.random.rand(100, 10))

y = pd.DataFrame(np.random.rand(100))

回帰分析モデルの作成

model = linear_model.LinearRegression()

モデルのフィッティング

model.fit(X, y)

予測値の計算

y_pred = model.predict(X)

モデルの評価

r2 = model.score(X, y)

このコードでは、NumPyとPandasを使ってデータを準備し、Scikit-learnのLinearRegressionクラスを使って回帰分析モデルを作成しています。

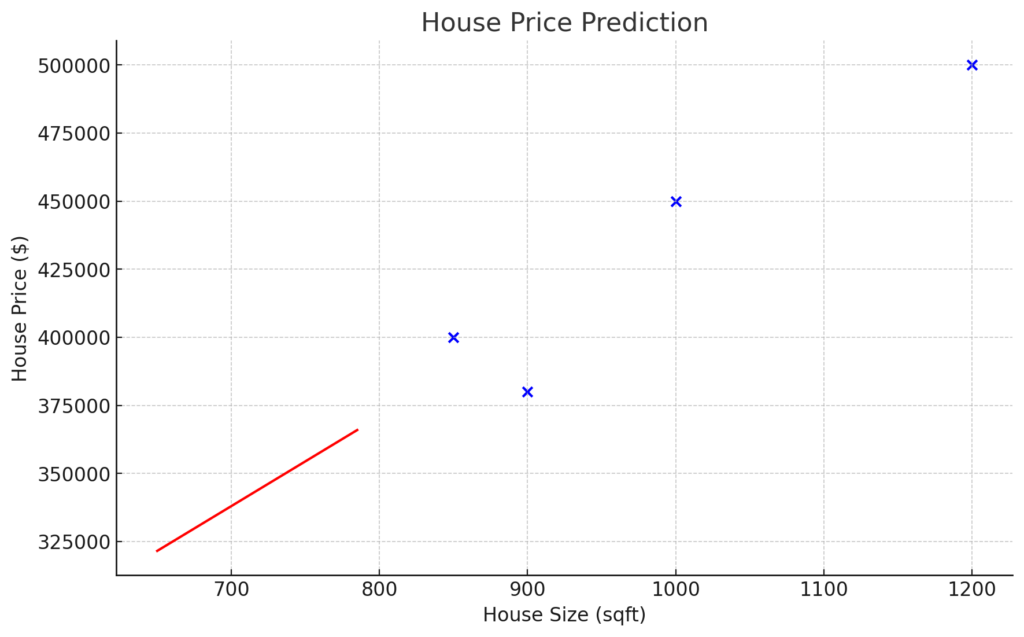

そして、モデルをフィッティングし、予測値を計算しています。最後に、モデルの性能を評価しています。GPT-4 Turbo

# Importing necessary libraries

import numpy as np

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

import matplotlib.pyplot as plt

# Example data

# Let's assume we have data of house sizes and their prices

data = {

'House Size (sqft)': [650, 785, 1200, 1000, 850, 900],

'House Price ($)': [300000, 350000, 500000, 450000, 400000, 380000]

}

df = pd.DataFrame(data)

# Splitting the data into training and test sets

X = df[['House Size (sqft)']]

y = df['House Price ($)']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Training the model

model = LinearRegression()

model.fit(X_train, y_train)

# Predicting the prices

predictions = model.predict(X_test)

# Plotting

plt.scatter(X_train, y_train, color='blue')

plt.plot(X_test, predictions, color='red')

plt.title('House Price Prediction')

plt.xlabel('House Size (sqft)')

plt.ylabel('House Price ($)')

plt.show()

簡単な線形回帰分析を実行するためのPythonコード・スニペットです。この例では、家の大きさとそれに対応する価格を含むデータセットを使用しています。

このコードでは、データを学習セットとテストセットに分割し、学習データで線形回帰モデルを学習し、テストデータで予測を行います。結果のプロットは、学習データの点と、家のサイズに基づいて家の価格を予測する線形回帰直線を可視化します。

GPT3.5 Turbo

回帰分析を行うためには、一般的に使用されるライブラリである`scikit-learn`を使用することができます。以下に、Pythonで簡単な線形回帰分析のコード例を示します。

```python

import numpy as np

from sklearn.linear_model import LinearRegression

import matplotlib.pyplot as plt

# サンプルデータを生成

np.random.seed(0)

X = 2 * np.random.rand(100, 1)

y = 4 + 3 * X + np.random.randn(100, 1)

# モデルの選択と学習

model = LinearRegression()

model.fit(X, y)

# パラメータの推定値

print("切片:", model.intercept_)

print("係数:", model.coef_)

# 新しいデータに対する予測

X_new = np.array([[0], [2]])

y_pred = model.predict(X_new)

# 結果の可視化

plt.scatter(X, y)

plt.plot(X_new, y_pred, color='red')

plt.xlabel('X')

plt.ylabel('y')

plt.title('Linear Regression')

plt.show()

```

このコードは、ランダムに生成されたデータに対して線形回帰を適用し、学習したモデルのパラメータを出力し、新しいデータに対する予測を行い、結果を可視化します。データに合わせて適切に修正してください。結果は、どのモデルの出力したコードも正しく動作するものになっています。

ただ、やはりこの中で突出して高い性能を示したのはGPT-4であり、他のモデルのコードではやっていない結果の可視化などもコードに含まれています。

ELYZA-japanese-Llama-2-70bとGPT-3.5のコードに大きな差はありませんでしたが、もっと複雑なコードになると差が出て来ることが予想されます。

今回の比較検証の結果をまとめると、ELYZA-japanese-Llama-2-70bは日本語による追加事前学習と事後学習により、日本語能力に関してはLlama2 70bより大幅に高く、他のグローバルモデルに匹敵することがわかりました。

ただ、知識面に関しては、Llama2 70bがベースということもあり、かなり不足している印象ですが、GPT-3.5も同様の問題を抱えているようなので、ELYZA-japanese-Llama-2-70bのみの問題ではなさそうです。

また、コーディング能力については、簡単なコーディングであればベンチマークで出ていたほどの差は出なさそうですが、複雑なコーディングをさせようとすると、かなり顕著な差が出そうです。

ELYZAでは、今後も継続して日本語LLMの開発に取り組まれるそうなので、より高性能な日本語LLMが登場することに期待が高まりますね!

なお、日本語とコーディングに特化したELYZA japanese CodeLlama 7bについて知りたい方はこちらの記事をご覧ください。

→【ELYZA japanese CodeLlama 7b】日本語版CodeLlamaの性能をGPT-4と徹底比較してみた

ELYZA-japanese-Llama-2-70bは最新最強の日本語LLM

ELYZA-japanese-Llama-2-70bは、日本のELYZA社によって構築された最新の日本語特化LLMです。

このモデルは、これまでのELYZAが開発した日本語モデルと同様に「Llama2」をベースに、日本語の追加事前学習と事後学習を行い、Llama2が持つ強力な英語能力を日本語に対する言語能力に拡張させています。

その性能は、後ほど詳しく見ていきますが、ELYZA Tasks 100という独自の日本語ベンチマークを用いた性能評価では、既存の日本語LLMを大きく上回っており、GPT-3.5 TurboやClaude 2.1などに匹敵する性能を示しました。

実際に使ってみた感想は、日本語能力は他のグローバルモデルに匹敵する高い日本語能力を示しましたが、知識面では不足している印象でした。

また、コーディングタスクについては簡単なものだとベンチマークで出ていたほどの差は感じられませんでしたが、より複雑なコーディングタスクになると、差が出てくるように感じました。

ELYZAは、このような日本語LLMを多数開発しており、今後も開発を続けられるそうなので、今後の動向に目が離せませんね!

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。