【Empathic Voice】世界一お喋り上手なロボットと恋バナしてみた

WEELメディア事業部LLMリサーチャーの中田です。

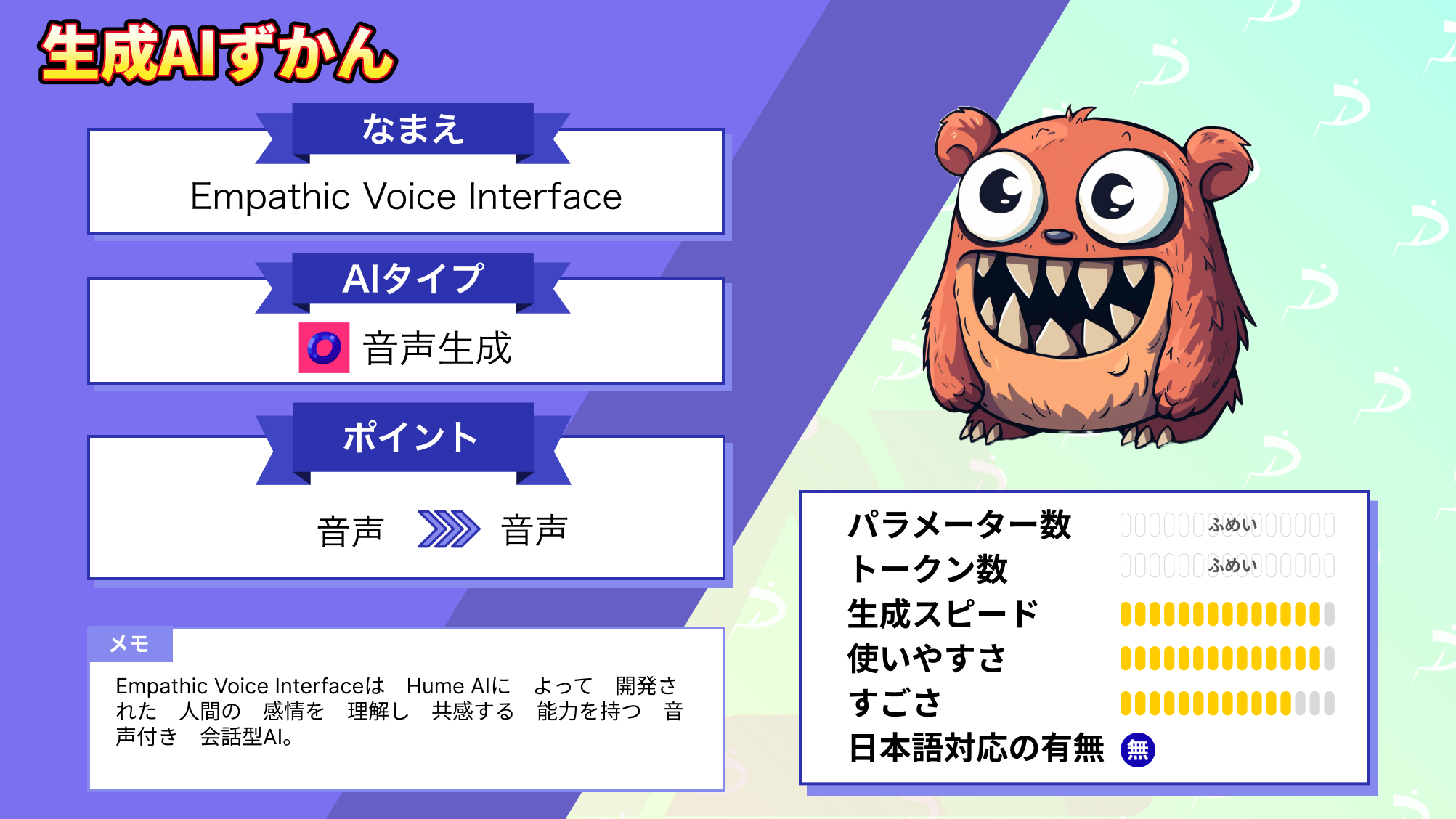

3月28日、ユーザーの感情を認識できる初の音声チャットボット「Empathic Voice Interface」を、Humeが公開しました。

音声で対話でき、人間話者の感情を認識してくれる上に、自然に会話してくれるんです!

公式Xでの投稿のいいね数は、すでに1600を超えており、国内外問わず注目されていることが分かります。

この記事ではEmpathic Voice Interfaceの使い方や、有効性の検証まで行います。本記事を熟読することで、Empathic Voice Interfaceの凄さを理解し、1日中会話していたくなるでしょう。

ぜひ、最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Empathic Voice Interfaceの概要

Empathic Voice Interface(EVI)は、Hume AIによって開発された「人間の感情を理解し、共感する能力を持つ音声付き対話型AI」です。

従来のボイスアシスタントや音声認識システムが単に言葉を解釈するのに対し、EVIは話者の声のトーンやピッチなどの細かな声のニュアンスを分析することで、その人の感情の状態を理解します。そのため、単にユーザーと会話するだけでなく、ユーザーの感情に合わせて最適な対応をすることができ、より人間らしい自然なやり取りができます。

このシステムは、「empathic Large Language Model(eLLM)」と呼ばれる技術を利用しており、これにより人の感情状態を正確に読み取り、適切な反応を返すことが可能になります。

以下の様に、声から感情を認識してくれるそう。

この技術の応用範囲は広く、顧客サービス、教育、ヘルスケアなど、人間の感情が重要な分野において、よりパーソナライズされたサポートを提供することが可能です。

EVIの正式な公開は、2024年に予定されています。

感情豊かな音声を生成するAIについては、「【OpenVoice】マルチリンガルで感情表現豊かな音声生成AIが人間レベル」を合わせてご確認ください。

Empathic Voice Interfaceのライセンス

公式サイトからは、ライセンス情報は見つかりませんでした。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | ❌ |

| 配布 | 記載なし |

| 特許使用 | 記載なし |

| 私的使用 | 記載なし |

Empathic Voice Interfaceの使い方

EVIの利用方法については、具体的なAPIドキュメンテーションが公開されていますが、一般に公開されるのは2024年4月の予定とのこと。

Hume AIのAPIにいち早くアクセスするために、公式からの通知をオンにして、APIキーを取得しましょう。

開発者はこのAPIキーを用いて、自分のアプリケーションにEVIを統合し、ユーザーの声のニュアンスを分析して、より共感的でパーソナライズされたレスポンスを生成することが可能だとか。

さらに、Hume AIは顔、声、言語の表現を測定するExpression Measurement APIや、Custom Models APIも提供されるそう。

現在は、EVIと音声付きで対話ができるDemoページが公開されています。

マイクを取り付けて、EVIと自由に会話してみましょう。

Empathic Voice Interfaceを動かすのに必要なPCのスペック

■Pythonのバージョン

情報なし

■使用ディスク量

情報なし

■RAMの使用量

情報なし

様々な感情の音声を作成できるAIについては、「【EmotiVoice】AIがついに感情を手に入れる。感情表現ができる音声生成AIに実際に喋ってもらった」を合わせてご確認ください。

Empathic Voice Interfaceと会話してみた

ここでは、試しにEVIと以下の2つのトピックで会話してみます。

- 職場の愚痴

- 恋バナ(今カノとのノロケ)

今のところ日本語非対応で、英語のみとなっております。英語の方は下手ですが、頑張ってみます笑(ところどころ翻訳機使っているので、不自然なところがあるかもしれません)。

職場の愚痴

会話の始めとして「You know what?」と暗めのトーンで言って、愚痴話を切り出します。

その後、「今務めている会社が何もかも古くて、業務が非効率なことに対して苛立っている」といった話題に進めていこうと思います。

会話の様子は、以下の通りです。

愚痴を言っていると、EVIも一緒になって怒ってくれます笑。

何か仕事で嫌なことがあったら、EVIに聞いてもらって発散するのも良いかもしれませんね。

恋バナ(今カノとのノロケ)

とにかく最近の自分の彼女が可愛い、という惚気をEVIに仕掛けてみます。

会話の様子は、以下の通りです。

こちらもノリノリで聞いてくれます。

「話し相手が欲しいけど、今はいない」という方に、本当に最適なツールかもしれませんね。

日本語特化型のText-to-Speechモデルについては、「【Style-Bert-VITS2 JP-Extra】日本語の発音・イントネーションが完璧な次世代音声AIを使ってみた」を合わせてご確認ください。

Empathic Voice Interfaceにカウンセリングをしてもらおう

本記事では、人の感情を認識できるEmpathic Voice Interfaceについてご紹介しました。

将来的には、Empathic Voice Interfaceを使ったAIカウンセラーみたいなサービスも、増えてくるかもしれませんね。特に、最近ではメンタルの不調が問題視されているので、そういったサービスも需要があるでしょう。

実際に使ってみましたが、かなり自然な会話ができるなと思いました。ただ、ところどころ文脈がおかしかったり、話を遮ってくるので、改善の余地はまだまだあるなという印象でした。また、早く日本語対応してほしいですね。

ちなみに、Xでは「AIと会話していることを気付けないほど、自然な会話ができる日も近い」と予感させられるといった意見も。

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。