Gemini 2.5 Flashを徹底解説!料金・使い方・他モデルも比較

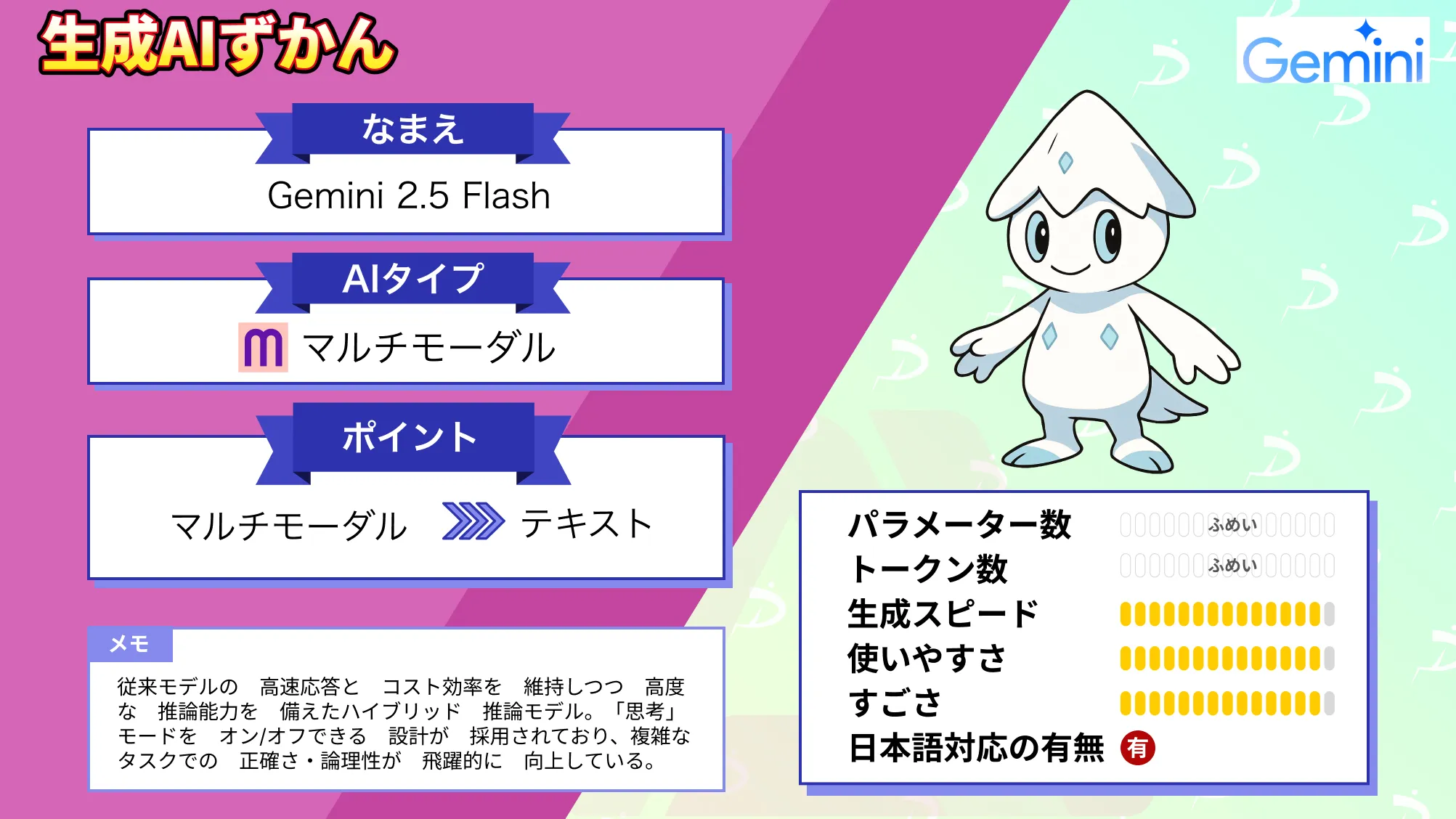

- 「思考」モードをオン/オフできる設計

- マルチモーダル対応の汎用モデルで、テキスト・コード・画像・音声・動画を入力として受け取る

- 従来モデルと比較し、複雑なタスクでの正確さ・論理性が飛躍的に向上

2025年4月、Googleから新たな大規模言語モデル「Gemini 2.5 Flash」がリリースされました!

Gemini 2.5 Flashは、高速応答とコスト効率を維持しつつ高度な推論能力を備えた「ハイブリッド推論モデル」で、従来モデル(Gemini 2.0 Flash)の優れた基盤の上に構築されており、初めて「思考(thinking)」モードをオン/オフできる設計が採用されているようです。

本記事では、Gemini 2.5 Flashについて、概要や料金プラン、使い方まで徹底解説します。ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Gemini 2.5 Flash 概要

Gemini 2.5 Flashは、Google(Google DeepMind)が2025年4月18日にプレビューリリースした最新の大規模言語モデルです。

通常のチャットモデルは、ユーザへの返答をすぐ生成しますが、Gemini 2.5 Flashでは、必要に応じて応答前に内部で段階的な思考(推論)プロセスを実行し、質問内容を理解・分解して計画を立てることができます。

この「思考」モードにより、数学問題の解答や深い分析質問などの複雑な課題でも、段階的に推論を積み重ねてより正確で包括的な回答に到達することが可能です。

Gemini 2.5 Flashは、マルチモーダル対応の汎用モデルでもあり、テキスト・コード・画像・音声・動画を入力として受け取り、テキストで出力することができます。

コンテキストウィンドウは最大100万トークンに達し、非常に長大な入力にも対応可能です。知識の学習データは2025年1月までがカットオフとなっており、比較的新しい情報にも対応しています。

設計思想として、開発者がユースケースに応じて、品質・コスト・応答速度のバランスを柔軟に調整できることが重視されています。例えば、「思考」プロセスを無効化すれば、Gemini 2.0 Flashと同等の高速・低コスト動作を維持しつつ、モデル自体の改良により精度は向上しています。

アップデートされたGemini 2.5 Flash

2025年9月、Gemini 2.5 Flashがアップデートされました。

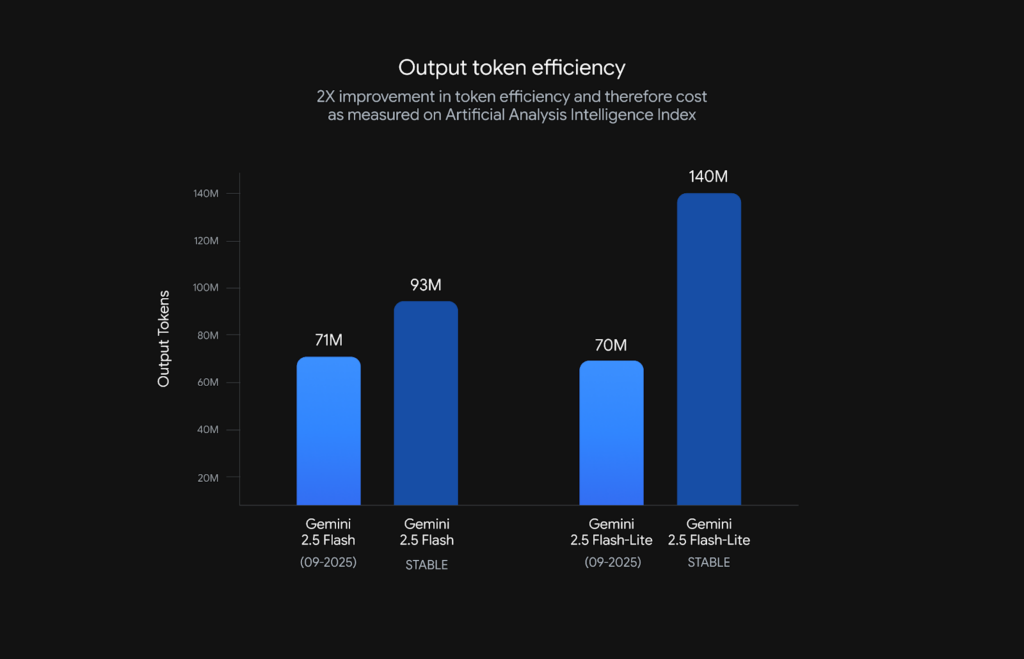

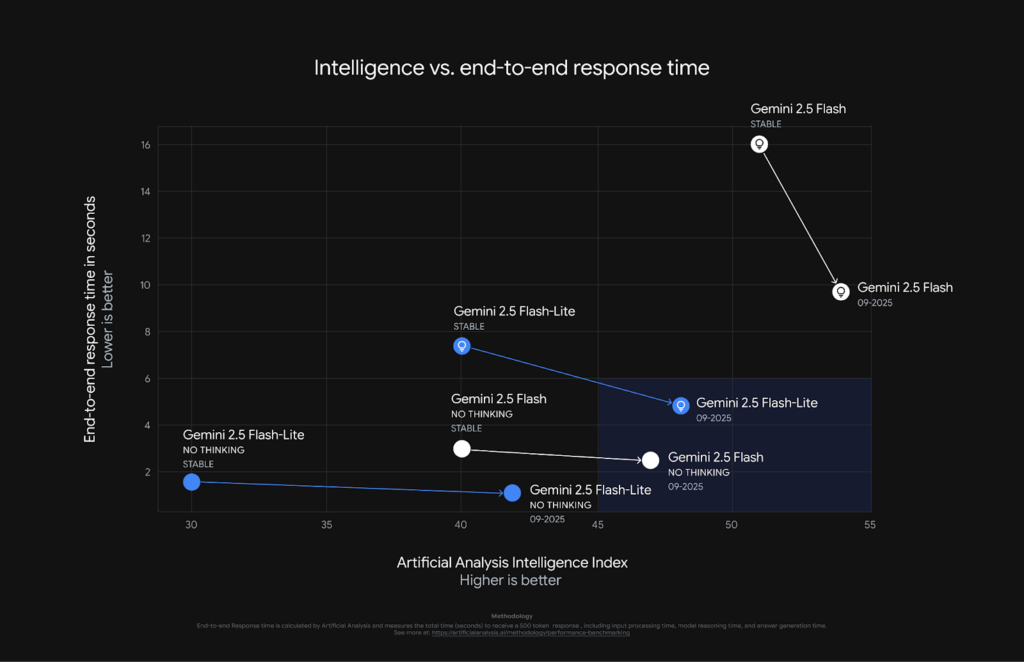

今回アップデートされたのは、Gemini 2.5 FlashとFlash liteの2つのモデル。ともに出力トークンは削減されており、Gemini 2.5 Flashでは24%の削減、Flash liteでは50%削減されています。

また両者ともに従来のGemini 2.5 FlashとFlash liteに比べ、品質と速度が向上。

Gemini 2.5 Flashのアップデート内容

Gemini 2.5 Flashのアップデート内容としては、下記の通りです。

- エージェント的タスク対応の強化

- Thinkingモードの効率化と高品質化

まずエージェント的タスク対応の強化ですが、Gemini 2.5 Flashではツール利用やマルチステップ推論を含むエージェント的な操作能力が向上しています。API呼び出しや外部ツール連携などをより適切なタイミングで実行。

また長い推論をより論理的に構築できるようになり、その結果SWE-Bench Verifiedで 48.9 % → 54 %(+5 ポイント) 改善しています。

Gemini 2.5 Flash liteのアップデート内容

Flash liteでは次の内容がアップデートされています。

- 複雑な指示に対する理解

- 冗長性の削減

- マルチモーダル・翻訳性能の向上

Flash liteでは従来に比べ、システムプロンプトや複雑な指示の理解・実行精度が大幅に改善しています。また、出力がより簡潔になりトークンコストを削減。

さらに音声認識の精度向上や画像理解力も向上しています。

なお、OpenAI発のコーディングモデルであるGPT-5-Codexについて詳しく知りたい方は、以下の記事も参考にしてみてください。

Gemini 2.0 Flash との違い

Gemini 2.5 Flashは前世代の2.0 Flashと比べ、推論性能が大幅に強化されています。

最大の違いは、前述の「思考」モードの有無で、Gemini 2.0 Flashはユーザへの応答を即座に生成する設計でしたが、Gemini 2.5 Flashでは必要に応じて内部で段階的推論を挟めるため、複雑なタスクでの正確さ・論理性が飛躍的に向上しました。

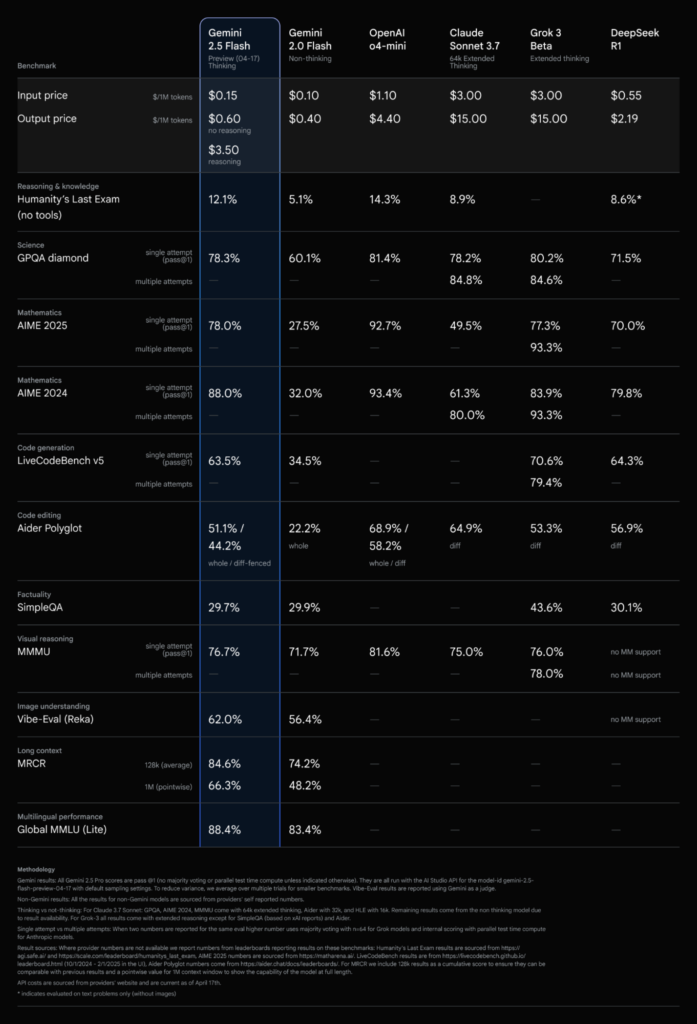

実際、極めて難度の高いベンチマーク「Humanity’s Last Exam (HLE)」での正答率は、Gemini 2.0 Flashの5.1%からGemini 2.5 Flashでは12.1%へと大きく向上しています。

これはOpenAIの新モデル「o4-mini」の14.3%に次ぐ水準で、Claude 3.7やDeepSeekなどの他社モデルを上回る成績となっています。

上記画像はGemini 2.5 Flashの性能一覧表です。料金は画像の価格から上がっていますが、性能に違いはありません。

また数学分野では、例えば数学競技試験「AIME 2025」において、単一試行での正解率がGemini 2.0 Flashの27.5%からGemini 2.5 Flashでは78.0%へ飛躍的に改善しており、多段階推論を要する問題への対応力が格段に上がっています。

加えて、コード生成の性能も強化されており、プログラミング課題でのスコアも大きく伸びています。

一方、一般的な知識質問への即答や単純な翻訳タスクなど「推論不要」の問題については、2.0 Flashも高い性能を持っているため2.5でも大差はありません。

Gemini 2.5 FlashとGemini 2.0 Flashで、マルチモーダル対応の範囲には大きな差はありません。どちらもテキスト・画像・音声・動画入力が可能で、多言語をサポートしており世界中の様々な言語での質問や翻訳に対応できます。

さらに、コンテキスト長も両者とも最大約100万トークンとなっており、特段相違点はありません。

最後に、速度とコストの面では、Gemini 2.5 Flashは、思考モードOFF時にはGemini 2.0 Flashと同等の低レイテンシーを保つよう最適化されています。モデル自体のサイズやアーキテクチャ詳細は公開されていませんが、Googleは「2.5への改良は速度やコストを妥協せず実現した」と報告しています。

Gemini 2.5 Flashの特徴

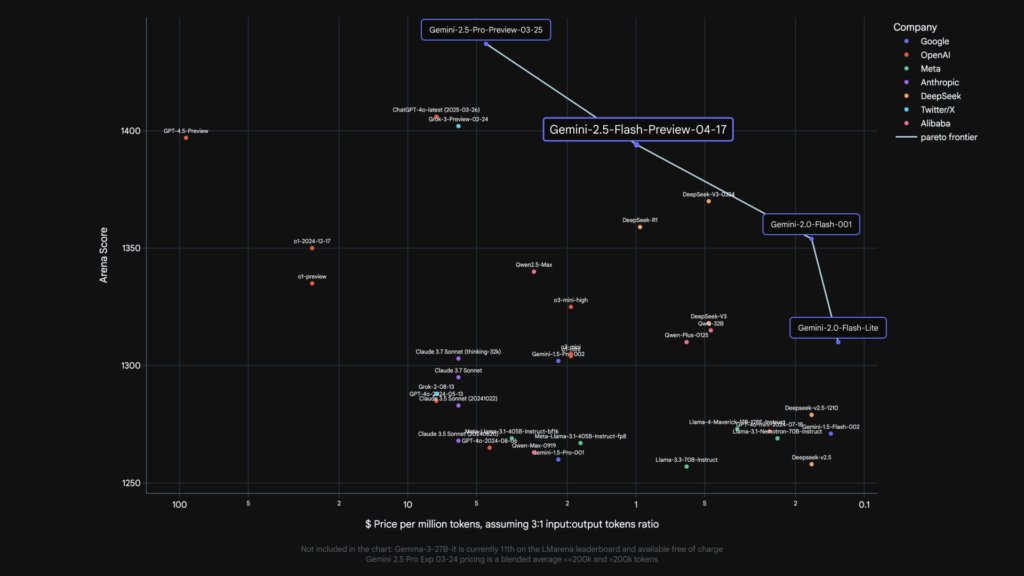

Gemini 2.5 Flashの特徴は推論モードのオン・オフを切り替えられる点、優れたコストパフォーマンスです。

Gemini 2.5 Flashは完全ハイブリッド推論モデルであり、ユーザーがThinkingモードのオン・オフを自由に変更することが可能。

Thinkingモードを自由に切り替えられることで、単純な質問に対してはレスポンスよく回答し、複雑な質問に対しては深い思考を用いて回答することができます。

また、Gemini 2.5 Flashでは思考予算というものが導入されています。思考予算はモデルが内部で推論を行う際に使用できるトークン数の上限を設定するもの。Gemini 2.5 Flashでは0〜24,576トークンで設定することが可能です。

さらに、Gemini 2.5 Flashの入力コストは$0.30/1Mトークン、出力コスト$2.50/1Mトークン。上記価格は2026年1月時点での価格です。

それに対してGPT-4oは入力コストは$2.50/1Mトークン、出力トークンは$10.00/1Mトーク、Claude 4 Sonnetは入力コストは$3.00/1Mトーク、出力トークンは$15.00/1Mトークンです。

Gemini 2.5 FlashとFlash-Liteの使い分け

Gemini 2.5 Flashファミリーには、標準版のFlashと軽量版のFlash-Liteがあります。性能・速度・コストのバランスが異なるため、用途に応じて使い分けるようにしましょう。

| 比較項目 | Gemini 2.5 Flash | Gemini 2.5 Flash-Lite |

|---|---|---|

| 推論性能 | 高度な推論・思考モード対応 | 基本的な推論 |

| 処理速度 | 標準 | より高速 |

| 入力料金 | $0.30/1M tokens | $0.10/1M tokens |

| 出力料金 | $2.50/1M tokens | $0.40/1M tokens |

上記はGemini 2.5 FlashとFlash-Liteの比較表です。

Flash-Liteは、Flashに比べて推論性能は抑えられているものの、処理速度が速く、料金が大幅に安くなっています。入力トークンは$0.10/1M tokens、出力トークンは$0.40/1M tokensとなっており、Flashの約1/6〜1/7のコストで利用可能です。

一方、Flashは思考モードに対応しており、複雑な分析やマルチステップ推論が必要なタスクで高い性能を発揮。入力$0.30/1M tokens、出力$2.50/1M tokensと、Flash-Liteよりコストは高いですが、品質重視の場面では力を発揮します。

Gemini 2.5 Flashの日本語性能と注意点

Gemini 2.5 Flashは多言語対応モデルとして設計されており、日本語でも高い処理能力を持っています。

一般的なビジネス文書の要約、顧客対応のQA生成、技術文書の翻訳といった実務タスクでは、十分な出力が得られます。特に、思考モードをONにした場合、日本語での論理展開がより安定し、段階的な説明や複雑な分析でも自然な文章構成が可能。

ただし、微妙なニュアンスを含む文学的表現や長大な議論の文脈理解においては、他の上位モデルと比較してやや差が出る場合があります。

例えば下記のプロンプトを思考モードオンとオフで比べると次のようになります。

納期遅延のお詫びメールを顧客向けに作成してください。理由は部材調達の遅れ、新しい納期は来週金曜日です。思考モードオフ

かしこまりました。以下、納期遅延のお詫びメールの文案です。

件名:【重要】〇〇(商品名/プロジェクト名など)の納期遅延に関するお詫びと新しい納期のご連絡

〇〇株式会社

〇〇様

平素は格別のご高配を賜り、厚く御礼申し上げます。

〇〇株式会社の〇〇(あなたの氏名)でございます。

この度は、ご注文いただきました〇〇(商品名/案件名)につきまして、誠に申し訳ございませんが、納期を遅延させていただきたく、深くお詫び申し上げます。

現在、〇〇(商品名/案件名)の製造に使用する一部部材の調達に予期せぬ遅れが生じており、当初お約束しておりました納期に間に合わせることが困難な状況となりました。

お客様には多大なご迷惑とご心配をおかけいたしますこと、重ねてお詫び申し上げます。

つきましては、大変恐縮ではございますが、**新しい納期を【来週金曜日】**とさせていただきたく存じます。

具体的な日程は以下の通りです。

(旧)納期:〇月〇日(〇)

(新)納期:〇月〇日(金)

遅延による影響を最小限に抑えるべく、部材の確保と製造・発送準備に全力を尽くしております。

今回の遅延により、ご迷惑をおかけいたしますこと、重ねて深くお詫び申し上げます。

何卒ご理解とご容赦を賜りますようお願い申し上げます。

ご不明な点やご要望などがございましたら、ご遠慮なくお申し付けください。

今後とも、品質管理と納期管理を徹底し、信頼回復に努めてまいる所存です。

引き続き、どうぞよろしくお願い申し上げます。

【補足】

〇〇の部分は、貴社名、顧客名、商品名、日付などに置き換えてご使用ください。

新しい納期が確定している場合は、具体的な**「〇月〇日(金)」**の日にちを記載してください。思考モードオン

承知いたしました。納期遅延のお詫びと新しい納期をご案内するメールを作成します。

件名:【重要】ご注文[注文番号など、特定できる情報] 納期遅延のお詫びと新しい納期のご案内

[顧客名]様

平素は格別のご高配を賜り、厚く御礼申し上げます。

この度、ご注文いただきました[商品名など、具体的な内容]につきまして、誠に申し訳ございませんが、納期を遅延させていただきたく、深くお詫び申し上げます。

ご注文時に[〇月〇日]とお伝えしておりましたが、現在、製造に必要な部材の調達に予期せぬ遅れが生じており、当初の納期に間に合わせることが困難な状況となりました。

お客様には多大なご迷惑をおかけしますこと、重ねてお詫び申し上げます。

つきましては、大変恐縮ではございますが、新しい納期を以下の通りとさせていただきます。

旧納期:[〇月〇日]

新納期:来週金曜日([具体的な日付:例 2月6日])

部材の入荷後、すぐに製造・出荷できるよう、最大限の努力をもって対応を進めてまいります。

今回の遅延により、お客様の業務やご計画に影響が生じますこと、心よりお詫び申し上げます。今後はこのような事態を招かぬよう、調達・生産管理体制を一層強化してまいる所存です。

何卒、事情ご賢察の上、ご理解を賜りますようお願い申し上げます。

本件に関しましてご不明な点がございましたら、ご遠慮なくお問い合わせください。

まずは、取り急ぎお詫びとご報告まで。

[署名]

〇〇株式会社

[部署名]

[担当者名]

住所:

電話番号:

FAX番号:

E-mail:パッとみた感じ、思考モードオンの方が丁寧かつ署名まで書いてくれているのでビジネスメールとしては思考モードオンの方が良さそうです。

Gemini 2.5 Flashを使ったAIエージェント活用例

Gemini 2.5 Flashは、2025年9月のアップデートでエージェント的タスク対応が強化されており、ツール利用やマルチステップ推論を含む複雑な操作を効率的に実行できます。

ここでは、Gemini 2.5 Flashをエージェントとして活用する代表的な3つのパターンを紹介します。

Function Callingによる外部ツール連携

Function Callingは、Gemini 2.5 FlashがAPI経由で外部ツールやデータベースを呼び出す機能です。

モデルがユーザーの質問内容を理解し、適切なタイミングで必要な関数を実行することで、リアルタイムデータの取得や外部システムとの連携が可能になります。

例えば、「明日の東京の天気は?」という質問に対し、モデルが天気APIを自動で呼び出し、最新の予報データを取得して回答を生成します。

2025年9月のアップデートにより、API呼び出しや外部ツール連携をより適切なタイミングで実行できるようになり、SWE-Bench Verifiedでは48.9%から54%へと5ポイント改善。

マルチステップ推論による長期タスク実行

Gemini 2.5 Flashの思考モードを活用することで、複数のステップにわたる長期タスクを段階的に実行できます。

例えば、「競合他社3社の製品を比較分析し、当社製品の改善案を提案する」といったタスクでは、1.各社の製品情報収集、2.比較分析、3.改善案の立案という3つのステップを順次実行。

各ステップで得られた情報を次のステップに引き継ぎながら、最終的な提案まですることが可能です。

Computer Useモデルとの併用によるブラウザ操作自動化

Gemini 2.5 Flashは、Computer Useモデルと併用することで、ブラウザ操作を自動化するエージェントを構築できます。

Computer Useモデルは、画面のスクリーンショットを入力として受け取り、マウスクリックやキーボード入力といった操作を出力する仕組み。

Gemini 2.5 Flashが全体のタスク計画と判断を担当し、Computer Useモデルが具体的な操作を実行することで、複雑なWebタスクを自動化できます。

例えば、「特定の商品を複数のECサイトで検索し、価格を比較してスプレッドシートにまとめる」といったタスクを、人間の操作なしで完遂することが可能です。

Gemini 2.5 Flashファミリー(Flash-Lite/Image/Audio/TTS)

Gemini 2.5 Flashは、単一のモデルではなく、用途に応じて選択できる複数のバリエーションを持つ「ファミリー」として提供されています。

テキスト処理に特化したFlash-Liteから、画像生成や音声合成に対応したモデルまで、幅広いラインナップが揃っており、それぞれが異なる特徴を持っています。

Flash-Lite:低コスト・大量処理向け

Gemini 2.5 Flash-Liteは、コスト効率と処理速度を最優先に設計された軽量モデルです。

2025年9月のアップデートでは、システムプロンプトや複雑な指示の理解精度が大幅に改善され、出力の冗長性が削減されたことで、さらにトークンコストを抑えられるようになりました。また、音声認識の精度向上や画像理解力も向上しています。

Flash Image/Audio/TTS:マルチモーダル生成モデル

Gemini 2.5 Flashファミリーには、テキスト以外のコンテンツ生成に特化したモデルも含まれています。

Flash Imageは、画像生成モデルで、速度・文脈理解に優れています。テキストプロンプトから直接画像を生成でき、出力料金は$0.039/画像です。

Flash Native Audioは、Live API向けの高品質音声出力モデルで、自然な発話ペース、声の表現力、ムードの再現性が向上。

入力$3.00/1M tokens(音声/動画)、出力$12.00/1M tokens(音声)で利用可能です。

Flash Preview TTSは、音声合成に特化したモデルで、低レイテンシーかつ制御性の高い音声生成を実現。2025年12月にアップデートされ、感情的な音声や複数話者機能が向上しています。

入力$0.50/1M tokens(テキスト)、出力$10.00/1M tokens(音声)で、価格パフォーマンスに優れた音声合成が可能です。

使い分けのポイント

Gemini 2.5 Flashファミリーの各モデルは、用途に応じて最適な選択が異なります。

テキスト処理においては、複雑な推論やエージェント開発が必要な場合は標準のFlashを選択し、大量処理や高頻度API呼び出しが求められるシーンではFlash-Liteを活用することでコストを大幅に削減できます。

画像生成については、本格的な画像生成タスクにはFlash Imageが最適。一方、テキストと画像を組み合わせた混合処理では、マルチモーダル入力として画像を扱える標準のFlashを使用することで、文脈を考慮した高度な処理が可能になります。

音声生成では、リアルタイム会話や高品質な音声出力が求められる場合にはFlash Native Audioを選び、テキスト読み上げや低コストでの音声合成を優先する場合にはFlash Preview TTSが良いでしょう。

Gemini 2.5 FlashとGemini 3 Pro/3 Flashの違い

2025年にGoogleはGemini 3シリーズをリリースし、Gemini 2.5 Flashと並行して複数のモデルが提供される体制となりました。

ここでは、Gemini 2.5 Flash、Gemini 3 Pro、Gemini 3 Flashの3モデルについて、性能・価格・用途の観点から比較し、それぞれの役割分担を整理します。

3モデルの性能・価格比較表

以下の表は、3つのモデルの主要な違いをまとめたものです。

| 比較項目 | Gemini 2.5 Flash | Gemini 3 Flash | Gemini 3 Pro |

|---|---|---|---|

| 位置づけ | 価格パフォーマンス重視の汎用モデル | 高速かつ高性能なバランス型 | 最高性能の推論・マルチモーダルモデル |

| 入力料金 | $0.30/1M tokens(テキスト/画像/動画) | $0.50/1M tokens(テキスト/画像/動画) | $2.00/1M tokens(≤200k tokens)$4.00/1M tokens(>200k tokens) |

| 出力料金 | $2.50/1M tokens | $3.00/1M tokens | $12.00/1M tokens(≤200k tokens)$18.00/1M tokens(>200k tokens) |

| 思考モード | 対応 | 対応 | 対応 |

| コンテキスト長 | 最大100万トークン | 最大100万トークン | 最大100万トークン |

| 処理速度 | 標準 | 高速 | やや低速(高品質重視) |

| 推論性能 | 高い | より高い | 最高レベル |

| グラウンディング | Google Search/Maps対応 | Google Search/Maps対応 | Google Search対応 |

料金体系は変動する可能性があります。上記の料金は本記事執筆(2026年1月)時点のものです。

用途別の推奨モデル

3つのモデルは、それぞれ異なる特徴・性能を持っており、用途に応じた使い分けが必要です。

Gemini 2.5 Flashは、コスパが良いので日常使いに最適です。

顧客対応の自動化やドキュメント要約、コード生成といった日常的なタスクに用いるのが良いでしょう。

また、思考モードにも対応しているため、複雑な推論が必要な場合でも十分に活用できます。

Gemini 3 Flashは、高速性と高性能のバランスを重視する場面で使うのが良いでしょう。

2.5 Flashよりも推論性能が向上しており、リアルタイム応答が求められるチャットボットや、品質を妥協したくない顧客向けアプリケーションに適しています。

Gemini 3 Proは、最高レベルの推論能力とマルチモーダル対応が求められる高度なタスクに特化。

複雑なデータ分析、専門的な技術文書の生成、高度な意思決定支援といったシーンでは、Gemini 3 Proの性能が不可欠です。

既存の2.5 Flash利用アプリケーションを3系に切り替えるタイミングとしては、次の3通りの場面でしょう。

- ユーザーから出力品質への不満が寄せられた場合

- より高度な推論や複雑なマルチモーダル処理が必要になった場合

- リアルタイム性が重視されるようになった場合

Gemini 2.5 Flash ライセンス

Gemini 2.5 Flashは、Googleが提供するクラウドAPIサービスとして利用されるモデルであり、ソースコードや学習済みモデル自体がオープンソースで提供されているわけではありません。

そのため、従来のOSSライブラリのような明確なライセンス名は存在せず、利用規約に従ったオンラインサービス利用という形になります。以下の表に、主な利用項目に関する可否をまとめます。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | ⭕️ | |

| 改変 | ❌️ | モデルの内部構造や重みは非公開。API利用規約でリバースエンジニアリングやモデル抽出は禁止。 |

| 配布 | ❌️ | 学習済みモデルそのものを入手・配布する手段がない。利用はクラウドAPI上での呼び出しに限定。 |

| 特許利用 | ❌️ | 本モデル使用に際しGoogleから特許実施の明示的許諾はない。 |

| 私的利用 | ⭕️ | API利用規約の範囲内で |

まとめると、Gemini 2.5 Flashは商用/非商用問わず利用可能なクラウドサービスですが、モデル本体はクローズドであり改変や再配布はできず、モデル自体の特許ライセンスが付与されるわけではありません。生成されたテキストや画像などのアウトプットは利用者のデータと見なされ、商用利用も含め自由に活用できます。

一方で、API提供元としてのGoogleの規約(安全性ポリシーや禁止事項)に従う必要があり、違法・有害用途での利用や、当該サービスを使って競合となるAIモデルの構築などは禁止されています。

なお、圧倒的スピードのClaude Haiku 4.5について詳しく知りたい方は、以下の記事も参考にしてみてください。

Gemini 2.5 Flash 料金プラン

Gemini 2.5 Flashの料金体系を以下の表にまとめます。

| プラン | 月額料金 | 1日あたりの無料利用上限 |

|---|---|---|

| Gemini Basic(Web / モバイルアプリ) | 無料 | 明示値なし(「通常利用向け」の内部制限) |

| Gemini Advanced (Google One AI Premium) | $19.99 / 月 (日本:2 か月無料→2,900 円/月) | 上限ほぼ撤廃(高レートリミット) |

| Gemini API Free Tier | 無料 | 明記なし |

| Gemini API Paid Tier | 従量課金 | – |

Gemini Basic無償枠には公開値がなく、実際には「10 ~ 数十 リクエスト/日」でリフレッシュされるローリング制限(Google Help Center記載)となっています。大量に利用する際は、Gemini Advancedか API Paid Tier 推奨となります。

Searchグラウンディング利用時の追加コスト

Gemini 2.5 FlashおよびFlash-Liteでは、Google SearchやGoogle Mapsによるグラウンディング機能を利用することが可能です。これにより、モデルがリアルタイムのWeb情報や地理情報を参照しながら回答を生成できるようになります。

Google SearchおよびGoogle Mapsグラウンディングの料金体系は下記の通りです。

| グラウンディング種別 | プラン | 無料枠(RPD) | 超過時の料金 |

|---|---|---|---|

| Google Search | Free Tier | 500 RPD | 利用不可 |

| Paid Tier | 1,500 RPD | $35/1,000リクエスト | |

| Google Maps | Free Tier | 500 RPD | 利用不可 |

| Paid Tier | 1,500 RPD | $25/1,000リクエスト |

上記はグラウンディングごとの料金一覧表です。1回のユーザーリクエストに対して、モデルが内部で複数回のGoogle検索を実行する場合があります。この場合、実行された検索クエリごとに課金が発生します。

Gemini 2.5 Flash 使い方

Gemini 2.5 Flashの使い方には大きく分けて、「Web / モバイル利用」と「AI Studio / Vertex AI利用」の2パターンがあります。それぞれ簡潔に利用フローを説明します。

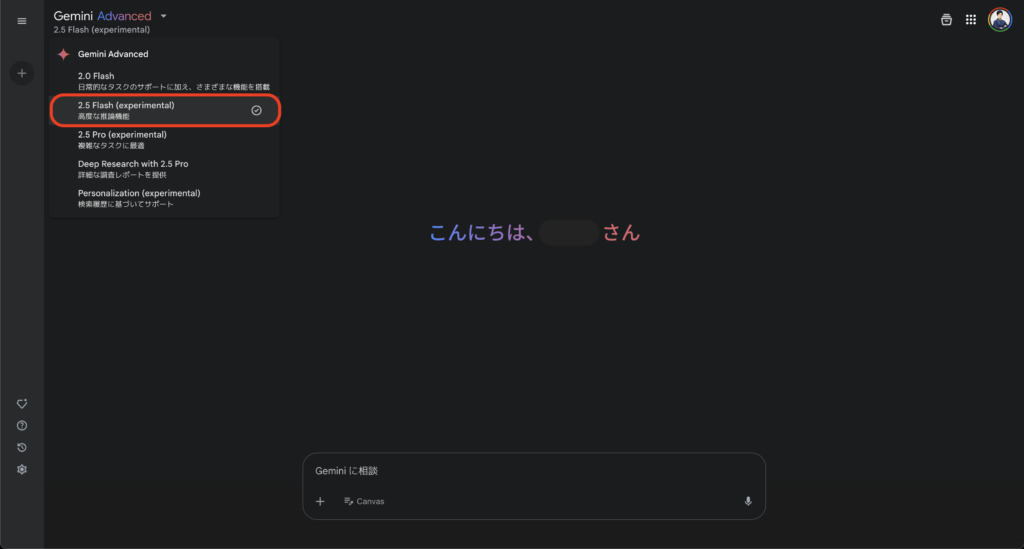

Web/モバイル利用

1.アクセス:Gemini Webページ(https://gemini.google.com/app)にログイン。もしくはモバイルの場合は、Gemini アプリ(Android / iOS)をインストールし、Google アカウントでログインしましょう。

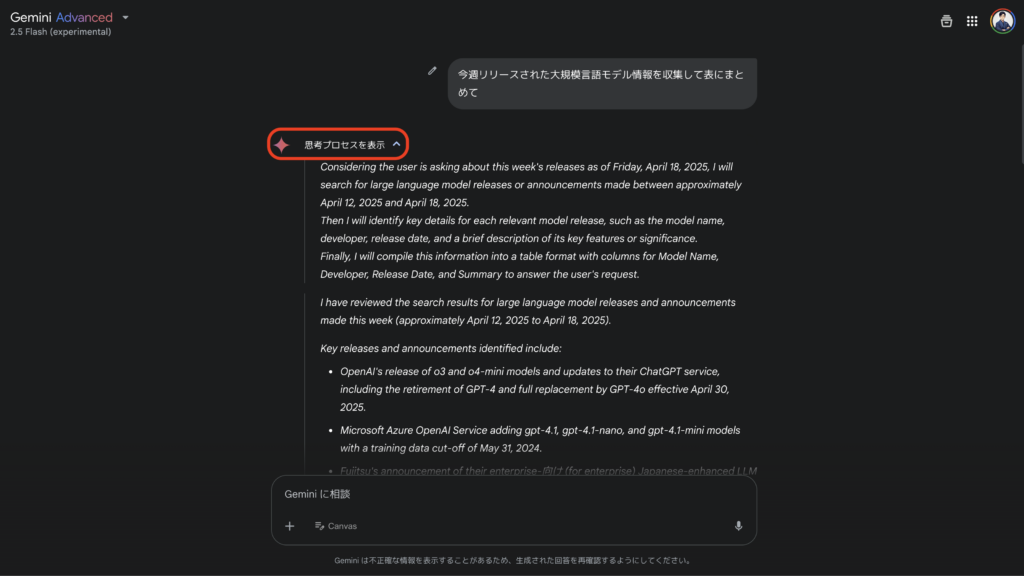

2.モデル選択:画面上部の Model ドロップダウン → 「2.5 Flash (Experimental)」 を選択してください。思考モード ON/OFF スライダーも UI で設定可能です。

3.プロンプト送信:テキスト・画像・音声・動画ファイルをドラッグ & ドロップで入力して送信しましょう。

4.思考表示:Show thoughts をオンにすると、Gemini 2.5 Flash が内部で生成したステップバイステップの推論を閲覧することができます。

5.上限に達したら(無料版の方):24 時間後にリセットされます。制限を緩和したい場合は Gemini Advanced にアップグレードするようにしましょう。

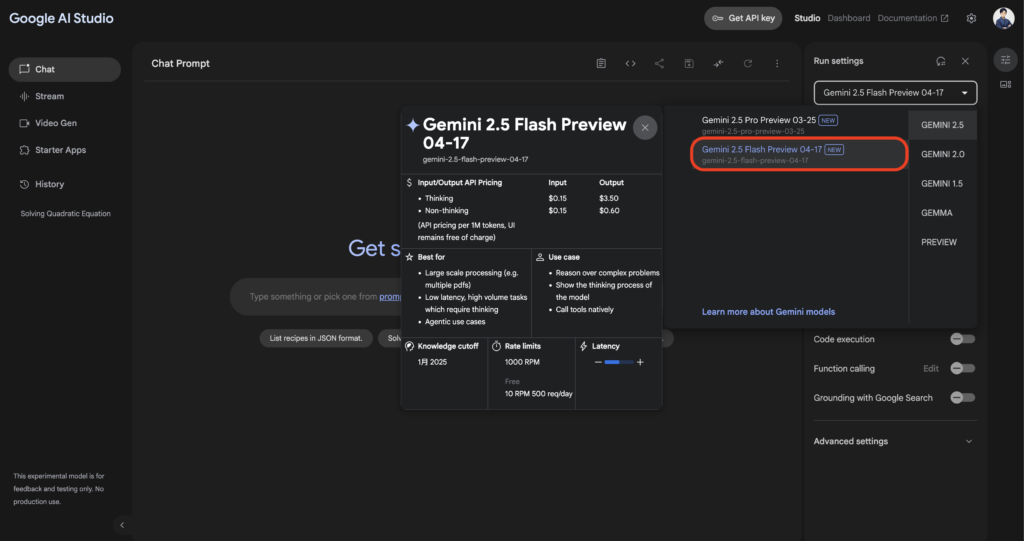

AI Studio/Vertex AI利用

1.アクセスの準備:Google Cloudアカウントでプロジェクトを作成し、Vertex AI APIを有効化します。

AI Studio上でモデルを選択するだけなら無料枠で即利用可能ですが、API経由で高負荷利用する場合は、課金アカウントを設定する必要があります。

2.モデルの選択:Vertex AI APIでは、モデル名でバージョン指定を行います。

Gemini 2.5 FlashをAPI経由で利用する際のモデルIDは、以下の通りです。

| モデル種類 | モデルID | バージョン |

|---|---|---|

| 2.5 Flash(安定版) | gemini-2.5-flash | Stable |

| 2.5 Flash Preview | gemini-2.5-flash-preview-09-2025 | Preview |

| Flash Latest(エイリアス) | gemini-flash-latest | Latest |

| 2.5 Flash-Lite(安定版) | gemini-2.5-flash-lite | Stable |

| 2.5 Flash-Lite Preview | gemini-2.5-flash-lite-preview-09-2025 | Preview |

| 2.5 Flash Image | gemini-2.5-flash-image | Stable |

| 2.5 Flash Native Audio | gemini-2.5-flash-native-audio-preview-12-2025 | Preview |

| 2.5 Flash TTS | gemini-2.5-flash-preview-tts | Preview |

上記はGemini 2.5 FlashとFlash-Liteのモデル名一覧です。本番環境では安定版IDを使うのがよいでしょう。

3.APIキー取得:APIを呼び出すには認証が必要です。

Google CloudのCredentialsから、APIキーまたはサービスアカウントを取得し、リクエストに添付します。AI Studio上で提供されているブラウザIDEやRESTコンソールを使う場合は自動的に認証されます。

4.リクエスト送信:Google提供のSDKやHTTP REST API経由でモデルに入力を送ります。

プロンプトや追加のコンフィグを指定してリクエストを作成し、コンフィグでは出力の体裁や、Gemini 2.5固有の思考設定 (thinking_budget)を指定することができます。例えば、Python SDKで思考予算1024トークンを設定して質問するコードは以下のようなイメージです。

from google import genai

client = genai.Client(api_key="YOUR_GEMINI_API_KEY")

response = client.models.generate_content(

model="gemini-2.5-flash-preview-04-17",

contents="2個のサイコロを振ったとき合計が7になる確率は?",

config=genai.types.GenerateContentConfig(

thinking_config=genai.types.ThinkingConfig(thinking_budget=1024)

)

)

print(response.text)上記の例では、generate_contentメソッドにモデル名と日本語の質問文を渡し、ThinkingConfigで内部思考に最大1024トークン使う設定をしています。実行すると、モデルからの回答テキストはresponse.textに得られるはずです。

5.応答の処理:APIから返ってきた応答には、モデルの回答本体に加え、思考モードをONにしていた場合はモデルのステップごとの思考内容も含まれます。

6.パラメータ調整と繰り返し:必要に応じて、thinking_budgetや温度パラメータを調整し、品質と速度のバランスを取ります。思考予算を0にすれば、Gemini 2.0 Flash相当のシンプルで高速な応答になり、逆に大きくとれば難しい問題に対しても詳細な回答が得られます。

「Gemini 2.0 Flash」 vs 「Gemini 2.5 Flash」比較検証してみた

それでは実際にGemini 2.5 Flashの強みを確認するため、Gemini 2.0 Flashを比較対象に、コーディング、英語、数学タスクを検証してみます!

コーディングタスク

入力プロンプトこちら(意図:段階的思考でアルゴリズムを下書きし、バグの少ないコードを生成できるか)

二分ヒープでDijkstraを実装してGemini 2.0 Flashの結果はこちら

import heapq

def dijkstra_with_heap(graph, start_node):

distances = {node: float('inf') for node in graph}

distances[start_node] = 0

priority_queue = [(0, start_node)] # (距離, 頂点)のタプルをヒープに格納

while priority_queue:

current_distance, current_node = heapq.heappop(priority_queue)

# より短い距離が見つかっている場合はスキップ

if current_distance > distances[current_node]:

continue

for neighbor, weight in graph[current_node].items():

distance = current_distance + weight

if distance < distances[neighbor]:

distances[neighbor] = distance

heapq.heappush(priority_queue, (distance, neighbor))

return distances

# グラフの例

graph = {

'A': {'B': 1, 'C': 4},

'B': {'A': 1, 'D': 2, 'E': 5},

'C': {'A': 4, 'F': 6},

'D': {'B': 2, 'E': 1, 'G': 3},

'E': {'B': 5, 'D': 1, 'H': 8},

'F': {'C': 6, 'H': 9},

'G': {'D': 3, 'H': 4},

'H': {'E': 8, 'F': 9, 'G': 4}

}

start_node = 'A'

shortest_distances = dijkstra_with_heap(graph, start_node)

print(f"始点 '{start_node}' からの最短距離: {shortest_distances}")Gemini 2.5 Flashの結果はこちら

import heapq

import math

def dijkstra(graph, start_node):

"""

二分ヒープ(優先度キュー)を使用したダイクストラ法の実装

Args:

graph (dict): グラフを隣接リスト形式で表現した辞書。

キーはノード、値は隣接ノードとその重みのリストのリスト。

例: { 'A': [('B', 1), ('C', 4)], 'B': [('C', 2), ('D', 5)], ... }

start_node: 開始ノード。

Returns:

dict: 各ノードへの最短距離を格納した辞書。

到達不可能なノードは math.inf となる。

"""

# 全ノードへの最短距離を無限大で初期化

distances = {node: math.inf for node in graph}

distances[start_node] = 0

# 優先度キューの初期化 (距離, ノード) のタプルを格納

# heapqは最小ヒープなので、距離が小さいものが優先される

priority_queue = [(0, start_node)]

while priority_queue:

# 優先度キューから最小距離のノードを取り出す

current_distance, current_node = heapq.heappop(priority_queue)

# 取り出した距離が、既に記録されている最短距離より大きい場合はスキップ

# これは、同じノードが異なる距離で複数回キューに入ることがあるため

if current_distance > distances[current_node]:

continue

# 現在のノードに隣接するノードを探索

if current_node in graph:

for neighbor, weight in graph[current_node]:

distance = current_distance + weight

# より短い経路が見つかった場合

if distance < distances[neighbor]:

distances[neighbor] = distance

# 優先度キューに新しい距離とノードを追加

heapq.heappush(priority_queue, (distance, neighbor))

return distances

# 使用例

if __name__ == "__main__":

# サンプルグラフ (隣接リスト形式)

# ノード: 'A', 'B', 'C', 'D', 'E'

# エッジ: (始点) -> (終点, 重み)

graph = {

'A': [('B', 1), ('C', 4)],

'B': [('C', 2), ('D', 5)],

'C': [('D', 1)],

'D': [('E', 3)],

'E': [] # Eからはどこへも行けない

}

start_node = 'A'

shortest_distances = dijkstra(graph, start_node)

print(f"始点 {start_node} から各ノードへの最短距離:")

for node, distance in shortest_distances.items():

if distance == math.inf:

print(f"ノード {node}: 到達不可能")

else:

print(f"ノード {node}: {distance}")

# 別の開始ノードでの例

start_node_2 = 'B'

shortest_distances_2 = dijkstra(graph, start_node_2)

print(f"\n始点 {start_node_2} から各ノードへの最短距離:")

for node, distance in shortest_distances_2.items():

if distance == math.inf:

print(f"ノード {node}: 到達不可能")

else:

print(f"ノード {node}: {distance}")Gemini 2.0 Flashは、実装はシンプルで動作は問題ないが、隣接辞書固定で汎用性に欠け、ノードの扱いも未対応となっています。さらに、コメントが少なく意図が読み取りづらい印象。

対してGemini 2.5 Flashは、詳しいdocstringと行内コメントで理解しやすく、隣接リスト採用で入力形式が柔軟です。サンプル実行を含み即テスト可能で、即実務投入できる完成度に仕上がっていますね。

英語タスク

入力プロンプトこちら(意図:用語の選択精度と文脈再構成が最適かどうか)

RFC断片抜粋元:https://www.rfc-editor.org/rfc/rfc9110.html

あなたは専門のテクニカルライター兼翻訳者です。

以下の RFC 断片を **英語から日本語**へ逐語的に翻訳してください。

- 技術用語・節番号・箇条書き・書式はそのまま保持してください。

- 解説や要約は付けず、**日本語訳のみ**を出力してください。

--- RFC 断片ここから ---

### 8.4. Content‑Encoding

The "Content‑Encoding" header field indicates what content codings

have been applied to the representation, beyond those inherent in

the media type, and thus what decoding mechanisms have to be applied

in order to obtain data in the media type referenced by the

Content‑Type header field. Content‑Encoding is primarily used

to allow a representation's data to be compressed without losing the

identity of its underlying media type.

Content‑Encoding = #content‑coding

An example of its use is

Content‑Encoding: gzip

If one or more encodings have been applied to a representation,

the sender that applied the encodings MUST generate a Content‑Encoding

header field that lists the content codings in the order in which

they were applied. Note that the coding named "identity" is reserved

for its special role in Accept‑Encoding and thus SHOULD NOT be

included.

Additional information about the encoding parameters can be provided

by other header fields not defined by this specification.

--- RFC 断片ここまで ---Gemini 2.0 Flashの結果はこちら

"Content‑Encoding" ヘッダーフィールドは、メディアタイプに固有のものを超えて、表現に適用されたコンテンツコーディングを示し、したがって、Content‑Type ヘッダーフィールドによって参照されるメディアタイプでデータを取得するために適用する必要があるデコードメカニズムを示します。Content‑Encoding は、主に、表現のデータの基になるメディアタイプの識別情報を失うことなく圧縮できるようにするために使用されます。

Content‑Encoding = #content‑coding

その使用例は次のとおりです。

Content‑Encoding: gzip

1 つ以上のエンコーディングが表現に適用されている場合、エンコーディングを適用した送信者は、適用された順序でコンテンツコーディングをリストする Content‑Encoding ヘッダーフィールドを生成しなければなりません (MUST)。"identity" という名前のコーディングは Accept‑Encoding における特別な役割のために予約されており、したがって含めるべきではありません (SHOULD NOT) ことに注意してください。

エンコーディングパラメータに関する追加情報は、この仕様で定義されていない他のヘッダーフィールドによって提供される場合があります。Gemini 2.5 Flashの結果はこちら

「Content‑Encoding」ヘッダーフィールドは、メディアタイプに固有のものに加えて、表現にどのようなコンテンツコーディングが適用されたかを示し、したがって、Content‑Typeヘッダーフィールドによって参照されるメディアタイプでデータを取得するためにどのようなデコーディングメカニズムが適用される必要があるかを示す。Content‑Encodingは、主に、表現のデータがその基になるメディアタイプの同一性を失うことなく圧縮されることを許可するために使用される。

Content‑Encoding = #content‑coding

その使用例は

Content‑Encoding: gzip

1つ以上のエンコーディングが表現に適用された場合、エンコーディングを適用した送信者は、適用された順序でコンテンツコーディングをリストするContent‑Encodingヘッダーフィールドを生成しなければならない(MUST)。"identity"という名前のコーディングは、Accept‑Encodingにおけるその特別な役割のために予約されており、したがって含まれるべきではない(SHOULD NOT)ことに注意。

エンコーディングパラメータに関する追加情報は、この仕様で定義されていない他のヘッダーフィールドによって提供されうる。Gemini 2.0 Flashは、原文構造と用語は忠実にキープできていますが、1文が長く読点が少ない印象です。

対してGemini 2.5 Flashは、ヘッダ名後のスペース削除など微細な整形も行き届き、形式保持と読みやすさを高水準で両立できている印象です!

数学タスク

入力プロンプトこちら(意図:高い思考予算を指定した際に、式導出→数値代入→結果提示まで一貫できるか)

あなたは構造力学の指導教員です。

以下の条件を持つ片持ち梁について、**最大曲げ応力**を求めてください。

- 梁の長さ:3 m(左端固定)

- 断面:幅 100 mm、せい 200 mm の長方形

- 荷重:全長にわたり 5 kN/m の等分布荷重

求める際の指示

1. 曲げ応力の公式 σ = M·y / I を使用し、固定端での最大応力を計算してください。

2. 計算手順をステップバイステップで示してください。

3. 最終結果は MPa 単位で小数点以下 2 桁に丸めて提示してください。 Gemini 2.0 Flashの結果はこちら

問題設定

梁の長さ (L): 3 m

断面: 幅 (b) = 100 mm, 高さ (h) = 200 mm の長方形

荷重 (w): 5 kN/m の等分布荷重

解答

ステップ 1: 最大曲げモーメント (M) の計算

片持ち梁に等分布荷重が作用する場合、固定端で最大曲げモーメントが発生します。最大曲げモーメントは以下の式で計算できます。

M = (w * L^2) / 2

ここで、

w = 5 kN/m

L = 3 m

したがって、

M = (5 kN/m * (3 m)^2) / 2 = (5 * 9) / 2 kN·m = 22.5 kN·m

ステップ 2: 断面二次モーメント (I) の計算

長方形断面の断面二次モーメントは、以下の式で計算できます。

I = (b * h^3) / 12

ここで、

b = 100 mm = 0.1 m

h = 200 mm = 0.2 m

したがって、

I = (0.1 m * (0.2 m)^3) / 12 = (0.1 * 0.008) / 12 m^4 = 0.0008 / 12 m^4 = 6.6667 * 10^-5 m^4

ステップ 3: 最大曲げ応力 (σ) の計算

曲げ応力の公式は、σ = M * y / I です。

ここで、

M = 22.5 kN·m = 22.5 * 10^3 N·m

y = h / 2 (中立軸から最外縁までの距離) = 0.2 m / 2 = 0.1 m

I = 6.6667 * 10^-5 m^4

したがって、

σ = (22.5 * 10^3 N·m * 0.1 m) / (6.6667 * 10^-5 m^4) = 2250 N/m^2 / 6.6667 * 10^-5 m^4 = 33750000 N/m^2 = 33.75 * 10^6 Pa = 33.75 MPa

最終結果

片持ち梁の最大曲げ応力は、33.75 MPa です。Gemini 2.5 Flashの結果はこちら

問題の概要

梁の長さ:L=3 m

断面:幅 b=100 mm、せい h=200 mm の長方形

荷重:全長にわたり w=5 kN/m の等分布荷重

最大曲げ応力は、曲げモーメントが最大となる固定端で発生します。長方形断面の場合、中立軸から最も離れた断面の上下縁で応力が最大となります。

計算手順は以下の通りです。

計算手順

ステップ 1: 最大曲げモーメント M

max

を計算する

片持ち梁に全長にわたって等分布荷重 w が作用する場合、固定端(左端)での最大曲げモーメント M

max

は以下の式で求められます。

M

max

=

2

wL

2

まず、荷重の単位を N/m に変換します。

w=5 kN/m=5×1000 N/m=5000 N/m

次に、最大曲げモーメントを計算します。

M

max

=

2

(5000 N/m)×(3 m)

2

=

2

5000×9

Nm=

2

45000

Nm=22500 Nm

応力計算で後ほど使用するため、単位を Nmm に変換しておきます。

M

max

=22500 Nm×1000 mm/m=22,500,000 Nmm

ステップ 2: 断面二次モーメント I を計算する

幅 b、せい h の長方形断面の断面二次モーメント I (中立軸周り)は以下の式で求められます。

I=

12

bh

3

与えられた断面寸法を代入します。

b=100 mm

h=200 mm

I=

12

(100 mm)×(200 mm)

3

=

12

100×8,000,000

mm

4

=

12

800,000,000

mm

4

I≈66,666,666.67 mm

4

ステップ 3: 中立軸から最大応力が発生するファイバーまでの距離 y

max

を求める

長方形断面の場合、中立軸は断面の中心に位置します。最大曲げ応力は上下縁で発生するため、中立軸から上下縁までの距離 y

max

は断面のせいの半分となります。

y

max

=

2

h

y

max

=

2

200 mm

=100 mm

ステップ 4: 最大曲げ応力 σ

max

を計算する

曲げ応力の公式 σ=

I

M⋅y

を使用し、固定端での最大応力を計算します。ここで、M=M

max

、y=y

max

とします。

σ

max

=

I

M

max

⋅y

max

ステップ 1, 2, 3 で求めた値を代入します。

σ

max

=

66,666,666.67 mm

4

(22,500,000 Nmm)×(100 mm)

計算を実行します。

σ

max

=

66,666,666.67 mm

4

2,250,000,000 Nmm

2

σ

max

≈33.75 N/mm

2

N/mm² は MPa と等しい単位です。

σ

max

≈33.75 MPa

最終結果

小数点以下 2 桁に丸めて提示します。

この片持ち梁に生じる最大曲げ応力は、固定端の上下縁において

σ

max

=33.75 MPa

となります。

今回の計算は、材料が弾性範囲内であると仮定しています。しっかりと手順を追って計算できていますね。素晴らしいです。Gemini 2.0 Flashは、説明が箇条書きに近いイメージで、数式と文章が連続していて読みにくい印象です。

それに対してGemini 2.5 Flashは、四則演算を明示、最後に材料弾性仮定まで言及して解釈を補強していて、構造も視認性が高く、非常に読みやすい印象です!

Gemini 2.5 Flashのビジネス活用シーン

Gemini 2.5 Flashは、その高いコストパフォーマンスと柔軟な推論能力により、さまざまなビジネスシーンで活用されています。ここでは、代表的な5つの活用例を紹介します。

問い合わせ自動応答・カスタマーサポート

顧客からの問い合わせに対して、FAQや過去の対応履歴をもとに自動で回答を生成するシステムに活用できます。

定型的な質問には即座に応答し、複雑な問い合わせには思考モードをONにして段階的に回答することで、顧客満足度を維持しながら対応工数を削減できます。

ドキュメント要約・社内ナレッジ検索

長大な社内文書や技術マニュアルを要約し、必要な情報を素早く抽出するタスクに適しています。

100万トークンのコンテキスト長を活かし、複数の文書を横断的に検索・要約することで、社内ナレッジの活用効率が大幅に向上します。

思考モードは単純な要約はOFF。複数文書の比較分析はON。

コード生成・レビュー支援

プログラムコードの自動生成や、既存コードのレビュー・バグ検出に活用できます。

2025年9月のアップデートでエージェント的タスク対応が強化され、SWE-Bench Verifiedでのスコアが54%に向上したことで、実務レベルのコーディングが可能になっています。

思考モードは簡単なコード生成はOFF。アーキテクチャ設計やリファクタリングはON。

社内業務フローの自動化

RPAツールと組み合わせることで、定型業務の自動化も可能。

例えば、受信メールの内容を解析し、適切な部署への振り分けや、データ入力作業の自動化などです。Function Callingを活用することで、外部システムとの連携もスムーズに行えます。

思考モードは判断が単純な場合はOFF。複数条件の判定が必要な場合はON。

データ分析レポート自動生成

売上データや顧客データを分析し、経営層向けのレポートを自動生成するタスクにも活用できます。

思考モードをONにすることで、データの傾向を段階的に分析し、論理的な考察や改善提案まで含めた包括的なレポートを作成できます。

Gemini 2.5 Flashで使える実務プロンプト例

ここでは、Gemini 2.5 Flashを業務で活用する際の具体的なプロンプト例を紹介します。

社内文書・マニュアル要約

以下の社内マニュアルを3段落以内で要約してください。

重要な手順や注意事項は必ず含めてください。

[マニュアル本文]単純な要約タスクのため、thinking_budgetは0に設定し思考モードをOFFにすることで高速かつ低コストで処理が可能。

定型的なマニュアル要約であればFlash-Liteでも十分な品質が得られますが、複数文書の比較や深い分析が必要な場合はFlashの利用が良いでしょう。

顧客メール・ビジネス文書の下書き作成

以下の状況に基づき、顧客向けのお詫びメールを作成してください。

・納期が1週間遅延

・原因は部品調達の遅れ

・代替案として優先配送を提案

丁寧かつ簡潔な文面でお願いします。定型的なビジネス文書の生成には思考モードは不要で、thinking_budgetは0で問題ありません。

ビジネスメールであればFlash-Liteでも対応可能ですが、複雑な交渉や謝罪が必要な文書ではFlashの利用が適切な文を出力してくれます。

エラーログ解析・原因候補の列挙

以下のエラーログから、考えられる原因を3つ列挙し、

それぞれの対処法を簡潔に説明してください。

[エラーログ]段階的な原因分析をさせるため、thinking_budgetは1024程度が良いでしょう。

単純なエラー分類であればFlash-Liteでも対応可能ですが、複雑なスタックトレース解析や複数の要因が絡む場合はFlashを選択すべきです。

API設計レビュー・コード品質チェック

以下のAPI設計について、セキュリティ、パフォーマンス、

保守性の観点からレビューしてください。

改善点があれば具体的に指摘してください。

[API設計書またはコード]多角的な分析が求められるため、thinking_budgetは2048程度に設定し、思考モードはON。コードレビューには推論能力が不可欠なため、Flash-Liteでは不十分であり、Flashの利用が必須となります。

データ分析結果のレポート生成

以下の売上データを分析し、経営層向けのレポートを作成してください。

・前年比の増減理由

・今後の改善提案

を含めてください。

[データ]因果関係の推論や傾向分析が重要となるため、thinking_budgetは2048〜4096程度がよいでしょう。

データ分析には思考モードが必須であり、Flash-Liteでは十分な品質が得られないため、Flashを使用すべきです。

契約書・法務文書の要点抽出

以下の契約書から、重要な条項(支払条件、納期、責任範囲)を箇条書きで抽出してください。

[契約書本文]重要箇所の判断には軽度の推論が有効なため、thinking_budgetは1024程度。

簡易的な要点抽出であればFlash-Liteでも対応可能ですが、法務的な判断が必要な場合はFlashを選ぶと良いでしょう。

プロジェクト会議議事録の自動整形

以下の会議メモを正式な議事録形式に整形してください。

・決定事項

・担当者

・期限

を明確にしてください。

[会議メモ]整形作業では推論は不要です。なのでthinking_budgetは0に設定し思考モードをOFFにすることで十分です。定型的な整形作業であればFlash-Liteで十分な品質が得られます。

多言語翻訳・ローカライゼーション支援

以下の製品説明文を英語に翻訳してください。

技術用語は正確に訳し、ビジネス文書として自然な表現にしてください。

[日本語原文]翻訳タスクには基本的に推論は不要なため、thinking_budgetは0で問題ありません。

一般的な翻訳であればFlash-Liteでも対応可能ですが、専門性の高い技術文書や微妙なニュアンスが重要な場合はFlashを使用がおすすめです。

社内FAQ・ナレッジベース自動生成

以下の社内文書をもとに、よくある質問とその回答をFAQ形式で5つ作成してください。

[社内文書]質問の抽出には軽度の推論が有効なため、thinking_budgetは512程度がよいでしょう。

単純なFAQ作成であればFlash-Liteでも対応可能ですが、複雑な文書から適切な質問を抽出する場合はFlashを選択すべきです。

RFP(提案依頼書)への回答ドラフト作成

以下のRFPに対する提案書のドラフトを作成してください。

・当社の強み

・提案内容

・スケジュール

を含めてください。

[RFP内容]戦略的な提案には高度な推論が必要なため、thinking_budgetは4096程度。

提案書作成には思考モードが必須であり、Flash-Liteでは不十分なため、Flashの利用が必須となります。

Gemini 2.5 Flashについてよくある質問

ここからはGemini 2.5 Flashについて、よくある質問に回答します。

まとめ

Gemini 2.5 Flash は、「考える/考えない」をUIでもAPIでも瞬時に切り替えられる最初のハイブリッド軽量モデルです。

モバイルアプリに直接搭載されたことでかんたんに体験できるようになり、「思考」を追加してもGPT‑4oライト級より安価な設定になっています。

開発~検証段階ではAI Studio、ユーザテスト段階ではWeb/アプリといった使い分けも有用そうなのが魅力的ですね!気になる方はぜひ本記事を参考に試してみてください!

最後に

いかがだったでしょうか?

生成AIを“試す”段階から“活用する”段階へと進む今、業務効率だけでなく、開発・翻訳・技術検証などの現場における実用性が問われています。

貴社の目的に最適なモデル選定や導入ステップを整理し、具体的なユースケースに落とし込むための情報を、この先の一歩としてご活用ください。

貴社の事業にどう活かせるか、具体的な導入事例や最適な活用方法をご提案できますので、ぜひご相談ください。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。