【GLM-4.6V/GLM-4.6V-Flash】オープンソース最強クラスVLMの性能・料金・使い方を徹底解説

- クラウド環境向けの「GLM-4.6V」と、PCでも扱える軽量版「GLM-4.6V-Flash」が同時リリース

- テキストだけでなく、画像や動画を入力として理解・処理できるビジョン・ランゲージモデル

- 視覚質問応答の指標「MMBench」において、GLM-4.6Vが88.8点というハイスコアを記録

2025年12月8日、Z.ai社から新たな大規模マルチモーダルモデル「GLM-4.6V」シリーズが公開されました!

このシリーズには、クラウド環境向けの「GLM-4.6V」(パラメータ1,060億規模)と、PCでも扱える軽量版「GLM-4.6V-Flash」(パラメータ90億規模)の2種類があります。

いずれもテキストだけでなく、画像や動画を入力として理解・処理できるビジョン・ランゲージモデルで、128Kという超長文コンテキストまで対応している点が大きな特徴です。

本記事では、このGLM-4.6VとGLM-4.6V-Flashについて、概要や性能、ライセンス、使い方まで徹底解説します。

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

GLM-4.6VとGLM-4.6V-Flashの概要

GLM-4.6Vは、中国のAI企業「Zhipu AI (ブランド名: Z.ai)」が開発した最新世代のマルチモーダル大規模言語モデルです。

最大の特徴は、テキストと画像・動画を組み合わせた入力に対応し、長文や複雑な資料からでも高度な理解と推論ができる点です。

モデルは、視覚情報と言語情報を統合的に処理できるよう訓練されていて、例えば、文章中のグラフ画像や表の内容を読み取りながら、その意味を考察して回答を生成することが可能です。

また、ネイティブな関数・ツール呼び出し機能を組み込んでいて、画像やウェブ検索結果など、視覚的な出力を直接受け取り、それを解析して必要なツールを自動的に実行するといった「見る→理解→行動」の一連の操作をモデル単体で完結できます。

GLM-4.6Vシリーズには、前述のように2つのモデルが含まれています。

大規模版のGLM-4.6Vは、クラウドサーバーや高性能GPUクラスタ上での動作を想定したフラッグシップモデルで、極めて高い精度と包括的な機能を備えています。

一方、軽量版のGLM-4.6V-Flashは、パラメータ数を約9億に抑え、ローカル環境でも扱いやすくしたモデルで、低遅延・高速応答が求められるケースに適しています。

コンテキスト長は、両モデルとも最大128kトークンと非常に長く、100ページを超える文書や長時間の動画でも一度に入力して処理できるポテンシャルを持っています。

Z.ai公式によると、およそ150ページ(あるいは1時間程度の動画)の情報量を1回の推論で読み込んで分析できるとのことです。

なお、従来モデルのGLM-4.5シリーズについて詳しく知りたい方は、以下の記事も参考にしてみてください。

GLM-4.6VとGLM-4.6V-Flashの違い

GLM-4.6Vシリーズの2モデル、GLM-4.6V(以下「本モデル」)とGLM-4.6V-Flash(以下「Flash版」)は、基本的なアーキテクチャや機能は共通していますが、その規模が大きく異なります。

まず、本モデルは、約1,060億ものパラメータを持つ超大型モデルで、動作には強力なGPUサーバー(A100クラスのGPUを複数枚搭載したマシンなど)が必要になります。

その分、モデルの表現力や理解力は非常に高く、微細なニュアンスの読み取りや複雑な推論、一段と正確な回答生成が期待できます。

一方のFlash版は、約90億パラメータと、本モデルの約1/12のサイズに削減された軽量モデルです。パラメータ数こそ大幅に減っていますが、その代わりモデルを動かすための計算資源やメモリ要件がかなり低く、一般的なPC向けGPUでも動作可能となっています。

GLM-4.6VとGLM-4.6V-Flashの性能

Z.aiの研究チームは、画像理解や論理推論、長文処理など計20以上の代表的なベンチマークで評価を行い、同程度のモデル規模で比較した場合に、GLM-4.6Vが軒並み最高クラスのスコアを達成したと報告しています。

例えば、視覚質問応答の指標である「MMBench」では、GLM-4.6Vが88.8点という高スコアを記録し、オープンな同規模モデルの中ではトップクラスの成績でした。

また、Flash版も86.9点をマークし、10億未満クラスでは突出した性能です。

他にも、数学を含む視覚推論を測る「MathVista」や、画像中の文字認識精度を見る「OCRBench」などで、軒並み高評価を得ています。

なお、生成AI搭載のOCRについて、詳しく知りたい方は以下の記事も参考にしてみてください。

GLM-4.6VとGLM-4.6V-Flashのライセンス

GLM-4.6VおよびGLM-4.6V-Flashは、いずれもMITライセンスで公開されています。

MITライセンスはオープンソースライセンスで、商用・非商用を問わず、ソフトウェアを自由に利用・改変・再配布できるのが特徴です。

| 利用用途 | GLM-4.6V (106B) | GLM-4.6V-Flash (9B) |

|---|---|---|

| 商用利用 | ⭕️ | ⭕️ |

| 改変 | ⭕️ | ⭕️ |

| 配布 | ⭕️ | ⭕️ |

| 特許使用 | ⭕️ | ⭕️ |

| 私的使用 | ⭕️ | ⭕️ |

GLM-4.6VとGLM-4.6V-Flashの料金

GLM-4.6Vシリーズは、オープンソースモデルとして重みデータが公開されているため、自前で実行する限り、コストは基本的にサーバー設備等の実費のみです。

しかし、Z.ai社は、自社のクラウドサービス上でAPI経由の利用も提供しており、その場合には以下のような利用料金モデルが設定されています。

| モデル | 入力単価(100万トークン) | 出力単価(100万トークン) |

|---|---|---|

| GLM-4.6V (106B) | $0.6 | $0.9 |

| GLM-4.6V-Flash (9B) | 無料 | 無料 |

GLM-4.6VとGLM-4.6V-Flashの使い方

GLM-4.6Vシリーズの使い方としては、大きく分けて(1)オンライン、(2)API、(3)ローカル環境の3パターンがあります。

1. オンライン(Z.ai公式チャットサービス)

1番お手軽なのが、Z.ai社が提供するウェブチャットUI「Z.ai Chat」を利用する方法です。

ブラウザで公式サイトのチャットページにアクセスし、モデル選択メニューから「GLM-4.6V」を選ぶだけで利用することができます。

2. API経由で利用する

GLM-4.6Vシリーズを自分のアプリやサービスに組み込んで使いたい場合、Z.aiの提供するOpenAI互換APIを利用する方法が便利です。

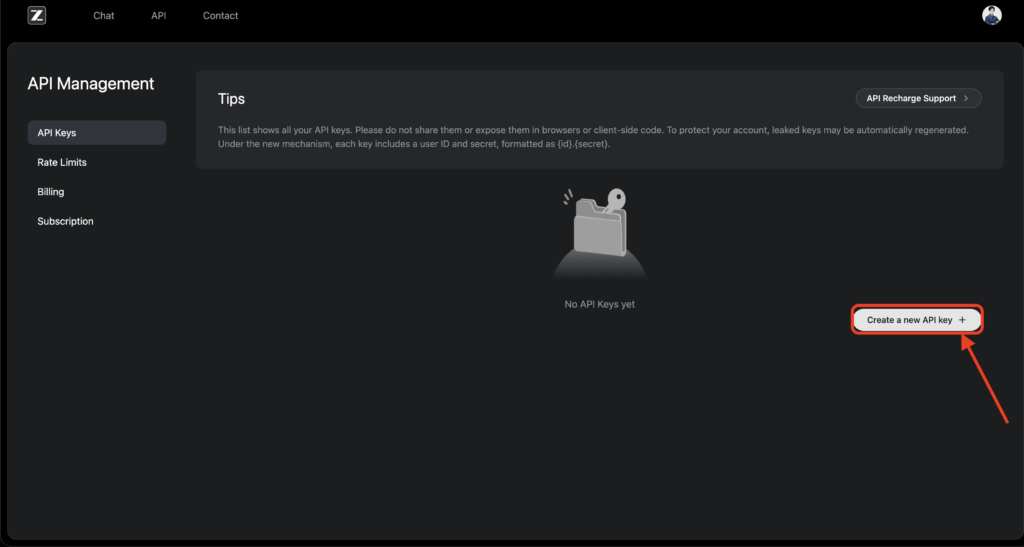

まず、Z.aiの開発者向けサイトでアカウント登録を行い、ダッシュボードからAPIキーを取得します。

APIはOpenAI社のAPIと高い互換性があり、エンドポイントURLやリクエスト形式はほぼ同じなので、既存のOpenAI API用ライブラリやコードを流用してGLM-4.6Vを呼び出すことも可能です。

具体的には、APIリクエストのヘッダーに取得したAPIキーを設定し、エンドポイントにモデル名として "glm-4.6v" あるいは "glm-4.6v-flash" を指定してリクエストを送ります。

利用料金は前述の通りですが、Flash版であればAPI経由でも無料で利用できるため、まずはFlash版APIから試してみるのも良いかと思います。

3. ローカル環境でモデルを動かす

Z.aiは、モデルの重みデータを公開しており、誰でもHugging Face経由でダウンロードできます。

まず、Hugging Faceのモデルページ(zai-org/GLM-4.6V および zai-org/GLM-4.6V-Flash)からそれぞれのモデルのファイル一式を入手します。

106B版はファイルサイズが非常に大きく、数100GB規模になるので注意してください。9B版であれば、数10GB程度です。

モデルはデータ並列で複数ファイルに分割されているので、git-lfs 等を用いて取得すると良いと思います。

次に、モデルを動かすための環境を用意します。

Pythonで実行する場合、Transformersライブラリが対応しているので、必要なバージョンをインストールします(2025年12月現在、Transformers 5.xが推奨されています)。

あわせて、画像入力など、マルチモーダル機能を扱うためのAutoProcessorも利用します。以下のような手順で推論が可能です。

from transformers import AutoProcessor, Glm4vMoeForConditionalGeneration

import torch

MODEL_PATH = "zai-org/GLM-4.6V-Flash" # Flash版9Bモデルを指定(106B版の場合は "GLM-4.6V")

messages = [

{

"role": "user",

"content": [

{"type": "image", "url": "https://example.com/sample.png"},

{"type": "text", "text": "この画像の内容を説明してください。"}

],

}

]

processor = AutoProcessor.from_pretrained(MODEL_PATH)

model = Glm4vMoeForConditionalGeneration.from_pretrained(

MODEL_PATH,

torch_dtype="auto",

device_map="auto",

)

inputs = processor.apply_chat_template(messages, tokenize=True, add_generation_prompt=True,

return_dict=True, return_tensors="pt").to(model.device)

inputs.pop("token_type_ids", None)

generated_ids = model.generate(**inputs, max_new_tokens=8192)

output_text = processor.decode(generated_ids[0][inputs["input_ids"].shape[1]:], skip_special_tokens=False)

print(output_text)以上がGLM-4.6Vシリーズの主な使い方です。

用途や目的に応じて、ブラウザ上でお手軽に試す方法から本格的に組み込む方法まで揃っているのは嬉しいポイントですね。

GLM-4.6VとGLM-4.6V-Flashを使ってみた

ここでは実際にGLM-4.6Vを、Z.ai公式チャットページで試してみます。

長文・複数ドキュメントの比較分析

決算サマリーのダミー文章を3社分用意して、長文ドキュメントの比較分析をしてもらいます。

あなたは上場企業の決算を読み解くプロのアナリストです。

以下の3社分の決算サマリーを読み比べて、

1. 各社の「売上高・営業利益・営業利益率」を一覧表にまとめる

2. 各社の成長要因・リスクを一行ずつ要約して対比する

3. 投資家目線で見たときの「特徴的な違い」や「気になるポイント」を整理する

という3点を日本語で分かりやすくまとめてください。

出力形式の希望は以下の通りです。

- 最初に、3社の主要指標をまとめた簡潔な表(マークダウン形式)

- その次に、各社ごとの「成長要因」と「リスク・課題」を1〜2行で整理

- 最後に、「3社を比較して分かること」を箇条書きではなく自然な文章で解説

なお、数値や文言は必ず以下の資料の内容に基づいてください。

外部情報を勝手に補完したり、想像で付け加えたりしないでください。

【資料1:Aテックホールディングス 2024年度通期決算サマリー】

・売上高:3,250億円(前年同期比 +12.3%)

・営業利益:410億円(前年同期比 +8.7%)

・営業利益率:12.6%

・主力事業:クラウドインフラ、データ分析プラットフォーム

・成長要因:

- 企業向けクラウド移行需要の継続

- 既存顧客へのサブスクリプション単価アップ

・リスク・課題:

- 海外大手クラウド事業者との価格競争

- データセンター新設に伴う設備投資負担

────────────────────────

【資料2:Bファイナンスグループ 2024年度通期決算サマリー】

・売上高:1,480億円(前年同期比 +3.1%)

・営業利益:195億円(前年同期比 -4.5%)

・営業利益率:13.2%

・主力事業:個人向けローン、キャッシュレス決済

・成長要因:

- キャッシュレス決済利用件数の増加

- 手数料収入の底堅さ

・リスク・課題:

- 金利上昇局面での調達コスト増加

- 与信コストの上振れリスク

- 新興フィンテックとの競争激化

────────────────────────

【資料3:Cリテールパートナーズ 2024年度通期決算サマリー】

・売上高:8,920億円(前年同期比 +1.8%)

・営業利益:310億円(前年同期比 +0.4%)

・営業利益率:3.5%

・主力事業:総合スーパー、ドラッグストア、EC

・成長要因:

- ドラッグストア業態の堅調な既存店売上

- ECチャネルの売上成長

・リスク・課題:

- 人件費・光熱費など固定費の増加

- 価格競争による粗利率の低下

- 地方店舗の来店客数減少

指示通りに情報を抽出できていて、出力自体も簡潔でわかりやすいですね。

他にも、画像や動画を入力として理解・処理させたり、より膨大な量のテキストを読み込ませるケースでも、パワーを発揮してくれると思いますので、気になる方はぜひ試してみてください。

まとめ

GLM-4.6VとGLM-4.6V-Flashは、最新の研究成果を取り入れた強力なマルチモーダルAIモデルです。

クラウド向けの106B版とローカル向けの9B版という2つの選択肢が用意されたことで、誰もが自分のニーズに合った形でこの先端モデルを活用できるようになっています。

ぜひみなさんも一度、試してみてください!

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。