【Qwen 3】アリババ発の最新LLMファミリー|概要から使い方まで徹底解説

- 「Thinking」モードをオン/オフできる設計

- Apache2.0ライセンスのもとでOSSで提供

- クラウドだけでなくローカルでも利用可能

2025年4月29日、Alibaba Cloudから最新大規模言語モデルファミリー「Qwen 3」がリリースされました!

前世代のQwen 2.5の推論・多言語性能に加え、思考プロセスを“見せる/隠す”モードを自在に切り替えられるハイブリッド設計を採用し、パフォーマンスとコスト効率を大幅に向上させているようです。

さらにQwen 3は、オープンソースとして無償公開されており、世界中の開発者から大きな注目を集めています。

本記事では、Qwen 3の特徴や使い方、活用方法まで詳しく解説していきます。ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Qwen 3の概要

Qwen 3は大きく分けて、「Denseモデル(0.6B~32B)」6つと「Mixture-of-Experts(MoE)モデル(30B-A3B/235B-A22B)」2つの2種類、計8つのモデル構成を持っています。

最大40,960トークンの長文入力に対応し、「思考モード(Thinking Mode)」を自由に切り替えることができます。

思考モードをオンにすると、推論過程が表示され、数学やコード生成など複雑なタスクに効果を発揮し、オフにすると、高速でシンプルな応答が可能です。

また、100以上の言語に対応しており、多言語翻訳ベンチマークで前世代比平均+6 BLEUというハイスコアを記録しています。

オープンソース版がHugging Face/ModelScope/GGUF形式で同時公開されており、ローカル環境やクラウドサービスで容易に利用することもできます。また、使用した分だけ課金される柔軟な料金体系も評価されているポイントです。

さらに、Alibaba Cloud Model Studioは“思考深度×消費トークン”課金を導入し、同一モデル内でコストと精度をタスクごとに最適化することができる仕組みになっています。

Qwen 3のライセンス

Qwen 3はApache 2.0準拠のOSSライセンスで提供されています。

OSSライセンスは自由度が高い一方、法的遵守が必須となるため、プロダクトに組み込む際はApache 2.0の条文および商標ガイドラインを必ず確認するようにしましょう!

特に、再配布時のLICENSEファイル添付や特許条項の扱いに注意することで、後々のトラブルを回避することができるかと思います。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | ⭕️ | Apache 2.0準拠、利用制限なし |

| 改変 | ⭕️ | フォーク・再学習・派生モデル作成が自由 |

| 配布 | ⭕️ | モデル・コード双方の再配布可(LICENSE必須) |

| 特許利用 | ⭕️ | Apache 2.0の特許許諾条項が適用される |

| 私的利用 | ⭕️ | 研究・学習用途も自由 |

Qwen 3は商用・非商用ともに広い自由度が担保されています。

したがって、自社サービスへの組み込みだけでなく、学術研究や個人開発でも安心して活用できます。

ただし、AI生成物の二次利用規約や第三者データの取り扱いは別途契約・ポリシーに従う必要がある点は覚えておきましょう。

Qwen 3の料金プラン

OSS版は完全無料ですが、クラウドAPIを使う場合はトークンベース課金が発生します。

API呼び出し時に “enable_thinking” をオンにすると出力トークン数が増えるため、コストが跳ね上がる点に注意しましょう。

| プラン | 入力料金 | 出力料金 | 無料枠 | 主な用途 |

|---|---|---|---|---|

| OSS版 | 無料 | 無料 | 無制限 | ローカル推論・微調整 |

| Qwen-Turbo | $0.05 | $0.20 | 100万トークン/180日 | 一般的なアプリバックエンド |

| Qwen-Plus | $0.40 | $1.20 | 100万トークン/180日 | 高精度RAG/自律エージェント |

| サードパーティ | 約$0.15 | 約$0.35 | なし | 小規模検証 |

上記の料金表は2025年4月末時点のものです。

Alibaba Cloudはキャンペーンで無料枠を拡充することが多いので、公式アナウンスを定期的にチェックするとベターです!

また、vLLMなどで独自ホスティングすることで、APIよりさらに低コストで運用することもできるかと思います。興味のある方はぜひ試してみてください。

Qwen 3 使い方

Qwen 3の使い方を「ローカル環境での利用」と「クラウドAPI経由での利用」の2つのパターンからご紹介します。

ローカル利用(GoogleColab)

ローカル環境での利用方法は以下の通りです。

なるべくメモリを使用しない方法で、GoogleColabで実装していきます。

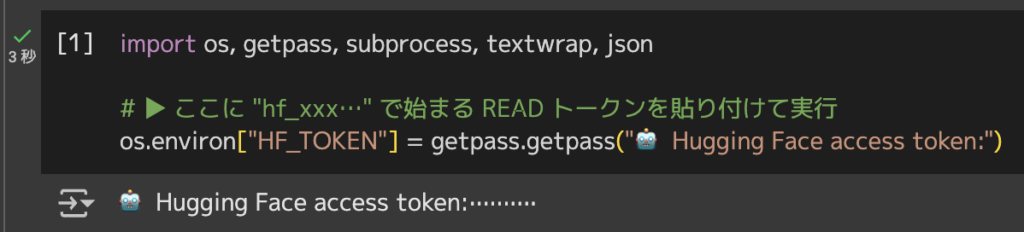

1.HuggingFaceでアクセストークンを取得

ブラウザで https://huggingface.co/settings/tokens にアクセスし、”Create new token”から新規アクセストークンを取得しましょう。

その後、GoogleColab上で以下コードを実行し、上記で取得したアクセストークンを入力してください。

import os, getpass, subprocess, textwrap, json

# ▶ ここに "hf_xxx…" で始まる READ トークンを貼り付けて実行

os.environ["HF_TOKEN"] = getpass.getpass("🤖 Hugging Face access token: ")以下画像のように実行完了できていればOKです。

2.GitとGit LFSをセットアップ

GoogleColabにはGitは入っていますが、LFSが無いので追加します。以下コードを実行してください。

!apt-get -qq install git-lfs

!git lfs install3.認証情報をGitに渡す

GoogleColabセッション用にcredential helperを設定し、以降のgit cloneで自動的にトークンが送信されるように設定します。

%%bash

git config --global credential.helper store

echo "https://user:${HF_TOKEN}@huggingface.co" > ~/.git-credentials4.ポインタのみクローン

大容量ファイルは落とさず、ポインタだけをクローンします。

%%bash

export HF_TOKEN=$HF_TOKEN # bash セクションでも参照できるように

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/Qwen/Qwen3-0.6Bクローン完了後、リポジトリ構造は /content/Qwen3-0.6B以下に展開されますが、pytorch_model-00001-of-00002.binなどのLFSオブジェクトはまだ実体がない状態になります。

5.safetensors取得

%%bash

cd /content/Qwen3-0.6B

git lfs pull -I "*.safetensors" # ≃ 1.8 GB ダウンロード6.モデル作成

model = AutoModelForCausalLM.from_pretrained(

model_dir,

trust_remote_code=True,

torch_dtype=torch.float16 # use_safetensors=True が既定値

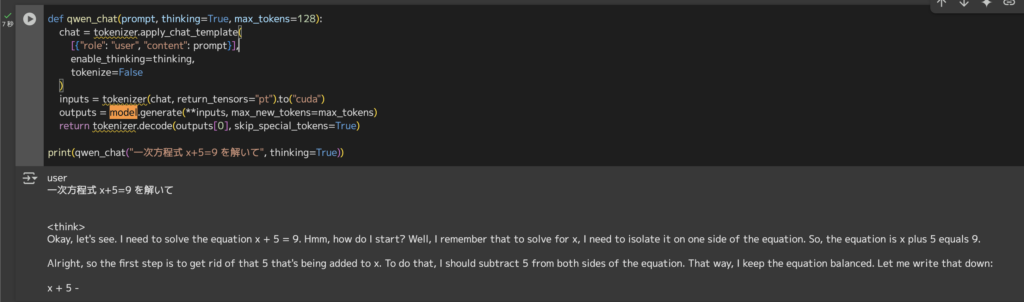

).to("cuda").eval()7.モデル実行

def qwen_chat(prompt, thinking=True, max_tokens=128):

chat = tokenizer.apply_chat_template(

[{"role": "user", "content": prompt}],

enable_thinking=thinking,

tokenize=False

)

inputs = tokenizer(chat, return_tensors="pt").to("cuda")

outputs = model.generate(**inputs, max_new_tokens=max_tokens)

return tokenizer.decode(outputs[0], skip_special_tokens=True)

print(qwen_chat("一次方程式 x+5=9 を解いて", thinking=True))以下画像のように出力が得られれば、ローカル環境でQwen 3を使える状態になりました。

クラウドAPI経由(Alibaba Cloud DashScope)

クラウドAPI経由でのQwen3の使用方法は以下の通りです。

1.DashScopeアカウントを開設しAPIキーを取得

ダッシュボード → API Key → Copy

2.エンドポイントとモデルIDを確認

例えば以下のとおり。

3.基本リクエスト(Thinking OFF)

curl "$ENDPOINT" \

-H "Authorization: Bearer $API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen-turbo-b-32k",

"messages": [{"role":"user","content":"Translate to French: Good morning"}]

}'4.Thinking Modeをオンにする例

curl "$ENDPOINT" \

-H "Authorization: Bearer $API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen-plus-b-32k",

"messages": [{"role":"user","content":"Explain RSA encryption in simple terms"}],

"extra_body": {"enable_thinking": true}

}'5.Python SDK利用(インライン生成)

from dashscope import client

rsp = client.Chat.completions.create(

model="qwen-turbo-b-32k",

messages=[{"role":"user","content":"Hello"}],

extra_body={"enable_thinking": False}

)

print(rsp.choices[0].message.content)6.料金管理に関するTips

以下のポイントを押さえておくことで、コスト削減に繋げられるかと思います。

- enable_thinkingを必要な呼び出しだけに限定する

- 長文はtemperature=0とmax_tokensでコントロールする

- 定額割引クーポン(Alibaba Cloud Coupon Pack)を活用する

以上、ローカル実行は、“自由度・完全オフライン・最小コスト”が魅力ですが、GPUメモリと運用保守については自己責任となります。

対して、クラウドAPIは“スケール・可用性・運用不要”の代わりにトークン課金が発生します。

プロトタイピングはローカル、プロダクションはAPIといったイメージでハイブリッド運用が現実的な落としどころになるかと思います。

Qwen 3を検証してみた!

Qwen 3の実力をチェックするため、「長文読解」、「コードリファクタリング」、「多言語翻訳」の3つのタスクで検証してみます!GoogleColab環境で進めていきます。

長文読解

入力プロンプトこちら

以下長文を3行で要約して。

本日は、松尾教授の研究室で、AIについての講義を受け、そしてまた実際に、AIの演習というか、私、あるいは5人の大臣(あべ大臣、中谷大臣、平大臣、赤澤大臣、城内大臣)と一緒にさせていただきました。それぞれの大臣が、それぞれの分野で、AIについて学ぶことはあるのだけれども、これだけ多くの閣僚が一遍に学ぶっていうのは、非常に意義のあることだったと思っています。AIというものが一体どういうものなのか、そして、これが世の中をどう変えるか、そして日本が世界の中でどういう立ち位置にあるか、これから何をしなければいけないかということについて、非常に学ぶことが多かったと思っております。我々として、これから先、人口が急激に減っていく中にあって、いかにして日本を発展させていくかというときに、AIが果たす役割は非常に大きい。そして、それに対して我々として、世界で最もAIの開発がやりやすい国ということにしたいと思っています。これは掛け声だけではなくて、ほんとに世界で最もAI開発が進んでいる国にしたい。それは決して容易なことではないけれども、城内大臣を中心に、これはやっていきたいというふうに思っておるところでありますし、同時に、最も使いやすい国にしたいと思っています。すみません、正確を期すためにちょっと朗読調になります。いくつかありますが、まず、急速にAIが進歩していると。昨日と今日どころか、朝と夜で違いますみたいな、ものすごいスピードで進化をしているわけですね。今、国会で審議中でありますが、AI法案というものを早く成立をさせると。イノベーション促進と、これリスクもありますんで、リスク対応を両立させながら、先ほど来、申し上げているように、世界で最もAIを開発、そして活用しやすい国ということを目指してまいりたいと思いますし、このような私どもの姿勢というのは、AI半導体分野の世界のトップ企業でありますNVIDIAのジェンスン・フアンさん、あるいはAMDのリサ・スーさん、AWSのマット・ガーマンさん、私もそれぞれ、お話をいたしましたが、賛同も受け、日本への大規模な投資というものを表明してもらっているところであります。Denseモデル、ローカル実行でも充分な結果を得ることができました。

文末が字余り状態にはなっていますが、要約内容自体は問題ないです。

コードリファクタリング

入力プロンプトこちら

次のPythonコードをコメント付きでリファクタリングして。

def process_data(data):

"""

data: List[Any]

数値(int/float)と文字列(数値化可能なもの)のみを集計し、

・合計値

・各要素×2 のリスト

・平均値

を辞書で返します。

"""

result = []

total = 0

for item in data:

if item is None: # None はスキップ

continue

if isinstance(item, (int, float)):

total = total + item

result.append(item * 2)

elif isinstance(item, str):

try:

num = float(item) # 文字列 → 数値変換

total += num

result.append(num * 2)

except: # 変換失敗は無視

pass

average = None

if len(result) > 0:

average = sum(result) / len(result)

return {"sum": total, "doubled": result, "average": average}結果はこちら

Okay, I need to make this Python code more readable, DRY (Don't Repeat Yourself), handle exceptions properly, add type hints, and improve the code structure. Let me start by looking at the original code.

The function is called process_data, which takes a list of Any. The function returns a dictionary with three keys: sum, doubled, and average. The code processes each item in the data list, adding to total and creating a result list. It checks if the item is None and skips it. Then, for each item that's not None, it checks if it's an int or float and

和訳:

よし、このPythonコードをもっと読みやすく、DRY(Don't Repeat Yourself)にして、例外を適切に処理し、型ヒントを追加し、コード構造を改善する必要がある。まず元のコードを見てみよう。

この関数はprocess_dataと呼ばれ、Anyのリストを受け取ります。この関数は、sum、doubled、average の 3 つのキーを持つ辞書を返します。コードはデータ・リストの各項目を処理し、合計に加算して結果リストを作成します。項目が None であるかどうかをチェックし、それをスキップします。次に、Noneでない各項目について、それがintまたはfloatであるかどうかをチェックします。モデルサイズが原因なのか、GoogleColabでの実行が問題なのか不明ですが、意図した出力は得られませんでした。

何度か実行しましたが、同様の結果でしたので、もしリファクタリングを試したい方は、モデルサイズや環境、設定を変更すると良いかもしれません。

多言語翻訳

入力プロンプトこちら

生成AIは私たちの働き方を変える」を日本語→英語→フランス語→日本語の順に逐次翻訳し、それぞれの文も表示して。結果はこちら

Okay, let's start by breaking down the user's request. They want a translation of the phrase "生成AIは私たちの働き方を変える" in three languages: Japanese, English, and French. The user wants each translation step by step, so I need to make sure I cover all the words and phrases accurately.

First, I'll translate the Japanese phrase. "生成AIは私たちの働き方を変える" translates to "AI generation is changing our work methods." That seems straightforward.

Next, I need to convert this English phrase into French. The original sentence is about AI generating changes in

和訳:

さて、まずはユーザーのリクエストを分解してみよう。生成AIは私たちの働き方を変える "というフレーズを3つの言語で翻訳してほしい: 日本語、英語、フランス語である。ユーザーはステップ・バイ・ステップの翻訳を望んでいるので、私はすべての単語とフレーズを正確にカバーする必要があります。

まず、日本語のフレーズを訳します。「生成AIは私たちの働き方を変える 「は 」AI世代が私たちの働き方を変える "と訳す。これは簡単だ。

次に、この英語のフレーズをフランス語に変換する必要がある。元の文章は、AIが私たちの仕事のやり方を変えるという内容だ。こちらも出力文字数制限により、出力が途切れてしまっていますが、思考連鎖しながら翻訳することができていることがお分かりいただけるかと思います!

お手軽に試行したい場合は、Denseモデルでも充分の性能です。

Qwen 3 活用可能性

ここからは、実際にQwen 3にはどのような活用可能性があるのかをわかりやすくご紹介します。

Qwen 3の柔軟な推論機能や多言語対応が、さまざまな分野でどのように業務効率化に役立っているのかをご確認ください。

製造業:部品調達プロセスの最適化

製造業の部品調達においては、部品の在庫切れリスクや価格の管理が重要かと思います。

Qwen 3は、部品のデータベースと連携して、必要な部品の代替品を素早く自動提案することができます。

特に、Thinkingモードを有効にすると、提案した部品がなぜ適切なのかという理由や納期、特性を詳細に説明してくれるため、担当者は経緯に納得したうえで迅速に判断することができます。

これにより、「見積り」や「承認」にかかる作業時間が削減され、部品の品質保証や監査対応も容易になると期待されます。

ECサイト:多言語対応の商品ページ生成

オンラインストアでは、世界各国向けの商品ページを迅速に展開する必要があります。

Qwen 3を使えば、商品情報をJSON形式で入力するだけで、100以上の言語に対応した商品タイトル、説明文、SEO用のキーワードまで瞬時に生成することができます。

従来は、翻訳や校正に数日を要していたようなタスクが、Qwen 3を導入することで、わずか数十分程度で完了する見込みとなり、新製品を全国へ迅速に投入できるようになると期待されています。

ゲーム開発:キャラクターの自律的な対話生成

ゲーム開発では、キャラクター(NPC)のリアルな会話や行動パターンの作成に手間がかかります。

Qwen 3をUnityゲームエンジンと組み合わせて導入すると、ゲーム内の状況に応じてNPCが自然な対話を自動で生成してくれます。

特にThinkingモードでは、キャラクターの性格や動機を可視化しながら会話内容を調整できるため、ストーリーやゲームの世界観を損なうことなく高品質な会話シナリオを効率よく作成することができるようになります。

ローカル環境で動作するため、開発コストを抑えつつゲーム品質を高められます。

以上、これらの事例からわかるように、Qwen 3の柔軟な推論能力や説明機能は業務の現場で大きな効率化と品質向上を実現する可能性があります。

特にThinkingモードを活用することで、単なる業務効率化だけでなく、担当者が納得感を持って判断・作業を進められるようになることが大きなメリットといえますね。

まとめ

Qwen 3は、高い推論能力と多言語対応力に加え、「Thinkingモード」のオン・オフで推論の深度を自由に調整できる柔軟性を備えた最新の生成AIモデルです。

Apache 2.0ライセンスでオープンソース公開されており、個人から企業まで幅広く活用することができます。

料金体系も明確で、ローカル環境とクラウドAPIの両方で簡単に導入できるため、さまざまな用途での効率化や業務改善に貢献が期待されます。

気になる方は、本記事でご説明した使い方を参考に、ぜひ試してみてください!

最後に

いかがだったでしょうか?

生成AIを“試す”段階から“活用する”段階へと進む今、業務効率だけでなく、開発・翻訳・技術検証などの現場における実用性が問われています。

貴社の目的に最適なモデル選定や導入ステップを整理し、具体的なユースケースに落とし込むための情報を、この先の一歩としてご活用ください。

貴社の事業にどう活かせるか、具体的な導入事例や最適な活用方法をご提案できますので、ぜひご相談ください。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。