【Llama 3.1】405BパラメータMeta製LLM!数々のクローズドソースを凌駕?

WEELメディア事業LLMライターのゆうやです。

2024年7月24日、ついにMeta社からLlama 3.1が公開されました!

今回の発表の目玉はなんといってもLlama 3.1 405Bで、このモデルは4050億のパラメータと128,000のコンテキストウィンドを有する超高性能モデルです。

その性能は、最新のクローズドモデルであるGPT-4oやClaude 3.5 Sonnetと同等かそれ以上で、間違いなくオープンソースモデルの中では最高の性能です。

今回は、Llama 3.1を405Bモデルを中心にその概要や使ってみた感想をお伝えします。

是非最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

Llama 3.1の概要

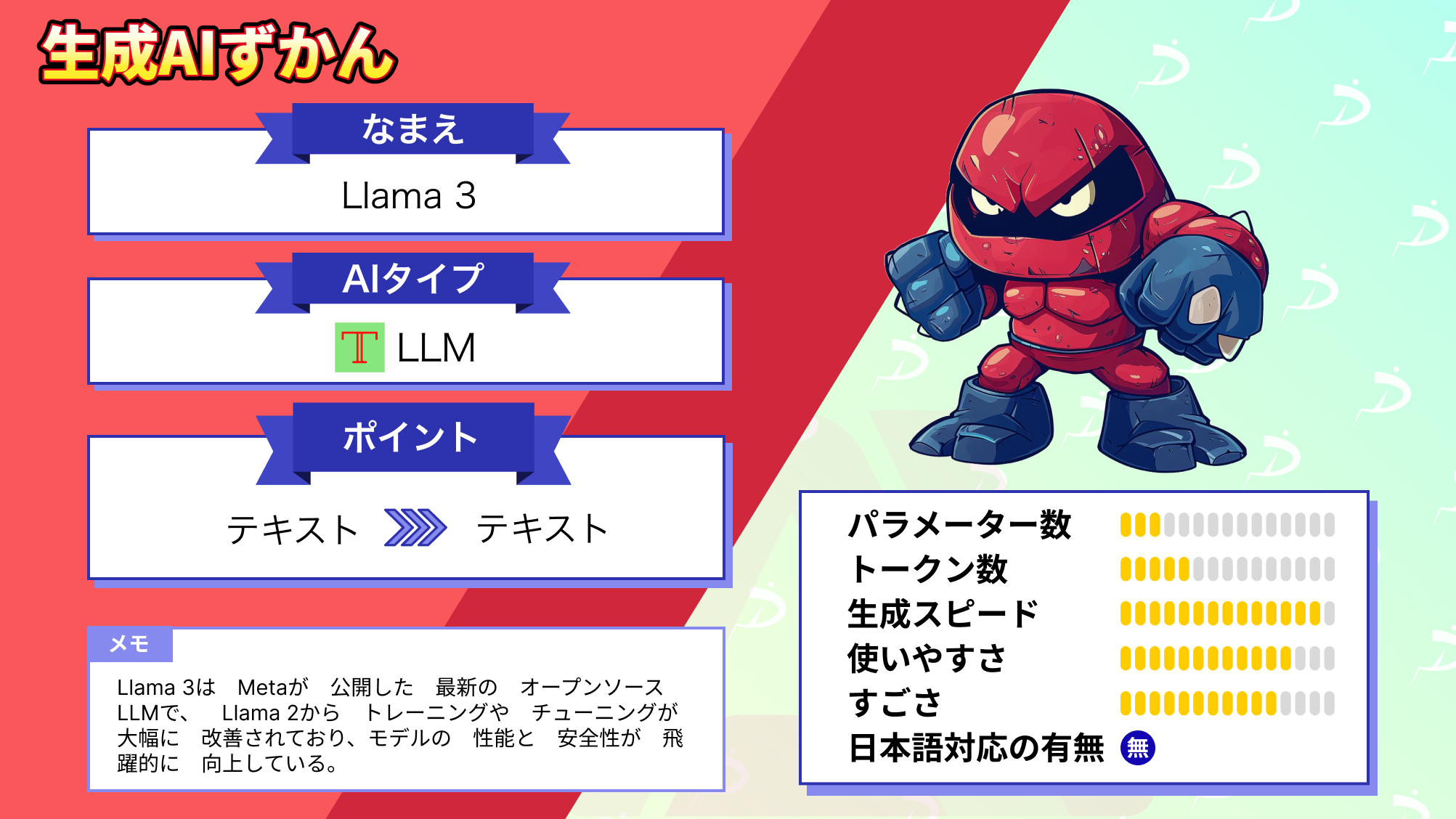

Llama 3.1は、20204年7月24日にMeta社から公開された最新のオープンソースLLMです。

「8B」「70B」「405B」の3つのモデルが公開されており、それぞれモデルサイズは大きく違いますが、すべてのモデルが128,000のコンテキストウィンドウを有しています。

Llama 3.1の中でも、目玉となるのがオープンソースモデルとしては類を見ないほど大きな405Bモデルです。

このモデルは、ベンチマークで最新のクローズドモデルであるGPT-4oやClaude 3.5 Sonnet等と同等かそれ以上の性能を示しており、オープンソースモデルとしては間違いなく最高の性能を有しています。

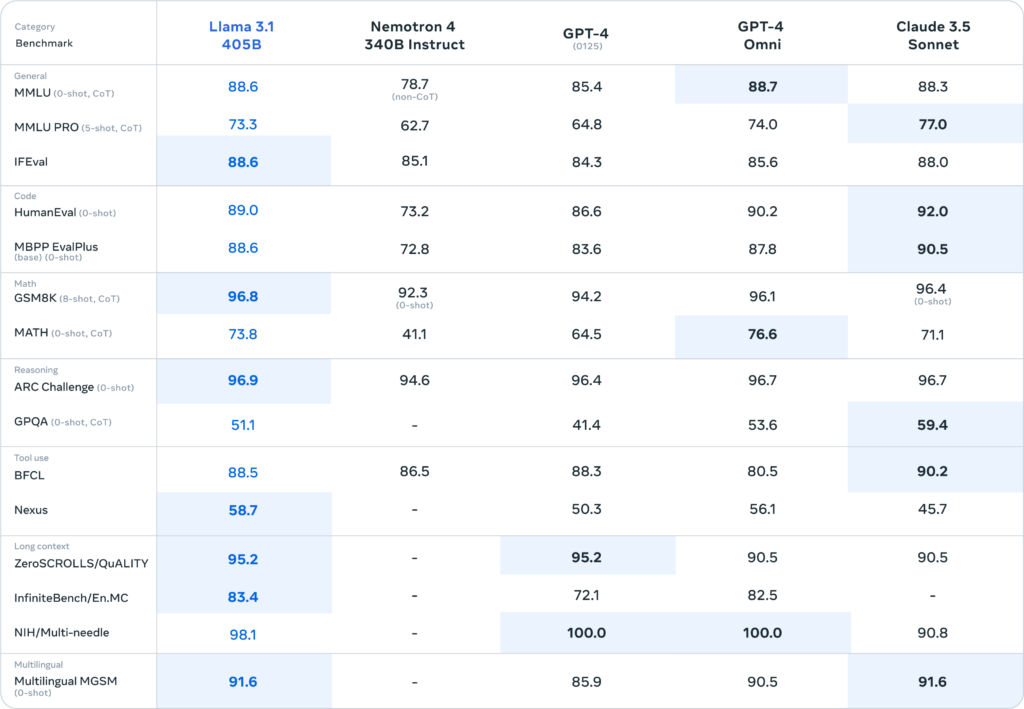

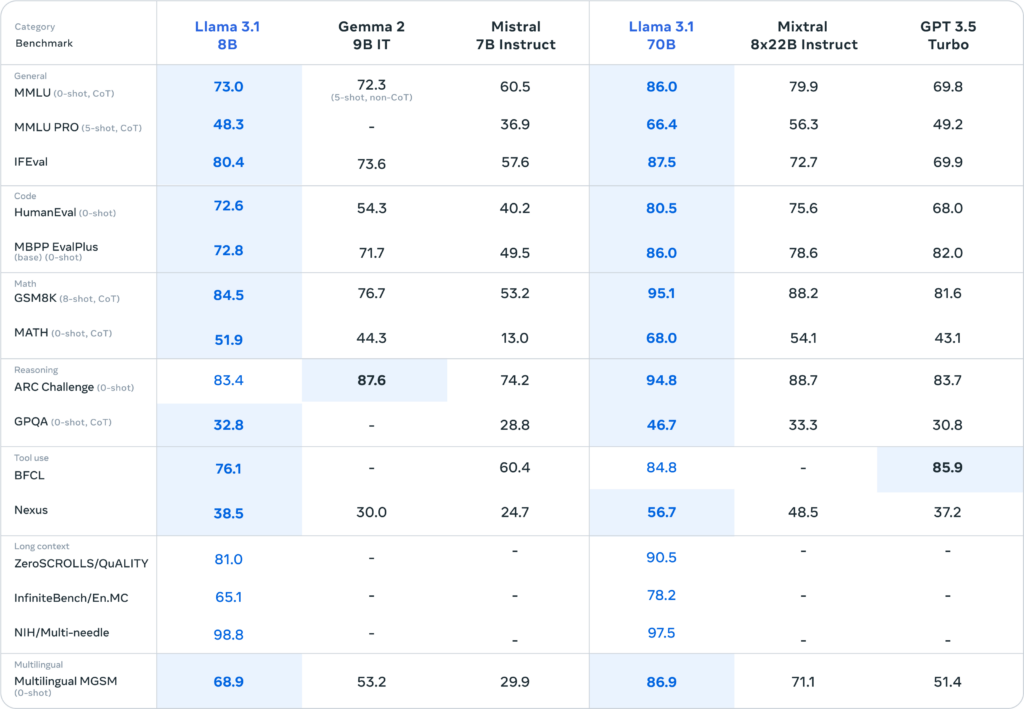

この表は、Llama 3.1 405Bのベンチマーク結果をNemotron 4 340B Instruct、GPT-4、GPT-4o、Claude 3.5 Sonnetと比較したものです。

この表を見ると、数学やマルチリンガルなど合計7つのベンチマークで最も高いスコアを獲得していることが分かります。

最新のクローズドモデルにも引けを取らない結果になっており、Llama 3.1 405Bのすごさが伺えます。

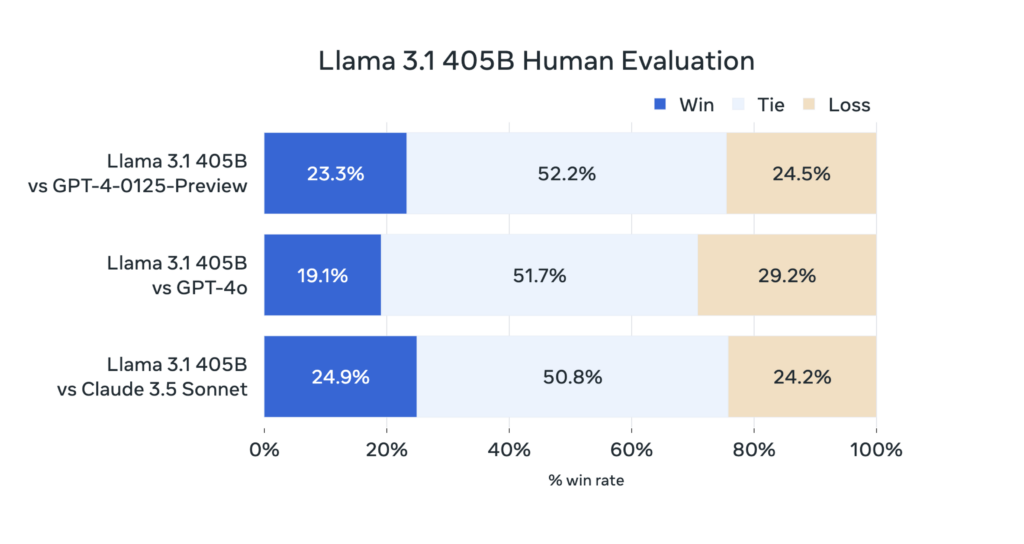

また、Llama 3.1 405Bの出力結果とGPT-4、GPT-4o、Claude 3.5 Sonnetの出力結果を人間が比較し、どちらがより優れているか検証した結果が以下のグラフです。

これを見ると、GPT-4oには負けてしまっていますが、GPT-4やClaude 3.5 Sonnetとは同等程度となっており、人間から見ても、Llama 3.1 405Bは最新のクローズドモデルに匹敵する能力を持っていることが分かります。

このように、最新の最新のクローズドモデルに匹敵する性能をもつLlama 3.1 405Bは、15兆を超えるトークンでトレーニングされ、この規模のトレーニングは非常に困難だったようです。

Metaは、このモデルをトレーニングするにあたり、16,000以上のNVIDIA H100 GPUを使用し、大規模なトレーニングを成功させました。

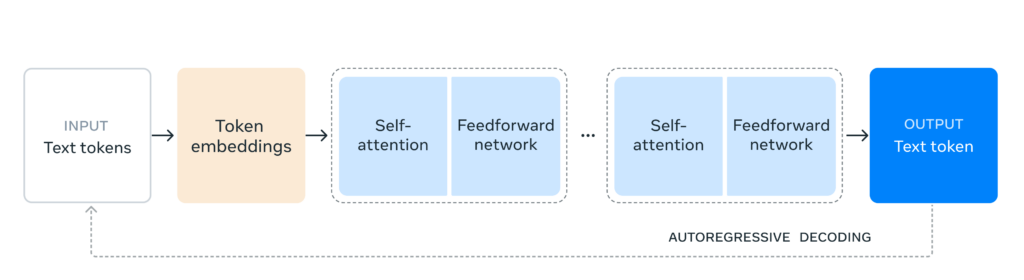

また、モデル開発ではシンプルな設計とトレーニング安定性を重視し、専門家混合モデルではなく、わずかな調整を加えた標準的なトランスフォーマーモデルを使用しています。

さらに、トレーニングデータの量と質を向上させ、慎重な前処理とフィルタリングを行うことで、モデルの性能を向上させました。

最後に、Llama 3.1 8BとLlama 3.1 70Bのベンチマーク結果も載せておきます。

どうしても405Bモデルに目が行きがちですが、8Bと70Bモデルも同クラスのモデルの中では頭一つ抜け出た性能を有しています。

ここからは、Llama 3.1の使い方を解説します。

なお、Llama 3について詳しく知りたい方はこちらの記事をご覧ください。

Llama 3.1のライセンス

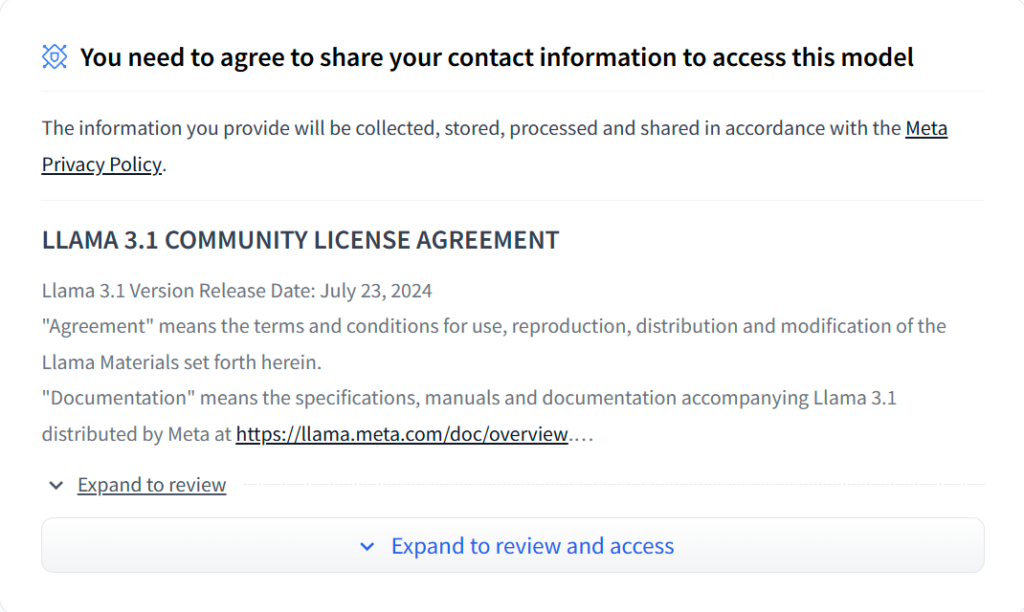

Llama 3はLLAMA 3.1 COMMUNITY LICENSE AGREEMENTのもとで提供されており、再配布や改変等は他のオープンソースモデルと同じように許可されていますが、商用利用には条件がある場合があります。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ ※月間アクティブ ユーザー数が 7 億人を超えている場合、ライセンスをリクエストする必要あり |

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | – |

| 私的使用 | ⭕️ |

Llama 3.1の使い方

Llama 3.1の各モデルは、Hugging Faceにて公開されているので、ダウンロードしてローカルで実装できますが、405Bモデルはスペック要件が高すぎるため、perplexityやNVIDIA NIMで使用することをおすすめします。

ここでは、ローカルで実装する方法を解説します。

Llama 3.1モデルをダウンロードして使用するには、連絡先情報の共有に同意して、リポジトリへのアクセスを許可してもらう必要があります。

許可が下りたら、以下のコードを実行してモデルのダウンロードを行います。

import transformers

import torch

model_id = "meta-llama/Meta-Llama-3.1-405B-Instruct"

pipeline = transformers.pipeline(

"text-generation",

model=model_id,

model_kwargs={"torch_dtype": torch.bfloat16},

device_map="auto",

)次に、以下のコードで推論を実行します。

messages = [

{"role": "system", "content": "You are a pirate chatbot who always responds in pirate speak!"},

{"role": "user", "content": "Who are you?"},

]

outputs = pipeline(

messages,

max_new_tokens=256,

)

print(outputs[0]["generated_text"][-1])これで実装は完了です。

Llama 3.1を実際に使ってみた

今回は、Llama 3.1 405Bを使用し、以下のプロンプトを入力します。

Please tell me about typical image generation AIs and their characteristics代表的な画像生成AIとその特徴を教えて

結果はこのようになりました。

結果はこちら

Here’s an overview of typical image generation AIs and their characteristics:

Types of Image Generation AIs:

- Generative Adversarial Networks (GANs): GANs consist of two neural networks: a generator and a discriminator. The generator creates images, while the discriminator evaluates the generated images and tells the generator whether they are realistic or not. Through this process, the generator improves, and the discriminator becomes more proficient at distinguishing between real and fake images.

- Variational Autoencoders (VAEs): VAEs are neural networks that learn to compress and reconstruct images. They consist of an encoder, which maps the input image to a lower-dimensional latent space, and a decoder, which generates an image from the latent space.

- Diffusion Models: Diffusion models are a class of generative models that iteratively refine the generated image by adding noise and then removing it. This process allows the model to explore different parts of the image space.

Characteristics of Image Generation AIs:

- Resolution: The resolution of the generated images can vary greatly, from low-resolution images (e.g., 28×28 pixels) to high-resolution images (e.g., 1024×1024 pixels).

- Realism: Image generation AIs can produce highly realistic images, but may also generate images with artifacts, such as blurry or distorted features.

- Diversity: Some image generation AIs can produce a wide range of diverse images, while others may generate images that are similar to each other.

- Mode coverage: Mode coverage refers to the ability of the AI to generate images that cover all the modes or styles present in the training data. Some AIs may excel at generating images in one style but struggle with others.

- Training data requirements: Image generation AIs typically require large amounts of training data to produce high-quality images. The quality and diversity of the training data can significantly impact the performance of the AI.

- Computational resources: Training image generation AIs can be computationally intensive, requiring significant GPU resources and memory.

- Evaluation metrics: Evaluating the performance of image generation AIs can be challenging. Common metrics include Inception Score (IS), Fréchet Inception Distance (FID), and Visual Information Fidelity (VIF).

Popular Image Generation AI Architectures:

- StyleGAN: A GAN-based architecture that generates highly realistic images of faces, objects, and scenes.

- BigGAN: A large-scale GAN architecture that generates high-resolution images with impressive realism and diversity.

- VAE-GAN: A hybrid architecture that combines the strengths of VAEs and GANs to generate high-quality images.

- DDPM: A diffusion-based architecture that generates high-quality images with impressive mode coverage and diversity.

Applications of Image Generation AIs:

- Computer vision research: Image generation AIs can be used to generate synthetic data for training and testing computer vision models.

- Art and design: Image generation AIs can be used to create artistic images, designs, and patterns.

- Data augmentation: Image generation AIs can be used to augment existing datasets with new images, which can improve the performance of machine learning models.

- Image-to-image translation: Image generation AIs can be used to translate images from one domain to another (e.g., converting daytime images to nighttime images).

I hope this provides a comprehensive overview of typical image generation AIs and their characteristics!

典型的な画像生成AIの概要と特徴を以下に示します。

画像生成AIの種類:

生成型対立ネットワーク(GAN):GANは、生成器と識別器の2つのニューラルネットワークで構成されています。生成器は画像を生成し、識別器は生成された画像を評価して、それが現実的なものかどうかを生成器に伝えます。このプロセスを通じて、生成器は向上し、識別器は本物と偽物の画像を区別する能力が高まります。

Variational Autoencoders (VAEs): VAEs は画像を圧縮し再構成することを学習するニューラルネットワークです。 入力画像を低次元の潜在空間にマッピングするエンコーダーと、潜在空間から画像を生成するデコーダーで構成されています。

拡散モデル:拡散モデルは、生成モデルの一種で、ノイズを加えてから取り除くという処理を繰り返し行うことで生成画像を改善します。このプロセスにより、モデルが画像空間のさまざまな部分を探索できるようになります。

画像生成AIの特徴:

解像度:生成される画像の解像度は、低解像度(例:28×28ピクセル)から高解像度(例:1024×1024ピクセル)まで、大きく異なります。

リアルさ:画像生成AIは極めてリアルな画像を生成できますが、ぼやけたり歪んだりした特徴を持つアーティファクトを含む画像を生成する場合もあります。

多様性:一部の画像生成AIは、幅広い多様な画像を生成できる一方、他のAIは互いに似た画像を生成する場合があります。

モードカバレッジ:モードカバレッジとは、AIがトレーニングデータに含まれるすべてのモードやスタイルをカバーする画像を生成できる能力を指します。AIによっては、あるスタイルの画像生成に長けているものの、他のスタイルの画像生成に苦戦するものもあります。

トレーニングデータの要件:画像生成 AI は通常、高品質な画像を生成するために大量のトレーニングデータが必要です。トレーニングデータの品質と多様性は、AI のパフォーマンスに大きな影響を与えます。

計算リソース:画像生成AIのトレーニングには、大量のGPUリソースとメモリが必要となり、計算負荷が高くなります。

評価指標:画像生成 AI のパフォーマンスを評価することは困難です。一般的な評価指標には、Inception Score (IS)、Fréchet Inception Distance (FID)、Visual Information Fidelity (VIF) があります。

一般的な画像生成AIアーキテクチャ:

StyleGAN:GANベースのアーキテクチャで、顔、物体、風景の極めてリアルな画像を生成します。

BigGAN:大規模なGANアーキテクチャで、非常にリアルで多様な高解像度画像を生成します。

VAE-GAN:VAEとGANの長所を組み合わせたハイブリッドアーキテクチャで、高品質な画像を生成します。

DDPM:拡散ベースのアーキテクチャで、モードカバレッジと多様性に優れ、高品質な画像を生成します。

画像生成AIの応用:

コンピュータビジョン研究:画像生成AIは、コンピュータビジョンモデルのトレーニングやテスト用の合成データを生成するために使用できます。

アートとデザイン:画像生成AIは、芸術的な画像、デザイン、パターンを作成するために使用できます。

データ拡張:画像生成AIは、既存のデータセットに新しい画像を追加して拡張し、機械学習モデルのパフォーマンスを向上させます。

画像から画像への変換:画像生成AIは、ある画像領域から別の画像領域への画像の変換に使用できます(例えば、昼間の画像を夜の画像に変換する)。

これで、典型的な画像生成AIとその特徴について、包括的な概要が理解できたかと思います!

GANやVAE、Diffusion Modelなどの代表的な画像生成モデルの概要や、画像生成AIそのものの特徴や応用例を詳しくまとめてくれています。

さすがは405Bモデルだと思います。

Llama 3.1を実行するのに必要なスペック

Llama 3.1 8Bであれば、NVIDIA RTX3090やRTX4090等の高性能な家庭用GPUであれば快適に動作しますが、70Bと405Bは非常に高いスペックが要求され、個人がローカルで動かすのはあまり現実的ではありません。

405Bモデルに関しては、NVIDIA A100やH100といったデータセンター用のGPUが複数台必要になります。

また、すべてのモデルで4.43.0以上のtransformersが必要になります。

モデルの実装前に、以下のコマンドでtransformersを更新してください。

pip install --upgrade transformersここからは、Llama 3.1 405BをGPT-4oとClaude 3.5 Sonnetと比較していきます。

Llama 3.1 405BをGPT-4oとClaude 3.5 Sonnetと比較してみた

今回の検証では、Llama 3.1 405B Instructを使用して、以下の項目を比較していきます。

- コーディング(形態素解析)

- ビジネスメールの作成(日本語)

早速検証していきましょう!

コーディング(形態素解析)

以下のプロンプトを入力して英語のテキストを日本語に翻訳して形態素解析するコードを生成してもらいます。

Generate a program that translates English text into Japanese and performs morphological analysis.英語のテキストを日本語に翻訳して形態素解析まで行うプログラムを生成して

結果はこのようになりました。

Llama 3.1 405Bの結果はこちら

Here is a Python program that uses the Googletrans library to translate English text into Japanese and the MeCab library to perform morphological analysis:

python

# Required libraries

from googletrans import Translator

import MeCab

# Function to translate English text to Japanese

def english_to_japanese(text):

translator = Translator()

result = translator.translate(text, dest='ja')

return result.text

# Function to perform morphological analysis

def morphological_analysis(text):

# Initialize MeCab with the IPADIC dictionary

mecab = MeCab.Tagger('-d /usr/lib/mecab/dic/ipadic')

# Parse the text

parsed = mecab.parse(text)

return parsed

# Example usage:

english_text = 'Hello, this is a test sentence.'

japanese_text = english_to_japanese(english_text)

print('Translated Japanese text:')

print(japanese_text)

morphological_result = morphological_analysis(japanese_text)

print('Morphological analysis result:')

print(morphological_result)

Requirements

- Python 3.x

googletranslibrary (install withpip install googletrans)mecablibrary (install withpip install mecab-python3)- MeCab and IPADIC dictionary installed on the system (installation depends on the operating system)

Explanation

- The

english_to_japanesefunction uses thegoogletranslibrary to translate the input English text into Japanese. - The

morphological_analysisfunction uses theMeCablibrary with the IPADIC dictionary to perform morphological analysis on the translated Japanese text. - The example usage shows how to use these functions to translate a test sentence and perform morphological analysis on the result.

Note: This program requires MeCab and the IPADIC dictionary to be installed on the system. Installation instructions can be found on the MeCab website. Also, be aware of the usage limits and potential inaccuracies of machine translation.

Googletrans ライブラリを使用して英語テキストを日本語に翻訳し、MeCab ライブラリを使用して形態素解析を行う Python プログラムは以下の通りです。

python

# Required libraries

from googletrans import Translator

import MeCab

# Function to translate English text to Japanese

def english_to_japanese(text):

translator = Translator()

result = translator.translate(text, dest='ja')

return result.text

# Function to perform morphological analysis

def morphological_analysis(text):

# Initialize MeCab with the IPADIC dictionary

mecab = MeCab.Tagger('-d /usr/lib/mecab/dic/ipadic')

# Parse the text

parsed = mecab.parse(text)

return parsed

# Example usage:

english_text = 'Hello, this is a test sentence.'

japanese_text = english_to_japanese(english_text)

print('Translated Japanese text:')

print(japanese_text)

morphological_result = morphological_analysis(japanese_text)

print('Morphological analysis result:')

print(morphological_result)

必要条件

Python 3.x

googletrans ライブラリ(pip install googletrans でインストール)

mecab ライブラリ(pip install mecab-python3 でインストール)

MeCabおよびIPADIC辞書がシステムにインストールされていること(インストール方法はオペレーティングシステムによって異なります)。

説明

english_to_japanese 関数では、googletrans ライブラリを使用して、入力した英語のテキストを日本語に翻訳します。

形態素解析機能では、MeCab ライブラリと IPADIC 辞書を使用して、翻訳された日本語テキストの形態素解析を行います。

この使用例では、これらの機能を使用してテスト文を翻訳し、その結果の形態素解析を行う方法を示しています。

注:このプログラムを使用するには、MeCabとIPADIC辞書をシステムにインストールする必要があります。インストール方法はMeCabのウェブサイトをご覧ください。また、機械翻訳には使用上の制限や不正確な点があることにご注意ください。

GPT-4oの結果はこちら

To create a program that translates English text into Japanese and performs morphological analysis on the Japanese text, you can utilize two main libraries: Google Translate API for translation and MeCab for morphological analysis.

Here is an example program in Python that does both:

Step 1: Set up Google Cloud Translate API

First, you need to set up the Google Cloud Translate API. Follow this guide to create a project, enable the API, and obtain your API key.

Step 2: Install necessary libraries

You need to install the google-cloud-translate library and mecab-python3 for translation and morphological analysis respectively. You can install these using pip:

pip install google-cloud-translate mecab-python3Step 3: Write the Python script

Below is the Python script that translates English text into Japanese and performs morphological analysis:

from google.cloud import translate_v2 as translate

import MeCab

def translate_text(text, target_language="ja"):

# Initialize the Google Translate API client

translate_client = translate.Client()

# Translate the text

result = translate_client.translate(text, target_language=target_language)

return result['translatedText']

def morphological_analysis(text):

# Initialize MeCab Tagger

mecab = MeCab.Tagger()

# Parse the text

parsed_text = mecab.parse(text)

return parsed_text

if __name__ == "__main__":

# Your Google Cloud Translate API key

# Make sure to set the environment variable GOOGLE_APPLICATION_CREDENTIALS to the path of your service account key file

import os

os.environ["GOOGLE_APPLICATION_CREDENTIALS"] = "path/to/your/service-account-file.json"

# Example English text

english_text = "Hello, how are you?"

# Translate English text to Japanese

japanese_text = translate_text(english_text)

print("Translated Text: ", japanese_text)

# Perform morphological analysis on the Japanese text

analyzed_text = morphological_analysis(japanese_text)

print("Morphological Analysis: ", analyzed_text)Explanation:

- Translation: The

translate_textfunction uses the Google Cloud Translate API to translate the input English text into Japanese. - Morphological Analysis: The

morphological_analysisfunction uses MeCab to analyze the translated Japanese text, breaking it down into its morphological components.

Running the Script:

- Ensure you have your Google Cloud service account JSON key file and set the

GOOGLE_APPLICATION_CREDENTIALSenvironment variable to its path. - Run the script using Python.

Note:

- Make sure you have MeCab installed on your system along with the necessary dictionaries. You might need to install MeCab separately depending on your OS. For example, on Ubuntu, you can install it using:

sudo apt-get install mecab libmecab-dev mecab-ipadic-utf8This script provides a basic framework for translating text and performing morphological analysis. You can expand and customize it further based on your specific requirements.

英語のテキストを日本語に翻訳し、日本語テキストの形態素解析を行うプログラムを作成するために、Google Translate APIとMeCabを使用します。

手順1: Google Cloud Translate APIの設定

まず、Google Cloud Translate APIを設定する必要があります。このガイドに従って、プロジェクトを作成し、APIを有効にし、APIキーを取得します:Google Cloud Translate APIのセットアップ

手順2: 必要なライブラリのインストール

google-cloud-translateライブラリとmecab-python3ライブラリをインストールします。これらはpipを使用してインストールできます:

pip install google-cloud-translate mecab-python3手順3: Pythonスクリプトを書く

以下は、英語のテキストを日本語に翻訳し、形態素解析を行うPythonスクリプトです:

from google.cloud import translate_v2 as translate

import MeCab

def translate_text(text, target_language="ja"):

# Google Translate APIクライアントを初期化

translate_client = translate.Client()

# テキストを翻訳

result = translate_client.translate(text, target_language=target_language)

return result['translatedText']

def morphological_analysis(text):

# MeCab タガーを初期化

mecab = MeCab.Tagger()

# テキストを解析

parsed_text = mecab.parse(text)

return parsed_text

if __name__ == "__main__":

# あなたのGoogle Cloud Translate APIキー

# サービスアカウントキーのファイルパスを環境変数GOOGLE_APPLICATION_CREDENTIALSに設定

import os

os.environ["GOOGLE_APPLICATION_CREDENTIALS"] = "path/to/your/service-account-file.json"

# 例としての英語のテキスト

english_text = "Hello, how are you?"

# 英語のテキストを日本語に翻訳

japanese_text = translate_text(english_text)

print("Translated Text: ", japanese_text)

# 日本語のテキストの形態素解析を実行

analyzed_text = morphological_analysis(japanese_text)

print("Morphological Analysis: ", analyzed_text)説明:

- 翻訳:

translate_text関数は、Google Cloud Translate APIを使用して、入力された英語のテキストを日本語に翻訳します。 - 形態素解析:

morphological_analysis関数は、MeCabを使用して、翻訳された日本語のテキストを解析し、その形態素構造を出力します。

スクリプトの実行:

- Google CloudサービスアカウントのJSONキーのファイルを持っていることを確認し、

GOOGLE_APPLICATION_CREDENTIALS環境変数にそのパスを設定します。 - Pythonを使用してスクリプトを実行します。

注意点:

- MeCabがシステムにインストールされており、必要な辞書が揃っていることを確認してください。OSによってはMeCabを別途インストールする必要があります。例えば、Ubuntuの場合、以下のコマンドでインストールできます:

sudo apt-get install mecab libmecab-dev mecab-ipadic-utf8このスクリプトは、基本的な翻訳と形態素解析のフレームワークを提供します。特定の要件に応じて、さらに拡張およびカスタマイズすることができます。

Claude 3.5 Sonnetの結果はこちら

Here’s a Python program that translates English text into Japanese and performs morphological analysis:

import requests

from googletrans import Translator

import MeCab

def translate_to_japanese(text):

translator = Translator()

translation = translator.translate(text, dest='ja')

return translation.text

def morphological_analysis(japanese_text):

mecab = MeCab.Tagger("-Ochasen")

parsed = mecab.parse(japanese_text)

return parsed

def main():

english_text = input("Enter English text: ")

japanese_text = translate_to_japanese(english_text)

print(f"Japanese translation: {japanese_text}")

analysis = morphological_analysis(japanese_text)

print("Morphological analysis:")

print(analysis)

if __name__ == "__main__":

main()Would you like me to explain or break down the code?

Python プログラムで、英語テキストを日本語に翻訳し、形態素解析を行う例です。

import requests

from googletrans import Translator

import MeCab

def translate_to_japanese(text):

translator = Translator()

translation = translator.translate(text, dest='ja')

return translation.text

def morphological_analysis(japanese_text):

mecab = MeCab.Tagger("-Ochasen")

parsed = mecab.parse(japanese_text)

return parsed

def main():

english_text = input("Enter English text: ")

japanese_text = translate_to_japanese(english_text)

print(f"Japanese translation: {japanese_text}")

analysis = morphological_analysis(japanese_text)

print("Morphological analysis:")

print(analysis)

if __name__ == "__main__":

main()コードについて、説明や解説をしましょうか?

どのモデルも基本的には正しいコードを出力してくれました。

Llama 3.1 405Bは、GPT-4oやClaude 3.5 Sonnetと遜色ないレベルのコードを生成してくれましたが、環境依存のディレクトリパスを指定していたりするなど、簡潔さや可読性の面で劣ると感じました。

ビジネスメールの作成(日本語)

次に、日本語能力を比較検証するために、日本語でのビジネスメールの作成を行います。

以下のプロンプトを入力します。

日本語でクライアントに送信する丁寧語・謙譲語を正しく使用したビジネスメールを作成してください。結果はこのようになりました。

Llama 3.1 405Bの結果はこちら

以下は、日本語でクライアントに送信する丁寧語・謙譲語を正しく使用したビジネスメールの例です。

件名: お見積もりについてのご連絡

本文:

お世話になっております。[あなたの会社名]の[あなたの名前]です。

この度は、お見積もりについてのご依頼をいただき、誠にありがとうございます。弊社では、お客様のご需求にできるだけお応えできるよう、最善を尽くしております。

お見積もりにつきましては、以下の通りです。

- 価格:¥100,000

- 物件:〇〇〇〇

- 納期:△△△△

ただいま、ご成約の手続きを進めております。ご契約書は、別途ご送付致しますので、ご確認ください。

何なりとご不明点ございましたら、お急ぎにご連絡ください。迅速にご対応致します。

ご厚意に感謝致します。

結び:

敬具

[日付]

[あなたの会社名]

[あなたの名前]

使い方

- 「お世話になっております」は、相手に感謝の意を表す挨拶文です。

- 「誠にありがとうございます」は、相手に感謝の意を表す表現です。

- 「最善を尽くしております」は、努力する意思を表す表現です。

- 「ご成約の手続き」は、契約の手続きを進めることを意味します。

- 「別途ご送付致します」は、別の方法で送信することを意味します。

- 「何なりとご不明点ございましたら」は、相手が不明点を感じた場合に連絡を促す表現です。

- 「ご厚意に感謝致します」は、相手の厚意に感謝を表す表現です。

注意:この文書は、一般的な商業用メールの例として作成されており、実際のメール送信には相手の特定の状況や文化を考慮する必要があります。

GPT-4oの結果はこちら

もちろんです。以下に、クライアントに送信する丁寧語・謙譲語を正しく使用したビジネスメールの例を示します。

件名:今月の業績報告と次回会議のご案内

株式会社〇〇

営業部 山田様

いつもお世話になっております。

株式会社△△の佐藤でございます。

この度は、弊社の今月の業績報告と次回の会議についてご連絡させていただきます。

まず、今月の業績についてご報告いたします。おかげさまで、目標を達成することができました。詳細につきましては、添付の資料をご覧いただければ幸いです。

次に、次回の会議の件ですが、以下の日程で開催させていただきたく存じます。

日時:〇月〇日(〇)午後3時から

場所:弊社本社ビル3階会議室

ご多忙のところ恐れ入りますが、ご都合のほどお聞かせいただけますと幸いです。ご出席が難しい場合は、別の日程をご提案いただければ調整いたします。

何かご不明点やご質問がございましたら、どうぞお気軽にご連絡くださいませ。

今後とも変わらぬご愛顧を賜りますよう、お願い申し上げます。

何卒よろしくお願い申し上げます。

敬具

株式会社△△

営業部 佐藤

電話番号:03-1234-5678

メールアドレス:sato@example.com

ポイント:

- 挨拶と自己紹介: 「いつもお世話になっております。株式会社△△の佐藤でございます。」のように、丁寧な挨拶と自己紹介を行います。

- 報告内容: 業績報告については「おかげさまで、目標を達成することができました。」と感謝の意を込めて報告します。

- 会議の案内: 会議の日程について丁寧に案内し、「ご都合のほどお聞かせいただけますと幸いです。」と依頼します。

- 結びの挨拶: 「今後とも変わらぬご愛顧を賜りますよう、お願い申し上げます。」と結びの挨拶を行います。

このように、丁寧語と謙譲語を適切に使用することで、クライアントに対して敬意を表すメールを作成することができます。

Claude 3.5 Sonnetの結果はこちら

はい、承知いたしました。ビジネス文脈で適切な敬語を使用した日本語のメールを作成いたします。以下は、クライアントに送信する丁寧な文面の例です:

拝啓

貴社ますますご清栄のこととお慶び申し上げます。

平素は格別のお引き立てを賜り、厚く御礼申し上げます。

さて、先日ご依頼いただきました件につきまして、ご報告申し上げます。

弊社にて慎重に検討いたしました結果、○○の方向で進めさせていただきたく存じます。

つきましては、来週○日(曜日)午後3時より、弊社会議室にてご説明させていただきたく存じます。

ご多用中誠に恐縮ではございますが、ご都合いかがでしょうか。

ご不明な点がございましたら、何なりとお申し付けください。

今後とも変わらぬお引き立てを賜りますよう、よろしくお願い申し上げます。

敬具このメールでは、以下のような敬語の使い方に注意しています:

- 丁寧語:「です」「ます」を基本として使用しています。

- 謙譲語:「いたす」「申し上げる」「させていただく」など、自分や自社の行動を控えめに表現しています。

- 尊敬語:「ご~」「お~」などを使用し、相手や相手の行動を敬って表現しています。

また、「拝啓」で始まり「敬具」で締めくくるなど、ビジネス文書の基本的な形式も踏まえています。

このメールの内容や形式をベースに、実際の状況や目的に応じて適宜調整することをお勧めします。より具体的な内容や状況がありましたら、それに合わせてさらに詳細なメールを作成することも可能です。

Llama 3.1 405Bは、「何なりとご不明点ございましたら、お急ぎにご連絡ください。」など一部で不自然な日本語になってしまっています。

また、「ご需求」といったなかなか使わない表現をしています。

一方のGPT-4oとClaude 3.5 Sonnetは、そのまま使えそうなほど丁寧で正しいビジネスメールを作成してくれました。

日本語能力においてもまだ差はありますが、そこまで激しく差があるわけではなく、この点でもオープンソースモデルとクローズドモデルの差は埋まりつつあると感じます。

今回は、我々が普段LLMを使用する際によく使う「コーディング」と「日本語」の能力を比較しました。

Llama 3.1 405Bは、GPT-4oとClaude 3.5 Sonnetと比較して遜色ない性能を有していますが、細かい点を見るとまだまだこれらのモデルとは差があると感じました。

ただ、確実に差は縮まっており、オープンソースモデルがクローズドモデルに勝る日は近いかもしれません。

もし気になった方は是非試してみてください!

なお、Claude 3.5 Sonnetについて詳しく知りたい方はこちらの記事をご覧ください。

Llama 3.1 405Bは史上最強のオープンソースLLM

Llama 3.1は、2024年7月24日にMeta社が公開した最新のオープンソースLLMです。

「8B」「70B」「405B」の3モデルが公開されており、特に405Bはこれまでにないサイズのオープンソースモデルとなっており、その性能はGPT-4oやClaude 3.5 Sonnetに匹敵します。

さらに、一部のベンチマークではこれらのクローズドモデルを上回るスコアを獲得しています。

実際にLlama 3.1 405B使用して、「コーディング」と「日本語」の能力をGPT-4oとClaude 3.5 Sonnetと比較しましたが、遜色ない性能を示しました。

しかし、細かい点を見るとまだまだ差はあると感じます。

ただ、その差は確実に縮まっており、オープンソースモデルがクローズドモデルに勝る日は近いかもしれません。

Llama 3.1は、AWSやGoogle Cloudなど多くのクラウドシステムで利用可能で、もちろんローカルで実装することもできるので、是非試してみてください!

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。