アリババ発のAI「Marco-o1」を使ってみた!その実力を徹底解説!

2024年11月27日、中国企業アリババの研究部門からAIモデル「Marco-o1」が発表されました!

このモデルは、OpenAI社が開発した「OpenAI o1」の影響を受け、アリババ社Qwenグループの大規模言語モデル「Qwen2-7B-Instruct」をベースとして作られており、より高度な推論タスクにも対応しているようです。

- 中国企業アリババが2024年11月に発表したAIモデル。

- ベースはアリババの大規模言語モデル「Qwen2-7B-Instruct」で、OpenAI社の「OpenAI o1」の影響を受けて開発された。

- 教育支援、研究開発、グローバルなビジネスコミュニケーション、カスタマーサポートなど、幅広い応用分野が期待される。

今回はそんなAIモデル「Marco-o1」の概要や特徴をお伝えします!ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Marco-o1の概要

主な特徴

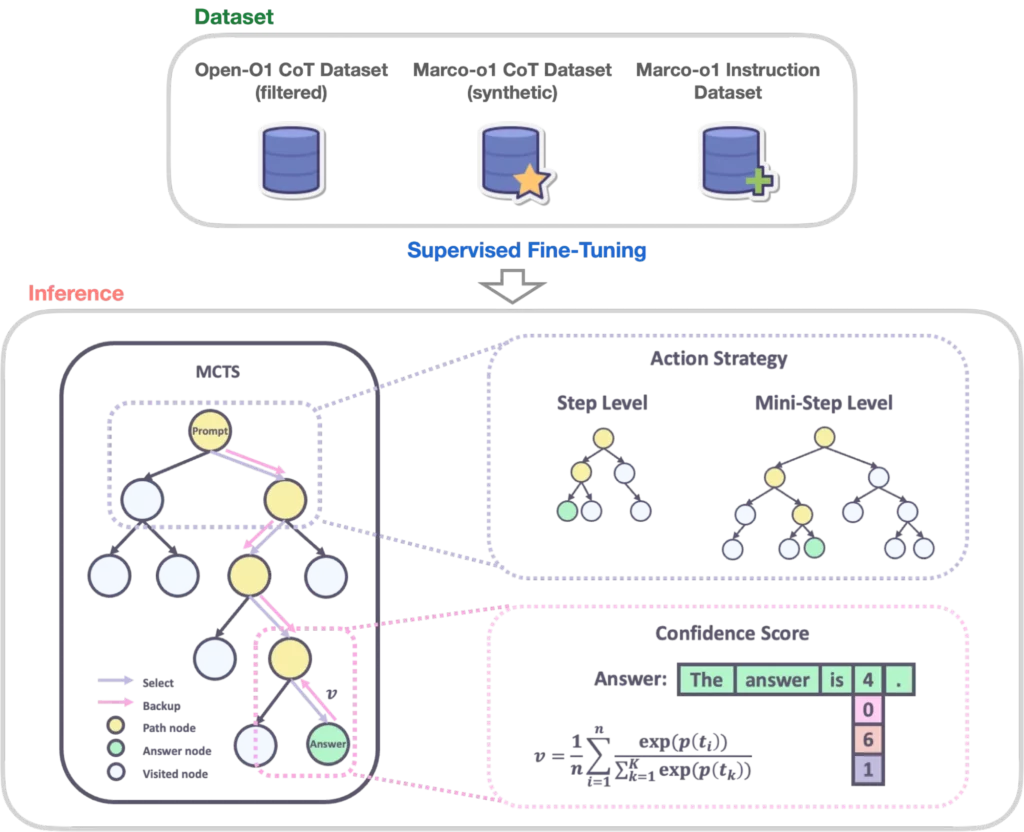

- Chain-of-Thought(CoT)データの微調整:1つずつ順を追う人間のような思考をする

- モンテカルロ木探索(MCTS)の活用:枝分かれした木のように思考する

- リフレクションメカニズム:推論結果を自己評価し、再考する

上記のような特徴により、OpenAI社の「OpenAI o1」が得意とする数学や物理学、コーディングだけでなく、明確な標準が存在しない現実世界の課題にも対応できる汎用的な推論能力も兼ね備えているようです。

また、Open-O1 CoTデータセット(フィルタリング済み)、Marco-o1 CoTデータセット(合成)、Marco-o1指示データセットの3つのデータセットを組み合わせることで、モデルの推論能力とタスク遂行能力の向上が図られました。

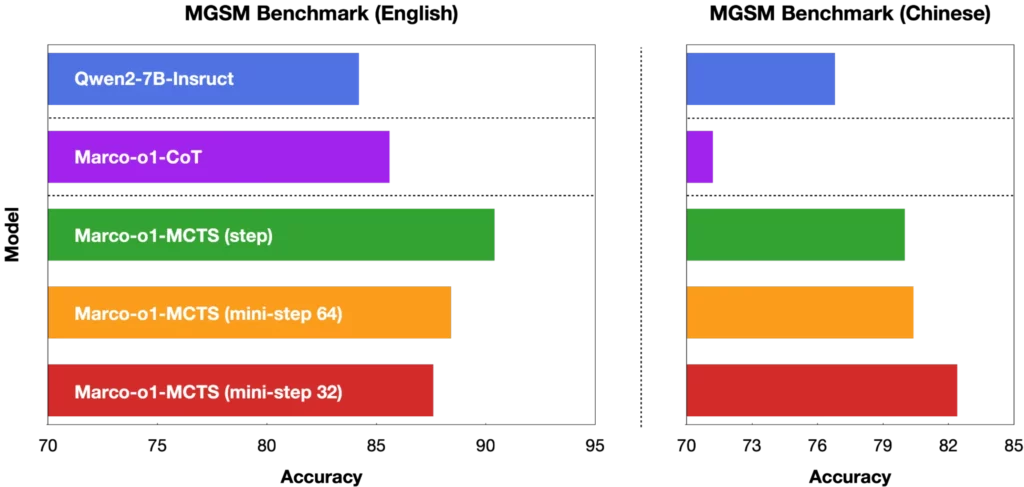

「Marco-o1」はMGSMという多言語環境における推論能力を評価するベンチマークにおいて、ベースである「Qwen2-7B-Instruct」を大きく上回る結果となっています。

下記図のように、「Marco-o1」はMGSM(英語)データセットで+6.17%、MGSM(中国語)データセットで+5.60%の精度向上を達成し、推論能力が向上していることを示しました。

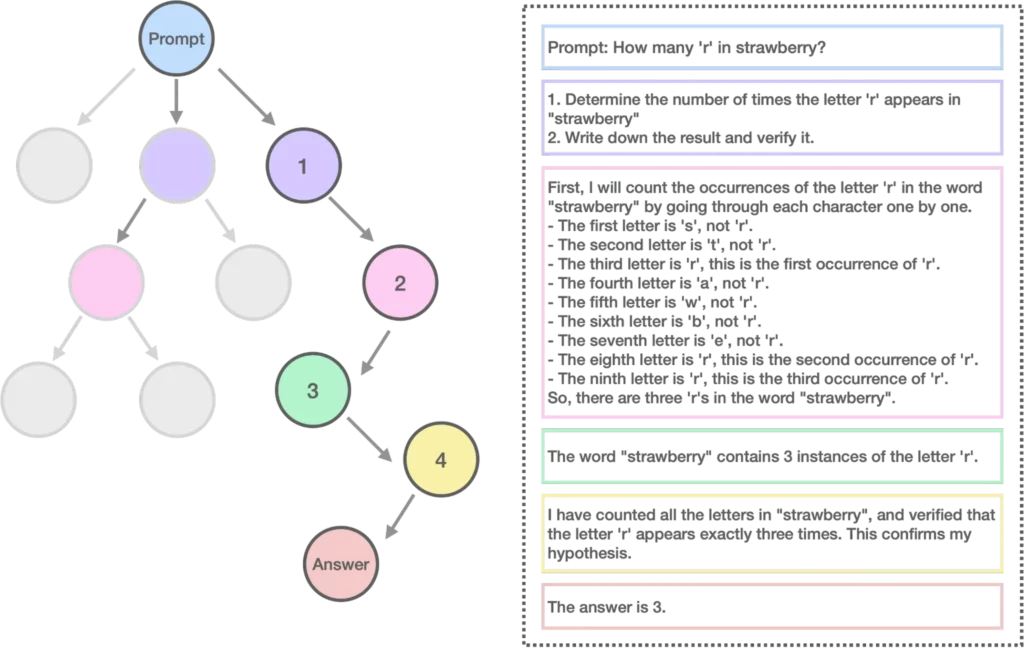

推論例

以下は、Marco-o1の推論例であり、”strawberry”という単語に含まれる’r’の数を数えるテストを行っています。

Prompt

How many “r” in strawberry?

和訳:

ストロベリーの”r”はいくつ?

プロンプトに対する回答全文の日本語訳は以下の通りです。

出力結果はこちら

1.”strawberry”の”r”の文字が何回出てくるか調べます。

2.結果を書いて検証します。

まず、「strawberry」という単語に含まれる「r」の出現回数を数えます。

-最初の文字は 「s」であり、「r」ではありません。

-2番目の文字は「t」であり、「r」ではありません。

-3番目の文字は「r」であり、これが最初に出現した「r」です。

-4番目の文字は「a」であり、「r」ではありません。

-5番目の文字は「w」であり、「r」ではありません。

-6番目の文字は「b」であり、「r」ではありません。

-7番目の文字は「e」であり、「r」ではありません。

-8番目の文字は「r」であり、これが2回目に出現した「r」です。

-9番目の文字は「r」であり、これが3回目に出現した「r」です。

つまり、「strawberry」という単語には3つの「r」があります。

「strawberry」という単語には「r」が3つ含まれている。

「strawberry」の全文字を数え、「r」がちょうど3回出現することを確認した。

答えは3です。

答えは正しいですが、最後の文字「y」が見落とされていますね。

これは、人間が「もう考えなくてよい」と判断するのと同様に、Marco-o1モデルも思考を省略しているようです。

まさにChain-of-Thought(CoT)やリフレクションメカニズム(下記参照)といった高度な技術が活かされています。

Wait! Maybe I made some mistakes! I need to rethink from scratch.

和訳:

待った!私は間違いを犯したかもしれない!最初から考え直す必要がある。

参考:https://arxiv.org/pdf/2411.14405

Marco-o1のライセンス

ライセンス詳細は以下の通りです。

本著作物またはその二次的著作物のコピーを、改変の有無にかかわらず、ソース形式またはオブジェクト形式で、あらゆる媒体で複製および配布することができるようです。

ただし、一部条件付きなので、詳細は公式ライセンスを必ず参照するようにしましょう!

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ❌ |

| 改変 | ⭕ |

| 配布 | ⭕ |

| 特許使用 | ❌ |

| 私的使用 | ⭕ |

なお、高度な数学を解けるQwenシリーズについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Marco-o1の使い方

※今回環境は、Google Colaboratoryの有料ハードウェア(A100 GPU)にて進めていきますが、ご自身の環境にあわせてコードを微修正してください。

最初に、「Marco-o1」をインストールしましょう。

インストール方法はこちら

# Clone the repository

!git clone https://github.com/AIDC-AI/Marco-o1

# Change to the Macaw-LLM directory

%cd Marco-o1

# Install required packages

!pip install -r requirements.txt

続いて、必要なライブラリをインポートしましょう。

ソースコードはこちら

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained(“AIDC-AI/Marco-o1”)

model = AutoModelForCausalLM.from_pretrained(“AIDC-AI/Marco-o1”)

これで準備はできたので、以下コードで推論スクリプトを実行することができる状態になりました。

ソースコードはこちら

./src/talk_with_model.py

# Use vLLM

./src/talk_with_model_vllm.py

OpenAI-o1とMarco-o1の比較検証

「OpenAI-o1」モデルは、主に数学やコーディングといった分野に特化しており、高い精度で正解を導き出す能力が注目されています。

一方で、「Marco-o1」はそのアプローチとは異なり、明確な基準がなく、解釈や推論が求められる課題に対応する汎用性を重視しているとのことです。

また、「Marco-o1」は、数学コンテストプラットフォーム「AIME」やプログラミング競技サイト「CodeForces」で他の主要モデルを上回る成果を達成しています。

アリババはこのモデルをオープンソースとして公開することで、AI研究者や開発者が自由に活用し、新たな応用可能性を探る場を提供しているようです。

ここから実際に検証してみます。

- OpenAI-o1、Marco-o1の性能比較

- 検証方法:同一の推論プロンプト(※)をそれぞれのモデルで実行

※推論プロンプトについては、以下ページを参照

参考記事:https://qiita.com/YutaroOgawa2/items/aca32f8fd7d551596cf8

今回期待する答えは、「(A)新卒に適した仕事」とします。

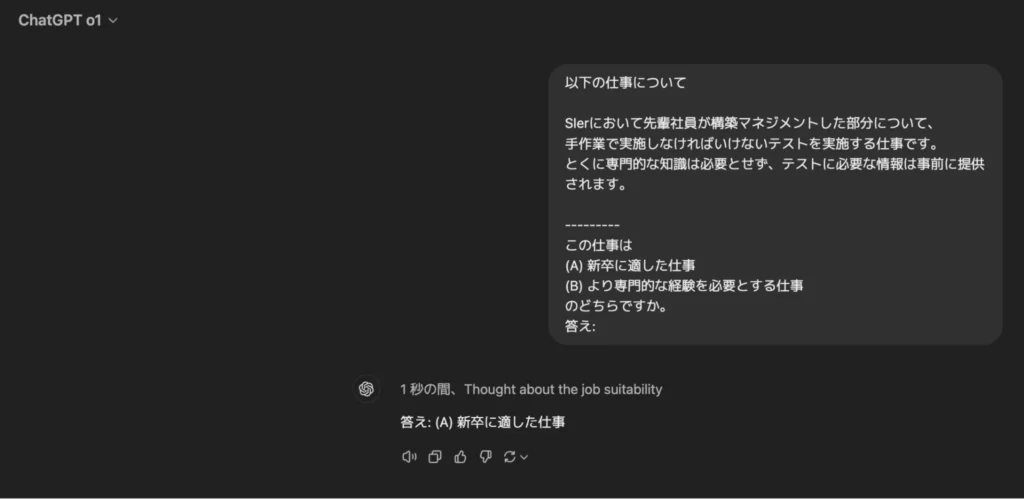

まずは「OpenAI-o1」の検証結果です。

「OpenAI-o1」については、期待通りの答えが返ってきました。

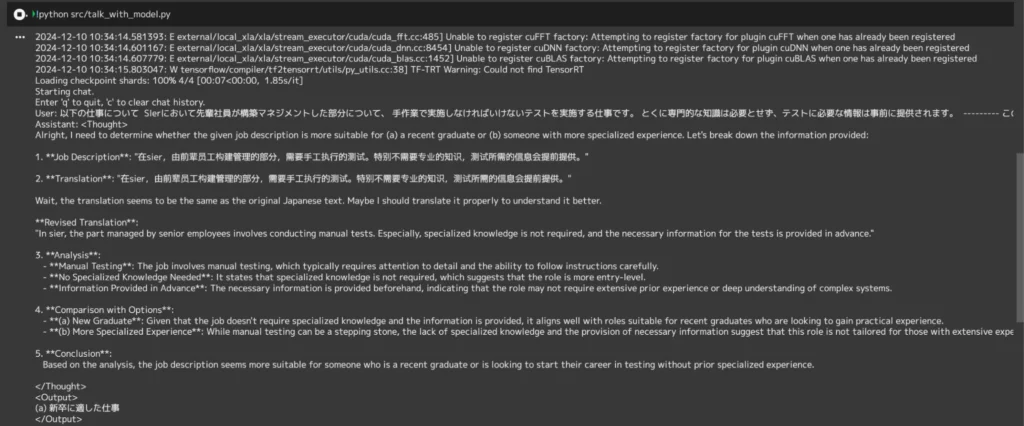

続いて「Marco-o1」の検証結果です!

出力結果の和訳はこちら

さて、与えられた仕事内容が、(a)新卒者に適しているのか、(b)より専門的な経験を積んだ人に適しているのかを判断する必要があります。提供された情報を分解してみよう:

1. **仕事内容 「元従業員たちによって築かれた経営の一部であり、特に手作業で行われる検査には専門的な知識は必要なく、検査に必要な情報も提供される。」

2. **翻訳 「実際には、元従業員によって構築された管理の一部は、手動で実行する必要があるテストは、特に専門的な知識を必要としない、テストに必要な情報は、前提条件を提供します。」

待てよ、この訳は日本語の原文と同じようだ。もっとよく理解するためには、きちんと訳すべきかもしれない。

**修正訳**:

「sierでは、シニア社員が管理する部分では、手動テストを実施する。特に専門的な知識は必要なく、テストに必要な情報は事前に提供される。」

3. **分析

– マニュアルテスト**: この仕事には手作業によるテストが含まれ、通常、細部への注意と指示に注意深く従う能力が要求される。

– 専門知識は不要**: 専門的な知識は必要ないと記載されており、この職務がよりエントリーレベルであることを示唆している。

– 事前に提供される情報**: 必要な情報が事前に提供されるため、その役割には広範な事前経験や複雑なシステムに対する深い理解は必要ないかもしれないことを示している。

4. **オプションとの比較**:

– (a) 新卒**者: (a)新卒**:専門的な知識は必要なく、情報も提供されることから、実務経験を積みたい新卒者に適した職務である。

– (b) より専門的な経験**: マニュアルテストは足がかりにはなるが、専門的な知識がなく、必要な情報が提供されていないことから、特定の分野で豊富な経験を持つ人には向いていない。

5. **結論

分析によると、この職務内容は、新卒者や、専門的な経験がなくてもテストのキャリアをスタートさせたいと考えている人に適しているようである。

</思考

<アウトプット

(a) 新卒に適した仕事

</アウトプット

「OpenAI-o1」と同じく、期待通りの答えが返ってきましたが、「OpenAI-o1」と異なり、答えに至るまでの推論過程も返してくれていますね!

また、2. **翻訳のあとに続く「待てよ、この訳は日本語の原文と同じようだ。もっとよく理解するためには、きちんと訳すべきかもしれない。」の部分は、まさしくリフレクションメカニズム(※推論結果を自己評価し再考するメカニズム)が活用されていることがわかります。

これが「OpenAI-o1」と「Marco-o1」の違いであり、「Marco-o1」モデルが人間と同じような高度な判断をした結果であると考えられますね。

「Marco-o1」恐るべしです。。

今回は簡単な例で検証を行いましたが、より高度な推論タスクで比較するとおもしろいかもしれません。

興味のある方はぜひ試してみてください!

なお、最新の1Mトークン対応のQwenシリーズモデルについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

まとめ

いかがでしたでしょうか?

「Marco-o1」は、明確な基準のない現実世界の課題にも対応できる汎用的かつ革新的なツールとして、さまざまな分野での応用が期待されています。

- 教育や学習支援

- 研究開発支援

- グローバルなビジネスコミュニケーション

- カスタマーサポート

上記は一例ですが、多種多様なシーンでの活用が期待されます!

今後のアップデートも楽しみですね!

最後に

いかがだったでしょうか?

高い推論性能を持つLLMは、教育や研究開発、カスタマーサービスなど、幅広い分野での活用が期待できるでしょう。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。