【Mercury】拡散LLMで爆速コーディング?AIモデルの概要や使い方、料金を徹底解説

- 従来のLLMと比べて最大10倍の高速生成が可能

- NVIDIA H100 GPU上で1秒あたり最大1000トークンを出力

- Transformer型(GPT-4系やClaude)よりも圧倒的に速い

2025年2月28日、スタンフォード大学の教授陣が中心メンバーとなるアメリカのスタートアップ「Inception Labs」が、AIモデル「Mercury」をリリースしました。

従来の大規模言語モデル(LLM)と比較して最大10倍の速度でテキストを生成できるそうで、注目されています。

「Mercury」は、拡散モデル(Diffusion Model)を採用した新しいタイプの大規模言語モデル(LLM)で、「世界初の商用グレード拡散LLM」として位置づけられています。

本記事では、「Mercury」の概要から使い方まで幅広くご紹介します。

ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Mercuryとは

「Mercury」は、従来のTransformer型モデルと異なり、ノイズから徐々に単語を生成する拡散モデルに基づいており、一度にテキスト全体の荒枠を並行生成してから細部を洗練させていく手法を取ります。

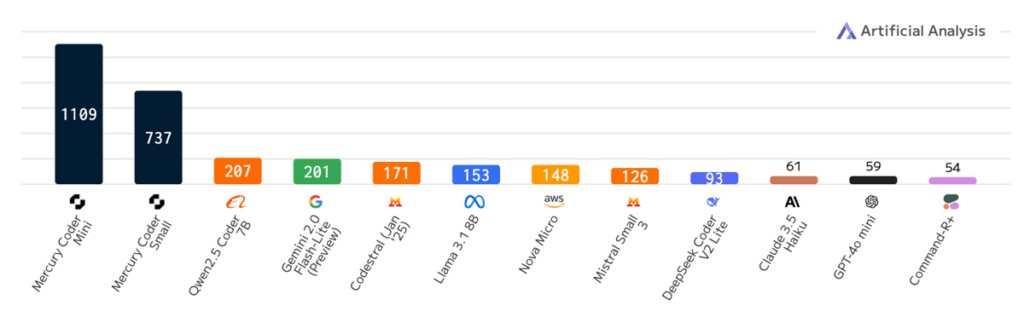

このアプローチにより生成速度が飛躍的に向上しており、NVIDIA H100 GPU上で1秒あたり最大1000トークンという高速出力を実現しています。

これは同等規模のTransformer型LLM(GPT-4系やClaudeなど)と比べて、5〜10倍以上高速という驚異的な性能になっています。

特殊なハードウェアを必要とせず、標準的なGPUで高速に動作するため、低コストでの運用も可能だそうです。

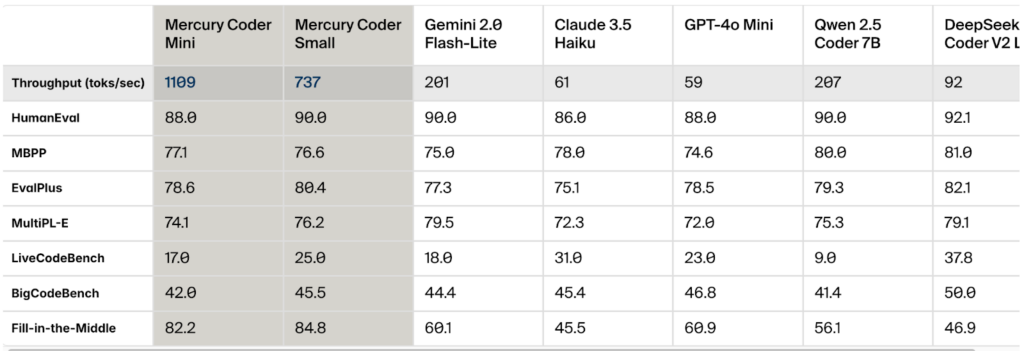

今回、最初のリリースとして、コード生成に特化した「Mercury Coder」モデルが公開されており、標準的なコーディングベンチマーク(HumanEvalやMBPPなど)で、OpenAIのGPT-4o MiniやAnthropic Claude 3.5 Haikuといった高速化LLMを上回る精度を示しつつ、処理速度で大きく勝っていることが報告されています。

拡散モデルの特性上、論理的整合性や構造化された応答にも強みがある可能性があり、逐次的にトークンを生成する従来モデルに比べ、文脈全体を考慮しながら出力を精錬できるため、誤りや「幻覚」も減らしやすいと期待されています。

Mercuryのライセンス

「Mercury」のライセンス情報は以下の通りです。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | 🔺 |

| 配布 | 🔺 |

| 特許使用 | 不明(明記なし) |

| 私的利用 | ⭕️ |

改変について

Mercuryはブラックボックス型のクラウドサービスであり、ソースコードやモデル構造が開示されていないため、利用者がモデルを改変することはできません。

ただし、Inception LabsはMercuryに関連する研究成果としてLLaDA(Large Language model via Denoising Algorithm 等)というモデル実装のコードを公開しており、Hugging Face上でデモが試すことができます。

その範囲では改変・再利用が許可されるかもしれませんが、実際の利用可否は明記されていないため、改変する際は公式に問い合わせをするようにしましょう。

配布について

Mercuryは、クラウド上で提供するクローズドなサービスであり、モデルの詳細や学習済みデータ(重み)は公開されていません。そのため、利用者がMercury自体をコピーして配布したり、独自に再ホスティングすることは許されていません。利用したい場合は必ず公式のAPIないしサービス経由で利用する必要があります。

Mercuryが生成したアウトプット(テキストやコード)の配布については、特段の制限は明言されていません。一般的な生成AIと同様に出力結果は自由(常識の範囲内)に利用・公開可能と考えられます。

実際の利用可否は明記されていないため、配布する際は公式に問い合わせをするようにしましょう。

Mercuryの料金体系

2025年3月現在、一般ユーザー向けには、公式Playgroundが無料で開放されており、クレジットカード登録等なしで誰でもMercuryを試用できます。

この無料枠では回数や利用時間に何らかの制限がある可能性もありますが、少なくとも基本的な動作を体験する範囲では費用は発生しません。

高度な利用を望む場合は、Inception Labsとのエンタープライズ契約が必要となるようです。企業クライアント向けに、Mercury(コード特化モデルや汎用モデル)へのAPIアクセス、およびオンプレミス版が提供されており、ニーズに応じたプランが用意されています。

具体的な料金は公開されていませんが、利用規模や提供形態に応じてカスタム見積もりとなる可能性が高いです。

また、2025年3月時点で、個人向けの有料サブスクリプションプランやソフトウェアの買い切り販売といったプランは発表されていません。Mercuryそのものを購入してローカルで使うことはできず、サービスとして利用する形となっています。

Mercuryの使い方

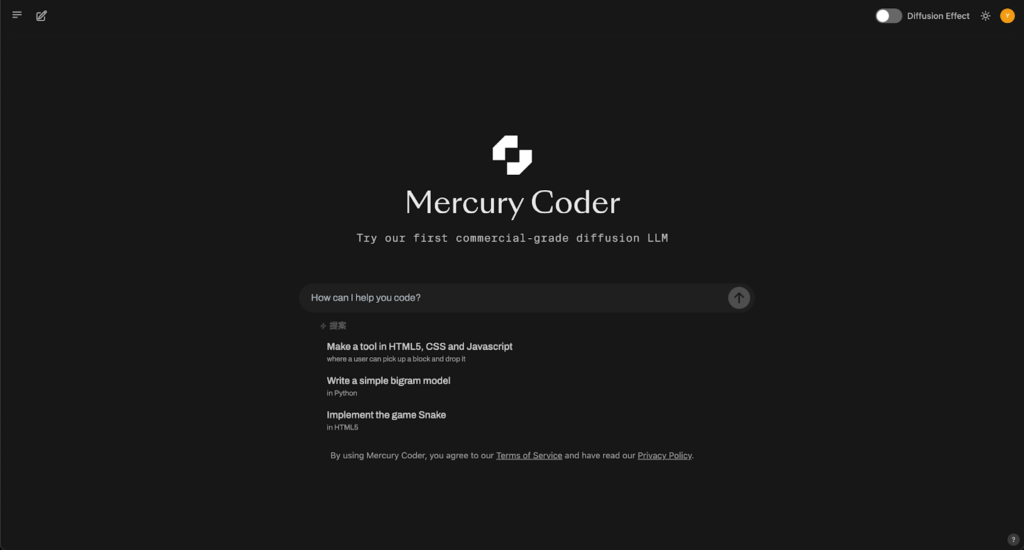

Mercuryは、Inception Labsが提供するウェブ上のPlayground(デモサイト)でモデルを利用することができます。

公式のPlayground(チャット形式のインタフェース)にアクセスすれば、無料でMercuryを体験できます。

- デモサイトへアクセス

- サインアップする

- 以上で「Mercury Coder」が使える状態になります。

Mercuryの活用事例

「Mercury」の活用事例を3つご紹介します!

コード自動生成

上記のポストでは、コード生成の速さが伺えます。

日本語性能について

日本語性能は概ね問題ないが細部の精度には改善の余地がありそうです・・!

性能比較

Mercury Coderをあるタスクに使用し、「このタスクでMercury Coderを試しましたが、成功しましたが、速度はGemini / Groqと同程度でした」と述べられています。

具体的なタスク内容は明らかにされていませんが、「Mercury Coder」が実用的なタスクで使用され、既存の高速モデルと性能比較しても劣っていないことが伺えますね。

以上、現時点では、出力スピードは申し分ないものの、正確性や課題解決能力に少し懸念がありそうです。

今後のアップデートに期待しましょう。

まとめ

最後に改めて「Mercury」の特徴をまとめます。

- 従来の大規模言語モデル(LLM)と比較して最大10倍の速度でテキストを生成できる新たなAIモデル

- 「世界初の商用グレード拡散LLM」として位置づけられる

- NVIDIA H100 GPU上で1秒あたり最大1000トークンという高速出力を実現

- 標準的なコーディングベンチマークで、OpenAIのGPT-4o MiniやAnthropic Claude 3.5 Haiku等の高速化LLMを上回る精度を示す

- 公式Playgroundが無料で開放されており、クレジットカード登録等なしで利用可能

気になる方はぜひ使ってみてください!

生成系AIの業務活用なら!

・生成系AIを活用したPoC開発

・生成系AIのコンサルティング

・システム間API連携

最後に

いかがだったでしょうか?

「Mercury」などの超高速LLMを活用することで、コード生成やレポート作成、問い合わせ対応の自動化など、業務を劇的に効率化できます。自社の業務に最適化したAIソリューションの導入やシステム構築についてもご相談いただけます!

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、通勤時間に読めるメルマガを配信しています。

最新のAI情報を日本最速で受け取りたい方は、以下からご登録ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。