【Gemini2.0 Flash】生成速度2倍!?無料で使えるGoogleのAI概要とマルチモーダル性能を実践検証

2024/12/12、Googleから新たなLLMが登場!

2024/12/9にGemini-exp-1206がリリースされたばかりですが、たった一週間で新たなモデル「Gemini2.0」が登場しました!

Gemini2.0はマルチモーダル機能・性能は向上し、生成速度は高速になっており、従来のモデルより多くのタスクをこなせるようになっています。

- マルチモーダル機能が向上し、生成速度が高速化つ高性能

- Project Astra、Project Mariner、Julesなど、Gemini2.0を使用したエージェント機能を模索

- Google AI Studioでも使え、活用の幅が広い

本記事では新たにリリースされたGemini2.0の特徴や使い方について解説します。様々な企業から凄まじい速度で新たなLLMがリリースされますが、本記事を最後まで読むことで、Gemini2.0の使い道が理解できます。

ぜひ最後までお読みください!

\生成AIを活用して業務プロセスを自動化/

Gemini2.0の概要

Gemini2.0は、Googleが開発した新しいAIモデルで、よりAgenticな時代に向けて開発されています。

Agentic:AIが単なるツールとしての役割を超えて、ある種の「エージェント(代理人)」のように振る舞うこと。

Gemini2.0は単に情報を処理するだけでなく、ユーザーのニーズや背景を理解し、その情報を基に「次に何が必要か」を考え、さらにその計画に従って行動できるモデルとして設計されています。

Gemini2.0 Flashの概要

2024年12月に試験運用版が公開され、2025年1月30日には「Gemini」アプリで利用可能となりしたが、2025年2月6日にはGoogle AI StudioとVertex AIのGemini APIを通じてGemini 2.0 Flashの提供を開始しました。

Gemini2.0 Flashは、低レイテンシーとハイパフォーマンスを備えたモデル。画像やビデオ、音声などのマルチモーダル入力に加え、多言語対応のテキスト読み上げ機能、生成画像などのマルチモーダル出力ができます。

さらに、Google検索やコード実行、さらにはサードパーティのユーザー定義関数などのツールを直接呼び出すことも可能です。

この機能により、Gemini2.0 Flashは単なる知識だけの役割を超え、Gemini2.0自身が情報を取得し、タスクを処理するようになります。

例えば、ユーザーが「最新のニュースを調べて」や「Pythonでグラフを作成して」といった指示を出すと、Gemini2.0 FlashはGoogle検索を利用して必要な情報を収集したり、コードを生成して実行し、その結果を返すことができます。

Project Astr

Project Astraは、Googleが開発中のAIアシスタントプロトタイプで、「普遍的なAIアシスタント」の機能を開発するためのプロジェクト。

現在、Androidスマートフォン上で動作し、信頼できるテスターによって試験運用されており、テスターから寄せられるフィードバックは、AIアシスタントがどのように実生活で役立つかを明らかにするだけでなく、安全性や倫理に関する課題の解決にも活用されています。

Project Mariner

Project Marinerは、GoogleがGemini 2.0を活用して開発中のプロトタイプで、ブラウザ上でのAIと人との新たな双方向でのやり取りの形を探求。Project Marinerは、テキストや画像、コードなどブラウザ内の情報を理解し、それを基にタスクを実行できるAIエージェントを目指しています。

たとえば、AIがブラウザ上の要素を認識し、それを活用してユーザーの命令に基づく作業を遂行可能です。Webページ上の情報を収集し、それを使ってレポートを作成したり、フォームに自動入力したりといったことができます。

さらに、Project Marinerは「WebVoyager」というベンチマークでWeb上のタスク処理において83.5%という優れた成功率を達成しています。この結果はProject Marinerが従来の技術と比較して、より正確かつ高いタスク実行能力を備えていることを示していると言えるでしょう。

Jules

Julesは、実験的なAIエージェントで、特にソフトウェア開発の補助を目的としています。JulesはGitHubのワークフローに直接統合されており、次のような補助を行うことができます。

- 課題の解決:与えられた開発課題(例えばバグ修正や新機能の実装)を理解し、その解決に向けた計画を立案。

- 計画の策定と実行:問題を分解し、具体的な実装内容を提案。その後、コードを生成し、タスクを実行します。

- 開発者との連携:Julesは完全自律型ではなく、開発者が方向性を示したり、提案を確認・修正したりする形で使います。

その他にも、Geminiとの低遅延の双方向音声および画面共有をしながらの問題解決が可能なMultimodal Live APIやGoogle検索を活用したSearch as a tool、音声生成、画像生成などを行うことができます。

Gemini2.0 Flash ProとGemini2.0 Flash-Liteの発表

2025年2月6日にGemini2.0 Flashのアップデート情報が公開されたとともに、Gemini2.0 Proの試験運用版公開と低コストモデルであるGemini2.0 Flash-Liteの発表も同時に行われました。

Gemini2.0 Pro

Gemini2.0 ProとはGemini2.0 Flashの上位モデルで、2025年3月15日現在では、試験運用版ということもあり、Google AI StudioやVertex AIの開発者や、Gemini Advancedユーザーなど一部ユーザーに向けて限定的に公開されているモデルです。

一年前に発表されたGemini1.5 Proの後継モデルとして発表されたGemini2.0 Proは、優れたコーディング能力を持っており、複雑なタスクにも対応できる性能を持っています。

大規模言語モデル(LLM)の性能を評価するためのデータセットである「MMLU-Pro」やPythonでのコード生成を評価する「LiveCodeBench(v5)」、数学的な性能を評価する「MATH」などのベンチマークで他のGeminiモデルの数値を上待っており、Geminiモデルの中でも最強の性能を持っています。

Gemini2.0 Flash-Lite

Gemini2.0 Flashの低コスト版として公開されたGemini2.0 Flash-Liteは、Gemini2.0 Flashとほぼ同じ性能とスピードを維持しながら運用コストを大幅に削減できるモデルです。

このモデルは、高度なマルチモーダル機能はあるものの機能を最小限に絞ることで、オーバースペックを抑制し、テキスト生成や画像処理などライトユーザーにおすすめのモデルと言えるでしょう。

現在は、Google AI StudioとVertex AIでパブリックプレビューとして利用可能利用可能となっています。

Gemini2.0 Flashに新機能が追加

2025年2月13日には、さらにGeminiのアップデートが行われ、より高性能かつ便利な機能が追加されました。

ここでは、Gemini2.0 Flashのアップデート情報についてご紹介します。

Gemini2.0 Flash Thinking Experimentalの強化

Geminiアプリの2.0Flash Thinking Experimentalのアップデートが行われ、プロンプトを分解してより適切な回答ができるように推論能力が強化されました。

さらに、100万トークンのコンテキストウィンドウが提供されたため推論能力が向上しただけではなく、より多くの情報を検索したり分析することができます。

また、複雑な情報をリサーチして分かりやすいレポートにまとめることのできる「Deep Research」に利用されているモデルもGemini1.5ProからGemini 2.0 Flash Thinking Experimentalに更新されたことにより、より高度なレポートを作成することが可能となりました。

画像生成機能の追加

今回のアップデートにより、Gemini2.0 Flashでも画像生成ができるようになりました。

入力できるプロンプトはテキストだけではなく画像データも入力可能で、画像データやテキストプロンプトを入力するだけで、簡単に画像生成が行えます。

さらに、上記のポストのように、画像データとテキストプロンプトを組み合わせて入力することにより、簡単に元画像を加工できるようになったため、画像の一部のみや構図の変更なども行うことができるようになっているのもポイントの一つです。

パーソナライゼーション機能の追加

パーソナライゼーション機能とは、ユーザーとの過去の会話履歴や検索履歴などに基づいて回答してくれる機能のことで、この機能を活用すればユーザーの趣味嗜好に沿った回答を行うことが可能です。

例えば、過去の検索履歴からユーザーの好みを把握し、好みに合わせたレストランやレシピの検索など、さまざまなことができるようになります。

また、Googleカレンダーやタスクといったその他Googleアプリとも連携ができるため、カレンダーに予定がない日時で予約可能なレストラン検索なども行えるようになりました。

こちらの機能は、ユーザーのプライバシーに関わる問題が懸念されますが、ユーザーの許可なしに過去の情報等は利用されないため、利用する・しないの選択がユーザーごとに行うことができるので利用したくない方にとっても安心です。

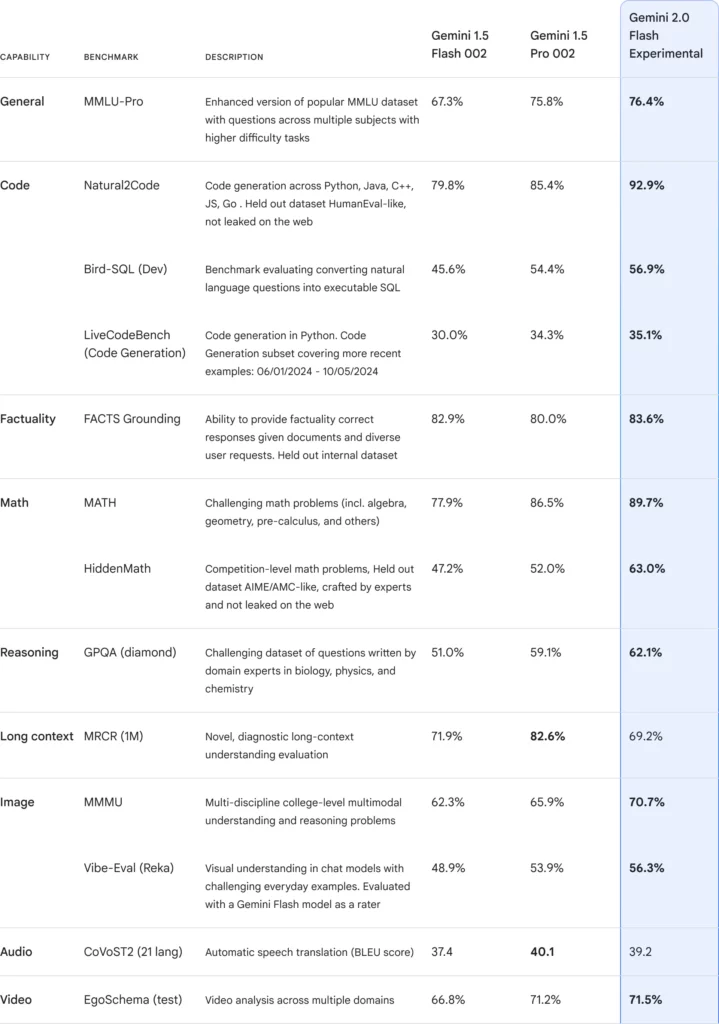

Gemini2.0 Flashの性能

Gemini2.0 Flashは、Gemini1.5 Flashをベースに開発されており、同様の応答時間を維持しながらパフォーマンスは向上。特に、主要なベンチマークでは1.5 Proを凌駕するパフォーマンスを達成しており、しかも2倍の速度で動作します。

1.5 ProとGemini2.0を比較してみると、Gemini2.0はLong contextとAudioを苦手としているようです。

Long contextに関してはMRCRで評価しています。

MRCRはユーザーとモデルの間で行われる長い会話を基にしており、モデルは過去の発言を参照しながら特定の応答を再現する必要があります。特に情報が複雑で混乱を招く要素が含まれている場合でも、モデルがどれだけ正確に過去の情報を保持し、適切に応答できるかを評価するベンチマークです。

また、AudioはCoVoST2を使用。CoVoST2は多言語音声翻訳のための大規模なベンチマークデータセットです。21言語から英語へ翻訳し、英語から15言語への翻訳が可能。

Gemini2.0 Flashの料金体系

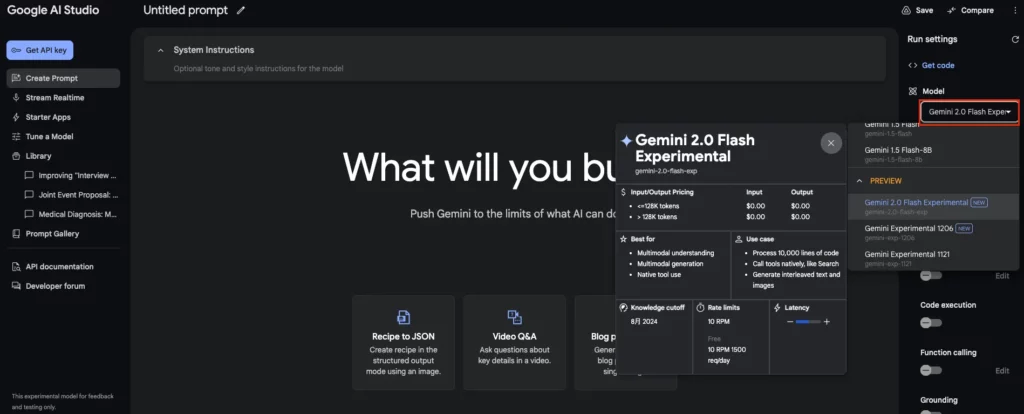

Gemini2.0 FlashはGoogle AI StudioもしくはAPIを通じて利用可能です。

Google AI Studioは無料で利用できます。Vertex AIでAPIを通じて利用することも可能ですが、API使用料については言及されておらず、Vertex AIの料金のみ記載されています。

なお、音声とテキストを融合したマルチモーダルAIについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Gemini2.0の使い方

Gemini2.0はGoogle AI StudioとVertex AIで利用可能です。

Google AI Studioで使うには、画面右上のModelからGemini 2.0 Flash Experimentalを選択すればOKです。

Gemini2.0に「LLMの適応と限界について具体例を交えながら教えてください」とプロンプトを入力してみました。

結果はこちら

LLM(Large Language Model、大規模言語モデル)の適応と限界について、具体的な例を交えながら解説します。

LLMの適応

LLMは、大量のテキストデータから学習することで、非常に幅広いタスクに対応できるようになっています。その適応能力の高さは、以下のような例で示されます。

テキスト生成:

例: 小説、詩、記事、メール、キャッチコピーなど、様々なジャンルのテキストを生成できます。

具体的な応用:

マーケティング: 複数のキャッチコピー案を生成し、効果的なものを選択する。

コンテンツ作成: ブログ記事の草稿を作成し、編集作業を効率化する。

創作活動: 小説のプロットを生成し、創作のヒントを得る。

適応: 学習データに含まれるパターンやスタイルを模倣し、多様なテキストを生成できます。また、プロンプトによって生成するテキストのスタイルやトーンを調整できます。

テキスト要約:

例: 長文のニュース記事や論文を短く要約できます。

具体的な応用:

情報収集: 大量の情報を効率的に把握する。

レポート作成: 長い文章を要約して、必要な情報だけを抽出する。

適応: テキストの重要なポイントを抽出し、短い文章にまとめることができます。

質問応答:

例: 与えられた質問に対して、テキストデータから回答を抽出したり、知識に基づいて回答を生成したりできます。

具体的な応用:

カスタマーサポート: 顧客からの質問に自動で回答する。

FAQ作成: よくある質問と回答のペアを生成する。

適応: 質問の意図を理解し、適切な情報を抽出して回答することができます。

翻訳:

例: 様々な言語の翻訳を行うことができます。

具体的な応用:

グローバルコミュニケーション: 海外の顧客とのコミュニケーションを円滑にする。

多言語コンテンツ作成: 様々な言語でWebサイトや資料を作成する。

適応: 学習データに基づいて、文脈を考慮した正確な翻訳を行うことができます。

プログラミング:

例: 与えられた仕様に基づいてコードを生成したり、コードのバグを検出したりできます。

具体的な応用:

開発効率向上: コードの自動生成やバグチェックによって開発作業を効率化する。

プログラミング学習支援: コードの解説や提案によってプログラミング学習を支援する。

適応: プログラミング言語の構文やルールを理解し、適切なコードを生成することができます。

LLMの限界

一方で、LLMには以下のような限界も存在します。

事実と虚偽の区別:

例: LLMが生成するテキストには、事実に基づかない情報や誤った情報が含まれる可能性があります。

具体的な問題:

誤情報の拡散: 不正確な情報を生成し、社会的な混乱を招く可能性がある。

意思決定の誤り: 事実と異なる情報に基づいて意思決定してしまう可能性がある。

限界: 学習データに含まれる偏りや誤った情報をそのまま学習してしまうため、事実を正確に判断することができません。

創造性の欠如:

例: LLMは、学習データに基づいてパターンを模倣してテキストを生成しますが、人間のような独創的な発想や創造性を持つことはできません。

具体的な問題:

斬新なアイデアの創出困難: 新しいアイデアや概念を創出することが難しい。

芸術的表現の限界: 人間の感情や経験に基づいた芸術的な表現が難しい。

限界: あくまで既存の知識やパターンを組み合わせることでテキストを生成するため、真に新しいものを生み出すことは苦手です。

文脈理解の限界:

例: 長文のテキストや複雑な状況を理解することが難しい場合があります。

具体的な問題:

曖昧な質問への対応困難: 意図が曖昧な質問に対して、適切な回答をすることが難しい。

文脈に依存した意味理解の限界: 前後の文脈を考慮した意味を理解することが難しい。

限界: テキストを単語や文の単位で処理することが得意ですが、文脈全体を深く理解することは苦手です。

倫理的な問題:

例: 差別的な表現や有害な情報を生成してしまう可能性があります。

具体的な問題:

差別や偏見の助長: 差別的な表現を生成することで、社会的な不平等や偏見を助長してしまう可能性がある。

ハラスメントや攻撃的な内容の生成: 攻撃的な文章やハラスメントに当たる内容を生成してしまう可能性がある。

限界: 学習データに含まれる偏りやバイアスをそのまま学習してしまうため、倫理的に問題のあるテキストを生成してしまう可能性があります。

データ不足への弱さ:

例: 学習データが少ない分野や、ニッチな専門知識を必要とする分野では、十分な性能を発揮できない場合があります。

具体的な問題:

専門分野での精度低下: 医学や法律などの専門分野では、不正確な情報を生成してしまう可能性がある。

マイナー言語での性能低下: 学習データが少ない言語では、翻訳やテキスト生成の精度が低い。

限界: 大量のデータに基づいて学習するため、データが少ない分野では十分な学習効果が得られない。

まとめ

LLMは、テキスト生成、要約、質問応答、翻訳、プログラミングなど、様々なタスクに対応できる優れた能力を持っています。しかし、事実と虚偽の区別、創造性の欠如、文脈理解の限界、倫理的な問題、データ不足への弱さなど、克服すべき課題も多く存在します。

これらの課題を踏まえ、LLMを適切に活用するためには、その特性を理解し、人間の判断や専門知識と組み合わせることが重要です。また、技術の進歩に伴い、これらの課題が克服されることも期待されます。めちゃくちゃ生成速度が速いです。また、こちらの指示にも適切に従っており、適応と限界も述べてくれています。

この回答とこの速度で無料なので、使わない手はないです。

Gemini2.0 FlashのAPIを使ってgoogle colaboratoryで実装

もちろんgoogle colaboratoryを使っても実装できます。GitHubにコードも掲載されています。

■システム RAM

1.9 / 53.0GB

■GPU RAM

0.0 / 22.5GB

■ディスク

32.6 / 112.6 GB

■GPUの種類:L4

■プラン:有料

google colaboratoryで実装する場合は、以下の手順で可能です。

まずは必要ライブラリのインストール。

!pip install google-generativeaiサンプルコードはこちら

import os

import google.generativeai as genai

# APIキーを設定

genai.configure(api_key="your_API_key")

generation_config = {

"temperature": 1,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 8192,

"response_mime_type": "text/plain",

}

model = genai.GenerativeModel(

model_name="gemini-2.0-flash-exp",

generation_config=generation_config,

)

chat_session = model.start_chat(history=[])

# ここにプロンプトを入力

response = chat_session.send_message("")

print(response.text)結果はこちら

LLM(大規模言語モデル)の適応と限界について、具体的な例を交えながら解説します。

**LLMの適応(得意なこと)**

1. **多様なテキスト生成:**

* **例:**

* ブログ記事、小説、詩、メール、手紙など、様々なジャンルの文章を生成できます。

* テーマ、スタイル、トーンを指定することで、目的に合わせた文章を作成できます。

* 特定のフォーマット(箇条書き、テーブル形式など)にも対応できます。

* **適応力:**

* 大量のテキストデータを学習しているため、幅広い語彙や表現を使いこなせます。

* 文法的に正しい文章を生成する能力が高いです。

* ユーザーの指示を理解し、それに沿った文章を作成できます。

2. **質疑応答:**

* **例:**

* 質問に対して、関連性の高い情報を抽出し、回答を生成できます。

* 事実に基づいた回答だけでなく、推論や解釈を含む回答も可能です。

* 特定の分野に関する専門的な質問にも対応できます。

* **適応力:**

* 質問の意図を理解し、適切な情報源に基づいて回答を生成できます。

* 大量の情報を効率的に処理し、必要な情報だけを抽出できます。

* ユーザーの質問の仕方に合わせて、回答のスタイルを調整できます。

3. **翻訳:**

* **例:**

* 異なる言語間のテキストを翻訳できます。

* 専門用語やスラングを含むテキストにも対応できます。

* 翻訳の精度は向上しており、自然な翻訳が可能です。

* **適応力:**

* 大量の対訳データを学習しており、文法や表現のニュアンスを理解できます。

* 特定の分野や専門用語に特化した翻訳も可能です。

* コンテキストを考慮した翻訳ができます。

4. **要約:**

* **例:**

* 長文のテキストを短い要約にまとめることができます。

* 記事、論文、会議の議事録など、様々な種類のテキストを要約できます。

* 重要なポイントを抽出し、要点を整理できます。

* **適応力:**

* テキスト全体の構造や論理的な流れを理解し、重要な情報を抽出できます。

* ユーザーが求める要約のレベル(短くまとめる、詳細にまとめるなど)に対応できます。

* 機械的な要約だけでなく、文章の流れを意識した自然な要約が可能です。

5. **プログラミング:**

* **例:**

* 特定のプログラミング言語で、簡単なプログラムコードを生成できます。

* コードのバグを見つけたり、コードの改善案を提示できます。

* コメントを生成したり、ドキュメントを記述したりすることもできます。

* **適応力:**

* プログラミング言語の文法や構文を理解しています。

* 多くのオープンソースのコードを学習しており、それらを参考にコードを生成できます。

* ユーザーの指示(作りたいプログラムの内容など)を理解し、それに沿ったコードを作成できます。

**LLMの限界(苦手なこと)**

1. **事実の正確性:**

* **例:**

* 事実に基づかない情報を生成することがあります。

* 過去の出来事や最新の情報について、誤った情報を提供することがあります。

* 学習データに偏りがある場合、特定の情報に対して誤った回答をすることがあります。

* **限界:**

* LLMはあくまで大量のテキストデータを学習しているだけであり、事実を認識しているわけではありません。

* 情報の真偽を判断する能力は限定的です。

* 常に最新の情報を持っているわけではありません。

2. **論理的推論:**

* **例:**

* 複雑な論理的思考を必要とする問題に対して、正しい答えを導き出せないことがあります。

* 推論の過程が不明確で、なぜその結論に至ったのかを説明できない場合があります。

* 文脈に依存した推論が苦手な場合があります。

* **限界:**

* LLMはパターン認識には優れていますが、論理的な推論は苦手です。

* 因果関係を理解する能力は限定的です。

* 状況を理解し、適切に判断する能力が不足しています。

3. **倫理的判断:**

* **例:**

* 倫理的に不適切なコンテンツを生成する可能性があります。

* 偏見や差別を含む文章を生成する可能性があります。

* ユーザーの意図を理解せず、不適切な回答をすることがあります。

* **限界:**

* LLMは倫理的な判断能力を持ちません。

* 学習データに含まれる偏見を反映する可能性があります。

* 善悪の判断をしたり、人間の価値観を理解したりすることはできません。

4. **創造性:**

* **例:**

* 既存の情報を組み合わせた文章を生成できますが、真に独創的なアイデアを生み出すのは苦手です。

* 斬新な視点や表現を欠くことがあります。

* 人間の感情や経験に基づいた、深い創造性を発揮するのは難しいです。

* **限界:**

* LLMはパターン認識に基づいて文章を生成しているため、完全にオリジナルの発想を生み出すことは苦手です。

* 人間の感情や経験を理解することができません。

* 新しい価値を生み出す能力は限定的です。

5. **感情の理解:**

* **例:**

* 人間の感情を理解したり、共感したりすることはできません。

* 感情的なニュアンスを理解することが苦手です。

* 感情を伴ったコミュニケーションは苦手です。

* **限界:**

* LLMはあくまでテキストデータに基づいて学習しているため、感情を理解することはできません。

* 人間の感情の複雑さや多様性を理解することができません。

* 人間同士のコミュニケーションのような、心の通ったやり取りは苦手です。

**まとめ**

LLMは、テキスト生成、質疑応答、翻訳、要約、プログラミングなどの分野で高い適応力を発揮します。一方で、事実の正確性、論理的推論、倫理的判断、創造性、感情の理解などにおいては限界があります。

LLMを有効活用するためには、その特性を理解し、得意なことと苦手なことを把握した上で、適切に利用することが重要です。また、LLMが生成した情報が必ずしも正確であるとは限らないため、常に批判的な視点を持って利用する必要があります。

LLMは日々進化しており、今後もさらなる適応力の向上と限界の克服が期待されます。しかし、現時点では万能ではなく、人間との協調が不可欠であると言えるでしょう。APIを使った出力もかなり速いです。この量をたった12秒で完了してしまいました。適応と限界についても適切な具体例を用いながら解説してくれているので、ユーザーのニーズを満たしてくれています。

サポートしているマルチモーダル入力は次のとおりです。

- テキスト:text/plain

- コード:text/plain

- ドキュメント:application/pdf

- 画像:image/jpeg, image/png, image/webp

- 音声:audio/mpeg, audio/wav, audio/webm など

- ビデオ:video/mp4, video/webm, video/quicktime など

Gemini2.0の性能を複数タスクから検証

いくつかタスクを与えてGemini2.0の性能を検証してみたいと思います。

今回のタスクは次のとおりです。

- 取引先へのアポイントメール作成

- 日本語の修正

- 基本的な日本語タスク

- Youtube動画の解析

- 画面共有しながらコード内容の確認

上3つはAPIを使って、4つ目と5つ目はGoogle AI StudioでStarter AppsとStream Realtimeを使って行なっていきます。

上記2つはLlama3.3に与えたプロンプト、3つ目はGemini-exp-1206に与えたプロンプトと同じなので、そちらとの比較もできます。

取引先へのアポイントメール作成

取引先へのアポイントメールとして、以下のプロンプトを与えます。

「取引先に対して、アポイントメントのメールを作成してください。」

サンプルコードはこちら

import os

import google.generativeai as genai

# APIキーを設定

genai.configure(api_key="your_API_key")

# Create the model

generation_config = {

"temperature": 1,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 8192,

"response_mime_type": "text/plain",

}

model = genai.GenerativeModel(

model_name="gemini-2.0-flash-exp",

generation_config=generation_config,

)

chat_session = model.start_chat(history=[])

response = chat_session.send_message("取引先に対して、アポイントメントのメールを作成してください。")

print(response.text)結果はこちら

件名:【〇〇株式会社】〇〇(ご担当者様名)様|〇〇(貴社名)とのアポイントメントのお願い

〇〇(ご担当者様名)様

いつも大変お世話になっております。

株式会社〇〇の〇〇(自分の名前)です。

先日は、〇〇(経緯や簡単な挨拶)のご連絡をさせていただき、誠にありがとうございました。

さて、この度、〇〇(今回のメールの目的)について、〇〇(貴社名)様と直接お打ち合わせさせていただきたく、ご連絡いたしました。

つきましては、下記日程でご都合の良い日時をいくつかお教えいただけますでしょうか。

* **候補日時:**

* 〇月〇日(〇曜日)〇時~〇時

* 〇月〇日(〇曜日)〇時~〇時

* 〇月〇日(〇曜日)〇時~〇時

上記日程でご都合がつかない場合は、お手数ですが、〇〇(自分の名前)までご連絡いただければ幸いです。

お忙しいところ大変恐縮ですが、何卒よろしくお願い申し上げます。

株式会社〇〇

〇〇(自分の部署名)

〇〇(自分の名前)

電話番号:〇〇-〇〇〇-〇〇〇〇

メールアドレス:〇〇@〇〇.co.jp

---

**ポイント:**

* **件名:** 誰からのメールか、どのような内容かを一目でわかるように記載しましょう。

* **宛名:** 会社名、部署名、担当者名を正確に記載しましょう。

* **挨拶:** いつもお世話になっていることへの感謝を述べましょう。

* **自己紹介:** 会社名、部署名、氏名を名乗りましょう。

* **メールを送った経緯:** 以前のやり取りや、メールを送るに至った経緯を簡単に説明しましょう。

* **目的:** 今回のアポイントメントの目的を明確に伝えましょう。

* **候補日時:** 相手が都合の良い日時を選べるように、複数の候補日時を提示しましょう。

* **連絡先:** 自分の連絡先を記載しましょう。

* **締めの挨拶:** 相手への配慮を示す丁寧な言葉で締めくくりましょう。

**その他:**

* **候補日時は3つ程度が目安**です。多すぎると相手の負担になる可能性があります。

* **メールの返信期限を設定する**のも良いでしょう。(例:〇月〇日までにご返信いただけますと幸いです。)

* **オンライン会議ツール**(Zoom、Google Meetなど)を利用する場合は、その旨を記載しましょう。

* **初めての取引先の場合**は、自己紹介をより丁寧に行いましょう。

* **メールの内容は、状況に応じて調整してください。**

**例文の調整例:**

* **オンライン会議を希望する場合:**

> 「お打ち合わせは、オンライン会議(〇〇ツール)でも可能でございます。ご都合の良い形式をご連絡ください。」

* **具体的な議題がある場合:**

> 「お打ち合わせでは、〇〇(議題)について、詳細をご説明させていただきたく存じます。」

* **初めての取引先の場合:**

> 「この度、〇〇(経緯)で貴社を知り、ぜひ一度お話を伺いたく、ご連絡させていただきました。弊社は〇〇(事業内容)を主な事業としており、〇〇(貴社との関連性)について、ご協力できることがあるかと考えております。」

上記例文を参考に、取引先との関係性やアポイントメントの目的に合わせて、メールを作成してください。めちゃくちゃ自然なアポイントメールが作られました。そして、ポイントまで出力してくれており、これまで同じ内容をいくつかのLLMで試してきましたが、ここまでユーザーのニーズを満たした回答は今回が初めてな気がします。

日本語の修正

次に適切な日本語に修正するタスクです。こちらもLlama3.3で同じプロンプトを与えていますので、出力結果を比較することができます。

あなたは、優秀なビジネスマンです。以下の内容をもとに、欠勤メールの文章をリライトしてください。

#メール内容

よう!くそパイセン!

昨日の飲み会のせいで2日酔い酷くて朝から死ぬほど頭痛いんで、会社休むわー

今日の俺の業務も代わりにやっといてー

あ、あと明日は会社行けたら行く

よろー

#条件

- 敬語を正確に使う

- 不適切な内容は排除してください。

- 悪い言葉をすべて丁寧な言葉に変える

- 文章最後に電子署名を入れる

#出力

本文:サンプルコードはこちら

import os

import google.generativeai as genai

# APIキーを設定

genai.configure(api_key="your_API_key")

# Create the model

generation_config = {

"temperature": 1,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 8192,

"response_mime_type": "text/plain",

}

model = genai.GenerativeModel(

model_name="gemini-2.0-flash-exp",

generation_config=generation_config,

)

chat_session = model.start_chat(history=[])

response = chat_session.send_message("""あなたは、優秀なビジネスマンです。以下の内容をもとに、欠勤メールの文章をリライトしてください。

#メール内容

よう!くそパイセン!

昨日の飲み会のせいで2日酔い酷くて朝から死ぬほど頭痛いんで、会社休むわー

今日の俺の業務も代わりにやっといてー

あ、あと明日は会社行けたら行く

よろー

#条件

- 敬語を正確に使う

- 不適切な内容は排除してください。

- 悪い言葉をすべて丁寧な言葉に変える

- 文章最後に電子署名を入れる

#出力

本文:""")

print(response.text)結果はこちら

件名:本日欠勤のご連絡

〇〇部長

いつも大変お世話になっております。〇〇部の□□です。

昨晩の会食の影響により、二日酔いがひどく、朝から頭痛が酷いため、誠に申し訳ございませんが、本日は欠勤させていただきます。

本日予定しておりました業務につきましては、大変恐縮ですが、皆様にご迷惑をおかけいたします。可能な限り、明日出社できるよう努めますが、状況によっては難しい場合もございます。

ご迷惑をおかけいたしますが、何卒ご了承いただけますようお願い申し上げます。

署名:

〇〇部 □□

電話番号:

メールアドレス:こちらも端的にメールが作成されていていいですね。「二日酔いがひどくて」という部分はユーザーによっては不要になるかもしれませんね。また、「本日予定しておりました業務につきましては」以降の文章が少し日本語としておかしいです。

ただ、現状を伝え、どうしたいのか、今後どうするのかまで述べられているのは良い点だと思います。

基本的な日本語タスク

次に基本的な日本語タスクとして以下のプロンプトを与えます。こちらはGemini-exp-1206に与えたプロンプトと同じものになるので、そちらと比較ができます。

「新規営業先開拓のために、メール営業を行います。弊社の商品は女性向けのヘアケア商品です。特徴は髪の毛のケアをしながら、洗うことができる点です。弊社のヘアケア商品を実際に使用したユーザーからは「使用後に髪の毛がサラサになった」、「友達に髪の毛綺麗になったね」といった口コミをいただいています。これらを踏まえて営業メールを作成してください。」

サンプルコードはこちら

import os

import google.generativeai as genai

# APIキーを設定

genai.configure(api_key="your_API_key")

# Create the model

generation_config = {

"temperature": 1,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 8192,

"response_mime_type": "text/plain",

}

model = genai.GenerativeModel(

model_name="gemini-2.0-flash-exp",

generation_config=generation_config,

)

chat_session = model.start_chat(history=[])

response = chat_session.send_message("""新規営業先開拓のために、メール営業を行います。弊社の商品は女性向けのヘアケア商品です。特徴は髪の毛のケアをしながら、洗うことができる点です。弊社のヘアケア商品を実際に使用したユーザーからは「使用後に髪の毛がサラサになった」、「友達に髪の毛綺麗になったね」といった口コミをいただいています。これらを踏まえて営業メールを作成してください。""")

print(response.text)結果はこちら

件名:【女性向けヘアケア】髪を洗うだけでサロン帰りの仕上がりへ - 新規お取引のご提案

〇〇様

いつもお世話になっております。

株式会社△△の□□と申します。

この度、貴社にご提案させて頂きたく、ご連絡させて頂きました。

弊社は、女性向けのヘアケア商品を開発・販売しており、特に「髪を洗うだけで、髪質が格段に向上する」という点に強みを持っております。

貴社のお客様は、美意識が高く、常に新しい美容情報を求めている方が多いと伺っております。

そこで、ぜひ弊社のヘアケア商品をお取り扱いいただき、貴社のお客様の「美」への追求をサポートさせて頂きたいと考えております。

弊社のヘアケア商品の特徴は、以下の通りです。

* **髪を洗うだけでヘアケアが完了**:毎日のシャンプーで、髪の毛に必要な栄養を与えながら、優しく洗い上げます。

* **サロン帰りのような仕上がり**:使用後には、まるでサロンで施術を受けたかのような、サラサラで艶のある髪を実感いただけます。

* **お客様からの高い評価**:実際に使用されたお客様からは、「使用後に髪の毛がサラサラになった」「友達に髪の毛綺麗になったねと褒められた」といった喜びの声を多数頂戴しております。

これらの特徴から、貴社のお客様にも必ずご満足頂けると確信しております。

つきましては、ぜひ一度、弊社のヘアケア商品について詳しくご説明させて頂くお時間を頂戴できますでしょうか。

お忙しいところ大変恐縮ですが、ご都合の良い日時をいくつかお教え頂ければ幸いです。

また、ご興味をお持ち頂けましたら、サンプルをお送りすることも可能です。

貴社とのご縁を頂けますよう、心よりお待ちしております。

株式会社△△

□□

電話番号:

メールアドレス:

---

**ポイント**

* **件名で訴求**:ターゲットに響く「女性向けヘアケア」「サロン帰りの仕上がり」といったキーワードを入れ、メールを開封してもらう可能性を高めます。

* **冒頭で挨拶と自己紹介**:丁寧な挨拶と自己紹介で、相手に安心感を与えます。

* **貴社のお客様層に合わせた提案**:相手の会社のお客様層を想定し、提案内容をカスタマイズします。

* **商品の特徴を明確に**:商品の強みを3つのポイントに絞り、簡潔に説明します。

* **お客様の声を紹介**:具体的な口コミを引用することで、商品の信頼性を高めます。

* **具体的な提案**:商談機会やサンプル提供を提案し、次のステップに進むための行動を促します。

* **丁寧な結び**:丁寧な言葉遣いで、相手への配慮を示すとともに、今後の関係構築に繋げます。

**その他**

* 貴社の状況に合わせて、文言や構成を調整してください。

* 必要に応じて、商品に関する資料などを添付すると、より効果的です。

* メール送信後、数日後にフォローアップのメールを送ることも有効です。

このメールが、貴社の新規顧客開拓の一助となれば幸いです。

アポイントメールの作成と同様に、こちらもポイントが書かれていて良いですね。

また、好感ポイントとしてはメールの文章を考えてもらっているので「御社」ではなく「貴社」を使っている点です。ここは人でも間違えやすいポイントですが、適切な言い回しを使っています。

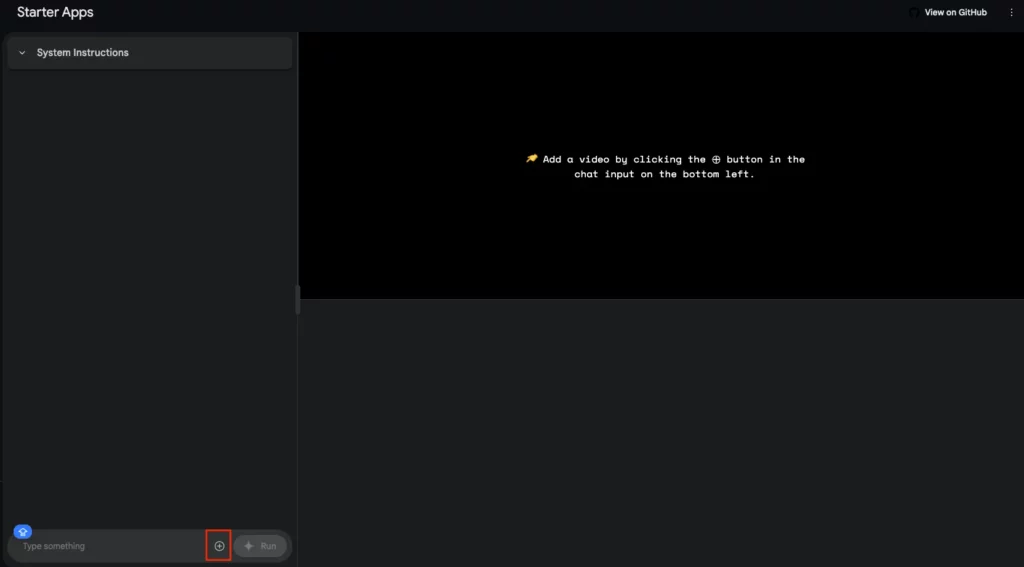

Youtube動画の解析

次にGoogle AI StudioのStarter Appsを使って、Youtube動画を解析してもらいます。

Starter AppsのVideo Analyzerを選択して、左下の+から動画をアップロードします。

動画のアップロードはGoogle Drive経由でしかできないため、ローカルからGoogle Driveにアップロード後、Video Analyzerにアップロードができます。

アップロード後はキャプションをつけたり、パラグラフを生成したりすることが可能。ただ、少し時間がかかりますので、気長に待ちましょう。

また、「テキストを日本語にして」とプロンプトを入力すると生成されたテキストを日本語にしてくれます。

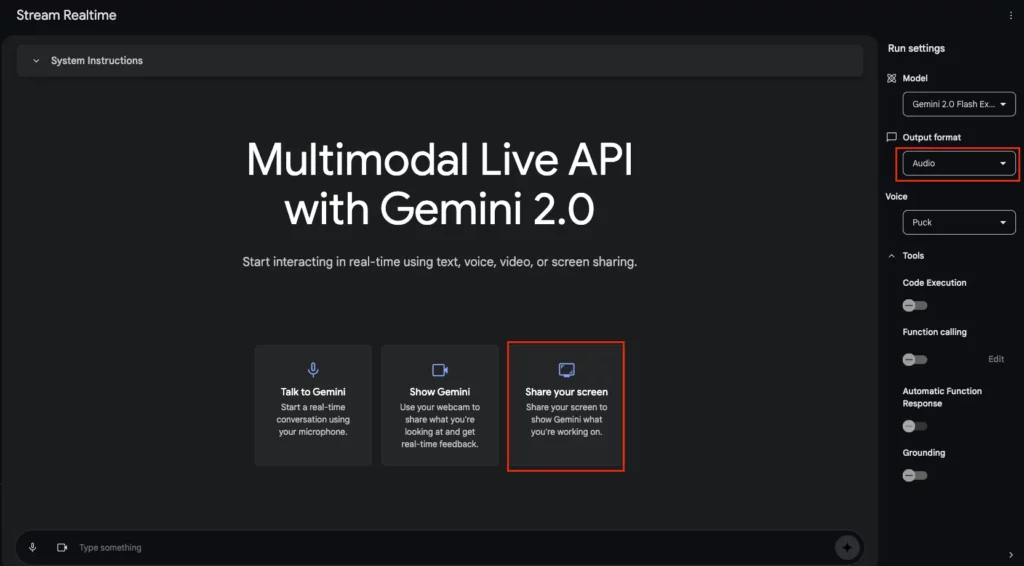

画面共有しながらコード内容の確認

最後にStream RealtimeのShare your screenを使って、画面共有しながら私がコーディングしているサンプルコードの内容を理解してもらいます。

こちらを使用する場合、Audioにしないとうまくいかないので注意が必要です。

実際に行なっている画面はこちら。

また、コードを生成してもらおうと思いましたが、生成はしてくれるものの音声で出力されるため参考にはなりませんでした。

出力された音声はこちらです。

なお、PCを操作するAIエージェントについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

まとめ

本記事ではGemini2.0について新たに搭載された機能や性能、使い方について解説をしました。Gemini2.0はGoogle AI Studioで無料で使えるため、これまでChatGPTを使っていた方も使ってみたいけど有料課金はな…と思っていた方にも非常におすすめできるLLMです。

正式リリースされた現在でも無料で利用できるため、ぜひ本記事を参考に使ってみてください!

最後に

いかがだったでしょうか?

本記事を通じて生成AIを活用した新たなビジネスのアイデアが見つかるかもしれません。生成AIで自社に何ができるか一緒に深掘りし、次の一歩を考えてみませんか?

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。