Stable Diffusion XL(SDXL)とは?旧モデルとの違いや導入方法、注意点を解説

- プロンプトの理解力が向上し、意図通りの画像を生成可能

- 従来のモデルと比べて2倍以上のパラメーター数で複雑なタスクに対応

- 繊細なライティングやシャドウ表現でリアルな仕上がりに

WEELメディアリサーチャーのいつきです。

みなさんは、Stable Diffusion XL(SDXL)についてご存知でしょうか?Stable Diffusion XLとは、Stability AI社が開発した画像生成AIで、SDXLとも略されています。

旧モデルと比較して高精度の画像を出力できるため、よりユーザーニーズに沿った画像を生成できるのが魅力です。

今回は、Stable Diffusion XLの特徴や使い方をご紹介します。

最後まで目を通していただくと、Stable Diffusion XLを使いこなせるようになるので、クリエイティブな活動が捗ること間違いありません。

ぜひ最後までご覧ください!

Stable Diffusion XLとは

Stable Diffusion XL(SDXL)とは、Stability AI社が2023年にリリースした画像生成AIです。オープンソースで提供されているため、基本的には誰でも無料で利用できます。

最大の特徴はプロンプトの理解力や出力する画像の精度が向上した点です。コントラスト・ライティング・シャドウなどが高いレベルで調整されているので、色鮮やかで綺麗な画像を生成できます。

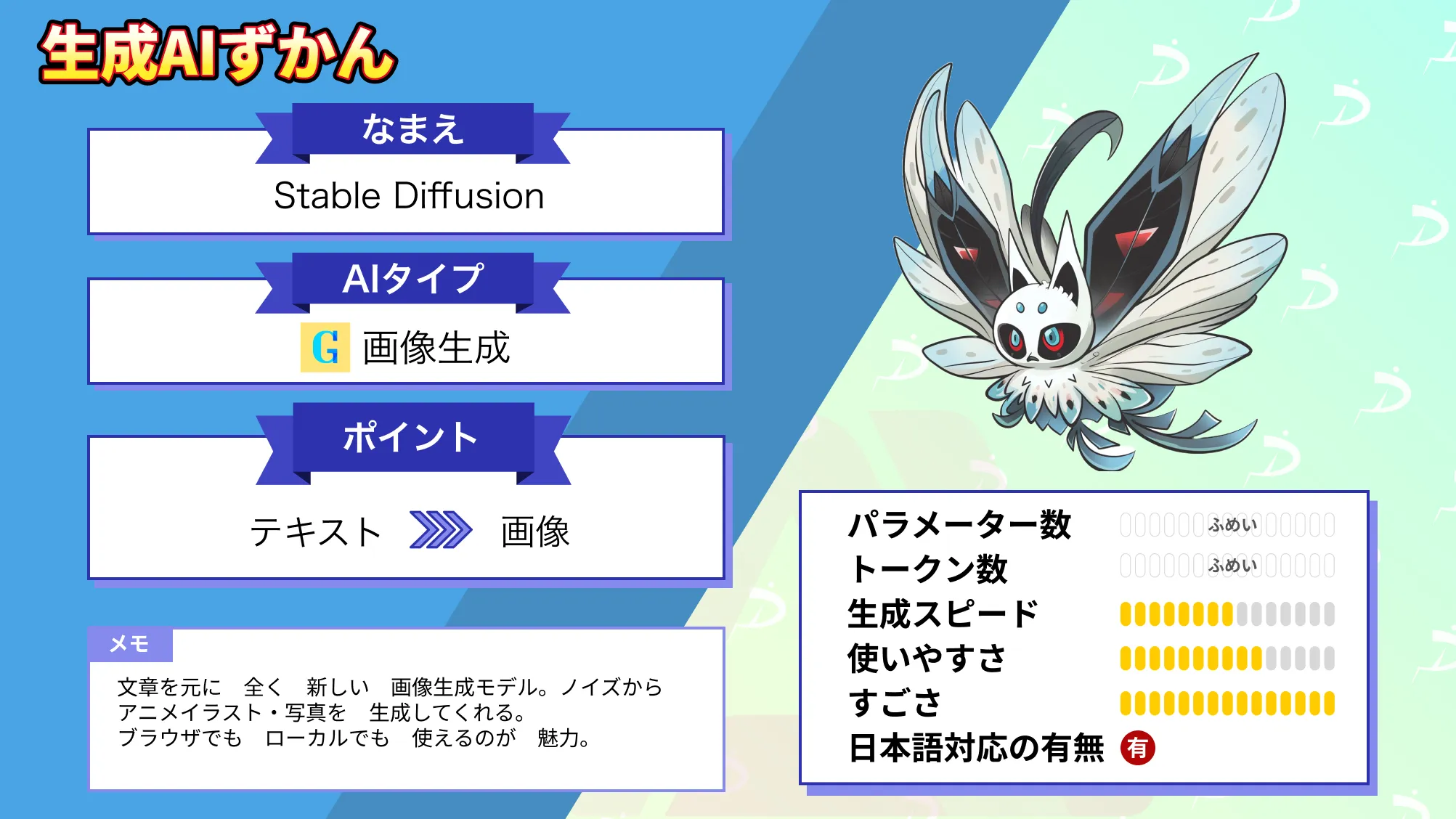

なお、Stable Diffusionについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusion XLと旧モデルとの違い

Stable Diffusion XLと旧モデルのStable Diffusion 1.5との違いをまとめました。

- 複雑な構図で画像生成が可能

- パラメーター数が従来のモデルの2倍以上

- 出力精度が上がった

- 最大1,024×1,024の画像が生成可能

とくに、画像の出力精度や画質が向上している点が大きな違いです。

Stable Diffusion XLの特徴を詳しく解説していくので、ぜひ参考にしてみてください。

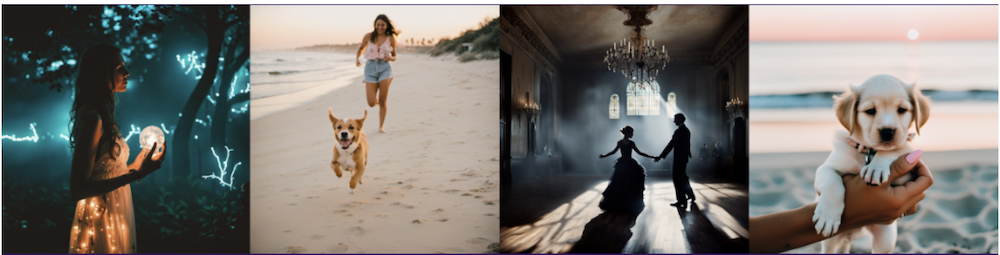

複雑な構図で画像生成が可能

Stable Diffusion XLは、旧モデルと比較して、複雑な構図での画像生成が可能になりました。手やテキストを綺麗に表現できるほか、上記画像の犬を追いかける女性といった空間的に配置された構図を表現できるのが特徴です。

画像モデルがレンダリングしにくかった概念を生成できるようになったので、画像生成の幅が広がっています。

パラメーター数が従来のモデルの2倍以上

Stable Diffusion XLは、旧モデルのStable Diffusion 1.5と比較してパラメーター数が2倍以上になっています。パラメーター数とは機械学習モデルが学習中に最適化する変数の数を表しており、数値が大きいほど複雑なタスクを高精度でこなせます。

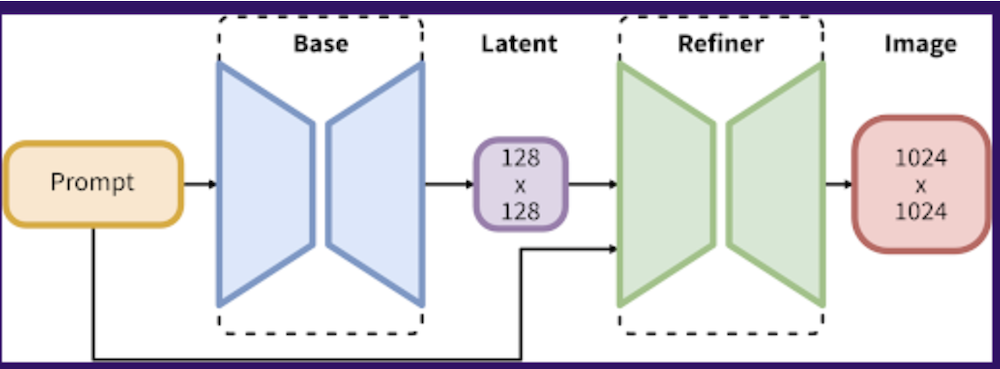

なお、Stable Diffusion XLは、3.5BのBaseモデルと6.6BのRefinerモデルの2種類で構成されているのが特徴です。Baseモデルが潜在情報を生成したあと、Refinerモデルがノイズ除去を実行して効率よく画像を生成できます。

出力精度が上がった

Stable Diffusion XLは、短いプロンプトからでも高画質画像の出力が可能になりました。単語を詳しく説明する修飾語を使わずとも、ユーザーの意図を理解した画像を作成できます。

「The Red Square」と「(a) red square」のように、概念の違いも理解できるようになったので、画像生成の利便性も向上しています。

最大1,024×1,024の画像が生成可能

Stable Diffusion XLでは、最大1,024×1,024の解像度で画像を生成できます。旧モデルのStable Diffusion 1.5が最大512×512だったため、2倍の大きさになりました。

画像サイズのアップに伴い、コントラスト・ライティング・シャドウなどの表現も向上しているので、色彩豊かで美しい画像を作成できるようになっています。

Stable Diffusion XLの導入方法

Stable Diffusion XLの導入手順を以下にまとめました。

- Stable Diffusion Web UIをインストール

- 必要なファイルをダウンロード

- ファイルを適切な場所に格納

- Stable Diffusion Web UIを起動してモデルを切り替え

導入するまでの手順が複雑ですが、以下で詳しく解説していくので、参考にしてみてください。

Stable Diffusion Web UIをインストール

まずは、Stable Diffusion Web UIをインストールします。すでにローカルPCにインストール済みの方は、この手順を飛ばして問題ありません。

Stable Diffusion Web UIをインストールする際は、PythonやGitなどの必要なファイルをいくつもダウンロードする必要があります。

インストール方法について詳しくは以下の記事をご覧ください。

Stable Diffusion Web UIをローカルPC上にインストールするのがスペック的に厳しい方は、Google Colab上でインストールして起動するのがおすすめです。

必要なファイルをダウンロード

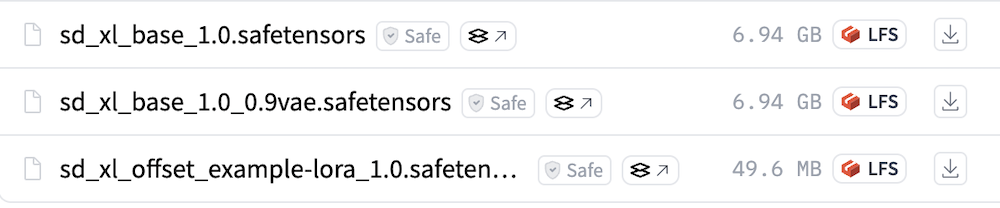

Stable Diffusion XLを導入するには、Baseモデル・Refinerモデル・VAEの3つのファイルをダウンロードする必要があります。

RefinerモデルとVAEはダウンロードしなくてもStable Diffusion XLを使えますが、生成画像を高画質化させる重要な役割を担っているのでダウンロード推奨です。

まずは、Hugging FaceからBaseモデルのダウンロードページにアクセスしてください。

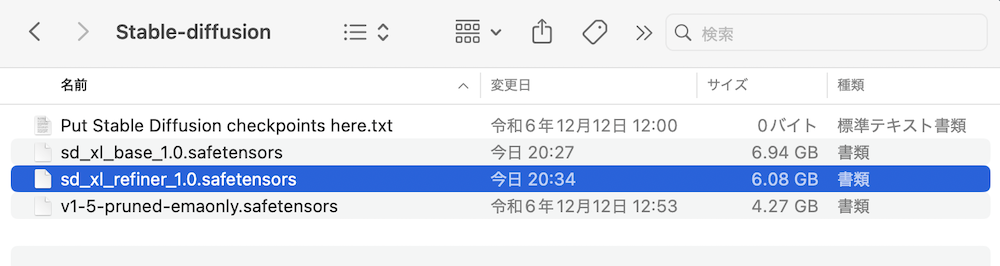

上記画像のうち、1番上の「sd_xl_base_1.0.safetensors」をダウンロードします。

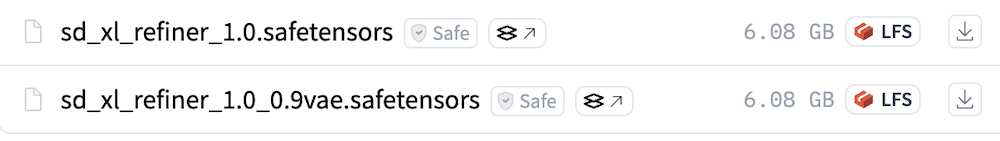

次はRefinerモデルをダウンロードします。

Hugging FaceのRefinerモデルのダウンロードページにアクセスして、上記画像にもある「sd_xl_refiner_1.0.safetensors」をダウンロードします。

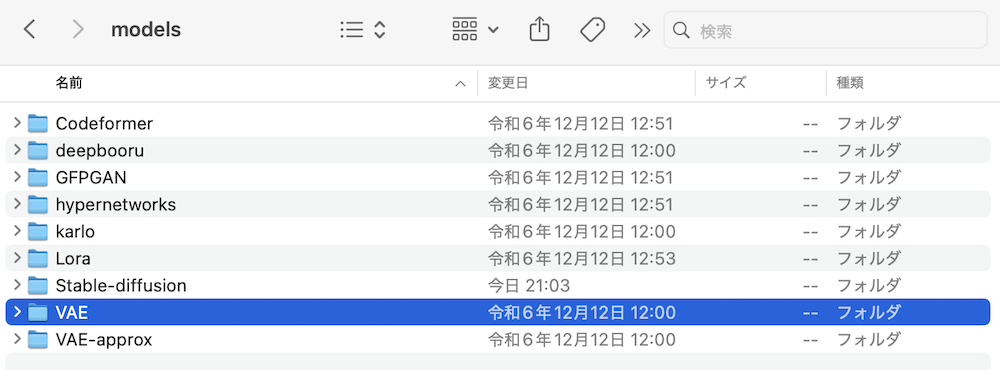

最後にVAEです。

Hugging FaceのVAEのダウンロードページにアクセスして、上記画像にもある「sdxl_vae.safetensors」をダウンロードします。

これで必要なファイルのダウンロードは完了です。

ファイルを適切な場所に格納

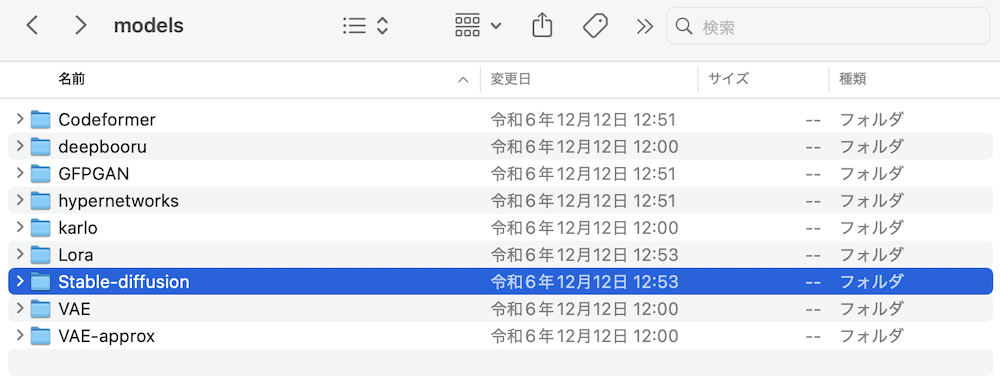

ダウンロードしたBaseモデル・Refinerモデル・VAEの3つをそれぞれ適切な場所に格納します。

BaseモデルとRefinerモデル:「stable-diffusion-webui」→「models」→「Stable-diffusion」

VAE:「stable-diffusion-webui」→「models」→「VAE」

筆者はMacを使用しているので、Macの手順を解説します。

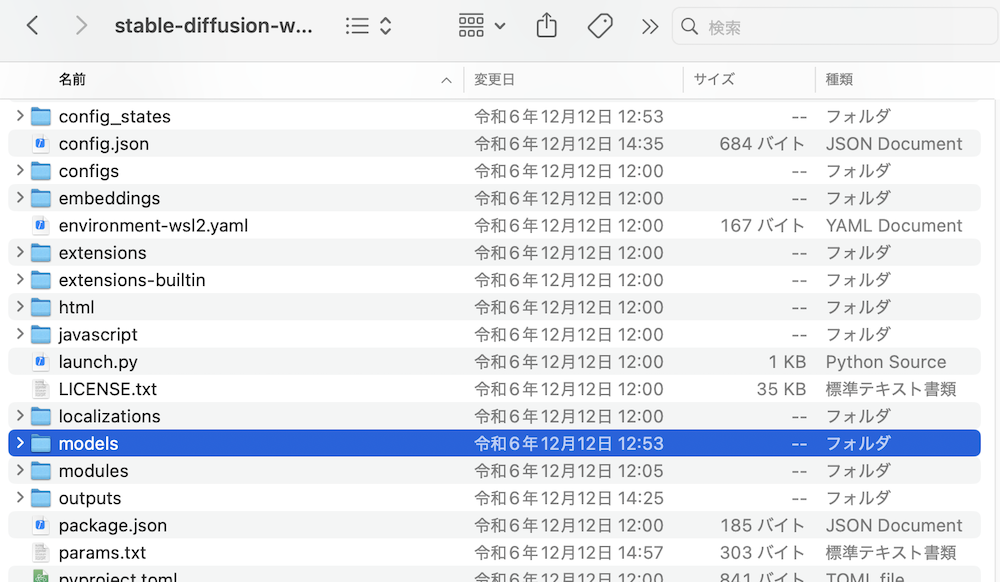

まずはFinderを開いて、「stable-diffusion-webui」のファイルを検索して見つけ出します。

検索しても出てこない場合は、Stable Diffusion Web UIをインストールできていないので、「Stable Diffusion Web UIをインストール」の手順に戻ってください。

「stable-diffusion-webui」→「models」の順に開きます。

「models」→「Stable-diffusion」の順に開いたら、ここにBaseモデルとRefinerモデルのファイルを格納してください。

VAEも同じ要領で「models」→「VAE」に格納します。

これでファイルの格納は完了です。

Stable Diffusion Web UIを起動してモデルを切り替え

Macの場合はターミナルで以下のコマンドを実行して、Stable Diffusion Web UIを起動します。

bash stable-diffusion-webui/webui.sh

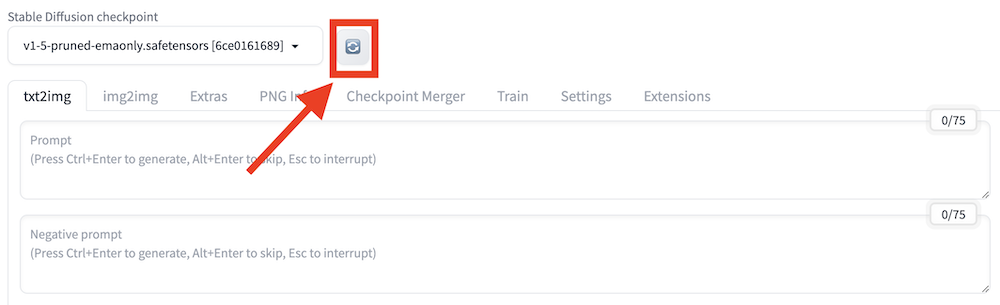

起動後は上記の更新ボタンを押したあと、ダウンロードした「sd_xl_base_1.0.safetensors」を選択してモデルを切り替えてください。

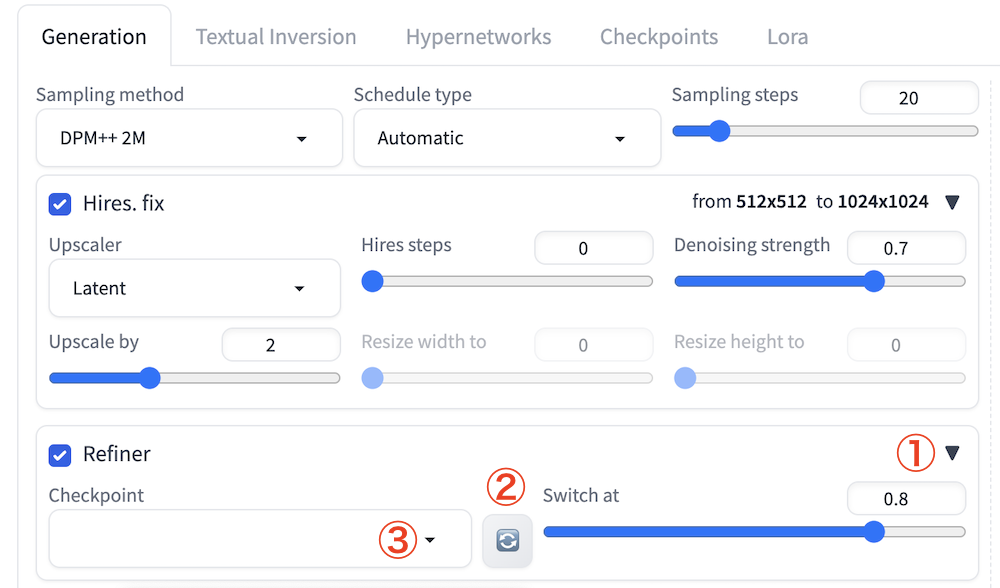

続いて、「txt2img」タブの下部にある「Refiner」横の三角アイコンをクリックします。

「Checkpoint」の更新ボタンを押してから、プルダウン内で「sd_xl_refiner_1.0.safetensors」を選択してください。

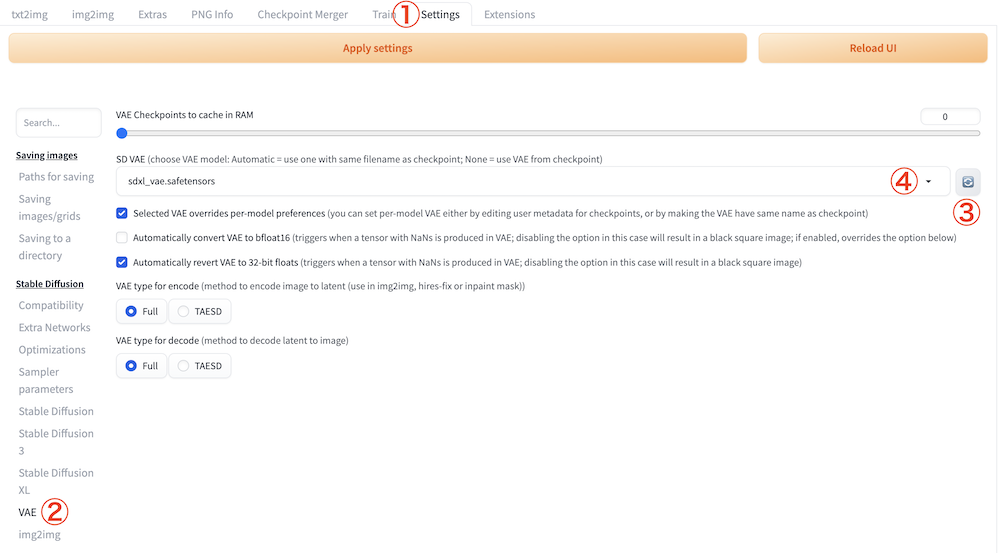

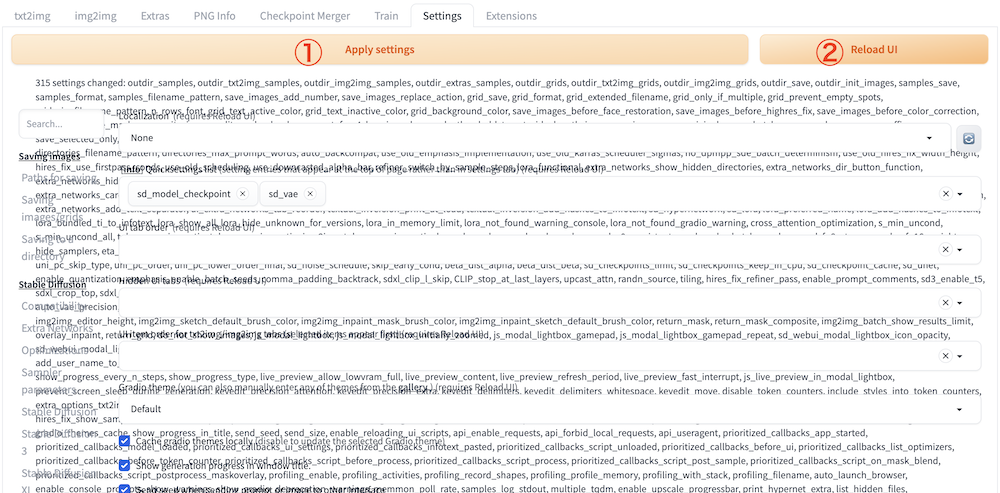

次は「Settings」タブを開いたあと、サイドバーの「VAE」を開きます。その後、「SD VAE」から「sdxl_vae.safetensors」を選択してください。

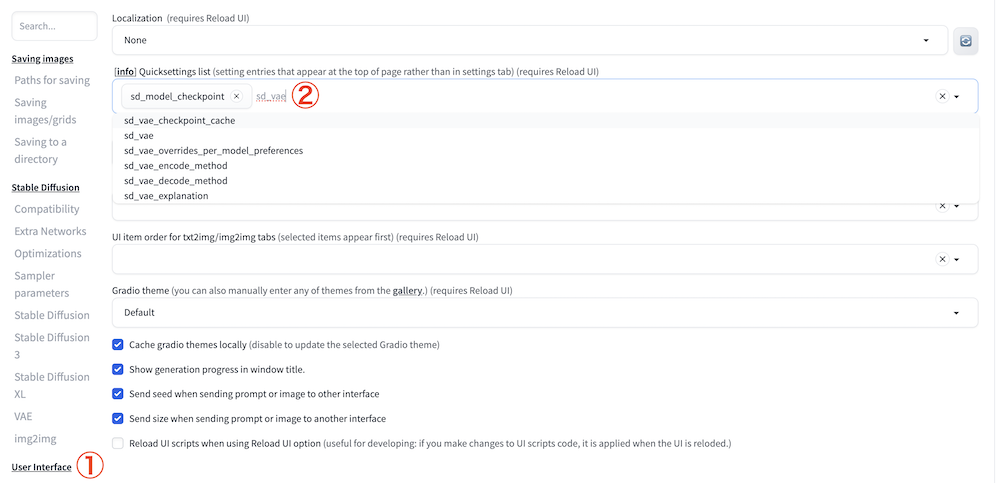

サイドバーの「User interface」を開きます。

上記画像の②の場所にカーソルを合わせて「sd_vae」と入力して、候補に出てくる「sd_vae」をクリックしてください。

次は「Apply Settings」をクリックして設定内容を保存したあと、「Reload UI」をクリックしてWeb UIをリロードします。

「Apply Settings」をクリックしたあとに一瞬表示がおかしくなりましたが、「Reload UI」でリロードしたあとは解決しました。

リロード後の画面上部に「SD VAE」が追加されていれば、Stable Diffusion XLを導入する一連の作業は完了です。

なお、Stable Diffusion Web UIについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusion XLを使って画像を生成してみた

実際にStable Diffusion XLを使って、画像を生成してみました。

まずは、以下のシンプルなプロンプトを入れてみます。

Beautiful girl in white dress.(白いドレスを着た美少女)ネガティブプロンプトには「low quality(低い画質)」を入れてみました。

生成された画像がこちらです。

仕上がりはだいぶ微妙ですね…

頭の上に変な物体がありますし、目の表現も綺麗ではありません。

今度はノイズの除去回数を示す「Sampling steps」を22に上げてみました。

プロンプトをしっかり把握できており、人物も綺麗な見た目になりましたね。

このように同じプロンプトでも設定をいじるだけで画像の出力精度が変わってきます。まだまだ改善の余地があるので、実際にStable Diffusion XLを利用する際は、色々な設定を試してみてください。

Stable Diffusion XLを利用する際の注意点

Stable Diffusion XLを利用する際は、以下の2点に注意してください。

- 導入までのハードルがある

- GPUメモリの消費量が激しい

それぞれの注意点を以下で詳しく解説します。

導入までのハードルがある

Stable Diffusion XLの導入方法でも解説しましたが、導入までにいくつものファイルをインストールし、設定を変更する必要があります。

手順が複雑なため、PCの操作に詳しくない方からすればかなりハードルが高いです。

ただし、当記事で紹介している情報を参考にしながら正しいステップを踏めば、問題なく導入できるので、諦めずにまずはチャレンジしてみてください。

GPUメモリの消費量が激しい

Stable Diffusion XLは高度な画像を生成できる分、GPUメモリの消費量が激しいです。GPUが搭載されていないPCでも動作はしますが、画像生成に多くの時間がかかります。

PCのスペック的にローカル環境へのインストールが厳しい場合は、Google Colab上で利用するか、DreamStudioなどのオンライン上で利用する方法を検討してみてください。

なお、Stable Diffusionが使えるWebアプリについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusion XLで高精度な画像を生成しよう

Stable Diffusion XLは、プロンプトの理解力や出力する画像の精度が向上しているので、ユーザーニーズに沿った綺麗な画像を出力できます。

とくに、旧モデルと比較して、以下の点が大きく異なるのが特徴です。

- 複雑な構図で画像生成が可能

- パラメーター数が従来のモデルの2倍以上

- 出力精度が上がった

- 最大1,024×1,024の画像が生成可能

導入までの手順は複雑ですが、当記事でも詳しく解説しています。

うまく使いこなせれば、高精度かつ自由度の高い画像を生成できるようになるので、ぜひ利用してみてください。

最後に

いかがだったでしょうか?

Stable Diffusionなどの画像生成AIを活用し、高精度な画像生成で広告バナーやSNS投稿用ビジュアルを迅速に作成。さらに、製品デザインのモックアップ作成を効率化し、時間とコストを削減しませんか?

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。