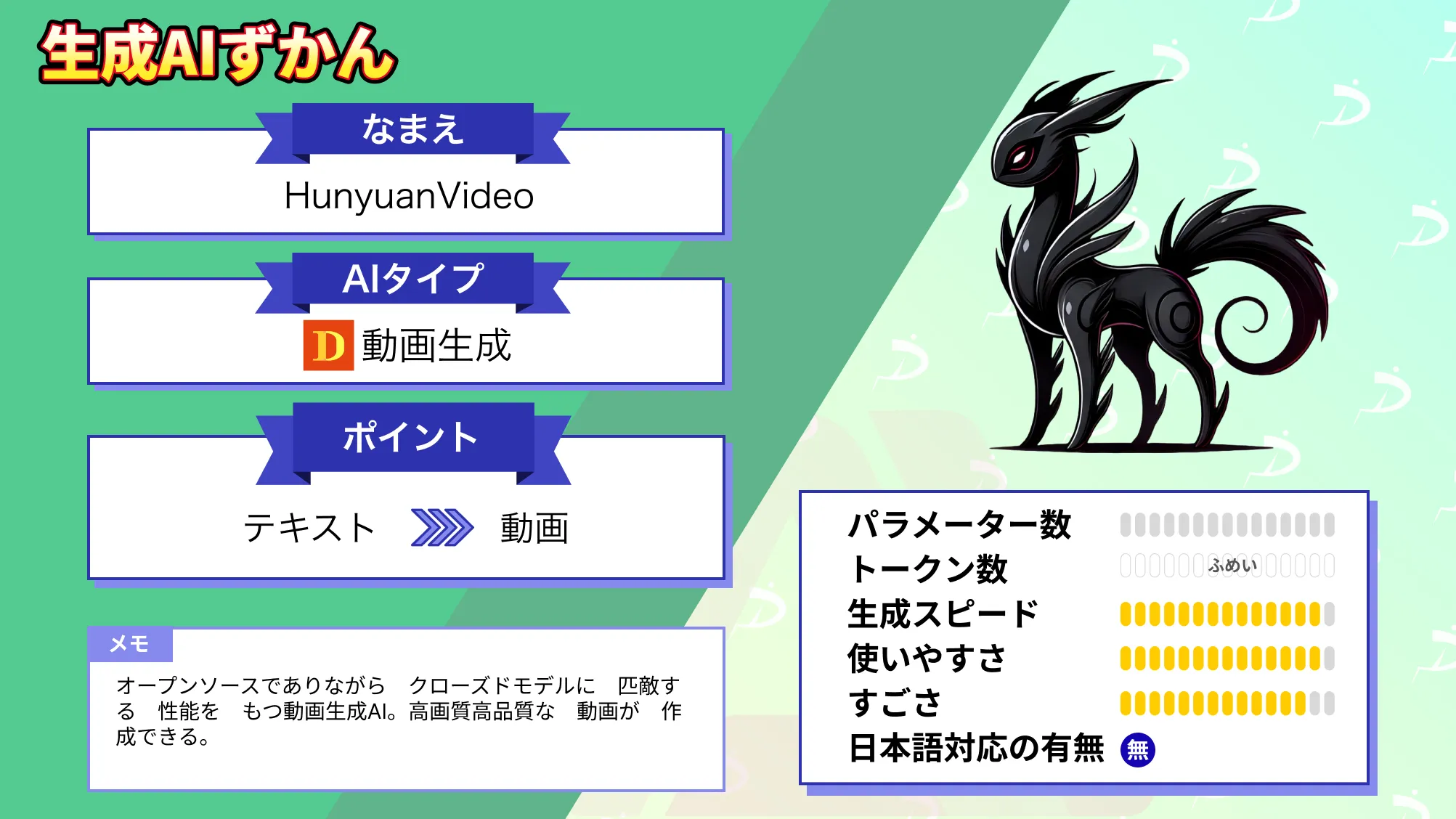

【HunyuanVideo】動画生成AI最高のパラメータ数!Tencent発の巨大オープンソース

- 動画生成AIの中でトップクラスのパラメータ数

- 物理法則遵守の動画生成

- クローズドモデルに匹敵する性能

Tencentから新たな動画生成AIが登場!

HunyuanVideoは、オープンソースで利用可能なテキストからビデオを生成するモデルの中で、現在最もパラメータ数が多く、高性能なモデルです。

約130億のパラメータを持ち、物理的な正確性とシーンの一貫性が高いビデオを生成できます。 これにより、コンセプトを具体化し、創造的な表現を促進します。

本記事では、HunyuanVideoがこれまでの動画生成AIとどう違うのか、どのように使っていくのかを解説し、リアリティの高い動画を生成できるか検証します。

最後まで読むことで、HunyuanVideoの理解が深まり活用できますので、ぜひ最後までお読みください!

\生成AIを活用して業務プロセスを自動化/

HunyuanVideoの概要

HunyuanVideoは、オープンソースで利用可能なテキストからビデオを生成するモデルの中で、最もパラメータ数が多く、高性能なモデルです。

100億のパラメータを持ち、物理的な正確性とシーンの一貫性が高いビデオを生成できます。

HunyuanVideoの特徴

HunyuanVideoの特徴はオープンソースでありながら、クローズドモデルの動画生成AIに匹敵する性能を持つ点です。

左のグラフが計算資源の使用比較であり、右の図がモデルの性能比較です。

まず、左のグラフではクローズドソースモデル(例:Gen-3やLuma1.6)は、多大な計算リソースを必要とする一方で、HunyuanVideoは効率的なリソース使用を実現していることが示されています。オープンソースの他モデルとの間に「計算資源のギャップ」が存在することも強調されています。

次に右のグラフでは、HunyuanVideoと他の代表的な動画生成AI(Runway Gen-3, Luma1.6, CNTopAなど)のパフォーマンスを「Overall Score (%)」として比較。

HunyuanVideoは、全体スコアにおいて最も高い評価を得ており、特にモーションの質で優位性を示すとされています。

それ以外にもHunyuanVideoの特徴はいくつもあります。それぞれ概要をお伝えします。

- 高画質:映画のようなビデオ品質を実現し、現実的なスタイルとバーチャルなスタイルを自由に切り替えることが可能。

- 高ダイナミクス:ダイナミックなモーションの制約を打ち破り、1つのショットで完全なアクションを表示。

- 連続アクション:豊富な表現により、一連のアクションを一度に完了。

- 芸術的なショット:単一カメラの動きを打ち破り、カメラワークをシームレスに統合することが可能。

- コンセプトの汎化:最も現実的なエフェクトを使用して、バーチャルなシーンを表現可能。

- 物理法則の遵守:物理法則に準拠することで、視聴者の違和感を軽減。

- 自然につながるシーン遷移:映画のようなストーリーテリングを実現。

- 簡単なコマンドでスムーズな作成:シンプルなコマンドでスムーズな作成が可能。

- 高度なシーンモデリング:高度なシーンモデリングが可能。

- 自然な背景の動き:自然な背景の動きを実現。

- 表情豊かで生き生きとした表情とジェスチャー: 表情豊かで生き生きとした表情とジェスチャーを表現。

- 人間の微妙な動きや表情をリアルタイムでキャプチャ: 人間の微妙な動きや表情をリアルタイムでキャプチャ。

HunyuanVideoと従来の動画生成AIとの違い

HunyuanVideoにおけるテキストエンコーダーはMultimodal Large Language Modelが採用されています。一方で従来の動画生成AIはT5 XXLであり、Multimodal Large Language Modelは高い画像テキスト整合性を持ち、HunyuanVideoが生成する動画の品質を向上させます。

また、ユーザーの指示を忠実に解釈する能力が向上し、複雑な生成タスクにも対応可能となりました。

また、HunyuanVideoで重要となるのがディフュージョンバックボーンです。

ディフュージョンバックボーンはHunyuanVideoがテキストから動画を生成する際に、テキスト情報とノイズ(初期状態の動画データ)を条件付けて処理する主要なコンポーネント。

テキスト情報を活用してノイズを動画に変換するディフュージョンプロセスを高度に最適化しており、特にデュアルストリームからシングルストリームへの設計が、効率性と生成品質を両立する重要な役割を果たします。

HunyuanVideoの進化のタイムライン

2024年12月初旬にxDiTによる並列推論のサポート

HunyuanVideoは公開当初から、分散推論エンジンである「xDiT」への対応が発表されました。xDiTは複数のGPUを連携させて、一つの動画生成タスクを分担して処理する技術です。

例えば 1枚のGPUでは時間がかかる重い処理も、複数枚のGPU(例えばRTX 4090を2枚など)があれば、数倍速く動画を書き出すことが可能です。

Diffusersライブラリへの統合を2024年12月17日に実施

HunyuanVideoは2024年12月17日にHugging Faceの標準ライブラリ「Diffusers」へ公式統合されました。

つまり世界中のAI開発者が使っている標準的なコード体系でHunyuanVideoが扱えるようになりました。HunyuanVideoを動かすのに複雑な独自環境を作らなくても、数行のPythonコードで動画生成ができるようになります。

また、 ComfyUIなどの外部ツールがHunyuanVideoをサポートしやすくなり、結果として私たちが使える便利なGUIアプリが増えました。

2024年12月18日にFP8量子化版の公開

Diffusersライブラリへの統合からわずか1日後、軽量な「FP8量子化モデル」のウェイトが公式リリースされました。

モデルの精度を維持しつつ、データの持たせ方を工夫してファイルサイズとメモリ消費量を約半分に削ったバージョンとなります。

本来48GB以上のVRAM(プロ用GPU)が望ましいHunyuanVideoの13Bモデルが、24GB(RTX 3090/4090)といった 家庭用GPUでも動くようになりました。

2025年1月13日にPenguin Video Benchmarkの公開

FP8量子化版の公開からしばらく大きなアップデートはありませんでしたが、2025年1月13日にTencent独自の評価指標「Penguin Video Benchmark」が発表されました。

これは動画生成AIの「動きの自然さ」「指示への忠実さ」「画質」を客観的に測定するためのベンチマークテストとなります。

Penguin Video Benchmarkによって「どのモデルが本当に優れているのか」が数値で分かるようになり、SoraやGen-3といったクローズドモデルと比較してもHunyuanVideoが極めて高性能であることが証明されました。

HunyuanVideoのアップデートは「最先端の技術を実装した」というものではなく、「誰でも最先端の技術を使える環境に常にアップデートしている」ことが、HunyuanVideoがこれほど支持されている最大の理由です。

HunyuanVideo 1.5が2025年11月21日に公開

HunyuanVideo 1.5 は 約8.3B(83億)パラメータ と比較的小さなサイズながら、従来モデルに迫る高品質な動画生成を実現しました。

DiT(Diffusion Transformer)ベースの効率的アーキテクチャで、家庭用GPU(14GB程度)でも動作 しやすく、テキスト→動画(T2V)と画像→動画(I2V)に対応しています。

スムーズなモーションや一貫性の高い動き、720p〜1080pクラスの出力が可能で、Diffusers・ComfyUIなどにも対応しており、扱いやすい仕様です。

ショートコンテンツの制作やプロトタイピング、クリエイティブな映像制作まで幅広い用途に利用可能です。

HunyuanVideoのライセンス

HunyuanVideoのライセンスはTencent Hunyuan Community License Agreementです。

Tencent Hunyuan Community License Agreementは特許使用以外可能と明記されていますが、細かな制約があります。

まず商用利用は可能ですが、月間アクティブユーザー数が1億人を超える場合(ライセンス対象者の全プロダクト/サービスの合計)、Tencentから別途ライセンスを取得する必要があります。また、Tencent Hunyuan Worksを商用プロダクトに利用する場合、「Powered by Tencent Hunyuan」の記載が推奨。

改変も可能ですが、改変後のモデルは「Model Derivatives」として扱われ、改変内容については「改変したこと」を明示する必要があります。また改変したモデルや派生物をTencent Hunyuan以外のAIモデルに活用することは禁止です。

配布も可能ですが、配布する際には第三者に本ライセンス契約のコピーを提供する必要があり、改変したファイルには「改変した」ことを明示する必要があります。また、配布物に「Tencent HunyuanはTencent Hunyuan Community License Agreementの下でライセンスされています」というテキストファイル(Notice)を含める必要があります。

配布する製品・サービスに「Powered by Tencent Hunyuan」と表示することを推奨。

私的利用も可能ですが、Acceptable Use Policy(適正利用ポリシー)を守ること(例:危害を加える用途や違法行為に使用しないなど)、利用地域(日本を含む)が「Territory(対象地域)」に限定されている必要があります。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | 不明 |

| 私的使用 | ⭕️ |

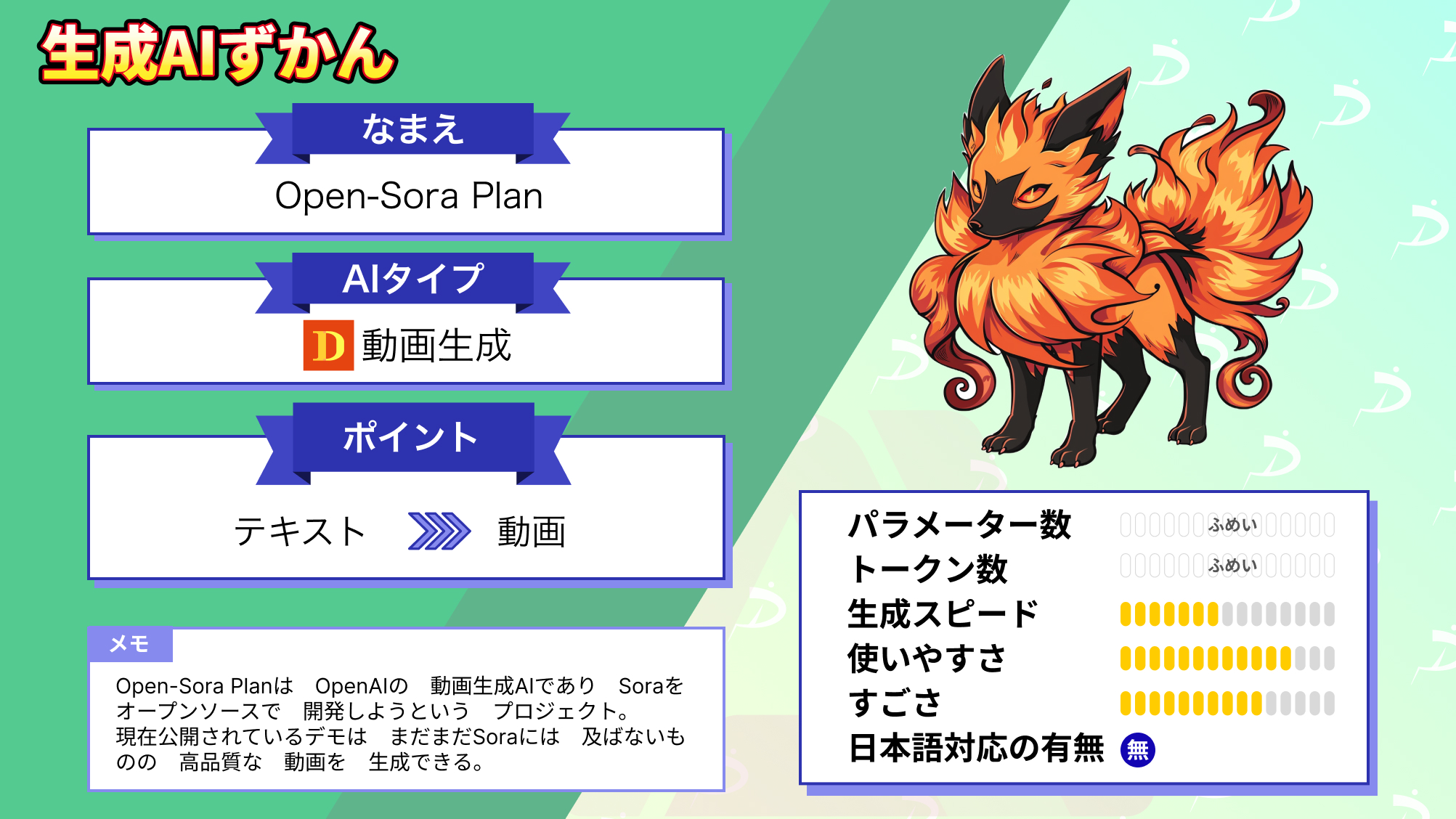

なお、1024×1024の10秒動画を生成できるOpen-Sora Planについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

HunyuanVideoと他のオープンソース動画生成AIの比較

オープンソースの動画生成AI界隈は短期間に強力なモデルが次々と登場しています。HunyuanVideoを筆頭に、主要なモデルとそれぞれの立ち位置を比較してみましょう。

| モデル名 | パラメータ数 | 得意分野・特徴 | ライセンス |

|---|---|---|---|

| HunyuanVideo | 13B / 8.3B | 長尺安定性・物理法則遵守・プロンプト忠実度が高い。 | TENCENT HUNYUAN COMMUNITY LICENSE AGREEMENT |

| Wan 2.2 | 14B / 5B | テキスト/画像→動画両対応。多言語対応・汎用性が高い。 | Apache 2.0 |

| Mochi 1 | 10B | 滑らかなモーションと自然表現に強い。テキスト理解も優秀。 | Apache 2.0 |

| CogVideoX | 5B / 2B | 汎用的な短尺の動画生成が可能。軽量でPCでも試しやすい。 | Apache 2.0 |

| LTX Video | 13B / 2B | 動画の高速生成が可能。軽量で効率的な動画合成が強み | Open Weights |

上記の通り、オープンソース動画AIは各モデルが独自の強みを持つ、いわゆる「適材適所」という時代に突入しています。

HunyuanVideoは映画のような質感と物理的な正確さで「表現の深さ」を追求する一方、Wan 2.1は圧倒的な物量と知能で総合力を、LTX-Videoは驚異的な生成速度で効率性を実現しました。

パラメータ数が高いからいい!というわけではなく、利用するPCのスペックや、リアリズム重視かスピード重視か、短尺か長尺か、というような制作目的に合わせて使い分けるのがよいでしょう。

]HunyuanVideoの使い方

ではHunyuanVideoを使っていきます。

デモが用意されているので、まずは使ってみたいという場合には、デモを使うのがおすすめです。

GitHubにはHunyuanVideoは最低でも45GBのGPU Peak Memoryが必要です。そのため、google colaboratoryのA100でも実装は難しいと思います。

HunyuanVideoモデル(バッチサイズ= 1)を実行してビデオを生成するための要件

そのため、自身のパソコンにGPUを積んでいない方もデモ版の利用が良いと思います。google colaboratoryのA100で実装をしてみましたが、モデルのダウンロードでクラッシュしたりするので、ここからはreplicateを使った使い方は解説します。

HunyuanVideoのデモ版の使い方

HunyuanVideoのデモはreplicateで提供されているので、サインアップもしくはログインすればOKです。

prompt、width、height、video_length、infer_steps、seedをそれぞれ入力すればOKです。

- prompt:動画の内容を指示。

- width:動画の横方向の解像度。

- height:動画の縦方向の解像度。

- video_length:動画のフレーム数を指定。

- infer_steps:推論プロセス(サンプリング)でのステップ数を指定。

- seed:再現性を確保するための乱数シード値。同じシード値を使えば同じ動画を生成。

プロンプトを「A dog walks on the grass, realistic style.」にして生成した動画が以下です。

かなりリアルに生成されていると思います。

replicate APIを使った実装

replicate APIを使った実装方法も記載されているので、google colaboratoryで実装してみます。

APIを使った実装はこちら

import replicate

import os

os.environ["REPLICATE_API_TOKEN"] = "your_API_Key"

# モデルの最新バージョンを取得して確認

model = replicate.models.get("tencent/hunyuan-video")

version = model.latest_version

print("Latest version ID:", version.id)

# 入力パラメータの設定

input_params = {

"prompt": "A cat walks on the grass, realistic style.",

"width": 854,

"height": 480,

"video_length": 129,

"infer_steps": 50,

"flow_shift": 7,

"embedded_guidance_scale": 6

}

# バージョンIDを含めて実行

model_path = f"tencent/hunyuan-video:{version.id}"

print("Using model path:", model_path)

# モデルの実行

output = replicate.run(

model_path,

input=input_params

)

# 出力の保存

with open("output.mp4", "wb") as file:

file.write(output.read())上記のコードを実行することで、output.mp4という動画が生成されるので、ダウンロードすればOKです。

実際に生成された動画はこちら。

HunyuanVideoで生成できる動画はリアリティが高いのかを検証

HunyuanVideoはオープンソースでありながら、クローズドモデルに匹敵する性能を持っています。また、物理法則を遵守し、高画質な動画生成が可能です。

そこで、HunyuanVideoで生成できる動画はリアリティが高いのか・物理法則を遵守するのか検証してみたいと思います。

また、他の動画生成AIと生成された動画を比較するために、同じプロンプトで動画を生成してみたいと思います。

タスクとしては次の3つです。

- 物理法則を遵守する動画生成

- OpenAI Soraと比較

- ビールのCM動画生成

物理法則を遵守する動画生成

まずは物理法則を遵守する動画を生成していきます。

プロンプトはこちらです。

A red ball rolls down a slope, accelerates naturally due to gravity, and comes to rest on a flat surface, realistic style.

和訳:赤いボールが斜面を転がり、重力によって自然に加速し、平らな面に静止するリアルなスタイル。

こちらのプロンプトでボールの加速や減速が自然に描写されるか、平坦な面で静止する動きが正しいか検証してみたいと思います。

加速はされていますが、減速はされていない印象です。また、後半になると地面からボールが浮き上がっており、物理法則を無視しているような気がします。

OpenAI Soraと比較

次にOpenAI Soraで作られている動画と同じプロンプトで動画を生成してみます。OpenAI Soraで作られている動画はこちらを参考にします。

A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about.

和訳:暖かく光るネオンとアニメーションの街の看板で埋め尽くされた東京の通りを歩くスタイリッシュな女性。黒いレザージャケットに赤いロングドレス、黒いブーツを履き、黒い財布を持っている。サングラスに赤い口紅。彼女は自信に満ち、さりげなく歩いている。通りは湿っていて反射し、色とりどりのライトの鏡のような効果を生み出している。多くの歩行者が歩いている。

HunyuanVideoに最適化したプロンプトではないからでしょうか。パッとみただけでAIで生成された動画、というのがわかる動画かと思います。

ビールのCM動画生成

最後にビールのCM動画を生成してみたいと思います。入力するプロンプトは以下です。

A cold glass of beer with golden liquid and a perfect frothy head placed on a wooden table, surrounded by soft golden light. Slow motion bubbles rising in the glass as condensation forms on the surface. A tagline appears: ‘Crafted to Perfection.’

和訳:木製のテーブルの上に置かれた、黄金色の液体と完璧な泡立ちを持つ冷たいグラスのビール。グラスの表面に結露が生じ、泡が立ち上がるスローモーション。「Crafted to Perfection」というキャッチフレーズが表示される。

キャッチフレーズが表示されるようプロンプトを与えましたが、それは遵守されませんでした。しかし、液体の流れとしての物理法則は遵守されています。

なお、高品質動画を効率的に作成する方法とGoogle Colabでの実装について詳しく知りたい方は、下記の記事を合わせてご確認ください。

HunyuanVideoのよくある質問

まとめ

本記事ではHunyuanVideoについて解説し、実際の使い方について紹介をしました。オープンソースでありながらクローズドモデルに匹敵する性能を持つのは本当でした。

HunyuanVideoで生成される動画はどれも高画質でありリアリティにあふれ、非常にクオリティの高いものばかりです。今後はHunyuanVideoを使ったショート動画や映画などさまざまな場面で使われることが予想できますね。

ぜひ皆さんも本記事を参考にHunyuanVideoを使ってみてください。

最後に

いかがだったでしょうか?

生成AIで貴社のビジネス課題を解決し、効率的かつ高品質な成果を実現。最新テクノロジーの導入で競争優位を築きましょう。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。