【Llama 4 Scout】巨大モデル並みの知識容量を実現する小型モデル!?MetaのLLMを徹底解説

- マルチモーダル対応の最新大規模言語モデル

- Llama 4シリーズの中で「小型モデル」として位置づけられている

- 「MoE方式」により、計算効率を保ちながら巨大モデル並みの知識容量を実現

2025年4月6日、Meta社はオープンソースの新たな大規模言語モデル「Llama 4シリーズ」をリリースしました。

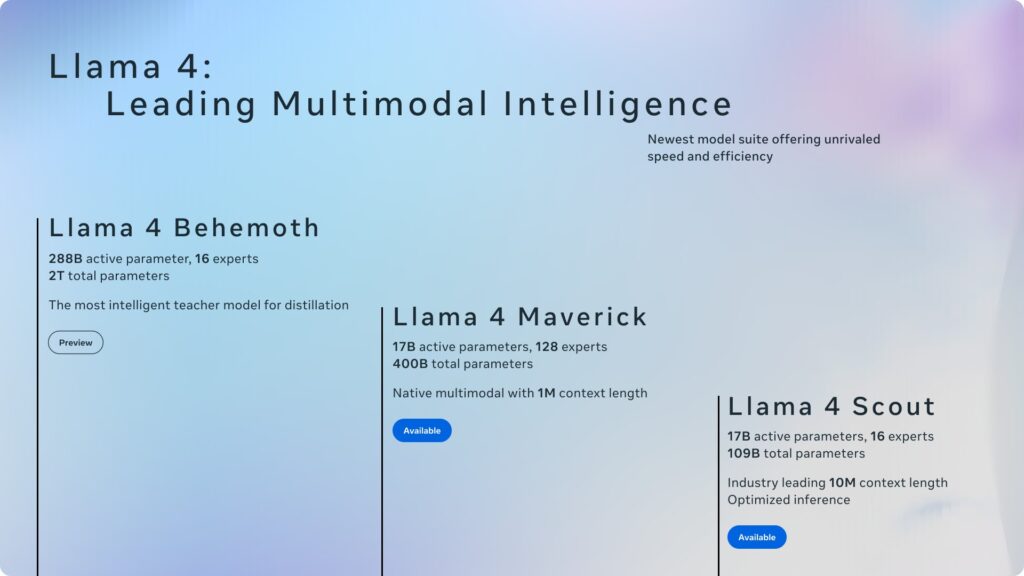

「Llama 4シリーズ」には、大型のLlama 4 Maverickや、小型のLlama 4 Scout、開発中のLlama Behemothが含まれており、本記事では小型モデル「Llama 4 Scout」についてご紹介します。

概要や仕組み、料金プランや使い方まで徹底的に解説しますので、ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

Llama 4 Scoutとは?概要・特徴を解説

Llama 4 Scoutは、Meta社が公開したLlama 4ファミリーの一角をなす最新の大規模言語モデルであり、オープンソースで提供される高度なモデルです。

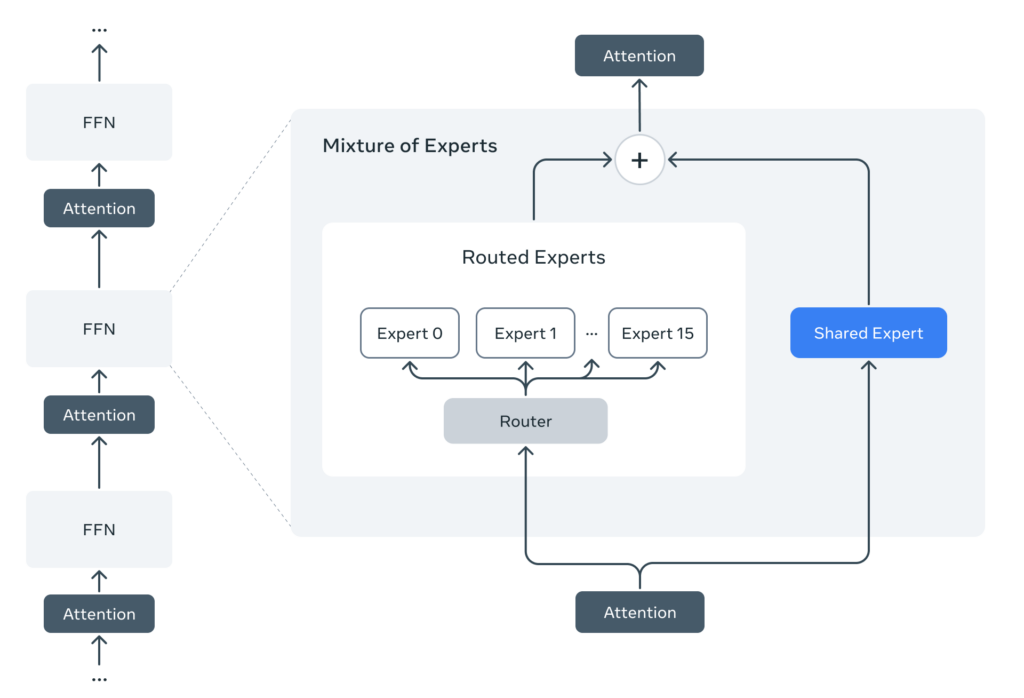

Llama 4ファミリーの中でもLlama 4 Scoutは、小型モデルながら、内部に16個のエキスパートモデルを持つ「Mixture-of-Experts(MoE)」構造を採用しており、合計で1,090億パラメータ規模という大容量を実現しています。

この「Mixture-of-Experts(MoE)」方式により、推論時には必要な一部のパラメータ(約170億)だけが使われ、計算効率を保ちながら巨大モデル並みの知識容量を実現しています。

さらに、テキストと画像の双方を入力として処理できるマルチモーダル対応であり、入力層でテキストと画像トークンを統合して処理する設計になっています。マルチモーダル対応により、画像に関する質問応答や描写などもテキストと同様にこなすことができるようになっているようです。

また、コンテキスト長は、Llama 3世代の約12.8万トークンから1,000万トークンへ拡張されており、既存モデルの中でもトップレベルの長さに伸びています。

1,000万トークンは、テキスト換算すると、数千ページにも及ぶ長文を一気にモデルに与えるレベル感のボリュームで、「長文ドキュメントの分析」や「複数文書の一括処理」などの新たなユースケースの実現が可能になったといえます。

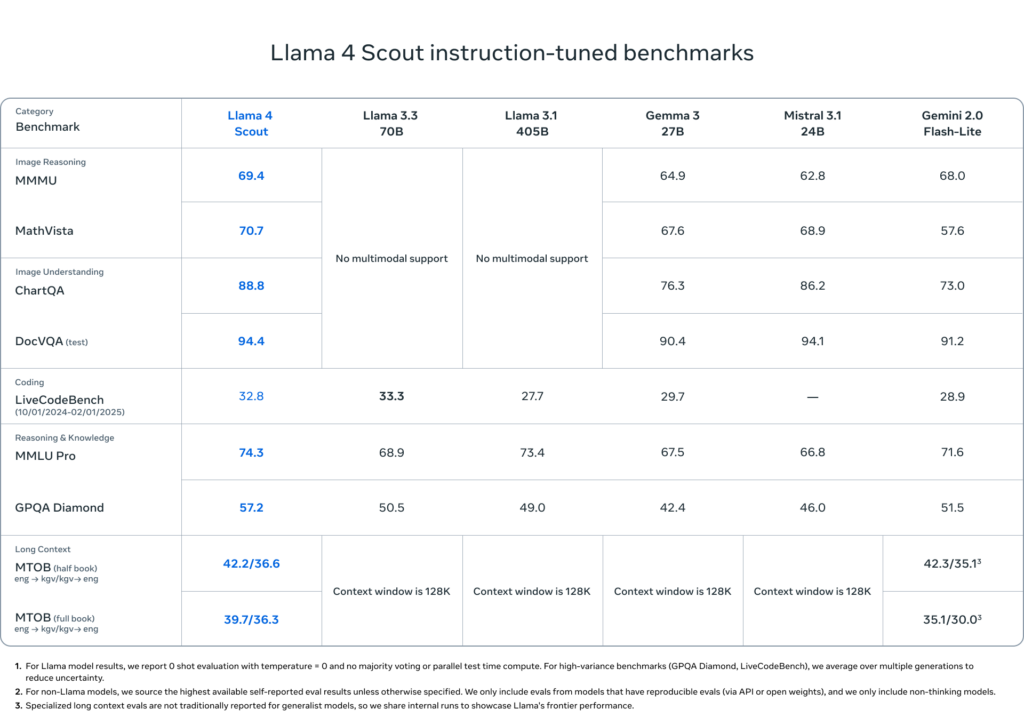

Llama 4 Scoutは小型モデルでありながら、同サイズの既存モデルと比較しても最高水準の性能を有しており、推論・要約・指示などの標準ベンチマークにおいて、GoogleのGemma 3やMistral 3.1といった他社オープンモデルを上回っていると報告されています。

なお、Meta社が開発した音声とテキストを融合したマルチモーダルAIについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Llama 4 Scoutができること

Llama 4 Scoutができることは多岐にわたりますが、ここでは代表的なものを5つピックアップします。

高度な対話・テキスト生成

Llama 4 Scoutは、指示調整が施されたモデルであり、人間のプロンプトに沿った自然な対話や文章生成を得意とします。

例えば、ユーザーの質問に回答したり、要約・翻訳・創作など、ChatGPTのようなAIアシスタント的な振る舞いが可能です。Meta社によると、Llama 4 Scoutは同程度の小型モデルの中で世界トップクラスの性能を有し、推論、文章要約、指示への応答正確性などで他のオープンモデルを凌駕しているとされています。

実際に、標準知識評価のMMLU Proベンチマークでも、Llama 4 Scoutは前世代のLlama 3 70Bモデルと同等以上の正答率を記録しています。

長文解析・要約

Scout最大の強みの1つとして、長い文脈を扱えることが挙げられます。従来のモデルでは困難だった「マルチドキュメント要約」や「膨大なログや議事録の分析」を実現することができます

例えば、数100ページにも及ぶ報告書を丸ごと与えて要約を生成したり、膨大なチャット履歴を踏まえて質問に答えることができます。

Micro Soft Azureの発表(※1)によると、「Llama 4 Scoutは、長い文脈と効率的なモデルサイズを活かし、大量の情報を要約・分析するタスクで特に威力を発揮するよう設計されている」と報告されており、実際のユースケースとして、複数のドキュメントから共通点と相違点を抜き出す比較要約や、ユーザーの長期間の行動ログを解析してパーソナライズされた提案を行うことなどが挙げられています。

画像認識・説明

マルチモーダル対応により、Llama 4 Scoutは画像や図表を理解し説明することもできます。

例えば、「写真の内容描写」、「チャートやグラフから読み取れる情報の要約」、「図に関する質問応答」、「書類画像中のテキスト読解と内容回答」などが可能となっています。

実際に、与えられた画像内の表を読み取り質問に答える「ChartQAベンチマーク」において、83.4%の精度、書類画像から質問への正答率を測る「DocVQAベンチマーク」では、89.4%という高いスコアを記録しています。

これは、Llama 4 Scoutが、視覚情報とテキスト情報を統合して推論できる力を示しており、単に画像キャプション生成だけでなく、画像を用いた高度な推論(例えば「このレントゲン写真と診療記録から患者の診断は何と考えられるか」など)にも応用が期待されます。

コード生成・理解

Llama 4 Scoutはテキスト・ビジョン両対応モデルですが、コーディング知識も搭載されています。

例えば、プログラミングに関する質問に答えたり、コードスニペットのバグを指摘・修正したり、新しいコードを書いたりすることも可能です。

公式ベンチマークでも、Llama 4 Scoutは、競技プログラミング問題集「MBPP」におけるコード正解率で、約67.8%を達成し、前世代のLlama 3 70Bモデルの約66.4%を上回っています。

ただし、コード生成や高度な論理推論に関しては、同時リリースされたLlama 4 Maverickの方が高性能であり、Llama 4 Scoutはどちらかというと、対話や要約、画像理解といった汎用タスクにバランス良く対応できるよう設計されています。

多言語対応

Llama 4 Scoutは、多言語に対応するよう訓練されており、英語以外にも12言語以上で高品質なテキスト生成が可能です。

事前学習では200もの言語を含む大規模なデータセットを使用され、日本語を含む主要言語であれば自然な文章生成や質問応答を行えます。Meta社のモデルカード(※2)によれば、アラビア語、ウルドゥー語、スペイン語、中国語などで大きく性能が改善されているとのこと。これにより、Llama 4 Scoutは、多言語のチャットボットや翻訳補助などグローバルな用途にも適しています。

以上のように、Llama 4 Scoutは、チャット対話から長文要約、画像解析、プログラミング支援、多言語対応まで幅広いタスクをこなせるオールラウンドなモデルです。

その性能水準は、分野によっては既存のGPT-4やClaudeなどの巨大モデルにも匹敵しうるとされ、非常に注目度の高いオープンソースモデルとなっています。

Llama 4 Scoutのライセンスと商用利用について

Llama 4 ScoutはMeta社独自のLlama 4 コミュニティ・ライセンスで提供されています。

オープンソースに近い形ではありますが、いくつかの条件や制限が設けられていますので、以下の表で整理しましょう。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | ⭕️ | 基本的に個人・中小規模法人の利用は許可されているが、月間アクティブユーザ700万人超の大規模サービス企業は、Meta社から特別ライセンス許諾を得る必要あり。 |

| 改変 | ⭕️ | |

| 配布 | ⭕️ | 同じLlama 4コミュニティライセンスの下で配布し、ライセンスおよび利用規約の存在をユーザーに明示することが求められる。 |

| 特許使用 | ⭕️ | |

| 私的使用 | ⭕️ | デモ等を公開する際は、「Built with Llama(Llama搭載)」といった帰属表示が必要。 |

以上、まとめると「研究者や企業が幅広く利用・改変できるが、巨大IT企業や一部の国では制限あり」というライセンスになっています。

ライセンス利用する際は、公式ドキュメントやFAQを確認するようにしましょう!

Llama 4 Scoutの料金プラン

Llama 4 Scoutの料金プランを利用環境ごとに整理します。詳細は以下の表の通りです。

| 項目 | 内容 | 備考 |

|---|---|---|

| モデル利用料 | 無料 | Metaのライセンス同意後、モデル本体は無償でダウンロード可能。 |

| 自己ホスト環境コスト | GPU:80GB以上推奨(例:NVIDIA H100) CPU:数百GB RAM推奨(非推奨) | モデル本体は約40GB、量子化によりさらに軽量化可。 |

| Google Colabでの実行 | Colab Pro/Pro+:A100(40GB)使用可、月額$9.99~$49.99程度 | 高速推論には有料プラン+高RAM GPUインスタンス推奨。 |

| クラウドAPI利用(例:Groq) | 入力:$0.11/100万トークン 出力:$0.34/100万トークン 合計:約$0.13/100万トークン | GPT-4比で約1/10のコスト。用途により従量課金。 OpenRouterやTogetherでも利用可能。 |

| 量子化版(4bit/8bit) | コミュニティ作成版が無料で入手可(Hugging Faceなど) | 小規模GPU(24GB~)やCPU環境でも動作可能になるが精度劣化あり。 |

どのプラットフォームで動かすか・どの精度で運用するかによりコストは変動するので、ご自身のユースケースに合わせて利用方法を選定することをおすすめします。

Llama 4 Scoutの使い方(Hugging Face・Google Colab編)

Hugging Face Spaceを用いた使い方

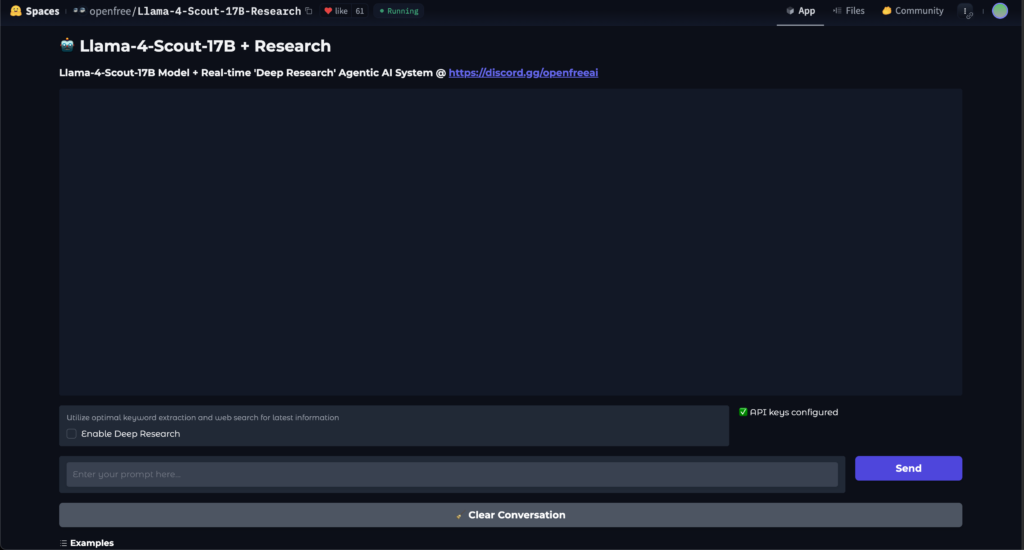

Hugging Face Hubで、Llama 4 Scoutのモデル重みが公開されており、コミュニティがデモ用のSpaceを公開しています。これにより、ブラウザ上のインタラクティブなUIでモデルを試すことができます。

2025年4月7日時点で、「openfree/Llama-4-Scout-17B-Research」というコミュニティSpaceが公開されており、チャット形式でLlama 4 Scoutモデルを試すことができます(このSpaceでは内部でエージェント機能なども付加されているようです)。

試しに簡単なタスクを3つ実行してみます。

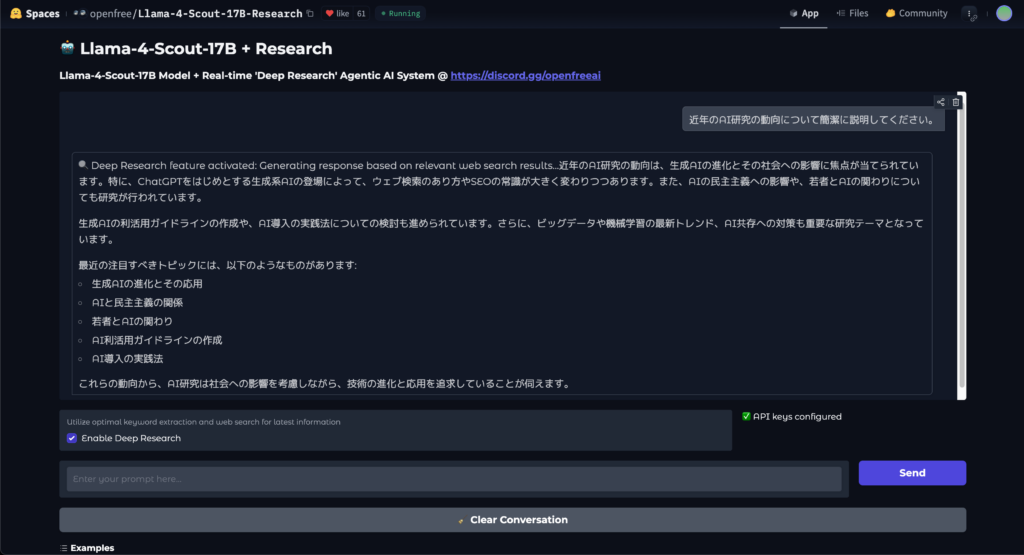

プロンプト①

"近年のAI研究の動向について簡潔に説明してください。"結果①

“近年の研究の動向としては、ディープラーニングを用いた画像認識や自然言語処理などの技術が大きく進展しています。また、強化学習やマルチエージェントシステムなどの研究も活発に行われています。さらに、AIの倫理や安全性に関する研究も重要視されています。”

プロンプト②

"近年のAI研究の動向について簡潔に説明してください。"

※本Spaceに搭載されているDeep Research機能を有効にして実行結果②

“Deep Research feature activated: Generating response based on relevant web search results…近年のAI研究の動向は、生成AIの進化とその社会への影響に焦点が当てられています。特に、ChatGPTをはじめとする生成系AIの登場によって、ウェブ検索のあり方やSEOの常識が大きく変わりつつあります。また、AIの民主主義への影響や、若者とAIの関わりについても研究が行われています。

生成AIの利活用ガイドラインの作成や、AI導入の実践法についての検討も進められています。さらに、ビッグデータや機械学習の最新トレンド、AI共存への対策も重要な研究テーマとなっています。

最近の注目すべきトピックには、以下のようなものがあります:

生成AIの進化とその応用

AIと民主主義の関係

若者とAIの関わり

AI利活用ガイドラインの作成

AI導入の実践法

これらの動向から、AI研究は社会への影響を考慮しながら、技術の進化と応用を追求していることが伺えます。”

プロンプト③

"特定の範囲内の素数を求めるPython関数を書いて。"

※本Spaceに搭載されているDeep Research機能を有効にして実行結果③

“Deep Research feature activated: Generating response based on relevant web search results…特定の範囲内の素数を求めるPython関数を以下に示します。

エラトステネスの篩を使用した素数生成

def generate_primes(start, end):

“””

特定の範囲内の素数を生成する関数。

Args:

start (int): 範囲の開始値。

end (int): 範囲の終了値。

Returns:

list: 範囲内の素数のリスト。

"""

sieve = [True] * (end + 1)

sieve[0:2] = [False, False] # 0と1は素数ではない

for current_prime in range(2, int(end ** 0.5) + 1):

if sieve[current_prime]:

for multiple in range(current_prime * current_prime, end + 1, current_prime):

sieve[multiple] = False

return [num for num, is_prime in enumerate(sieve) if is_prime and start <= num <= end]start_range = 1

end_range = 100

primes = generate_primes(start_range, end_range)

print(f”{start_range}から{end_range}までの素数: {primes}”)

この関数generate_primesは、指定された範囲startからendまでの素数を生成します。エラトステネスの篩アルゴリズムを使用して、効率的に素数を検索します。

簡略化された素数判定を使用した方法

よりシンプルな方法として、素数判定用のヘルパー関数を使用することもできます。

def is_prime(n):

“””

素数かどうかを判定するヘルパー関数。

Args:

n (int): 判定対象の数。

Returns:

bool: 素数であればTrue、そうでなければFalse。

"""

if n <= 1:

return False

if n == 2:

return True

if n % 2 == 0:

return False

max_divisor = int(n**0.5) + 1

for d in range(3, max_divisor, 2):

if n % d == 0:

return False

return Truedef generate_primes_simple(start, end):

“””

範囲内の素数を生成する関数(簡略化版)。

Args:

start (int): 範囲の開始値。

end (int): 範囲の終了値。

Returns:

list: 範囲内の素数のリスト。

"""

return [n for n in range(start, end + 1) if is_prime(n)]start_range = 1

end_range = 100

primes_simple = generate_primes_simple(start_range, end_range)

print(f”{start_range}から{end_range}までの素数(簡略版): {primes_simple}”)

こちらの方法はより直感的で理解しやすいですが、特に大きな範囲に対してはエラトステネスの篩を使用した方法の方が効率的です。”

Google Colabを用いた使い方

ここからは、Llama 4 ScoutをGoogle Colaboratoryで実装するためのフローをご紹介します。Llama 4 Scoutの使い方はHugging Faceで提供されており、比較的簡単に試すことができます。

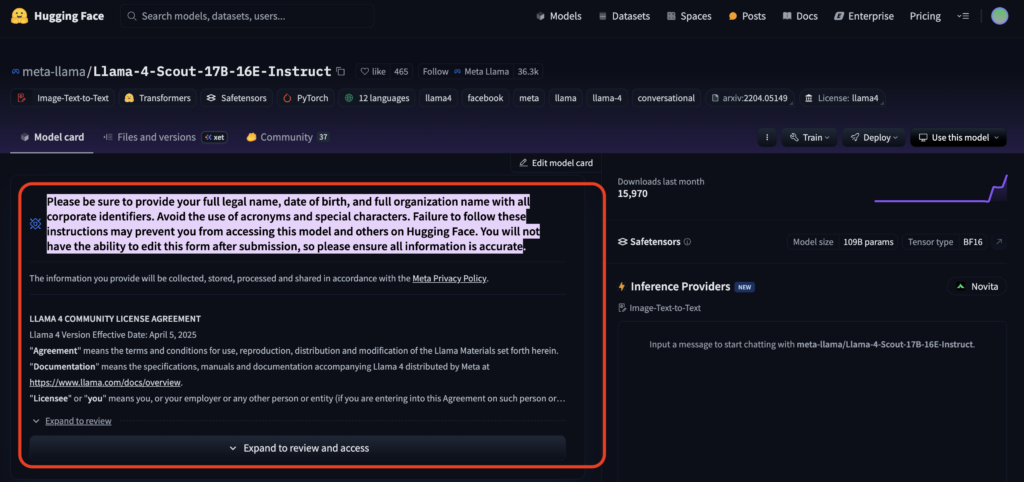

以下画像の赤枠内「Expand to review and access」をクリックすると利用申請フォームが表示されるので、氏名や所属などの必要事項を入力して申請しましょう。

申請が承認されると、以下画像のようなメールが届きます。Lllama 4コミュニティのダウンロードアクセス権が付与されるので、 以降は自分の環境にモデルをダウンロードするか、クラウド上で読み込んで使用するようにしましょう。

申請承認後、Hugging Faceアクセストークンを取得します。プロフィール→Settings→Access Tokensタブ→New tokenでトークンを作成&コピーしましょう。スコープはreadで問題ありません。

Google Colabでトークン認証するには以下コードを実行します。

from huggingface_hub import login

# 発行したアクセストークンを貼り付けてください

login("hf_XXXXXXXXXXXXXXXXXXXXXXXXXXXX")Llama 4 Scoutを動かすには、PythonのTransformersライブラリ(バージョン4.51.0以上)が必要です。

GPUを用いる場合は、CUDA対応環境と充分なVRAMメモリを準備しましょう。

Google Colabを用いる場合は、無料板でも動かなくはないですがモデルサイズが大きいため、有料版でA100 GPU以上を選ぶと快適に動かすことができるかと思います。

以下、Google Colabにて実装していきます。

# Transformersを最新板にアップグレード

!pip install --upgrade git+https://github.com/huggingface/transformers.git# モデルのロード

from transformers import pipeline

import torch

model_id = "meta-llama/Llama-4-Scout-17B-16E-Instruct"

pipe = pipeline(

"text-generation",

model=model_id,

device_map="auto",

torch_dtype=torch.bfloat16,

)上記コードで、Hugging Face上のLlama 4 Scoutモデル(Instruct版)を自動的にダウンロードしてロードします。device_map=”auto”を指定するとGPUがある場合自動で割り当て、ない場合CPUでロードします。ただしCPUのみだとメモリや速度の点で厳しいため、GPU環境を推奨します。

モデルをロードできたら、pipeを使ってテキスト生成することができます。

プロンプト例

prompt = "近年のAI研究の動向について簡潔に説明してください。"

result = pipe(prompt, max_new_tokens=200)

print(result[0]['generated_text'])このように入力プロンプトを与え、max_new_tokensで生成させるトークン数の上限を指定して実行すると、モデルからの応答テキストが得られます。Instructモデルの場合、プロンプトに対する丁寧な回答や指示に沿った出力が生成されます。上記例ではAI研究動向に関する要約説明が日本語で返ってきます。

続いて、画像入力は以下のような手順で試すことができます。

from PIL import Image

from transformers import AutoProcessor, AutoModelForVisionText2Text

processor = AutoProcessor.from_pretrained(model_id)

model_v = AutoModelForVisionText2Text.from_pretrained(model_id, device_map="auto", torch_dtype=torch.bfloat16)

image = Image.open("chart.png")

question = "このグラフから分かる要点を教えてください。"

inputs = processor(images=image, text=question, return_tensors="pt").to(model_v.device)

outputs = model_v.generate(**inputs, max_new_tokens=100)

response = processor.batch_decode(outputs, skip_special_tokens=True)[0]

print(response)上記コードのように、AutoProcessorで画像とテキストのペア入力を処理し、AutoModelForVisionText2Textでモデルをロードしてからgenerateを呼ぶことで、画像+テキストの複合入力に対する回答を得られます。

例えば、chart.pngに折れ線グラフが描かれていれば、その内容を読み取って要点を説明する文章が出力されます。

その他の使い方として、Llama 4 Scoutは、対話用途にも対応しており、メッセージ履歴を与えてチャットボットを実装することも可能です。

Hugging Faceのモデルカードでは、対話テンプレートを適用する例が紹介されています。また、LangChainなどの高レベルフレームワークでLlama 4 Scoutを組み込んでツール駆動型のエージェントを構築することもできます。

まとめ

改めて最後に、Llama 4 Scoutの特徴をおさらいします。

- Llama 4ファミリーの一角をなす大規模言語モデル

- 同サイズの既存モデルと比較しても最高水準の性能を誇る

- Meta社独自のLlama 4 コミュニティ・ライセンスで提供

- モデル自体は無料で利用可能

- Hugging Faceで使い方が提供されており、比較的簡単に試行可能

Llama 4 Scoutは「小さなリソースで大きな仕事を成し遂げる」、次世代の汎用AIモデルです。その導入により、これまで困難だった長文処理やマルチモーダル対話が可能となり、AI活用の可能性がさらに広がります。ユースケースに応じて、適材適所でLlama 4 Scoutを活用することで大きなメリットが得られると思いますので、ぜひ試してみてください!

最後に

いかがだったでしょうか?

Llama 4 ScoutはLlama 4シリーズで最も軽量でコスト効率に優れたモデルです。また、オープンソースの特徴を活かすことで、企業ごとに適したモデルに改良することも可能に。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。