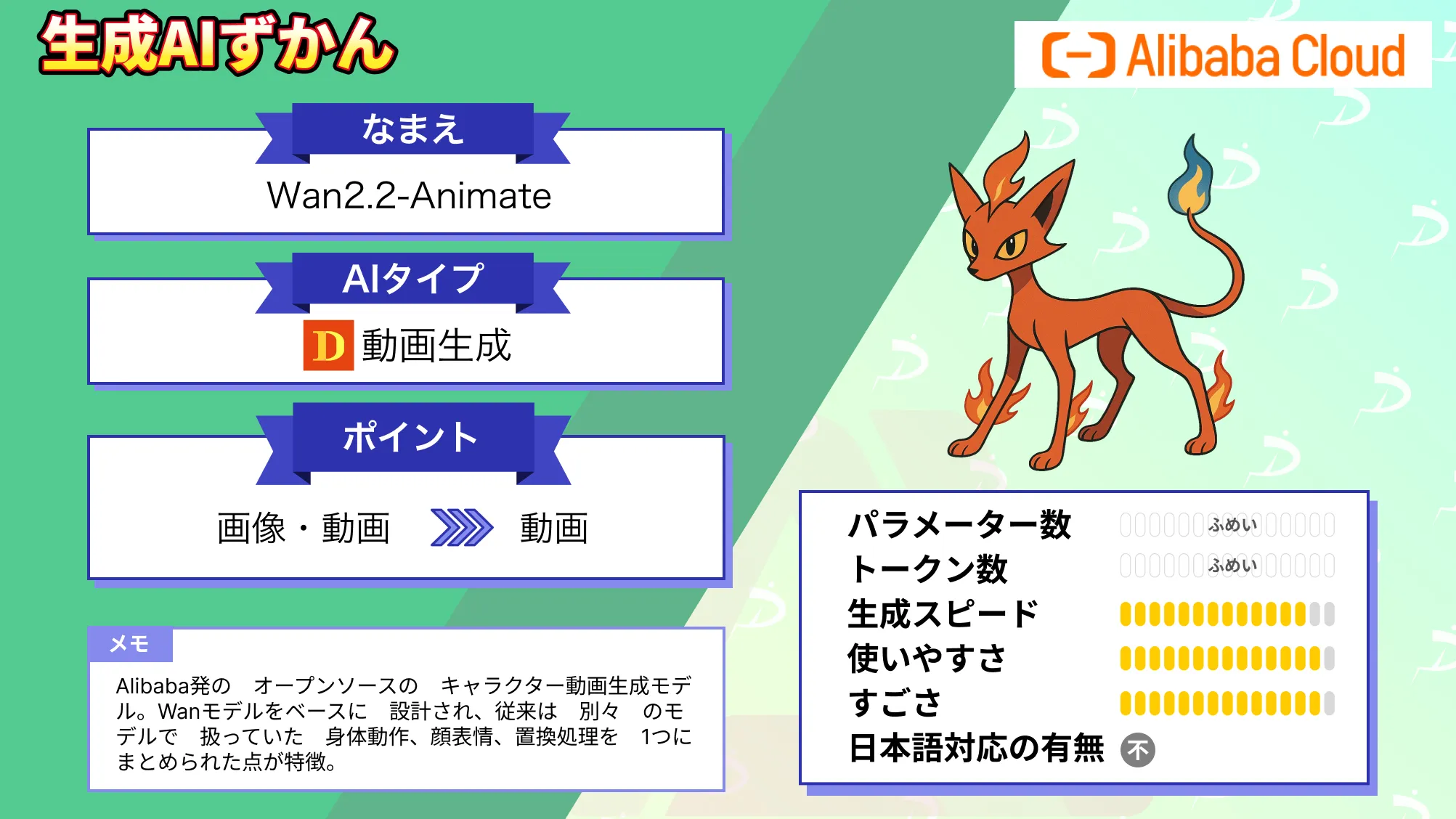

【Wan2.2-Animate】Alibaba発キャラクター動画生成AI!性能・ライセンス・使い方・Wan2.1との違いを徹底解説

- Alibaba発のオープンソースのキャラクター動画生成モデル

- Wanモデルをベースに設計され、従来は別々のモデルで扱っていた身体動作、顔表情、置換処理を1つにまとめられた点が特徴

- Apache 2.0ライセンスで公開され、商用利用なども可能

Wan2.2-Animateは、AlibabaのTongyi Wanxiangチームが2025年9月にリリースした、オープンソースのキャラクター動画生成モデルです。

Wan2.2-Animateは、静止画と動画を入力として、静止画の人物が動画の動きや表情を忠実に再現する「モーション模倣」、および動画中のキャラクターを静止画の人物に置き換える「キャラクター置換」の機能が備わっています。

従来の類似ツールと比べて、人物の識別性や映像品質が向上していて、空間的に整列した骨格情報と顔の特徴量を統合することで、より自然な動作を生成することが可能です。

本記事では、Wan2.2-Animateの性能や従来モデルとの違い、使い方まで徹底的に解説します。

ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Wan2.2-Animateの概要

Wan2.2-Animateは、画像と動画から高品質なキャラクター動画を生成する統合フレームワークです。

入力として与えたキャラクター画像と参照動画から、参照動画の人物の表情や動作を精密に再現したアニメーション動画を生成します。置換モードでは、生成したキャラクター映像を参照動画に挿入し、照明や色調を元動画に合わせてシームレスに合成します。

Wan2.2-Animateは、Wanモデルをベースに設計され、従来は別々のモデルで扱っていた身体動作、顔表情、置換処理を1つにまとめた点が特徴的です。実験では最先端の性能も出ているようで、学術的・産業的なベンチマークで従来モデルを上回る結果を達成しています。

Wan2.2ファミリーの中でのWan2.2-Animateの位置づけ

| モデル名 | 入力 → 出力 | 主な用途・特徴 |

|---|---|---|

| Wan2.2-T2V | テキスト → 動画 | テキスト指示から動画を生成する基本モデル。構図や動きの再現性が高い。 |

| Wan2.2-I2V | 画像 → 動画 | 静止画を元に自然なモーションを付与。フレーム間の一貫性に強み。 |

| Wan2.2-TI2V | テキスト/画像 → 動画 | テキストと画像を組み合わせた動画生成に対応。柔軟な入力が可能。 |

| Wan2.2-S2V-14B | 音声 → 動画 | 音声(発話・歌唱など)を元に人物やキャラクターを動かす音声駆動型モデル。 |

| Wan2.2-Animate | 動画/画像 → 動画 | 既存動画の動作をキャラクターに転写したり、人物を別キャラに置換する編集特化モデル。 |

Wan2.2は、テキスト・画像・音声といった多様な入力から動画を生成する複数のモデルで構成された動画生成ファミリーです。

その中でWan2.2-Animateは、新規生成を主目的とするT2VやI2Vとは異なり、既存動画のモーションを活かしてキャラクターを動かしたり、人物を別キャラクターに置き換える「編集寄り」の役割を担っています。

キャラクターアニメーションや実写動画のキャラ差し替えなど、後処理・演出用途に強いのが特徴です。

Wan2.1との違い

Wan2.2-Animateは、Wan2.1系のモデル基盤をベースにしつつ、キャラクターアニメーションとキャラクター置換を1つのモデルで統合した点が最大の特徴でWan2.1系との違いです。公式情報において、この2つのモードを1つのモデルで扱うことができる設計だと紹介されています。

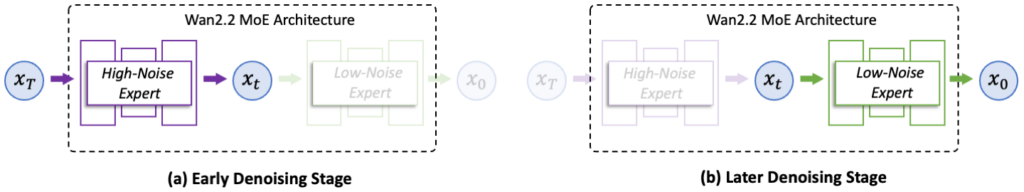

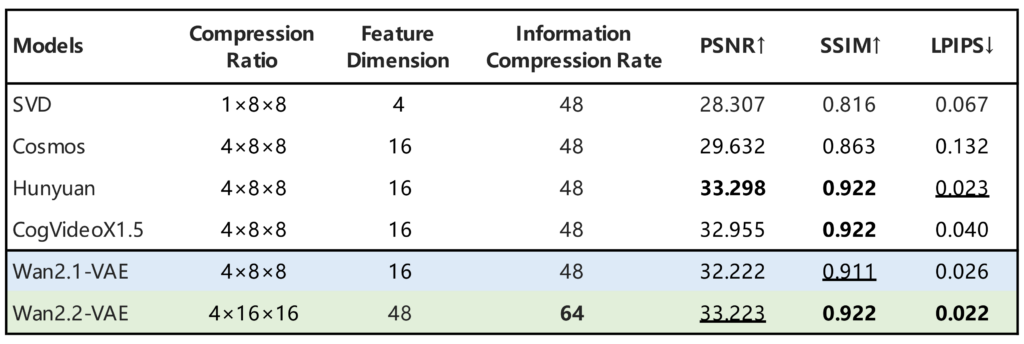

さらに、Wan2.2-Animateでは、Mixture-of-Experts(MoE)を拡張した拡散モデル設計、照明・構図・色調などのデータの導入、そして学習データの規模を大幅に増やした(画像が+65.6%/動画が+83.2%)と公表されていて、動きや意味理解、画作りの性能がかなり上がっているようです。

結果的に、高性能な動作・表情の追従と一貫した見た目のキープ力を、2.1よりもコスパ高く実現できるようになっています。

なお、Wan2.1について詳しく知りたい方は、以下の記事も参考にしてみてください。

Wan2.2-Animateの性能

Wan2.2-Animateは、各種評価指標で高い性能を発揮しています。構造類似度のSSIMやLPIPS、動画品質評価指標のFVDなどで、従来のオープンソースモデル(Animate AnyoneやVACEなど)を上回る結果が報告されています。

また、ByteDanceのDreamActor-M1やRunwayのAct-Twoといった商用モデルと比べても、同等以上の性能を誇っていることが確認されています。

動作の再現精度や顔の一貫性、表情の自然さにおいて優れた結果を得ており、滑らかかつリアルなアニメーションを生成できるとのこと。さらに、720p@24fpsの動画生成に対応した軽量版モデルの提供もされていて、高解像度かつ高速な生成にも配慮されています。

Wan2.2-Animateのライセンス

Wan2.2-Animateは、Apache 2.0ライセンスで公開されていて、商用利用・改変・再配布・特許利用・私的利用のすべてが許可されています。Apache 2.0ライセンスはオープンな条件で利用を認められているライセンスです

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | ⭕️ | |

| 改変 | ⭕️ | |

| 配布 | ⭕️ | |

| 特許使用 | ⭕️ | |

| 私的使用 | ⭕️ |

Wan2.2-AnimateはApache 2.0ライセンスのもと、商用利用を含めて幅広い用途で利用できますが、生成物の内容や利用方法については利用者側が責任を負う点に注意が必要です。

まず、違法・有害なコンテンツの生成や法令に反する利用は認められていません。また、既存IPや実在人物を用いた生成物を商用利用する場合は、権利者のガイドラインや肖像権・プライバシーへの配慮が不可欠です。

Wan2.2-Animateの料金

Wan2.2-Animate自体はオープンソースで無償提供されており、モデル利用料は発生しません。しかし、高性能な動画生成ツールなので、クラウド利用する場合やGPU利用には計算リソースが必要となります。

| 区分 | 料金 | 備考 |

|---|---|---|

| モデル使用 (ダウンロード/ローカル実行) | 無料 | |

| クラウドAPI利用 (Alibaba Cloud等) | 従量課金 | |

| GPUレンタル (AWS/GCP等) | 使用時間やスペックに応じて課金 |

モデル自体の利用料は不要ですが、GPUレンタルやクラウドサービスの使用料は別途発生するので、ご自身の用途に応じてよく確認してから利用するようにしましょう。

Wan2.2-Animateの使い方

Wan2.2-Animateの使い方にはいくつか方法がありますが、まず、1番簡単に試す方法としては、公式が案内している2つのデモ環境があります。

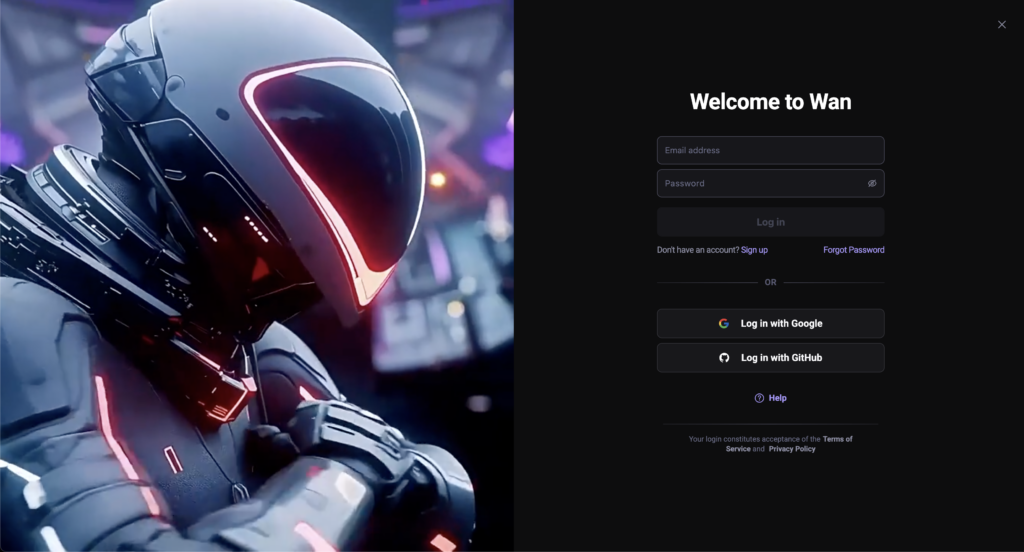

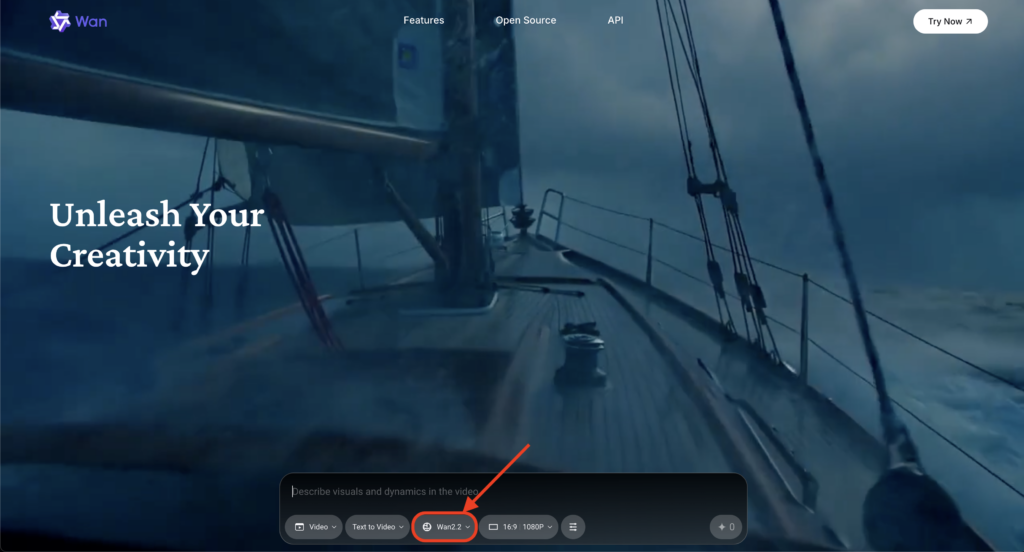

①wan.video

wan.videoを開いて、サインアップをしましょう。

サインアップが完了すると、以下の画像のようにWan2.2-Animateが使える状態になります。

②Hugging Face Space(Wan-AI/Wan2.2-Animate)

続いてHugging FaceのWan2.2-Animate公式スペースです。

Hugging Faceアカウントを持っている方であれば、すぐにWan2.2-Animateを試すことができます。試しにページ内下部のExamplesの例を実行してみます。

Generate Videoボタンを押してから1分ほどで以下の動画が生成されました。インプット動画の男性の手の動きが忠実に再現されていることが分かります。

③ローカル環境

ローカルで本格利用する場合は、まず公式GitHubの Wan2.2 リポジトリを取得し、依存関係をインストールします。PyTorch 2.4 以上が前提で、flash_attn が失敗する場合は他のパッケージを先に入れて最後に flash_attn を入れる運用が推奨されています。

git clone https://github.com/Wan-Video/Wan2.2.git

cd Wan2.2

pip install -r requirements.txt

# S2Vを使う場合のみ追加:

# pip install -r requirements_s2v.txt次にモデル重みを取得します。Wan2.2-Animate-14Bは、Hugging FaceとModelScopeから公式に配布されており、CLIでのダウンロード手順がモデルカードに掲載されています。

# Hugging Face 経由

pip install "huggingface_hub[cli]"

huggingface-cli download Wan-AI/Wan2.2-Animate-14B --local-dir ./Wan2.2-Animate-14B

# ModelScope 経由

pip install modelscope

modelscope download Wan-AI/Wan2.2-Animate-14B --local_dir ./Wan2.2-Animate-14BWan2.2-Animateは前処理 → 生成の二段構成になっています。前処理で参照動画からポーズや顔特徴などの素材を作り、その素材とキャラクター画像を条件として推論を回す設計になっています。モデルカードやREADMEには animation(動作模倣) と replacement(置換) のそれぞれの前処理コマンド例が掲載されています。

# (1)前処理:動作模倣 animation用

python ./wan/modules/animate/preprocess/preprocess_data.py \

--ckpt_path ./Wan2.2-Animate-14B/process_checkpoint \

--video_path ./examples/wan_animate/animate/video.mp4 \

--refer_path ./examples/wan_animate/animate/image.jpeg \

--save_path ./examples/wan_animate/animate/process_results \

--resolution_area 1280 720 \

--retarget_flag \

--use_flux

# (1)前処理:人物置換 replacement用

python ./wan/modules/animate/preprocess/preprocess_data.py \

--ckpt_path ./Wan2.2-Animate-14B/process_checkpoint \

--video_path ./examples/wan_animate/replace/video.mp4 \

--refer_path ./examples/wan_animate/replace/image.jpeg \

--save_path ./examples/wan_animate/replace/process_results \

--resolution_area 1280 720 \

--iterations 3 \

--k 7 \

--w_len 1 \

--h_len 1 \

--replace_flag前処理が終わったら生成に進みます。animationモードは、キャラクター画像に参照動画の動きや表情を移し、replacementモードは参照する動画内の人物をキャラクター画像に置き換えます。

# (2)生成:animationモード(単一GPU)

python generate.py --task animate-14B \

--ckpt_dir ./Wan2.2-Animate-14B/ \

--src_root_path ./examples/wan_animate/animate/process_results/ \

--refert_num 1

# (2)生成:animationモード(分散)

python -m torch.distributed.run --nnodes 1 --nproc_per_node 8 generate.py \

--task animate-14B --ckpt_dir ./Wan2.2-Animate-14B/ \

--src_root_path ./examples/wan_animate/animate/process_results/ \

--refert_num 1 --dit_fsdp --t5_fsdp --ulysses_size 8

# (3)生成:replacementモード(単一GPU)

python generate.py --task animate-14B \

--ckpt_dir ./Wan2.2-Animate-14B/ \

--src_root_path ./examples/wan_animate/replace/process_results/ \

--refert_num 1 --replace_flag --use_relighting_lora

# (3)生成:replacementモード(分散)

python -m torch.distributed.run --nnodes 1 --nproc_per_node 8 generate.py \

--task animate-14B --ckpt_dir ./Wan2.2-Animate-14B/ \

--src_root_path ./examples/wan_animate/replace/process_results/src_pose.mp4 \

--refert_num 1 --replace_flag --use_relighting_lora --dit_fsdp --t5_fsdp --ulysses_size 8Wan2.2-Animateでは、人物置換(replacement)時に「–use_relighting_lora」を指定することで、キャラクターを背景動画の光源や色調になじませる補正が行われます。(上記コマンド後半に含まれています)

実写動画にキャラクターを合成する場合、光の向きや明るさの違いによってキャラクターだけが浮いて見えることがあります。しかし、Relighting LoRAはこうした違和感を抑え、より自然な仕上がりに近づけることが可能です。

より詳しい使い方やオプションについては、公式情報を参照しましょう。

④ComfyUI(GUIで使う方法)

ComfyUIは、Stable DiffusionなどのAI画像生成モデルを操作するためのノードベースのGUIツールです。ComfyUIを使うことで、ローカル・ブラウザの両方でWan2.2-Animateを利用できるようになります。

まずは、ComfyUIの実行に必要な環境を準備し、環境構築を済ませましょう。

ComfyUIが動作するPC環境

- OS:Windows/Mac/Linux

- Python環境・CUDA設定はComfyUI側の要件に準拠

※NVIDIA GPUを搭載したマシンを推奨(VRAMは最低でも16GB以上)

※FP8量子化やオフロードを併用すれば、RTX 4090(24GB)で実用的とされる事例が多いです

環境構築を済ませたら、ComfyUIでWan2.2-Animateを使うために必要な以下のモデルファイルを用意します。

| モデル名 | 配置先 | 役割 |

|---|---|---|

| Wan2.2-Animate-14B(本体モデル) | ComfyUI/models/diffusion_models/ | キャラクターアニメーション・人物置換を行う中核モデル |

| wan_2.1_vae.safetensors(VAE) | ComfyUI/models/vae/ | 動画のエンコード・デコードに使用 |

| WanAnimate_relight_lora_fp16.safetensors(LoRA/任意で) | ComfyUI/models/loras/ | キャラクターを背景動画の光源・色調に自然になじませる |

| lightx2v_I2V_14B_480p_cfg_step_distill_rank64_bf16.safetensors(LoRA/任意で) | ComfyUI/models/loras/ | 動画全体のライティング・質感・一貫性を安定させる |

| umt5_xxl_fp8_e4m3fn_scaled.safetensors(テキストエンコーダ) | ComfyUI/models/text_encoders/ | プロンプト解釈に使用される言語モデル |

| clip_vision_h.safetensors(視覚エンコーダ) | ComfyUI/models/clip_vision/ | 入力画像の理解に使用される |

コミュニティが配布している「FP8量子化モデル」を使うことで、VRAM消費を抑えることも可能です。

必要なファイルを用意できたら、いよいよComfyUIでWan2.2-Animateを動かします。ComfyUIでは、公式配布のワークフローJSONを読み込むことで、比較的簡単にWan2.2-Animateを試せます。

基本的な流れは以下の通りです。

- ComfyUIを起動し、ワークフローJSONを読み込む

- 入力画像(キャラクター)を1枚設定

- 参照動画(動きを転写したい動画)を1本設定

- 必要に応じてRelighting LoRAや各種パラメータを調整

- 「Queue」ボタンを押して生成開始

Wan2.2-Animateの公式ワークフローJSONは、Wan2.2公式GitHub内のComfyUI向けディレクトリで配布されています。

代表的な例は以下です。

Wan2.2/ComfyUI/workflows/Wan2.2-Animate.jsonWan2.2-Animateを動かすためのGPU・VRAM目安と実行方法の選び方

Wan2.2-Animateは高品質なキャラクターアニメーションを生成できる一方で、モデルサイズが大きく、実行環境によって必要なGPUスペックが大きく変わります。

用途や環境に応じて、適切な実行方法を選ぶことが重要です。

| 実行方法 | GPU要件 | 特徴 |

|---|---|---|

| wan.video | 不要 | 公式が提供する最も手軽なデモ環境。すぐに挙動を確認できる |

| Hugging Face Space | 不要(制限あり) | 無料で試せる公式スペース。短時間・軽量な検証向け |

| ローカル(CLI) | VRAM 24GB以上推奨 | 最大品質での生成や分散実行が可能。本格運用向け |

| ComfyUI | VRAM 16GB〜24GB | GUIで操作しやすく、設定調整もしやすい |

| FP8 / GGUF 量子化 | VRAM削減可 | 低VRAM環境向け。検証・実験用途に有効 |

ローカル環境で本格的に使う場合は、VRAM 24GBクラス以上のGPUが現実的な目安です。

Wan2.2-Animateの活用事例

こちらでは、Wan2.2-Animateを用いた動画生成事例をご紹介します。

GGUF版でのキャラクター置換

上記ポストでは、男性が踊っている動画をインプットとして、キャラクター置換動画を生成した結果が紹介されています。GGUF版でここまで回るの結構すごいですね。

4090でVRAMがギリギリになるというのはある程度納得ですが、生成やアップスケール、フレーム補間まで一気通貫でやってくれるので安定感を感じますね。ただ、前処理とかLoRAの調整ができたら肌とか輪郭はもう一歩精度アップも期待できそうです。

ディズニーキャラクターへの置換

上記ポストでは、インプット動画の男性にキャラクターを置換してアニメーション動画を生成している様子が紹介されています。

何よりも置換の自然さがハンパないですね。手指の動きやライティングの馴染み方がめちゃくちゃ自然です。こちらは実運用面では権利許諾が前提ですが、オリジナルIPやラフ広告などの作成にはすぐに活かせそうですね。

VTuberとして差し替え映像の作成だったり、実写×CGみたいなパターンでも活用できそう。

アニメーション置換

上記ポストでは、実写のダンス動画を参照イラストのタッチに合わせてアニメ調へ変換するデモが紹介されています。

単なるフィルタだけでなく、重心移動まで再現されていてクオリティの高さが分かります。顔出しをしたくないけどショート動画を出したい方はすぐに活用できそうな事例ですね。

なお、アリババが開発した「Qwen3-Omni」が気になる方は、以下の記事もご覧ください。

Wan2.2-Animateに関するよくある質問

Wan2.2-Animateをアニメーション制作で活用しよう!

Wan2.2-Animateは、1枚の画像から高品質なキャラクター動画を生成できる革新的なツールです。その技術力がオープンソースで公開されたということで、アニメーションの制作だったり、コンテンツ制作の常識を大きく変える可能性がありますね。

オープンソースかつ無料なので手軽に試すことができますし、顔出しすることなくクリエイティブな動画を作ることができます。

気になる方はぜひWan2.2-Animateを活用した動画制作にチャレンジしてみてください。

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。