【AudioPaLM】Googleの神音声AIツール、導入から使い方まで解説

皆さん、Google が新しく発表したAudioPaLMというモデルについてご存知ですか?

これは、Googleが発表した音声に関係するモデルですが、どのように世の中が変わるのでしょうか。

AudioPaLMの概要やデモを触ってみた感想、日本語の精度などについてお話していきますので、ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

AudioPaLM概要

AudioPaLMは、音声データとテキストデータのどちらも扱うことができるモデルです。

テキストベースの言語モデルであるPaLM-2と、音声ベースの言語モデルであるAudioLMを合わせて作られたとか。

そのおかげで、以下の2つができるようになりました。

- 音声間翻訳(Speech-to-speech translation)

- 音声からテキストへの翻訳(Speech-to-text translation)

それぞれ詳しく見ていきましょう。

音声間翻訳(Speech-to-speech translation)

これは、話し手の声のまま、別言語へ翻訳する技術です。

音声間翻訳は、次のようなプロセスを踏みます。

実際の会話をもとに考えると、

- 筆者の声で、「こんにちは」と入力する

- こんにちは→Helloに翻訳する

- 筆者の声のまま、「Hello」と言ってくれる

この技術が発展することで、動画コンテンツの吹き替えが楽になることが予想できます。

音声からテキストへの翻訳(Speech-to-text translation)

これは音声をテキストに変換し、そのテキストを別の言語に翻訳するという技術です。

実際の会話を想定すると、以下かなと。

- 筆者の声で、「私の名前はLeon Kobayashiです」と入力する

- 「私の名前はLeon Kobayashiです」→「I’m Leon Kobayashi」と出力される

- 相手が、「I’m Leon Kobayashi」という文字情報を理解してくれる

言語が通じないヒト同士での会話で、翻訳が必要な場合、機能は便利そうですね!

AudioPaLMがどんなものか触ってみた

こちらのページで、AudioPaLMが翻訳した音声やテキストを確認できます。

デモ:音声間翻訳(Speech-to-speech translation)

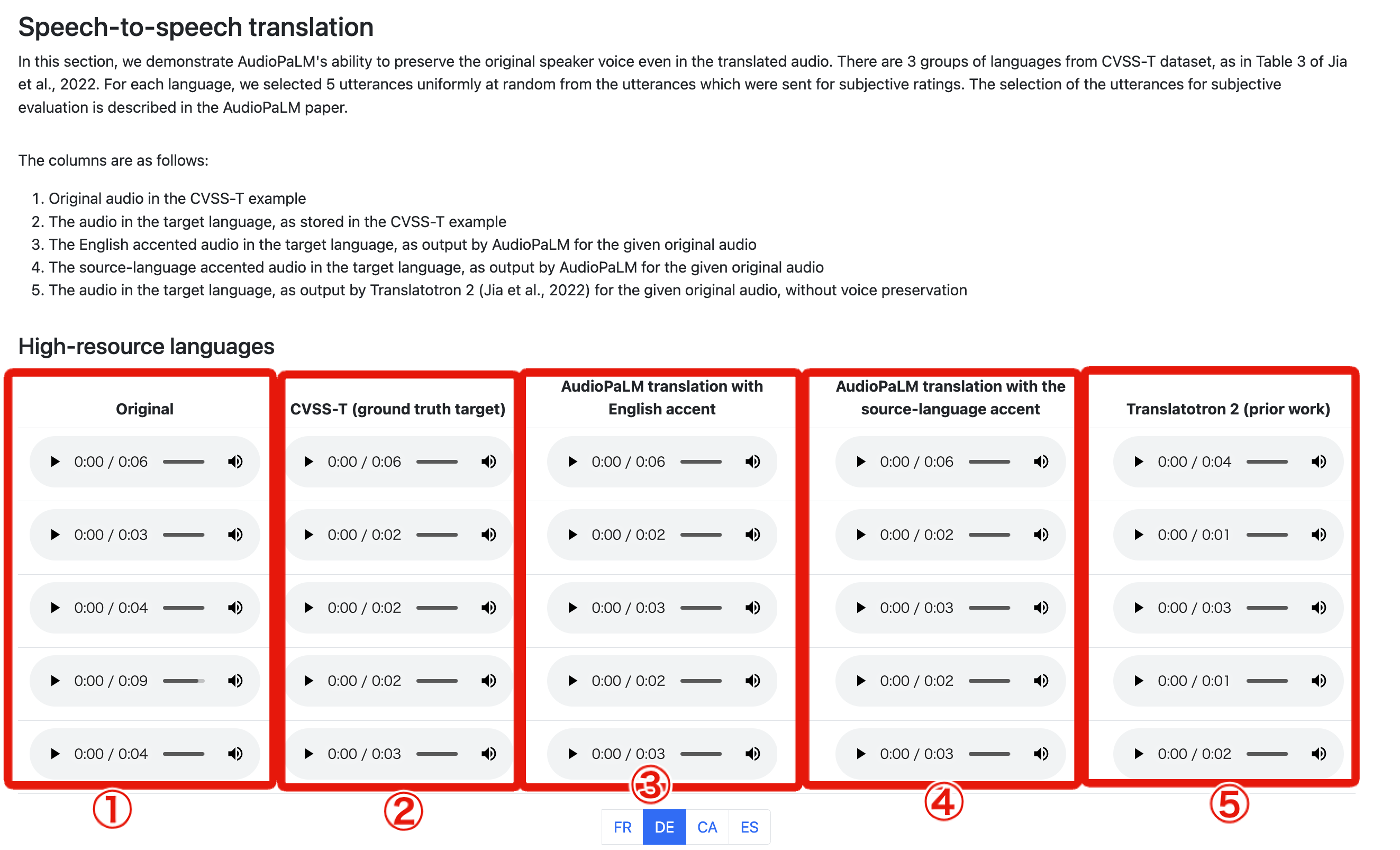

以下のような画面になっています。

音声間翻訳(Speech-to-speech translation)は、

音声情報(訛りや声の高低など)を保持したまま、異言語に音声のまま翻訳する処理です。

リアルタイム通訳のイメージをしてもらえるとわかるかもしれないですね。

実際に聞き分けるためにそれぞれの説明をすると、左から

- CVSS-T データセットのオリジナルの音声(上記のキャプチャだとドイツ語)

- CVSS-T データセットの教師データ(英語)

- AudioPaLMが翻訳した英語

- AudioPaLMが翻訳した英語(ドイツ訛り)

- Translatotron 2で変換したもの(音声はオリジナルを保持しない)

英語やドイツ語に詳しくないので、素人考えではありますが……

- 2と3を比較し、オリジナルの声(1.)は保持したまま、英語の発音ができている

- 3と4を比較して、ドイツ訛(っぽい)英語になっている

と感動しました!

日本語もあったので試してみました。

Low-resource languages の一つということで、学習データも少なく、まだまだ精度は低い模様。

真ん中の、AudioPaLM translation with English accent を聞いても、正しく訳されていないように思えました。

音声間翻訳(Speech-to-speech translation)に関しては以上です!

次は、音声からテキストへの翻訳(Speech-to-text translation)のデモを見てみましょう!

デモ:音声からテキストへの翻訳(Speech-to-text translation)

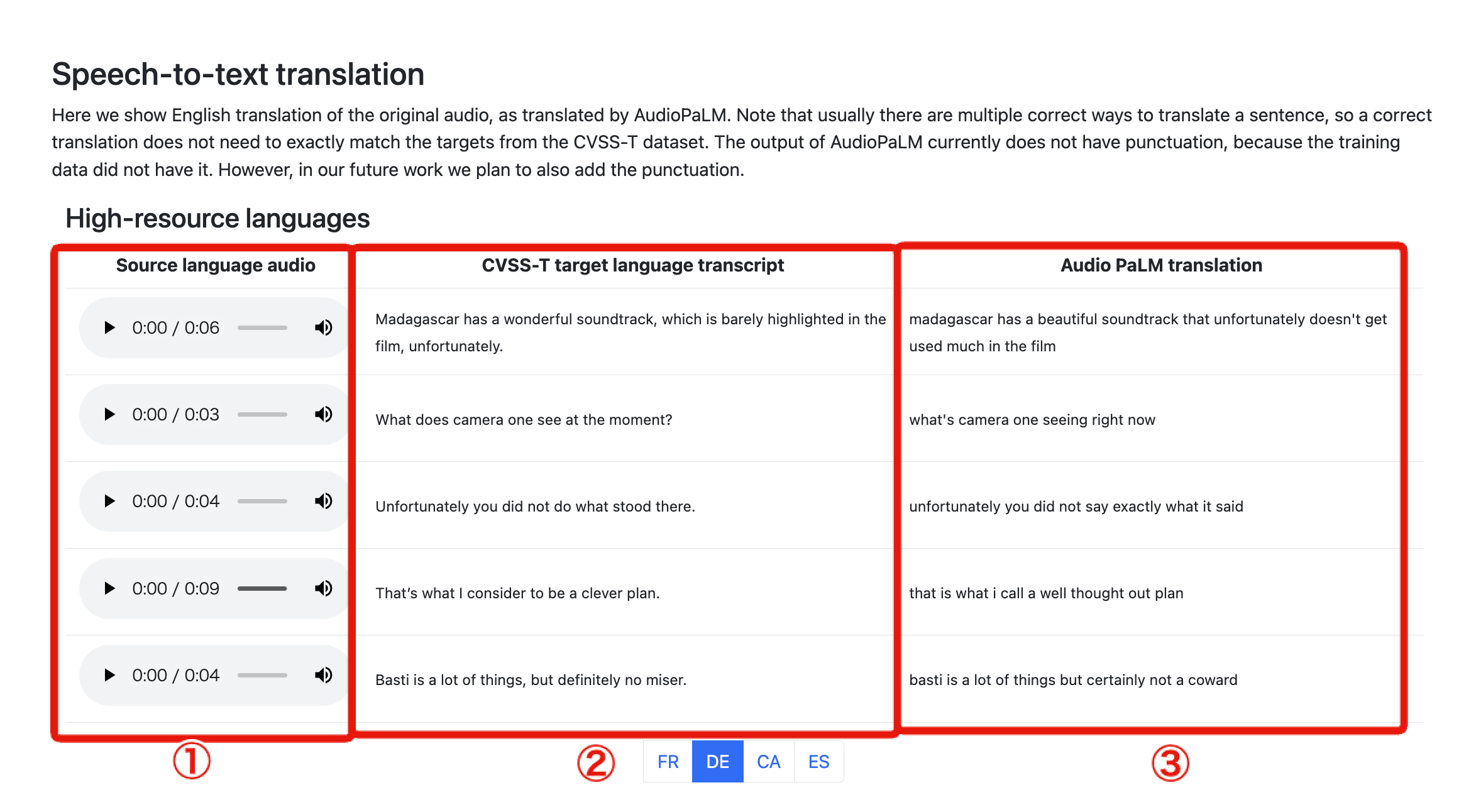

以下は、音声からテキストへの翻訳(Speech-to-text translation)の画面です。

ここでは、音声データからテキスト(英語)に翻訳する処理をしています。

画面の説明は、それぞれ左から次のとおりです。

- 翻訳される音声(例ではドイツ語)

- 教師データ(英語)

- AudioPaLMが翻訳したテキスト(英語)

こちらに関しては、完璧という感じではなさそうですが、ユースケース次第では問題ないという印象でしょうか?

文脈が分かるのであれば、異言語を文字起こしする場合で、かつユーザーがネイティブなら問題ないくらいの誤差かなと思いました。

ちなみに、日本語はこのような画面になってます。

デモ結果を見た感じ、日本語→英語の翻訳は大変なのかなぁという印象です。

Low-resource languages で学習データも少ないですし、

西洋の言葉に比べると、英語に似ていないので。

以上が、デモの所感に関してでした。

みなさんもぜひ試してみてください!

なお、その他の高性能音声生成AIについて詳しく知りたい方はこちらをご覧ください。

→【WhisperSpeech】Whisperがさらに高性能になった音声モデルを使ってエミネムにゆっくり喋らせてみた

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。