【WhisperSpeech】Whisperがさらに高性能になった音声モデルを使ってエミネムにゆっくり喋らせてみた

2024年11月18日、Whisperを利用したText-to-Speechモデル「WhisperSpeech」のアップデート版を、Collaboraが公開しました。

このAIモデルを用いることで、テキストを入力するだけで、簡単にそのテキストを(AIが)読み上げることができるんです、、、!※1

GitHubでのスター数は、本記事執筆時点(2025年9月)4400を超えており、期待度が高いことを示しています。

この記事ではWhisperSpeechの使い方や、有効性の検証まで行います。本記事を熟読することで、WhisperSpeechの凄さを実感し、そこら辺のTTSには戻れなくなるでしょう。

ぜひ、最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

WhisperSpeechの概要

WhisperSpeechはCollaboraによって開発されたAIで、簡単に言うと「文字起こしAIのWhisperを逆にしてText-to-Speechに応用したもの」です。

WhisperSpeechを用いることで、入力したテキストをAIに「声に出して」読ませることが可能になります。

WhisperSpeechの仕組みとしては、以下の手順でTTSが実現されます。

- テキストが入力される

- OpenAIのWhisperを使用して入力テキストから意味を抽出

- 抽出された意味をもとに、MetaのEnCodecを音響モデリングに入力し、圧縮された音響情報を出力

- 出力された音響情報をもとに、Charactr IncのVocosを用いて実際に音声に変換し出力

WhisperSpeechの対応言語

現在、このモデルは英語のLibreLightデータセットで学習されているため、英語やポーランド語のみの対応ですが、今後複数の言語に対応させていく予定とのこと。

WhisperSpeechのロードマップには「最終的に多言語対応モデルを完成させる」ことが明確に掲げられています。※2

具体的には以下のロードマップが記載されています。

- 自由利用可能な多言語データセットの拡充

ライセンス的に安全な音声データを基盤に、多言語モデルの訓練を継続。 - 感情や韻律への対応

ただ単に複数言語を話すだけでなく、感情やイントネーションを制御可能な音声生成を目指す。 - 実務的ユースケースへの展開

英語以外の言語を必要とするグローバル環境や多言語サービスへの実装。

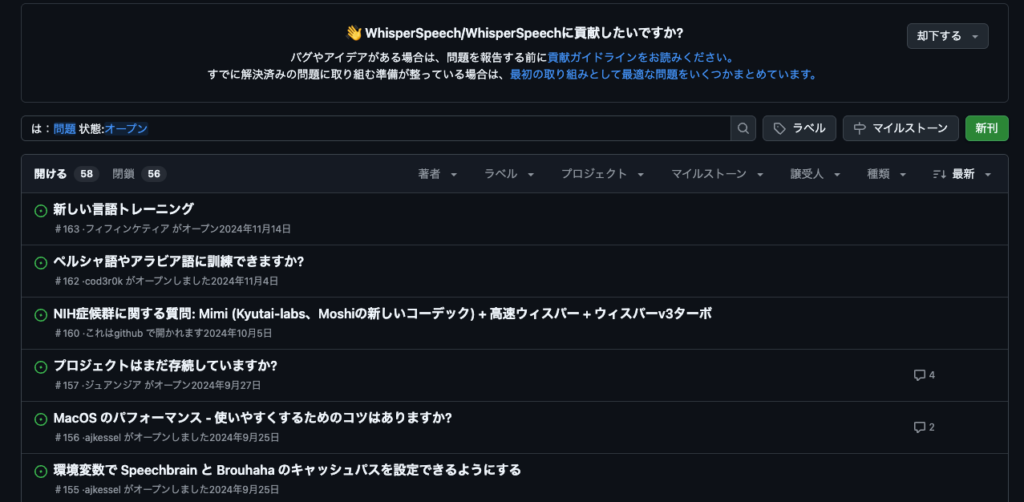

とはいえ、2025年9月時点でGitHubのIssueを見てみると2024年11月で更新が止まっているので、もしかしたら開発は進んでいないのかもしれませんね。

WhisperSpeechの料金体系

WhisperSpeechはオープンソースであるため、誰でも無料で利用可能です。

WhisperSpeechのライセンス

whisperspeechはMITライセンスのため、商用利用が可能です。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | 不明 |

| 私的使用 | ⭕️ |

上記はwhisperspeechのMITライセンスで可能なことの一覧です。特許使用について、ライセンス上に明示的に「特許使用が可能」とは記載されていませんので、不明としています。また、MITライセンスでは配布する場合(修正版・バイナリ含む)、オリジナルの著作権表示とライセンス文を残す義務があります。

なお、Metaが開発している音声生成AIについて知りたい方はこちらの記事をご覧ください。

WhisperSpeechの使い方

今回はGoogle ColabのT4を用いて、実行していきます。GitHub上にもgoogle colaboratoryのリンクが記載されているので、そちらから利用するでもOKです。

まず、以下のコードを実行して、ライブラリをインストールしましょう。

# Do not forget to install all dependencies first:

!pip install -Uqq WhisperSpeech次に、以下のコードを実行して、TTS生成の準備をしましょう。

def is_colab():

try: import google.colab; return True

except: return False

import torch

if not torch.cuda.is_available():

if is_colab(): raise BaseException("Please change the runtime type to GPU. In the menu: Runtime -> Change runtime type (the free T4 instance is enough)")

else: raise BaseException("Currently the example notebook requires CUDA, make sure you are running this on a machine with a GPU.")

%load_ext autoreload

%autoreload 2

import torch

import torch.nn.functional as F

from IPython.display import Markdown, HTML

# check "7. Pipeline.ipynb"

from whisperspeech.pipeline import Pipeline

# let's start with the fast SD S2A model

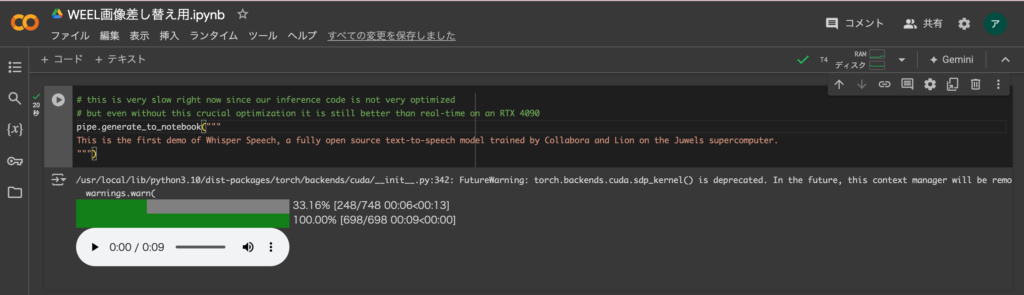

pipe = Pipeline(s2a_ref='collabora/whisperspeech:s2a-q4-tiny-en+pl.model')最後に、以下のコードを実行することで、「This is the first demo of Whisper Speech, a fully open source text-to-speech model trained by Collabora and Lion on the Juwels supercomputer.」という文章をAIに読ませることが可能になります。

# this is very slow right now since our inference code is not very optimized

# but even without this crucial optimization it is still better than real-time on an RTX 4090

pipe.generate_to_notebook("""

This is the first demo of Whisper Speech, a fully open source text-to-speech model trained by Collabora and Lion on the Juwels supercomputer.

""")すると、以下のように出力されるはずです。

WhisperSpeechを動かすのに必要なPCのスペック

■Pythonのバージョン

Python 3.8以上

■必要なパッケージ

WhisperSpeech

Pytorch

IPython

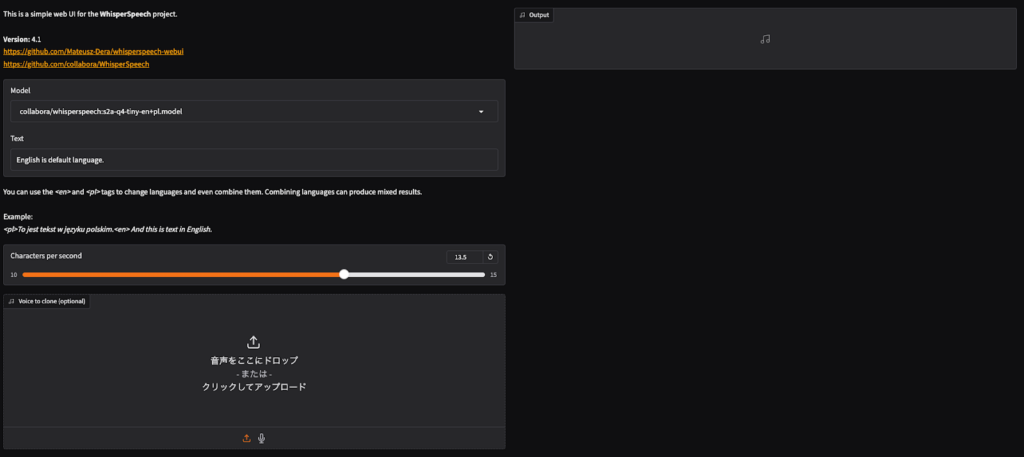

whisperspeech webuiを使ってみる

GItHubにwhisperspeechのwebuiに関するリポジトリがあります。こちらを使えばWebUIでwhisperspeechを使うことができるので、実際に使ってみたいと思います。

まずは必要ライブラリのインストール。

!apt-get -y install ffmpeg

!pip install uv続いてGitHubのリポジトリをクローン。

!git clone https://github.com/Mateusz-Dera/whisperspeech-webui.git

%cd whisperspeech-webuiそしたら起動です。google colaboratoryで実行する場合、「share」をつける必要があるので、下記のようになります。

!uv run --extra cuda webui.py --share --apiそうするとlocal URLの他にpublic URLが表示されるので、publicからアクセスします。

あとは実行していきます。

前述した「This is the first demo of Whisper Speech, a fully open source text-to-speech model trained by Collabora and Lion on the Juwels supercomputer.」を喋らせてみます。

流暢に喋ってくれているのがわかります。

同じように日本語も試してみます。

今の内容を日本語に翻訳して「これは、CollaboraとLionがJuwelsスーパーコンピュータでトレーニングした完全オープンソースのテキスト読み上げモデル「Whisper Speech」の最初のデモです。」をテキストとして渡します。

結果はこちら。

うーん、やはり日本語は対応していないということから、出力内容が不安定ですね。

今回のgoogle colaboratory実行環境は次の通り。

◆システム RAM:3.6 / 53.0 GB

◆GPU RAM:2.5 / 22.5 GB

◆ディスク:48.0 / 112.6 GB

◆GPU:L4

◆プラン:無料

ローカル環境で実行する場合の要件としては下記のようになっています。

| 名称 | 情報 |

|---|---|

| CPU | AMD Ryzen 9950X3D |

| GPU | AMD Radeon 7900XTX |

| RAM | 64GB DDR5 6600MHz |

| Motherboard | ASRock B650E PG Riptide WiFi (BIOS 3.30) |

| OS | Ubuntu 24.04.2 LTS |

| Kernel | 6.14.0-28-generic |

| ROCm | 6.4.3 |

もしくは下記です。

| 名称 | 情報 |

|---|---|

| CPU | IntelCore i5-12500H |

| GPU | NVIDIA GeForce RTX 4050 |

| RAM | 16GB DDR4 3200MHz |

| Motherboard | GIGABYTE G5 MF (BIOS FB10) |

| OS | Ubuntu 25.04 |

| Kernel | 6.14.0-28-generic |

| NVIDIA Driver | 570.169 |

| CUDA | 12.8 |

上記はいずれも推奨要件の一覧です。上記を参考にローカル環境で実行してみてください。

WhisperSpeechを実際に使ってみた

先ほどと同様に、「This is the first demo of Whisper Speech, a fully open source text-to-speech model trained by Collabora and Lion on the Juwels supercomputer.」という文章をWhisperSpeechに入力したところ、以下のような結果になりました。

精度としてはかなり高く、英語の発音・イントネーションも完璧ですね。

このWhisperSpeechでは、声の主を変えることも可能です。先ほどと同様の文章を、違う話者に読ませるには、以下のコードを実行してください。

# we can give it an audio file reference to get zero-shot voice cloning

#

# you can provide a URL or upload your own audio files

pipe.generate_to_notebook("""

This is the first demo of Whisper Speech, a fully open source text-to-speech model trained by Collabora and Lion on the Juwels supercomputer.

""", lang='en', speaker='https://upload.wikimedia.org/wikipedia/commons/7/75/Winston_Churchill_-_Be_Ye_Men_of_Valour.ogg')その結果は、以下の通りです。

こちらも、精度高いですね。

ここで、自分の好きな声に読ませるには、音声のURLを探してきて、それを上記のコードの以下の「speaker=”」の部分に張り付けましょう。

pipe.generate_to_notebook("""

This is the first demo of Whisper Speech, a fully open source text-to-speech model trained by Collabora and Lion on the Juwels supercomputer.

""", lang='en', speaker='')試しに、エミネムに同じ文章を読ませてみましょう笑

「speaker=’https://upload.wikimedia.org/wikipedia/en/1/11/02_Kill_You.ogg’」と入力し、再度実行してみてください。結果は、以下の通りです。

おおー!なんとエミネムの声になりました!ゆっくり話すエミネムなんて珍しいですね!

なんかもう、これでディープフェイクとか簡単に作れてしまいますね。

WhisperSpeechの推しポイントである音読能力は本当なのか?

ここまでは、WhisperSpeechの音読能力(TTS)の高さについて見てきましたが、果たしてそれは本当なのかを検証するために、「VALL E」というTTSモデルと比較検証します。※3

ここでも同じ文章を読ませてみましたが、結果は以下の通りになりました。

全体的に、WhisperSpeechよりも発音が劣っているように感じました。

特に、「speech」の発音が「speak」に聞こえたり…

個人的には、WhisperSpeechに軍配が上がったかと思いました!

なお、PCをGUIで操作する方法について詳しく知りたい方は、下記の記事を合わせてご確認ください。

まとめ

WhisperSpeechはCollaboraによって開発されたAIで、簡単に言うと「文字起こしAIのWhisperを逆にしてText-to-Speechに応用したもの」です。WhisperSpeechを用いることで、入力したテキストをAIに「声に出して」読ませることが可能になります。

精度としてはかなり高く、英語の発音・イントネーションも完璧でした。加えて、自分の好きなアーティストにも読ませることが可能です。ただし、ディープフェイクの温床にならないか心配ですね。

数年後にはこの技術を応用し、AI同士が自由に会話するようになっているのかもしれないですね。

現在は、CUI上でAIエージェント同士が、テキストベースでやり取りし、タスクを実行してくれるツールがあります。これと今回のWhisperSpeechのような技術を組み合わせれば、あたかもAI同士が声に出して会話しているかのような技術に応用できるかもしれません。

最後に

いかがだったでしょうか?

WhisperSpeechを活用した高度な音声生成や多言語対応の可能性を、自社の事業やサービスでどのように実装できるか、具体的な活用戦略をご検討いただけます

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。