パラメーター数– tax –

-

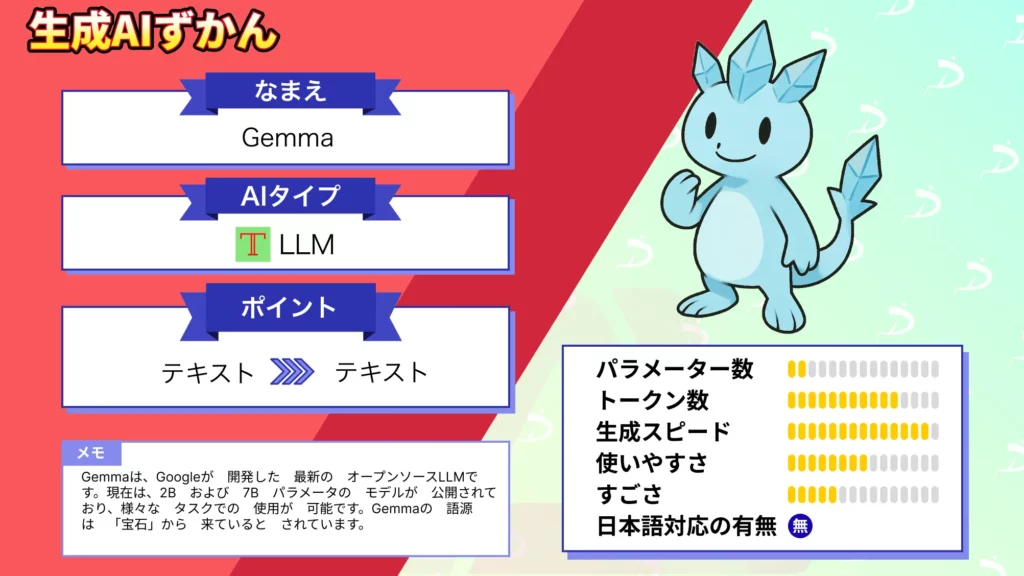

【Gemma】”Llama 2超え”と噂のGoogleのオープンソースLLMの性能を徹底比較してみた

-

【GLM‑4.5/GLM‑4.5 Air】高性能と低コストを両立するオープンソースモデルの性能や使い方を徹底解説!

-

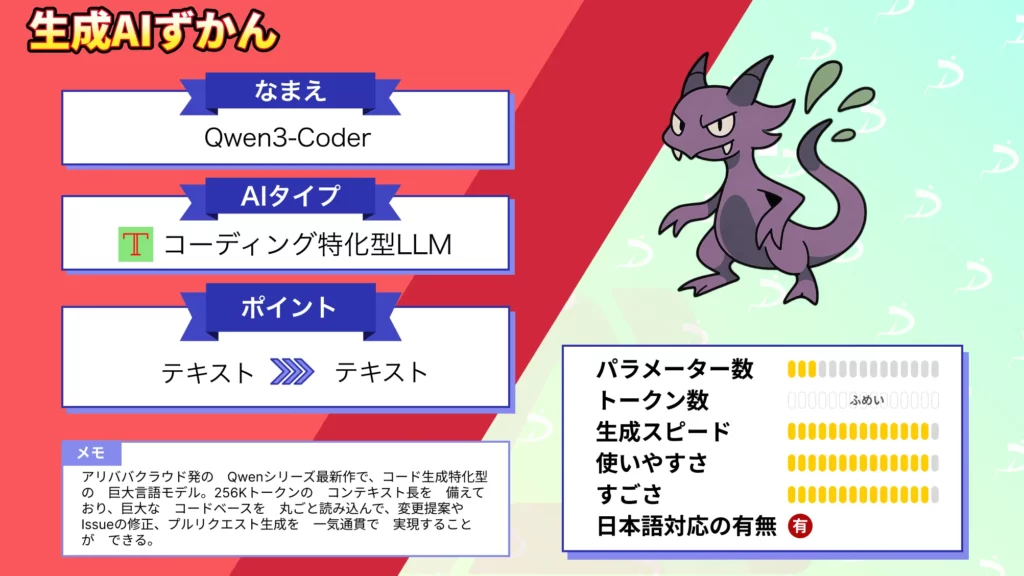

Qwen3‑Coderの完全ガイド!性能・料金プラン・使い方を徹底解説

-

【Kimi K2】パラメータ数1兆!?中国発の最先端大規模言語モデルを使ってみた

-

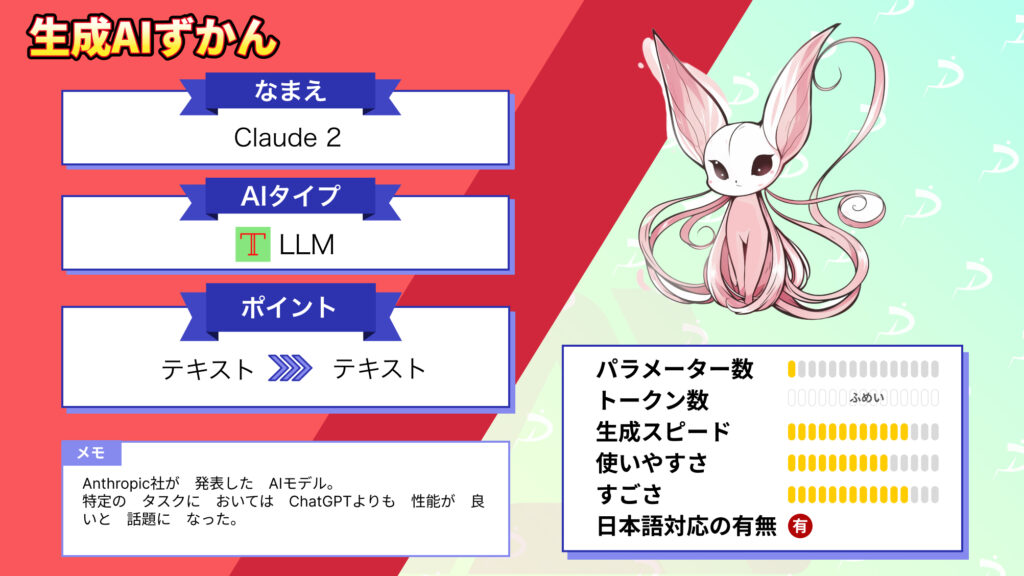

Claude 2の日本での使い方解説!料金体系やセキュリティ、ChatGPTとの違いについても解説

-

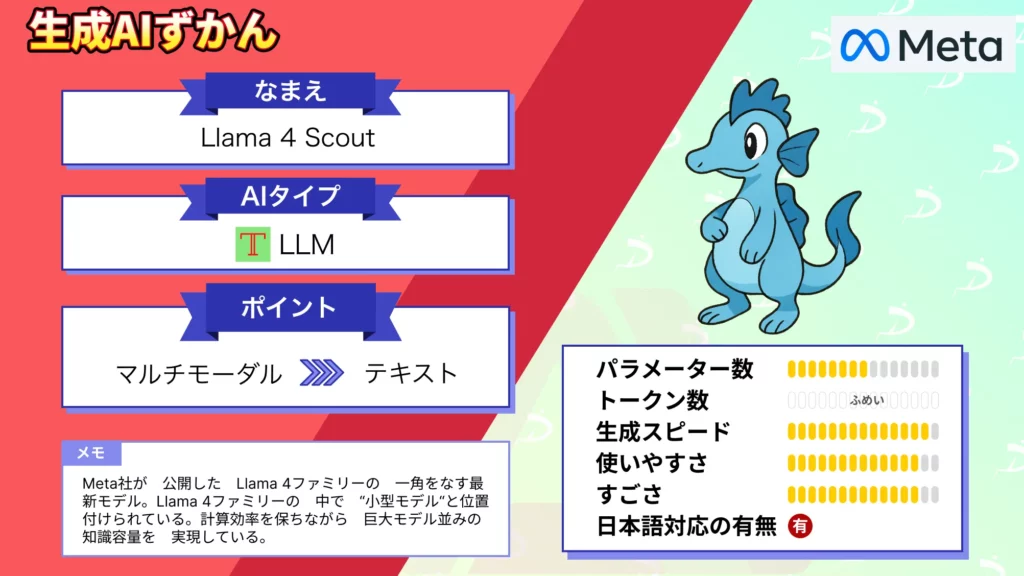

【Llama 4 Scout】巨大モデル並みの知識容量を実現する小型モデル!?MetaのLLMを徹底解説

-

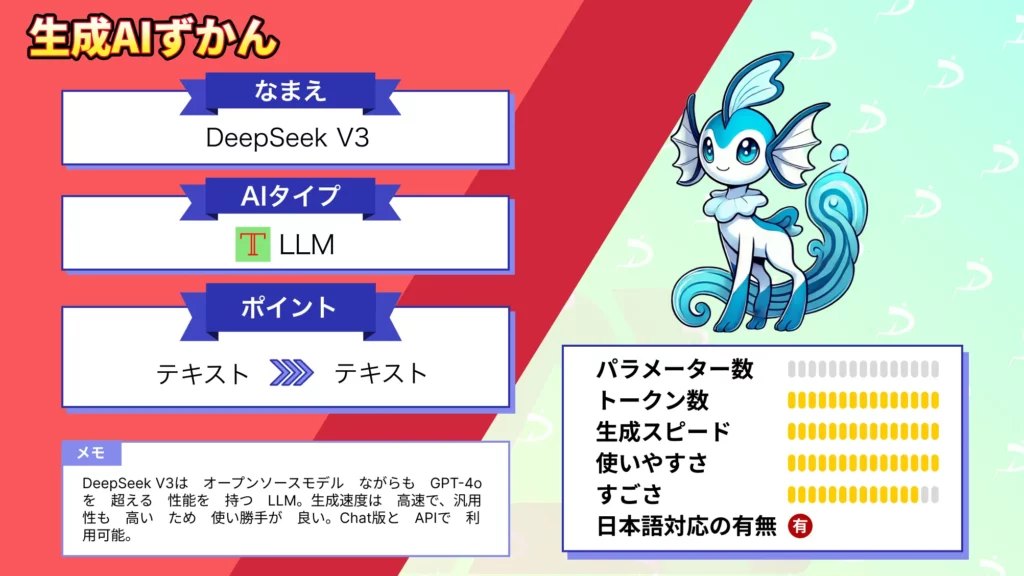

DeepSeek V3とは?特徴や使い方、ビジネス活用法まで徹底解説!

-

「Mistral Small 3.1」登場!GPT-4oを超えた?128kトークン長文処理&マルチモーダル対応のLLMを徹底検証

-

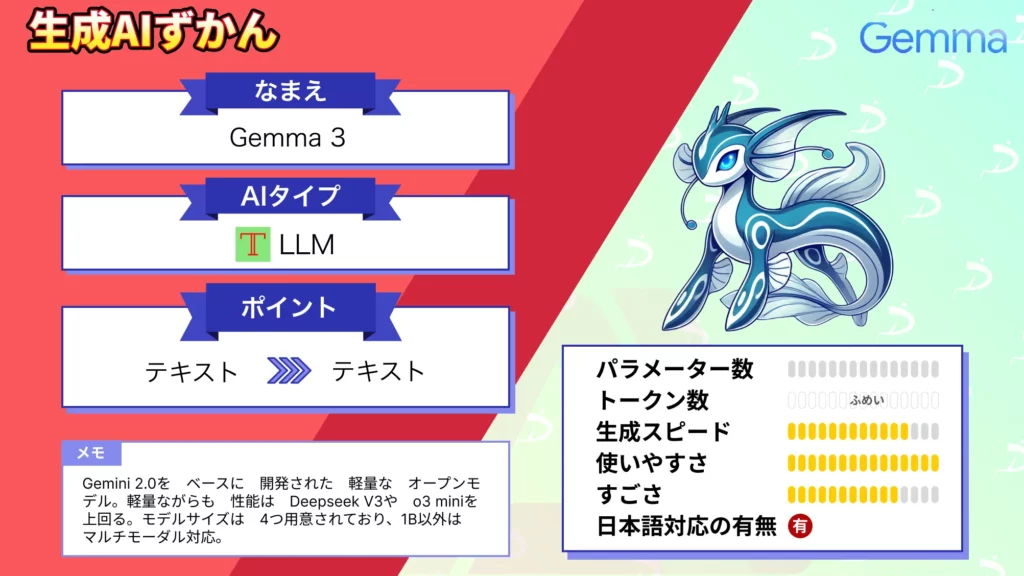

【Gemma 3】軽量&マルチモーダル処理が可能な高性能!GoogleのオープンAIモデル解説