パラメーター数– tax –

-

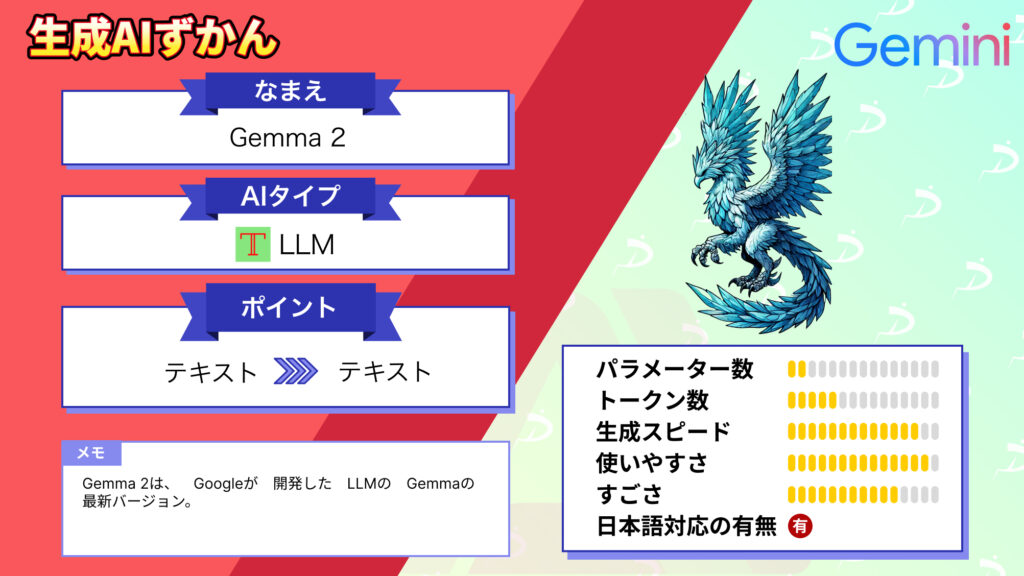

【Gemma 2】Llama 3を超えたGoogleのオープンLLM

-

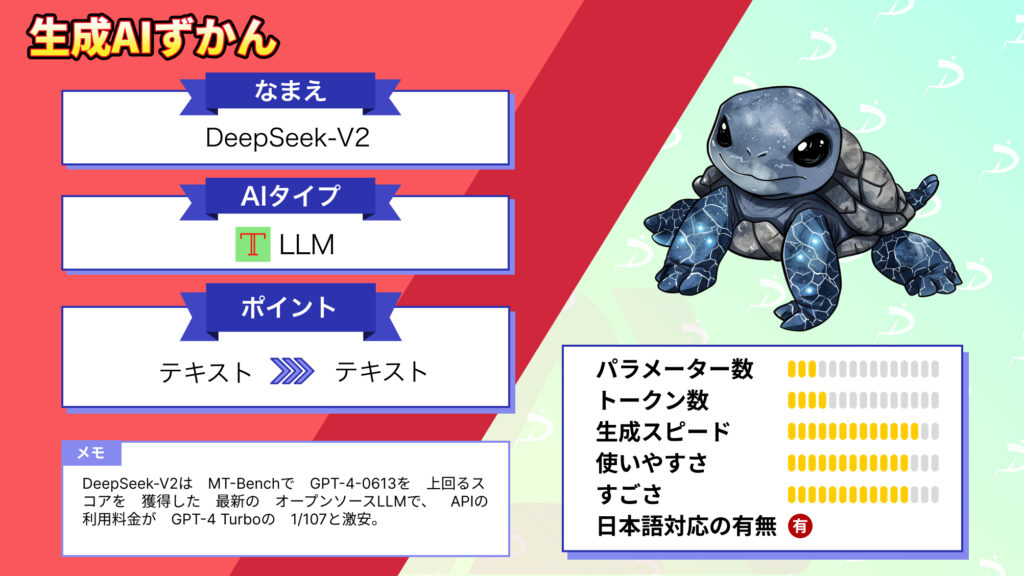

【DeepSeek-V2】Llama3を完全に超えた?コスパ最強オープンソースLLM

-

【Calm2 7b】サイバーエージェントの最新LLMが優秀すぎたので、ChatGPTと比較レビューしてみた

-

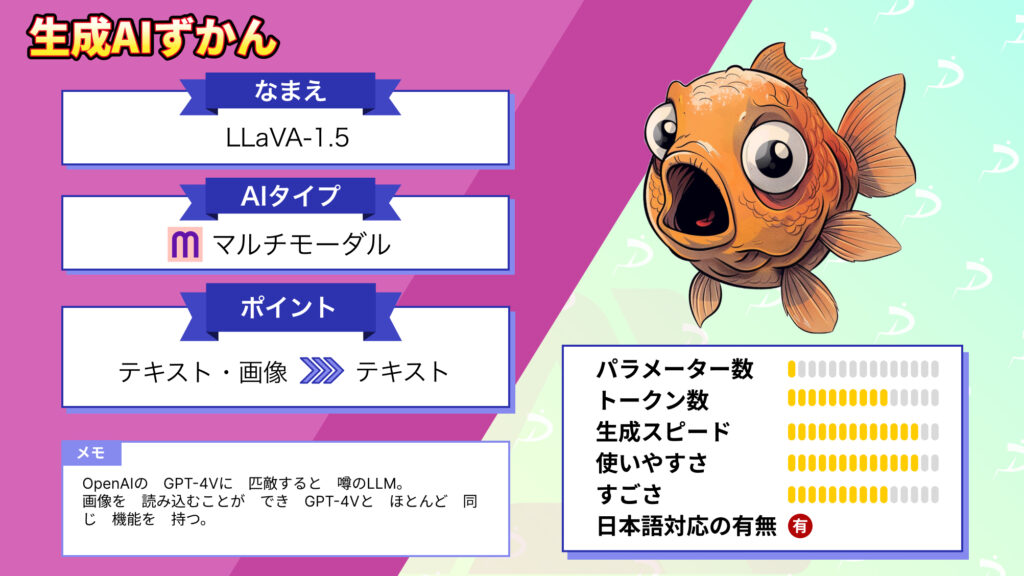

【LLaVA 1.5】オープンソース版GPT4-Vの使い方~比較レビューまで

-

【DBRX】1320億パラメータ×エキスパート16人搭載の最強LLM

-

【Swallow on mistral】日本語最強の性能を叩き出す70億パラメーター国産LLMを使ってみた

-

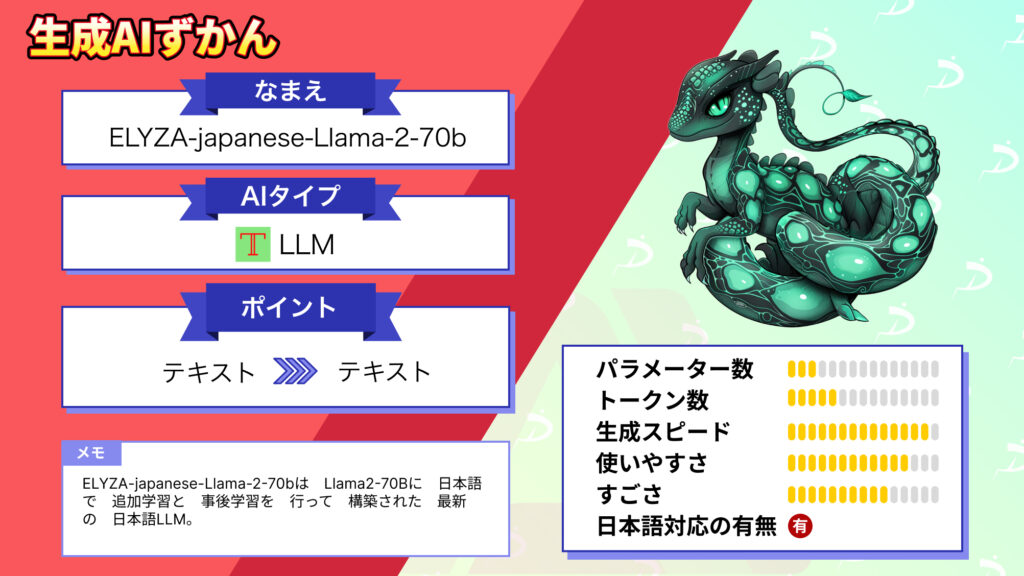

【ELYZA-japanese-Llama-2-70b】日本語特化モデル最大級の700億パラメーターLLMを使ってみた

-

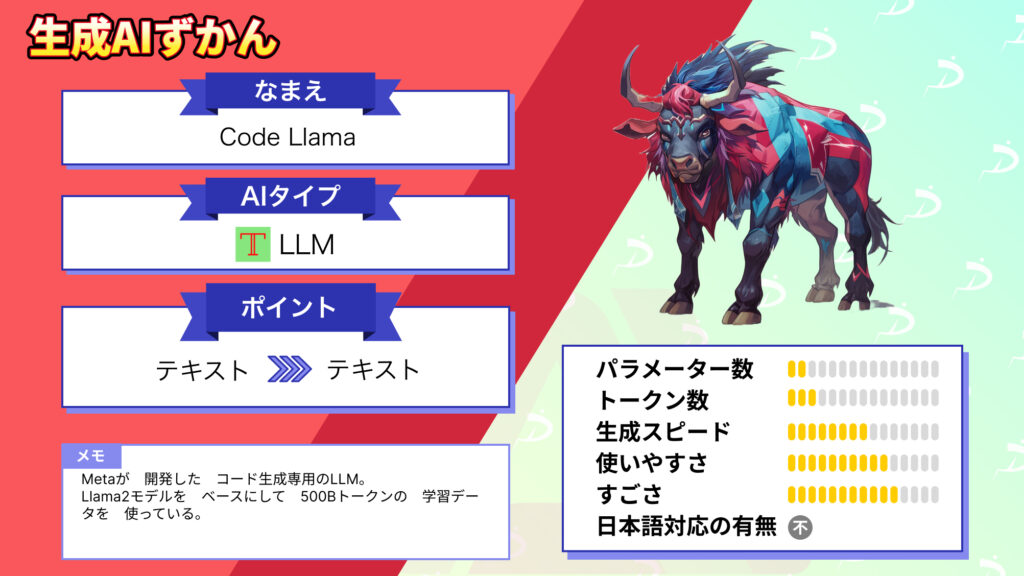

【Code Llama】最強コード生成AIの使い方と実践を解説

-

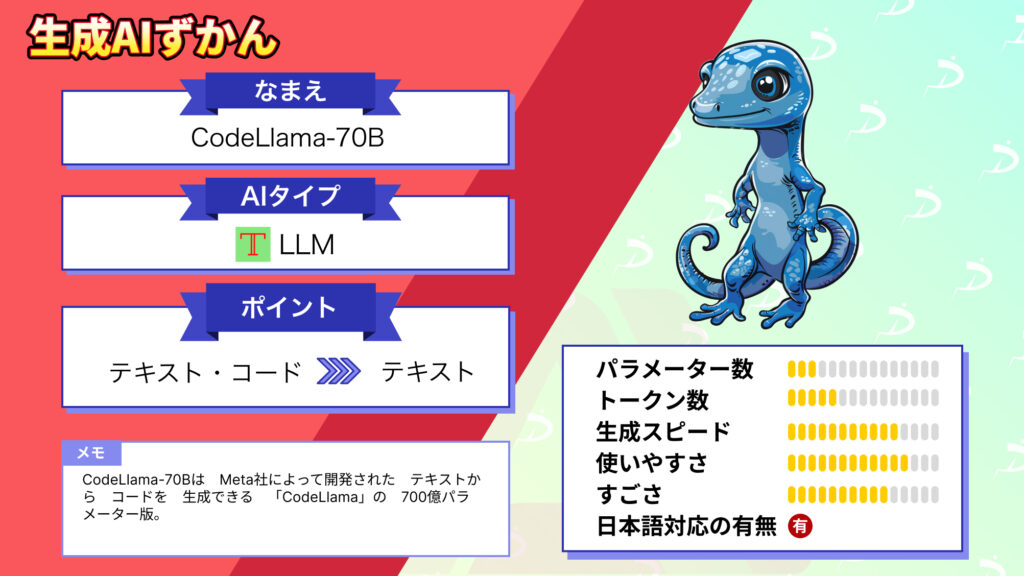

【CodeLlama-70B】700億パラメーターコード生成AIをGPT-4と比較してみた