Gemini 3 Proガイド!料金・API活用から業務実装の手順まで徹底解説

- Googleの最新AIモデルファミリー「Gemini 3」

- フラッグシップの「Gemini 3 Pro」は、推論・マルチモーダル・コーディングなど主要ベンチマークでGemini 2.5 Proを大きく上回る性能を記録

- 一般ユーザーはGeminiアプリやGoogle検索のAIモードから、開発者はGoogle AI Studio/Gemini API/Vertex AI/AntigravityからGemini 3 Proを利用可能

2025年11月19日、ついにGoogleが次世代モデルファミリー「Gemini 3」を正式発表しました!

2023年末に登場した初代Geminiから数えて3世代目となるモデルで、推論能力・マルチモーダル・エージェント機能が大きく進化した「Google史上もっともインテリジェントなモデル」と位置づけられています。

実は正式リリースに先立ち、2025年11月上旬にはVertex AI上に「gemini-3-pro-preview-11-2025」というモデル名でテスト公開されており、X(旧Twitter)でも開発者による検証報告が相次いでいました。

その時点ではレスポンスが不安定だったり、地域によっては利用できなかったりと、「実験段階」という状況でしたが、現在は公式プロダクトとしてGeminiアプリ、Google検索のAIモード、Google AI Studio、Vertex AIなどから安定して利用できるようになっています。

本記事では、Gemini 3.0の特徴や性能、使い方について、解説していきます。ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Gemini 3.0の概要

Geminiは、Google DeepMindが開発する次世代のマルチモーダルAIモデルです。

テキスト、コード、画像、音声、動画など複数のデータ形式(モダリティ)を統合的に扱えるのが大きな特徴で、2023年末にPaLM 2などの後継として発表されました。

Gemini 3.0はGoogle史上最も高度な知能を持つAIモデルであり、ユーザーのあらゆるアイデアを形にする手助けをすることを目指しています

このモデルは、高度な推論能力とマルチモーダル機能(テキスト・画像・音声・動画・コードを統合的に理解・生成する能力)において最先端で、入力の意図を深く把握することに長けています。

例えば、以前のモデルではテキストや画像を読み取るだけでしたが、Gemini 3.0では状況や文脈まで「空気を読む」かのように理解できるようになりました。

実際、GoogleのCEOであるスンダー・ピチャイ氏は「この2年でAIはただ文章や画像を読む存在から、場の空気を読む存在へと進化した」と述べ、Gemini 3.0が繊細なニュアンスまで理解する画期的なモデルであることを強調しています。

またGemini 3.0は、検索エンジンからクラウドサービスまでGoogleの幅広い製品に統合されており、発表当日からGoogle検索のAIモードにも組み込まれています。

これによって、われわれユーザーは検索結果として生成されるインタラクティブな回答やツールを体験できるようになっています。

Gemini 3.0は、汎用人工知能(AGI)への大きな一歩とも位置付けられており、あらゆる分野の学習・創作・業務支援に革新をもたらすことが期待されています。

なお、Gemini 2.5 Proについて詳しく知りたい方は、以下の記事も参考にしてみてください。

Gemini 3.0とGemini 3.0 Proの違い

Gemini 3.0には、「標準モデル」と「上位モデル」という形で複数のバリエーションが用意されており、2025年11月時点では、フラッグシップの「Gemini 3.0 Pro」と、さらに推論能力を強化した「Gemini 3.0 Deep Think」の2系統が公式に発表されています。

上位版である「Gemini 3.0 Pro」は、大規模なパラメータと高度な推論・創造的応答に最適化されたフラッグシップモデルであり、その上に、より長時間の思考ステップを割り当てて難問を解く「Gemini 3.0 Deep Think」モードが重なる構成になっています。

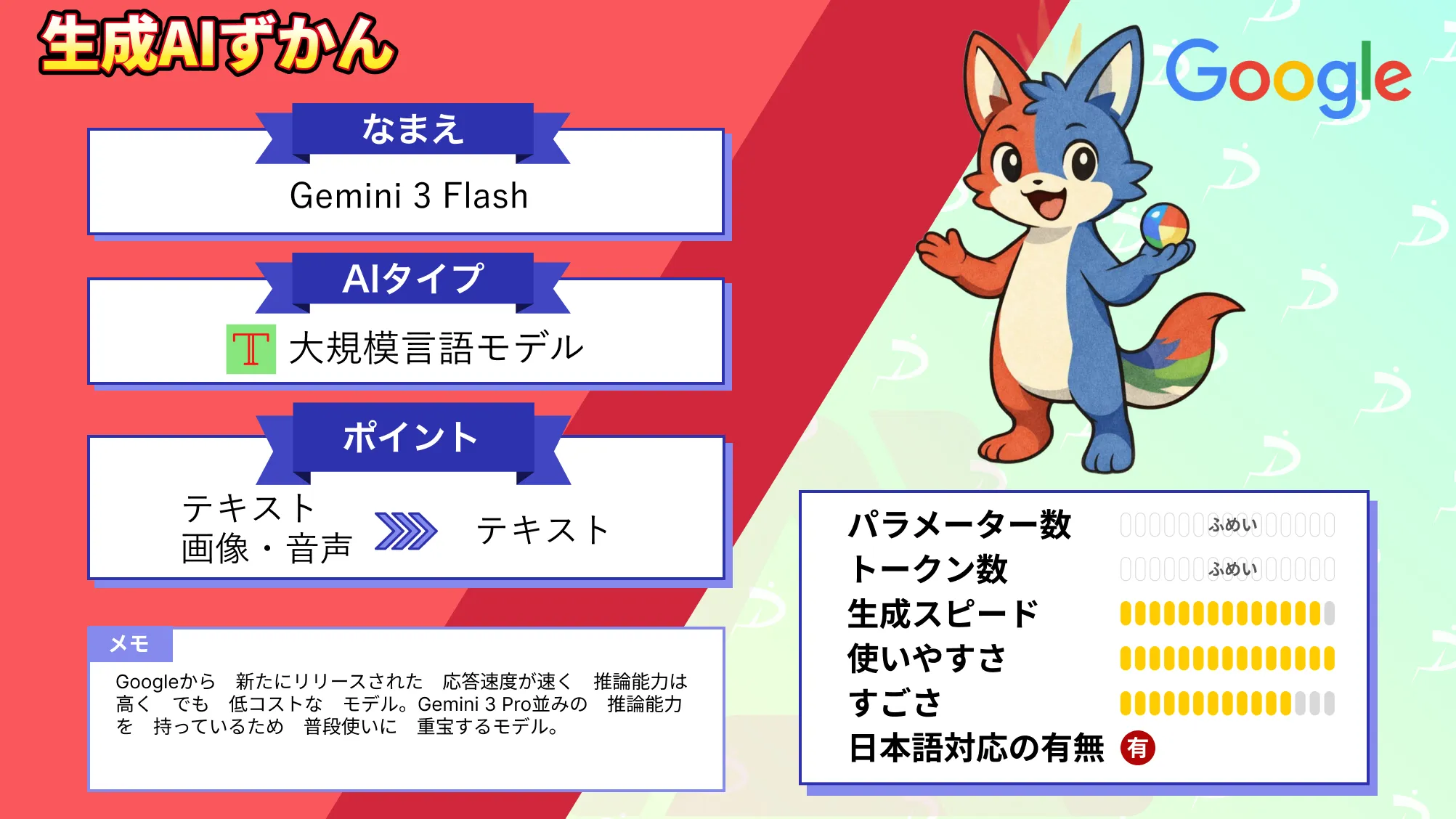

Gemini 3.0 Flashについては下記の記事を参考にしてください。

Gemini 3.0シリーズのラインアップ

Gemini 3.0を触り始めた人が最初につまずくのは、性能比較よりも「結局どれを選べばいいの?」です。

これはGeminiに限った話ではありませんが、モデルが増えるほど、どれを選べばいいかわからなくなります。そこでここでは、Gemini 3.0 Pro / Flash / Deep Thinkについて解説します。

| 区分 | 位置づけ | 得意領域 |

|---|---|---|

| Gemini 3.0 Pro | 高度な推論・マルチモーダル・エージェント/コーディングを総合的に最大化した中核モデル | 複雑な問題解決、品質重視のアウトプット生成、長文・多情報の統合 |

| Gemini 3.0 Flash | 「Pro級の推論をFlash級の速度で」。Geminiアプリではデフォルトとして展開されやすいモデル | 速度・スループット、反復処理、軽量な推論、短サイクルの改善 |

| Deep Think | Proを考え抜くモード。複数仮説を並列検討する設計 | 難問(数学・科学・論理)、戦略的な思考、複雑なトレードオフ整理 |

上記表はGemini 3.0の一覧です。

区分としてDeep Thinkを記載していますが、Deep Thinkは別モデルではなく、Gemini 3.0 Proの高度推論モードです。Deep ThinkモードではGemini 3.0 Proの性能を上回ります。

Gemini 3.0の性能

Gemini 3.0はGemini 2.5 Proを上回る性能です。

圧倒的なコンテキスト処理能力

Gemini 3.0 Proの注目すべき性能の1つが、超長文コンテキスト処理です。

Gemini 2.5 Proではすでに最大100万トークン(約75万語)もの文脈を保持でき、非常に長い会話や巨大なドキュメントを一度に解析可能でした。

Gemini 3.0 Proでも最大100万トークンもの超長文コンテキストを保持でき、巨大な文書や複数資料を同時に分析するタスクにも対応可能です。

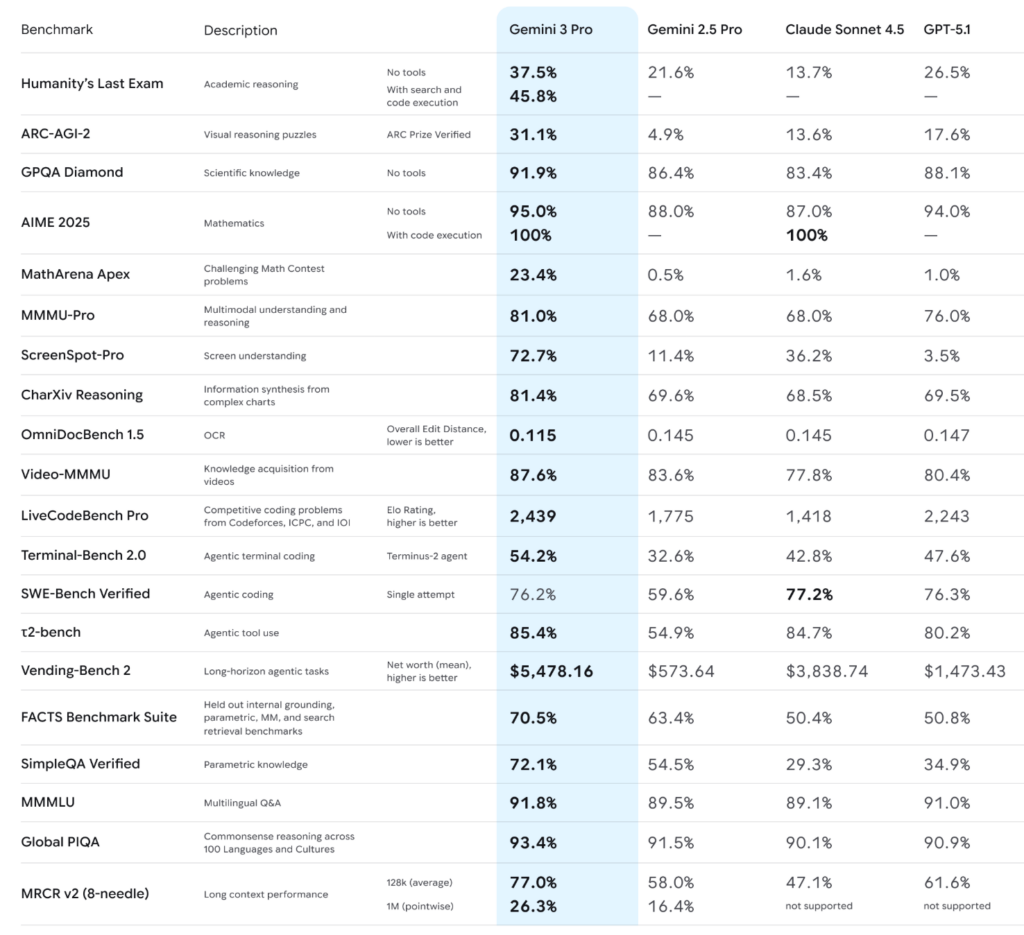

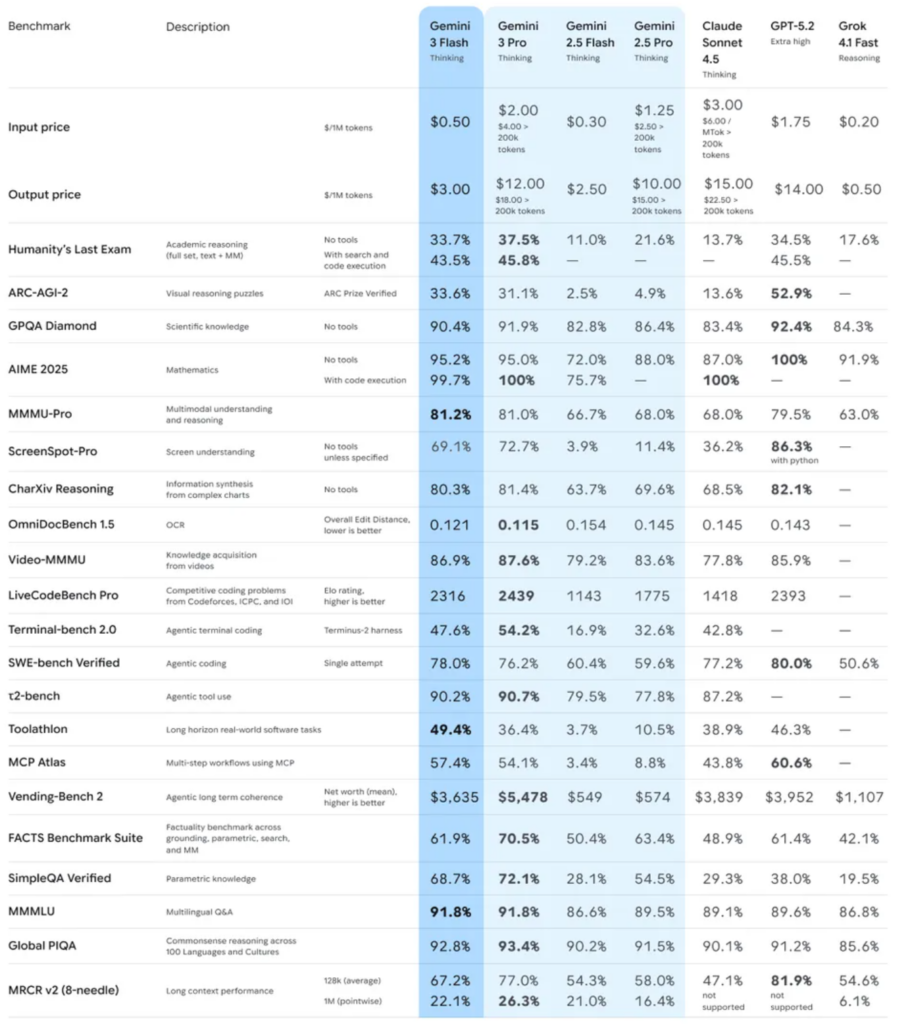

各種ベンチマークでの向上

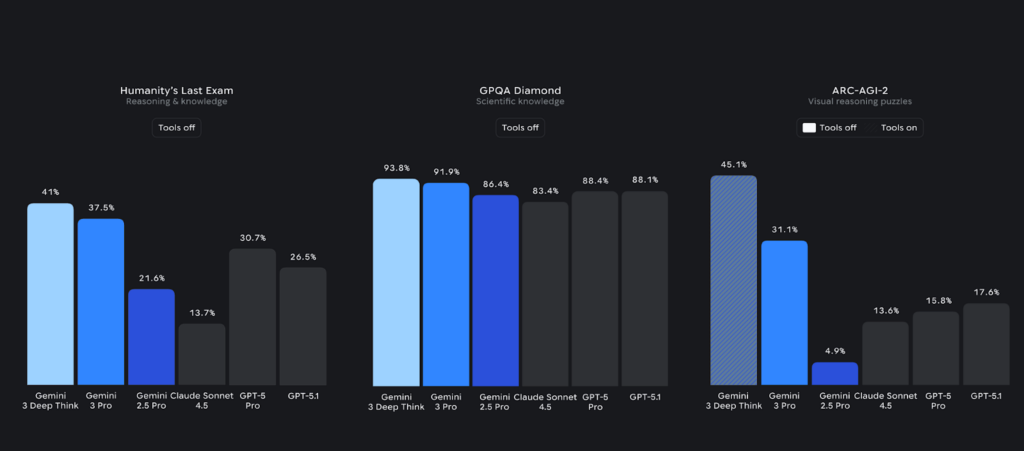

Gemini 3.0はベンチマーク指標でも現行トップクラスであり、Googleによれば前世代モデルを全ての主要ベンチマークで上回っています。

具体的な評価指標では、LMArena(大規模言語モデルの総合評価)において、Eloスコア1501という画期的な最高値を記録し、ランキング1位を獲得しています。

また、超難関とされる人類最後の試験(Humanity’s Last Exam)で37.5%という博士号レベルの成績を達成し、高度な読解・推論力を誇っています。

さらに、GPQA Diamondという厳しい文脈質問応答テストでも91.9%とトップクラスの正答率を叩き出し、数学分野ではMathArena Apexで23.4%と従来モデルを大きく上回る新記録を樹立しました。

マルチモーダル(複数媒体)分野でも、画像・動画理解の指標であるMMMU-Proで81%、Video-MMMUで87.6%という高スコアを記録し、事実に基づく正確性を測るSimpleQA Verifiedでは72.1%と最新モデル中トップの精度を残しています。

これらはいずれも業界の最新最高水準(State-of-the-Art, SOTA)であり、Gemini 3.0が科学・数学など幅広い領域の複雑な問題を高い信頼性で解決できることを意味します。

プログラミング・エージェント能力の強化

Gemini 3.0は、プログラミングやエージェント的なタスクにおいても優れた性能を発揮。例えば、コード自動生成やUI構築に強みを持ち、Web開発分野の評価指標WebDev ArenaでEloスコア1487を記録し1位です。

また、コンピュータのターミナル操作能力を測るTerminal-Bench 2.0では54.2%という高スコアを達成し、ソフトウェア開発に必要なマルチステップ思考力を示しました。

さらに、ソフトウェアエンジニアリングのエージェント性能を評価するSWE-Bench Verifiedでも76.2%を記録し、前世代(Gemini 2.5 Pro)の成績を大幅に上回っています。

これらの結果から、Gemini 3.0は、高度な推論力・知識正確性・マルチモーダル処理能力・コーディング能力のいずれにおいても現行最高峰であり、まさに次世代を代表するAIモデルと言えるでしょう。

高度な推論モード「Deep Think」

このGemini 3.0にはさらに、高度な推論モード「Deep Think」も用意されています。

Deep Thinkモードでは、推論アルゴリズムを強化することで、Humanity’s Last Examで41.0%blog.google、新たな難関ベンチマークARC-AGI-2では45.1%blog.googleという従来比で飛躍的に高いスコアを記録。

Deep Thinkは、複数の仮説を並列に検討する並列思考(parallel thinking)によって推論性能を引き上げ、難しい数学・科学・論理問題のような「じっくり考える価値が高い」領域で力を発揮します。

Deep ThinkはGemini 3.0 Proの性能をさらに大きく引き上げるモードで、極めて難解な問題にも前例のない精度で挑むことが可能になっています。

Gemini 3.0 Proの日本語性能の特徴

普段使いで気になるのはベンチマークより適切な文章を出力してくれるか?です。

Gemini 3.0 Proは素朴な指示にはかなり強い一方、微妙なニュアンス調整や長い議論のニュアンスではChatGPTやClaudeに軍配が上がる場面がまだあります。

Gemini 3.0 Proの料金プラン

Gemini 3.0 ProはサブスクリプションとAPIでの利用の2通りがあります。料金はそれぞれ下記のようになっています。

| 項目 | Google AI Pro | Google AI Ultra |

|---|---|---|

| 料金 | 月額2,900円(税込) | 月額36,400円(税込) |

| こんな人向け | 個人の実務利用〜軽い開発まで。まずは普段使いをしたい人向け | 最上位体験や先行機能を利用したい人向け |

| Gemini 3 Pro へのアクセス | Gemini アプリ等で利用 | 同様に利用 |

| Deep Think | 提供状況はプラン・地域・ロールアウトに依存 | Ultra 加入者向けに提供。Gemini アプリで「Gemini 3 Pro」選択+プロンプトバーで「Deep Think」 |

上記はサブスクリプションのプラン表です。Google AI Ultraを契約すればDeep Thinkを利用できますが、Proとは10倍近く価格が異なります。

続いてはAPI料金です。単価はUSD/1Mトークン。なお Gemini 3.0 Proは「入力が20万トークンを超えるか」で単価が変わります。

| モデル | 入力 (≤200k) | 入力 (>200k) | 出力 (≤200k) | 出力(>200k) |

|---|---|---|---|---|

| Gemini 3 Pro | $2.00 | $4.00 | $12.00 | $18.00 |

| Gemini 3 Flash | $0.50 (text/image/video) $1.00 (audio) | $1.00 (text/image/video) $2.00 (audio) | $3.00 | $3.00 |

上記は基本となるテキスト入出力のAPI利用料金です。20万トークンを超えると価格が変わっているのがわかります。

| モデル | キャッシュ書き込み (≤200k) | キャッシュ書き込み (>200k) | 保管 |

|---|---|---|---|

| Gemini 3 Pro (preview) | $0.20 | $0.40 | $4.50 / 1M tokens /hour |

| Gemini 3 Flash (preview) | $0.05 (text/image/video) $0.10 (audio) | 同左の上位単価 | $1.00 / 1M tokens /hour |

また、上記はContext Caching時の料金になります。

| 項目 | 無料枠 | 超過単価 | 課金開始日 |

|---|---|---|---|

| Grounding with Google Search | 5,000 prompts /月 | $14 / 1,000 search queries | 2026年1月5日 |

最後がグラウンディングの料金です。課金は2026年1月5日から開始されています。

Gemini 3.0のライセンス

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕ |

| 改変 | ❌️ |

| 配布 | ❌️ |

| 特許利用 | ❌️ |

| 私的利用 | ⭕ |

Gemini 3.0は、Google DeepMindが独自開発したプロプライエタリ(クローズドソース)のモデルです。

そのため、モデルそのもの(学習済みパラメータ)は公開されておらず、ソースコードも含めオープンソースライセンスは適用されていません。

つまり、他社や個人がGemini 3.0の重みデータを入手して自由に利用・改変・再配布することはできず、Google提供のサービスやAPI経由で利用する形態となります。

一方で、Googleは、Gemini 3.0を多くのユーザーに使ってもらえるよう自社サービスに統合し、商用・非商用を問わず幅広い用途で活用できるよう配慮しています。以下に、Gemini 3.0の利用に関するライセンス面のポイントを整理します。

Gemini 3.0のアップデートまとめ

ここでは2026年1月19日時点でのGemini 3.0に関するアップデートを表形式でまとめます。

| トピック | ポイント |

|---|---|

| ① Gemini 3.0 Flash 正式リリース | FlashがGemini 3.0ファミリーとして展開。Geminiアプリ・検索AI Modeでデフォルト化、開発者向けにも提供面が拡大 |

| ② Gemini 3.0 Pro Image Preview(Nano Banana Pro) | 画像生成・編集のPro Image Previewがラインナップに追加 |

| ③ API料金更新(Searchグラウンディング課金開始) | 料金表が整備。特にGrounding with Google Searchの課金開始日が明記(2026年1月5日) |

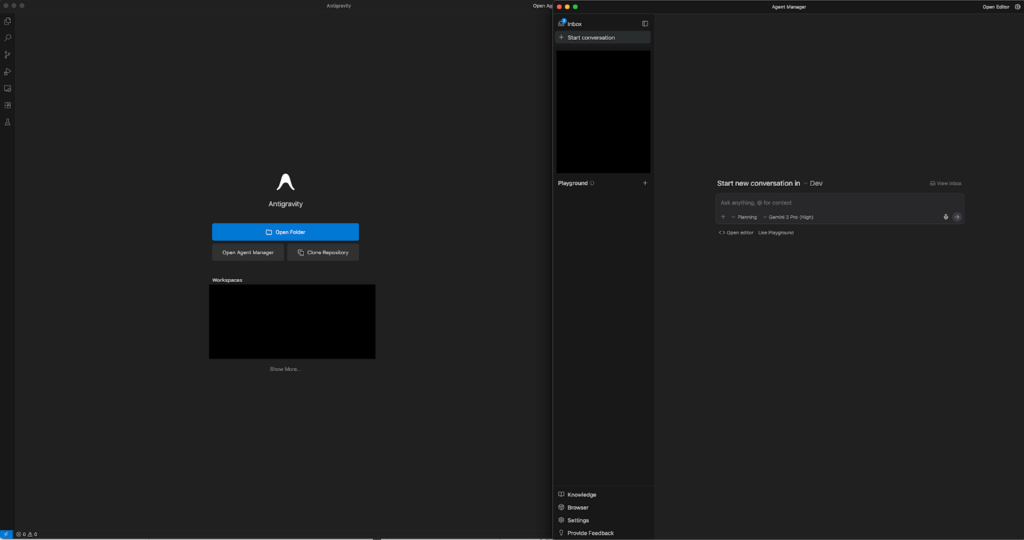

| ④ Google Antigravity 連携強化 | AntigravityにGemini 3.0 Flashが入り、エージェント開発の待ちを減らす方向 |

| ⑤ Gemini Agent / Deep Research の状況 | Deep Researchはモデルではなくエージェントとして提供。 |

Gemini 3.0の使い方

Gemini 3.0は一般ユーザー向けのアプリケーションから開発者向けのクラウドAPIまで、様々な方法で利用できます。それぞれのツールごとに、具体的な利用手順を解説します。

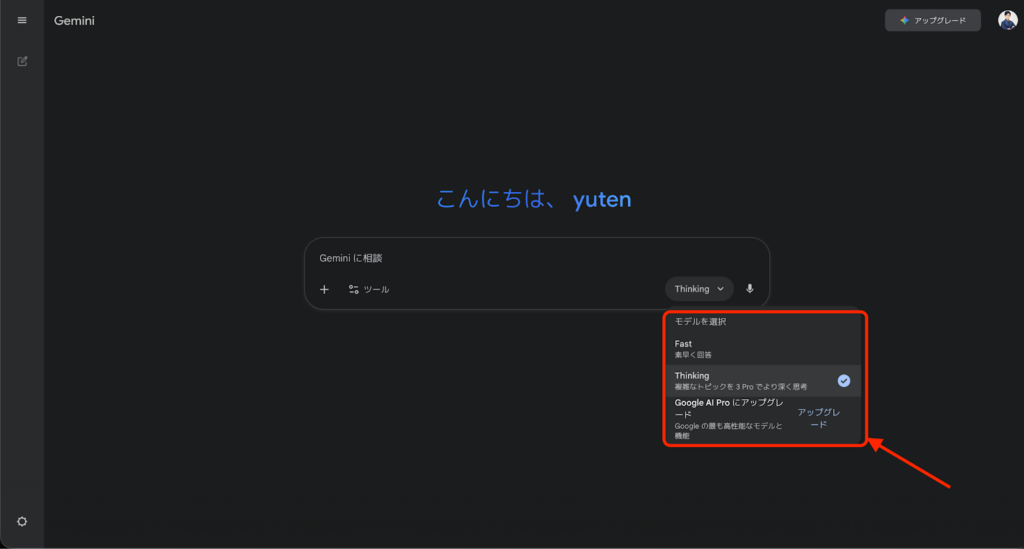

Geminiアプリでの使い方

まず一般利用者が最も手軽にGemini 3.0を体験できるのが、Google提供のGeminiアプリ(Gemini Canvas)です。使い方は次のとおりです。

1. アクセスとログイン

お使いのウェブブラウザでGeminiアプリのページにアクセスします。

Googleアカウントでログインすると、AIとのチャット画面が表示されます。

2. プロンプトの入力

画面下部の入力欄に質問や依頼内容を日本語で入力します。例えば、「今日のニュースを要約して」といったシンプルな質問から、「この写真の内容を説明して」と画像ファイルを添えて依頼することも可能です。

Gemini 3.0は、マルチモーダル対応しているため、画像やPDFをアップロードすれば、それらを理解した上で回答を生成してくれます。

質問内容が長文でも問題ありません。最大100万トークンという超長文にも対応しているため、例えば小説1冊分に相当するテキストを貼り付けて解析・要約させることもできます。

3. 応答の確認と対話の継続

送信すると、Gemini 3.0がクラウド上で推論を行い回答を表示します。回答は箇条書きや表形式、コードブロックなど内容に応じてリッチな形式で提示されます。

Gemini 3.0は従来モデルに比べ回答が簡潔かつ的確で、お世辞や冗長な前置きを避け「必要なことを率直に伝える」傾向があります。

回答内容を確認し、必要に応じて「○○について詳しく教えて」など追加の質問で対話を深めることができます。

Geminiは会話の文脈を深く理解するため、後から「それは具体的にどういう意味?」のように尋ねても前のやり取りを踏まえた説明が得られるかと思います。

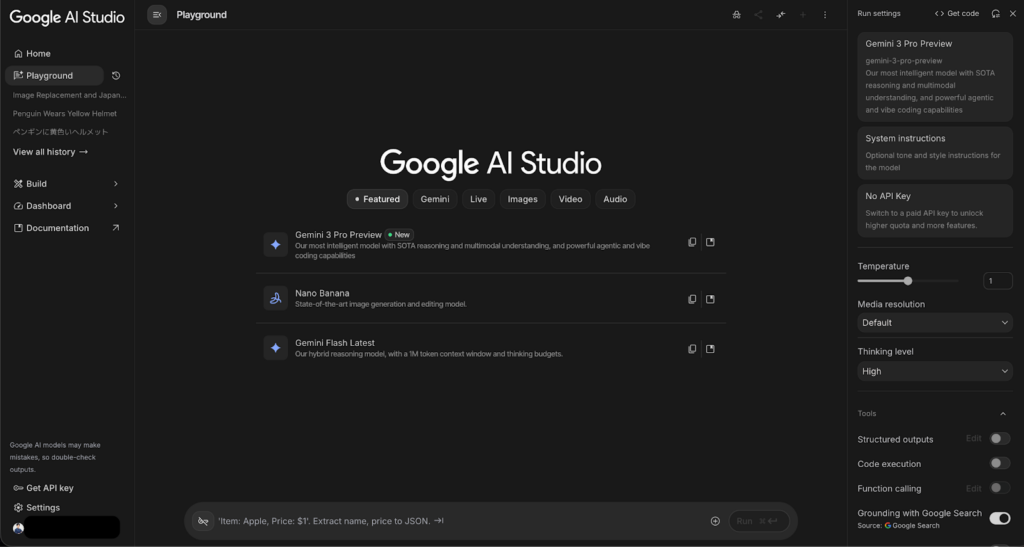

Google AI Studioでの使い方

開発者や高度なユーザー向けには、Google Cloud上のAI開発ツール「Google AI Studio」でGemini 3.0を使う方法があります。

AI Studioは、ブラウザ上で動作する統合開発環境で、APIキーの発行やモデル呼び出しテスト、データのアップロードなどを視覚的に行うことができます。

1. プロジェクトの準備

まずGoogle Cloudアカウントを用意し、Google AI Studioにアクセスします(事前にGoogle Cloud上で課金設定やVertex AI APIの有効化が必要です)。

AI Studioにログインしたら、新規プロジェクトを作成します。無料枠で試す場合でもこのプロジェクトが必要になります。

2. モデルのテスト実行

AI Studio上で、対話インターフェースを開きます。

テキスト入力欄にプロンプトを書いて、「実行(Run)」ボタンを押すとGemini 3.0からの応答が右側ペインに表示されます。

これによって、APIをコードから呼び出す前に対話形式で出力を確認することができます。

例えば、商品レビューの要約やコード生成などをここで試し、モデルの出力傾向を把握できます。AI Studioのプレイグラウンドでは画像やPDFを入力に与えることもでき、Geminiのマルチモーダル応答を確認できます。

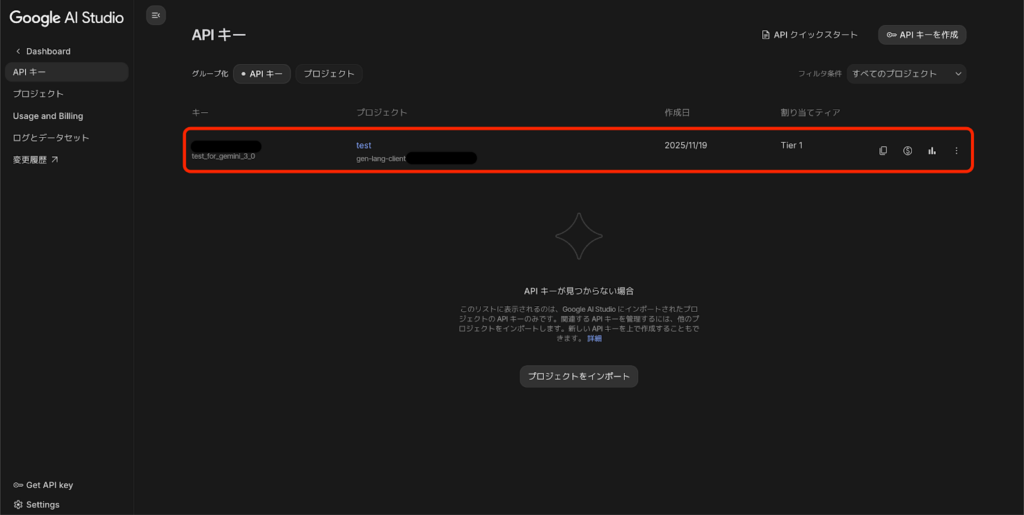

3. APIキーの取得

自作アプリケーションからGemini 3.0を利用する場合、AI Studio APIキー作成ページからAPIキーを発行します。

AI Studioのダッシュボードで「APIキーを作成」ボタンを押し、表示されたキーを安全な場所に控えます。

このキーはプログラムからGemini APIを呼び出す際に必要となるシークレットキーです。

無料枠では1分あたりのリクエスト数など制限がありますが、このキーを使えば制限内で自由にGeminiにアクセスできます。

4. コードへの組み込み

発行したAPIキーを用いて、お好みのプログラミング言語からGemini APIを呼び出します。

Googleは公式にPython用SDKやREST APIエンドポイントを提供しており、それを利用することができます。

例えば、Pythonでは、google.generativeaiライブラリをインポートし、先ほどのAPIキーを指定してクライアントを初期化、そしてgenerate_text()メソッド等でGemini 3.0に問い合わせることができます。

テキスト生成だけでなく、画像解析やコード実行といった拡張機能も関数で呼び出せます(必要な権限設定や追加のAPI有効化がある点に注意しましょう)。

5. 応答結果の処理

API経由で取得したGeminiの応答はJSON形式で返ってきます。

これを自分のアプリで扱いやすい形(テキスト抽出やHTMLレンダリングなど)に変換します。

例えば、チャットボットに統合するなら、ユーザーの質問に対してAPIから得た回答テキストをそのまま表示すれば完了です。

ビジネスアプリに組み込む場合は、生成結果をデータベースに保存したり、別の関数に受け渡したりして自動処理のワークフローに組み入れることもできます。

Google CloudのVertex AIでは、このような一連の呼び出しをワークフローやパイプラインとして管理する仕組みも用意されているので、気になる方はのぞいてみてください。

その他のツールでの使い方

Gemini 3.0は、上記以外にも様々なツールやプラットフォームで利用可能です。

例えばGemini CLIというオープンソースのコマンドラインツールが提供されており、開発者はターミナル上でGeminiと対話することができます。

Gemini CLIを使えば、プログラミング中にエディタから離れずに、コードの質問をしたり補完を得たりすることが可能です。

インストール方法はGitHub上で公開されており、CLI起動後にGoogleアカウントでログインすると無料のCode Assistライセンスで一定回数まで利用できます。

さらに、JetBrainsやVS CodeといったIDE向けにはGemini Code Assistプラグインが公式提供されており、エディタ内でGeminiにコードレビューやリファクタリングを頼むこともできます。

なお、Gemini CLIについて詳しく知りたい方は、以下の記事も参考にしてみてください。

Gemini 3.0 ProとGemini 3 Flashの違い・使い分け

Gemini 3.0 Proを使うかFlashを使うべきか迷った場合には以下のように分けると良いでしょう。

品質と詰めの推論を最優先するならPro、速度とコスト効率を重視するならFlash。

Gemini 3.0 Proは、推論力やマルチモーダル処理、エージェント運用まで含めた総合性能を重視したフラッグシップモデルです。

難易度の高いタスクや長文処理でも破綻しにくく、最終成果物の品質を担保したい場面で力を発揮します。

一方のGemini 3 Flashは、品質を維持しながらも、低レイテンシと低コストを徹底的に追求したモデルです。

大量処理や反復的なタスク、ユーザー体験としてのレスポンス速度が重要なプロダクトでは、Flashの方が扱いやすくなります。

またAPI料金では、Proは出力単価が高めに設定されており、特に20万トークンを超える長文入力ではコストが跳ね上がります。Flashは入力・出力ともに単価が低く、無料枠も用意されているため、回せば回すほどコスト効率が効いてくる設計です。

使い分けの一例

下記に使い分けの例としていくつか紹介をしますので、参考にしてください。

| 利用シーン | 向いてるモデル | 具体例 |

|---|---|---|

| 重い推論・失敗できない成果物 | Gemini 3.0 Pro | 要件が複雑な仕様策定、矛盾検出を含むレビュー、長文ドキュメントの整合性チェック・一発で通す提案書・設計書 |

| 高速レスポンス・大量処理 | Gemini 3.0 Flash | FAQ生成、文書の一括要約、ログ・チケット分類、抽出・チャットUIなど体感速度が価値の場面 |

| 実務の定石 | Flash → Pro | 下書き・一次生成はFlash、最終レビュー・品質保証はProなどミスが許されない文書など |

| 長文運用の注意 | Pro利用時は設計必須 | 20万トークン超で単価アップ。長文を頻繁に扱うならContext Cache前提が現実的 |

Gemini 3.0 Proと他モデル(GPT-5.1/Claude/Gemini 2.5)の比較

Gemini 3.0 Pro以外にもその他のモデル、GPTやClaudeなど色々ありますが、その中でどういったモデルを選べばいいのかというのは多くの方が悩まれるかと思います。

ここではGeminiを使うべきかGPTなのかClaudeなのかということについて解説をしていきます。

主要ベンチマークの比較

下記のベンチマークを比較してみると、Gemini 3.0 Proは難易度が高く、途中で崩れやすいタスクに強いという傾向がはっきりしています。

学術推論や高度な知識を問うHumanity’s Last ExamやGPQA DiamondではGemini 3.0 Proが安定して高スコアを記録しており、長い推論や整合性が求められるタスクに強いことが分かります。

一方で、SWE-bench VerifiedやToolathlonなど「エージェントを高速に何度も回す」系の指標では Gemini 3.0 Flashが非常に強く、低レイテンシかつ低コストで周回させる用途に向いています。

コーディング単体や数学の一点突破ではGPT-5.2が最高値を出す場面もありますが、Terminal-benchやLiveCodeBenchのような実務寄りの複合タスクではGemini 3.0 Proが最上位クラス。

Claude Sonnet 4.5は多くの指標で中位に位置し、数値上は突出しないものの、文章の自然さや対話品質を重視する運用では依然として有力な選択肢と言えます。

価格面を見ると、Gemini 3.0 Flashは入力・出力ともに圧倒的に安く、常時運用やPoC向きです。Gemini 3.0 Pro は明確に高単価ですが、その分「失敗できない最終出力」を任せる価値があります。

上記をまとめると下記のようになります。

| モデル名 | 使いどき |

|---|---|

| Gemini 3.0 Pro | 要件が多く、途中で壊れると致命的なタスク。長文の整合性チェック、仕様策定、医療・法務ドキュメント、エージェントの最終判断など「失敗できない場面」。 |

| Gemini 3.0 Flash | 高速レスポンスや大量処理が必要なとき。下書き生成、分類・抽出、チャットUI、エージェントの周回処理など「回して当たりを出す」用途。 |

| GPT | 数学・アルゴリズム・単発のコーディングなど、正解が明確な問題を一気に解きたいとき。専門家的な一点突破が欲しい場面。 |

| Claude | 文章の自然さや人間味が成果に直結する場面。メール返信、説明文、ナレッジ記事、対話文など、読み手の感情やトーンを重視する用途。 |

どのモデルを選ぶべきか?

どのモデルを選ぶべきかは、4つの観点で見ると判断しやすくなります。

まず日本語の自然さという点では、Claudeは元の文章のニュアンスや文体を保ったまま書き直す、整えるといった運用と相性が良いモデルです。

既存の文章をベースにした編集、トーン調整、メールの返信などでは、原文への追従性が高く、人間らしい表現になりやすい傾向があります。

一方、Gemini 3.0 Proは「簡潔で直接的」な出力を目指しており、原文を尊重するというより、業務文書として不要な表現を削ぎ落とす用途に向いています。

エージェント性能という観点では、Gemini 3.0 Proがツールを使いながら最後まで完走するタイプのタスクに強く、複雑な手順や長い文脈でも破綻しにくいのが特徴。

一方でGemini 3.0 Flashは低遅延・低コストで反復処理を回すのに向いており、エージェントを何度も走らせる運用で力を発揮します。

マルチモーダルの観点では、Gemini 3.0 ProとFlashはいずれも、PDF、表、画像が混在する入力への対応力が強いです。Flashは速度と効率を落とさず扱えるため、実装面でも導入しやすい立ち位置にあります。

価格でいうと、Gemini 3.0 Proは高単価で、特に長文前提の運用では設計上の注意が必要です。一方、Gemini 3 Flashは単価が低く無料枠もあるため、PoCや常時運用に向いているといえます。

Gemini 3.0 ProとGoogle AntigravityでのAIエージェント開発

Antigravityは、従来の「IDEの横にチャットを置く」構成とは異なります。

エディタで人がコードを書く一方、エージェントマネージャーでは複数のエージェントを並列で走らせ、さらにブラウザでは調査や検証を含む操作を分離して行います。

もう一つ重要なのが、成果物を中心にレビューできる設計です。

エージェントのログやツール呼び出しの履歴ではなく、タスクリストや実装計画、スクリーンショット、ウォークスルーといった「人が判断しやすい形」で結果を残してくれます。

エージェント開発で起きがちな「何をやったのか分からない」という不安を、成果物ベースの確認に寄せて軽減しているわけです。

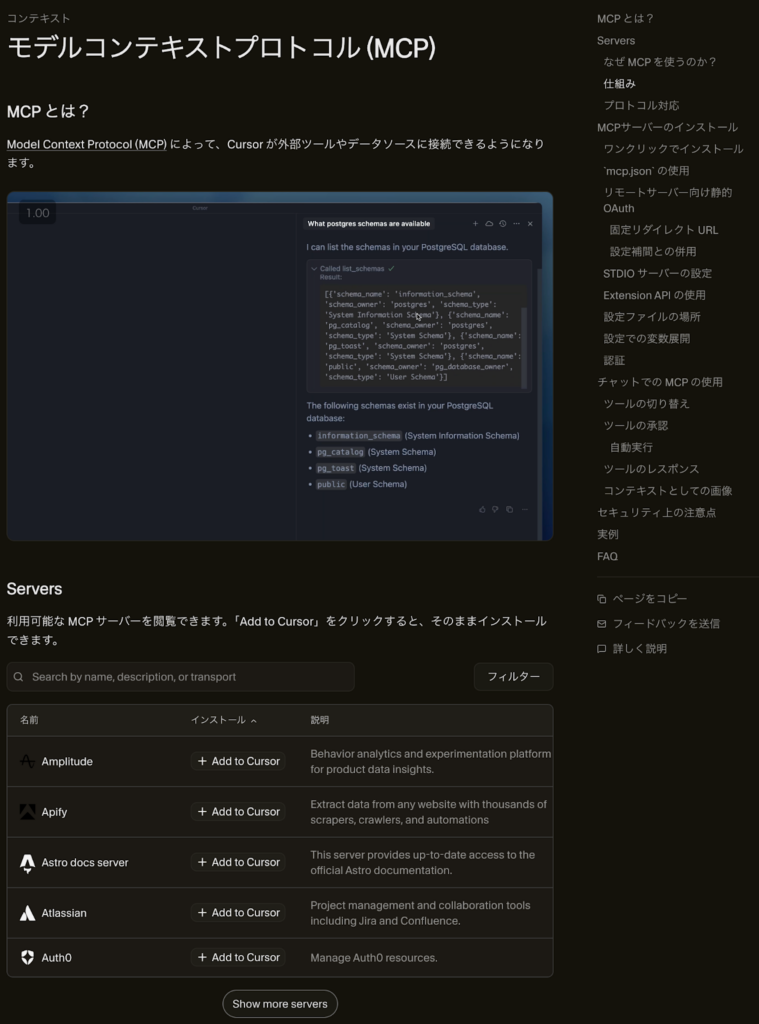

MCP対応

AntigravityはMCPに対応しており、MCPによりIDEと社内外のデータ、ツール、SaaSを安全に接続することができます。

MCPでできることは大きく分けて2種類あり、Context ResourcesとCustom Toolsです。

Context Resourcesは、DBスキーマやログ、外部ドキュメントなどを読み込ませ、提案や生成の精度を底上げ。

一方でCustom Toolsは、Issue作成や検索といった、限定的で安全な操作をツールとして呼び出します。

さらにAntigravityにはMCP Storeが用意されており、GitHub、Notion、Figma Dev Mode、Firebase、BigQuery、Cloud SQL、Linear、SonarQube、Stripe、Supabaseなど、実務で使われがちな統合が最初から揃っています。

外部IDE・外部ツール連携

ここで言う「連携」は、 Antigravityと他IDEが直結するという話ではありません。そうではなく、Gemini 3.0 Proを使う環境が増えていて、各IDEや各エージェントがMCPなどを介して外部ツールに繋がるというものです。

JetBrains

JetBrainsのAI AssistantはMCPに対応しており、STDIO/Streamable HTTP 経由でMCPサーバーへ接続できます。さらに、JetBrainsのIDE自体をMCPサーバーとして動かし、外部クライアントからIDE操作を受ける構成も案内されています。

Cursor

CursorもMCPに対応しており、GitHubやNotion、PostgreSQLなどと繋ぐことができます。そのほかにも公式ドキュメントが用意されているので、そこから確認が可能です。

Manus

Manusは MCP connectors を使い、複数の業務ツールを横断して動くエージェント化を前面に出しています。例として、Notion+Google Calendar、Gmail+資料分析、HubSpot+Notionのように、複数SaaSを活用する方法があります。

Gemini 3.0 Proのビジネス活用例

Gemini 3.0 Pro は「長文・複雑・マルチモーダル」をまとめて扱えるのが強み。読む→考える→整える→次アクションまでを一気に出力してくれます。

そのため次の3領域で活用しやすいのではないでしょうか。

リサーチ・文献調査

Gemini 3.0 Proが最も力を発揮する用途の一つが、リサーチや文献調査。

単なる検索や要約に留まらず、調査テーマの定義から情報収集、精読、比較、示唆の抽出までを一連の流れとして回せる点に価値があります。

特に、社内の意思決定にそのまま使える「出典付きの調査メモ」を作れることは大きな強みです。

Gemini APIには、複数ステップの調査をバックグラウンドで実行できるDeep Research Agentが用意されており、時間のかかる調査タスクを放置で実施可能。

コード生成・レビュー・エージェント開発

Gemini 3.0 Proは、単発でコードを書かせるよりも、既存コードベースを理解した上で設計から実装、テスト、レビュー、修正までを往復する作業に向いています。

コード全体の意図や依存関係を踏まえた指摘が出やすく、影響範囲や潜在的なバグ、セキュリティ観点まで含めて整理できる点が特徴です。

リファクタリングにおいても、最小差分で安全に進める手順や後方互換への注意点を含めて整理できるため、実務での手戻りを減らしやすい点が評価できます。

営業資料/スライド生成

営業資料やスライド作成の領域でも、Gemini 3.0 Proは実務向きです。

メモ、議事録、競合比較、要件定義、FAQなど、粒度がバラバラな情報をまとめ、「商談で使える構成」へ再編集する工程を得意とします。

特に、長い説明を短く刺さる表現へ落とし込む作業、たとえばタグラインや見出し、比較軸の設計で効果を発揮します。

Gemini 3.0 Proで使える実践プロンプト集

ではここでいくつかGemini 3.0 Proで使える実際のプロンプトを紹介します。あくまでも一例なので、本プロンプトを参考に改変して使ってみてください。

長文レポート要約用

まずは長文を要約したい場面で使う時のプロンプトです。

あなたは経営企画のアナリストです。

以下のレポートを読み、意思決定者向けに1枚で要約してください。

制約:

- 推測は禁止

- 本文中の根拠(該当箇所の要約)に紐づけて書く

- 分からない点は「不明」と明記する

出力形式:

1. 結論(3行)

2. 重要ポイント(最大7つ、各1行)

3. リスク/前提(最大5つ)

4. 次アクション(着手順に3つ)

5. 追加で確認すべき質問(最大5つ)

【レポート本文】

(ここに貼る)

質問:上の形式で出力して。LLMに対して役割を与えるべきか否かという話もありますが、役割を与えること自体はネガティブな結果にならないと考え、本プロンプトでは役割を与えています。

また、LLMのハルシネーションを防ぐポイントとしては、「不明」「わからない」などという出力を明示的に許可することも必要です。

コードリファクタリング用

次にコードリファクタリングのプロンプトです。AntigravityやCursorを使っている場合には、コードをコピペするのではなく、ファイルパスを渡すなどで代替可能です。

あなたはシニアエンジニアです。

以下のコードをリファクタリングしてください。

ゴール:

- 可読性・保守性の向上

- 挙動は変えない

制約:

- 変更は最小差分

- 関数の入出力は維持

出力:

1. 問題点(箇条書き)

2. 改善方針(3点)

3. 変更後コード(全文)

4. 追加すべきテスト(pytest想定、ケース列挙)

【コード】

…

質問:上の形式でリファクタ案を出して。スライド自動生成用

続いてスライド作成です。本記事後半でも実際にスライド作成をしていますので、そちらも参考にしてみてください。

あなたはB2B営業の提案資料作成担当です。

以下の素材から、10枚のスライド構成案を作ってください。

制約:

- 1枚あたり箇条書き3点まで

- 難語は避ける

- 顧客の課題 → 解決 → 根拠 → 導入の順

出力:

- タイトル案(3つ)

- スライド10枚(見出し+箇条書き3点)

- 口頭補足(各スライド1〜2文)

- 想定QA(5つ)

【素材】

…

質問:上の形式で出力して。要件定義→設計書ドラフト生成用

最後に要件定義から設計書のドラフト作成です。壁打ちをしながら構成を整え、一旦話をまとめてから要件定義に入るとスムーズに進みます。

また、機能のみならず非機能の要件定義も指示を与えればしてくれます。

あなたはテックリードです。

以下の要件メモから、基本設計書のドラフトを作ってください。

ルール:

- 確定していない点は断定せず「要確認」と書く

- 矛盾があれば指摘する

出力:

1. 目的・スコープ

2. ユースケース(主要3つ)

3. 画面一覧(画面名 / 目的 / 入出力)

4. データモデル案(エンティティ / 主キー / 主要属性)

5. API案(エンドポイント / 入出力 / 認可 / エラー)

6. 非機能要件(性能 / 監査ログ / 可用性 / セキュリティ)

7. 未確定事項・質問リスト(最大15)

【要件メモ】

…

質問:基本設計ドラフトを作って。あくまで一例なので上記をもとにプロンプトを作り込んでいくのが良いでしょう。

Gemini 3.0 Proを業務で使う際の注意点

法人・業務利用で気をつける点が、「無料枠で試したものをそのまま本番に出せるのか」と「入力したデータが学習に使われないのか」という2点です。

無料枠でGemini 3.0 Proは使えない

Gemini 3.0 Proは無料枠ではAPI利用できません。

料金表上、Gemini 3.0 Proは無料枠が「Not available(利用不可)」と明記されており、「まずは無料で3.0 ProをAPI接続してPoC」という進め方はできません。

一方で、Gemini 3 Flashは無料枠が提供されています。速度感や出力品質、プロンプト設計、JSON出力、ツール呼び出しなどを試す入口としてはFlashが使えます。

有料なら入力データは学習に使われない

課金設定をしている場合には、「プロンプトおよびレスポンスを製品改善に使用しない」と明示されています。※1

つまり、課金を有効化したAPI利用であれば、入力データがモデル改善の学習に使われることはありません。

一方で、無料枠やGoogle AI Studioでは、「提出したコンテンツや生成物が製品改善やML技術の開発に使われうる」「人手レビューが入る場合がある」「機密情報や個人情報を入力してはならない」と明記されています。

Gemini 3.0を使ってみた

ここからは実際にGemini 3.0を使いながら性能をみていきます。

スライド生成

まずは、SNS上でも話題になっている「スライド生成」を試してみましょう。プロンプトはテキトーに以下の通りとします。

Gemini 3.0についてまとめたスライドを作ってワンショットでこのクオリティは評判通りの性能の高さですね。プロンプトさえ工夫すれば、簡易なスライド生成にかける時間はほぼゼロにできるかもしれません。

ゲーム生成

続いて、ゲーム生成をしてもらいましょう。

WebXR対応の将棋ゲームを作ってこちらもかなりテキトーなプロンプトではありますが、ワンショットでこれを出してくれました。

無料プランで色々試していたら上限に達してしまいましたので、試行はここまでとしますが、他にも3D生成やサイト作成、アプリ制作などもハイクオリティで実行してくれるという声も多々あがっていますので、気になる方はぜひ試してみてください!

Gemini 3.0 Proに関するよくある質問

最後にGemini 3.0 Proに関してよくある質問に回答していきます。

まとめ

「Gemini 3.0 / 3.0 Pro」は、Google DeepMindが送り出す最新のAIモデルであり、高度な推論力とマルチモーダル処理により、専門的な課題から日常の些細な質問まで幅広く対応でき、ユーザーの創造力や生産性を飛躍的に高めてくれます。

実装面では、オープンソースではないものの、その分Googleの強力なインフラと安全管理のもとで安定したサービスが提供されており、個人利用から商用利用までスムーズに活用できる点も魅力です。

ぜひ皆さんもGemini 3.0の性能を味わってみてください。

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。