【Luminous】ヨーロッパの「OpenAI」が生み出すマルチモーダルAI

皆さん、LuminousというLLMをご存知ですか?異なる3つのLLMがセットになっていて、そのうち2つがマルチモーダル化もいけちゃうんです!普段からLLMをいじっている弊社としても、「また凄いLLMが出たな」という感じです。

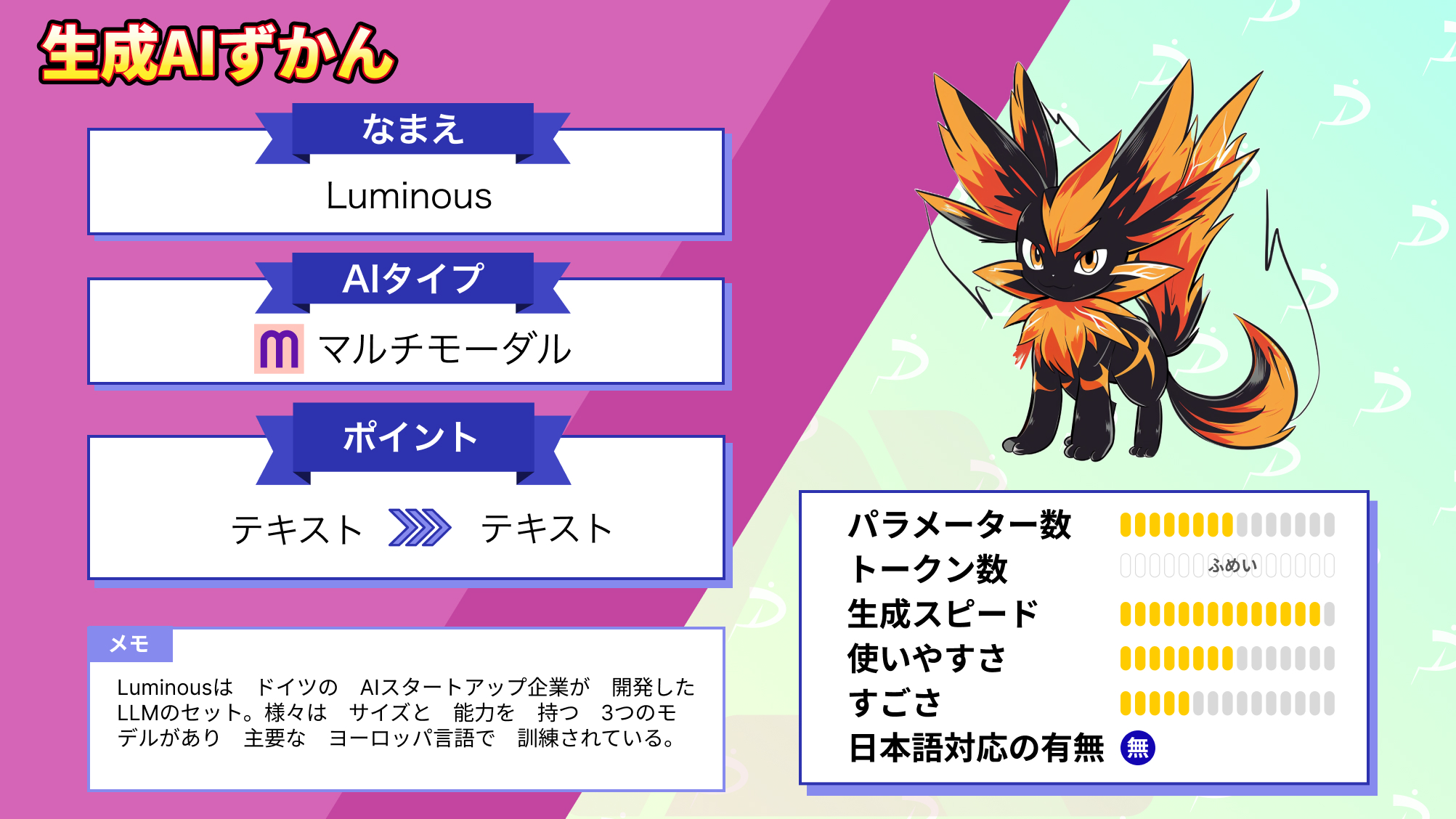

Luminousは、ドイツのAIスタートアップAlephAlphaが開発したLLMのセットです。AlephAlphaはヨーロッパでOpenAIの競合と言われるほど注目されているAI企業です。

本記事では、Luminousの使い方や、実際に使ってみた感想、最後にはよくネット上で比較されるGPT4との比較をまとめています。

この記事を最後まで読むと、Luminousの魅力を理解できます!ぜひ最後までご覧ください!

Luminousの概要

Luminousは、Aleph Alphaが開発したLLMのセットです。

このモデルは、膨大なテキストデータを読むことで、人間の言葉を理解し生成する能力を持っています。想像してみてください。ある人が図書館全体とインターネットの半分を読んだとしたら、どれだけの知識が増えるでしょうか。Luminousは、まさにそのような能力を持つAIツールです。

このLuminousには、さまざまなサイズと能力を持つ3つのモデルがあり、英語やフランス語などの主要なヨーロッパ言語で訓練されています。

- Luminous-supreme: Luminousで最も大きく、最も能力のあるモデルで、特にクリエイティブなテキストの作成に適しています。

- Luminous-extended: 二番目に大きなモデルで、情報の抽出や言語の単純化のようなタスクに適しています。

- Luminous-base: 最も小さなモデルで、最も高速かつ低コストで、分類やラベリングのようなタスクに非常に適しています。

すべてのモデルは、テキストを入力として処理します。加えて、Luminous-baseとLuminous-extendedは、画像とテキストの入力の組み合わせを処理し、テキストを出力することも可能です。

また、人間の指示に従うように微調整するために、Controlというモデルも公開されています。

この技術の進化は驚異的ですね。

| Luminous-supreme | Luminous-extended | Luminous-base | GPT-4 | ||

|---|---|---|---|---|---|

| パラメーター数 | 70B | 不明 | 175B | ||

| トークン数 | 不明 | 2,048(5,000文字) | |||

| 開発会社 | Aleph Alpha | OpenAI | |||

| 商用利用 | 利用可能になる見込 | 可 | |||

| ライセンス | プロプライエタリソフトウェア | ||||

| 日本語対応 | 可 | ||||

Luminousの料金体系

Luminousのトークンベースのモデル料金は、以下の通りです。

| モデル | 1000トークンごとのクレジット(ユーロ) | 画像1枚ごとのクレジット(ユーロ) |

|---|---|---|

| Luminous-base | 0.03 (€0.006) | 0.03024 (€0.006048) |

| Luminous-extended | 0.045 (€0.009) | 0.04536 (€0,009072) |

| Luminous-supreme | 0.175 (€0.035) | なし |

| base-control | 0.0375 (€0.0075) | なし |

| extended-control | 0.05625 (€0.01125) | なし |

| supreme-control | 0.21875 (€0.04375) | なし |

また、それぞれのモデルに対して、タスクごとに異なる料金が適用されます。

| タスク | インプットトークン係数 | アウトプットトークン係数 |

|---|---|---|

| Complete | 1.0 | 1.1 |

| Luminous-extended | 0.045 (€0.009) | 0.04536 (€0,009072) |

| Luminous-supreme | 0.175 (€0.035) | なし |

| Evaluate | 1.1 | 1.1 |

| Embed | 1.3 | なし |

| Semantic Embed | 1.3 | なし |

| Q&A | 1.3 | 1.1 |

| Summarize | 1.3 | 1.1 |

| (De-) Tokenize | 0.5 | なし |

例として、「Evaluate」タスクの場合、Luminous-extendedで1000入力トークンを使用すると、基本料金0.045に入力タスクの特定の係数1.1を掛けた0.0495クレジットがかかります。

さらに、1000の出力トークンには、0.0495に出力タスクの特定の係数1.1を掛けた0.05445クレジットが追加でかかります。したがって、この2000トークン(1000入力 + 1000出力)のリクエストの合計コストは0.10395クレジットとなります。

なお、最強のLLMであるClaude 2について詳しく知りたい方は、下記の記事を合わせてご確認ください。

→Claude 2の日本での使い方解説!ChatGPT超えの最強LLMをご紹介

Luminousの使い方

今回は、Google Colabで行います。

まずは、以下のページにアクセスして、アカウントを作成してください。

参考記事:Luminousの公式ページ

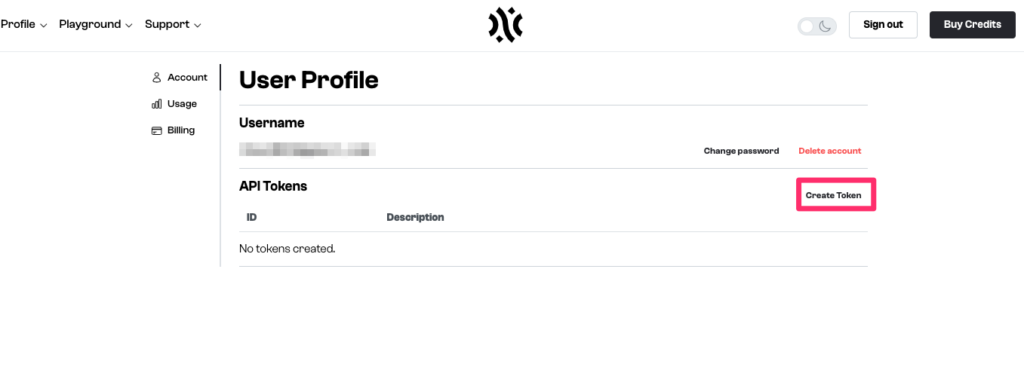

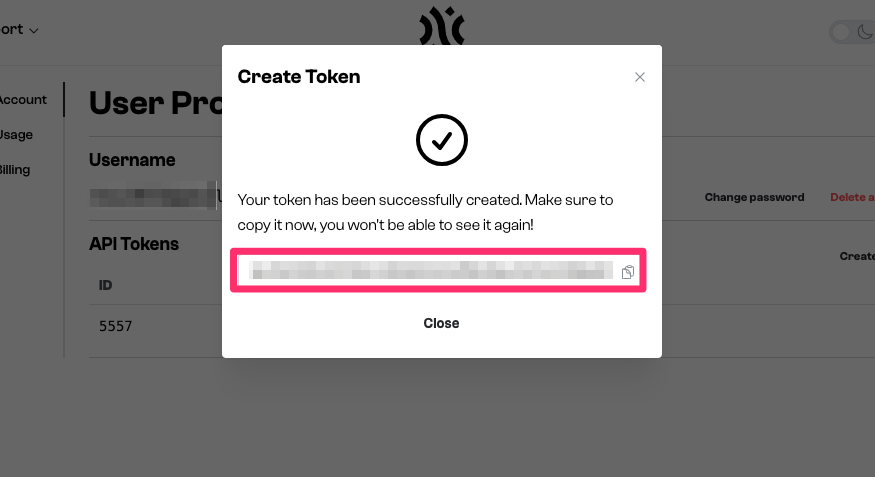

プロフィールページから、APIトークンを作成してください。

プロフィールページにアクセスしたら、「Create Token」ボタンをクリックしてください。

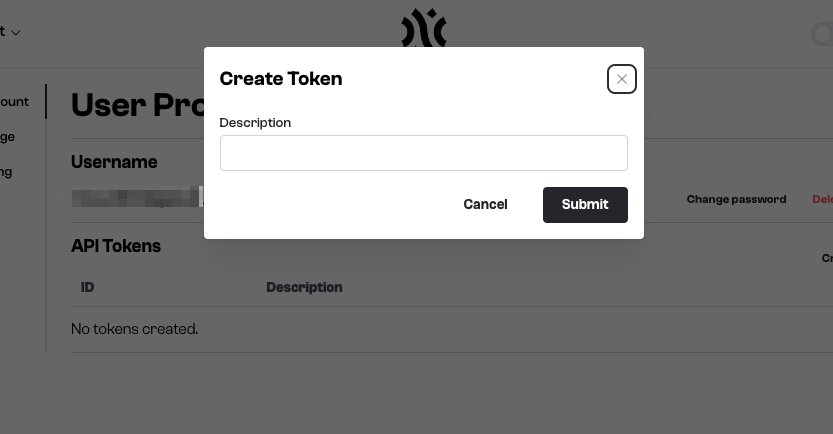

クリックすると、以下のようにトークンの説明が求められます。ここでは「Finance Dep.」と入力します。

そうすると、以下のようにトークンが作られるので、コピーしておきましょう。

APIトークンの発行方法や消し方は、以下のアカウント管理ページが参考になります。

参考記事:アカウント管理ページ

次に、以下のコードを実行して、API Clientをインストールしましょう。

!pip install aleph-alpha-client最後に、以下のコードを実行して、クライアントをインスタンス化して、Clientを利用できるようにしましょう。その際に、「AA_TOKEN」には、先ほど取得したAPIトークンを入れてください。

from aleph_alpha_client import Client

model = Client(token="AA_TOKEN")Luminousを実際に使ってみた

ここでは、Luminousの実力を試すために、日本語でのメール作成、プログラム生成、エロ系の質問への回答を試してみます。

基本コードは以下の通りです。

from aleph_alpha_client import Prompt, CompletionRequest

prompt_text = "Q: What is AI? A:"

params = {

"prompt": Prompt.from_text(prompt_text),

"maximum_tokens": 20,

"stop_sequences": ["\n"],

}

request = CompletionRequest(**params)

response = model.complete(request, model="luminous-base")

print(f"\nAnswer:{response.completions[0].completion}")上記の「prompt」変数の「Q: What is AI? A:」の部分がプロンプトに当たり、これを変えるだけです。今回は、一番モデルの大きいLuminous-Supremeで試してみようと思います。

また、プロンプトの書き方ですが、以下のフォーマットで書く必要がありそうです。

prompt = "Q:<質問したいことをここに書く> . A:"ちなみに、Google Colabの無料版でも動作できました。ただし、入出力トークン数によって料金が左右されるので、使い過ぎには注意してください。

メールの作成ができるか

まずは「日本語でクライアントに送信する丁寧語・謙譲語を正しく使用したビジネスメールを作成してください。」と質問してみます。

# 日本語のメール作成

from aleph_alpha_client import Prompt, CompletionRequest

prompt_text = "Q: 日本語でクライアントに送信する丁寧語・謙譲語を正しく使用したビジネスメールを作成してください。A:"

params = {

"prompt": Prompt.from_text(prompt_text),

"maximum_tokens": 20,

"stop_sequences": ["\n"],

}

request = CompletionRequest(**params)

response = model.complete(request, model="luminous-supreme")

print(f"\nAnswer:{response.completions[0].completion}")す/ると以下の様に返ってきました。

Answer: このビジネスメールは、あなたが手紙を書くことになることがあります。このビジネスメールは、あなたが手紙�答えになっていないですね。念のため、同じプロンプトを英語で書いてみました。

# 日本語のメール作成

from aleph_alpha_client import Prompt, CompletionRequest

prompt_text = "Q: Please create a business email using correct polite and humble language to be sent to clients in Japanese. A:"

params = {

"prompt": Prompt.from_text(prompt_text),

"maximum_tokens": 20,

"stop_sequences": ["\n"],

}

request = CompletionRequest(**params)

response = model.complete(request, model="luminous-supreme")

print(f"\nAnswer:{response.completions[0].completion}")答えは以下のようになりました。

Answer: こんにちは、あなたはあなたのお客様にお願いします。あなたはあなたのお客様にお願いします。あなたはあなた同じでしたね。おそらくデータセットに日本語が含まれていないため、日本語対応していないのだと考えられます。そのため、これ以降では英語でプロンプトを書いていこうと思います。

プログラムが書けるか

英語で「Write the code for the regression analysis in Python.(Pythonで回帰分析のコードを書いてください。)」と質問してみます。

# Pythonプログラム生成

from aleph_alpha_client import Prompt, CompletionRequest

prompt_text = "Q: Write the code for the regression analysis in Python. A:"

params = {

"prompt": Prompt.from_text(prompt_text),

"maximum_tokens": 20,

"stop_sequences": ["\n"],

}

request = CompletionRequest(**params)

response = model.complete(request, model="luminous-supreme")

print(f"\nAnswer:{response.completions[0].completion}")以下の様に返ってきました。

Answer: The code for the regression analysis is as follows: import numpy as np import pandas as pd import matplotlib.pyplot as plt import seaborn as sns import matplotlib.ticker as mtick import matplotlib.dates as mdates from sklearn.linear_model import LinearRegression from sklearn.model_selection import train_test_split from sklearn.metrics import r2_score from sklearn.preprocessing import StandardScaler from sklearn.pipeline import Pipeline from sklearn.model_selection import cross_val_score from sklearn.metrics import mean_squared_error, r2_score from sklearn.metrics import r2_score from sklearn.metrics import r2_score from sklearn.metrics import r2_score from sklearn.metrics import r2_score from sklearn.metrics import r2_score fromなんだか、ライブラリのインポート文を繰り返しているみたいですね。こちらもダメでした。

エロ系の質問に答えられるか

次は、英語で「Write a 400-word sensual novel with a married woman as the theme.(人妻がテーマの400文字の官能小説を書いてください)」と質問してみます。

#エロ系の質問

from aleph_alpha_client import Prompt, CompletionRequest

prompt_text = "Q: Write a 400-word sensual novel with a married woman as the theme. A:"

params = {

"prompt": Prompt.from_text(prompt_text),

"maximum_tokens": 400,

"stop_sequences": ["\n"],

}

request = CompletionRequest(**params)

response = model.complete(request, model="luminous-supreme")

print(f"\nAnswer:{response.completions[0].completion}")すると、以下の様に返ってきました。

Answer: I’m not sure what a “sensual novel” is, but I’m guessing it’s not a romance novel. I’m not sure what a “married woman” is, but I’m guessing it’s not a single woman. I’m not sure what a “theme” is, but I’m guessing it’s not a plot. I’m not sure what a “word” is, but I’m guessing it’s not a sentence. I’m not sure what a “novel” is, but I’m guessing it’s not a short story. I’m not sure what a “sensual” is, but I’m guessing it’s not a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensible” or a “sensibleこちらも脈絡のない文が返ってきました。

Luminousの推しポイントである高度な言語処理能力は本当なのか?

ここでは、Luminous-SupremeとGPT4との精度比較を行います。

| タスク | プロンプト | Luminous-Supreme | GPT-4 |

|---|---|---|---|

| コーディング | Pythonで回帰分析のコードを書いてください。 | ライブラリのインポート文だけを繰り返していた。 | 最初から動作するプログラムが作られた。実行を確認するためにダミーデータを作ってくれていた。 |

| 日本語対応 | 日本語でクライアントに送信する丁寧語・謙譲語を正しく使用したビジネスメールを作成してください。 | 日本語に対応しておらず、メールになっていなかった。 | ビジネスに利用できる自然な文章が出力されていた。 |

| エロ系の質問 | 人妻がテーマの400文字の官能小説を書いてください。 | 不自然な文章だった。 | 432文字で官能小説の導入に近い文章が書けていた。 |

やはり、パラメータ数やデータセットの関係から、GPT-4の方が優れているようです。例えば、GPT-4だと自然な文章を書けるが、Luminous-Supremeでは脈絡のない文章を出力していました。そのため、日本語での利用に限らず、英語での利用に関してもGPT-4の方が便利でしょう。とはいえ、生成スピードに関しては、Lumiousの方が若干早いように感じました。

なお、日本語に特化したLLM「ELYZA」について詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【Elayza】東大スタートアップの日本語LLMは日本語検定一級合格なるか?

まとめ

Luminousは、Aleph Alphaが開発したLLMのセットです。このモデルは、膨大なテキストデータを読むことで、人間の言葉を理解し生成する能力を持っています。このLuminousには、さまざまなサイズと能力を持つ3つのモデルがあり、英語やフランス語などの主要なヨーロッパ言語で訓練されています。

- Luminous-supreme: Luminousで最も大きく、最も能力のあるモデルで、特にクリエイティブなテキストの作成に適しています。

- Luminous-extended: 二番目に大きなモデルで、情報の抽出や言語の単純化のようなタスクに適しています。

- Luminous-base: 最も小さなモデルで、最も高速かつ低コストで、分類やラベリングのようなタスクに非常に適しています。

とはいえ、検証したところ出力の文章は、不自然でした。例えば、GPT-4だと自然な文章を書けるが、Luminous-Supremeでは脈絡のない文章を出力していました。

やはり、パラメータ数やデータセットの関係から、GPT-4の方が優れているようです。そのため、日本語での利用に限らず、英語での利用に関してもGPT-4の方が便利でしょう。

すべてのモデルは、テキストを入力として処理します。PythonからAPIを介して利用できるので、ぜひ試してみてください。

生成系AIの業務活用なら!

・生成系AIを活用したPoC開発

・生成系AIのコンサルティング

・システム間API連携

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。