PDFをポッドキャスト化!PDF2Audioで効率よく情報をインプットする方法

ビジネス書や技術書、学術論文など、多くの重要な情報がPDFとして提供されていますが、それらを読む時間はなかなかありませんよね。。

そんな時、「PDF2Audio」が大いに役立ちます!PDF2Audioは、PDFファイルの内容を音声に変換し、ポッドキャストや講義の形式で耳から情報を得ることができるサービスです。

このサービスでは、単にPDFを音声に変換するだけでなく、生成された音声の編集や、声の選択、さらにはフィードバックに基づいた改善も可能。まるで自分専用の講師がPDFを解説してくれるような感覚を体験できます。

視覚に頼らず、耳で情報をキャッチする新しいスタイルが、学びの質を向上させるかもしれません。

この記事では、PDF2Audioの特徴や活用法、そして今後の可能性について詳しく紹介します。ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

PDF2Audioの概要

PDF2AudioはPDFファイルを読み込ませることで、ディスカッションをしながら説明をしてくれるAIサービスです。

ポッドキャストや講義、要約などに変換して、読み上げます。

PDF2AudioはOpenAIのGPTモデルを使用してテキスト生成とテキスト読み上げを行います。ドラフトのトランスクリプトを複数回編集し、特定のコメントを提供したり、適応や改善の方法について全体的な指示を提供したりすることも可能。

使い方はGitHubリポジトリでコードが公開されており、ローカルマシンにインストールして使用できます。

PDFから音声への変換方法

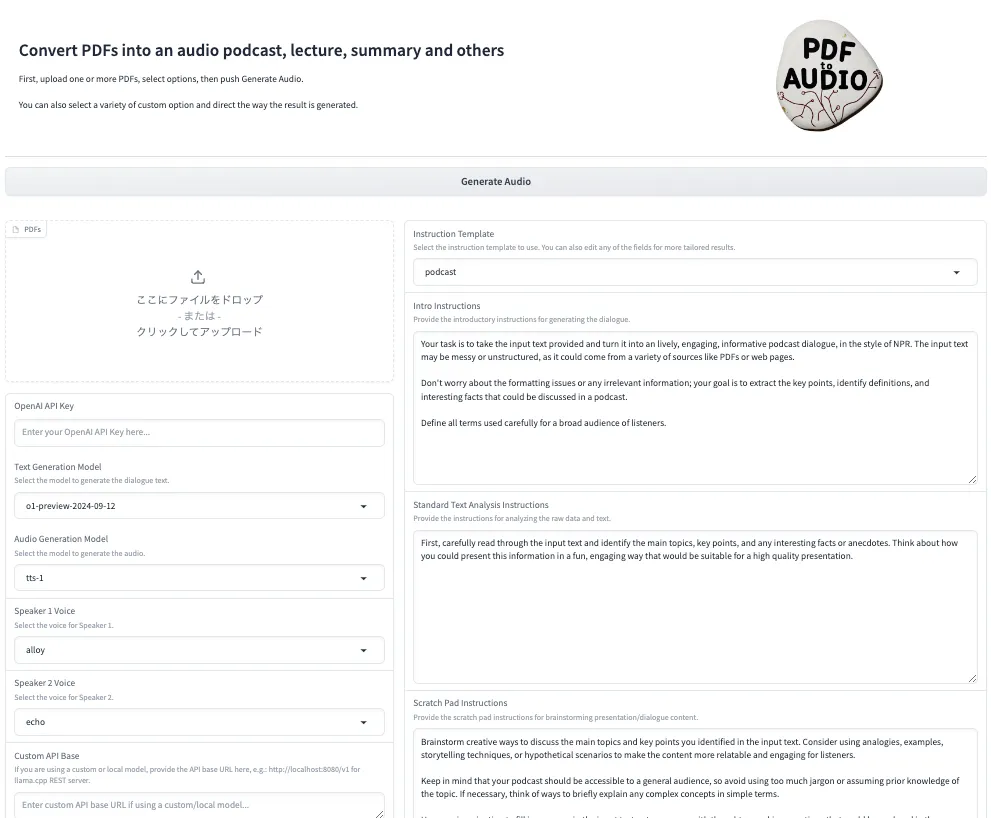

PDF2Audioは、OpenAIのGPTモデルを利用してPDFファイルのテキストを音声に変換します。音声変換過程には、テキスト生成とテキスト読み上げ変換が含まれます。ユーザーは、ポッドキャストや講義、要約などさまざまな指示をテンプレートから選択できます。

また、生成された音声のドラフトを編集したり、特定のコメントや指示を提供して、適応または改善の方法を指示することもできます。

さらに、テキスト生成や音声モデルのカスタマイズ、話者に応じた声の選択、ドラフトに対するコメントや編集による反復などが可能。

PDF2Audioの使用用途

PDF2Audioは、PDFファイルから音声コンテンツを作成することを目的としています。 具体的には、ポッドキャストや講義、要約など、さまざまな形式の音声コンテンツを作成するために利用可能です。

ユーザーは、自分のニーズに合った指示をテンプレートを選択し、必要に応じてカスタマイズできます。 また、生成された音声のドラフトを編集したり、特定のコメントや指示を提供して、より質の高い音声コンテンツを作成することも可能です。

PDF2Audioの機能

PDF2Audioは、PDFファイルを音声コンテンツに変換するための様々な機能を提供しています。

- 複数のPDFファイルの一括アップロード: 複数のPDFファイルを一度に変換

- 音声出力形式の選択: ポッドキャスト・講義・要約など、異なる指示テンプレートから選択可能

- 指示テンプレートのカスタマイズ: 必要に応じて、用意された指示テンプレートのカスタマイズが可能

- テキスト生成と音声モデルのカスタマイズ: テキスト生成と音声モデルをカスタマイズ可能。 ただし、具体的なカスタマイズオプションについては明らかになっていません。

- 話者に応じた声の選択: 異なる話者に対して異なる声を選択可能

- ドラフトの編集とフィードバック: 生成された音声のドラフトを編集したり、特定のコメントや指示を提供して、適応または改善する方法を指示可能

PDF2Audioのライセンス

PDF2AudioのライセンスはApache license2.0です。そのため、基本的には商用利用や私的利用などが可能です。

配布も可能ですが、配布する場合には、ライセンスのコピーを同封すること、変更を加えた場合は、変更したことを明記すること、元の著作権表示、特許表示、商標表示を保持することが義務付けられています。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | ⭕️ |

| 私的使用 | ⭕️ |

なお、論文PDFをアップロードして分かりやすく解説してくれるkotaemonについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

PDF2Audioの使い方

PDF2AudioはHugging Faceから利用できます。ただし、OpenAIのAPIキーが必要なので、まだ取得していない場合には、APIキーを取得してから利用しましょう。

google colaboratoryでのコードも提供されているので、google colaboratory上でも動かすことができます。google colaboratoryを実行すると、Gradioが表示され、Hugging Faceのページと同じものが表示されますので、こちらでもOpenAIのAPIキーを入力して使用します。

■PythonのバージョンPython 3.11以上

■使用ディスク量36.8GB

■システムRAMの使用量 2.5GB

■GPURAMの使用量 0GB

OpenAIのAPIキー取得方法

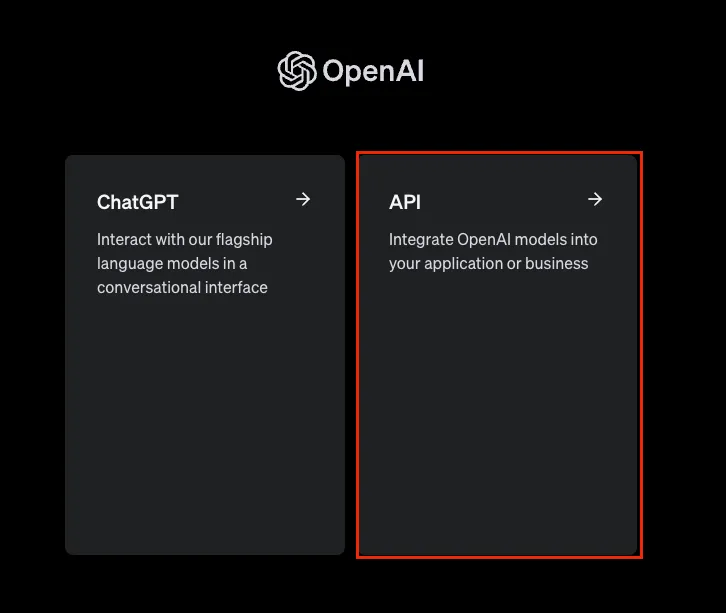

OpenAIのAPIキーを取得するには、まずOpenAIにログインします。

ログイン後、ChatGPTかAPIかを選択する項目が出てくるので、APIを選択します。

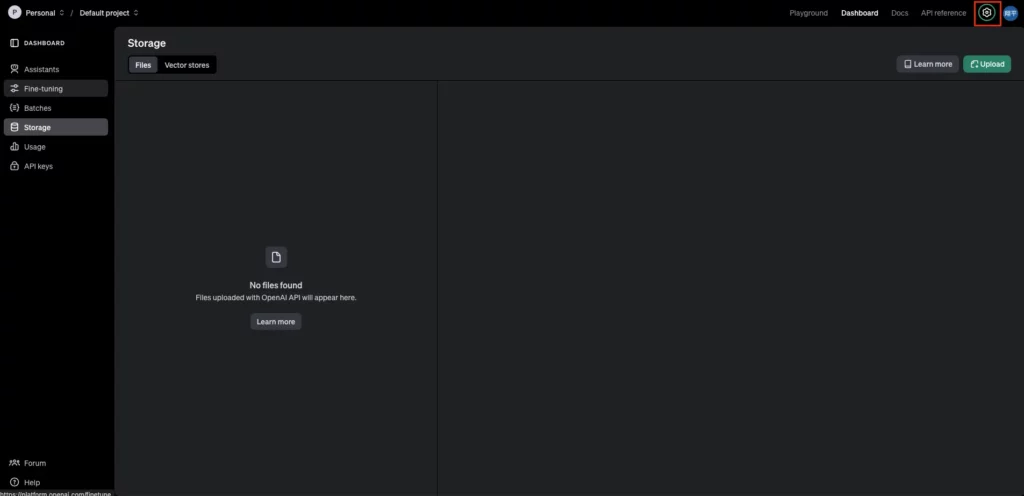

APIを選択すると以下の画面に移ります。

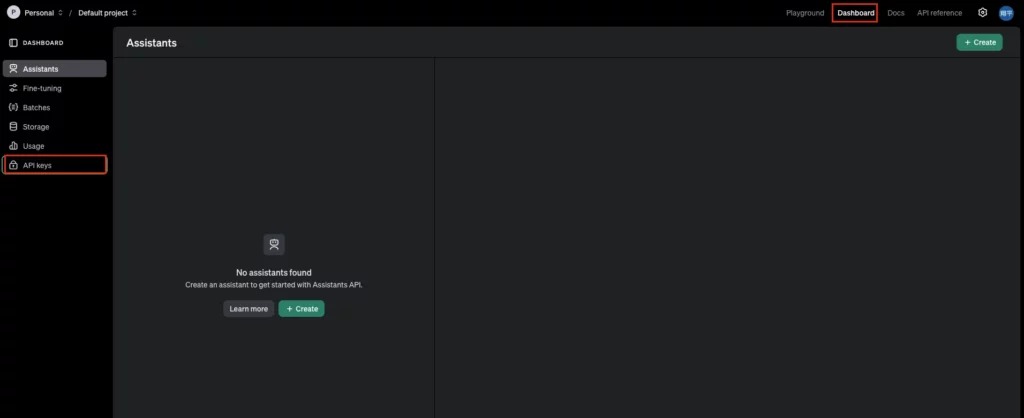

右上のメニューバーからdashboardを選択して、API Keysを選択します。

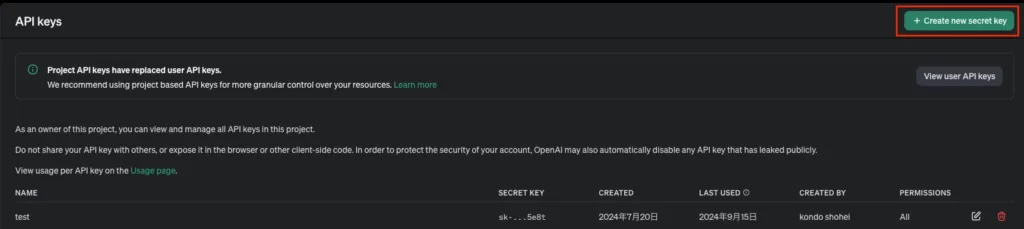

API key作成画面に移るので、Create new secret keyをクリックします

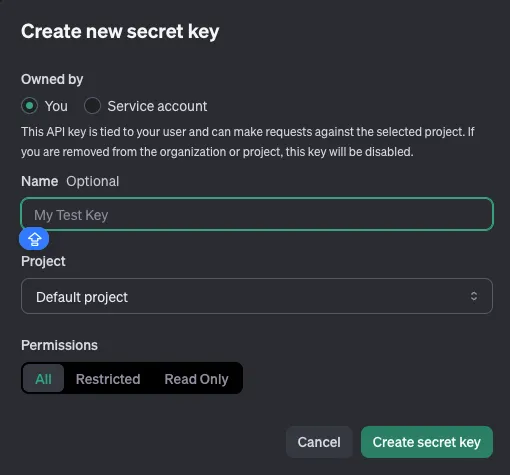

その後、APIキーの名前を入力して、Create secret Keyをクリックすれば、APIキーが作成できます。

APIキーの作成自体はこれで終了ですが、実際に使用するにはクレジットカードを登録して、事前にお金を支払う必要があります。

以前は、従量課金制でしたが、ある時から事前支払い制に変更となっています。

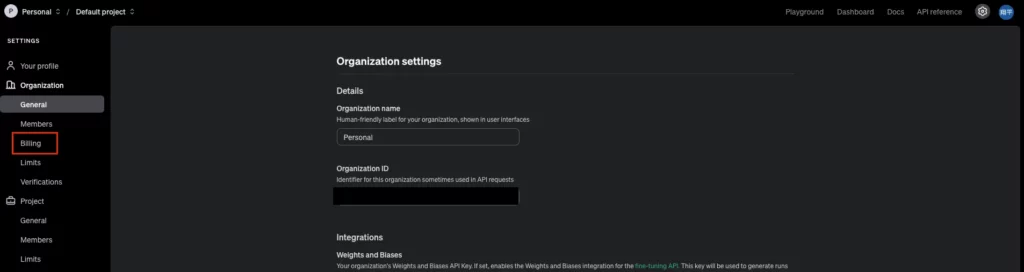

画面向かって右上の歯車マークからsettingsページに移ります。

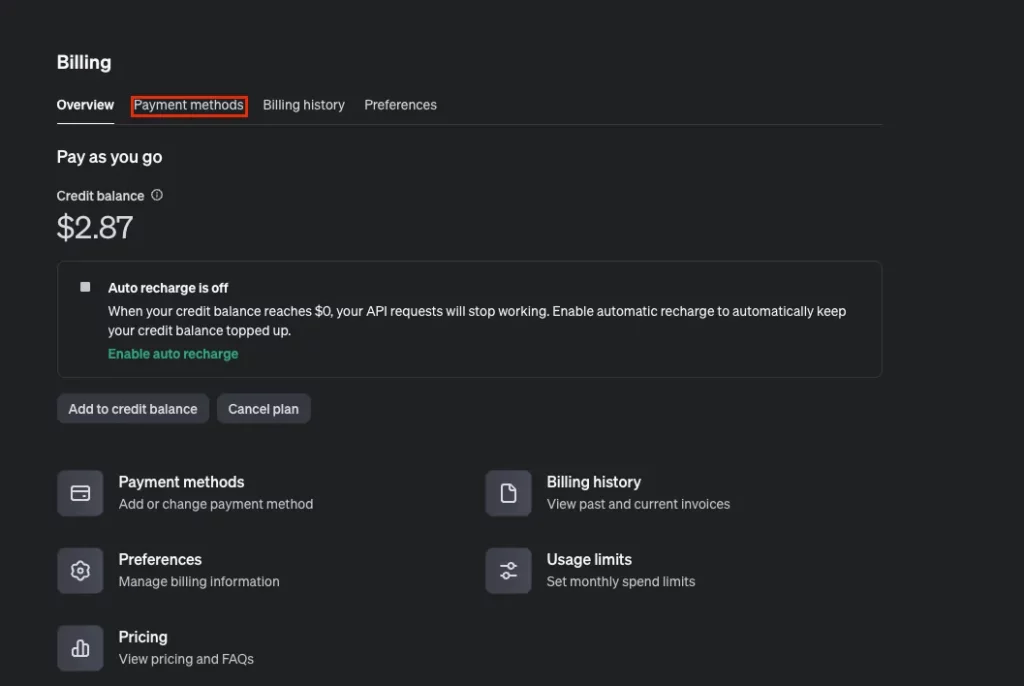

Billingから支払いメニューに移り、Payment methodsでカードを登録、使用料分を支払います。最低支払い金額が5ドルからなので、試しにOpenAIのAPIキーを使ってみたい、という場合には5ドルでOKです。

また、Auto rechargeをオンになっていることがあるので、こちらはオフにしておいた方がいいでしょう。ある程度の金額を下回ると勝手に課金されます。

これでAPIキーを使う準備ができました。

PDF2Audioを使って論文をわかりやすく解説

では、実際にPDF2Audioを使っていきます。本記事では、PDF2Audioを使って論文をわかりやすく解説をしてもらいます。

解説してもらう論文としては、

- 英語論文を分かりやすく解説

- 日本語のPDFの内容を分かりやすく解説

の2つです。また、日本語での音声を出力できるかも試していきたいと思います。

使用する英語論文はLLM関連の論文で、こちらを使用します。

LONGWRITER: UNLEASHING 10,000+ WORD GENERATION FROM LONG CONTEXT LLMS

日本語のPDFも日本語で書かれているLLMの論文を使用します。

まずは英語論文をわかりやすく解説してもらった結果がこちらです。

英語論文のテキスト結果はこちら

speaker-1: Welcome to 'Tech Talk', where we shine a light on the innovations shaping our world. I’m your host, Sarah, and today we’ll be exploring the fascinating advancements in artificial intelligence. We’re excited to have Dr. Yushi Bai and Dr. Jiajie Zhang from Tsinghua University with us. They are leading research to improve long-context capabilities in language models. Let's dive in! What led you to focus your research in this area?

speaker-2: Thanks, Sarah! Our interest in long-context models stems from the observation that, although these models can handle massive inputs — up to 100,000 tokens, which you can think of as chunks of text — they struggle significantly when it comes to generating long outputs. They generally cap out around 2,000 words, almost like having an extensive library of knowledge but being unable to write more than a couple of pages on any topic.

speaker-1: That’s quite a vivid analogy! For our listeners, could you explain what you mean by 'tokens'? How do they apply to the texts generated by these models?

speaker-2: Certainly! In the realm of language models, a token can represent a character or can comprise an entire word. To put it simply, the model breaks down input text into these tokens to process language effectively. It’s akin to how a person interprets sentences by segmenting them into meaningful parts. The challenge appears not only in how much data these models can input but also in the type of training they received. Specifically, during the Supervised Fine-Tuning phase, they weren’t exposed to examples of longer outputs, limiting their ability to generate content beyond 2,000 words.

speaker-1: This brings us to your innovative solution, AgentWrite. Can you explain what it is, and how it tackles this output limitation?

speaker-2: AgentWrite functions as a two-stage pipeline designed to break down extensive writing tasks into smaller, manageable subtasks. Imagine you’re writing an elaborate report; instead of trying to do everything at once, you would structure an outline indicating what each section should cover. In the first stage, we create this outline. In the subsequent stage, we generate content for each section sequentially. This method allows us to leverage existing models to produce substantial outputs, sometimes exceeding 20,000 words. It’s reminiscent of a chef preparing a multi-course meal step-by-step, ensuring each dish is perfectly crafted!

speaker-1: I love that analogy! By breaking down larger tasks, it undoubtedly makes the whole process less daunting for the AI. Let’s talk about data collection; this must be essential for training these models. Can you elaborate on your dataset, LongWriter-6k?

speaker-2: Absolutely! LongWriter-6k is a significant part of our research. We collected 6,000 writing prompts that required long outputs, with lengths ranging from 2,000 to 32,000 words. By providing this varied dataset, we ensure our models encounter the longer types of requests they previously lacked exposure to. It’s like giving them a comprehensive study guide instead of just a single page of notes before an exam. Incorporating this dataset during training enables our models to learn how to produce longer, coherent texts effectively.

speaker-1: And how does LongBench-Write contribute to this research?

speaker-2: LongBench-Write is a benchmark we developed specifically to evaluate the ultra-long generation capabilities of models. It comprises a variety of writing tasks that test how well these models can adhere to specified word counts while maintaining quality. Essentially, we’re investigating how long and how effectively these models can write when given clear instructions. This is vital for gauging their real-world applicability.

speaker-1: So, you’ve created a system that not only generates lengthy outputs but also assesses their quality. What exciting findings have emerged from your research?

speaker-2: The results are promising! For instance, our model, which contains 9 billion parameters, can now generate outputs that exceed 10,000 words without losing coherence. This represents a significant advancement considering the limitations we mentioned earlier. Our evaluations indicate an overall improvement in writing across various dimensions such as relevance, clarity, and depth—all of which are crucial for effective communication.

speaker-1: It’s fascinating to imagine how such developments could transform AI-assisted writing. In what ways do you think this could impact fields like education or creative writing?

speaker-2: That’s an excellent question! In the realm of education, extended writing capabilities could assist students by providing more detailed feedback on their essays or even collaborating on lengthy research papers. For creative writing, these developments could facilitate authors in brainstorming plots for books or generating entire chapters—instead of taking months, this might become something that can be done in mere minutes, fostering a new wave of collaboration between humans and machines.

speaker-1: As we explore these potential applications, what ethical considerations do you think accompany advancing AI’s writing capabilities?

speaker-2: With great power certainly comes great responsibility! As AIs acquire enhanced writing capabilities, it's vital that we ensure their ethical use. This includes addressing issues such as misinformation, biases present in generated texts, and authorship questions. Setting up safeguards is essential to ensure that these models enhance human creativity, rather than substitute it or contribute to the spread of false information.

speaker-1: Clearly, this work transcends technical advancements; it’s about fostering meaningful human interaction with knowledge and creativity. As we conclude, could you share any future research directions you plan to pursue?

speaker-2: Certainly! One direction is expanding the AgentWrite framework to produce even longer outputs while also refining the models to improve quality. Future developments could lead to AI capable of generating narratives or articles that can rival those created by humans. We’re also looking at ways to enhance inference efficiency, ensuring the model operates smoothly without any hindrance, thus elevating its usability.

speaker-1: What a compelling vision for the future! Thank you, Dr. Bai and Dr. Zhang, for sharing your insights today. Any final thoughts for our listeners?

speaker-2: Just that the future of AI writing looks incredibly promising, and we’re thrilled to be part of this transformative journey. The collaboration between human intelligence and artificial intelligence is set to redefine how we approach learning and communication!

speaker-1: Absolutely! And thank you, listeners, for tuning into this enlightening discussion. We’ve unpacked the innovations in long-context language models and how they’re redefining AI-assisted writing. Keep your curiosity alive and continue exploring the technological landscape with us. Until next time!

日本語の論文をわかりやすく解説してもらったのがこちらです

日本語論文のテキスト結果はこちら

speaker-1: Welcome to our podcast! Today, we're diving into a topic that feels like science fiction but is very much a part of our reality: Large Language Models, or LLMs.

speaker-2: That's right! LLMs are powerful artificial intelligence systems designed to understand and generate human language. They can compose compelling text, answer questions, and even engage in chat-like conversations. It’s fascinating how they work, isn’t it?

speaker-1: Absolutely! To break it down, when we say 'Large Language Model,' we’re referring to a model that's trained on vast amounts of text data using advanced algorithms. Think of it like a student who’s read every book in the library. This student can now answer questions or write essays based on everything they've read.

speaker-2: Exactly! And what’s intriguing is that these models like GPT-4 or LLaMA use statistical techniques to predict what words might come next based on the context given. They analyze the relationships between words and phrases in ways that often produce surprisingly coherent and contextually relevant responses.

speaker-1: And let’s not forget about cross-lingual capabilities, which is one of the thrilling aspects of these models. They are designed to handle multiple languages, making them pivotal in breaking down language barriers and enhancing communication worldwide.

speaker-2: Right! Imagine a world where you could converse in your language while the other person speaks entirely different language. LLMs facilitate this communication seamlessly. But how do we measure their performance, especially in academic or programming contexts?

speaker-1: Great question! This is where evaluations like HumanEval come into play. HumanEval is a benchmark for assessing coding capabilities of models by testing their Python programming skills through a series of challenges. It’s a way to see if the AI behaves like a competent coder.

speaker-2: And what we find intriguing is how different models perform on these tasks. For example, GPT-4 shows higher scores compared to other models with its ability to understand complex problem statements and provide relevant solutions. This directly reflects on how effective the model is in a real-world programming scenario.

speaker-1: Speaking of models, we can’t ignore the impact of tools like ChatGPT and GitHub Copilot. ChatGPT is widely known for generating human-like text and aiding productivity, while GitHub Copilot acts as an AI pair programmer, suggesting code snippets as developers write code.

speaker-2: Exactly! It's like having a super helpful assistant sitting right by your side. But let’s address the elephant in the room—how do users feel about these tools? Are they being embraced, or is there skepticism around their reliability?

speaker-1: You know, user experience can vary widely. Some developers take to GitHub Copilot with enthusiasm, praising how it speeds up their coding process. Others, however, are cautious, worrying about the quality of the suggestions or potential over-reliance on AI. It’s a delicate balance.

speaker-2: This brings us to the ethical aspects of using LLMs. How much should we depend on AI in our creative processes? Are we losing a part of our human touch when we allow machines to assist us too much?

speaker-1: That’s a rich area for discussion. On one hand, these tools enhance our capabilities, but on the other hand, we must continue nurturing our skills and creativity. AI should complement our work, not replace it.

speaker-2: So, how can we ensure that we’re using these tools responsibly while still benefiting from their power? Continuous learning is key here. As we support AI’s integration into our workflows, we need to adapt and evolve in how we approach our tasks.

speaker-1: Absolutely. Educating ourselves on their capabilities, limitations, and the ethical considerations will empower us—and our creativity. And utilizing models like LLMs should be about enhancing the human experience.

speaker-2: Wouldn’t it be interesting to see how we can further optimize these models to make them even better in understanding context? They are already so advanced, yet there's always so much more to improve upon.

speaker-1: Right! Improvements in representing nuances of human communication will lead to more effective interactions with both humans and systems. It’s a journey that continues to unfold.

speaker-2: And speaking of journeys, let’s mention the exciting developments on the horizon. With regular advancements in AI research, we can expect models to become more adept and specialized. Perhaps one day, they’ll even understand our emotions and tones better!

speaker-1: Now, that's a provocative thought! An emotionally intelligent LLM could really change the landscape—like a virtual empathetic companion. But of course, that presents its own set of challenges.

speaker-2: That’s right. There’s a potential risk of misuse if not handled carefully. It brings us back to our point; education and responsible usage are mantras we should all live by as we navigate this technology.

speaker-1: To wrap up, what are the key takeaways we’d like our listeners to remember from today’s episode?

speaker-2: First, LLMs are powerful tools that are reshaping how we communicate and work. They have extensive capabilities, both creatively and technologically, but must be used wisely.

speaker-1: Secondly, understanding models like GPT-4 and GitHub Copilot allows us to leverage their strengths while also being aware of their limitations. Incorporating them should be about enhancement rather than replacement.

speaker-2: Lastly, as we embrace these technological advancements, we must also keep a focus on ethical considerations. It’s our responsibility to ensure a balance between AI assistance and human creativity.

speaker-1: That’s a perfect summarization of today’s engaging discussion! Thank you all for tuning in, and we hope you leave with a newfound appreciation for the world of Large Language Models!

speaker-2: Until next time, keep exploring, keep questioning, and embrace the future with curiosity!

日本語の論文を提供していますが、英語になってしまいます。

Instruction Templateには日本語の選択肢がありません。そのため、Intro Instructionsで「Also, please keep your language consistent with the Japanese language in which you speak.」と全ての言語を日本語に統一するように指示を与えます。

日本語指示を与えた結果はこちら

speaker-1: こんにちは、リスナーの皆さん。今日は、大規模言語モデル、略してLLMについてお話ししましょう。これらの技術が最近どのように進化しているのか、また実際の活用例についても深く掘り下げていきます。私たちのゲストには、LLMに関する専門家、田中さんがいらっしゃいます。田中さん、今日はよろしくお願いいたします。

speaker-2: よろしくお願いします。LLMという言葉、自体は多くの人にとってはあまり馴染みがないかもしれません。しかし、実は私たちの生活の中で非常に影響力のある技術なんです。

speaker-1: そうですね。まず最初に、LLMとは何かを簡単に説明してもらえますか?

speaker-2: もちろんです。LLM、大規模言語モデルは、自然言語処理において使用される技術の一つです。膨大なデータを使って学習し、人間の言語生成や理解を模倣します。例えば、文章を生成したり、質問に答えたり、翻訳を行ったりすることができます。

speaker-1: 早速面白いですね!最近ではChatGPTやGitHub Copilotのようなモデルが特に注目されています。これらは特にプログラミングの分野でどのように役立っているのでしょうか?

speaker-2: GitHub Copilotは、プログラマーがコードを書く際にリアルタイムで提案を行うAIペアプログラマーとして活用されています。これにより、コードを書く際の効率が大幅に向上します。具体的には、必要なコードのサンプルを提供したり、エラーメッセージを解決するためのアドバイスを受けたりすることが可能です。

speaker-1: 素晴らしいですね!プログラマーにとってコードを書くときに手助けしてくれるツールがあることは非常に心強いです。では、ChatGPTの役割についても教えてください。

speaker-2: ChatGPTは、自然な会話を生成する能力があり、ユーザーからの質問に対して人間らしい回答を返します。このようなAIとコミュニケーションを取ることで、学びや情報交換がより効率的になります。

speaker-1: なるほど。これらのツールがどのように私たちの作業を向上させているのか、とても興味があります。ただ、これらのアプリケーションがどれだけ正確なのか、またその評価プロセスについてはどうなっているのでしょうか?

speaker-2: いい質問ですね。ここで言及すべきなのは、HumanEvalとJHumanEvalという評価基準です。これらは特にプログラミングの課題に対するモデルのパフォーマンスを測定するために開発されました。これらの指標を使用することで、モデルがどれだけ正確にコードを生成できるかを評価しています。

speaker-1: 評価基準のようなものがあるなら、開発者たちは自分たちの技術の進歩を追跡しやすくなりそうですね。

speaker-2: その通りです。実際、最近の研究では大規模言語モデルが異なる言語間でうまく機能することを示している、いわゆるクロスリンガルトランスファーに関連するものもあります。これは、特に多言語を扱う場面での課題解決に役立つ技術です。

speaker-1: クロスリンガルトランスファーという概念は聞いたことがあります。具体的にはどのように機能するのでしょうか?

speaker-2: 簡単に言えば、一つの言語での学習が他の言語に応用されるということです。たとえば、英語でトレーニングを受けたモデルが、日本語や他の言語に対しても高いパフォーマンスを持つことができます。これは、言語間の共通パターンを見つけ出すことに基づいています。

speaker-1: 非常に興味深いですね!この技術の進展によって、多くの言語を使う人々が恩恵を受けることが期待できますね。それでは、最後に、リスナーに向けてこのポッドキャストの重要なポイントを振り返りましょう。

speaker-2: はい、LLMは私たちのコミュニケーションやプログラム開発の仕方を変えつつあり、特にGitHub CopilotやChatGPTのようなツールによって、私たちの日常の作業がどれほど効率的になるのかを実感しています。また、HumanEvalやJHumanEvalといった評価方法により、これらの技術がどれほど信頼できるのかを測定することができます。そして、クロスリンガルトランスファーは、多様な言語の理解を深める鍵となるかもしれません。

speaker-1: 素晴らしいです!これからの技術の進化を楽しみにしているリスナーの皆さんに、最後までお付き合いいただきありがとうございました!

日本語の選択肢はありませんが、プロンプトで日本語の指示を与えることで、かなりスムーズな日本語での解説も可能ということがわかりました。

実際に日本語での解説を聞いてみると、AIっぽさがなく、非常になめらなか日本語で喋っていることがわかります。

なお、自然な音声と多言語対応の音声生成AIについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

PDF2Audioで広がる作業効率化

PDF2Audioはデフォルトでは日本語モードがありませんが、プロンプトを活用することで、日本語でPDFの内容を解説させることが可能だとわかりました。これだけスムーズにかつ内容を具体的に解説してくれるとなると、活用の幅が非常に広がります。

例えば、PDF2Audioを使えば、PDFに書かれた長文や技術的なドキュメント、論文などを、目を使わずに耳で聞くことができるため、読書の負担を軽減できます。通勤や運動中に学習したい場合に特に便利です。

また、複数のPDFを音声に変換し、ポッドキャストや講義形式のコンテンツを作成することもできる可能性があります。これにより、専門的な知識や情報を、音声メディアとして提供できるため、新たな情報発信の手段として活用可能。

他にも、視覚に障害がある方や、文字を読むのが困難な方でも、PDFの内容にアクセスできるようになります。音声で情報を得ることができるため、コンテンツの利用範囲が広がり、アクセシビリティの向上にもつながるでしょう。

PDF2Audioをアプリに組み込むことができる可能性もあります。

学習アプリやリーダーアプリにPDF2Audioを統合することで、ユーザーがテキストを音声で楽しむことができます。ユーザーは、PDFファイルを読み上げる機能を使って、学習や読書をもっと柔軟に行えたり、オンライン学習プラットフォームにPDF2Audioを組み込むことで、教材や論文などを音声で提供でき、特に視覚に障害のある学生や、移動中に学習を進めたい学生にとって非常に有益なツールになり得ます。また、複数の言語に対応できるため、国際的な学生にも対応可能です。

PDF2Audioの可能性はかなり広く、今後の発展が非常に楽しみなツールです。ぜひ皆さんも本記事を参考にPDF2Audioを使って、どういうサービスに活用できそうかを考えてみてください。

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。