【Qwen-14B】Llama 2を超えた!?中国最強のLLMをGPT-4と比較レビュー

皆さんはQwen-14Bをご存じですか?

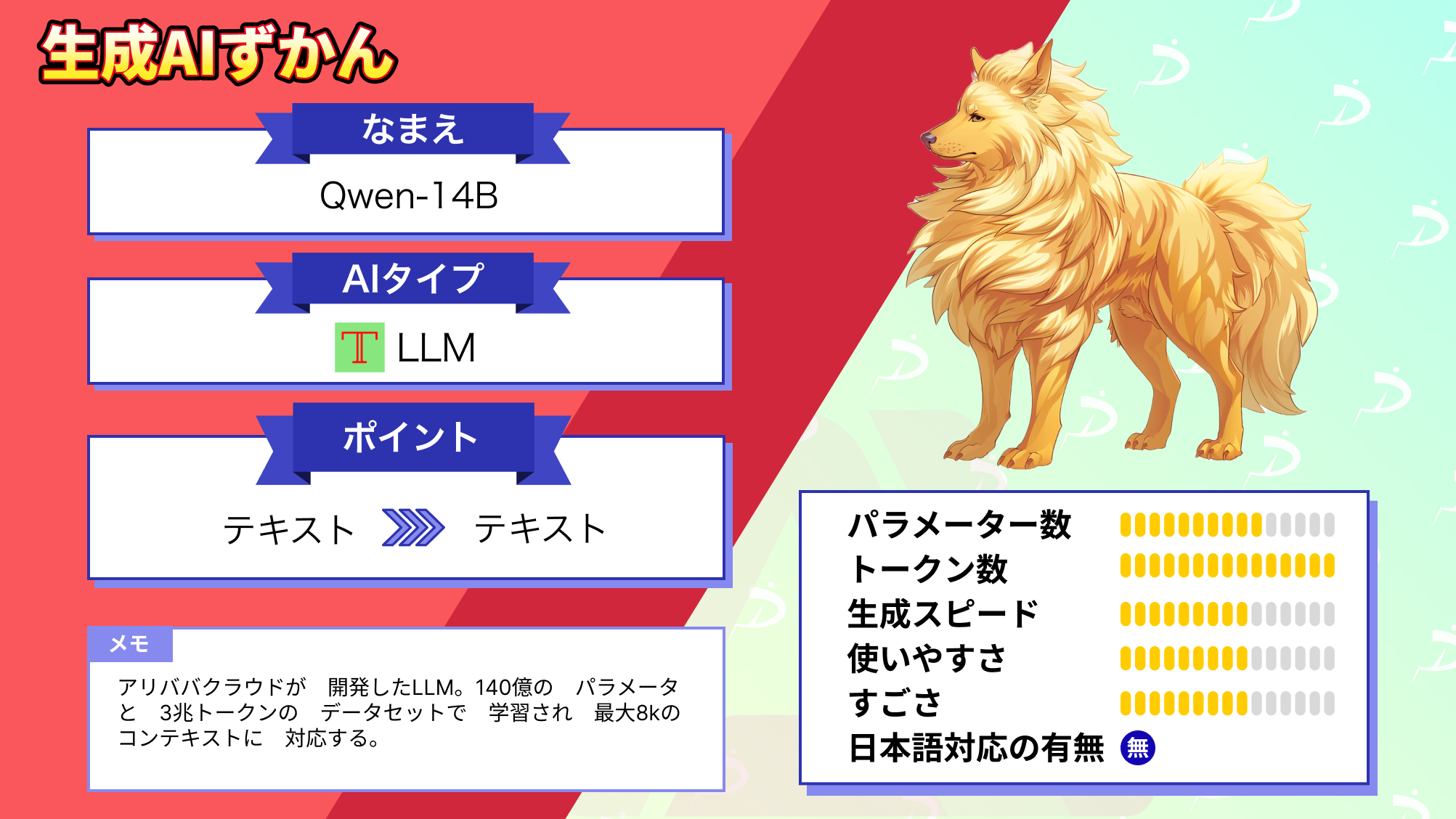

中国のAlibaba Cloud社が開発したLLMで、3兆トークンを超えるトレーニングデータを使用しており、ベンチマークで同サイズの他のLLMを超える性能を叩き出しています。

なんと、このLLMはオープンソースとして公開されており、さらにファインチューニング用のスクリプトも提供されているので、ユーザー自身でモデルをチューニングすることもできます!

自分好みにチューニングできるのは他のLLMではあまりなかった特徴なので、新しいですよね。

今回は、Qwen-14Bの概要や性能、実際に使ってみた感想、GPT-4と比較してみた結果をお伝えします。

是非最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

Qwen-14Bの概要

Qwen-14Bは、Transformerベースの大規模な言語モデルで、140億のパラメータを持ち、3兆トークンのデータで学習された、非常に大規模な大規模言語モデル(LLM)です。

過去には、Qwen-7BというLLMも公開しています。

そんなQwen-14Bの特徴は以下の5つです。

大規模なモデル:3兆以上のトークンで事前学習されており、さらには中国語、英語などの書籍やコードといった多種多様なタイプのデータを学習しています。

多言語対応:複数の言語のデータを学習し、サポートする高性能のオープンソースモデルとして設計されています。これには日本語も含まれます。

高度な推論:大量の高品質データを学習したことにより、このモデルは高度な推論、認知、および問題解決能力を持っているため、ユーザーの意図した回答をすることができます。

オープンソース:Qwenシリーズの一部としてQwen-14Bをオープンソースとして提供しています。さらに、多様な実装方法を提供していたり、ファインチューニング用のスクリプトを用意しているので、カスタマイズ性にも富んでいます。

チャットモデル:チャットモデルとしても利用することができ、ユーザーとの対話をサポートしています。

ただ、大規模なモデルとはいえ、GPT-3(1750億)、GPT-4(1.5兆※正確な値は非公開)には遠く及ばないものになっており、これらに対してスペックは劣ります。

しかし、Qwen-14Bは同規模のモデルにはベンチマークスコアで上回っているだけでなく、オープンソースでユーザーが自由に使えてカスタマイズもできる事から、かなり期待できます。

そんなQwen-14Bの性能は、公式から詳しくドキュメントが出ているので、それを参考にしながら紹介していきます!

なお、アリババの画像生成AIについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【Animate Anyone】アニメキャラを自由に動かせるアリババAIの使い方や導入方法を解説

Qwen-14Bの性能

こちらの公式Githubページのドキュメントを参考にしました。さらに詳しく知りたい方はこちらをご覧ください。

参考サイト:README_JA.md

まずは以下のグラフをご覧ください。

このグラフは、「GPT-4」「GPT-3.5」「Previous 13B SOTA」「Qwen-14B」の各ベンチマークの結果をグラフ化したものです。

結果を比較すると、GPT-4が圧倒的なのは当然と言えますが、C-EvalというベンチマークではQwen-14BとGPT-4は互角の数値を出しています。

ただ、このベンチマークは中国語の知識や推論能力を評価するものなので、Qwen-14Bが有利に働いている可能性があります。

そのため、その他の言語ではこのグラフのような結果にはならない可能性があります。

続いて、同規模のLLMとのベンチマークスコアの比較結果の表をご覧ください。

この結果から、Qwen-14Bは同規模のLLMに比べ、非常に高い性能を有しているとともに、前身のQwen-7Bからも大幅に進化している事が分かります。

ただ、ベンチマークスコアが実際に使ったときの性能を表しているとは限りません。

そのため、この記事の後半では、Qwen-14Bを実際に使い、他のLLMと比較を行っていきたいと思います。

まずはその導入方法から説明していきます。

Qwen-14Bの導入方法

まず、公式huggingfaceにアクセスします。

huggingface:Qwen-14B

Qwen-14Bを動かす際の必要条件が書いてあるので、それを確認します。

必要条件は以下の通りです。

- python 3.8 以上

- pytorch 1.12 以上、2.0 以上を推奨

- CUDA 11.4 以上を推奨(GPU ユーザー、フラッシュアテンションユーザー向けなど)

今回は、量子化されたQwen-14B-Chat-Int4というモデルを導入していきます。

この方法はauto-gptqを使用するので、その要件を満たしていることを確認してください。

(torch 2.0以上、transformers 4.32.0以上など)

※GPTQとはGPTモデルを量子化する手法で、モデルサイズの削減と推論速度の高速化ができます。

今回は、Google Colab Proを使用していきます。

Google Colab

まず、以下のコードを実行します。

pip install auto-gptq optimum続いて以下のコードを実行して、必要なライブラリをインストールします。

pip install transformers==4.32.0 accelerate tiktoken einops scipy transformers_stream_generator==0.0.4 peft deepspeedこれでQwen-14B-Chat-Int4を使用する準備が整いました。

早速質問して、他のLLMとも比較していきましょう!

なお、アリババの音声生成AIも動かしてみたい方は、下記の記事を合わせてご確認ください。

→【Qwen-Audio】音声だけで状況認識や多言語翻訳ができるアリババ産LLMを使ってみた

Qwen-14Bを実際に使ってみた

以下のコードを実行することで、モデルをロードして実行することができます。

from transformers import AutoTokenizer, AutoModelForCausalLM

# Note: The default behavior now has injection attack prevention off.

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-14B-Chat-Int4", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

"Qwen/Qwen-14B-Chat-Int4",

device_map="auto",

trust_remote_code=True

).eval()

response, history = model.chat(tokenizer, "自己紹介して", history=None)

print(response)赤字で示したところに、プロンプトを入力します。

出力結果がこちらです。

とても自然な日本語で自己紹介してくれたので驚きました。

ただ、これだけでは性能を測ることはできないので、同規模のLLMであるLlama-2-13bをベースにチューニングされたXwin-LM-13Bと、参考程度にGPT-4との比較を行っていきます。

Qwen-14Bの推しポイントである高性能は本当なのか?

以下の3つのプロンプトに対する出力を比較していきます。

・フィボナッチ数列の計算をしてください。100以上の数値が出るまで、数字を出力し続けてください

・Pythonで重量回帰分析をするプログラムを書いてください。

・うずまきナルト風に喋って

結果

結果は以下の表をご覧ください。

| タスク | プロンプト | Qwen-14B | Xwin-LM-13B | GPT4 |

|---|---|---|---|---|

| 計算 | Calculate the Fibonacci sequence.Keep outputting numbers until you get a number greater than 100.フィボナッチ数列の計算をしてください。100以上の数値が出るまで、数字を出力し続けてください。 | 計算は正しいが、100以上の数値も出力された。 | 計算は正しいが、100以上の数値も出力された。 | 正しい数字を出力してくれただけでなく、フィボナッチ数列がの説明をしてくれて、Pythonのコードも出力してくれました。 |

| コーディング | Please Write code for regression analysis in Python.Pythonで回帰分析のコードを書いてください。 | シンプルなコードを生成してくれて、何をしているものなのか丁寧な説明をつけてくれた。 | ちゃんとしたコードを生成してくれましたが、詳しい説明はなかった。 | かなり複雑なコードを短時間で出力してくれて、何をするためのコードなのかという説明に加え、必要なライブラリとそのインストール方法まで教えてくれた。 |

| 喋り方 | うずまきナルト風に喋って | お前、何がしたいんだい?うずまきナルトって、誰か知ってるか?俺、うずまきナルトだ。忍者の世界で一番強くなった男だ。俺、君の相手に立つよ。Ready? Let’s go! | うずまきナルトです!ナルト村の子供で、忍者を目指しています!今日も私の忍者修行を続けています。ありがとうございました! | オレはChatGPT、未来の火影…じゃなくて、未来の最強のAIを目指してるんだってばよ!OpenAIの里で修行してるんだ。何か質問があったら、どんどん聞いてくれ!オレは答えるってばよ! |

コーディングの出力結果を以下に示します。

Qwen-14B

Xwin-LM-13B

GPT-4

考察

まず計算について。

どれも計算は正しいのですが、Qwen-14BとXwin-LM-13Bについては100以上の値も出力されてしまいました。

そんなに難しい指示ではないと思うのですが、GPT-4との差がわかりやすく見えてしまいました。

GPT-4に関しては、100以下の正しい値を出力してくれただけでなく、フィボナッチ数列の説明に加えてPythonのコードも出力してくれました。

次に、コーディングに関してですが、これはどれも正しいコードを出力してくれました。しかし、GPT-4とQwen-14Bは丁寧な説明をしてくれましたが、Xwin-LM-13Bはコード内に説明書きがある程度でした。

最後に、喋り方についてです。

これは正直あまり期待してはいませんでしたがですが、案の定Qwen-14BとXwin-LM-13Bは出来ませんでした。

GPT-4は「だってばよ」というナルトの特徴的な語尾に加えて、ナルトの知識を活かしたジョークを言っており、さすがに驚きました。GPT-4の安定感すごすぎる!

総合的に見ると、やはりパラメータ数が桁違いのGPT-4は頭一つ抜けている感じはします。Qwen-14BとXwin-LM-13Bはほとんど同じような回答でしたが、全く見当違いの回答というわけではなく、ある程度正確な回答を出してくれてはいました。今回は、GPT-4が圧勝で、その後にXwin-LM-13BとQwen-14Bが同列で続くという感じでした。

これからこのモデルをベースにさらに進化したモデルが開発されることに期待しましょう!

なお、同じ中国企業であるバイトダンスのAIについて知りたい方は、下記の記事を合わせてご確認ください。

→【MVDream】TikTok、ByteDanceのテキストから高精度の3D画像を生成するAIモデルを使ってみた

これからのQwen-14Bに期待!

Qwen-14Bは、Transformerベースの大規模な言語モデルで、140億のパラメータを持ち、3兆トークンのデータで学習された、非常に大規模な大規模言語モデル(LLM)です。

中国語、英語などの書籍やコードといった多種多様なタイプの高品質なデータを学習しています。そのため、他の同規模のモデルに比べてベンチマークスコアで上回っています。

しかし、他のモデルとの比較では、十分な回答をしてくれましたが、同規模のモデルと性能に大差はなかったことに加えて、GPT-4には大差をつけて負けてしまっていました。今後さらに多くのデータを学習させ、性能を向上させてモデルが出てくることに期待しましょう!

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。