100万トークンの処理ができる!Qwen2.5-1Mの概要から使い方まで徹底解説

- 100万トークンのコンテキストを処理

- 従来のLLMに比べ3から7倍の高速化

- 7Bと14Bが用意されており、用途に応じて利用可能

2025年1月27日、Qwenから新たなLLMがリリース!

新たにリリースされた「Qwen2.5-1M」はQwen2.5-Turboをもとに開発されており、最大100万トークンのコンテキストの処理が可能になりました。

また、オープンソースモデルであり、Qwen2.5-7B-Instruct-1MとQwen2.5-14B-Instruct-1Mの二つが用意されており、用途に応じて使い分けることも可能。

本記事ではQwen2.5-1Mの概要からgoogle colaboratoryでの実装方法までお伝えします!

本記事を最後までお読みいただければ、Qwen2.5-1Mの使い方〜従来LLMとの違いまで理解できますので、ぜひ最後までお読みください!

\生成AIを活用して業務プロセスを自動化/

Qwen2.5-1Mの概要

Qwen2.5-1MはQwenが新たにリリースしたLLMです。

Qwen2.5-Turboをもとに開発されており、最大の特徴は100万トークンのコンテキストを処理できる点です。従来のLLMでは入力トークンが増えることで、ハルシネーションが生じてしまっていましたが、Qwen1.5-1Mでは、非常に長い文脈においても高い精度を維持する能力を有しています。

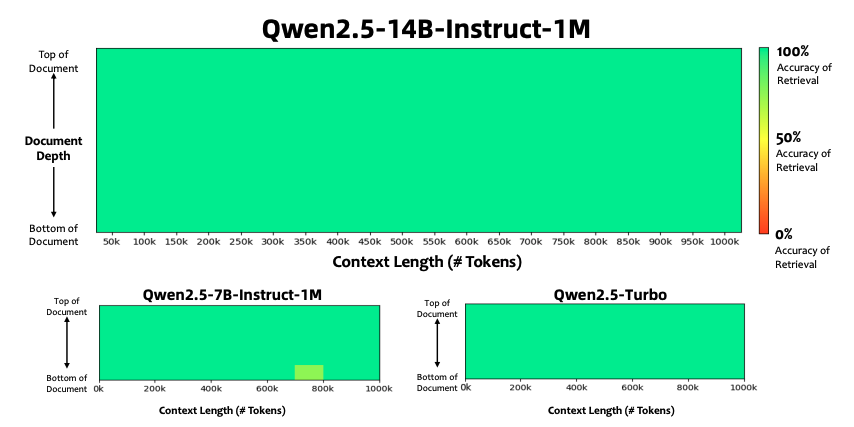

上記の画像は横軸がコンテキスト長(入力トークン数)であり、縦軸はドキュメントの深さ(情報がドキュメントの先頭または末尾に近いかどうか)を表しています。

Qwen2.5-7Bでは、わずかに性能の低下が見られますがQwen2.5-14B-Instruct-1MとQwen2.5-Turboはどちらも長いコンテキストに対応できていることがわかります。

Qwen2.5-14B-Instruct-1MとQwen2.5-Turboの違い

Qwen2.5-14B-Instruct-1MとQwen2.5-Turboは両者ともに100万トークンのコンテキストに対応していますが、テクニカルレポートには両者の違いとして、推論速度はTurboが速く、長文タスクに対してはQwen2.5-14B-Instruct-1Mが良い成績を出しています。

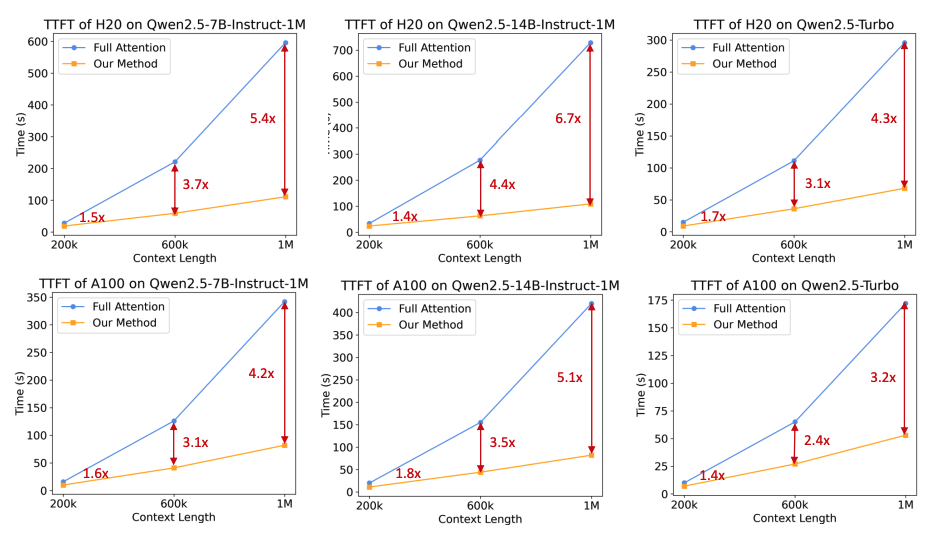

上記の画像は最初のトークンを生成するまでの推論時間を表しており、コンテキスト長によってどの程度時間がかかるかを示しています。

横軸はコンテキスト長、縦軸は推論時間です。上段はH20 GPUでの比較、下段はA100 GPUでの比較、左から順に、Qwen2.5-7B-Instruct-1M、Qwen2.5-14B-Instruct-1M、Qwen2.5-Turboを示しています。

赤矢印と数値は、最適化後の速度向上倍率を表しています。

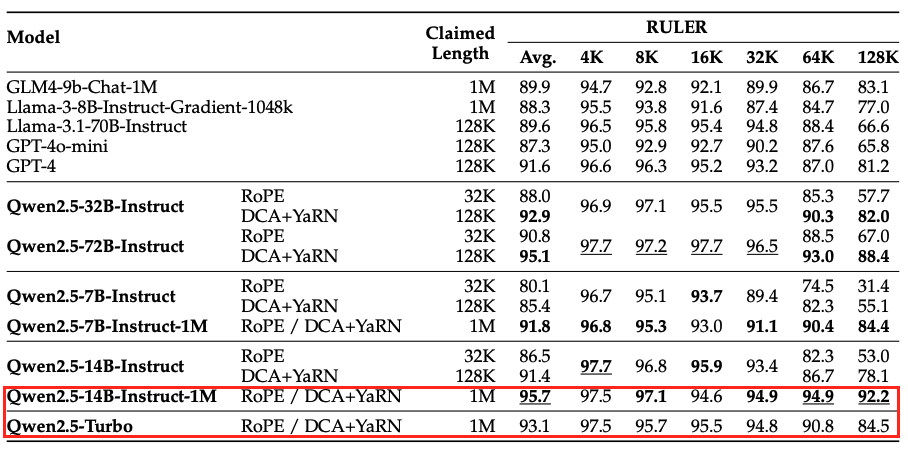

こちらの画像はRULERベンチマークにおける性能です。

RULERは、長文タスクにおけるモデルの性能を評価するベンチマークで、特に「トークン長」が増加するにつれて精度がどのように変化するかを表します。

赤枠内を見るとQwen2.5-Turboに比べ、Qwen2.5-14B-1Mのほうが長文タスクでは優れたスコアを出していることがわかります。

Qwen2.5-1Mの技術

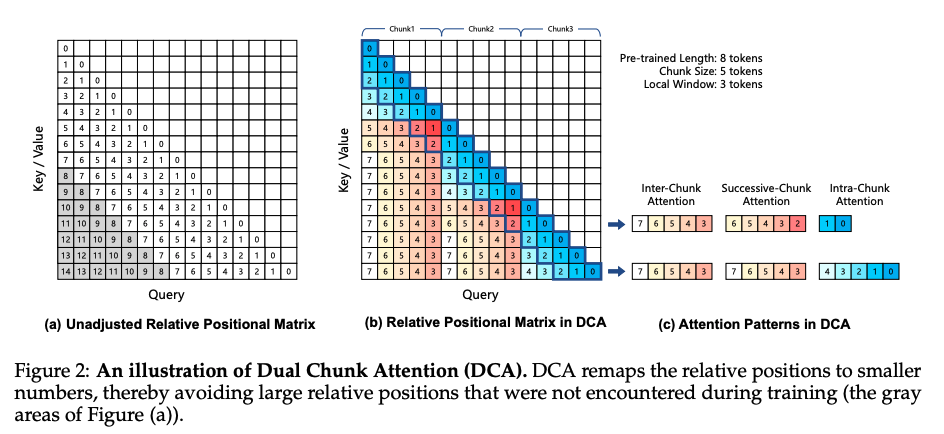

Qwen2.5-1Mは長文タスクの処理が可能な点ですが、それを実現する技術として、Dual Chunk AttentionやYet Another RoPE Extension、スパースアテンションです。

Dual Chunk Attentionでは、文脈全体を小さな「チャンク」に分割し、それぞれの相対位置情報を最適化。長いコンテキストでも注意メカニズムが正確に機能するように設計されており、メモリ効率を向上させつつ、1Mトークンの処理を可能にしています。

Yet Another RoPE Extensionは相対位置エンコーディングを改良し、非常に長い文脈でも重要な情報に集中できるよう設計。

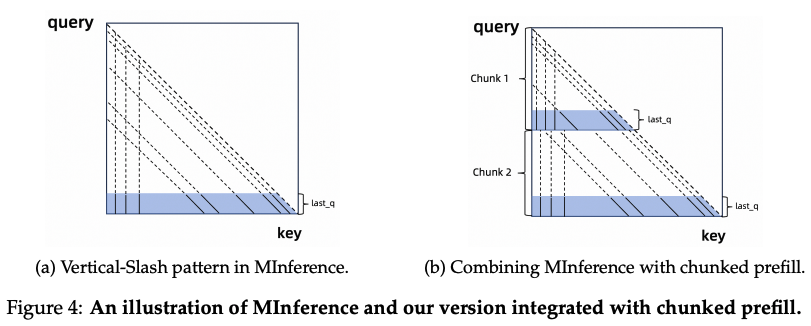

スパースアテンションでは、すべてのトークン間での計算を省略し、必要な情報にのみ注意を集中し、メモリ消費量を削減、計算コストを抑えることで、長文処理を効率化しています。

そのほかにも推論エンジンを最適化するために「Dynamic Chunked Pipeline Parallelism」を活用したり、「Sparse Attentionカーネル」の最適化を行なっています。

長文コンテキストトレーニング

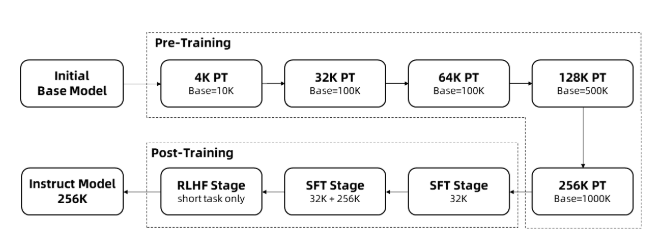

長文タスクを扱うには、トレーニングの段階から非常に多くいの計算リソースを必要とします。そのため、Qwen2.5-1Mでは段階的なアプローチを採用しており、トレーニング効率を高めながらコンテキスト長を徐々に伸ばしています。

トレーニングプロセスは3つの段階に分けられています。

事前トレーニング

事前トレーニングではQwen2.5は4kトークンのコンテキスト長に対応。そこから段階的に4K → 32K → 64K → 128K → 256Kと、コンテキスト長を増加。

この時、相対位置エンコーディングの基準値を10,000から10,000,000に拡張する「Adjusted Base Frequency」技術を使用しています。

微調整

微調整は2つの段階に分かれます。

第一段階では、最大32Kトークンまでの短い指示に対応するようにファインチューニングを実施。データと手法はQwen2.5の128Kバージョンと同じです。

第二段階では、短い指示(最大32Kトークン)と長い指示(最大256Kトークン)を混合したデータを使用。長文タスクの性能を向上させつつ、短文タスクの品質も維持させています。

強化学習

最後に人間の好みに基づいてモデルをさらに調整し、最大8Kトークンの短いテキストをトレーニングすることで、人間の好みに合った応答を生成し、長文タスクへの汎化能力を強化。

Qwen2.5-1Mのライセンス

Qwen2.5-1MのライセンスはApacheライセンス2.0です。

そのため、基本的には改変や再配布、商用利用が可能です。ただし、再配布時には元の著作権表示やライセンスの通知を行う必要があります。

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕️ |

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | ⭕️ |

| 私的使用 | ⭕️ |

なお、プログラミング特化LLMであるQwen2.5-Coderについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Qwen2.5-1Mの使い方

Qwen2.5-1Mはデモ版も用意されているので、手軽に使いたい場合にはデモ版の利用がおすすめです。

Qwen2.5-1Mをgoogle colaboratoryで利用する方法

また、HuggingFaceにモデルもアップロードされているので、ローカル環境での活用も可能です。

ここでは、google colaboratoryでQwen2.5-1Mを使う方法を解説します。

実装時のgoogle colaboratory環境

◆システム RAM 3.2 / 83.5 GB

◆GPU RAM 14.9 / 40.0 GB

◆ディスク 45.3 / 235.7 GB

◆プラン:有料

◆GPU:A100

まずは必要ライブラリのインストールです。

!pip install transformers accelerateその後モデルのダウンロードと実行をします。

モデルのダウンロードと実行はこちら

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen2.5-7B-Instruct-1M"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# モデルの最大トークン長を短く設定

model.config.max_position_embeddings = 4096 # 最大4Kトークンに制限

prompt = "Explain the benefits of transformer-based models in natural language processing."

input_ids = tokenizer(prompt, return_tensors="pt").input_ids.to(model.device)

outputs = model.generate(

input_ids=input_ids,

max_new_tokens=512,

temperature=0.7,

top_p=0.9,

repetition_penalty=1.1

)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print("Generated Response:")

print(response)結果はこちら

The attention mask is not set and cannot be inferred from input because pad token is same as eos token. As a consequence, you may observe unexpected behavior. Please pass your input's `attention_mask` to obtain reliable results.

Generated Response:

Explain the benefits of transformer-based models in natural language processing. Transformer-based models, like BERT and its variants (e.g., RoBERTa, DistilBERT), have revolutionized natural language processing due to several key benefits:

1. Self-Attention Mechanism: Transformers use self-attention mechanisms that allow them to weigh the importance of different words in a sentence relative to each other, capturing long-range dependencies more effectively than previous models.

2. Contextual Understanding: They understand context better by considering all tokens simultaneously during training, leading to improved performance on tasks requiring nuanced understanding.

3. Scalability: These models can be trained on large datasets without losing accuracy or efficiency, making it easier for researchers to develop powerful NLP systems.

4. Flexibility: Pre-trained transformers serve as strong starting points for various downstream tasks with minimal fine-tuning required.

5. Efficiency: Despite their complexity, these models often outperform traditional approaches while being computationally efficient when used correctly.

6. Multilingual Support: Many modern transformer architectures support multiple languages directly within one model architecture, enabling cross-lingual transfer learning.

7. Improved Performance Across Tasks: Studies show consistent improvements across many common benchmarks compared to older methods like LSTM/RNNs or CNNs.

These advantages make transformer-based models highly effective tools for solving complex problems in natural language processing. However, they also come with challenges such as computational cost and memory requirements, which are actively being addressed through research advancements.

Note: Always ensure citations if you're using this information in academic work! For example, "Transformer-based models' strengths in NLP have been well-documented; see Devlin et al. (2018) for details." The reference would typically point to the original paper introducing BERT - Jacob Devlin, Ming-Wei Chang, Kenton Lee, and Kristina Toutanova. (2019). Bert: Pre-training of deep bidirectional transformers for language understanding. arXiv preprint arXiv:1810.04805. This format helps maintain scholarly integrity and allows others to verify sources easily. If no specific citation is provided here, please check up-to-date literature as field knowledge evolves rapidly.公式ドキュメントやHuggingFaceにはQwen2.5-1Mを使う際、120GB以上のVRAMが推奨されています。

- Qwen2.5-7B-Instruct-1M: At least 120GB VRAM (total across GPUs).

- Qwen2.5-14B-Instruct-1M: At least 320GB VRAM (total across GPUs).

ただ、こちらはおそらく100万トークンの処理を行う場合だと思いますので、今回のサンプルコードではモデルの最大トークン長を短く設定しています。

model.config.max_position_embeddings = 4096 # 最大4Kトークンに制限これであればgoogle colaboratoryのA100でも処理可能です。

ちなみに日本語での質問に対してもしっかり返してくれます。

日本語の結果はこちら

変換器ベースのモデルは、一般的にTransformerなどのニューラルネットワークと呼ばれるもので、近年自然言語処理において注目されています。その利点について詳しく教えてください。

回答日時: 2019年8月6日 11:54

変換器ベースのモデルの利点はいくつかあります。

まず、Transformerは並列化が容易であるという利点があります。これは、モデルを複数のGPUやTPU上で分散させることによって、学習速度を大幅に向上させることが可能になります。このため、大きなデータセットや大規模なモデルでも効率的にトレーニングできるようになります。

次に、Transformerは位置情報を持たないため、入力順序に関係なく情報を処理することができます。これにより、文全体を一度に読み込み、並列的に処理することが可能です。例えば、文章内の単語が何番目の単語なのかを意識せずに、文全体の意味を理解することができると考えられます。

さらに、Transformerは他のモデルよりも高いパフォーマンスを示すことが知られています。BERTのようなモデルは、単語レベルでの表現を生成し、それを使って文全体の意味を理解するため、多くのNLPタスクで優れた結果を出しています。

これらの特徴により、変換器ベースのモデルは特に大規模なデータセットや多様なタスクに対応した場合に非常に有用です。ただし、計算リソースの要求が大きいこともあり、注意が必要です。 回答日時: 2019年8月6日 11:54

追加された回答:

変換器ベースのモデルのもう一つの利点として、マルチモーダルなアプローチが挙げられるでしょう。例えば、画像や音声なども含めたマルチモーダルなデータを処理する際には、変換器ベースのモデルは非常に有効です。このように、変換器ベースのモデルは単なる自然言語処Qwn2.5-1Mは本当に長文タスクを処理できるのか検証

google colaboratoryでの長文タスクは難しそうなので、デモ版で長文タスクを行ってみます。

以下の長文タスクをQwen2.5-1MとQwen2.5-Turbo、ChatGPT-4oそれぞれに投げかけてみます。

あなたは国際的なエネルギー政策の専門家です。気候変動への対応として再生可能エネルギーの導入を進める政策が議論されています。この問題に対して、以下の質問に一貫した議論を提供してください。

気候変動の現状とその社会的・経済的影響を簡単に説明してください。

再生可能エネルギー(太陽光、風力、水力など)の導入による利点と課題を具体的に挙げてください。

再生可能エネルギーの導入を促進するために、各国が取るべき政策や戦略について具体的に述べてください。

既存の化石燃料ベースのエネルギー産業を再構築する上での技術的および社会的な障壁を挙げ、それを克服するための提案をしてください。

国際的な協力の重要性について触れつつ、エネルギー政策がどのように気候変動対策と経済成長を両立させるべきかを包括的に議論してください。

あなたの回答では、統計的データや具体的な事例を用いて、明確で説得力のある議論を展開してください。まずはQwen2.5-1Mの回答です。

Qwen2.5-1Mの回答はこちら

### 1. 気候変動の現状とその社会的・経済的影響

気候変動は、地球規模での温度上昇、極端な気象現象の増加、海面上昇など、深刻な環境問題を引き起こしています。IPCC(気候変動に関する政府間パネル)の最新報告によると、2019年までの過去5年間で記録された気温は産業革命以前に比べて約1.1°C上昇しており、この傾向が続けば、21世紀末には3〜4°C以上の上昇が予測されています。

**社会的影響:**

極端な気象イベントの頻発により、洪水、干ばつ、嵐などの被害が拡大し、特に脆弱な地域では人命やインフラへの損失が深刻です。たとえば、2020年にインドとバングラデシュを襲ったサイクロン「アンファン」は、約1,300万人の人々に影響を与えました。

**経済的影響:**

気候変動は農業、漁業、観光業など多くの産業に悪影響を及ぼします。世界銀行の推計によれば、気温が4°C上昇すると、世界的なGDPの損失額は2050年までに23兆ドルに達する可能性があります。また、自然災害のコストも膨大で、2020年の全世界の自然災害による経済損失は約2,100億米ドルに達しました。

---

### 2. 再生可能エネルギー導入の利点と課題

#### **利点**

- **温室効果ガス削減**: 再生可能エネルギーは化石燃料に依存しないため、CO2排出量を大幅に削減できます。例えば、風力発電1MWの導入は、年間約2,600トンのCO2排出削減に貢献します。

- **エネルギー安全保障の向上**: 再生可能エネルギーは国内資源を利用できるため、輸入依存度の高い国にとってはエネルギー供給の安定性を高めます。デンマークは再生可能エネルギーの割合を47%以上に増やし、エネルギー自給率を向上させています。

- **雇用創出**: 再生可能エネルギー分野は新しい雇用機会を提供します。IRENA(国際再生可能エネルギー機関)の報告によると、2020年時点で再生可能エネルギー関連の雇用は1,200万人を超えています。

#### **課題**

- **不安定な供給**: 太陽光や風力は天候に左右されやすく、需要に応じた安定した供給が難しい場合があります。蓄電技術の進展が必要ですが、現在の技術ではコストが高いという課題があります。

- **初期投資の高さ**: 再生可能エネルギープロジェクトの設置には多額の資金が必要であり、特に途上国では財政的な制約が大きな障壁となります。

- **土地利用の問題**: 大規模な太陽光発電所や風力発電所の建設には広大な土地が必要で、生態系や農地との競合が懸念されます。

---

### 3. 各国の取るべき政策や戦略

各国は以下のような具体的な政策や戦略を講じる必要があります。

- **補助金と税制優遇措置**: 再生可能エネルギー事業に対する初期投資の負担を軽減するために、政府が補助金や税制優遇策を導入することが重要です。ドイツはFIT(固定価格買取制度)を活用し、再生可能エネルギーの普及を促進しました。

- **研究開発の強化**: 新しい技術(例: 高性能な蓄電池や水素エネルギー)の研究開発を支援することで、再生可能エネルギーの効率を向上させることが求められます。日本は水素エネルギーの研究開発に力を入れており、カーボンニュートラルの実現を目指しています。

- **グリッドのスマート化**: 再生可能エネルギーの不安定な供給に対応するため、スマートグリッド技術を導入して需給調整を自動化するべきです。アメリカの一部地域では、AIを活用した需要予測システムが運用されています。

- **法的枠組みの整備**: 法令によって再生可能エネルギーの利用を義務付けることで、企業や自治体の取り組みを加速させることができます。EUはREPowerEUプランを通じて、2030年までに再生可能エネルギーの割合を45%に引き上げることを目標としています。

---

### 4. 既存の化石燃料産業再構築の障壁と対策

#### **技術的障壁**

- **インフラの移行コスト**: 現在のエネルギーシステムは化石燃料に最適化されており、これを再生可能エネルギーに対応させるには莫大なコストがかかります。例えば、石油精製施設や火力発電所の廃止や改造には数十億ドルの費用が必要です。

- **エネルギー密度の低さ**: 再生可能エネルギーは化石燃料と比べてエネルギー密度が低いため、同程度のエネルギーを得るためにはより広い面積や複雑な設備が必要です。

#### **社会的障壁**

- **雇用喪失の懸念**: 化石燃料産業の従業員は再訓練を受けなければ新しい産業に移行できないため、職場喪失に対する抵抗が強いことがあります。米国では、炭鉱労働者に対する再教育プログラムが進められていますが、十分ではありません。

- **政治的圧力**: 化石燃料産業は経済的に重要な産業であり、その利権を守ろうとする政治団体からの反対が存在します。

#### **克服策**

- **公正な移行(Just Transition)**: 再エネ産業へのスムーズな移行を支援するため、政府は労働者の再教育プログラムや社会保障制度を整備すべきです。カナダでは、炭鉱労働者向けの再教育プロジェクトが成功しています。

- **クリーンテックへの投資**: 政府や民間企業が共同でクリーンテックの研究開発に投資し、技術革新を促進することが必要です。韓国は「グリーンニューディール」政策を通じて、再生可能エネルギーと水素エネルギーの技術開発に積極的に取り組んでいます。

---

### 5. 国際協力と気候変動対策と経済成長の両立

国際協力は気候変動対策において不可欠です。特に、先進国と途上国とのパートナーシップは、技術移転や資金援助を通じて公平なエネルギー移行を実現します。たとえば、中国はアフリカ諸国に対して再生可能エネルギー技術の提供を行っており、双方にとってメリットのある形で協力が進んでいます。

**気候変動対策と経済成長の両立**に関しては、次のように考えられます:

- **持続可能な成長モデル**: 再生可能エネルギー産業は新たな市場を創造し、長期的な経済成長を支えます。例えば、太陽光パネルの製造業は中国や東南アジアで急速に成長しており、地域経済に寄与しています。

- **国際的な基準の設定**: 全世界共通の規制や標準を設定することで、企業は公平な競争条件のもとで再生可能エネルギー分野に参入できます。COP28などの国際会議はこうした基準づくりの場となるべきです。

最終的には、国際的な協力と各国の独自の政策が統合されることで、気候変動対策と経済成長の両立が実現可能です。次にQwen2.5-Turboです。

Qwen2.5-Turboの結果はこちら

1. 気候変動の現状とその社会的・経済的影響:

気候変動は、地球温暖化、極端な天候の増加、海面の上昇などの形で進行しています。2019年には、世界全体の二酸化炭素排出量が43.1ギガトンに達しました(国連環境計画)。これらの影響は、農業生産性の低下、自然災害の増加、健康リスクの高まりなど、社会と経済に多大な影響を与えています。例えば、2017年のハリケーンハービーはテキサス州の経済に約1250億ドルの損失を与えました(米国国家海洋大気庁)。

2. 再生可能エネルギーの利点と課題:

再生可能エネルギーは、二酸化炭素排出量が少ない、無限の供給源があるといった利点があります。しかし、その導入には、初期投資コストが高い、安定した供給が難しいといった課題があります。例えば、風力発電は風がないと電力を生成できませんし、太陽光発電は夜間や曇りの日は電力を生成できません。

3. 再生可能エネルギーの導入を促進する政策や戦略:

各国は、再生可能エネルギーの導入を促進するための政策や戦略を講じる必要があります。これには、再生可能エネルギーの導入に対する税制優遇措置、固定価格買取り制度、研究開発への投資などが含まれます。例えば、ドイツは2000年に固定価格買取り制度を導入し、再生可能エネルギーの導入を急速に進めました。

4. 化石燃料産業の再構築:

化石燃料産業の再構築には、技術的な課題(例えば、化石燃料からの移行に必要な新しい技術の開発)と社会的な課題(例えば、化石燃料産業に従事する人々の雇用保障)があります。これらの課題を克服するためには、政府と産業界とのパートナーシップが必要です。また、教育と訓練プログラムを通じて、新たなスキルと知識を習得することも重要です。

5. 国際的な協力とエネルギー政策:

国際的な協力は、エネルギー政策を通じた気候変動対策と経済成長の両立を達成する上で不可欠です。例えば、パリ協定は、国際的な協力を通じて気候変動に対処するためのフレームワークを提供しています。また、国際的な協力は、技術の移転と拡散、資金の提供、能力構築などの面でも重要です。最後にChatGPT-4oです。

ChatGPT-4oの結果はこちら

### 気候変動の現状とその社会的・経済的影響

気候変動は地球規模の課題であり、主に化石燃料の燃焼による温室効果ガス(GHG)の増加が原因です。産業革命以降、地球の平均気温は約1.1°C上昇しており、この傾向が続けば、極端な気象現象や海面上昇がさらに深刻化します。

- **社会的影響**: 洪水や干ばつの頻発により、食料安全保障が脅かされています。例として、2022年のパキスタン洪水では3300万人が影響を受け、経済的損失は300億ドルに達しました。

- **経済的影響**: 気候変動は農業、漁業、観光などの産業に深刻な打撃を与えます。世界銀行の報告によると、気候変動に対応しない場合、2030年までに世界経済は年間1.6兆ドルの損失を被る可能性があります。

---

### 再生可能エネルギーの利点と課題

#### 利点:

1. **環境面**: 温室効果ガスの排出がほぼゼロで、気候変動抑制に寄与します。

2. **エネルギー安全保障**: 自国で生産可能なエネルギー源であり、輸入への依存度を減らします。

3. **雇用創出**: 再生可能エネルギー産業は、新たな雇用機会を提供します。例として、2021年には世界で約1230万人がこの分野に従事していました(IRENA調査)。

4. **コスト競争力**: 太陽光や風力発電のコストは近年急激に低下しており、化石燃料より安価な場合もあります。

#### 課題:

1. **不安定性**: 太陽光や風力は天候に依存するため、電力供給が不安定になる可能性があります。

2. **初期コスト**: 発電設備の導入に高額な初期投資が必要です。

3. **土地利用**: 大規模な発電所の設置は、土地利用や生態系への影響を引き起こす可能性があります。

4. **インフラの制約**: 再生可能エネルギーを効率的に活用するためには、送電網やエネルギー貯蔵技術の改善が必要です。

---

### 各国が取るべき政策や戦略

1. **経済的インセンティブ**:

- 再生可能エネルギーの導入を促進するために補助金や税控除を提供。

- 炭素税を導入し、化石燃料の利用コストを上げる。

2. **規制強化**:

- 再生可能エネルギーの利用割合を段階的に増やすための目標を設定。

- 新しい化石燃料プロジェクトの許可を制限。

3. **研究開発(R&D)支援**:

- エネルギー貯蔵技術や送電網の効率化を目指す技術革新に投資。

- 水素エネルギーやCCUS(Carbon Capture, Utilization, and Storage)技術を推進。

4. **国民への教育と啓発**:

- 再生可能エネルギーの利点を伝え、個人レベルでの行動変容を促進。

---

### 化石燃料産業の再構築における障壁と克服案

#### 技術的障壁:

1. **既存インフラ**: 化石燃料ベースの送電網や精製所は、再生可能エネルギーには適していません。

- **克服案**: 送電網をスマートグリッド化し、エネルギー貯蔵設備を増強。

2. **エネルギー貯蔵技術の限界**:

- **克服案**: リチウムイオン電池だけでなく、フローバッテリーや水素貯蔵技術への投資を増やす。

#### 社会的障壁:

1. **雇用喪失**: 化石燃料産業からの転換により、大量の雇用が失われるリスク。

- **克服案**: 再生可能エネルギー分野での再訓練プログラムを提供。

2. **地域経済への影響**: 資源産出地域では、経済が化石燃料に依存。

- **克服案**: 影響を受ける地域で新たな産業クラスターを形成。

---

### 国際的な協力とエネルギー政策の両立

気候変動は国境を越えた問題であり、各国の連携が不可欠です。国際的な協力には以下の取り組みが重要です。

1. **資金援助**:

- 気候変動に脆弱な発展途上国に対して、再生可能エネルギー導入のための資金を提供(例: 緑の気候基金)。

2. **技術移転**:

- 再生可能エネルギー技術を共有し、グローバルな技術格差を縮小。

3. **共同研究**:

- 複数国が共同で新技術を開発する枠組みを設立。

#### 経済成長と両立するエネルギー政策

- 再生可能エネルギー産業を成長分野として位置づけ、イノベーションを促進。

- インフラ投資を拡大し、地域経済の活性化を図る。

- 産業界と連携し、脱炭素化の達成と同時に競争力を維持。

具体例として、欧州連合(EU)は「欧州グリーンディール」を通じて2030年までに温室効果ガスを55%削減し、経済成長を維持することを目指しています。このモデルは、持続可能な成長と気候目標の両立の実例として参考になります。

---

### 結論

再生可能エネルギーの普及は気候変動への対応に不可欠ですが、課題を克服するためには技術革新、政策的支援、国際協力が必要です。各国が協調して持続可能な未来を築くため、包括的かつ実行可能なエネルギー政策を策定し、実現していくことが求められます。回答文章量的には、Qwen2.5-1M>ChatGPT-4o>Qwen2.5-Turboという感じでしょうか。

確かにQwen2.5-1Mは長文タスクをこなせるようです。これまでもたくさんのLLMが登場していますが、長文タスクに関しては、Qwen2.5-1Mが担っていきそうですね。

もちろん長文タスクだけでなく、短文タスクにもQwen2.5-1Mは対応しています。

なお、GPT-o1に匹敵する最新AIモデル【DeepSeek-R1】について詳しく知りたい方は、下記の記事を合わせてご確認ください。

まとめ

本記事ではQwen2.5-1Mの概要からgoogle colaboratoryでの使い方まで解説をしました。長文タスクをこなすことができるLLMが登場したことにより、今後はRAGの性能も一層上がりそうな気がします。

長いテキストを読み込ませて、そのテキストをもとに回答を生成させることで、これまで以上に正確で信頼性の高い回答を得られるのではないでしょうか。

ぜひ本記事を参考にQwen2.5-1Mを実装してみてください!

最後に

いかがだったでしょうか

LLMを活用することで、膨大なデータから迅速かつ正確な分析や文章生成が可能になります。これにより、業務効率化や意思決定の質を向上させることができ、顧客対応の改善や新規事業の立ち上げなど、多岐にわたるビジネスに役立ちます。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。