【Qwen3.5-397B-A17B】マルチモーダルトークンの早期融合学習が採用されたアリババの次世代AIモデルを徹底解説!

- アリババクラウドのQwenチームが開発した次世代マルチモーダルAIモデル

- モデル全体では397Bのパラメータを持ちながら、1トークンの処理に使われるアクティブパラメータはわずか17Bに抑えられている

- 201の言語・方言をサポートし、最大約100万トークンという超長文コンテキストにも対応

2026年2月16日、アリババのQwenチームが新たな大規模AIモデル「Qwen3.5-397B-A17B」を発表しました!

Qwen3.5-397B-A17Bは、総パラメータ数397B(3970億)という巨大なモデルでありながら、推論時にはわずか17B(170億)のパラメータのみを活性化するという、極めて効率的なアーキテクチャを採用しています。

テキストだけでなく、画像や動画もネイティブに理解できるマルチモーダル対応に加え、201の言語・方言をサポートし、最大約100万トークンという超長文コンテキストにも対応しています。

そこで本記事では、このQwen3.5-397B-A17Bの仕組みから使い方、料金体系、実際の活用シーンまでを徹底的に解説していきます。

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

Qwen3.5-397B-A17Bとは?

Qwen3.5-397B-A17Bは、アリババクラウドのQwenチームが開発した次世代マルチモーダルAIモデルです。

「397B-A17B」という名前の通り、モデル全体では397B(約3970億)のパラメータを持ちながら、1トークンの処理に使われるアクティブパラメータはわずか17B(約170億)に抑えられています。これはMixture-of-Experts(MoE)と呼ばれるアーキテクチャによるもので、512個のエキスパートモジュールの中からトークンごとに最適な11個だけを選択して処理を行います。

テキスト生成はもちろんのこと、画像や動画の入力にもネイティブ対応しています。

Qwen3世代までは、言語モデルとビジョンモデルが別々に存在していましたが、Qwen3.5ではマルチモーダルトークンの早期融合学習(Early Fusion Training)を採用し、1つのモデルでテキスト・画像・動画をシームレスに処理できるようになりました。

コンテキスト長についても大幅に進化しています。ネイティブで262,144トークン(約26万トークン)に対応し、YaRN(Yet Another Rotary iNterpolation)スケーリングを適用することで最大約100万トークンまで拡張可能となっています。

Qwen3.5-397B-A17Bの仕組み

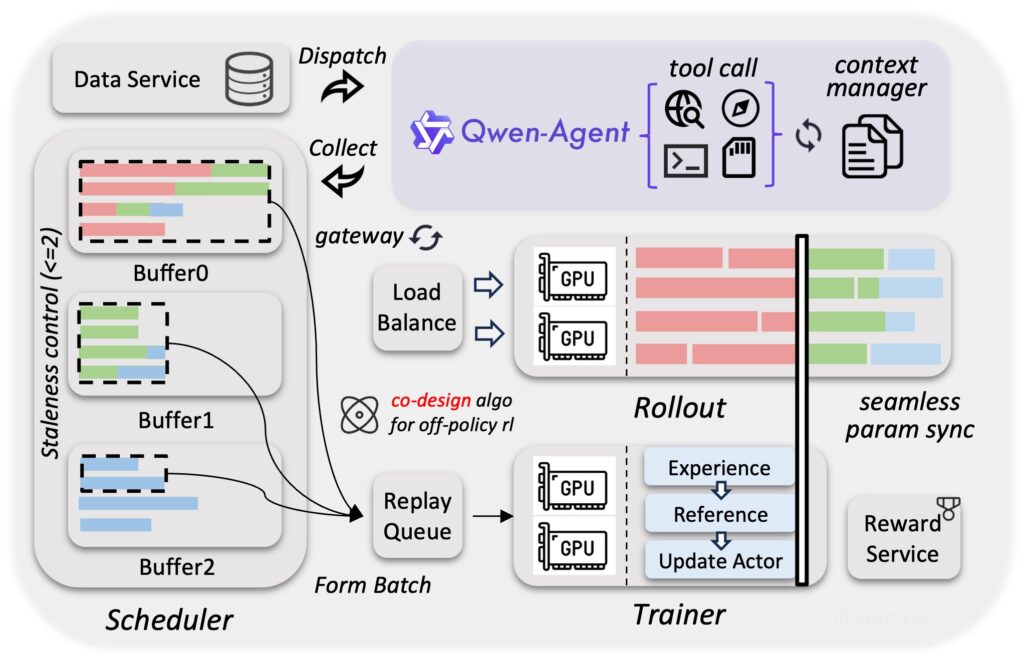

Qwen3.5-397B-A17Bには、2つの革新的な技術が組み合わされています。「Gated Delta Networks(ゲーテッドデルタネットワーク)」と「疎なMixture-of-Experts(MoE)」です。

モデルは全60層で構成されていて、各ブロックは「3層のGated DeltaNet + MoE」と「1層のGated Attention + MoE」が交互に積み重なる構造をとっています。

つまり、4層のうち3層が線形注意(Gated DeltaNet)、残り1層が標準的な二次注意(Gated Attention)という3:1の比率になっています。

前者のGated DeltaNetは、従来のTransformerが抱えていた長文処理時の計算量の爆発的増加を解消する仕組みです。

通常のアテンション機構では、シーケンス長の二乗に比例して計算コストが増えると思いますが、Gated DeltaNetは線形の計算量で処理が可能です。

これによって、256Kトークンの超長文でもメモリ不足に陥ることなく処理できて、Qwen3-Maxと比較しても32Kコンテキストで8.6倍、256Kコンテキストで19倍という高速デコードを実現しています。

また、MoE層では、512個のエキスパートモジュールからトークンごとに最適な10個をルーティングし、さらに1個の共有エキスパートを加えた合計11個で処理を行います。

Qwen3.5-397B-A17Bの特徴

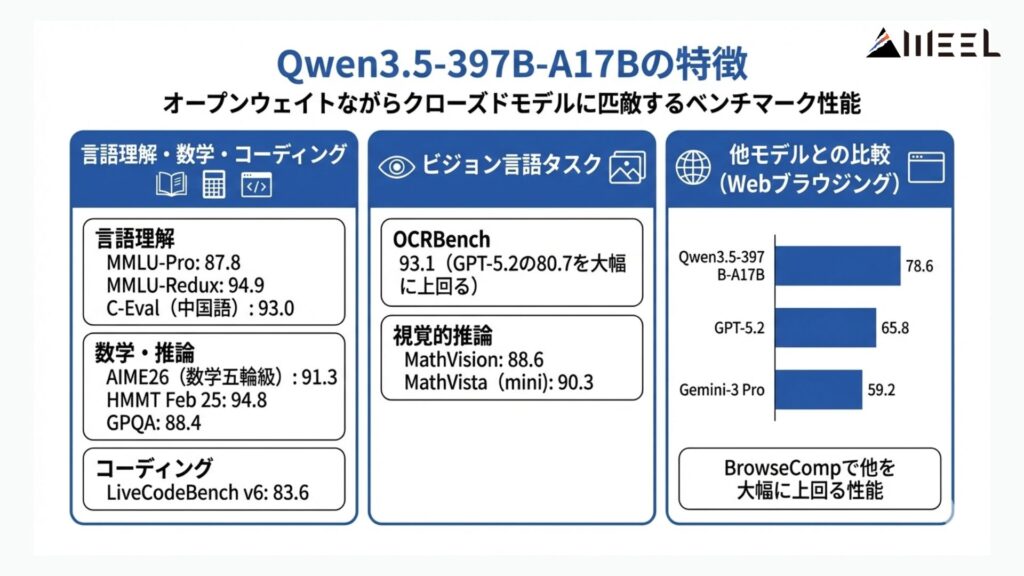

Qwen3.5-397B-A17Bの最大の強みは、オープンウェイトモデルでありながらクローズドモデルに匹敵するベンチマーク性能を発揮する点です。公式が公開しているベンチマーク結果から、主要な数値を見ていきましょう。

言語理解の分野では、MMLU-Proで87.8、MMLU-Reduxで94.9、中国語評価のC-Evalで93.0という高いスコアを記録しています。

数学・推論分野では、AIME26(数学オリンピック級の問題)で91.3、HMMT Feb 25で94.8、GPQAで88.4と、難関問題でも高い正答率を示しました。コーディング分野ではLiveCodeBench v6で83.6を達成しています。

ビジョン言語タスクでも注目すべき結果が出ています。

OCRBenchでは93.1を記録し、GPT-5.2の80.7を大きく上回りました。数学的な図形問題を扱うMathVisionでは88.6、MathVista(mini)で90.3と、視覚的な推論能力の高さが光ります。

Qwen3.5-397B-A17Bの安全性・制約

Qwen3.5-397B-A17Bは、オープンウェイトモデルなので、利用者自身がデプロイ環境におけるセーフティガードを構築する必要があります。

思考モード(Thinking Mode)を搭載しており、内部推論プロセスを可視化できますが、思考トークンは複数ターンの会話では、Jinja2チャットテンプレートによって自動的に削除される仕組みとなっています。

Qwen3.5-397B-A17Bの料金

Qwen3.5は、オープンウェイトモデルとしてセルフホスティングすれば無料で利用できます。

一方、アリババクラウドのModel Studio(DashScope)経由でAPIとして利用する場合は、従量課金制が適用されます。

| プラン | 入力(0〜256K) | 入力(256K〜1M) | 出力(非思考モード) | 出力(思考モード) |

|---|---|---|---|---|

| Alibaba Cloud Model Studio(国際版) | $0.4 / 100万トークン | $1.2 / 100万トークン | $2.4 / 100万トークン | $7.2 / 100万トークン |

| Alibaba Cloud Model Studio(中国本土版) | 約$0.115 / 100万トークン | 約$0.573 / 100万トークン | 約$0.688〜$3.44 / 100万トークン | – |

| OpenRouter経由 | $0.60 / 100万トークン | – | $3.60 / 100万トークン | – |

| セルフホスティング(HuggingFace / GitHub) | 無料 | 無料 | 無料 | 無料 |

Qwen3.5-397B-A17Bのライセンス

Qwen3.5-397B-A17Bは、Apache License 2.0の下で公開されています。

これはオープンソースライセンスの中でも優しめなライセンスの1つで、商用利用から改変・再配布まで幅広い用途が認められています。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 | ⭕️ | |

| 改変 | ⭕️ | |

| 配布 | ⭕️ | |

| 特許使用 | ⭕️ | |

| 私的使用 | ⭕️ |

Qwen3.5-397B-A17Bの使い方

Qwen3.5-397B-A17Bを利用する方法は大きく分けて3つあります。ブラウザから手軽に試せるWebチャット、APIとしてプログラムから呼び出す方法、そしてローカル環境にモデルをデプロイしてセルフホスティングする方法です。

それぞれの手順を見ていきましょう。

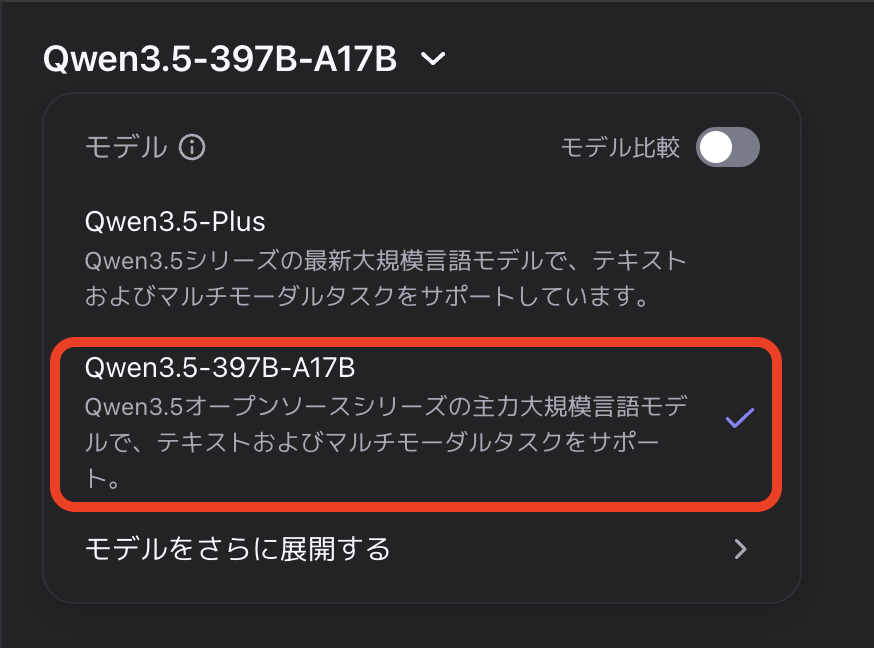

Webチャット(chat.qwen.ai)で試す

最もお手軽なのは公式のWebチャットを使う方法です。アカウント登録だけですぐに使い始められます。

ブラウザで公式Webチャットページ(https://chat.qwen.ai/)にアクセスし、Googleアカウントまたはメールアドレスでアカウント登録・ログインします。

その後、チャット画面上部のモデル選択欄から「Qwen3.5-397B-A17B」を選択します。テキストだけでなく、画像や動画をアップロードして質問することも可能です。

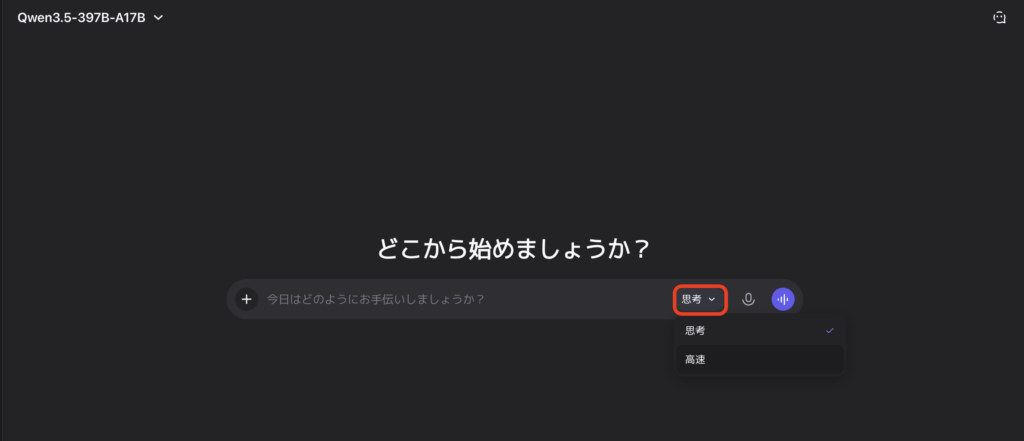

テキストボックスに質問やタスクを入力して送信すれば、Qwen3.5-397B-A17Bが応答を返してくれます。思考モード(Thinking)のオン・オフも切り替えられます。

DashScope API経由で利用する

プログラムからQwen3.5-397B-A17Bを呼び出す場合は、アリババクラウドのModel Studio(DashScope)APIを利用します。OpenAI互換のSDKがそのまま使えるため、既存のコードからの移行も簡易的かと思います。

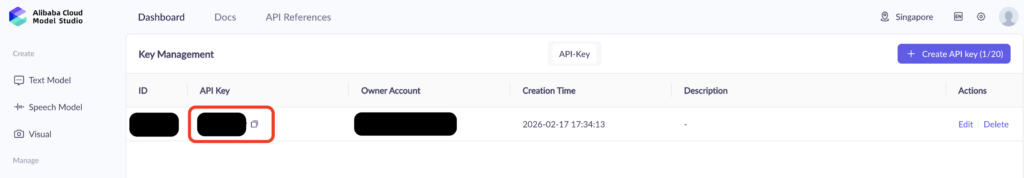

まずは、Alibaba Cloud Model Studio(https://modelstudio.alibabacloud.com/) でアカウントを登録して、ダッシュボードページからAPIキーを生成します。

その後、ご自身のPython環境でOpenAI SDKをインストールします。

pip install openaiインストールが完了したら、以下のPythonコードでテキスト生成を実行します。

from openai import OpenAI

client = OpenAI(

api_key="YOUR_DASHSCOPE_API_KEY",

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1"

)

messages = [

{"role": "user", "content": "量子コンピューティングの基本原理を簡潔に説明してください"}

]

response = client.chat.completions.create(

model="qwen3-vl-235b-a22b-thinking", # 例として、思考モードにしています

messages=messages,

max_tokens=81920,

temperature=0.6,

top_p=0.95,

extra_body={"top_k": 20},

)

print(response.choices[0].message.content)画像を添付して質問する場合は、以下のようにcontent内にimage_urlを追加します。

messages = [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": "https://example.com/chart.png"}

},

{

"type": "text",

"text": "このグラフの傾向を分析してください"

}

]

}

]

response = client.chat.completions.create(

model="qwen3-vl-235b-a22b-thinking",

messages=messages,

max_tokens=81920,

temperature=0.6,

top_p=0.95,

extra_body={"top_k": 20},

)ローカル環境にセルフホスティングする

自社インフラ上でモデルをデプロイしたい場合は、vLLMまたはSGLangを使った推論サーバーの構築が推奨されています。

まず、推論フレームワークをインストールします。

vLLMの場合:

pip install vllmSGLangの場合:

pip install sglang続いて、推論サーバーを起動します。vLLMでの起動コマンドは以下の通りです。

vllm serve Qwen/Qwen3.5-397B-A17B \

--port 8000 \

--tensor-parallel-size 8 \

--max-model-len 262144 \

--reasoning-parser qwen3SGLangの場合はこちらです。

python -m sglang.launch_server \

--model-path Qwen/Qwen3.5-397B-A17B \

--port 8000 \

--tp-size 8 \

--mem-fraction-static 0.8 \

--context-length 262144 \

--reasoning-parser qwen3ツール呼び出し(Function Calling)を有効にします。エージェント用途でツール呼び出し機能を使う場合は、起動時に以下のオプションを追加します。

vllm serve Qwen/Qwen3.5-397B-A17B \

--port 8000 \

--tensor-parallel-size 8 \

--max-model-len 262144 \

--reasoning-parser qwen3 \

--enable-auto-tool-choice \

--tool-call-parser qwen3_coderそして、サーバーにリクエストを送ります。起動後は、OpenAI互換のAPIとしてlocalhost:8000にリクエストを送信できます。

DashScope APIと同じPythonコードをそのまま使うことができます(base_urlを http://localhost:8000/v1 に変更するだけです)。

以上、代表的な使い方3つのご紹介でした。

【業界別】Qwen3.5-397B-A17Bの活用シーン

Qwen3.5-397B-A17Bは、マルチモーダル対応・超長文コンテキスト・多言語サポート・エージェント機能といった特性から、幅広い業界での活用が見込まれます。

ここでは代表的な業界ごとに、どのような使い方が向いているかを整理していきます。

金融・保険業界

金融業界において、契約書や約款、決算資料といった数10〜数100ページに及ぶドキュメントの分析は、100万トークンのコンテキスト長が真価を発揮する場面です。

PDFの図表やグラフを画像として入力し、数値の読み取りから要約・比較までを一気通貫で処理することができるかと思います。さらに、多言語対応により、海外拠点の報告書もそのまま分析可能です。

なお、金融業界のDX化について、詳しく知りたい方は以下の記事も参考にしてみてください。

製造業・建設業

製造業界においては、設計図面や検査報告書の画像を入力して、不具合箇所の検出や仕様の確認を行うといったユースケースが考えられます。

OCRベンチマークで93.1を記録した高い文字認識精度を活かし、紙ベースの帳票をデジタルデータに変換する業務フローの自動化にも適しているかと思います。

なお、製造業界における生成AI活用について、詳しく知りたい方は以下の記事も参考にしてみてください。

教育・研究機関

AIME26で91.3、GPQAで88.4を記録した高い数学・科学推論能力は、大学レベルの問題解決支援に十分な水準だと思います。

201言語対応により、多言語の学術論文を横断的に分析するリサーチアシスタントとしても機能します。Apache 2.0ライセンスのため、研究用途でのファインチューニングや派生モデルの公開にも制約がないのもポイントですね。

なお、教育業界における生成AI活用について、詳しく知りたい方は以下の記事も参考にしてみてください。

メディア・コンテンツ制作

Qwen3.5-397B-A17Bは、動画入力に対応しているため、映像コンテンツの自動要約や字幕生成、シーン分析といったタスクに活用できます。

【業務別】Qwen3.5-397B-A17Bが解決できること

ここでは、ビジネスや開発の現場で実際に直面しがちな課題と、Qwen3.5-397B-A17Bがどのように解決策となり得るかを整理します。

短時間で大量ドキュメントを処理

Qwen3.5-397B-A17Bの特徴である、100万トークンのコンテキスト長と高速デコード(従来比最大19倍)によって、数100ページの書類を一度に読み込んで分析できます。

契約書のレビュー、議事録の要約、規制文書のチェックなど、人手で数日かかる作業を大幅に短縮可能です。

紙帳票のデジタル化でOCR精度が足りない

OCRベンチマーク93.1という高精度な文字認識能力を持ち、手書き文字や複雑なレイアウトの帳票でも高い読み取り精度を発揮してくれます。

画像入力として、帳票の写真やスキャンデータを渡すだけで、構造化データへの変換が可能です。

多言語対応AIシステムの構築

Qwen3.5-397B-A17Bは、201の言語・方言に対応しているため、このモデルだけで多言語サービスを展開できます。

言語ごとに別のモデルを用意する必要がなく、インフラコストの削減と運用の簡素化が同時に実現します。

Qwen3.5-397B-A17Bを使ってみた

それでは実際に、Qwen3.5-397B-A17Bを公式Webチャット上で使ってみましょう。

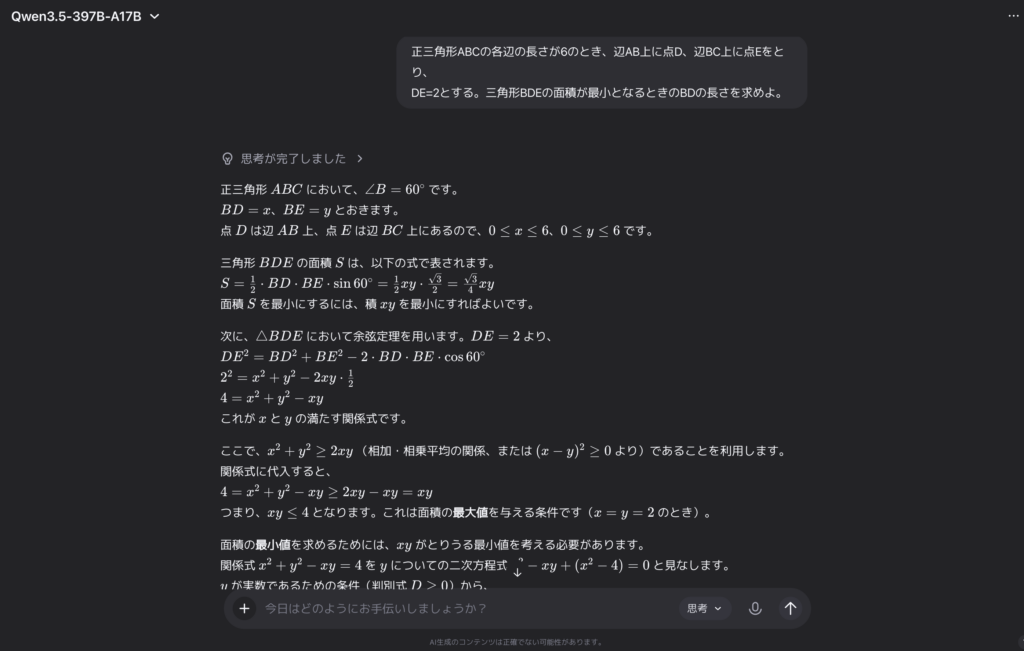

数学タスク

プロンプトはこちら

正三角形ABCの各辺の長さが6のとき、辺AB上に点D、辺BC上に点Eをとり、

DE=2とする。三角形BDEの面積が最小となるときのBDの長さを求めよ。出力結果はこちら(一部抜粋)

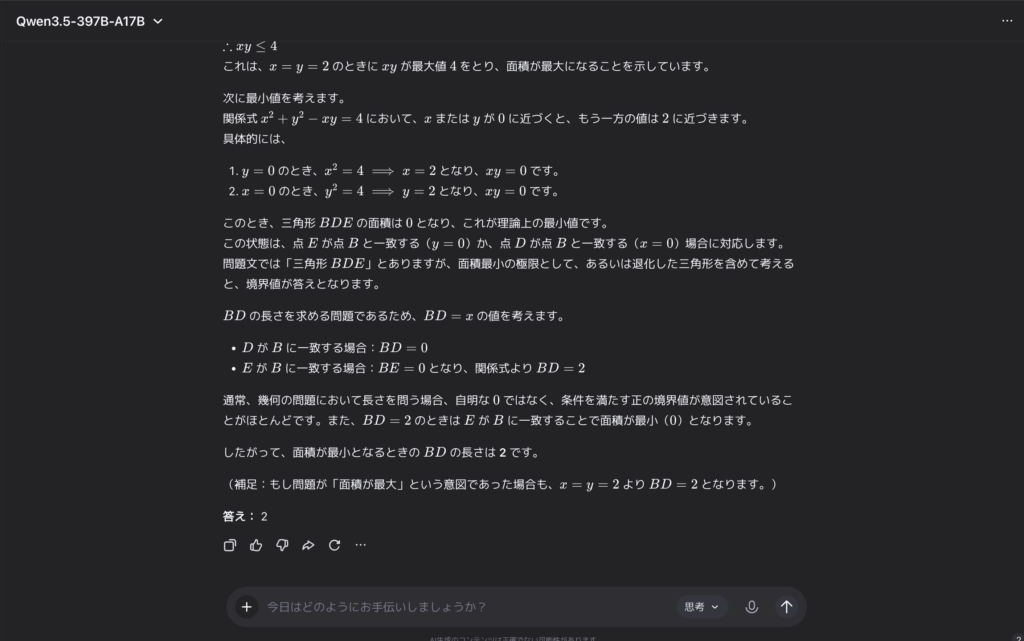

「面積が最小」になるケースでは、退化した三角形に行き着いていて、Qwen3.5自身もその点に言及した上で「条件を満たす正の境界値」としてBD=2を選んでいますね。

問題の意図として、「面積が正の最小値」を求めるのか「面積が最大」を求めるのかで解釈が分かれうる問題設定だったので、Qwen3.5が補足で両方のケースに触れているのは丁寧な対応だと感じました。

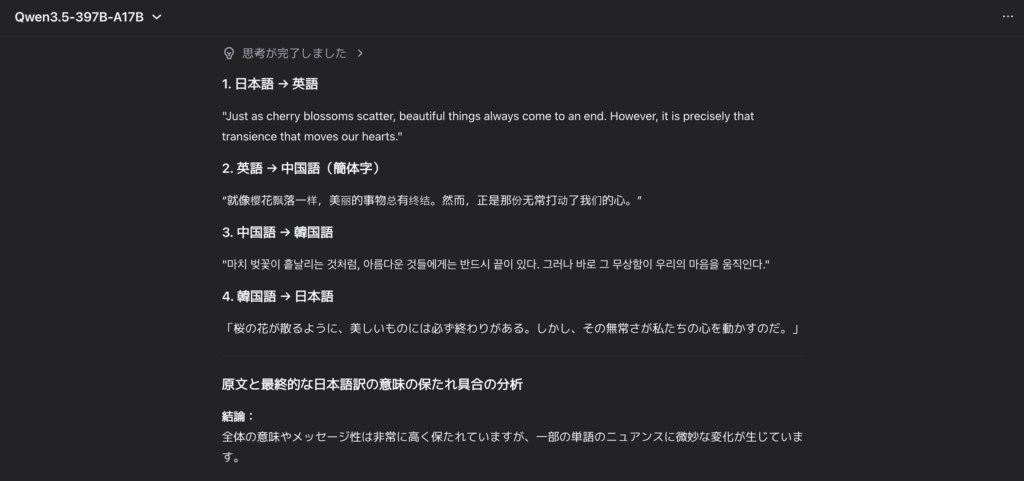

多言語翻訳タスク

プロンプトはこちら

以下の日本語の文章を、次の順番で翻訳してください。

各ステップの翻訳結果をすべて出力してください。

原文(日本語):「桜の花が散るように、美しいものには必ず終わりがある。

しかしその儚さこそが、私たちの心を打つのだ。」

1. 日本語 → 英語

2. 英語 → 中国語(簡体字)

3. 中国語 → 韓国語

4. 韓国語 → 日本語

最後に、原文と最終的な日本語訳の意味がどの程度保たれているかを分析してください。出力結果はこちら(一部抜粋)

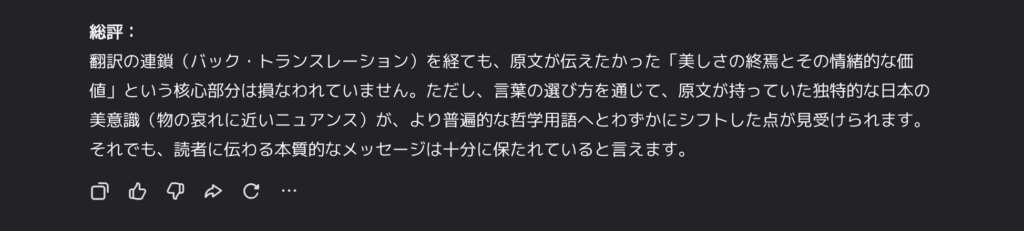

なんの問題もなく、一連の翻訳連鎖を経て、ほとんど意味を損なわずに日本語へ戻してくれました。自己評価も良い感じですね。

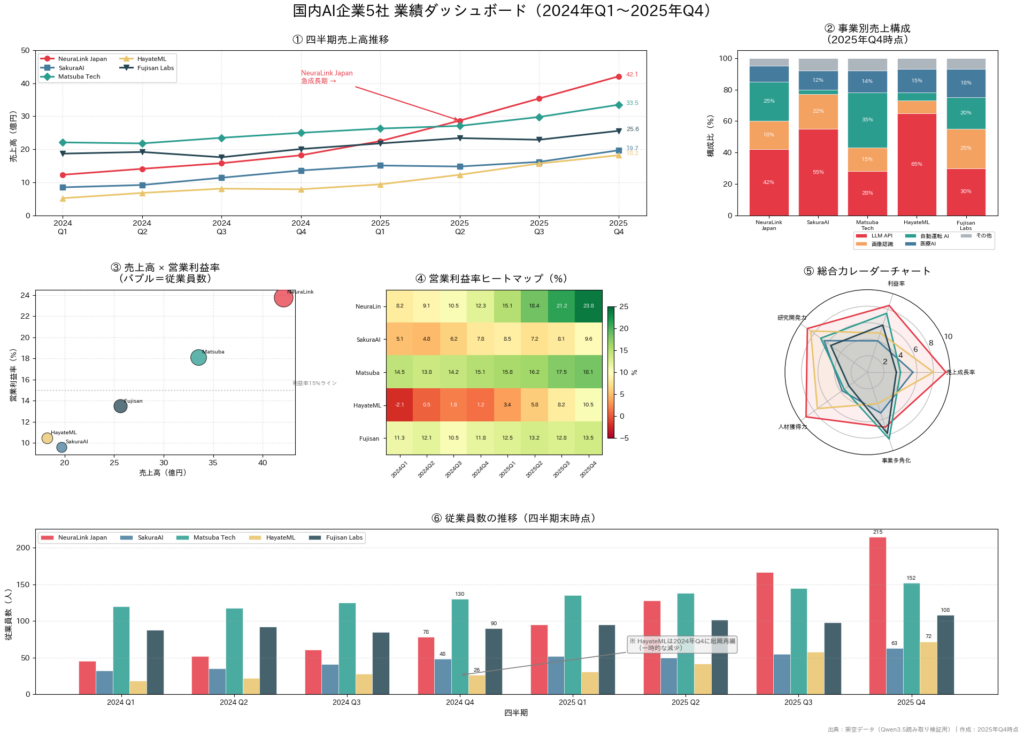

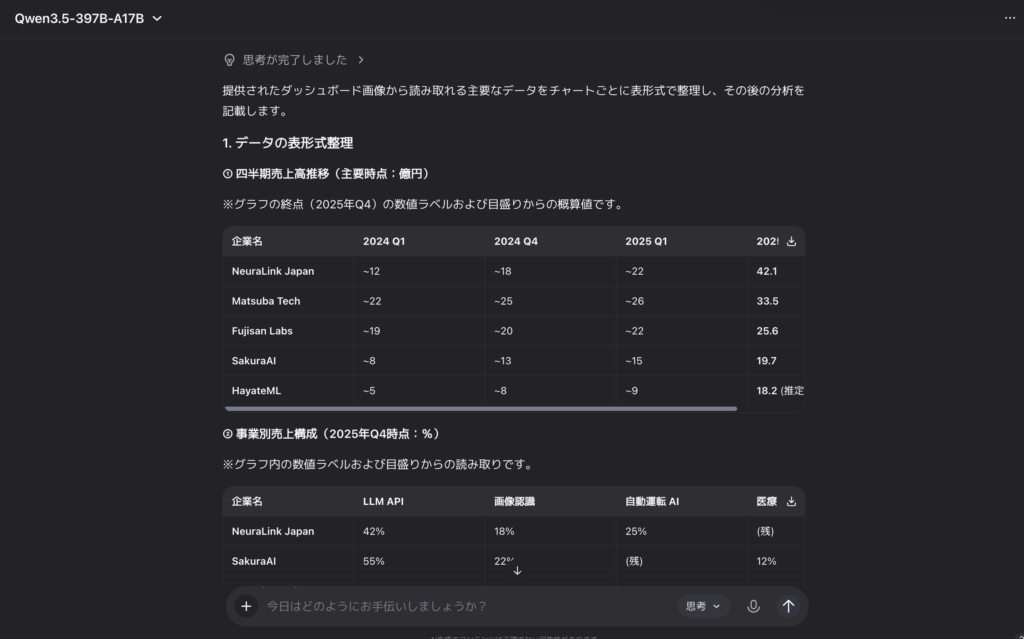

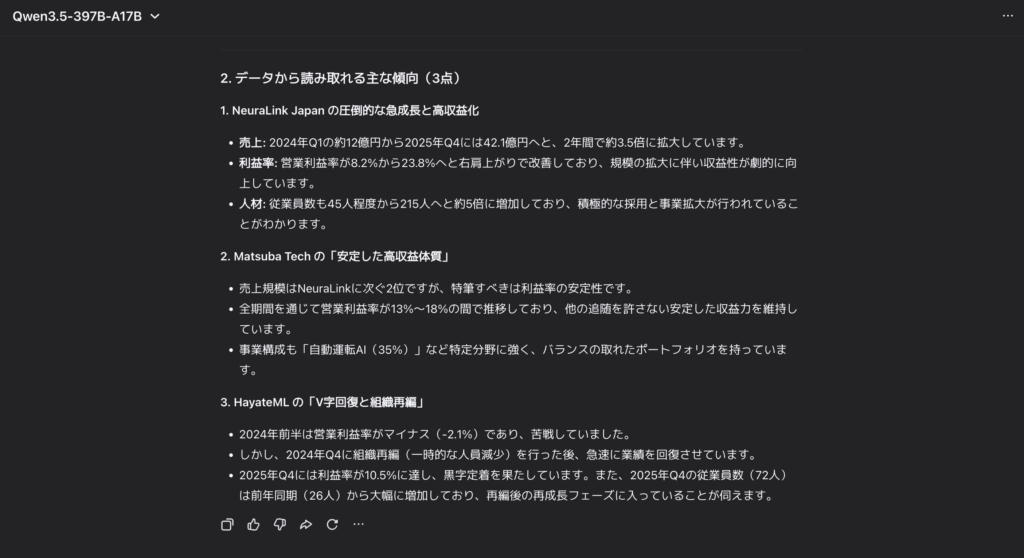

複雑なグラフ画像読み取りタスク

プロンプトと入力画像はこちら。画像は、本タスク用に生成した架空のデータです。

この画像に含まれるすべてのデータを読み取り、表形式に整理してください。

また、読み取ったデータに基づいて主な傾向を3点挙げてください。

出力結果はこちら(一部抜粋)

整理されているとはいえ複雑なグラフ画像から、正確な数値情報、会社ごとの傾向まで分析してくれました。

各タスクにおいて、ハイレベルな遂行能力を見せてくれたと思います。

よくある質問

まとめ

Qwen3.5-397B-A17Bは、アリババが2026年2月16日にリリースした次世代マルチモーダルAIモデルです。

397Bのパラメータからトークンごとに17Bだけを活性化するMoEアーキテクチャと、線形計算量を実現するGated Delta Networksの組み合わせにより、巨大モデルの表現力と効率的な推論を両立しています。

気になった方は、ぜひ一度試してみてください。

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。