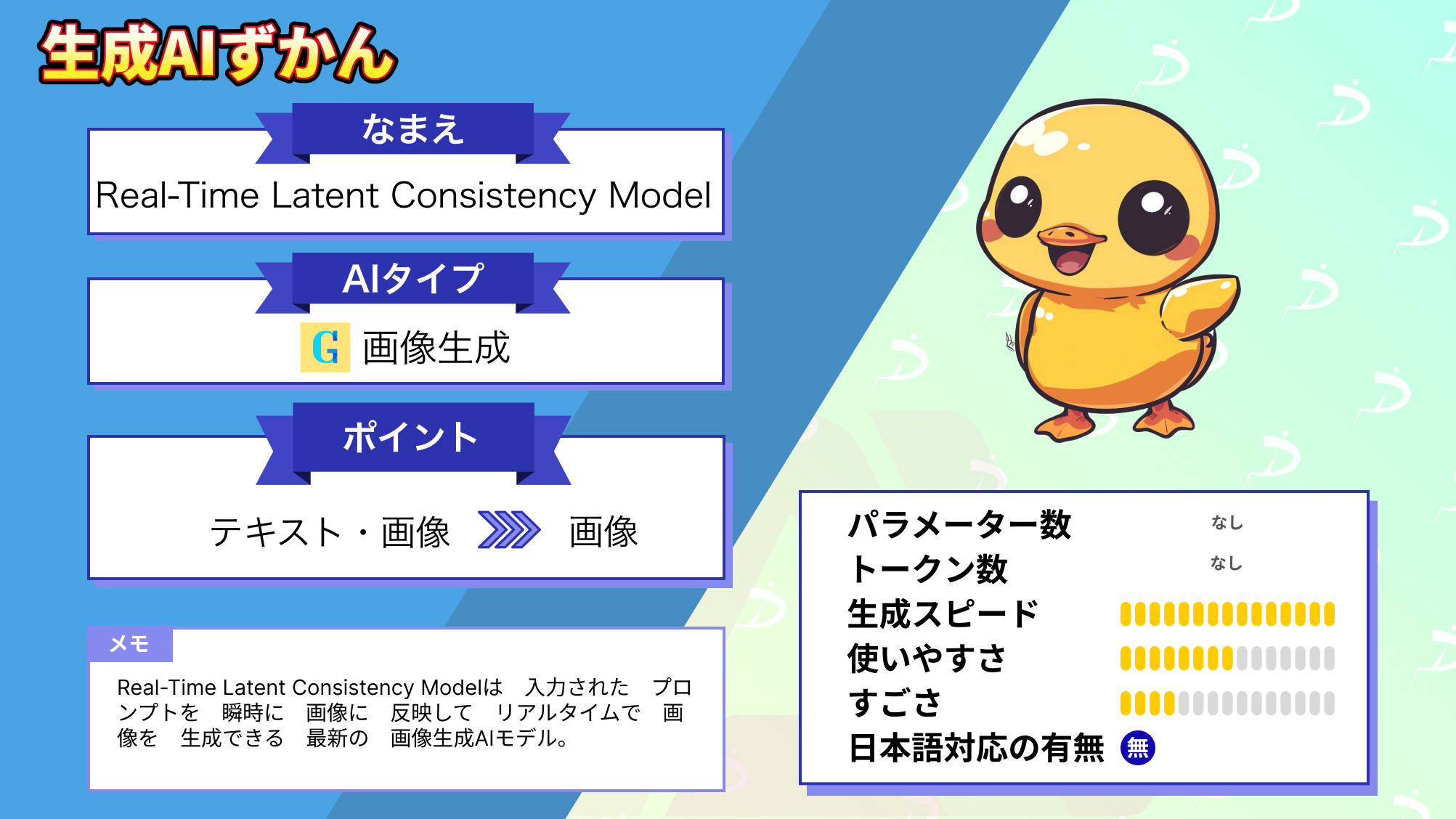

【Real-Time Latent Consistency Model】リアルタイムで入力したプロンプトがすぐに画像になる高速画像生成AIを使ってみた

Real-Time Latent Consistency Modelは、リアルタイムで画像生成をすることができ、ユーザーが入力したプロンプトが反映された画像を逐一出力します。

一文字変えるだけでも瞬時に別の画像を生成するので、理想の画像が作れると今世間を賑わせており、デモを紹介したポストには1700以上のいいねがついています。

実際にこんなことができちゃうんです!

一瞬で画像が変化するのはすごいですよね!

今回は、Real-Time Latent Consistency Modelの概要や使ってみた感想をお伝えします。

是非最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

Real-Time Latent Consistency Modelの概要

Real-Time Latent Consistency Modelは、潜在一貫性モデル (Latent Consistency Model)を利用して、リアルタイムで画像を生成することが可能になった最新の画像生成モデルです。

LCMはリアルタイムで動作するように設計されており、ウェブカメラのインタラクションやプロンプトの入力などに、即時結果を返せるようになっています。

以下は、デモを実行した際の様子です。

プロンプトを入力すると、逐一画像が変化し、段々と具体的な画像が出力されているのが分かります。

なぜこれほどまでに高速な画像生成が可能なのかというと、潜在一貫性モデル(LCM)は、時間のすべての点から原点へのマッピングを学習し、1stepまたは数stepで画像を生成することを可能にしているからです。

もう少し具体的に説明すると、通常のモデルは画像を生成する際に、多くの中間ステップを経て徐々に詳細な画像にしていく必要があります。

一方LCMは、画像の生成過程における各時点での情報を原点に関連付けることを学び、画像の各ピクセルや特徴がどのように組み合わされるべきかを効率的に把握し、迅速に高品質な画像を生成します。

その結果、従来のモデルより大幅に生成速度が向上し、リアルタイム画像生成ができるほどになっています。

このReal-Time Latent Consistency Modelは、Hugging Face上でデモが公開されており、誰でも簡単に利用できます。

しかし、現在デモ版はアクセスが集中しており、なかなか満足に画像生成ができない状況になっているようです。

ただ、このモデルは従来のものに比べて軽量であるため、一般的な家庭用GPUでも十分動くようなので、今回はローカルで動かしてみたいと思います。

早速導入方法から解説していきます。

\画像生成AIを商用利用する際はライセンスを確認しましょう/

Real-Time Latent Consistency Modelの導入方法

ローカルへの導入方法は、以下のGithubページに記載されています。

radames/Real-Time-Latent-Consistency-Model

また、デモ版を使いたい方は以下のリンクからアクセスしてください。

spaces/radames/Real-Time-Latent-Consistency-Model-Text-To-Image

ローカルに導入するにあたり、CUDAとPythonのインストールまたは、M1/M2/M3チップのMacが必要だそうです。

私は、WindowsにCUDA12.3とPython3.11を入れて導入しました。

ちなみに、必要スペックなどの情報は書いてなかったのですが、参考までに今回導入した私のPCのスペックを記載しておきます。

CPU:AMD Ryzen 5 3600 6-Core Processor 3.60 GHz

GPU:NVIDIA RTX 2060 SUPER 8GB

RAM:16GB

では、早速導入していきましょう。

まずはReal-Time Latent Consistency ModelのGitHubリポジトリをクローンし、そのディレクトリに移動します。

git clone https://github.com/radames/Real-Time-Latent-Consistency-Model.git

cd Real-Time-Latent-Consistency-Model次に、以下のコードを実行して仮想環境を作成します。

python -m venv venv作成したら仮想環境を起動します。

Windows

.\venv\Scripts\activateUnix

source venv/bin/activate仮想環境になったのを確認したら、以下のコードを実行して必要なパッケージをインストールします。

pip install -r requirements.txt最後に、以下のコードを実行してuvicornサーバを起動すれば導入は完了です。

uvicorn "app-txt2img:app" --host 127.0.0.1 --port 7860 --reloadポート番号は任意のものを入力してください。

以下のようにApplication startup complete.と表示されていれば成功です。

表示されているURLにアクセスすると以下のような画面になります。

それでは実際に使っていきましょう!

なお、リアルタイムに画像が生成されるAIについて知りたい方はこちらをご覧ください。

→【SDXL Turbo】最強のリアルタイム画像生成AI!使い方や導入方法、機能比較まで

Real-Time Latent Consistency Modelを実際に使ってみた

以下のプロンプトを入力して、逐一画像生成してくれるのか見ていきます。

1girl, cute, smile実行の様子は以下の動画をご覧ください。

最終的に生成された画像はこちらです。

プロンプトに沿った高品質な画像が生成できていますね!

生成に関しても、プロンプトを入力するごとに逐一画像を出力してくれました。

私の環境でも一瞬で生成できるので、汎用性も速度も品質も文句ないですね!

これは本当にすごいモデルが出てきたかもしれません。

ここからは、さらにいくつかのパターンの複雑なプロンプトを入力してみて、生成時間やクオリティが変化するか検証していきます。

Real-Time Latent Consistency Modelの性能を検証してみた

ここでは、いくつかのパターンのプロンプトを入力して、結果がどのように変化するのか検証します。

まずは、先ほどのものから大幅に長くしたプロンプトを入力してみます。

1girl, collarbone, wavy hair, looking at viewer, blurry foreground, upper body, necklace, contemporary, plain pants, ponytail, freckles, red hair, dappled sunlight, smile, happy生成の様子

生成画像

かなり多くのプロンプトを入力しましたが、生成の様子を見ていただくと分かるように、こちらも入力するたびに正確に反映されて行っていることが分かります。

最終的な生成画像もプロンプトに沿ったものになっており、クオリティも十分高いです。

次は、人物ではなく風景を出力させてみます。

image of a bustling Tokyo street scene at dusk, with the iconic Tokyo Tower in the background, people crossing the Shibuya Crossing, neon signs illuminating the area, cherry blossoms gently falling生成の様子

生成画像

こちらは、画像自体はなかなかクオリティの高いものになっていますが、with the iconic Tokyo Tower in the backgroundの後のプロンプトがほとんど反映されておらず、生成の様子を見てもプロンプトを入力してもほとんど画像が変わっていないことが分かります。

なぜそのようなことになったのか原因は不明ですが、プロンプトの書き方や組み合わせの問題である可能性もあり、今後研究が進むにつれ、最適なプロンプトの書き方などが示されることを期待しましょう。

続いて、プロンプトに画像のクオリティや解像度を上げるプロンプトを入力すると、どのような変化が起こるのか検証します。

以下のプロンプトを入力します。

clear, high-quality, 8k, masterpiece, best quality, image of Tokyo at sunset, Tokyo Tower, bright neon signs, cherry blossoms,生成の様子

生成画像

先ほどの画像は少し暗かったので、clearというプロンプト追加し、とりあえずより高精細にしたかったので、high-quality, 8k, masterpiece, best qualityを追加しました。

結果は画像が明るくなりましたが、ディテールはあまり変わっていないような気がします。

ただ、生成の様子を見ると、先ほどの2つ目の検証と違い、入力したプロンプトが全部反映され、画像が大きく変わっていくことが分かります。

やはり、プロンプトの書き方や組み合わせに原因があるのかもしれません。

ここまでReal-Time Latent Consistency Modelを使ってきましたが、画像のクオリティは従来のモデルより多少劣るかもしれませんが、全然だめというわけではありません。

むしろ、この生成速度でここまでの品質の画像が生成できるのはすごいことだと思います。

今後、さらに研究が進んで、より高いクオリティでより速い生成ができるようになれば、、潜在一貫性モデル (Latent Consistency Model)は画像生成モデルのスタンダードになる可能性を秘めています。

使える機能が増えたり、さらに進化したモデルが登場した際は、また記事にしてご紹介します。

なお、高速画像生成モデルInstaflowについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【InstaFlow】Stable Diffusionの40倍の速さで画像生成できるAI

まとめ

Real-Time Latent Consistency Modelは、潜在一貫性モデル (Latent Consistency Model)を利用して、プロンプトを逐一画像に反映して、リアルタイムで画像を生成することが可能になった最新の画像生成モデルです。

従来のモデルが段階を踏んで画像を生成するところを、一気にワンステップで行うように学習することで、超高速で高品質な画像を生成できます。

使ってみた感想は、一般的な家庭用GPUでも超高速で、十分なクオリティの画像が生成できるため、今後の画像生成モデルのスタンダードになる可能性を秘めていると感じました。

潜在一貫性モデルを利用した高速画像生成は、今後も継続的に研究が行われ、さらに進化することが予想されますので、期待が高まりますね!

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。