LSTM(長・短期記憶)とは?RNNやGRUとの違い、活用するメリットをわかりやすく解説

WEELメディア事業部リサーチャーのいつきです。

LSTMとは、生成AIや時系列予測で活躍するニューラルネットワークの1つです。日本語では長・短期記憶とも略されており、文章生成や音声生成などの技術に活用されています。

今回の記事では、LSTMの特徴や仕組み、RNNやGRUとの違いをご紹介します。

最後までお読みいただくと、普段使用している生成AIの仕組みを深く理解できるので、AI活用の幅が広がり、生成AIマスターに一歩近づくでしょう。

ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

LSTM(長・短期記憶)とは

LSTM(長・短期記憶)とは、機械学習を行うためのニューラルネットワークの一種で、「Long Short Term Memory」の略です。

従来のニューラルネットワークが抱えていた長いデータの処理における課題を克服し、入力された情報を活用して学習モデルを構築できます。

LSTMの主な特徴は、時間の経過とともにデータの依存関係を考慮できる点です。従来のニューラルネットワークは、時間的な情報を保持する能力が弱く、長文や時間の長いデータに対して正確な学習が難しいという課題を抱えていました。

LSTMはこれを改善し、長期間の依存関係があるデータでも高精度な予測や学習を可能にしています。

LSTMとRNNの違い

RNNとは、「Recurrent Neural Network」の略で、「回帰型ニューラルネットワーク」とも呼ばれています。時間の経過とともに変化するデータの学習を得意としているので、予測系のタスクをこなせるのが特徴です。

LSTMとRNNの違いは、記憶セルの有無です。RNNはセルを持たず、単純に前のステップの出力を次のステップへ引き渡す仕組みです。一方でLSTMは記憶セルを持つことで、長期間の情報をキープしながら必要に応じて過去の情報を引き出し、高精度な予測を実現しています。

つまり、RNNが抱えていた長期データ処理の課題を克服したのがLSTMなんです。

なお、生成AIについて詳しく知りたい方は、以下の記事もご覧ください。

生成AIにはChatGPTやMidjourneyなど、多岐にわたるものがあります。

他にもどんな生成AIがあるのか、それらの仕組みも併せて知りたいという方に、おすすめの記事です。

続きを読む

LSTMとGRUの違い

GRUとは、「Gated Recurrent Unit」の略で、「ゲート付き回帰型ユニット」とも呼ばれています。LSTMと似た機能を備えているニューラルネットワークの一種です。

LSTMとGRUは、どちらもRNNの改良版ですが、その構造や仕組みが異なります。LSTMは記憶セルを使って情報を保持する複雑な構造をしているのに対し、記憶セルがないGRUはその分構造がシンプルです。

LSTMとGPUの主な違いを表で整理します。

| 比較項目 | LSTM | GPU |

|---|---|---|

| ゲート数 | 3つ(忘却・入力・出力) | 2つ(リセット・更新) |

| 記憶セル | あり(長期記憶が得意) | なし(シンプル構造) |

| 処理速度 | やや遅いが高精度 | 高速だが精度はタスク次第 |

| 得意な用途 | 長文や複雑な時系列処理 | 短文やリアルタイム処理 |

どちらが優れているかはタスクの種類によって異なります。構造が複雑なLSTMは長文理解などで長けていますが、シンプルなタスクであればGRUのほうが速いです。

LSTMとTransformerの違い・使い分け

LSTMとTransformerはどちらも自然言語処理や時系列データ分析に使われるニューラルネットワークですが、その仕組みや得意領域が異なります。

LSTMは、RNNを改良したモデルで、時系列の長期依存関係を処理できる「記憶セル」と複数のゲートを備えています。

一方のTransformerは、2017年に提唱された比較的新しいモデルで、自己注意機構(Self-Attention)によって文章中の重要部分を直接参照し、並列処理を行うことで計算効率を向上させています。

LSTMは、少量から中規模のデータや、特に順序が明確で連続性が重要な株価予測・天気予報・音声認識などのタスクに強みがあります。

Transformerは、大規模データを扱う翻訳・文章生成・要約などの自然言語処理で特に高い精度を発揮しますが、計算資源が比較的多く必要になります。

目的やデータ規模に応じて適切に使い分けることが、生成AIプロジェクト成功の鍵となります。

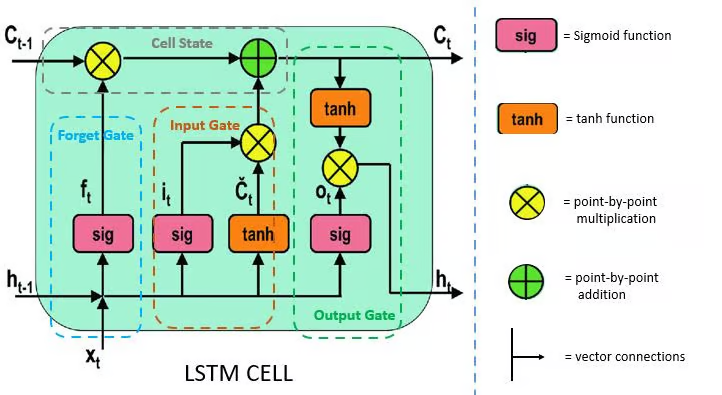

LSTMの特徴

LSTMは、RNNのように「前の出力(y_{t-1})」を次のステップで入力として使う構造を持ちながらも、「長期記憶(C_{t-1})」を少しずつ調整していけるのが大きな特徴です。

そのため、LSTMは過去の情報を保持しつつ、新しい情報を適切に取り入れられます。

さらに、LSTMではこれを3つのゲートで制御しています。具体的には、「忘却ゲート(Forget Gate)」「入力ゲート(Input Gate)」「出力ゲート(Output Gate)」の3つです。

この3つのゲートが機能することにより、LSTMは過去の情報を保持しつつも、必要に応じて柔軟に新しい情報を取り入れています。

LSTMを活用するメリット

LSTMを活用するメリットは、長文理解や時系列予測などの複雑なタスクを短時間でこなせる点です。これは、LSTMが記憶セルを活用して、入力した情報を長時間保持していることが関係しています。

従来のRNNでは、やり取りが増えたり、プロンプトが長くなるにつれて勾配が減衰し、過去の入力情報が次第に影響を失っていました。

しかし、LSTMなら保持している情報を必要に応じて出力できるので、長期依存関係のタスクを効率的に学習できます。

なお、生成AIを活用する際の課題や対策法が知りたい方は、以下の記事もご確認ください。

LSTMの仕組み

LSTMの仕組みを理解するうえで欠かせないのが、以下3つのゲートです。

- 忘却ゲート

- 入力ゲート

- 出力ゲート

これら3つのゲートがそれぞれ機能することで、LSTMが自然言語処理を効率的にこなしています。

それぞれのゲートの役割について、以下でみていきましょう。

忘却ゲート

忘却ゲートは、入力された情報に基づいて、記憶セルに保存されているデータをどれくらい忘れるかを決定する役割を担っています。0から1までの値を出力することで、記憶セルのデータを管理しているのが特徴です。

たとえば、機械学習の過程で記憶セル内のデータをすべて消去する必要がある場合は、忘却ゲートから0の値が出力されます。逆に、記憶セル内のデータをすべて保持する場合は1の値を出力するという仕組みです。

入力ゲート

入力ゲートの役割は、入力された情報の中から、どの情報を新しく記憶セルに保存するかを決定することです。さらに、シグモイド関数を使って、各入力の重要度を0から1の範囲で評価して出力し、その重要度を反映させています。

入力ゲートで計算された値は、記憶セルに保存されるデータと組み合わされ、次のステップで出力ゲートに引き渡されます。

出力ゲート

出力ゲートは、最終的にどの情報を外部に出力するかを決定する役割を果たしています。入力ゲートまでに処理された情報に対して、その重要度に応じた重みをかけ、最終的な出力データを計算しているのが特徴です。

ここまで3つのゲートを紹介しましたが、LSTMはこれら3つのゲートを使ってデータを効率的に取捨選択し、高精度な機械学習を実現しています。

入力された情報を部分的に記憶する仕組みによって、文章生成などの自然言語処理を効率的におこなっているというわけです。

LSTMの活用方法

LSTMの活用方法として、代表的なものを以下にまとめました。

- 自然言語処理:テキスト生成や翻訳、感情分析など幅広いタスクを処理するのに使われています。

- 手書き文字の認識:手書きの文字を認識してデジタルテキストに変換できます。

- 音声認識:音声をテキストデータに変換するのに活用されています。

- 時系列予測:天気予報や株価、需要予測などで活用されています。

- 自動運転:自動運転車に搭載され、物体検出や経路設定などをこなしています。

上記のように、LSTMは複雑なタスクも効率的にこなせるのが魅力です。もしかしたら、知らないうちにLSTMを活用したサービスを利用しているかもしれません。

LSTMの仕組みを理解して、今後も生成AIを効率的に活用していきましょう。

なお、生成AIの国内開発事例が知りたい方は、以下の記事をご覧ください。

LSTMを理解して生成AIを使いこなそう

LSTM(長・短期記憶)とは、機械学習をおこなうためのニューラルネットワークの一種です。記憶セルで一部の情報を保持しておけるので、長期間の依存関係があるデータも効率的に処理できます。

同じニューラルネットワークの1種としてRNNやGRUとの違いが疑問視されやすいですが、それぞれタスクを処理する仕組みや構造が異なります。

LSTMで使われているのは、以下3つのゲートです。

- 忘却ゲート

- 入力ゲート

- 出力ゲート

それぞれのゲートでデータを効率的に取捨選択し、高精度な機械学習を実現しています。

なお、LSTMの活用方法としては、以下のようなものが挙げられます。

- 自然言語処理:テキスト生成や翻訳、感情分析など幅広いタスクを処理するのに使われています。

- 手書き文字の認識:手書きの文字を認識してデジタルテキストに変換できます。

- 音声認識:音声をテキストデータに変換するのに活用されています。

- 時系列予測:天気予報や株価、需要予測などで活用されています。

- 自動運転:自動運転車に搭載され、物体検出や経路設定などをこなしています。

とくに、LSTMは長文理解や時系列予測などの複雑なタスク処理に優れているのが特徴です。生成AIを活用する際は、ニューラルネットワークの特性も理解したうえで、最適なサービスやモデルを利用しましょう。

最後に

いかがだったでしょうか?

LSTMなどの最新技術を活用した生成AIの導入で、業務効率化やビジネス成長を実現しませんか?自社のプロジェクトに最適なAIソリューションの具体的な導入事例や活用方法をご提案いたします。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。

【監修者】田村 洋樹

株式会社WEELの代表取締役として、AI導入支援や生成AIを活用した業務改革を中心に、アドバイザリー・プロジェクトマネジメント・講演活動など多面的な立場で企業を支援している。

これまでに累計25社以上のAIアドバイザリーを担当し、企業向けセミナーや大学講義を通じて、のべ10,000人を超える受講者に対して実践的な知見を提供。上場企業や国立大学などでの登壇実績も多く、日本HP主催「HP Future Ready AI Conference 2024」や、インテル主催「Intel Connection Japan 2024」など、業界を代表するカンファレンスにも登壇している。