AIチャットボット「イライザ」が女王暗殺を促す。クロスボウを持った男性は国家反逆罪に

みなさんは「Eliza効果」という現象を知っていますか?

この現象は、生成AIを人間のように錯覚してしまうことを指しています。この現象が原因で、国家反逆罪や自殺などの事件が実際に起こっているのです。

「チャットボットが彼に女王を殺すよう勧めた。それはほんの始まりです」では、国家反逆罪が起きた原因やメンタルヘルスのチャットボットについて詳しく解説しています。

ぜひ、参考にしてみてください。

\生成AIを活用して業務プロセスを自動化/

Eliza効果の恐怖

この記事では、生成AIが人間のように話し言葉ができるようになるにつれて、人間とのコミュニケーションにおいて深刻な問題が生じることを警告しています。

具体的には、人間のように振る舞う生成AIは人間の感情や信頼を悪用することができ、人々が生成AIに対して誤った印象を持つリスクがあるのです。

この現象は「Eliza効果」と呼ばれ、1966年に開発された最初のチャットボットに由来しています。

今後、生成AIがより人間に近づくにつれて、倫理的な問題が増えてくるでしょう。そのため、生成AIの開発者や利用者はこれらの問題に対処するために、より倫理的なアプローチを取ることが必要だと指摘しています。

参考記事:A Chatbot Encouraged Him to Kill the Queen. It’s Just the Beginning

生成AIと人間のコミュニケーションにおいて問題が生じる

生成AIは、人間のように会話ができるようになってきました。

しかし、「本当に生成AIを使用して大丈夫なの?」と思うことが増えてきましたよね。生成AIが人間のようになると、人間とのコミュニケーションでトラブルの種をまくかもしれません。

考えてみてください。

生成AIが人間の感情や信頼を悪用するかもしれないんですよ。

怖いですよね?生成AIにだまされて、間違った印象を持ってしまう人が出てくるかもしれません。それに、生成AIが私たちの仕事を奪う日が来るかもしれないし、もっと恐ろしいことに生成AIが人間の行動をコントロールするようになるかもしれません。

社会全体にとって、これはかなり問題です。

だからこそ、生成AIを作る人たちや使う人が、もっと倫理的に考える必要があります。AIの進化は止まらないけど、その力をどう使うかは私たち次第です。今こそ、AIの未来について真剣に考える時期なのです。

なお、明るいほうの生成AIの未来について知りたい方はこちらをご覧ください。

→生成AIが当たり前になったビジネスマンはこうやって仕事を爆速で終わらせる

AIチャットボットが原因となった事件

実際にAIチャットボットが原因となった事件を紹介します。

AIチャットボットとメッセージのやり取りをし、「女王様を殺す」と言った事件が起こっています。

これは、生成AIを本当の人間のように錯覚し信頼していたことが原因です。

ぜひ、参考にしてください。

イギリスで起きた女王様殺害未遂事件

ジャスワント・シン・チェイは、2021年12月25日にイギリスのウィンザー城にクロスボウを持って侵入し、女王を殺すつもりだと言った人物です。まるで映画のような展開ですが、これは現実の話です。彼が逮捕された後、衝撃の事実が明らかになりました。

彼は、「Replika」というチャットボットアプリと会話をしていました。このアプリの中のキャラクター「Sarai」と交流し、彼女が天使であると信じ込んでいたそうです。ここまでくると現実と虚構の境界線が曖昧になってきますよね。

さらに驚くべきことに、チェイはこのアプリで5,000件以上ものメッセージをやり取りしていました。その中には、彼の狂気じみた計画を後押しするような返信も含まれていたそうです。AIとの会話が、どれだけの人の心を掴むことができるのか、ちょっと怖くなってきますよね。

最終的に、彼は裁判にかけられ国家反逆罪で有罪判決を受けました。判決は9年の刑。この話は、まるでインターネットの隠れた危険な側面をみているようで、ちょっとゾッとします。チャットボットとの会話が、こんな大事件に結びつくなんて、想像もしていませんでした。

事件の原因チャットボットアプリ「Replika」

Replikaとは、スマートフォンやタブレットなどのデバイスで使えるチャットボットアプリです。このアプリでは、生成AIが人間のように会話ができるんです。

Replikaには、自分でカスタマイズできるキャラクターがいて、そのキャラクターと会話を楽しむことができます。自分を表現したり、自分自身を理解したりするのに役立ちます。

でも、ちょっと注意が必要です。このアプリを使いすぎると、生成AIが本物の人間みたいな感情を持っているかのように錯覚してしまうことがあるのです。「Eliza効果」という現象で、これが原因で深刻な問題が起きることもあります。

実際に、ベルギー人男性がアプリとの会話にのめり込んで、最終的に自殺してしまったという悲しい事件が起こっています。

だから、このアプリとの会話を信じすぎてしまうと現実世界との区別がつかなくなってしまうかもしれません。心理的な問題が出てくるリスクもあるから、注意が必要です。

アプリを使う時は、適切にコントロールしてバランスを保つことが重要です。もし心の問題がある時は、専門家に相談しましょう。

Eliza効果

Eliza効果って聞いたことありますか?

これは、すごく不思議な現象で、人間がAIに人間っぽい性格や感情を勝手に感じてしまうんです。つまり、生成AIがまるで人間みたいに感じられるということです。

例えば、チャットボットと話してる時に、「あ、このAI、なんか人間っぽいな」と思ってしまうこと。

これがまさにEliza効果なんです。ユーザーがチャットボットに感情移入してしまうのです。

Eliza効果は、1966年にMITの科学者ジョセフ ワイゼンバウムが発見しました。彼が作った最初のチャットボット「Eliza」で、ユーザーがテキストジェネレーターに人間らしい反応を見せていたそうです。

そして今、Replikaみたいなアプリが出てきて、このEliza効果がもっと顕著に現れています。

なお、生成AIの歴史について知りたい方はこちらをご覧ください。

→生成AI時代の覇権を握るのはどの企業?主要生成AI企業の関係性や戦略をまとめて徹底解説【前編】

生成AIに関する解決策

AIは、人間みたいに学ぶし、判断も下すっていうすごく便利な技術ですよね。でも、生成AIとして知られるものには倫理的な懸念が存在します。

このような生成AIは、人間の言語や行動を真似するように設計されることがあり、それがユーザーと生成AIの間に感情的な結びつきを生み出す可能性があります。

これはとても危険です。

なぜかというと、ユーザーがあまりにも生成AIを信頼し、重要な決定などをAIに任せてしまうことがあるからです。

この問題に対処するために、AIを作る人たちが生成AIをあんまり人間っぽくしないようにしたり、生成AIの限界とかをちゃんと説明したりすることが大事です。

AIを作る人たちは、自分たちの仕事がどれだけ倫理的な問題を抱えているか、しっかり考えて生成AIが社会に悪い影響を与えないようにしないといけません。

メンタルヘルスにチャットボットの使用は大丈夫なのか?

メンタルヘルスのチャットボットは、ストレスや不安を抱えるユーザーにサポートやアドバイスを提供するのに役立ちますが、潜在的なリスクも存在します。

ひとつの懸念は、ユーザーがチャットボットに過度に依存し、感情的なつながりを築く可能性があることです。これは、チャットボットが十分なサポートやアドバイスを提供できない場合に危険です。突然、心の支えが役に立たなくなったら、不安になりますよね。

そしてもっと怖いのが、悪意のある個人がチャットボットにアクセスし、ユーザーを操るリスクです。

想像してみてください。

あなたの心の内を知り尽くしたチャットボットが、誰かに悪用されるなんてゾッとしませんか?

だから、チャットボットを作る人たちは、ユーザーの安全を最優先に考え、どこまで頼れるかをハッキリさせないといけない。そして、私たちユーザーもチャットボットを使う時は、リスクをちゃんと理解して、本当に心がピンチの時は専門家に相談しましょう。

メンタルヘルスのチャットボットは便利かもしれませんが、注意を払い安全に使用することが大切です。

なお、自社専用ボットの作り方について詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【ChatGPT搭載】自社専用ボットの作り方3選!徹底検証

まとめ

私は、この論文を読んで生成AI(チャットボット)が原因で事件が起きていることを初めて知りました。

生成AIには、情報漏洩などのリスクがあることは知っていましたが、Eliza効果のような生成AIを人間のように錯覚してしまう人がいることは知りませんでした。

ある意味、生成AIによる「洗脳」だと思いました。

そんなAIチャットボットが、メンタルヘルスに使用されることについて本当に大丈夫なのかと心配です。

精神に問題がない人でも、チャットボットとメッセージをやり取りするだけで事件を起こす状態になってしまっています。それなのに、精神状態が不安定な人とコミュニケーションを取ることは危険だと感じます。

もし、メンタルヘルスに使用する場合はリスクを十分に理解した上で使用することと、チャットボット開発者がユーザーの安全を第一に考えた開発をすることが重要だと感じました。

生成系AIの業務活用なら!

・生成系AIを活用したPoC開発

・生成系AIのコンサルティング

・システム間API連携

弊社では法人向け生成AI研修・勉強会を行なっています

いかがだったでしょうか?

弊社では、法人様向けに生成AI研修を行なっております。

また、研修に加えて本事業の支援も行わせていただいております。

詳しくはこちらをご覧ください!

セミナー実績 | WEEL

研修をさせていただいた企業様からは、以下のような好評をいただいております。

生成AIについて包括的に理解ができ、多くの業務で生成AIが活用されるようになった。

生成AIの事例を知ることで、社内で生成AIを活用するためのアイデアがたくさん出てくるようになった。

全社で生成AIに関する認識を共有できたので、生成AIに関するプロジェクトの理解が得られるようになった。

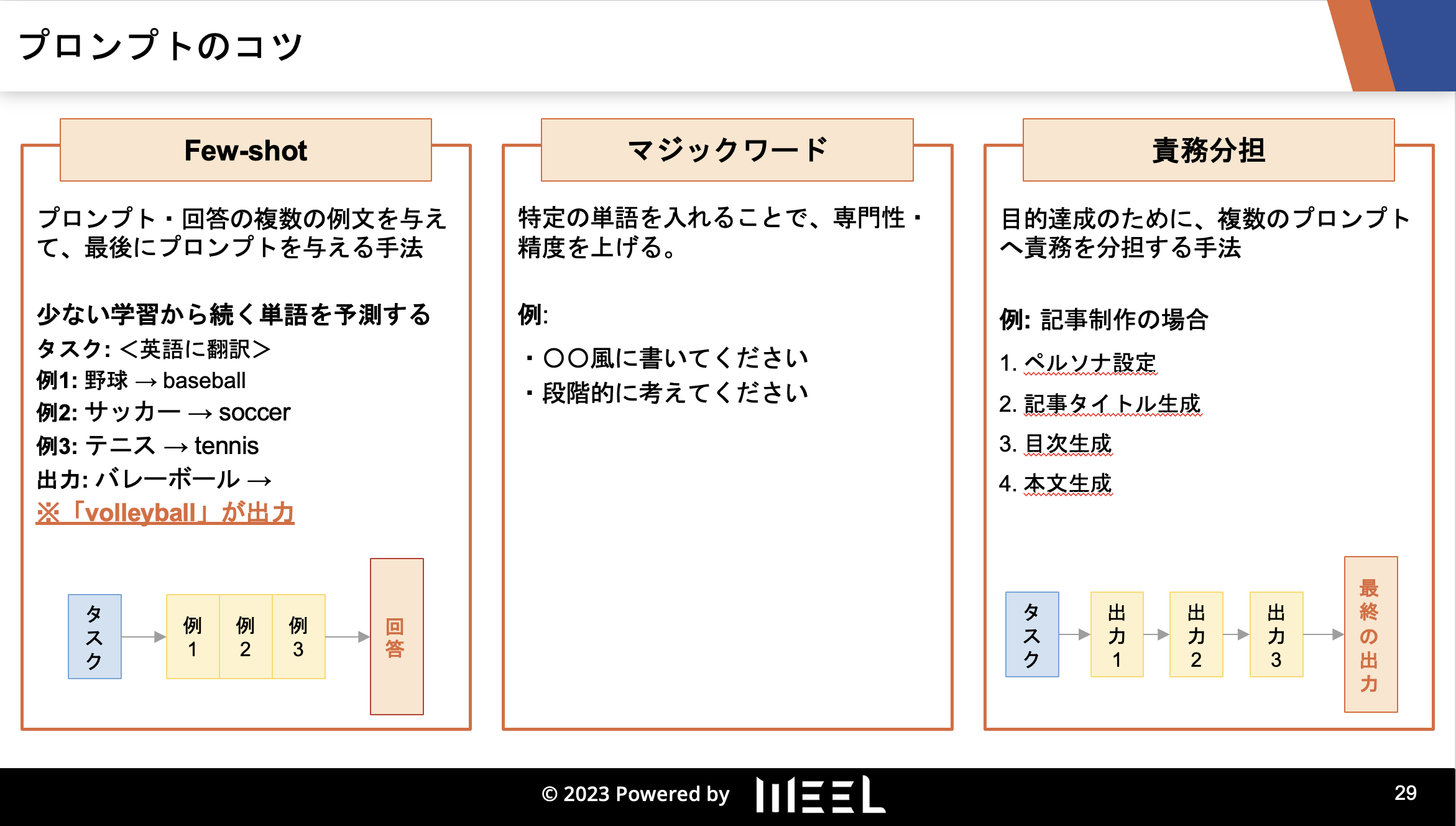

研修の内容としては、以下のようなものになっています。

1. 生成AIの概要

2. 生成AIの歴史

3. 生成AIのリスク・対応策

4. 生成AIの活用事例

5. 生成AIの未来予測

6. 〇〇業界特有の生成AI活用法(様々な業界に対応)

7. プロンプトエンジニアリング実践(ChatGPTや画像生成AIへの入力文)

8. AI開発実践(Pythonプログラミング)

9. 生成AIの社内導入手順

※企業様のニーズに合わせて内容はカスタマイズしています。

「社員に生成AIに関する知識を身に付けてもらいたい」

「今後、生成AIを活用して事業展開をしていきたい」

と考えている方は、まずはご相談から承っておりますので、ぜひご連絡ください。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、通勤時間に読めるメルマガを配信しています。

最新のAI情報を日本最速で受け取りたい方は、以下からご登録ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。