【Animagine XL 3.0】誰でも簡単にアニメ美少女の画像を生成できる神AI!使い方や料金、使ってみた感想を紹介

WEELメディア事業部LLMリサーチャーの中田です。

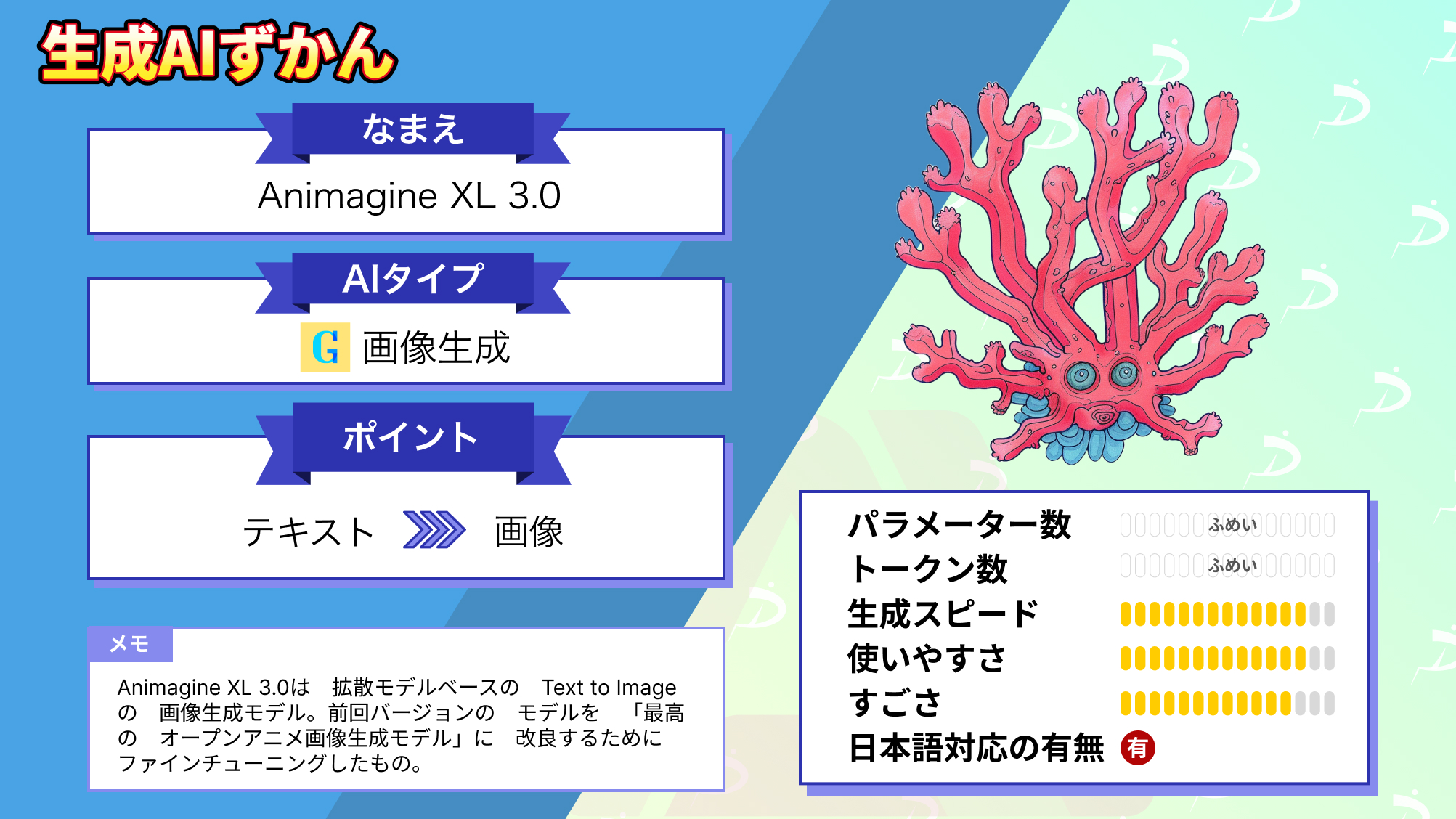

1月10日、Cagliostro Research Labが、拡散モデルベースのText-to-Imageの画像生成モデル「Animagine XL 3.0」を公開しました。

このAIツールを使うことで、テキスト指示から高画質なアニメ画像を、簡単に生成できるんです…!

HuggingFaceでのモデルダウンロード数は、すでに5,048を超えており、多くの人に使われていることが分かります。素人でも簡単にアニメーション画像を作れるため、アニメ制作などにも活用できそうです。

例えば、次のようなアニメ画像も、簡単に作れるんです。

1girl, green hair, sweater, looking at viewer, upper body, beanie, outdoors, night, turtleneck, masterpiece, best quality

この記事ではAnimagine XL 3.0の使い方や、有効性の検証まで行います。本記事を熟読することで、Animagine XL 3.0の凄さを実感し、普通の画像生成AIには戻れなくなるでしょう。

ぜひ、最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

Animagine XL 3.0の概要

Cagliostro Research Labが、拡散モデルベースのText-to-Imageの画像生成モデル「Animagine XL 3.0」を公開しました。2ヶ月前に、同研究チームは「Animagine XL 2.0」を発表しており、それを「最高のオープンアニメ画像生成モデル」に改良するために、ファインチューニングしたのだとか。

加えて、Stable Diffusion XLをベースに開発されており、以下のようなアニメ画像を生成するのに特化しています。

なお、Animagine XL 2.0について詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【Animagine XL 2.0】解像度が高すぎるアニメ画像を生成できちゃうAIを使って推しの女の子を作ってみた

Animagine XL 3.0のライセンス及び料金体系

Animagine XL 3.0はオープンソースであるため、誰でも無料で利用可能です。

ただ、「Fair AI Public License 1.0-SD」というライセンスのもとで提供されており、モデルの変更を行った場合、その変更と元のライセンスを共有する必要があります。また、変更されたバージョンがネットワーク経由でアクセス可能な場合、他者がソースコードを入手できるようにする必要があります。

| 利用用途 | 可否 |

| 商用利用 | ⭕ |

| 改変 | ⭕ |

| 配布 | ⭕ |

| 特許使用 | ⭕ |

| 私的利用 | ⭕ |

\画像生成AIを商用利用する際はライセンスを確認しましょう/

Animagine XL 3.0の使い方

Animagine XL 3.0は以下のGradioのデモページで、簡単に試すことができます。

参考記事:ANIMAGINE XL 3.0 Gradio Demo Page

今回はGoogle ColabのT4で実行しました。

まずは、以下のコードを実行して、必要なライブラリをインストールしましょう。

!pip install -q --upgrade diffusers invisible_watermark transformers accelerate safetensors次に、以下のコードを実行して、モデルのロード等を行いましょう。

import torch

from torch import autocast

from diffusers import StableDiffusionXLPipeline, EulerAncestralDiscreteScheduler

model = "linaqruf/animagine-xl"

pipe = StableDiffusionXLPipeline.from_pretrained(

model,

torch_dtype=torch.float16,

use_safetensors=True,

variant="fp16",

)

pipe.scheduler = EulerAncestralDiscreteScheduler.from_config(pipe.scheduler.config)

pipe.to('cuda')そして、以下のコードを実行することで、画像を生成できます。

import matplotlib.pyplot as plt

from PIL import Image

prompt = "face focus, cute, masterpiece, best quality, 1girl, green hair, sweater, looking at viewer, upper body, beanie, outdoors, night, turtleneck"

negative_prompt = "lowres, bad anatomy, bad hands, text, error, missing fingers, extra digit, fewer digits, cropped, worst quality, low quality, normal quality, jpeg artifacts, signature, watermark, username, blurry"

output = "/content/anime_girl.png"

image = pipe(

prompt,

negative_prompt=negative_prompt,

width=1024,

height=1024,

guidance_scale=12,

target_size=(1024,1024),

original_size=(4096,4096),

num_inference_steps=50

).images[0]

image.save(output)

image = Image.open(output)

plt.imshow(image)

plt.axis('off') # to hide the axis生成結果は、以下の通りです。

かなり精度が高く、しっかりとアニメ調ですね!

ちなみに、30秒くらいで生成できました。

なお、公式ブログによると、以下のようなプロンプト設計がおすすめだそうです。

1boy/1girl, what character, from which series, everything else in random order*まず最初にキャラの性別、どんなキャラなのか、何のシリーズなのか、それ以降の記述はランダムで、という流れになります。

Stable Diffusionでは画質に関するプロンプトを先に書くことが多いですが、Animagine XL 3.0ではキャラに関する要素を先に書くと良いみたいです。

Animagine XL 3.0を動かすのに必要なPCのスペック

■Pythonのバージョン

Python 3.8以上

■必要なパッケージ

- diffusers

- invisible_watermark

- transformers

- accelerate

- safetensors

なお、省エネで高精度の画像を生成できるAIについて知りたい方はこちらの記事をご覧ください。

→【Stable Diffusion WebUI Forge】省エネ・高速・高解像度の画像生成モデルを使ってみた

Animagine XL 3.0を実際に使ってみた

ここでは、キズナアイさんのような「VTuber」を作ってみようと思います。

プロンプトを以下の様に変更し、再度実行してみます。

"face focus, cute, masterpiece, best quality, 1girl, pink hair, virtual youtuber, playing a game, upper body, beanie, indoors"結果は以下の通りです。

VTuberにはならなかったですが、「pink hair」や「playing a game」の部分は上手く反映されているようです!

virtual youtuberというよりも、ゲーム配信をするYouTuberっぽくなりましたね。そもそもVTuberの概念がわからないのかもしれません。

Animagine XL 3.0の推しポイントであるアニメ画像生成は本当なのか?

Animagine XL 3.0は本当に、以前のバージョンのAnimagine XL 2.0よりも進化したのかを検証してみます。

そのために、先ほどと同様のプロンプトを、Animagine XL 2.0にも入力してみます。

結果は下記の通りです。

Animagine XL 3.0はもう一度同じプロンプトで再出力してみましたが、どちらもプロンプトの内容を、うまく捉えられていると思います。

ただ、やはり今回のAnimagine XL 3.0の方が、よりリアルなアニメ画像を生成できるようですね!

確かに、前回バージョンよりも進化しているのが分かります。

率直に、将来のアニメ制作においても、本モデルは大いに活用できると思いました。

Animagine XL 3.0でアニメ画像を簡単に量産してみましょう

Cagliostro Research Labが、拡散モデルベースのText-to-Imageの画像生成モデル「Animagine XL 3.0」を公開しました。本モデルは、アニメ画像を生成するのに特化しています。確かに、前回バージョンよりも進化しており、今回のAnimagine XL 3.0の方が、よりリアルなアニメ画像を生成できるようです。

また、モデルやLoRaを自分で選択することはできないですが、アニメ画像だけを生成するという用途に限るのであればStable Diffusionよりも遥かに使いやすいと感じました。

スペックに関しても、無料のGoogleColabのT4でストレスなく画像生成することができたので、ひとまず簡単にアニメ画像を生成したいんだけど・・・と考えている方にぜひ試してみてほしいと思います。

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。