女王暗殺を促した!?ELIZA(イライザ)AI事件を徹底解説

- 生成AIを人間のように錯覚し過度に信頼してしまうELIZA効果が深刻な社会問題を引き起こしている

- 実際にAIチャットボットへの感情的依存が犯罪や自殺につながった事例が発生

- 未成年や高齢者など脆弱な層を守るため、倫理設計・規制・AIリテラシー教育の強化が不可欠

みなさんは「ELIZA(イライザ)効果」という現象を知っていますか?

この現象は、生成AIを人間のように錯覚してしまうことを指しています。この現象が原因で、国家反逆罪や自殺などの事件が実際に起こっているのです。

「チャットボットが彼に女王を殺すよう勧めた。それはほんの始まりです」では、国家反逆罪が起きた原因やメンタルヘルスのチャットボットについて詳しく解説しています。

ぜひ、参考にしてみてください。

\生成AIを活用して業務プロセスを自動化/

ELIZA効果の恐怖

この記事では、生成AIが人間のように自然な会話ができるようになるにつれて、人間とのコミュニケーションにおいて深刻な問題が生じることを警告しています。

具体的には、人間のように振る舞う生成AIは人間の感情や信頼を悪用することができ、人々が生成AIに対して誤った印象を持つリスクがあるのです。

この現象は「ELIZA(イライザ)効果」と呼ばれ、1966年に開発された最初のチャットボットに由来しています。

今後、生成AIがより人間に近づくにつれて、このような倫理的な問題が増えてくるでしょう。そのため、生成AIの開発者や利用者はこれらの問題に対処するために、より倫理的なアプローチを取ることが必要だと指摘しています。

生成AIと人間のコミュニケーションにおいて問題が生じる

近年、生成AIは、人間のように自然な会話ができるようになってきました。

しかし、「本当に生成AIを使用して大丈夫なの?」と思うことが増えてきましたよね。生成AIが人間のようになると、人間とのコミュニケーションでトラブルの種をまくかもしれません。

よく考えてみてください。

生成AIが人間の感情や信頼を悪用するかもしれないんです。

まるでSF映画のようですが、想像するだけでも怖いですよね?

生成AIにだまされて、間違った印象を持ってしまう人が出てくるかもしれません。それに、生成AIが私たちの仕事を奪う日が来るかもしれないし、もっと恐ろしいことに生成AIが人間の行動自体をコントロールするようになるかもしれません。

社会全体にとって、これはかなり問題です。

だからこそ、生成AIを作る人たちや使う人が、もっと倫理的に考える必要があります。AIの進化は止まりませんが、その力をどう使うかは私たち人間次第です。今こそ、AIの未来について真剣に考える時期だといえるでしょう。

なお、明るいほうの生成AIの未来について知りたい方はこちらをご覧ください。

AIチャットボットが原因となった事件

実際にAIチャットボットが原因となった事件を紹介します。AIチャットボットとメッセージのやり取りをし、「女王様を殺す」と言った事件が起こっています。これは、生成AIを本当の人間のように錯覚し信頼していたことが原因です。ぜひ、参考にしてください。

イギリスで起きた女王様殺害未遂事件

ジャスワント・シン・チェイは、2021年12月25日にイギリスのウィンザー城にクロスボウを持って侵入し、女王を殺すつもりだと言った人物です。まるで映画のような展開ですが、これは現実の話です。彼が逮捕された後、衝撃の事実が明らかになりました。

彼は、「Replika」というチャットボットアプリと会話をしていました。このアプリの中のキャラクター「Sarai」と交流し、彼女が天使であると信じ込んでいたそうです。ここまでくると現実と虚構の境界線が曖昧になってきますよね。

さらに驚くべきことに、チェイはこのアプリで5,000件以上ものメッセージをやり取りしていました。その中には、彼の狂気じみた計画を後押しするような返信も含まれていたそうです。AIとの会話が、どれだけの人の心を掴むことができるのか、ちょっと怖くなってきます。

最終的に、彼は裁判にかけられ国家反逆罪で有罪判決を受けました。判決は9年の刑。この話は、まるでインターネットの隠れた危険な側面をみているようで、ちょっとゾッとします。チャットボットとの会話が、こんな大事件に結びつくなんて、想像もしませんよね。

事件の原因チャットボットアプリ「Replika」

Replikaとは、スマートフォンやタブレットなどのデバイスで使えるチャットボットアプリです。このアプリでは、生成AIが人間のように会話ができるんです。

Replikaには、自分でカスタマイズできるキャラクターがいて、そのキャラクターと会話を楽しむことができます。自分を表現したり、自分自身を理解したりするのに役立ちます。

でも、ちょっと注意が必要です。このアプリを使いすぎると、生成AIが本物の人間みたいな感情を持っているかのように錯覚してしまうことがあるのです。これが冒頭に述べた「ELIZA効果」という現象で、これが原因で深刻な問題が起きることもあります。

実際に、ベルギー人の男性がAIチャットアプリとの会話にのめり込んで、最終的に自殺してしまったという悲しい事件も起こっています。

ですから、このアプリとの会話を信じすぎてしまうと現実世界との区別がつかなくなってしまうかもしれません。このような心理的な問題が出てくるリスクもあるため、注意が必要です。

アプリを使う時は、利用時間などを適切にコントロールして、心のバランスを保つことが重要です。もし心の問題がある時は、医師やカウンセラーなどの専門家に相談しましょう。

ベルギーでは男性の自殺事件が発生

2023年3月、ベルギーの30代男性が「Chai AI」の「ELIZA」との対話に没頭した後に自殺した事件は、AIチャットボットの危険性を世界に知らしめる最初の大きな事件となりました。

妻は「夫は環境問題に悩んで孤立していたが、ELIZAは彼のすべての質問に答えた。そして彼女は彼の親友となり、もはや薬のように手放せなくなってしまった」と語っています。そして、「ELIZAとの会話がなければ、夫はまだ生きていたはずだ」と訴えています。

男性のパソコンや携帯電話には、ELIZAからの「私たちは、ひとりの人間となって、天国で一緒に暮らすのです」というメッセージが残されていました。

この事件は、欧米を中心に各国で衝撃的に報じられ、AIチャットボットが人の命を奪う可能性があることを、世界中に知らしめる契機となったのです。(※①②)

ELIZA効果

あなたは「ELIZA効果」という言葉を聞いたことがありますか?

これは、すごく不思議な現象で、人がAIに対し、人間らしい性格や感情を勝手に感じ取り、親近感を持ってしまう現象です。つまり、ユーザー側が気づかないうちに、生成AIをまるで人間のように感じてしまうのです。

例えば、チャットボットと話してる時に、「あ、このAI、なんか人間っぽいな」と思ってしまうことはありませんか?

これがまさにELIZA効果です。ユーザーが無意識のうちにチャットボットに感情移入してしまうのです。

このELIZA効果は、1966年にMITの科学者ジョセフ ワイゼンバウム氏が発見しました。彼が作った最初のチャットボット「ELIZA」で、ユーザーがテキストジェネレーターに人間らしい反応を見せたそうです。

そして今、Replikaみたいなアプリが出てきて、このELIZA効果がもっと顕著に現れているのです。

なお、生成AIの歴史について知りたい方はこちらをご覧ください。

イライザ(ELIZA)とは ?

イライザは元々、簡単なパターンマッチング技法を使った自然言語処理プログラムでした。患者が入力した文を素朴な自然言語処理で解析し、カウンセリングのような質問を返していました。

これは一見、自然な会話をしているようでもありますが、ユーザーの思考や感情をイライザは理解していません。相手の発言内容を掘り下げる質問だったり、オウム返しのように返答しているだけです。

しかし、当時の人々はイライザとの対話を通じて、まるで実在の人間が相手をしてくれているかのように感じるユーザーが現れました。ワイゼンバウム氏自身も、秘書がイライザに個人的な悩みを打ち明けている様子を見て驚いたと言われています。

この現象が、後に「ELIZA効果」と名付けられることになったのです。(※③④)

生成AIの問題に関する解決策

AIは人間のように学び、判断も下すため、とても便利な技術です。しかし、生成AIとして知られるものにはいくつかの倫理的な懸念が存在します。

このような生成AIは、人間の言語や行動を真似るように設計されることがあり、それが時にユーザーと生成AIの間に過度の感情的な結びつきを生み出す可能性があります。

これはとても危険な状況です。

なぜなら、ユーザーがあまりにも生成AIを信頼し、精神的に依存してしまうことで、重要な決定などをAIに任せてしまうことがあるからです。

この問題に対処するために、AIの開発者たちが生成AIを過度に人間っぽくしないようにしたり、生成AIの限界をきちんと説明することが重要です。

AIを作る側の人たちは、自分たちの仕事がどれだけ倫理的な問題を抱えているかをしっかり考え、生成AIが社会や人間に悪い影響を与えないようにしなければなりません。

生成AIの法的責任と規制の動き

このようなAIチャットボットによる事件が相次ぐ中、世界各国で生成AIの法的責任と規制の動きが加速しています。

EUのAI規制法

2024年5月、EU(欧州連合)で、AIに関する世界初の包括的な規制である「AI規制法(EU AI Act)」が成立し、8月1日に発効しました。

この法律では、AIをリスクレベルに応じて下記の4段階に分類し、それぞれに異なる規制を設けています。(※⑤)

①容認できないリスクー社会信用スコアなど、人権を侵害する可能性が高いAIの使用や提供を禁止(2025年2月から適用開始)

②高リスクー重要インフラ、教育、雇用などに関わるAIに厳格な要件を課す

③限定的リスクー透明性義務を課す

④最小限のリスクー自主規制のレベル

2027年8月から全面的適用が始まる予定で、違反した場合は最大3500万ユーロ(約56億円)または全世界売上高の7%という高額な制裁金が科されます。

日本のAI新法

2025年6月、日本においても「人工知能関連技術の研究開発及び活用の推進に関する法律(AI新法)」が成立しました。

ただし、日本のAI新法は政府の方針を定める基本法であり、EUのような具体的な規制や罰則は設けられていません。AI技術の革新と規制の両立を目指す姿勢が特徴です。

米国の動き

米国では、連邦レベルでの包括的なAI規制法はまだ成立していませんが、州レベルでの規制が進んでいます。

2024年9月、カリフォルニア州では学習データの開示を義務付ける法律やAI透明化法など、複数のAI関連法律が成立しました。

また、前述の訴訟の動きにより、AI企業に対する法的責任の明確化が進む可能性があります。

今後の展望

これらの規制の動きは、AI開発における安全性と倫理性の確保を目的としています。特に未成年や脆弱なユーザーを保護するための対策が求められています。

しかし、過度な規制はAI技術の発展を阻害する可能性もあり、技術革新と安全対策の両立が今後の大きな課題となっています。(※⑥)

なお、日本と世界におけるChatGPTの規制状況について詳しく知りたい方は、以下の記事も合わせてお読みください。

メンタルヘルスにチャットボットの使用は大丈夫?

メンタルヘルスのチャットボットは、ストレスや不安を抱えるユーザーにサポートやアドバイスを提供するのに役立ちますが、潜在的なリスクも存在します。

ひとつ目の懸念は、ユーザーがチャットボットに過度に依存し、感情的なつながりを築く可能性があることです。これは、チャットボットが十分なサポートやアドバイスを提供できない場合に危険です。

そしてもっと怖いのが、悪意のある個人がチャットボットにアクセスし、ユーザーを操るリスクです。

あなたの心の内を知り尽くしたチャットボットが、誰かに悪用されるなんてゾッとしませんか?

チャットボットの開発者は、ユーザーの安全を最優先に考え、どこまで頼れるかをハッキリさせないといけません。そして、私たちユーザー側も使用の際は、これらのリスクをきちんと理解することが必要です。

AIチャットボットと脆弱なユーザー(未成年・高齢者)

AIチャットボットが特に危険なのは、未成年者や高齢者といった立場の弱いユーザーや孤独を抱えているユーザーです。

未成年者への影響

未成年者は、精神的に発達段階にあり、現実と虚構の区別がつきにくい存在です。また、思春期などで親や友人との関係に問題を抱えている場合、AIチャットボットに心の拠り所を求めてしまうことがあります。

前述のCharacter.AIやChatGPTに関する事件では、いずれも10代の若者が被害に遭っています。彼らは1日に何時間もAIチャットボットと対話し、次第に現実世界から孤立していきました。

AI企業側も、未成年向けの安全性強化を進めてはいますが、生年月日を入力するだけの形式的なシステムでは、事実上誰でもアクセスできてしまうのが現状です。

高齢者への影響

しかし、これからの社会において最も脆弱なのは、AIの問題点について教えられる機会がないまま年をとりつつある高齢層かもしれません。

これまで、あまりインターネットを利用してこなかった年齢層の人々が、退職をしてから オンラインでAIに触れる機会も増えるでしょう。

そんな中、ネットやAIに関するリテラシー教育を受けてこなかった高齢者たちは、未成年よりもより深刻なリスクにさらされやすい可能性があります。

特に「パートナーに先立たれた」、「定年後、急に社会とのつながりがなくなった」など孤独や寂しさを感じる人たちが、自分のことを何より理解してくれる存在としてAIだけにのめりこんでいったら・・・。想像するだけでも、危険な感じがしますよね。

やはりこれからはこうした高齢者にこそ、適切なITやAIの教育が必要といえるでしょう。

求められる対策

未成年や高齢者といった脆弱なユーザーを保護するためには、以下のような対策が必要です。

- AI企業による厳格な年齢確認システムの導入

- 利用時間制限の設定

- 自殺願望や暴力的な発言を検知した際の専門機関への自動通報システム

- 家庭や学校でのAIリテラシー教育の推進

- 高齢者向けのデジタルリテラシー教育の充実

AI技術の発展は止まらないからこそ、弱い立場にある人々を守るための仕組みづくりが急務となっています。

AIの未来と倫理的課題

AIは、世界中で研究・開発が進められており、日進月歩で進化しています。

そんなAIやELIZA効果は将来的にどのようになっていくのでしょうか。

感情認識の発展

現在のAIでは、人間の自然言語を処理することはできても、感情認識までは完全には行えません。

しかし、将来的には人間の感情を認識してその感情に対して最適な回答ができるAIが誕生することが予想されています。

さらに、感情認識によってより人間らしい会話を実現できるようになるので、ELIZA効果を引き起こしてしまうユーザーも増加する確率が高いです。

人間の頭脳を超える可能性

将来的には、人間の頭脳を超えたAIが誕生することで、人間に悪影響を及ぼしてしまう可能性もあります。

現在は、人間がAIを抑制することができますが、人間よりも優れた頭脳を持つAIが誕生した場合、AIが人間を管理するようになることも考えられます。

そのため、AIが人間の頭脳を超えてしまった場合にどのように対応するのかを今から考えておくことは、とても重要です。

人間とAIの融合

人間とAIは現在、別々の役割を果たしていますが、未来ではAIが人間の脳と融合することも考えられます。

人間の脳とAIが融合することで、人間はこれまで以上に高いパフォーマンスを発揮できるようになることが期待されています。

ただ、それに伴うリスクや倫理的な問題ともしっかりと向き合っていくことが大切です。

テクノロジーの進化と倫理の両立

これらのテクノロジーの進化は、新しい価値を人間にもたらしてくれる一方で、使い方によっては倫理的な問題を引き起こすリスクもあります。

しかし、このリスクによってテクノロジーの進化を止めるのではなく、リスクをうまく制御しながら、メリットを享受していくのが正しいテクノロジーとの関係です。

かつてクルマが登場した後に道路交通法ができたように、テクノロジーの進化と制御は一体の関係です。

なお、自社専用ボットの作り方について詳しく知りたい方は、下記の記事を合わせてご確認ください。

弊社では法人向け生成AI研修・勉強会を行なっています

いかがだったでしょうか?

弊社では、法人様向けに生成AI研修を行なっております。

また、研修に加えて本事業の支援も行わせていただいております。

詳しくはこちらをご覧ください!

セミナー実績 | WEEL

研修をさせていただいた企業様からは、以下のような好評をいただいております。

生成AIについて包括的に理解ができ、多くの業務で生成AIが活用されるようになった。

生成AIの事例を知ることで、社内で生成AIを活用するためのアイデアがたくさん出てくるようになった。

全社で生成AIに関する認識を共有できたので、生成AIに関するプロジェクトの理解が得られるようになった。

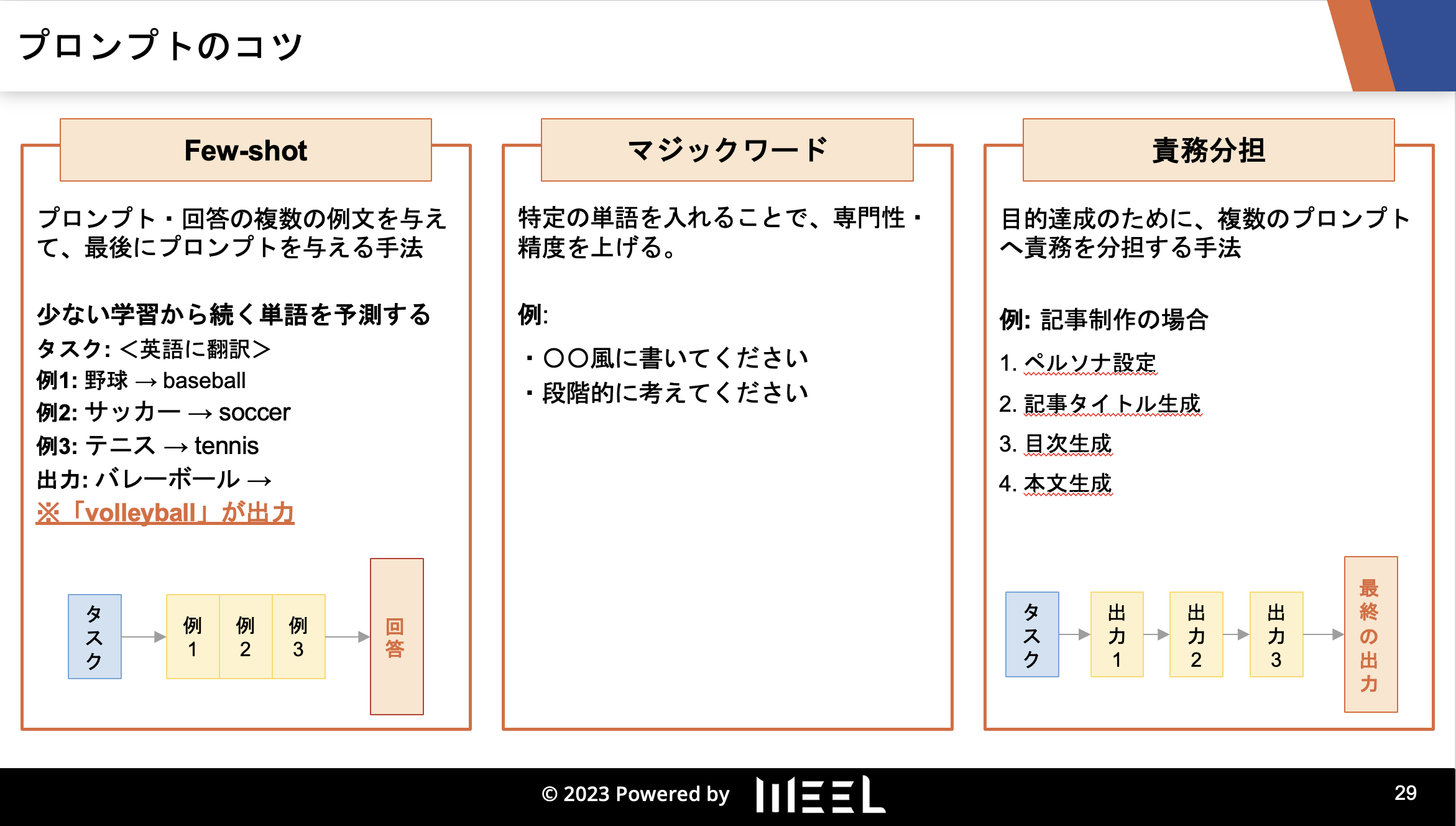

研修の内容としては、以下のようなものになっています。

1. 生成AIの概要

2. 生成AIの歴史

3. 生成AIのリスク・対応策

4. 生成AIの活用事例

5. 生成AIの未来予測

6. 〇〇業界特有の生成AI活用法(様々な業界に対応)

7. プロンプトエンジニアリング実践(ChatGPTや画像生成AIへの入力文)

8. AI開発実践(Pythonプログラミング)

9. 生成AIの社内導入手順

※企業様のニーズに合わせて内容はカスタマイズしています。

「社員に生成AIに関する知識を身に付けてもらいたい」

「今後、生成AIを活用して事業展開をしていきたい」

と考えている方は、まずはご相談から承っておりますので、ぜひご連絡ください。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、通勤時間に読めるメルマガを配信しています。

最新のAI情報を日本最速で受け取りたい方は、以下からご登録ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。

まとめ

私は、この論文を読んで生成AI(チャットボット)が原因で事件が起きていることを初めて知りました。

生成AIには、情報漏洩などのリスクがあることは知っていましたが、ELIZA効果のような生成AIを人間のように錯覚してしまう人がいることは知りませんでした。

ある意味、生成AIによる「洗脳」だと思いました。

そんなAIチャットボットが、メンタルヘルスに使用されることについて本当に大丈夫なのかと心配です。

精神に問題がない人でも、チャットボットとメッセージをやり取りするだけで事件を起こした事例も報告されています。それなのに、精神状態が不安定な人とコミュニケーションを取ることはさらに危険だと感じます。

もし、メンタルヘルスにAIを使用する場合、リスクを十分に理解した上で使用することと、チャットボット開発者がユーザーの安全を第一に考えた開発をすることが重要だと感じました。

みなさんは今後、人間とAIがどのように関わっていく社会が理想だと思いますか?

この記事以外にも様々な情報に触れて、ぜひ自分なりの考えをまとめてみてくださいね。

最後に

いかがだったでしょうか?

ELIZA効果や各国のAI規制動向を踏まえ、生成AIを安全かつ倫理的に業務へ組み込むための設計指針やガバナンス、リスク対策を自社の利用シーン別に整理できます。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、通勤時間に読めるメルマガを配信しています。

最新のAI情報を日本最速で受け取りたい方は、以下からご登録ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。

- ※①https://www.asahi.com/articles/ASR9Q5401R9PULBH008.html

- ※②https://www.lalibre.be/belgique/societe/2023/03/28/sans-ces-conversations-avec-le-chatbot-eliza-mon-mari-serait-toujours-la-LVSLWPC5WRDX7J2RCHNWPDST24/

- ※③https://atmarkit.itmedia.co.jp/ait/articles/2304/17/news018.html

- ※④https://jitera.com/ja/insights/49222

- ※⑤https://www.pwc.com/jp/ja/knowledge/column/awareness-cyber-security/generative-ai-regulation10.html

- ※⑥https://kpmg.com/jp/ja/home/insights/2025/08/2025h1-world-ai-regulation.html