【TripoSR】Stability AI×Tripo AI|1秒で画像を高品質な3Dモデルに変換できるAIを使ってみた

WEELメディア事業部LLMライターのゆうやです。

TripoSRは、Stability AIがTripo AIと提携して開発した、1秒以内に単一の画像から高品質な3Dモデルを生成するオープンソースモデルです。

このモデルは、2023年11月に公開された「LRM: Large Reconstruction Model for Single Image to 3D」という論文にインスパイアされて構築されました。

TripoSRはMITライセンスの下で提供され、誰でも使用できることに加え、低い推論バジェット(GPUなし)でも動作するため他のモデルと比較してより幅広いユーザーが使用できます。

今回は、TripoSRの概要や使ってみた感想をお伝えします。

\生成AIを活用して業務プロセスを自動化/

TripoSRの概要

2024年3月5日、Stability AIから公開されたTripoSRは、3Dモデル生成AIを開発するTripoとの提携によって開発され、1秒以内に単一の画像から高品質な3Dモデルを生成するモデルです。

以下の動画のように、たった1枚の画像から非常に高品質な3Dモデルを超高速で生成できます。

このモデルは、「LRM: Large Reconstruction Model for Single Image to 3D」という論文にインスパイアされて構築された高速3Dオブジェクト再構築モデルです。

そんなTripoSRの特徴は以下の5点です。

- 高速フィードフォワード3D生成: TripoSRは、単一の画像から直接、迅速に3Dモデルを生成できます。これにより、複雑な処理や長時間の待機なしに3Dコンテンツを作成できます。

- 先進的なモデル設計: このモデルは、LRMネットワークアーキテクチャに基づいており、データキュレーション、モデル、トレーニングの改善を含む技術的進歩を取り入れています。

- 大規模なトレーニング: TripoSRは、22のGPUノードで構成される、各ノードに8つのA100 40GB GPUを搭載した強力なハードウェア上で5日間トレーニングされています。

- 実世界に近いトレーニングデータ: トレーニングにはObjaverseデータセットの一部が使用され、実世界の画像の分布をより密接に模倣するために強化されたレンダリング方法が採用されています。これにより、生成された3Dモデルのリアリズムと一般化能力が向上しています。

- オープンソース: TripoSRは、MITライセンスで提供されるオープンソースモデルであり、誰でもアクセスして使用できます。

- 必要要件:TripoSRは、GPUなしでも動作するほど軽量で、デフォルト設定でも6GBのVRAMがあれば動作します。

TripoSRは、LRM(大規模再構築モデル)の原理を取り入れることで、従来の反復的な最適化手法とは異なり、高い品質と高速な生成を同時に可能にしました。

ここからは、TripoSRの性能について見ていきます。

TripoSRの性能

TripoSRの売りは、生成速度と品質です。

TripoSRは、当たり前ですが高性能なGPUを使用するほど高速な生成が可能で、NVIDIA A100 GPUを使用するとなんと0.5秒未満で高品質な3Dモデルを生成できます。

とんでもなく高速ですよね!

また、TripoSRは定性的評価と定量的評価の両方で優れたパフォーマンスを示しています。

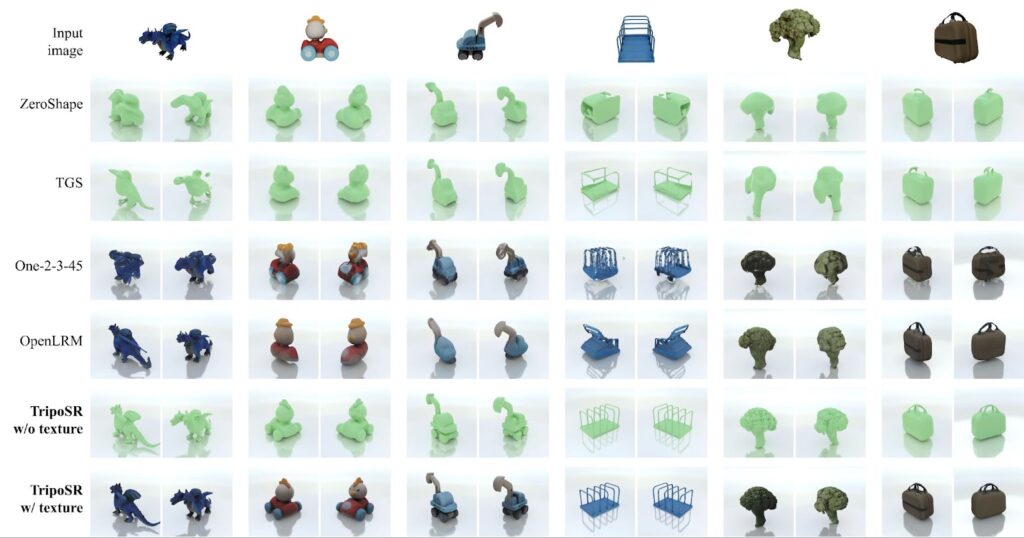

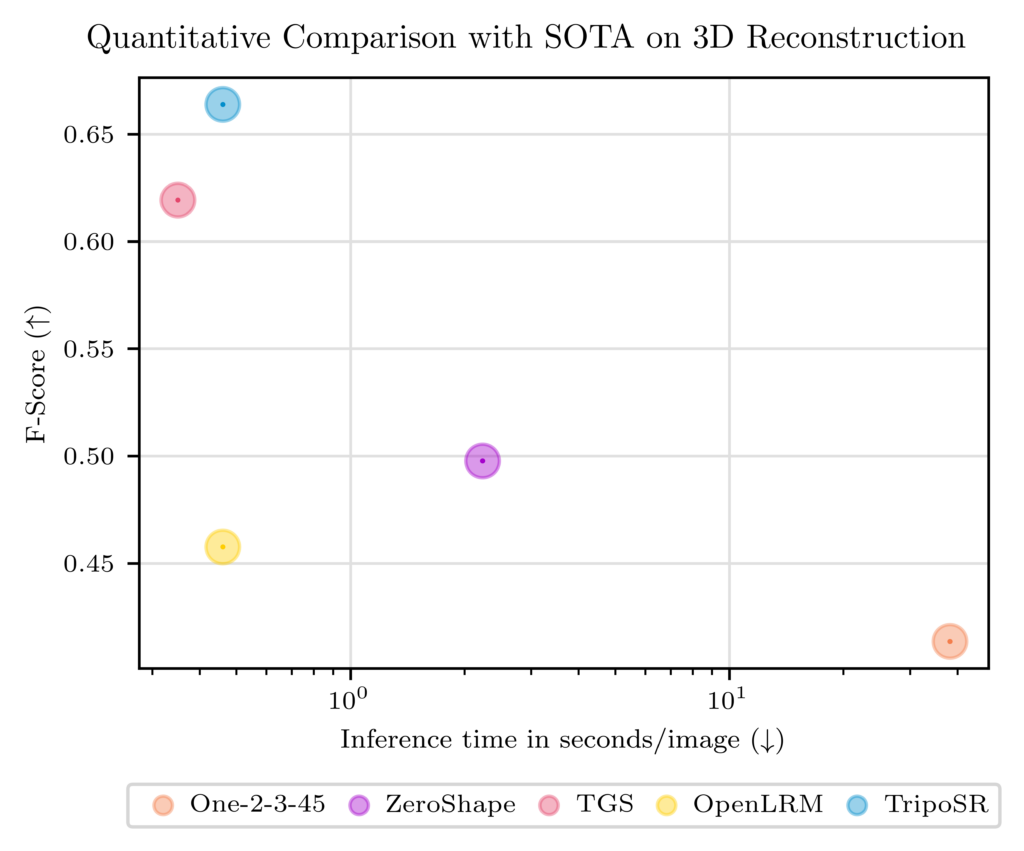

以下の画像と表は、TripoSRと他の主要な3Dモデル生成AIの出力と、モデルが生成した3Dモデルの品質(Fスコア)と推論時間を表しています。

この結果を見ると、他のモデルが3D化できないような画像も正確に3Dモデルを生成できています。

また、生成時間に関しては、TGSよりわずかに遅く、OpenLRMと同等であるものの、3Dモデルの品質評価では最も高いスコアを獲得しており、スピード、質ともに他のモデルを凌駕する性能を有しています。

最後に、TripoSRで実際に生成できる3Dモデルの例を紹介します。

ここからは、TripoSRの使い方を解説し、実際に使ってみようと思います。

なお、その他の3Dモデル生成AIについて知りたい方はこちらの記事をご覧ください。

TripoSRのライセンス

TripoSRは「MIT License」のもとで提供されています。そのため、商用・非商用を問わず、無料で利用、コピー、変更、組み合わせ、再配布することができます。

該当のライセンスについて詳しくは公式ページをご確認ください。

MIT License → https://opensource.org/license/mit

| 利用用途 | 可否 |

|---|---|

| 商用利用 | ⭕ |

| 改変 | ⭕ |

| 配布 | ⭕ |

| 私的利用 | ⭕ |

TripoSRの料金

MITライセンスのもとで公開されており、ソースコードや事前学習済みモデルは基本的に全て無料で利用可能です。

ただし、クラウド上でのホスティングや、APIとして提供されるサービス(ex. Tripo AIのWebサービスやAPI)を利用する場合、有料プランが設定されている場合があります。

TripoSRの使い方

TripoSRは、オンラインデモを使用する方法とローカルに実装する方法の2種類あります。

オンラインデモは、本来以下のリンクにアクセスするだけで使用できるのですが、2025年2月4日時点ではRuntime Error(管理者側の更新中or構成ミス?)で利用できなくなっています。

参考:https://huggingface.co/spaces/stabilityai/TripoSR/discussions/12

気を取り直して、ローカルで実装する方法を解説します。

実装を始める前に、以下がインストールされていることを確認してください。

- Python >= 3.8

- CUDA

- PyTorch(環境にマッチしたCUDA対応版)

まずはTripoSRのGitHubリポジトリをクローンします。

git clone https://github.com/VAST-AI-Research/TripoSR.gitTripoSRのディレクトリに移動します。

cd TripoSRsetuptoolsを更新してください.

pip install --upgrade setuptools次に、依存関係をインストールします。

pip install -r requirements.txtこれでインストールは完了です。

TripoSRを実行する方法は、コマンドラインから手動で実行する方法と、Gradioアプリで実行する方法の2種類あります。

手動で実行する方法は、以下のコマンドを実行します。

python run.py examples/chair.png --output-dir output/これを実行して生成された3Dモデルは、output/に保存されます。

保存された画像はこちら

また、画像ファイルを複数指定することで、一括処理も可能です。

続いて、Gradioアプリで実行する場合は、まずGradioをインストールします。

pip install gradio次に、以下のコマンドを実行してGradioアプリを起動します。

python gradio_app.py上記コードを実行後、ブラウザからhttp://127.0.0.1:7860へアクセスしましょう。

Gradioで実行する場合と、オンラインデモを使用する場合は以下のような画面になります。

Gradioを使用する方が、手動実行するより遥かに分かりやすいですし、リアルタイムで生成結果が確認できそうなので、パラメータ調整に適してそうですね。

実装は完了したので、実際に実行してみようと思います。

TripoSRを実際に使ってみた

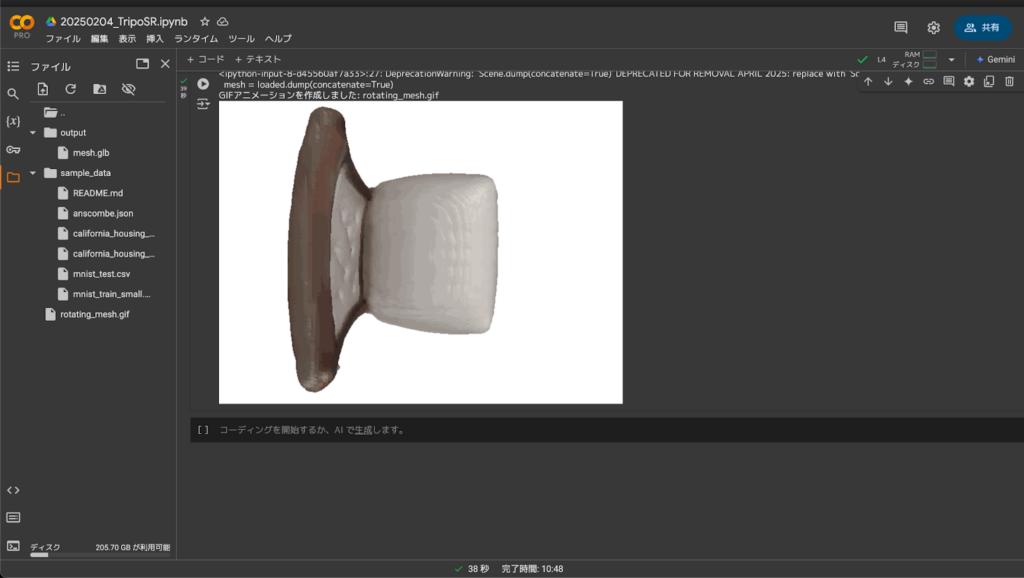

今回は、より高速な推論が行えるように、Google ColabでV100 GPUを使用しました。

以下の画像を入力します。

結果はこのようになりました。

正直あまりよい結果とは言えませんね。

前側が平面になっており、3Dモデルとしての品質は低いです。

入力する画像によっては、このように3D化に失敗してしまうのかもしれません。

ちなみに、GoogleColab上で出力まで一気通貫で完結させる実行手順は以下の通りです。

- outputディレクトリを作成し、好きなglbファイルを格納(今回はmesh.glbという名の椅子の画像を使用)

- 以下コードを実行

# 1. システムパッケージの更新と必要ライブラリのインストール(xvfb, libglu1-mesa)

!apt-get update && apt-get install -y xvfb libglu1-mesa

# 2. 必要な Python パッケージ(numpy 以外)を extras なしでインストール

!pip install trimesh imageio pyvirtualdisplay

# 3. 既存の numpy をアンインストールし、依存パッケージに合わせ numpy==1.26.0 を強制インストール

!pip uninstall -y numpy

!pip install numpy==1.26.0 --force-reinstall --no-cache-dir

# 4. numpy のバージョン確認(1.26.0 になっているか確認)

!python -c "import numpy; print('numpy version:', numpy.__version__)"

# 5. ヘッドレス環境対応:仮想ディスプレイの起動

from pyvirtualdisplay import Display

display = Display(visible=0, size=(1024, 768))

display.start()

# 6. 3Dメッシュの読み込み

# "output/mesh.glb" が存在すれば読み込み、存在しなければサンプルとして icosphere を生成

import os

import trimesh

if os.path.exists('output/mesh.glb'):

loaded = trimesh.load('output/mesh.glb')

# loaded が Scene オブジェクトの場合、Trimesh オブジェクトに変換

if isinstance(loaded, trimesh.Scene):

mesh = loaded.dump(concatenate=True)

else:

mesh = loaded

else:

print("output/mesh.glb が見つからなかったため、サンプルメッシュ(icosphere)を使用します。")

mesh = trimesh.creation.icosphere()

# 7. 3Dメッシュを回転させた各フレームを生成

import numpy as np

import imageio

import io

from PIL import Image

frames = []

num_frames = 36 # 360°回転を36フレーム(約10°ずつ)で作成

for i in range(num_frames):

angle = (360.0 / num_frames) * i

rotated_mesh = mesh.copy()

# Y軸周りに回転

R = trimesh.transformations.rotation_matrix(np.radians(angle), [0, 1, 0])

rotated_mesh.apply_transform(R)

# rotated_mesh が Scene か Trimesh かで分岐

if isinstance(rotated_mesh, trimesh.Scene):

scene = rotated_mesh

else:

scene = rotated_mesh.scene()

# 画像データを取得

png_data = scene.save_image(resolution=(640, 480), visible=True)

if png_data is None:

continue # 画像生成に失敗した場合はスキップ

image = Image.open(io.BytesIO(png_data))

frames.append(np.array(image))

# 8. 各フレームを GIF アニメーションとして保存

output_gif = 'rotating_mesh.gif'

imageio.mimsave(output_gif, frames, fps=10)

print("GIFアニメーションを作成しました:", output_gif)

# 9. Colab 上で GIF を表示

from IPython.display import Image as IPyImage

IPyImage(output_gif)一部パッケージの依存関係によってエラー文が出るかもしれませんが、以下画像のように3Dモデルが生成できました。

ここからは、TripoSRの実用性を測るため、想定される様々なシチュエーションで精度の高い3Dモデルが生成できるか、他の3Dモデル生成AIとの比較も行いながら検証します。

別ツールとの連携

TripoSRは、ComfyUIと連携したり、Stable Diffusionなどの画像生成AIツールを活用することで、画像生成から3Dアセット作成までのワークフローを簡単に構築することもできます。

ComfyUI参考:https://weel.co.jp/media/innovator/comfyui/

Stable Diffusion参考:https://weel.co.jp/media/stable-diffusion

- ComfyUIとの連携

- GitHubで公開されているカスタムノードを利用すると、ComfyUIの環境内から直接TripoSRを呼び出して3Dモデル生成が可能になります。

- インストール方法

- ComfyUIのcustom_nodesフォルダにリポジトリをクローンし、依存パッケージをインストールするだけです。

- この方法により、Stable Diffusionなどで生成した画像や、既存の画像をそのまま入力として、TripoSRの3D生成機能を利用でき、生成されたファイルもOBJ形式であるため、3D編集ソフトへも簡単に取り込むことが可能です。

TripoSRの推しポイントである高速かつ高品質な3Dモデル生成は本当なのか検証してみた

ここからは、TripoSRの実用性を検証するため、活用が想定される様々な分野のシチュエーションで精度の高い3Dモデルが生成できるか検証します。

またTripoSRと同じ3Dモデル生成AIであるOne-2-3-45とOpenLRMとの比較も同時に行います。

果たしてTripoSRは、実際の業務でも活用できるほどの性能を有しているのでしょうか?

なお、今回の比較検証では、TripoSRはV100 GPUで、One-2-3-45とOpenLRMはデモを使用するためA10Gで実行します。

早速検証していきましょう!

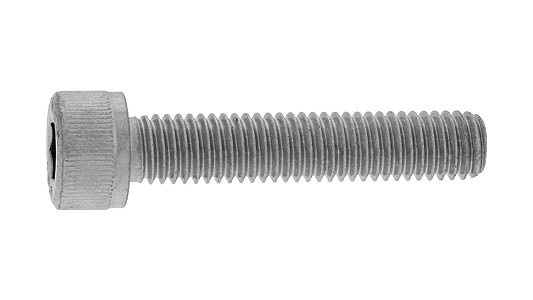

製品設計

TripoSRのような3Dモデル生成AIは、製造業の製品設計のような業務に活用可能です。

1枚の画像から精度の高い3Dモデルを生成できれば、3Dモデリングの作業が大幅に効率化されます。

そこで、以下のボルトの画像を入力して3Dモデルを生成してもらいます。

結果はこのようになりました。

TripoSR

8秒ほどでこの3Dモデルを生成してくれました。

一枚の画像から生成されたものだと考えればなかなかの精度だと思いますが、実用的なレベルではないと感じます。

OpenLRM

こちらはA10Gで、約20秒ほどで生成してくれました。

品質はTripoSRとほぼ同等ですが、生成時間はTripoSRの方が遥かに速いです。

One-2-3-45

One-2-3-45は、この中で最も低い品質の3Dモデルを生成しました。

テクスチャも反映されておらず、こちらも実用的なレベルではないようです。

ちなみに生成時間は20秒ほどでした。

ゲームキャラクター

続いて、ゲームのキャラクターの画像を入力して3Dモデルを生成します。

ゲーム開発においても、キャラクターや環境、アイテムなどの3Dモデルを作成してゲーム内で使用するため、TripoSRのような3Dモデル生成AIによって開発作業が大幅に効率化されるでしょう。

以下の画像を入力します。

この手のモデルは立体感のない画像は苦手そうですが、結果はどうなるでしょうか。

見ていきましょう!

TripoSR

今度は6秒ほどでこの3Dモデルを生成してくれました。

かなり高速ですが、やはり二次元の画像は平面なので立体化しにくいのか、かなりバランスの悪い3Dモデルになってしまっています。

OpenLRM

OpenLRMは、約20秒ほどでこの3Dモデルを生成してくれました。

こちらは全体的に薄っぺらいですが、TripoSRのようないびつさはなく、バランスはとれています。

しかし、まだまだ実用的なレベルには至っていないです。

One-2-3-45

こちらはテクスチャが反映されておらず、分かりにくいですが、3Dモデルの品質は悪いです。

また、One-2-3-45はこの3Dモデルを生成するのに1分以上かかっており、その性能は他の2つと比較して低いと言わざるを得ません。

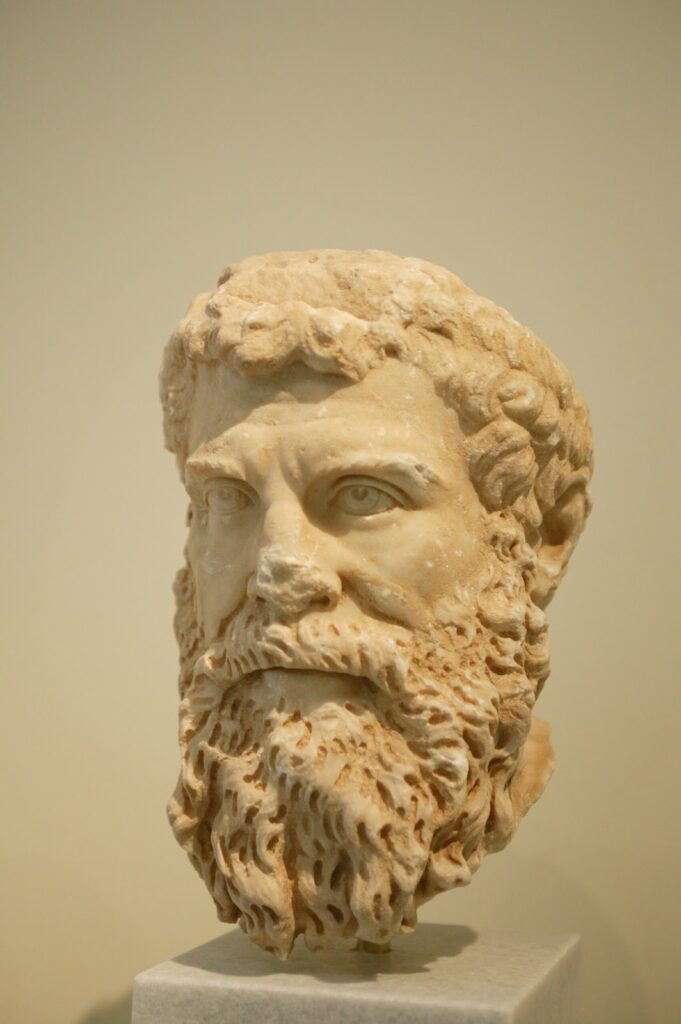

美術品

TripoSRは、美術館に展示されているような美術品の画像から3Dモデルを生成し、デジタルアーカイブとして保存したり、バーチャル美術館としてそのモデルをオンライン上で公開するといったことにも活用可能です。

この検証では、以下の彫刻の画像を入力し、高い精度で3D化できるか検証します。

髭や髪の毛など、凹凸がかなりありますが、どこまで再現してくれるのでしょうか。

見ていきましょう!

TripoSR

今回はなんと4秒ほどで3Dモデルを生成してくれました。

ですが、肝心の3Dモデルの品質はというと、画像に写っている部分は非常によくできているのですが、写っていない背面は全くダメで、かなりバランスの悪いモデルになってしまっています。

OpenLRM

こちらは、先ほどと同様に約20秒ほどでこのモデルを生成してくれました。

TripoSRと違い、背面もかなり頑張って生成してくれていますが、やはり画像に写っていない部分の品質はかなり悪いです。

One-2-3-45

One-2-3-45が生成した3Dモデルは、またテクスチャが反映されていないので分かりにくいですが、いびつな形をしており、こちらも品質は良くないです。

今回の検証では、TripoSRの実用性を検証するため、活用が想定される様々な分野のシチュエーションで精度の高い3Dモデルが生成できるか検証しました。

結果は、TripoSR含め、今回検証したすべての3Dモデル生成AIは実用的なレベルには至っておらず、まだまだ進化の余地があると感じました。

また、公式発表ではTripoSRはOpenLRMより大幅に高い品質の3Dモデルを生成できるとされていましたが、実際はそこまで差があるようには感じませんでした。

ただ、生成速度に関してはGPUの差を考慮してもTripoSRが圧倒的速かったので、総合的な性能はTripoSRが最も高いと言えそうです。

このように、まだ実用的なレベルには至っていないものの、今後のアップデート次第では実用的なレベルに達して、3Dモデリングを必要とする多くの業務を効率化させる革命的なツールになるポテンシャルを秘めていると思います。

TripoSRは、オープンソースで誰でも使用可能なので、気になった方は是非試してみてください!

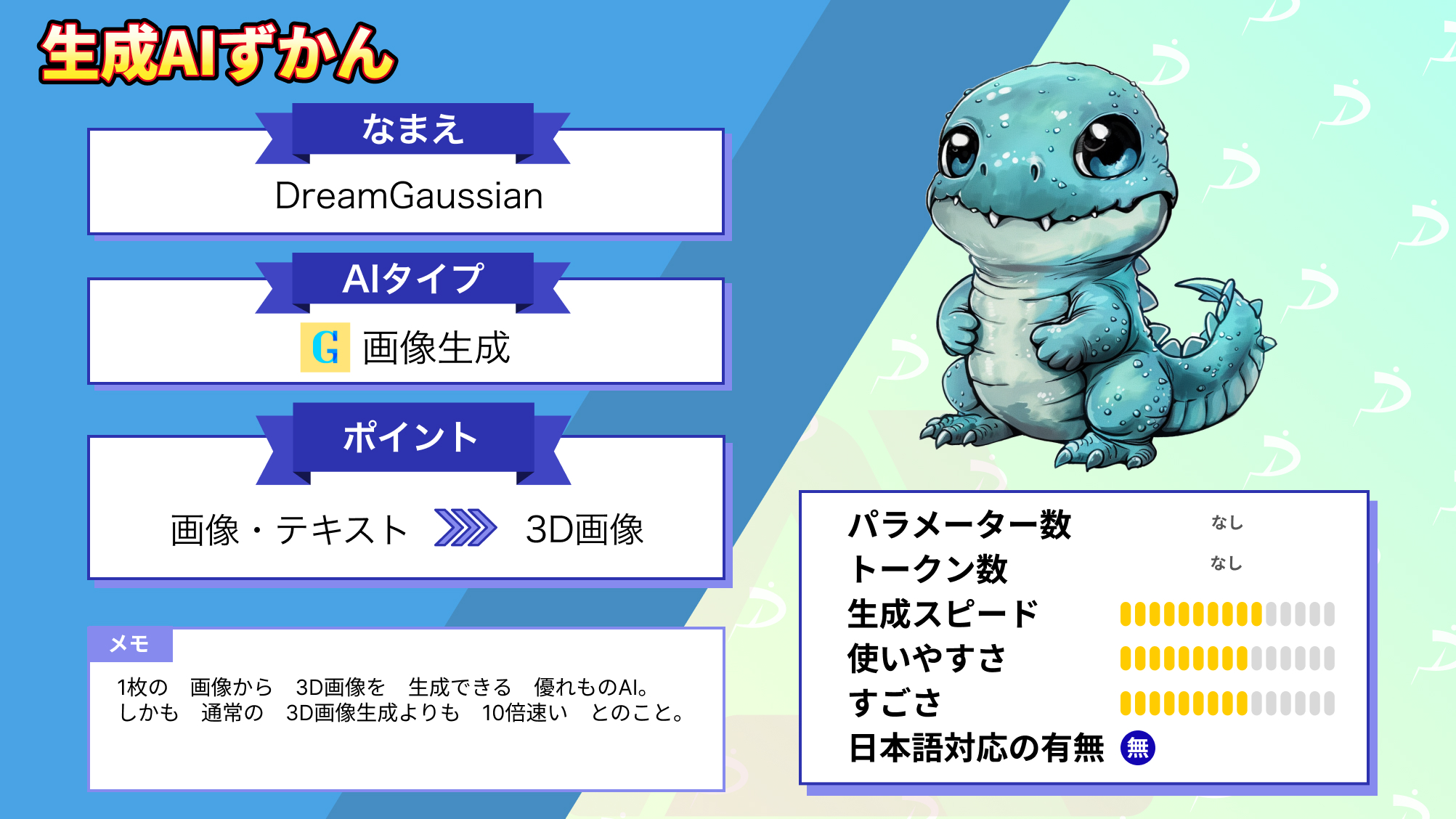

なお、同じく一枚の画像から3Dモデルを生成可能なDreamGaussianについて知りたい方はこちらの記事をご覧ください。

TripoSR利用時の注意点

主な注意点は4つです。

- 入力画像の品質と構図

- 対象物がはっきり写っている画像を使用することが重要です。複雑な背景の場合、イメージと乖離した画像が生成される恐れがあるため、背景除去や画像前処理をするとよりよい3D画像を作成できると思います。

- ハードウェアリソース

- 推論時はGPUのVRAM使用量が高くなる可能性があるので、十分なメモリ(※8GB以上推奨)を備えた環境での利用をおすすめします。また、CPU環境でも動作しますが、生成スピードには期待しないようにしましょう。

- 依存関係の管理

- TripoSRは多くの依存パッケージに依存しているため、インストール時にバージョン不整合やエラーが発生する場合があります。公式のインストール手順や READMEを参照し、適切なバージョンのパッケージをインストールしてください。

- 生成結果の限界

- 高速推論を実現するため、細部の再現性や複雑なオブジェクトの形状に関しては、完全ではない場合があります。用途によっては、後処理(ex. リトポロジーやテクスチャ調整)が必要になることもあります。

活用事例

TripoSRは様々な方法で活用されています。ここではTripoSRの活用事例をいくつか紹介します。

1体のドラえもんを増産

他のツールも併用されているかもしれませんが、1体のドラえもんから増殖させることもできるようです。

らくがきから一気に3D画像生成!

絵心がない方でも、これならイラスト作成の幅が広がりますね〜。

HuggingFaceでも高速生成

上述の通り、2025年2月4日時点ではRuntime Error(管理者側の更新中or構成ミス?)で試すことができませんが、以前はHuggingFace上でも生成ができていたようです。

キャラクター画像の背景抜き

背景除去もへっちゃらです。

バナナキャラクター

AIアプリケーションを自動的かつ簡単にインストール、実行、制御できるWebブラウザ「Pinokio」でも高速生成できていますね。

FAQ(よくある質問)

TripoSRを利用するにあたって気になる点を「質問形式」でまとめておきます。

TripoSRは高速と高品質を兼ね備えた最高クラスの3Dモデル生成AI

TripoSRは、Stability AIがTripo AIと提携し、共同開発した最新の3Dモデル生成AIです。

このモデルは、高性能GPUで動作させれば、1秒以内に単一の画像から高品質な3Dモデルを生成でき、NVIDIA A100GPUを使用すると、なんと0.5秒未満で3Dモデルを生成できます。

また、生成速度だけではなく、品質も従来のものと比較して向上しており、これは「LRM: Large Reconstruction Model for Single Image to 3D」という論文にインスパイアされ、モデルやトレーニング等の改善を行った結果です。

実際に使用した結果、他のモデルと比較して、生成速度が非常に速く、それなりの品質の3Dモデルを生成してくれますが、まだ実際の業務で使用できるレベルには達していないと感じました。

また、他のモデルとの比較でも、発表されているほどの性能差があるようには感じられませんでした。

TripoSRは、オンラインデモも公開されており、GPUのない環境でも実行できるため、気軽に使用できます。もしこの記事を読んで気になった方は、是非試してみてください!

最後に

いかがだったでしょうか?

TripoSRの高速3Dモデル生成は、プロダクト開発やデジタルコンテンツ制作の効率を飛躍的に向上させます。貴社のワークフローに最適な活用方法を検討してみてください。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。