AGI終末時計

AGI終末時計

Doomsday Clock

AGIとは、汎用型人工知能のことで、人間と同じように思考して、

人間が実現可能なあらゆる知的作業を理解・学習・実行することが可能な人工知能のことです。

AGIとは、汎用型人工知能のことで、人間と同じように思考して、人間が実現可能なあらゆる知的作業を理解・学習・実行することが可能な人工知能のことです。

※残り日数は、イーロンマスクやサムアルトマンの発言を元に2028年にAGIが到来すると仮定したもの

※残り日数は、イーロンマスクやサムアルトマンの発言を元に

2028年にAGIが到来すると仮定したもの

※残り日数は、イーロンマスクやサムアルトマンの発言を元に2028年にAGIが到来すると仮定したもの

AGI終末時計は、

生成AI業界を牽引する著名人の予測をもとに作成いたしました。

今後は、皆様からのご意見を元に客観的な視点をもって随時更新されていきます。

AGIの誕生まで残り──3年。

「AGI終末時計」は、現在のAIの進歩を可視化することで、

AGIの到来にどこまで近づいているかをお伝えします。

それまでの過程で私達の働き方がどのように変わり、

AIに置き換わっていくのでしょうか?

カウントダウンするだけでは意味がない。

今私たちに必要なことは──未来に追いつくこと。

AGI終末時計では、AIによる仕事の置き換えやAIを使った働き方について、

業務別

業界別(未実装)

職業別(未実装)

といった観点から表示していきます。

AGI終末時計は、

生成AI業界を牽引する著名人の予測をもとに作成いたしました。

今後は、皆様からのご意見を元に客観的な視点をもって随時更新されていきます。

AGIの誕生まで残り──3年。

「AGI終末時計」は、現在のAIの進歩を可視化することで、

AGIの到来にどこまで近づいているかをお伝えします。

それまでの過程で私達の働き方がどのように変わり、

AIに置き換わっていくのでしょうか?

カウントダウンするだけでは意味がない。

今私たちに必要なことは──未来に追いつくこと。

AGI終末時計では、AIによる仕事の置き換えやAIを使った働き方について、

業務別、業界別(未実装)、職業別(未実装)、

といった観点から表示していきます。

AGI到達レベル

AIビックテックのAGI到達レベルは、2023年11月に発表されたGoogle Deepmindの「Levels of AGI: Operationalizing Progress on the Path to AGI」という論文内に記載されていた、Levels of AGIという表を参考に作成しています。

弊社ではレベル4をAGI達成と解釈し、それを100%とした時の現在の数値を記載しています。

Google Deepmind Levels of AGI(2024年6月時点)

Scroll

| パフォーマンス×一般性 | 狭義(明確に範囲が定められたタスク) | 広義(身体を伴わないタスク) |

|---|---|---|

| レベル0:AIでない | 狭義の非AI: 電卓ソフトウェア コンパイラ | 広義の非AI: 人間参加型計算 例: Amazon Mechanical Turk |

| レベル1:発展途上 未熟な人間と同等か それよりも若干優れている | 発展途上の狭義のAI: GOFAI (Boden, 2014) simple rule-based systems e.g. SHRDLU (Winograd, 1971) | 発展途上のAGI ChatGPT(OpenAI, 2023) Bard(Anil et al., 2023) Llama2(Touvron et al,2023) Gemini(Pichai and Hassabis, 2023) |

| レベル2:有能 熟練者の内、少なくともその中央値に達している | 有能な狭義のAI: 有害性検出器 例: Jigsaw (Das et al., 2022) スマートスピーカー 例: Siri (Apple), Alexa (Amazon) Googleアシスタント (Google) VQAシステム 例: PaLI (Chen et al, 2023) Watson (IBM) 特定のタスクのための最先端LLMS 例: 短いエッセイの執筆 シンプルなコーディング | 有能なAGI: 未達成 |

| レベル3:専門家 熟練者の内、少なくともその上位10%に達している | 専門家レベルの狭義のAI: スペリング 文法チェッカー 例: Grammarly (Grammarly, 2023) 画像生成モデル 例: Imagen (Saharia et al., 2022) DALL-E 2 (Ramesh et al., 2022) | 専門家レベルのAGI: 未達成 |

| レベル4:名人 熟練者の内、少なくともその上位1%に達している | 名人レベルの狭義AI: Deep Blue (Campbell et al., 2002), AlphaGo (Silver et al., 2016, 2017) | 名人レベルのAGI: 未達成 |

| レベル5:超人 全人類より優れている | 超人レベルの狭義AI: AlphaFold (Jumper et al., 2021) AlphaZero (Silver et al., 2018) StockFish (Stockfish, 2023) | 人工超知能 (ASI): 未達成 |

AIビックテックのAGI到達レベル

(2025年12月1日更新)

AIビックテックのAGI到達レベル変遷

タイムライン(2024/01/01 – 2024/12/31)

| 更新日 | 概要 | |

|---|---|---|

| 2025年11月27日 | 2025年11月27日、Alibabaは新たな画像生成モデル「Z-Image-Turbo」をリリース。 Z-Image-Turboは、「Z-Image」をベースにした高速推論モデルであり、 写真級のリアリティと中英バイリンガルの正確な文字描画を両立することが可能である。 | 変遷 |

| 2025年11月24日 | 2025年11月24日、OpenAIは新しい機能「ChatGPTショッピングリサーチ」を発表。 ChatGPTショッピングリサーチは、商品調査をAIが自動で代行する新機能である。 | |

| 2025年11月21日 | 2025年11月21日、Google DeepMindは最新の画像生成AI「Nano Banana Pro(ナノバナナプロ)」を発表。 Nano Banana Proは、「Nano Banana」(Gemini 2.5 Flash Image)を大きく上回る性能を持つ 画像生成・編集モデルである。 | 変遷 |

| 2025年11月20日 | 2025年11月20日、xAIは新たなAIモデル「Grok 4.1 Fast」を発表。 Grok 4.1 Fastは、200万トークンのコンテキストウィンドウを備えているのが特徴で、 顧客サポートや財務などの実務で使えるようトレーニングされている。 | |

| 2025年11月20日 | 2025年11月20日、OpenAIは新しいAIコーディングモデル「GPT-5.1-Codex-Max」を発表。 GPT-5.1-Codex-Maxは、OpenAIの最新基盤推論モデルをベースにした エージェント型コーディングAIである。 | |

| 2025年11月18日 | 2025年11月18日、Googleは新たなAIサービス「Google Antigravity」を発表。 Google Antigravityは、Googleが公開した新しい「エージェント指向のIDE」である。 | |

| 2025年11月18日 | 2025年11月18日、Googleはソフトウェア開発における重要な課題を解決するために 設計されたツール「Code Wiki」を発表。 Code Wikiは、ソースコードを読み取り、処理の流れやAPIの情報を自動で整理し 「開発チーム向けのWiki」を生成してくれるツールである。 | |

| 2025年11月13日 | 2025年11月13日、Googleから新たなAIエージェント「SIMA 2」を発表。 SIMA 2は、Google DeepMindが開発したAIエージェントであり、 3D仮想空間において人のパートナーとして行動・推論・学習ができる。 | 変遷 |

| 2025年11月13日 | 2025年11月13日、OpenAIは「GPT-5.1」をリリース。 GPT-5.1は、GPT-5シリーズに属する2つの新モデル「GPT-5.1 Instant」と 「GPT-5.1 Thinking」から構成されている。 | |

| 2025年11月12日 | 2025年11月12日、ChatGPTに新しく「グループチャット」機能が追加。 グループチャットは、複数の人とAIを同じ対話空間に招き、友人との旅行計画から 職場の議論まで、共同でアイデアを出し合える場である。 | |

| 2025年11月7日 | 2025年11月7日、AlibabaはQwen3-Maxシリーズにおいて、推論性能を極限まで高めたモデル 「Qwen3-Max-Thinking」をリリース。 Qwen3-Max-Thinkingは、すでに登場していたQwen3-Max-Instructをベースに、 論理的思考や数学的推論を中心に強化したモデルであり、「考えることに特化したAI」 として位置づけられている。 | 変遷 |

| 2025年10月30日 | 2025年10月30日、OpenAIは自律型サイバーセキュリティエージェントの「Aardvark」をリリース。 Aardvarkは、コードリポジトリを継続的に監視し、脆弱性を「発見→検証→優先度付け→修正提案」 まで一貫して行えるため、自律型セキュリティエージェントとして定義されている。 | |

| 2025年10月29日 | 2025年10月23日、OpenAIは新たなオープンソース安全推論モデル「gpt-oss-safeguard」をリリース。 gpt-oss-safeguardは、「gpt-oss」シリーズをベースにファインチューニングされたもので、 開発者が独自のコンテンツポリシーをモデルに与え、 入力テキストの安全性を判定できる点が特徴である。 | 変遷 |

| 2025年10月27日 | 2025年10月27日、xAIから次世代の知識プラットフォーム「Grokipedia」が発表された。 Grokipedia(グロキペディア)とは、Elon Musk氏が率いるAI企業 xAI によって開発された、 「生成AIを活用した独自の百科事典サービス」である。 | |

| 2025年10月23日 | 2025年10月23日、OpenAIから新たな機能「Company Knowledge」がリリース。 Company Knowledgeは、社内で使うGoogleドライブやSlack、SharePointなど 色々なサービスに分かれてしまった資料やメッセージを、 ChatGPT上で一度に探して答えを見つけることができる新しい仕組みである。 | |

| 2025年10月22日 | 2025年10月22日、OpenAIから新たなサービス「ChatGPT Atlas」がリリース。 ChatGPT Atlasは、AI搭載の新しいWebブラウザで、従来のように「ChatGPTを開いて質問する」 のではなく、どのWebページ上でもChatGPTがユーザーの操作を理解し、即座にサポートする という体験を実現している。 | 変遷 |

| 2025年10月16日 | 2025年10月16日、Anthropicから新たなAIサービスが「Agent Skills」がリリース。 Agent Skillsは、Claudeに特定の知識・手順・スクリプトをまとめて 読み込ませることができる機能である。 | 変遷 |

| 2025年10月16日 | 2025年10月16日、Anthropicから新たな大規模言語モデル「Claude Haiku 4.5」が公開。 Claude Haiku 4.5は、Anthropic社が2025年10月16日に発表した Claude 4.5シリーズの最新モデルである。 | |

| 2025年10月9日 | 2025年10月9日、Google Cloudが企業向けのプラットフォームとして 「Gemini Enterprise」を発表。 Gemini Enterpriseとは、AIエージェントや各種ツールを連携する総合プラットフォームで、 Googleは「職場のAIへの入口」と表現している。 | 変遷 |

| 2025年10月7日 | 2025年10月7日、xAIから新たなAIツール「Imagine v0.9」を発表。 Imagine v0.9(通称:Grok Imagine)は、テキストや画像を入力するだけで、 短いAI動画を自動生成できる次世代の映像生成ツールである。 | |

| 2025年10月7日 | 2025年10月7日に開催されたOpenAI DevDayで、OpenAIから新たなサービス 「Apps Inside ChatGPT」がリリースされた。 Apps Inside ChatGPTは、ユーザーがチャット中に自然な流れでアプリを 呼び出し、操作できる機能である。 | |

| 2025年10月7日 | 2025年10月7日に開催されたOpenAI DevDayで、OpenAIはUIでワークフローを 構築しながらAIエージェントを作成できる「AgentKit」を発表。 AgentKitは、マルチエージェント型のAI開発を支援する統合ツール群で、 視覚的なワークフロー作成ツールや埋め込み型チャットUI、安全性フィルター、 評価フレームワークなどを含んでいる。 | |

| 2025年10月7日 | 2025年10月7日、Googleから新たなAIモデル「Gemini 2.5 Computer Use」が登場。 Gemini 2.5 Computer Useは、「Gemini 2.5 Pro」を基盤に構築され、 ユーザーインターフェース(UI)を直接操作できるAIエージェントである。 | |

| 2025年10月6日 | 2025年10月6日にGoogle DeepMindが新しいAIエージェント「CodeMender」を発表。 CodeMenderは、大規模言語モデルを活用して、ソフトウェアのセキュリティ向上を自動化する 画期的な取り組みとして注目を集めている。 | |

| 2025年9月30日 | 2025年9月30日、OpenAIから新たな動画・音声生成モデル「Sora2」が登場。 2024年2月に公開された初代Soraが「GPT-1に相当する」と評されたのに対し、 Sora2は「GPT-3.5に匹敵する進化」と位置づけられている。 Sora2は従来の動画・音声生成モデルに比べて物理的な正確さとリアリティが大幅に向上しており、 シーン内での失敗や偶然の出来事も自然に描けるのが特徴である。 | 変遷 |

| 2025年9月30日 | 2025年9月30日、AnthropicはClaudeシリーズの最新モデル「Claude Sonnet 4.5」をリリースした。 Claude Sonnet 4.5は、特にコーディングと複雑なエージェント構築に優れたAIである。 公式発表では「世界最高のコーディングモデルであり、複雑なエージェント構築で最強、 コンピュータ操作も得意」と謳われていて、推論力や数学能力でも大きく性能が向上している。 | |

| 2025年9月25日 | 2025年9月25日、ChatGPTに新たなAIアシスタント「ChatGPT Pulse」を発表。 ChatGPT Pulseは、ChatGPTシリーズの中でも「最新情報を効率よく集め、 自分に合った形で整理できる」ことに強みを持つサービスである。 一般的なChatGPTと比べて大きな特徴は、ニュースや業界の動きを素早くキャッチできる点にある。 | |

| 2025年9月24日 | 2025年9月24日、GoogleがChrome DevTools MCPサーバーを公開。 Chrome DevTools MCPサーバーは、AIエージェントが実際のChromeブラウザを 操作・調査できるようにするMCP(Model Context Protocol)サーバーである。 MCPは、大規模言語モデルと外部ツールを接続するオープン標準で、 このサーバーを介してエージェントはChrome DevToolsの機能を そのまま利用することができるようになる。 | |

| 2025年9月23日 | 2025年9月24日、GoogleがChrome DevTools MCPサーバーを公開。 Chrome DevTools MCPサーバーは、AIエージェントが実際のChromeブラウザを操作・調査できるよう にするMCP(Model Context Protocol)サーバーである。MCPは、大規模言語モデルと外部ツールを 接続するオープン標準で、このサーバーを介してエージェントはChrome DevToolsの機能をそのまま利用 することができるようになる。 | 変遷 |

| 2025年9月23日 | 2025年9月23日、Alibaba社は次世代のテキスト音声合成(TTS)モデル「Qwen3-TTS-Flash」をリリース。 Qwen3-TTS-Flashは17種類の音声プリセットを備えており、英語・日本語・中国語・フランス語などの 10言語に加え、北京語や上海語、広東語など多様な中国方言もサポートする マルチリンガル・マルチダイアレクト対応モデルである。 | |

| 2025年9月23日 | 2025年9月23日、Alibabaから新たなオムニモーダルLLM「Qwen3-Omni」がリリース。 Qwen3-OmniはAlibaba Cloudが開発したエンドツーエンド型のオムニモーダルモデル。 テキスト・音声・画像・動画を入力として処理できるだけでなく、レスポンスをテキストと 自然音声の両方で即時に返すことが可能となっている。 | |

| 2025年9月20日 | 2025年9月20日、XAIから新たなAIモデル「Grok 4 Fast」がリリースされた。 このGrok 4 Fastは、「とても速くて手頃」なのが大きな特徴である。 複雑な質問にもすぐに答えてくれるため、待ち時間のストレスがない。 料金もこれまでのGrokより安くなっているので、個人でも会社でも気軽に使うことができる。 | |

| 2025年9月19日 | 2025年9月19日、AlibabaのTongyi Wanxiangチームは、オープンソースの キャラクター動画生成モデル「Wan2.2-Animate」を公開。 Wan2.2-Animateは、静止画と動画を入力として、静止画の人物が動画の動きや表情を忠実に再現する 「モーション模倣」、および動画中のキャラクターを静止画の人物に置き換える 「キャラクタ置換」を実現するモデルである。 | |

| 2025年9月16日 | 2025年9月16日、OpenAIはGPT-5をプログラミング用途向けに高度に最適化したモデル 「GPT-5-Codex」をリリース。 GPT-5-Codexは、実際のソフトウェア開発で必要なタスク (新規プロジェクト構築、機能・テスト追加、デバッグ、大規模なリファクタリング、 コードレビューなど)に重点を置いて訓練されており、人間のコーディングスタイルに近いコードを 生成し、与えられた指示に厳密に従ってテストを繰り返す能力を持っている。 | 変遷 |

| 2025年9月12日 | 2025年9月12日、Googleが新たなオープンLLMを発表。 VaultGemmaは、Google ResearchとGoogle DeepMindが共同開発した世界最大規模の 「差分プライバシー(DP)付き」大規模言語モデル。パラメータ数は約10億で、 オープンウェイトで提供され、Hugging FaceやKaggleでも利用可能である。 | |

| 2025年9月12日 | 2025年9月12日、AlibabaのQwenチームは次世代大規模言語モデル「Qwen3-Next-80B-A3B」を発表。 昨今、AI研究においてはパラメータ数や文脈長の拡大が続いていますが、 これに応える形で「Qwen3-Next」アーキテクチャが導入されました。 本モデルは、800億パラメータを持ちながら、実際の推論ではわずか30億パラメータしか 活性化しない超効率設計が特徴となっている。48→51に変更。 | 変遷 |

| 2025年9月9日 | 2025年9月9日、新たな画像生成AIがByteDanceから登場。 Seedream 4.0は、TikTokの運営元であるByteDanceが2025年9月に発表した最新の画像生成AI。 これまでのSeedream 3.0(画像生成)とSeedEdit 3.0(画像編集)が一つになり、 生成から編集まで一気通貫で利用できるのが大きな特徴である。 | |

| 2025年9月9日 | 2025年9月9日、Alibabaから新たなモデルが登場。 Qwen3-ASR-Flashは、従来のASRモデルと比較して幅広い言語対応と高い認識精度を持つ 音声認識モデル。 対応言語は中国語(四川語、閩南語、呉語などの主要方言を含む)、 英語(米国英語、英国英語などの地域アクセントも含む)、さらに日本語、韓国語、フランス語、 ドイツ語、ロシア語、イタリア語、スペイン語、ポルトガル語の合計11言語である。 | |

| 2025年9月6日 | 2025年9月6日、Alibabaが最新の大規模言語モデル「Qwen3-Max-Preview」を公開。 本モデルは単なる世代交代ではなく、1兆パラメータを超える圧倒的な規模と 262,144トークンという驚異的なコンテキスト長を兼ね備えた最新の大規模言語モデルとなっている。 従来のQwenシリーズが持つ多言語対応力や推論性能をさらに強化し、 ClaudeやGemini、DeepSeekといった競合モデルを上回る性能を有している。 | |

| 2025年9月4日 | 2025年9月4日、Google DeepMindが新たなオープンソースのテキスト埋め込みモデルを発表。 EmbeddingGemma-300mは、GoogleがGemma 3アーキテクチャを基盤に開発した テキスト埋め込み専用モデル。入力された文や文書を、意味を保持したベクトルに変換することで、 情報検索・分類・クラスタリングなどのタスクを高精度に処理可能。 | |

| 2025年8月29日 | 2025年8月29日、MicrosoftのAI部門「Microsoft AI(通称MAI)」は音声生成AI「MAI-Voice-1」と その基盤モデル「MAI-1-preview」を公開。 MAI-Voice-1は、テキストから驚くほど自然な音声を超高速で生成できる音声AIモデルであり、 一方のMAI-1-previewはMicrosoft初の大規模言語モデル(LLM)で、 ユーザーからの指示に従って有用な回答を返すことに特化している。 | 変遷 |

| 2025年8月28日 | 2025年8月28日、xAIから新たなエージェント型コーディング特化のAIモデルがリリースされた。 今回リリースされたGrok Code Fast 1は高速かつ低コストで、コーディングをサポートしてくれる。 Grok Code Fast 1は全く新しいモデルであり、軽量モデルアーキテクチャをベースにゼロから 設計されている。 | 変遷 |

| 2025年8月27日 | 2025年8月27日、Google DeepMindは新たな画像生成AIモデル「Gemini 2.5 Flash Image」を発表。 このモデルはテキストで指示を与えるだけで、高品質な画像の生成や既存画像の編集を行える 最先端のAIである。 従来モデルの低遅延かつ低コストな強みはそのままに、画像の合成や細部の編集、 キャラクターの一貫性維持などクリエイティブな制御能力が大幅に向上している。 開発コードネーム「nano-banana」として、事前の評価サイトで話題を呼んでいたこのモデルは、 正式名称とともに公開され、生成AI界隈で大きな注目を集めている。 | |

| 2025年8月27日 | 2025年8月27日、Anthropic社がClaude for Chromeのプレビュー版をリリースしたと発表した。 Claude for Chromeとは、ブラウザの操作をAIエージェントが代行してくれるChromeの拡張機能である。 カレンダーの管理やメールの返信といったタスクを自動化できるため、 これまで手作業で実施していたルーティン業務から解放されるかもしれない。 | |

| 2025年8月26日 | 2025年8月26日、Microsoftから新たなTTSモデルがリリースされた。 今回リリースされたVibeVoice-1.5Bは長尺・マルチスピーカー音声生成が可能。 本モデルの開発背景として、従来のTTSが短い発話や単一話者に強かったのに対し、 本モデルはポッドキャストやオーディオブックのような長時間の会話音声を 自然に合成することを目的に開発されている。 | |

| 2025年8月14日 | 2025年8月14日、Googleは新たなオープンモデル「Gemma 3 270M」を発表。 Gemma 3ファミリーの一員であるこのモデルは、その名の通り、 約2億7千万パラメーターという極めて小型な規模ながら、高い性能と柔軟性を備えているのが 特長である。 | 変遷 |

| 2025年8月8日 | 2025年8月8日、OpenAIが「GPT-5」を正式発表! 前世代のGPT-4oやo3の良さを引き継ぎながら、 「いつ素早く答え、いつ深く考えるか」を自動で切り替える統合設計が最大の特徴。 | 変遷 |

| 2025年8月6日 | 2025年8月6日、OpenAIが1,170億(実稼働51億)パラメータの「gpt-oss-120b」と、 より軽量な200億パラメータの「gpt-oss-20b」の2本立てでリリースされており、 従来はクローズド環境に置かれがちだった高性能なLLMを、 誰でもダウンロードして検証・改変・再配布できるようになっている。 | |

| 2025年8月6日、AnthropicはClaude Opus 4.1をリリースした。 前バージョンClaude Opus 4からさらなる性能向上を果たし、 特に複雑な推論・マルチファイルのコードリファクタリング、 実用的なエージェントタスクへの対応力が向上。 | ||

| 2025年8月5日 | 2025年8月、Google DeepMindからAIモデル「Genie 3」が発表された。 テキストでの指示だけで、リアルタイムに操作可能な仮想世界を自動生成できるこのツールは、 まるでゲームのようなインタラクティブな体験を可能にし、 教育・研究・シミュレーションなど幅広い分野での活用が期待されている。 | |

| 2025年8月5日、Alibabaから新たな画像生成AIが登場。 今回リリースされた「Qwen Image」は特に文字描画に長けており、 ただ単純に画像に文字が入っているレベルではなく、 「人がデザインしたかのように整って見えるテキスト・構成・スタイル」の画像を生成可能。 | ||

| 2025年7月29日 | ChatGPTに新しく「Study Mode(学習モード)」が追加された。 この機能は、ただ正解を提示するのではなく、 ヒントや対話を通じて「考える力」を育てる学習支援ツール。 対話を通じて学べる家庭教師のように、 学生一人ひとりの理解に寄り添うことが可能に。 | 変遷 |

| MicrosoftがWebブラウザ「Edge」に新機能「Copilot Mode(コパイロットモード)」を導入! AIがユーザーのニーズを先読みしてサポートする能動的なブラウジング体験へと進化させる試み。 | ||

| 2025年7月25日 | アリババ・クラウドは多言語翻訳に特化した最新モデル「Qwen3‑MT」をリリース。 wen3ファミリーの技術をそのまま受け継ぎつつ、 翻訳タスク専用に数兆規模の多言語・対訳トークンで追加学習が行われたモデル。 | 変遷 |

| 2025年7月23日 | アリババ CloudのQwenチームは、 コード生成特化型の巨大言語モデル 「Qwen3‑Coder」 をリリース。 Qwen3ファミリーの中でもエンジニアリングに特化した オープンエージェントコーディングモデル。 | |

| 2025年7月14日 | 2025年7月14日、AWSからAIエージェント搭載のIDEが公開。 新たに公開された「Kiro」はコード補完に留まらず、 要件定義から設計・実装・テスト・デプロイまでを AIエージェントと共に進めることが可能。 | |

| 2025年7月10日 | 2025年7月10日にxAI社が、Grokの最新モデルであるGrok4を発表。 先代のGrok3から大幅に進化を遂げ、ベンチマークの結果を見る限り ChatGPTやGemeni、Claudeなどといった主要の生成AIツールよりもハイスコアを記録。 | |

| 2025年6月25日 | Googleは最新の大規模言語モデルGemini 2.5 Proを直接呼び出せるツール「Gemini CLI」を公開。 VS Code拡張のGemini Code Assistと同じエージェント基盤でありながら、 より軽量かつスクリプトからも自在に呼び出せる点が特徴。 | |

| 2025年6月18日 | 2025年6月18日、「Gemini 2.5 Flash-Lite」が登場。 Gemini 2.5モデルの中で最も高速に動作し、最もコストに優れたモデル。 最大100万トークンの長文入力に対応し、テキスト・画像・音声・動画といったマルチモーダルにも対応。 | |

| 2025年6月11日 | 2025年6月11日、OpenAIは推論特化型モデル「o3」の最上位版となる 「o3‑pro」 をリリース! 200 kトークンという巨大なコンテキストを保持しながら、 数理・科学・コーディング領域で従来モデルを上回る精度を実現。 OpenAIは「最も信頼できる汎用AI」と位置付けており、 教育・研究・ビジネスの現場で“考える作業”そのものを肩代わりする存在として注目を集めている。 | 変遷 |

| 2025年6月6日 | 2025年6月6日、Alibabaから新たなAIモデル「Qwen3-Embedding」が登場! テキスト埋め込みモデルで、多言語対応。 従来のLLMと異なり、明示的なタスク記述に対応したLLM。 | |

| 2025年6月3日 | 2025年6月3日、Googleから「Gemini Fullstack LangGraph」が公開! Geminiモデルの高精度な推論力とLangGraphの柔軟なエージェント制御が可能で 検索クエリの自動生成からウェブ調査、ギャップ分析、 回答生成までを一気通貫で実装しているのが特徴。 公開からわずか数日でGitHub 2,000star超えを記録しており、 LLMエンジニアの間で話題を呼んでいる。 | 変遷 |

| 2025年5月23日 | Anthropicから「Claude Opus 4」が登場! コーディング性能が高いLLMであり、 さらに複雑な問題解決に優れており、複数のエージェントに採用されている。 Cursor社や楽天が高い評価をしている。 | 変遷 |

| 同日「Claude Sonnet 4」が登場! 「高速性」と「深い推論力」のバランスを兼ね備えたモデル。 前世代のSonnet 3.7の「ハイブリッド推論」をさらに発展させ、 用途に応じて即座に高速レスポンスを返したり、じっくりと思考を深めたりと自在に調整可能。 | ||

| 2025年5月21日 | AI技術を中心に多数の新機能が発表された。 Gemini 2.5 Proの強化や、対話型検索が可能な「Google検索のAIモード」などが注目を集めたほか、 新たなLLMやAIアシスタント機能の進化も披露された。 | |

| 「Gemma 3n」が登場。 軽量・高性能なオープンソースAIモデルであり、 スマートフォンやタブレットなどのオンデバイス実行に最適化。 Gemini Nanoと同じ基盤技術を使用し、 「日常のデバイス上で動作するリアルタイムAI体験の実現」を目指して設計されたAIモデル。 | ||

| Gemini Diffusionという「テキスト用拡散モデル」という新機軸を採用した研究モデルが公開。 従来の大規模言語モデル(LLM)がトークンを一語ずつ逐次的に出力するのに対し、 “ノイズを洗練させる”拡散過程を経て、複数トークンをブロック単位で同時に生成する。 | ||

| 動画生成AIのVeo3が登場! 音声付きの動画がプロンプト1つで生成できるように進化していて、 編集・リップシンク不要で会話調のショート動画などが作成可能に。 | ||

| コーディング用AIエージェント「Jules」がリリース。 ソースコードの生成からデバッグ、プルリクエストまでの高度な自動化が可能。 OpenAIが繰り出す「Codex」の直接的なライバル。 | ||

| 2025年5月17日 | 2025年5月17日、OpenAIから「Codex」が登場! ChatGPTのサイドバーやターミナル、API経由で動作し、 コード生成からテスト、自動リファクタリングまでを一気通貫でサポート。 従来のコード補完ツールと異なり、仮想マシン内でコマンドを実行しながら結果を説明してくれるため、 開発プロセスの透明性と安全性が大幅に向上。 | 変遷 |

| 2025年5月2日 | Claudeに新機能「Integrations」を実装。 Web版&デスクトップ版Claudeと外部ツールを 「MCPサーバーのインストールなし」で実現してくれるように。 Claudeと外部ツールをシームレスに連携することが可能。 | 変遷 |

| 2025年4月30日 | Alibaba Cloudから最新大規模言語モデルファミリー「Qwen 3」がリリース! 前世代のQwen 2.5の推論・多言語性能に加え、 思考プロセスを“見せる/隠す”モードを自在に切り替えられるハイブリッド設計を採用し、 パフォーマンスとコスト効率を大幅に向上。 | |

| Microsoftから新たなSLM「Phi-4-reasoning」が登場。 推論に特化したSLM (Small Language Model) であり、 特に数学、科学推論、アルゴリズムの問題解決、コーディングといった分野で高い性能を発揮。 大規模言語モデルに匹敵する性能を軽量な構成で実現することを目的にしている。 | ||

| 2025年4月18日 | Googleから新たな大規模言語モデル「Gemini 2.5 Flash」がリリース。 速応答とコスト効率を維持しつつ高度な推論能力を備えた「ハイブリッド推論モデル」で、 従来モデル(Gemini 2.0 Flash)の優れた基盤の上に構築されており、 初めて「思考(thinking)」モードをオン/オフできる設計が採用。 | 変遷 |

| 2025年4月17日 | OpenAIから「o3」が登場。 GPT-4までの従来モデルと比べ、 「より長く考えてから回答する」ことを特徴とする「oシリーズ」の第3世代モデル。 ChatGPT環境において、ツールのフル活用が可能で、 ウェブ検索・コード実行(Python)・ファイルや画像の解析・画像生成といったあらゆるツールを 自律的に組み合わせて問題解決ができるように。 | |

| 同日、推論能力やコスト効率にも優れたハイバランスモデル「o4-mini」が公開。 軽量でありながらも、推論能力が向上しているモデル。 軽量ながらもマルチモーダル対応であり、手書きの文字や画像内の情報も理解可能。 | ||

| ターミナル上からコマンドラインで操作することができる、 コーディングエージェント「Codex CLI」も公開。 マルチモーダル対応であり、スクリーンショットや手書きのUIスケッチからコードが生成でき、 すべての処理はユーザーのローカル環境内で行われる。 | ||

| 2025年4月9日 | Googleが、Agent2Agentというオープンプロトコルを発表。 異なるベンダーやフレームワークで構成されたAIエージェント同士を シームレスに連携し、一括で作業を行えるようにするプロトコル。 50社以上のテクノロジーパートナー主要なサービスプロバイダーが参加しており、 今後更なる機能の拡大が期待されている。 | 変遷 |

| 2025年3月26日 | Googleから試験版の「Gemini 2.5 Pro」が公開。 これまでで最も知的と位置づけられた次世代モデルであり、 回答生成前に内部で「思考」する能力を備えた大規模言語モデル。 前モデルのGemini 1.5やGemini 2.0 Proから大幅に進化しており、 数学・科学・コードの各種ベンチマークで競合を凌駕する結果に。 | 変遷 |

| 2025年3月24日 | Microsoftから「Playwright MCP」が登場。 LLMがWebブラウザを操作できるようにするためのツール。 高速かつ軽量で従来のスクリーンショットに頼らない新たな手法を用いているとのこと。 | |

| 2025年3月21日 | 2025年3月21日、OpenAIが次世代音声認識モデル 「GPT-4o Transcribe」「GPT-4o Mini Transcribe」を公開。 「GPT-4o Transcribe」は、従来のWhisperモデルを上回る性能を持ち、 テキストベースのAIエージェントを音声対話へと拡張するような仕組み。 「GPT-4o Mini Transcribe」はGPT-4o Transcribeの軽量高速版であり、 モデルサイズを小型化し、推論速度を向上させている。 | 変遷 |

| 同日、OpenAIから新たな音声合成モデル「GPT-4o Mini TTS」も公開。 従来の音声合成モデルに比べ、 テキストをより自然な音声に変換するための軽量かつ高性能モデル。 話し方を指示できるのが大きな特徴で、音声出力の対応言語は多言語対応になっており、 英語はもちろん、スペイン語や日本語、フランス語、中国語などに対応している。 | ||

| 2025年3月12日 | 2025年3月12日、OpenAIから新たなマルチエージェントワークフロー「Agents SDK」と 従来の「Chat Completions API」と「Assistants API」の統合「Responses API」が登場。 Agents SDKは、「swarm」をベースに改良されたAIエージェント開発フレームワークで、 高度なAIエージェント構築の支援、複雑なタスクの自動化を容易にすることを目的としている。 Webサーチやファイルサーチ、 コンピューター操作といったツールも組み込まれ、誰でも標準利用可能に。 | 変遷 |

| 2025年3月12日、Googleから「Gemma 3」が公開された。 リリースされたモデルは1B、4B、12B、27Bの4モデルで、1B以外はマルチモーダル対応(画像)。 Gemma 2と比べると、全てのベンチマークでスコアが向上しているが、 Gemini 2.0 FlashとProで比較してみると、性能がやや劣るよう。 | ||

| 2025年2月27日 | 2025年2月27日、OpenAIはGPT-4oの後継にあたる「GPT-4.5」を公開。 思考力と会話の自然さが向上したGPT-4.5では、 従来モデルよりもわかりやすく、適切な回答が行えるようになった。 | 変遷 |

| 2025年2月27日、Microsoftから新しい言語モデル「Phi-4-mini」が公開。 Phi-4-miniは3.8億パラメータを持つコンパクトなモデル。 従来の大型モデルに匹敵する性能を発揮。 小型かつ高速なモデル設計のため、エッジデバイスやオンデバイス実行での利用が可能に。 | ||

| 2025年2月27日、Microsoftから新しい言語モデル「Phi-4-multimodal」が公開。 Phi-4-multimodalはテキストのみならず画像や音声などの入力が可能なマルチモーダルモデル。 テキストだけではなく、画像や音声などの組み合わせによる推論が可能になっていて、 音声+テキストや画像+音声などといった推論が可能に。 | ||

| 2025年2月20日 | 2025年2月20日、「PaliGemma 2」をベースとした「PaliGemma 2 mix」を公開。 追加の学習なしで汎用的な画像と言語の処理能力を発揮する実用的なモデルであり、 マルチモーダル入力も可能。 物体検出やOCRに活用できる。 | |

| 2025年2月25日 | 2025年2月25日、AnthropicからClaudeの新たなモデル「Claude 3.7 Sonnet」が公開。 安全性と性能を兼ね備えたハイブリッド型の推論モデル。 従来のモデルにはない新たな「拡張思考モード」を搭載し、 複雑な問題に対しても回答できるように。 | |

| 2025年2月6日 | 2025年2月6日、Googleは「Gemini 2.0シリーズ」を拡張。 Gemini 2.0に「Pro」モデルと「Flash-Lite」モデルが追加された。 Gemini 2.0 Proは、これまでのモデルに比べコーディング性能が向上。 200万トークンのコンテキストウィンドウをもち、 大量の情報を一度に処理することも可能に。 Gemini 2.0 Flash-Liteは低コスト版として開発され、 処理コストは100万トークンあたり約0.019ドル。 | 変遷 |

| 2025年2月2日 | 2025年2月2日、ChatGPTの新機能であるdeep researchを公開。 検索、分析し、高精度なレポートを自動生成するエージェント機能を搭載。 | 変遷 |

| 2025年1月31日 | 2025年1月31日OpenAIから「o3-mini」が登場。 従来の「o1-mini」と比較して応答速度が24%向上し、より正確な回答を提供。 推論モデルと検索機能が統合された初期のモデルとなった。 | 変遷 |

| 2025年1月29日 | 2025年1月29日、QwenグループからVLM「Qwen2.5-Max」が登場。3日連続のリリースとなった。 事前トレーニングは20兆トークンで、 DeepSeek V3、GPT-4o、Claude-3.5-SonnetなどのLLMと比較し、 DeepSeek V3を上回る性能を発揮。 | 変遷 |

| 2025年1月28日 | 2025年1月28日、QwenグループからVLM「Qwen2.5-VL」が公開された。 画像とテキストだけではなく1時間を超える動画を解析し、特定のイベントを識別することが可能。 エージェント機能が搭載され、AndroidのUI操作やタスク実行ができるようになった。 | |

| 2025年1月27日 | 2025年1月27日、Qwenグループから「Qwen2.5-1M」が登場。 他の大規模言語モデルと比較して、同等またはそれ以上の性能を持ちながら、 計算コストが低く、効率的に動作するように。 | 変遷 |

| 2025年1月23日 | 2025年1月23日、OpenAIからWebブラウザを直接操作して タスクをこなすことができるAIエージェントが公開。 画面に表示されるボタンやメニュー、テキストなどのGUIで操作できるように。 | 変遷 |

| 2025年1月21日 | ソフトバンク、OpenAI、オラクル、MGX、Arm、Microsoft、NVIDIAなど大手企業を中心に 全世界に莫大な経済的利益をもたらす取り組み。 AI技術の安全性と倫理的側面への配慮は不可欠であり、 これらの企業は透明性のある運用で、新しい時代を築いていくことが期待されている。 | |

| 2025年1月14日 | OpenAIは、2025年1月14日に、リマインダー機能である「タスク」を 有料プラン加入ユーザー向けにベータ版として提供開始。 指定した時間に指定したタスクをこなすことができるので、 ChatGPTを使って毎日繰り返し行う作業や、時間になったら最新のニュースを通知してくれる様に。 |

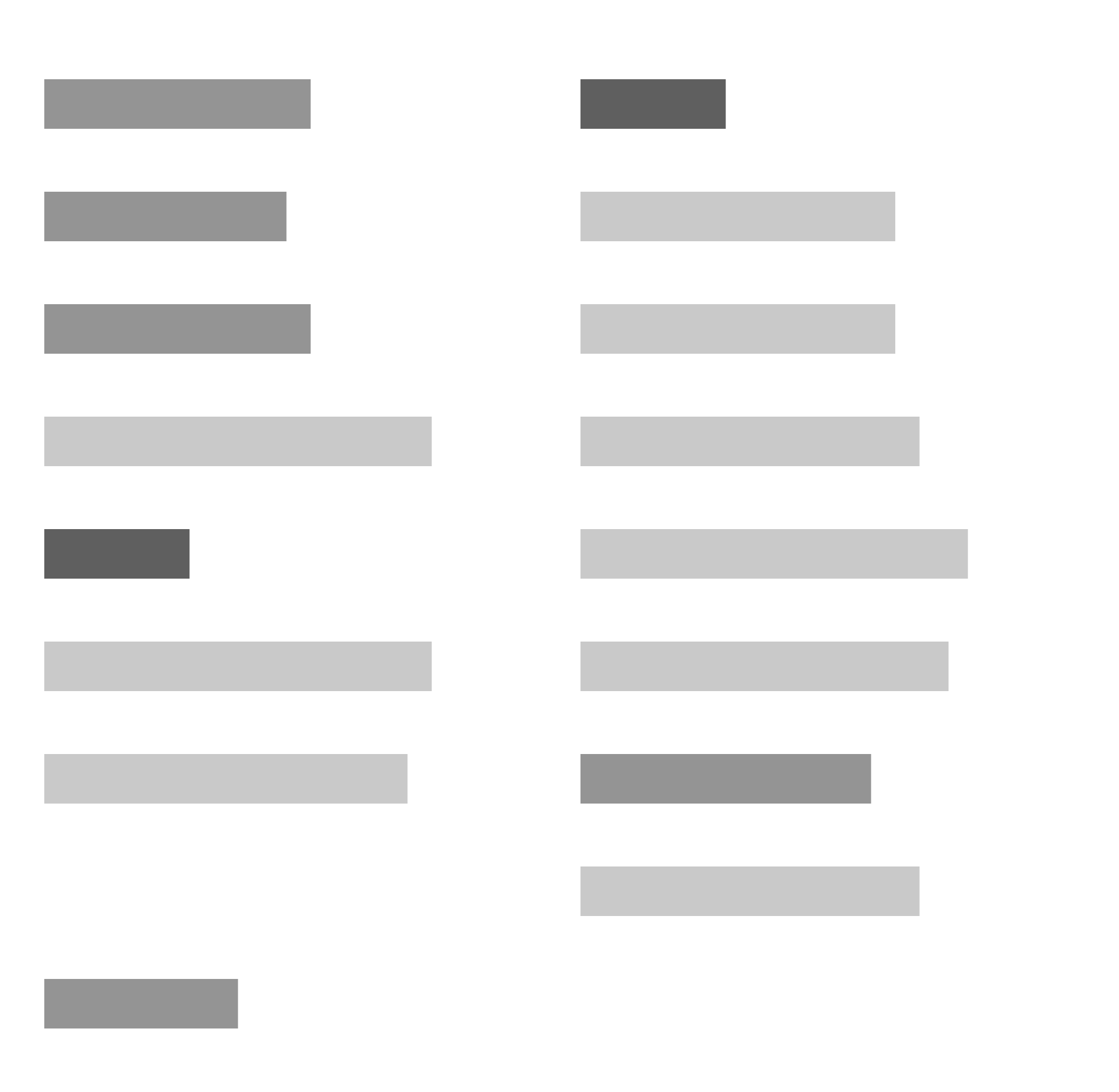

AGIパラメータ

AIの能力を評価する指標には

- チェスなどの対戦ゲームで広く使用されている評価システム「Elo」

- 言語理解の能力を評価するためのベンチマーク「MMLU」

- Google Deepmindの「Levels of AGI: Operationalizing Progress on the Path to AGI」

などがありますが、

これらを生成AIに適用し、みなさまにわかりやすく表現するのは難しいため、弊社で独自の指標を用意しました。

AGIパラメータの定義

Scroll

| 仕事消滅レベル | 仕事消滅度 | 実行者 | 実行領域 | 概要 |

|---|---|---|---|---|

| レベル0 | 0% | 人 | 適用外 | AIは一切介入せず、人間が全ての作業を行い完成品ができる。 |

| レベル1 | 1~25% | 人 | 限定的 | 人間が指示を出し、ブレスト等を通じてAIがアイデアを出すが、人間の行動のみで完成品ができる。 |

| レベル2 | 26~50% | 人 | 限定的 | 人間が指示を出し、人間が主体で作ったものをAIが添削して、それを繰り返し、最後に人間が軽く添削して完成品ができる。 |

| レベル3 | 51~75% | 人 | 限定的 | 人間が指示を出し、AIが主体で作ったものを人間が確認して完成品ができる。 |

| レベル4 | 76~99% | AI | 限定的 | 指示出しから作業過程ではAIだけが行動し、完成品の最終確認は人間が行う。 |

| レベル5 | 100% | AI | 際限なし | 人間は一切介入せず、AIのみで完成品ができる。 |

AGIパラメータ

Scroll

| 仕事内容 | 仕事消滅レベル | 仕事消滅度 | リードプロジェクト | 代替範囲 |

|---|---|---|---|---|

| メール作成 | レベル3 | 55% | ChatGPT | AIは定型的なテンプレートだけでなく、 文脈や受け手に合わせたメールも生成できるようになった。 ただし、それを完全にAIに任せることはできない。 |

| 資料作成 | レベル3 | 55% | Gemini, Genspark AI | 0から資料を作成することが可能だが、 人間の介在なしに完成品を作ることは難しい。 |

| 文書作成 | レベル3 | 55% | ChatGPT, Claude | 文脈に沿った文章の作成は可能だが、内容の正確性や事実関係にはまだ不安がある。 |

| コーディング | レベル3 | 65% | GitHub Copilot, Claude code | 自然言語からのコーディングやデバック、 リバースエンジニアリングの補助は可能だが、 複雑なプログラムの作成はまだ難しい。 |

| コピーライティング | レベル3 | 55% | ChatGPT | 平均的な文章の作成は可能だが、 人間の介在なしに完成品を作ることは難しい。 |

| 正確な情報のリサーチ | レベル3 | 65% | ChatGPT, Perplexity | 自然言語での検索が可能になり、 検索意図を含めた情報検索が可能。 正確性にはまだ不安がある。 |

| 多言語翻訳 | レベル4 | 80% | ChatGPT | 多言語に渡る長文の翻訳をほぼ過不足なく行える。 ネイティブ視点での自然さの実現はまだむずかしい。 |

| クリエイティブ作成 | レベル3 | 70% | DALL-E 3, Stable Diffusion | プロンプト通りのクリエイティブの作成、文字の反映が可能だが、 細かい指示の実現がまだ難しい。 また、AI独特の特徴を持った画像になりがち。 |

| 3Dオブジェクトの作成 | レベル2 | 30% | CSM AI, TripoSR | 画像を元に数分で3Dモデルを作成することが可能だが、 読み込ませる画像によってクオリティの差がある。 |

| 絵画の作成 | レベル4 | 80% | Stable Diffusion | 素人目では、人間が描いたものと見分けのつかない絵画を出力することができる。 |

| 人間らしい会話内容の表現 | レベル4 | 80% | Air AI | 人間の発言を理解し、リアルタイムで音声を出力することが可能。 |

| 人間らしい会話スピードの実現 | レベル4 | 76% | Air AI | 違和感を持たれない程度の受け答えができるが、 時々間が生まれることがある。 |

| 人間が作るのと遜色ない音楽の作成 | レベル4 | 75% | Suno AI | AI独特の特徴のある音楽になるものの、 作詞から作曲まで高クオリティで行える。 |

| リアルタイム音声翻訳 | レベル3 | 60% | ChatGPT | リアルタイムでの翻訳を口頭で行えるが、 イントネーションや自然さに欠ける時がある。 |

| 動画編集 | レベル2 | 40% | Runway, Adobe Premiere Pro | 動画編集もAIで実現できるが、 AIが自律的に仕上げるのではなく、人間が意図や指示を与える必要がある。 |

| 動画の作成 | レベル3 | 70% | Sora | 最長1分というこれまでにない長時間の動画を超高品質で生成できる。 |

| 連続したタスクの実行 | レベル2 | 40% | Open Interpreter | シンプルなタスクであれば、ほぼ自律して完了させることが可能。 複数のタスクが組み合わさったものになるとまだ難しい。 |

仕事消滅度

AGI終末時計について

終末時計が、世界の平和を祈る注意喚起であるように、

AGI終末時計も、AIによる支配を目指すものではありません。

むしろ日本らしいロボットアニメやドラえもんのような、

AIとの共創カルチャーを目指し、

子どもたちがAI-Nativeな時代で楽しく過ごせるように。

私たち大人が「未来に追いつく指標作り」をヴィジョンとして運営していきます。

このAGI終末時計は、皆様からのご意見を元に客観的な視点をもって随時更新されていくことを前提としています。

AGI度数やAGIレベル、そしてそれぞれの数値について皆さんのご意見や批判を受け付けております。

ご意見がある際はX(Twitter)にて #AGI終末時計 とつけてポストしてください。

弊社で確認させていただきます。

【運営元のWEELについて】

運営元のWEELについて

WEELはただの情報発信ではなく、未来予測をする拠点としてメディアを位置付けてきました。

活動は多岐にわたり、

- OpenAIやGAFAMの生成AI競争の記事化

- 次のトレンドを予測して、GitHubで生成AIのOSSをレビュー

- HuggingFaceから面白いLLMを記事化

- お客様のPC操作を模倣する自律型AIの開発

etc…

これまでの活動で得たノウハウ、最新情報、

そして皆様からのフォードバックとお便りをもって

AGI終末時計を更新し続け、現在のAIの進歩を可視化することで

AGIの到来にどこまで近づいているかお伝えします。