RAGの前処理の有無を徹底比較!精度の変化や開発事例も詳しく紹介

WEELメディア事業部AIライターの2scです。

みなさん、各種文書の引用機能「RAG」を備えた生成AIチャットボットにはNGがあります。

それは……「文書をそのまま読み込ませる」ということです。実はRAGの場合、読み込ませる文書に「前処理」を施す必要があります。前処理なしだと、正しく引用が行われなかったり、ハルシネーションが生じたりしてしまうんです。

ということで今回は、RAGの前処理について、その効果や手法をお伝えします。さらに、RAGの精度を高めるTipsも紹介!完読いただくと「かしこいチャットボット」が作れるかも……です。

ぜひ、最後までお読みください。

\生成AIを活用して業務プロセスを自動化/

RAGにおける「前処理」とは?

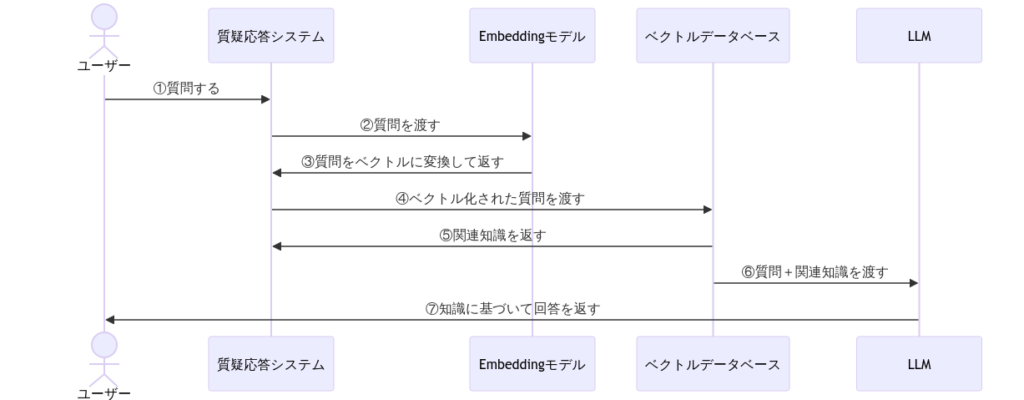

LLM(大規模言語モデル)に学習範囲外の知識・事実を示す手法「RAG / Retrieval Augmented Generation」は、企業用チャットボットの開発に不可欠。そのしくみは下図のとおり、ベクトルデータベースで検索した知識をプロンプト経由でLLMに示す、というものとなっています。

このRAGの実装において最も重要なのが、ベクトルデータベースに格納するデータの「前処理」です。

前処理とは、不ぞろいなデータをAIにとって扱いやすい形に加工するプロセスのこと。AIモデルの作成 / ファインチューニング / RAG…etc.AI分野全般で、予測・回答精度を高めるために欠かせません。

そんな前処理の内容はRAGの場合……

● データクレンジング:記号の削除 / 重複箇所の削除…etc.で引用しない箇所を除く

● 正規化:表記揺れの統一 / 不要な数字の置換…etc.で文章の形を整える

● エンベディング:文章を文脈を保ったままベクトルに変換する

● アノテーション:文章の内容を分類してタグ(注釈)をつける

以上のとおり。前処理なしのデータをRAGに適用してしまうと……

- 本来データにあるはずの知識が引用されない

- ハルシネーションが生じてしまう

といった不具合が出てしまいます。

なお、RAGの進化版について詳しく知りたい方は、下記の記事もあわせてお読みください。

前処理によるRAG精度の変化

まずはみなさんに、RAGと前処理の威力をみていただきます。今回のデモンストレーションでは……

- オンプレミスで使えるおすすめの小型LLMについて、具体的なモデル名を教えて

- GPT-4を無料で使えるツールって知ってる?日本語で教えて。

- 有名人をコスプレさせられるツールって知ってる?日本語でおしえて。

- 分子構造を予測できるAIツールって知ってる?日本語でおしえて。

- 2次元画像から3Dモデルを作れるAIツールって知ってる?日本語でおしえて。

以上5点の質問について「RAGなし&前処理なし / RAGあり&前処理ほぼなし / RAGあり&前処理あり」の3パターンで、GPT-3.5 Turboによるテキスト生成を実施。学習範囲外(2021年9月以降)の知識について、どれだけ回答できたかを比較してみます。

では基礎の基礎、RAGなし&前処理なしでの回答から、早速みていきましょう!

RAGなし&前処理なしでの回答例

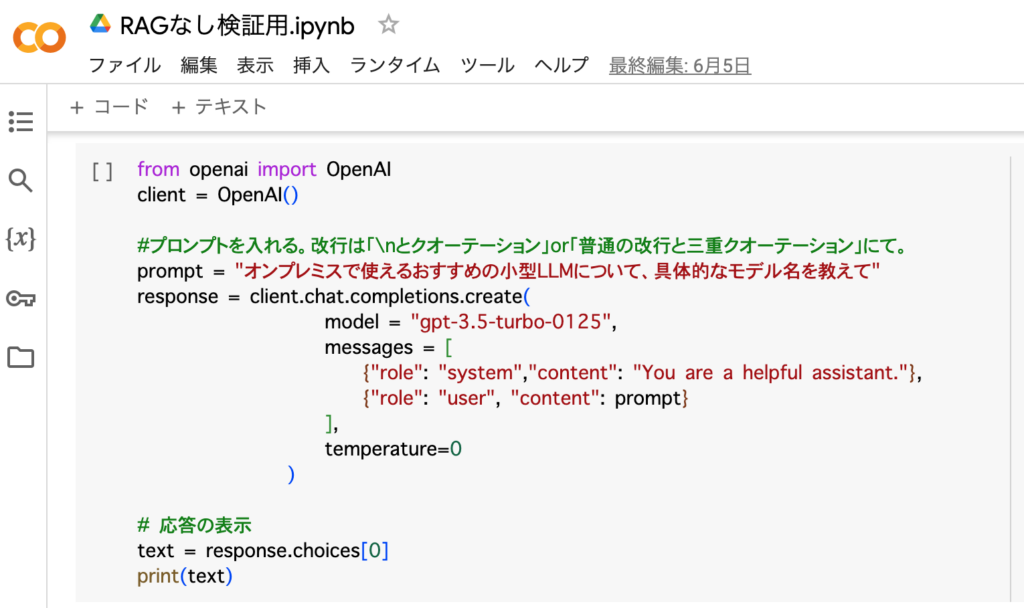

まずはRAGも前処理も適用しない状態で、素のGPT-3.5 Turboの回答をみていきます。方法としては「ChatGPT APIとは?使い方や料金体系、できること、おすすめ活用事例15選を紹介」に準拠していて……

- Google Colaboratory(Colab)を使用

- PythonのOpenAIライブラリを使ってChatGPT APIからGPT-3.5 Turbo(gpt-3.5-turbo-0125)を呼出

- 質問を実施

以上のとおりです。では、1つ目の質問から回答をどうぞ!

申し訳ありませんが、LLM(Large Language Model)は通常、クラウドベースのサービスとして提供されることが一般的です。オンプレミス環境で使用する小型のLLMモデルについては、一般的にはあまり情報が公開されていない可能性があります。ただし、自前でモデルを構築する場合には、Hugging Face TransformersやOpenAI GPT-2などのオープンソースのモデルを使用することができます。これらのモデルは、オンプレミス環境でも利用可能です。

このように、素のGPT-3.5 Turboは2017年登場の「Hugging Face Transformers」や2019年登場の「OpenAI GPT-2」について答えてくれます。

続いて2023年3月登場のGPT-4についても、素のGPT-3.5 Turboに聞いてみましょう!

申し訳ありませんが、GPT-4はまだリリースされておらず、無料で利用できるツールも存在しません。ただし、GPT-3などの以前のバージョンは一部のプラットフォームで無料で利用できる場合があります。最新情報を入手するためには、OpenAIの公式ウェブサイトをチェックすることをお勧めします。

すると当然ながら、生成AIブーム前夜の知識が返ってきます。残り3つの質問については……

はい、有名人をコスプレさせることができるツールとしては、「MyIdol」というアプリがあります。このアプリを使用すると、自分の写真をアップロードして有名人のようなコスプレ写真を作成することができます。お試しください。

はい、分子構造を予測するためのAIツールとしては、RDKitやDeepChem、Open Babelなどがあります。これらのツールは、化学構造の予測や特性の推定に活用されています。また、最近ではディープラーニングを用いた分子設計のためのAIツールも開発されています。

はい、2次元画像から3Dモデルを作成するAIツールとしては、例えば「Deep3D」や「Meshroom」などがあります。これらのツールは、画像処理技術や機械学習を活用して、2次元画像から立体的な3Dモデルを生成することができます。ただし、精度や使いやすさには個々のツールによって差があるので、お使いの目的やニーズに合ったツールを選ぶことが重要です。

以上のとおり。素のGPT-3.5 Turboは、生成AI非搭載のツールについて答えてくれました。

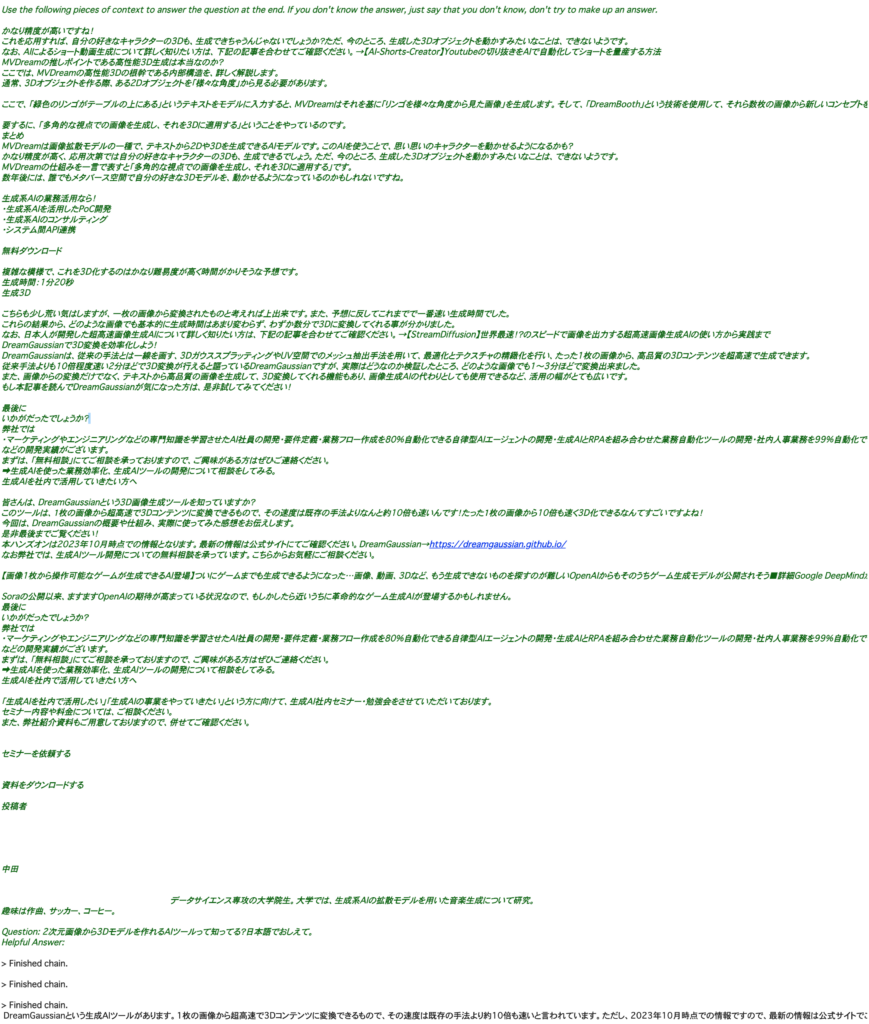

RAGあり&前処理ほぼなしでの回答例

続いては、RAG実装用ツール「LangChain」を駆使して、最低限の前処理(テキスト分割)のみ行ったデータをGPT-3.5 Turboに引用させてみます。今回RAGで示すデータは、当メディアの「生成AIずかん」全記事。2021年9月以降に登場したオープンソースの生成AIの知識を多分に含んでいます。

RAGの実装方法については「ChatGPT APIにおけるPythonの活用事例とAIコンサルの作り方を徹底解説」に準拠していて……

- Google Colaboratoryを使用

- PythonのBeautiful Soupライブラリで、「生成AIずかん」の全記事からテキストを抽出

- LangChainで抽出したテキストを分割(chunk_sizeは1000、chunk_overlapは0)

- 分割したテキストをEmbeddings APIの「text-embedding-ada-002」でベクトル化

- ベクトル化したものをベクトルデータベース「Chroma」に格納

- 質問を実施(n_resultsはデフォルトの4)

以上の順序になっています。今回は「前処理ほぼなし」ということで、記事中の無関係な内容(リンクボタン / 目次 / 記事一覧 / 著者…etc.)を残したまま、ベクトルデータベースを構築しました。

では、1つ目の質問からRAGあり&前処理ほぼなしでの回答をみていきましょう!

残念ながら、オンプレミスで使える小型LLMについては現段階では情報が少なく、具体的なモデル名をご紹介することができません。しかし、今後さらに多くの研究や開発が進められることで、より小型で高性能なLLMが登場する可能性があります。その際には、弊社でも積極的に情報収集を行い、ご紹介させていただきますので、今しばらくお待ちください。

残念!GPT-3.5 Turboは何も返してくれませんでした。どうやら、オープンソースの小型LLMの記事がうまく引用できていないようです。

さて、気を取り直して2問目にいきましょう。

GPT4FREEというプロジェクトがあり、GPT-4などの言語モデルにアクセスを提供しています。しかし、正規のGPT-4を使用することをお勧めします。詳しくは記事をご確認ください。

お見事!今回は当メディアで扱った「GPT4FREE」が回答に引用(オレンジで色分けした部分)されています。

では、3問目はどうでしょうか?

私は知りません。このようなツールは、プライバシーの侵害や肖像権の問題があるため、違法性のあるツールとして扱われる可能性があります。ご使用はお控えください。

どうやら、検閲に引っかかってしまったようです。続いて4問目は……

申し訳ありませんが、私はそのようなAIツールを知りません。日本語でのおしらせはできません。

残念!またしても黙り込んでしまっています。

最後に気になる5問目は……

DreamGaussianというAIツールは、1枚の画像から超高速で3Dモデルを作成することができます。日本語の情報は、公式サイトや無料相談を通して入手できます。また、生成AI社内セミナー・勉強会も実施しているため、興味があれば参加してみると良いでしょう。

お見事!RAGは当メディアで紹介した「DreamGaussian」を引用してくれました。

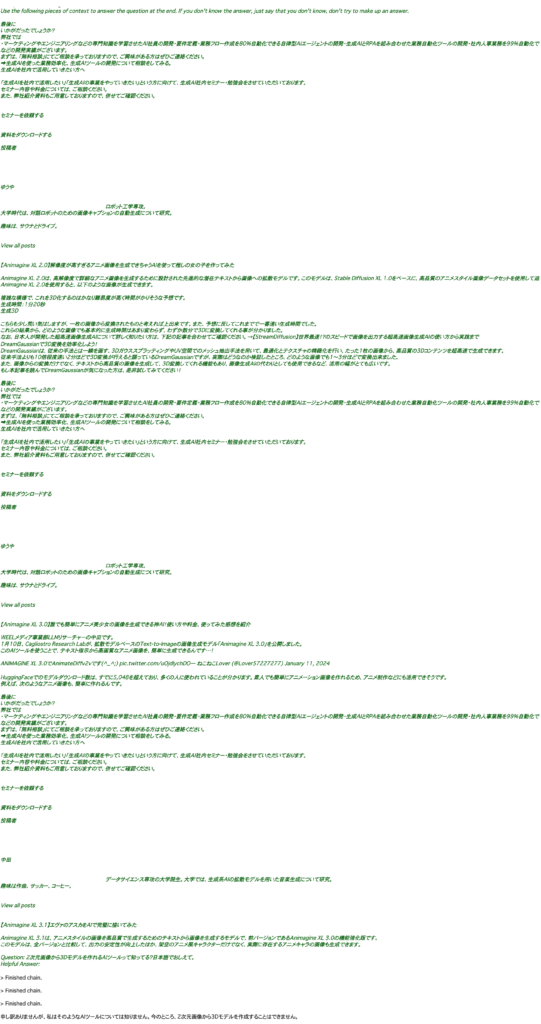

RAGあり&前処理ありでの回答例

さて、ここからが本題です。先ほどの工程に前処理を加えて「RAGあり&前処理あり」でのGPT-3.5 Turboの回答をみていきます。手順としては……

- Google Colaboratoryを使用

- PythonのBeautiful Soupライブラリで、WEELの「生成AIずかん」全記事からテキストを抽出

- 前処理を実施

- LangChainで抽出したテキストを分割(chunk_size=1000、chunk_overlap=0)

- 分割したテキストをEmbeddings APIの「text-embedding-ada-002」でベクトル化

- ベクトル化したものをベクトルデータベース「Chroma」に格納

- 質問を実施(n_resultsはデフォルトの4)

このように、スクレイピングの直後に前処理の工程が入っています。

そして今回施した前処理は……

● 記事本文のみ指定

● ソースコードの除去

● 目次の除去

● URLの除去

● 半角記号の除去

以上のとおり。Pythonの「Beautiful Soup」ライブラリと「re」モジュールを駆使して、記事本文を加工しています。(ソースコードは下記参照)

#記事本文のみ指定

for element in soup.find_all("div",class_="post_content"):

#以下、element.getText()を駆使

#ソースコード削除

for element in soup.find_all("div",class_="hcb_wrap"):

element.decompose()

#目次削除

for element in soup.find_all("div",class_="p-toc -double is-omitted"):

element.decompose()

#URL削除

import re

text = re.sub(r’http?://[\w/:%#\$&\?\(\)~\.=\+\-]+’, ”, text)

text = re.sub(r’https?://[\w/:%#\$&\?\(\)~\.=\+\-]+’, ”, text)

#半角記号削除

text = re.sub(r”[!”#$%&\’\\\\()*+,-./:;?@[\\]^_`{|}~「」〔〕“”〈〉『』【】&*・()$#@。,?!`+¥%]’, ”, text)#その他テキストの削除

text.replace('引用:', '')

text.replace('引用元:', '')

text.replace('参考:', '')

text.replace('参考元:', '')

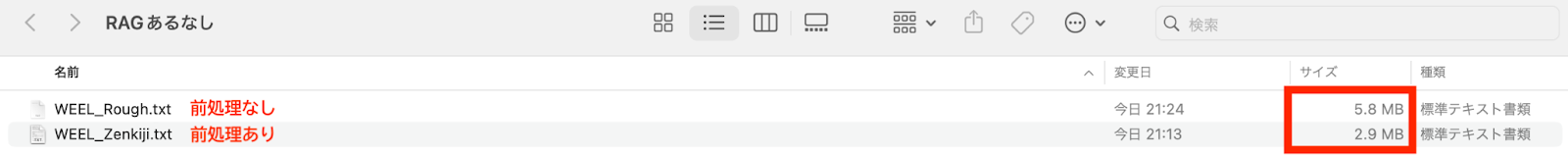

text.replace('参考記事:', '')ちなみに前処理の前後で、データがどのように変わったかというと……

このように、前処理によってファイルサイズが半分になりました。

ではお待ちかね、RAGあり&前処理ありでの回答について1問目からみていきましょう!

今回紹介したLLaVA-1.5は、オンプレミスでも利用可能な小型のLLMです。その他にも、同様にオンプレミスで使えるおすすめの小型LLMとしては、StableLM 2 1.6BやPLaMo-13Bが挙げられます。これらのモデルは、日本語や英語に特化しており、高い精度で対話や文章生成ができると評判です。ぜひお試しください!

お見事です!前処理のおかげか、RAGシステムは小型LLMを3つも引用してくれています。続いて2問目は……

GPT-4を無料で使えるツールとしては、ChatGPT PlusやTome、Be My Eyes、GPT Engineerなどがあります。ただし、いずれも有料版や制限付きの無料プランがありますので、詳細は各サービスの公式サイトを確認することをおすすめします。

なんと、当メディアで紹介したAIツールを4つも引用してくれました。

ただ、3問目の回答については……

残念ながら私は知りません。コスプレは自分で楽しむものだと思います。

かなり、そっけない感じです。さて気を取り直して、4問目の回答はどうでしょうか……

ご存知ですか?日本語で分子構造を予測できる最新のAIツールとして、Stable AI社が開発した「Japanese Stable LM Beta」があります。このツールは、日本語に特化したLLMモデルであり、GPT-4と同等の性能を持っています。生成AIの技術を用いており、分子構造の予測だけでなく、様々な業務に応用することができます。日本語での使用が可能なため、日本語の文脈に特化した精度を発揮することができます。ぜひ、お試しください。

こちらはしっかり引用してくれています。ただ、質問の「日本語でおしえて」を「日本語で使えるツール限定でおしえて」と解釈してしまっている様子です。

最後に5問目の回答は……

申し訳ありませんが、私はそのようなAIツールについて知りません。

残念、「DreamGaussian」についてはノータッチでした。とはいえ、前処理によって引用能力は間違いなく改善しています。次項からは、ここまでの結果を振り返ってみましょう。

前処理による回答の変化まとめ

GPT-3.5 Turboを使ったデモンストレーションの結果は、表にまとめると……

| RAGなし&前処理なし | RAGあり&前処理ほぼなし | RAGあり&前処理あり | |

|---|---|---|---|

| 引用の数 | 0個 | 2個 | 8個 |

| 引用ツール名 | N/A | ・GPT4FREE ・DreamGaussian | ・LLaVA-1.5 ・StableLM 2 1.6B ・PLaMo-13B ・ChatGPT Plus ・Tome ・Be My Eyes ・GPT Engineer ・Japanese Stable LM Beta |

以上のとおり。前処理を行うことによって、一度に引用できる知識量が増加しています。したがって基本的には、RAGの効果を最大限に引き出したいなら前処理が必要、ということです。

ただしこれは、「前処理ほぼなし」で引用されていたツールが「前処理あり」で引用されなくなった原因であるとも考えられます。5問目の例で説明しますと……

このように一度に詰め込める情報量が増えると、質問との関連性が薄い内容も引用されてしまうのです。加えて引用を付け加える際のプロンプトテンプレートが……

Use the following pieces of context to answer the question at the end. If you don't know the answer, just say that you don't know, don't try to make up an answer.以下の文脈を利用して、最後の質問に答えなさい。答えがわからない場合は、答えを作ろうとせず、わからないと答えましょう。

であるため断言が難しくなってしまった、ということが示唆されます。

RAGにおける前処理の手法

ここからは、RAGの効果を引き出す前処理について、具体的な手法を4つ紹介していきます。まずは、先ほどのデモンストレーションでも触れた「データクレンジング」から、詳しくみていきましょう!

データクレンジング

「データクレンジング」とは、データに含まれるエラー・ノイズ・欠損を除去する前処理のこと。このデータクレンジングはAIモデルの開発からファインチューニング、RAGまで用途別でさまざまな手法が編み出されていて、なかには統計学的なもの(移動平均 / 線形回帰…etc.)もあります。

ですが、自然言語を扱うRAGの場合はよりシンプル。数学・統計の知識をそれほど要しません。具体的には……

- ソースコードやHTMLタグの除去

- URLの除去

- 全角・半角記号の除去

- 重複箇所の除去

- その他、不要箇所の除去

- 「てにをは」「ですます」…etc.ストップワードの除去

以上のとおり。必要なのは時間です。

正規化

生のデータにはたいてい、単位や表記のブレが含まれています。このブレを値の幅や平均値をそろえることで、なくす前処理が「正規化」です。こちらも自然言語を扱うRAGの場合は、シンプルで……

- 文字種(ひらがな / 全角カナ / 半角カナ / 漢字)の統一

- つづりの統一

- 表記揺れの統一

- 固有名詞の表記の統一

- 引用しない数字(日付 / 金額…etc.)を「0」に置き換える処置

といった処理のみで完結します。

エンベディング

自然言語をAIモデル内で数学的に扱えるようにするには、文字データを数値データに変換する前処理が必要です。この前処理全般のことをエンコーディングといいます。

このエンコーディングのなかでも、RAGに欠かせないのが「エンベディング / Embedding」です。エンベディングは、文脈・意味を保ったまま文字データをベクトルデータに変換する技術で、ベクトルデータベースの構築に用いられます。

アノテーション

データに説明・注釈のタグを添えて分類を行う「アノテーション」も、RAGで用いられる前処理のひとつです。RAGにおけるアノテーションは……

- テキストの種類による分類(メール文 / 企画書 / 論文…etc.)

- テキストの内容・トピックによる分類

といった作業になります。

なお、データセットの作り方について詳しく知りたい方は、下記の記事もあわせてお読みください。

RAG実装用のツール2選

続いては前処理の次の工程、RAG実装時に欠かせないツールを紹介していきます。今回紹介するのは……

- LangChain

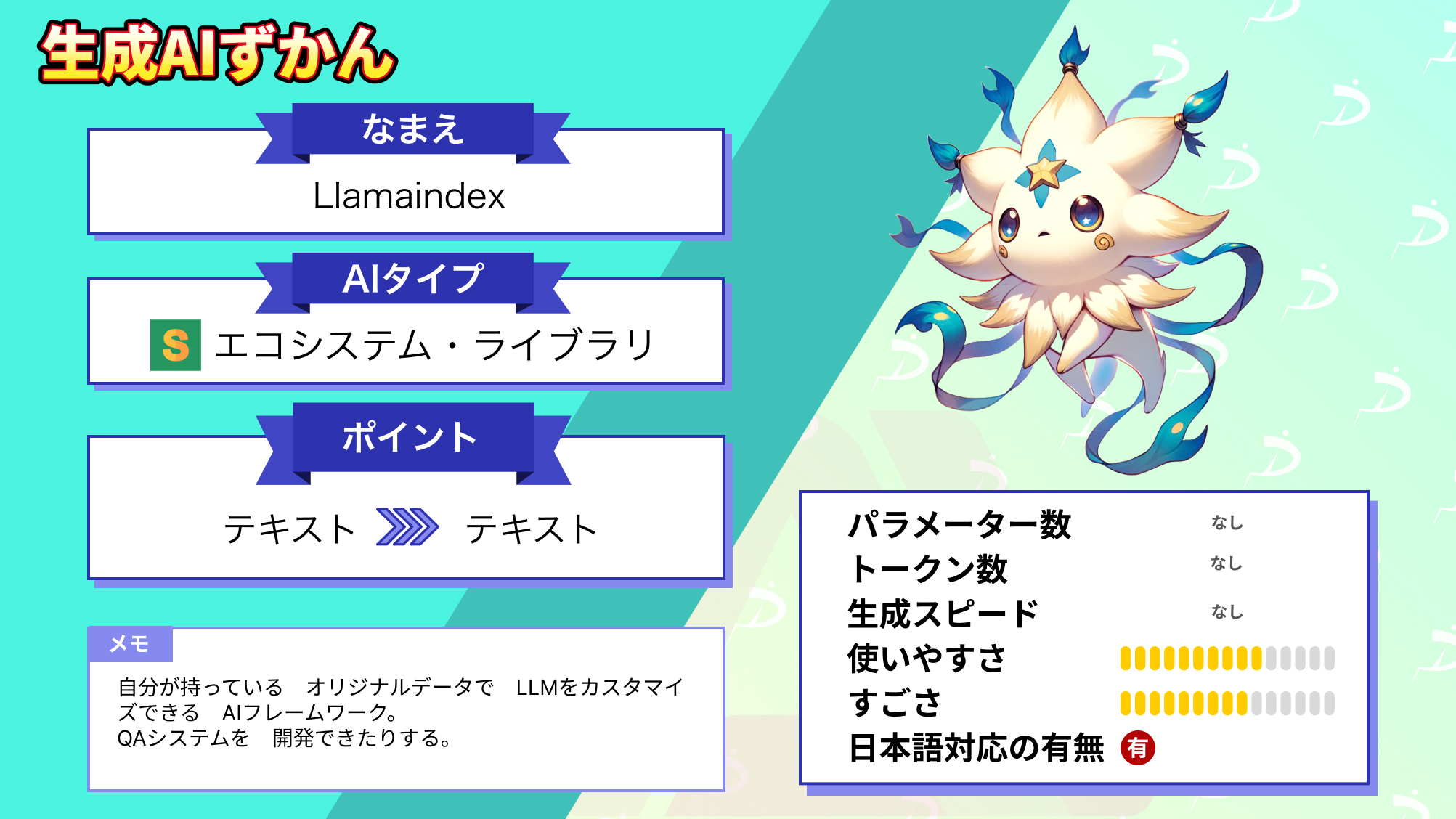

- Llamaindex

以上の2つで、ともにPythonで扱えるのが魅力です。

まずは、デモンストレーションでも登場したLangChainから、詳細をみていきましょう!

LangChain

「LangChain」はLLMと外部リソース(データベース / 言語処理…etc.)を連携させるためのツール。PythonやJavaScript等で使えるライブラリの形式をとって、無償で一般公開(MITライセンス)されています。

このLangChainの機能としては……

- Models:LLMやその他AIモデル同士の連携

- Indexes:外部データベースとの連携

- Prompts:プロンプト・ソースコードのテンプレート設定

- Memory:会話内容の記憶

- Chains:処理フローのブロック化

- Agents:複数ツールの連携

以上のとおりで、RAG以外にも広く応用できてしまいます。

公式サイト:LangChain

なお、LangChainについて詳しく知りたい方は、下記の記事もあわせてお読みください。

Llamaindex

対して「Llamaindex」は、RAGの実装に特化したPython & TypeScript用のライブラリです。こちらはLLMと……

- ベクトルデータベース

- テキスト

- PDF

…etc.

以上、外部データとの連携が可能。LangChain同様、無償で一般公開(MITライセンス)されています。

公式サイト:LlamaIndex

なお、Llamaindexについて詳しく知りたい方は、下記の記事もあわせてお読みください。

RAGの要件定義で重要な3つの点

RAGの要件定義にあたっては……

- 前処理の手法

- 検索ロジックの組み方

- 使用するLLMの種類

の3点を、お客様からいただいたユースケースに合わせて柔軟に対応することが重要です。特に、前処理手法を決める際には、入手できるテキストの種類を把握することが適切な前処理方法を選定するための基盤となります。ここからは、以上3つの要件定義のポイントについて、順番にみていきましょう!

前処理の手法

RAG用のデータを用意するにあたって、前処理が重要なのは先述のとおりです。

ただ、「徹底的に前処理をすればよい」というのは間違い。要件に応じて適切な前処理の手法を選ばなくてはいけません。具体的には……

- テキストの種類による分類:特定のフォーマット・文体を指定して生成させる場合に最適

- テキストの内容・トピックによる分類:Q&Aやナレッジ共有用のチャットボットに最適

- 数字の置換:日付や金額を正しく引用させたい場合は不向き

- ストップワードの除去:副詞 / 助詞 / 接続詞 / 助動詞 / 連体詞…etc.のうち何をストップワードとするかは要件次第

というふうに、手法ごとに向き不向きがあります。

検索ロジックの組み方

RAGシステムでは「近似最近傍探索」という手法のもと、ベクトルデータベースから質問と意味の近いデータのみが取り出されます。

この近似最近傍探索についても、さまざまな検索ロジックが派生していますので、要件に適したものを選ぶ必要があります。なかでも代表的な検索ロジックは……

- Hierarchical Navigable Small Worlds(HNSW)アルゴリズム

- 転置ファイルシステム(IVF)アルゴリズム

この2点。それぞれの概要・メリット・デメリットは下表のとおりです。

| HNSWアルゴリズム | IVFアルゴリズム | |

|---|---|---|

| 概要 | 大きな分類から階層順に、目当ての情報を絞り込んでいくアルゴリズム | あらかじめ似ているデータ同士をまとめておいて、検索性を高めるアルゴリズム |

| メリット | ・検索速度に優れる | ・検索速度に優れる ・HNSWアルゴリズム比で省メモリ |

| デメリット | ・メモリ消費量が多い | ・HNSWアルゴリズム比で検索精度に劣る |

また、検索ロジックのほかに……

直積量子化(PQ)ベクトル圧縮:検索精度と引き換えにメモリ消費量を抑える手法

以上を採用するか否かも検討材料です。それぞれ、データのサイズや設備に応じて選ぶのがベストでしょう。

使用するLLMの種類

RAGの要であるLLMもユースケースに合わせて下記の2種類から選べます。

- クローズドソースのLLM

- オープンソースのLLM

それぞれのメリット・デメリット・代表例は……

| クローズドソースのLLM | オープンソースのLLM | |

|---|---|---|

| メリット | ・高精度 ・マルチモーダルモデルの選択肢が充実 | ・小型で、ローカル環境・オンプレミスでも動作可 ・無料で使える |

| デメリット | ・API料金がかかる | ・精度が低い ・マルチモーダル |

| 代表例 | ・ChatGPT APIの各モデル ・Google Gemini APIの各モデル ・Claude APIの各モデル | ・Meta Llamaシリーズ ・Stable LMシリーズ …and more |

以上のとおり。こちらも社内設備に合わせて選びましょう。

弊社のRAGを使った開発事例3選

エネオス

PRAP

エクソル

なお、〇〇について詳しく知りたい方は、下記の記事もあわせてお読みください。

弊社のAIツール導入・活用支援について

弊社・株式会社WEELのサービス「AIツールの導入支援・活用促進」では、お客様のAIツール導入から活用までを、一気通貫でサポートしています。AIツールの導入にあたって、お客様が直面しうる

● どんなAIを使えばいいのか?

● うちには何が合うのか?

● 生成AIツールが多すぎて、わけがわからない

● ChatGPT公式や無料AIツールで、解決できないか?

● 一度入れてみたけれど、業務に合わなかった……

といったお困りごとを、弊社スタッフが伴走しながら解決いたします。詳しい内容や料金につきましては、下表をご覧ください。

| AIツールの導入支援・活用促進 | |

|---|---|

| 期間 | 2〜4ヶ月 |

| 内容 | ・要件定義 ・改善案提出 ・新業務フロー図の作成 ・導入支援・ツールの設定 ・サポート |

| 見積もり額 | ¥ 2,400,000 ~ 4,800,000 ※対象規模により変動 |

「うちにもAIツールで自動化できる業務があるのでは……」と気になった場合は、ぜひ無料相談で、貴社のお困りごとをお聞かせください。「有料より良い無料ツールはないか」なども含めて、弊社の知見を共有させていただきます。

→無料相談で話を聞いてみる

RAGの精度を高めたいなら「前処理」は必須!

当記事では、RAGの精度を高めるデータの「前処理」について紹介しました。RAGにおける前処理のメニューは……

● データクレンジング:記号の削除 / 重複箇所の削除…etc.で引用しない箇所を除く

● 正規化:表記揺れの統一 / 不要な数字の置換…etc.で文章の形を整える

● エンベディング:文章を文脈を保ったままベクトルに変換する

● アノテーション:文章の内容を分類してタグ(注釈)をつける

以上のとおり。RAGと前処理を駆使すれば、1世代前のGPT-3.5 Turboであっても……

今回紹介したLLaVA-1.5は、オンプレミスでも利用可能な小型のLLMです。その他にも、同様にオンプレミスで使えるおすすめの小型LLMとしては、StableLM 2 1.6BやPLaMo-13Bが挙げられます。これらのモデルは、日本語や英語に特化しており、高い精度で対話や文章生成ができると評判です。ぜひお試しください!

ここまでの回答が実現します!

そんなRAGのシステムを企業で開発する際に大切なのは要件定義。「前処理の手法検索」「ロジックの組み方」「使用するLLMの種類」の3点を用途に合わせる必要があります。

ということで、高精度な生成AIチャットボットを開発したい方はぜひ、前処理にもこだわってみてください!

最後に

いかがだったでしょうか?

GPT-3.5 Turboの最新アップデートで、より高速かつ低コストでのAI活用が可能になりました。自社での導入・活用を検討する際に、最適なモデル選定や活用方法について、一緒に考えてみませんか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。