【無料も可】今から始める画像生成AI「Stable Diffusion」の使い方!プロンプトのコツや活用事例を初心者向けに解説

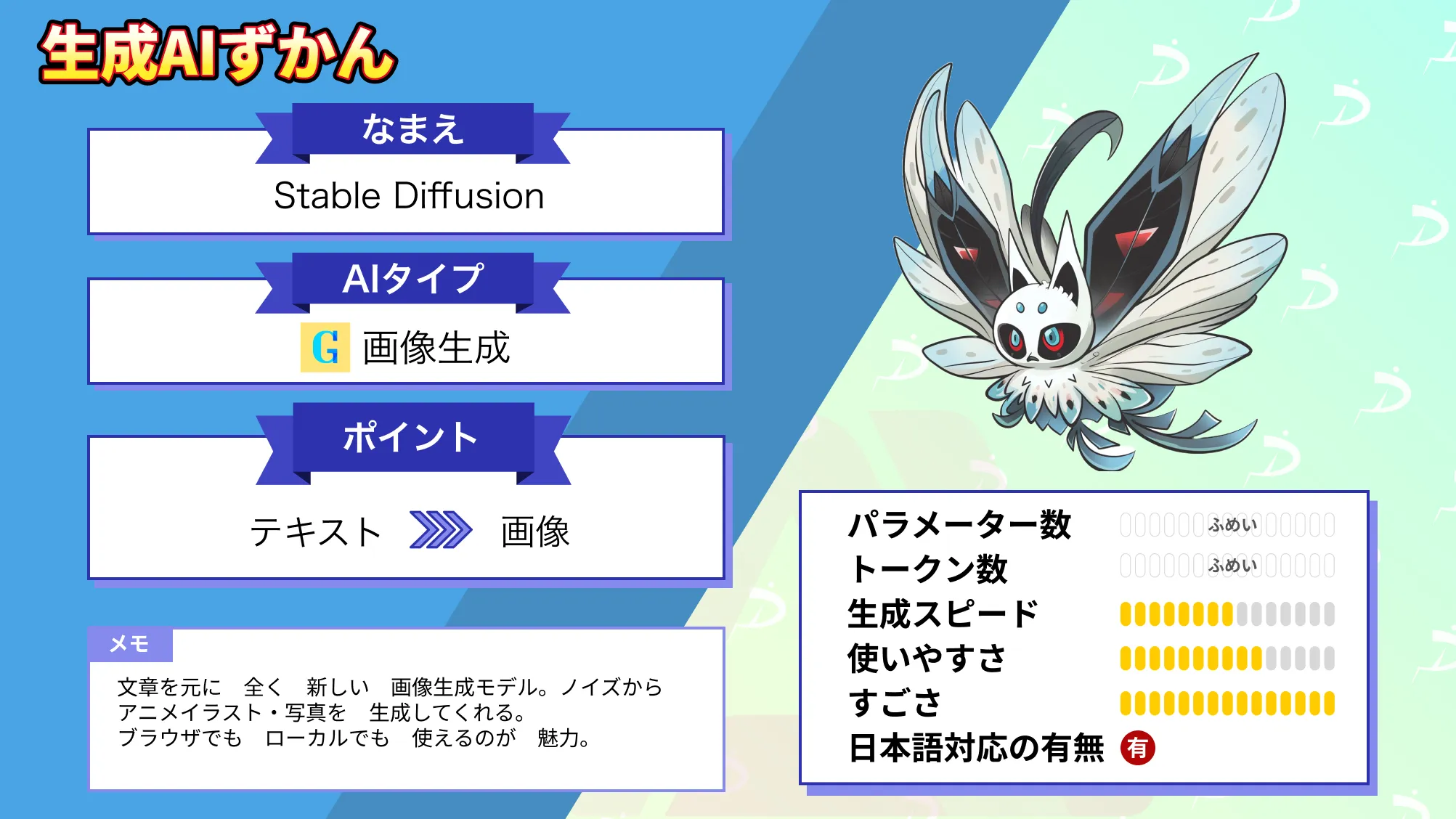

Stable Diffusionは、入力されたテキストや画像を基に、自動で新しい構成の絵を生み出す画像生成AIです。リリースからたったの一年で1,000万以上のユーザーを集め、約6億9,000万枚もの画像を生成してきた、人気のオープンソースソフトウェアなんです!※1

2023年11月17日には、日本に特化した「Japanese Stable Diffusion XL」も登場し、日本での話題はさらに盛り上がる一方です。

この記事ではStable Diffusionの特徴から利用手順まで網羅し、5分後には生成画像を作れるくらいわかりやすい形でまとめました。ぜひ記事の最後まで目を通してみてください。

\生成AIを活用して業務プロセスを自動化/

画像生成AIとは?

画像生成AIとは、ユーザーが入力したテキストを基に、AIがオリジナルの画像を自動生成する技術のことです。例えば、AIに「海辺を散歩する女性」などと指示すると、それに合った画像をAIが自動で作ってくれるというものです。

代表的な画像生成AIには、今回ご紹介する「Stable Diffusion(ステーブルディフュージョン)」や「Midjourney(ミッドジャーニー)」があり、デザイン業界の常識を覆す存在として注目を浴びています。

知識も技術も必要とせずにハイクオリティな画像を生成できることは多くのユーザーにとって大きなメリットである一方、クリエイターやカメラマンにとっては少なからず脅威と認識されており、画像生成AIは今後のデジタルクリエイティブに大きな影響を与える存在となっています。

Stable Diffusionとは?

Stable Diffusionは、入力されたテキストや画像を基に、先進的なアルゴリズムである「深層拡散モデル」を使用して独自の生成画像を生成するAI技術です。

そのすごいところを簡単にまとめました。

● プロンプトを元に、ノイズから画像を描画

● テキストだけで全く新しい画像が生成可能(Text-to-Imageモデル)

PhotoshopやCanvaのレイヤー透過で無数の画像をかけ合わせていくと最後は判別不能なノイズとなるのですが……その逆処理が深層拡散モデルなんです!

具体的にはプロンプトの命令文に沿ってAIがノイズ除去の制御を行うため、既視感を持ちながらも全く新しい画像が出力できます。

Stable Diffusion XLとは

「Stable Diffusion XL(SDXL)」は、2023年に発表された新モデルです。2002年にリリースされたStable Diffusionと比較して機能が大きく進化し、高品質の画像生成が可能になりました。

さらにSDXL1.0は、Stable Diffusionの最新画像生成AIモデルです。開発されたモデルの中でも最高の品質を誇り、他の画像生成AIとの比較テストにおいても高い評価を受けています。

Stable Diffusion 3.5の発表

2024年10月にStability AIから、最新画像生成AIモデルの「Stable Diffusion 3.5」が発表されました。

前バージョンであるStable Diffusion 3からのフィードバックを基に改良されており、高いカスタマイズ性や多様なスタイルと出力などが特徴です。

最新モデルではプロンプトの解釈力と生成精度が大幅に向上し、特にクロスアテンション機能が改良されたことで、テキストの細かなニュアンスを正確に画像に反映できるようになりました。

さらに、新しいノイズ抑制技術により、複雑な構図や具体的な指示を含むプロンプトでも期待通りの結果を得ることができます。

なお、Stable Diffusion 3.5について詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusionの料金は無料?

Stable Diffusionは基本無料で使えます。ブラウザ版・ローカル環境の2種類ありますが、課金する場合はブラウザ版のみとなります。下記3つのブラウザ版は無料版もありますが、有料での利用も可能です。(※6、7、8)

| Stable Diffusion Online | Pro:月額7ドル(月2000回まで&商用利用可) Max:月額14ドル(月4000回まで&商用利用可) |

|---|---|

| Dream Studio | 10ドル/1000回生成 |

| Mage.space | Basic:月額10ドル(生成速度2倍&LoRAと全モデルへのアクセス…etc.) Pro:月額25ドル(生成速度4倍&LoRAの追加機能…etc.) Pro Plus:月額50ドル(カスタムモデルのインポート…etc.) |

- ローカル環境(無料):無料で使えるが、ハイスペックなパソコンが必要

- ブラウザ版(無料):無料で使えるが、機能や枚数に制限がある

- ブラウザ版(有料):有料にはなるが、環境に関係なくある程度自由に使える

このようなイメージです。

なお、ローカル環境向けのWeb UIモデルについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusionのライセンス

Stable DiffusionではCreativeML Open RAIL M Licenseのもと、商用利用・モデル配布等が許可されています。具体的には……

| 商用利用 | ⭕️ |

|---|---|

| 改変 | ⭕️ |

| 配布 | ⭕️ |

| 特許使用 | ⭕️ |

| 私的使用 | ⭕️ |

以上のとおりです。派生モデルの配布時には、ライセンス全文のコピーを添える必要があります! ご注意ください。

Stable Diffusionの特徴3つ

Stable Diffusionの特徴は大きく分けて3つあります。

- リアル調からアニメ調まで画像生成が可能

- ブラウザ&ローカル環境にて無料で使える

- 商用利用も部分的に可能

それぞれの内容について、わかりやすく解説します。

リアル調からアニメ調まで画像生成が可能

上記は筆者が「Cute dog」で生成した犬の画像。

Stable Diffusionはリアルな人物像からアニメ風の美少女まで、多岐にわたる画像を生成できます。リアル調は映画のVFXやCG技術並の美しさを誇り、遠目から見れば現実と虚構の見分けがつかないほど精密な作りです。

アニメ調は流行りのグラデーションを用いており、イラストレーター風から平坦なVtuber風の色合いまで幅広く対応しています。Stable Diffusionが画像生成AIの中で人気な理由も、リアル調からアニメ調まで1つの技術で網羅できるからです。

ブラウザ&ローカル環境にて無料で使える

Stable DiffusionはWebブラウザもしくはローカル環境で無料で使うことが可能。ブラウザ上でStable Diffusionを使うメリットとしては、所有しているパソコンのスペックを問わず使用できること・特別な準備を必要とせず、すぐにStable Diffusionをブラウザ上で使えることです。

Stable Diffusionをブラウザで使う方法は、この後のWebブラウザ編で詳しく解説をします。

また、ローカル環境でもStable Diffusionは使えます。ローカル環境でStable Diffusionを使うメリットは完全無料で利用可能・生成枚数に制限なし・プロンプト制限なし・最新機能が試せるなどです。

より自由度の高い画像生成を行いたい場合にはローカル環境でStable Diffusionを使うのがおすすめ。この後の【ローカル編】では、ローカル環境でStable Diffusionを構築する方法をお伝えします!

さまざまな便利オプションを利用できる

ブラウザでStable Diffusionを使う場合に比べて、ローカルでStable Diffusionを使うと、扱えるオプションが増えます。一部ブラウザ版でもオプションを使うことができますが、ローカルでStable diffusionを使うよりも自由度は下がります。

画像入力が可能な点

例えば、ローカルでStable Diffusionを構築するとimg2imgの機能を使って、画像から画像を生成できます。後述するReimagine XLに近い機能ですが、img2imgの方が細かくプロンプトを指定できます。

高画質化が可能な点

また、ローカル環境ではHires.fixやExtrasも使うことができるため、生成画像の高画質化を行えます。より高画質の画像を生成したい場合にはローカル環境でStable Diffusionを使うのがいいかもしれません。

拡張機能などの点

高画質化に類似しますが、ブラウザ版のStable Diffusionでは拡張機能が乏しく、自由度が低いです。画像の高画質化もその一つです。

他にも生成画像の手や足、顔などを自動で検知して修正してくれるADetailerやイラストの細かい描写を可能にするControlNetもローカルで拡張機能を使うことで利用できるようになります。

Stable Diffusionは商用利用も可能

Stable Diffusionでは、ユーザーが生成したAI画像の商用利用を認めています。

生成された画像について権利を主張しないと公式に発表しており、間違った使い方をしない限り、Stable Diffusionで作成した画像を商用利用可能です。

商用利用する場合の注意点

ただし、全ての生成されたAI画像について商用利用が許可されているわけではありません。※2.※3

著作権フリー素材に関しても、利用する際には細かい区分けがあるため注意が必要です。

- 全て放棄

- 営利目的は不可

- 改変可能、ただし報告必須

- 改変不可

- 出典明記義務

- 利用可能、ただし報告必須

- 二次配布禁止

Stable Diffusionは元画像を元にして新たな絵を作り出す技術です。4番目の「改変不可」が記述されているサイト、または画像はStable Diffusionで利用できません。

そしてStable Diffusionを利用してAI画像を生成する際に使用された画像データが、著作権を侵害しているとわかった場合、生成された画像データは商用利用できません。

具体的な例として、大手ブランドショップのロゴ、スポーツ選手やハリウッドスターのバストアップ写真などが挙げられます。ネットで見つけた画像を読み込ませて生成した画像が、実は著作権を侵害していた場合、損害賠償請求を受ける可能性があります。

Stable Diffusionを使用して商用利用可能な画像を作成したい方は、著作権問題に発展しないようにフリー素材や商用利用が許可されている画像を用いてください。

\画像生成AIを商用利用する際はライセンスを確認しましょう/

他の画像生成AIとの違い

Stable Diffusionは、他の画像生成AIと比べていくつかの特徴があります。ここでは、他の画像生成AIとの違いを説明します。

| サービス名 | 費用 | 作成枚数 | 商用利用 |

|---|---|---|---|

| Stable Diffusion | 無料(PC版) | 無制限 | 可能(モデルによる制限あり) |

| Midjourney | 有料(月額約10ドルから) | 無制限(ただし有料プラン内で) | 可能 |

| Canva | 無料プランあり(有料プランあり) | 制限あり(プランによる) | 可能(素材による制限あり) |

| Adobe Firefly | Adobe Creative Cloudに含まれる | 制限あり(プランによる) | 可能 |

| DALL-E | 有料(クレジット制) | 制限あり(クレジットによる) | 可能(条件付き) |

Stable Diffusionと各種画像生成AIの比較

- 費用面での違い

- Stable Diffusionは基本的に無料で使用可能

- 多くの他のAIは有料サービスか利用回数に制限がある

- PC版なら誰でも画像生成が可能

- 作成枚数の制限

- Stable Diffusionは作成枚数に制限なし

- 他のAIサービスでは枚数制限がある

- 所有権に関する違い

- Stable Diffusionで生成した画像には基本的に権利が発生しない

- 人に悪影響を与えない内容なら自由に使用可能

- ほとんどの場合、商用利用も認められている

- 使いやすさ

- キーワード入力だけで高品質な画像生成が可能

- 絵を描くスキルがなくても作品作りできる

Stable Diffusionは無料で使えて、作品の権利も自由度が高いのが特徴ですが、注意すべき点もあります。学習モデルによってはライセンスの問題で商用利用ができないケースもあるので、事前にはライセンス条項を必ず確認しましょう。

Stable DiffusionハイスペックなPC不要!

Stable Diffusionは、一般家庭にあるPCでも十分に動作する画像生成AIで、他のツールと比べると驚くほど低スペックで利用できるのが特徴です。

基本的な動作環境として、CPUはIntel Core i5以上、メモリは8GB以上あれば問題なく使えます。グラフィックボードは、NVIDIA GeForce GTX 1060 6GB相当以上があると快適に動作するでしょう。グラフィックボードがなくてもCPUのみで動かすことも可能ですが、その場合は処理速度が遅くなりますが、使用することはできます。

ストレージに関しては、Stable Diffusion本体とモデルデータを合わせて20GB程度の空き容量があれば十分でしょう。OSは、Windows 10/11、macOS、Linuxでも動作します。より高性能なPCを使えば、画像生成の速度が上がり、より大きなサイズの画像を作成できます。

画像生成を始めるためのハードルが低く設定されているのが、Stable Diffusionの魅力の一つと言えるでしょう。

Stable Diffusionの使い方とメリット

Stable Diffusionの使い方は2通りあります。

- ブラウザ環境で使う

- ローカル環境で使う

ブラウザを介してWebアプリケーションとして利用できるほか、PCにダウンロードしてローカル環境で実行も可能です。

生成AIやプログラミング言語に慣れてない方は、ブラウザからStable Diffusionに接続するのがおすすめです。ただしブラウザ利用は枚数制限と課金要素があり、自由度が低いため注意してください。

一方で、ハイスペックなゲーミングPCや動画編集に対応したPCを所有している方にはローカル環境(Stable Diffusion Web UI)がおすすめです。ローカル環境では、ブラウザ経由の利用では制限されていた機能が解除され、無料かつより高度な画像生成が可能です。

どちらにも一長一短のメリット・デメリットがあります。一度もAI技術に触れたことがない方やStable Diffusionに興味を持っている方は、無料で利用できるブラウザ版の利用から始めるのがおすすめです。

ブラウザ環境で使うメリット

ブラウザ上でStable Diffusionを使うメリットとしては以下の2点が挙げられます。

- 所有しているパソコンのスペックを問わず使用できる

- 特別な準備を必要とせず、すぐにStable Diffusionを使える

1つずつ解説します。

所有しているパソコンのスペックを問わず使用できる

ブラウザ上でStable Diffusionを利用する際、ユーザーが所有しているパソコンの性能は特に関係ありません。

これは、画像生成の処理がクラウド上の高性能なサーバーで行われるためです。その結果、低スペックのパソコンやGPU非搭載のデバイスでも高品質な画像生成を体験できます。

一方、ローカル環境でStable Diffusionを使用する場合、高度な画像処理能力が求められ、ハイスペックなパソコンが必要となります。

ブラウザ環境での利用は、ハードウェアの制約を気にせず誰でも手軽に画像生成を楽しむことができる点で優れています。

特別な準備を必要とせず、すぐにStable Diffusionを使える

ブラウザ環境でのStable Diffusion利用は、ソフトウェアのインストールや複雑な設定が不要です。

ユーザーはインターネット接続とWebブラウザさえあれば、すぐにサービスを利用開始できます。技術的な知識がなくても、簡単に画像生成を試すことが可能です。

一方、ローカル環境での利用には、Pythonや関連ツールのインストール、環境構築などの手間がかかり、初心者にとってはハードルが高い場合があります。

ブラウザ環境での利用は、こうした準備の手間を省き、迅速かつ簡単にStable Diffusionの機能を体験できる点が大きなメリットです。

Stable Diffusionをブラウザで使う方法は、この後のWebブラウザ編で詳しく解説をします。

ローカル環境で使うメリット

ローカル環境でStable Diffusionを使うメリットは主に以下の4つです。

- 完全無料でさまざまな便利オプションを利用できる

- 生成枚数&プロンプトに制限なし

- 画像入力&高画質化が可能

- 最新機能が試せる

1つずつ解説します。

完全無料でさまざまな便利オプションを利用できる

ローカル環境でStable Diffusionを使用する最大の利点は、完全に無料で利用できることです。また、AUTOMATIC1111版などのWeb UIを導入することで、テキストからの画像生成(txt2img)や画像からの画像生成(img2img)、画像の一部を修正するInpainting/Outpaintingなど、多彩な機能を活用できます。

他にも、生成画像の手や足・顔などを自動で検知して修正してくれるADetailerや、イラストの細かい描写を可能にするControlNetもローカルで拡張機能を使うことで利用できるようになります。

このような拡張機能を追加することで新たな機能やカスタマイズが可能となり、ユーザーのニーズに合わせた柔軟な操作が可能です。

一部ブラウザ版でもオプションを使うことができますが、ローカルでStable diffusionを使うよりも自由度は下がります。

生成枚数&プロンプトに制限なし

ローカル環境での利用は、画像生成の枚数やプロンプト入力に一切の制限がありません。

クラウドサービスやオンラインツールでは無料プランでの使用回数や生成枚数に制限が設けられていることが多いですが、ローカル環境ではそのような制約がなく、思う存分画像生成を行えます。

試行錯誤を重ねながら理想の画像を追求することが可能となるので、企業利用や商用利用を考えている方にとって非常に大きなメリットと言えますね。

画像入力&高画質化が可能

ローカル環境でStable Diffusionを構築すると、img2imgの機能を使って画像から画像を生成できます。後述するReimagine XLに近い機能ですが、img2imgの方が細かくプロンプトを指定できます。

また、ローカル環境ではHires.fixやExtrasも使うことができるため、生成画像の高画質化も行えます。画像のスタイル変更や細部の修正、高解像度化が容易に行え、プロフェッショナルな品質の成果物を得ることができます。

より高画質の画像を生成したい場合には、ローカル環境でStable Diffusionを使うのがおすすめです。

最新機能が試せる

ローカル環境での利用は、Stable Diffusionの最新バージョンや新機能、拡張機能をいち早く試すことが可能です。

オープンソースとして公開されているため、コミュニティによる最新の開発やアップデートを即座に取り入れ、自身の環境に適用できます。

常に最新の技術や機能を活用し、画像生成の幅を広げることができる点は大きなメリットと言えるでしょう。

より自由度の高い画像生成を行いたい場合には、ローカル環境でStable Diffusionを使うのがおすすめです。この後の【ローカル編】では、ローカル環境でStable Diffusionを構築する方法をお伝えします!

Stable Diffusionはスマホでも使える!

スマホでもStable Diffusionを使えるサービスがいくつかあり、iPhoneやAndroidでも無料で画像生成が可能になっています。

以下が、初心者の方でも簡単に試せる4つのサービスです。

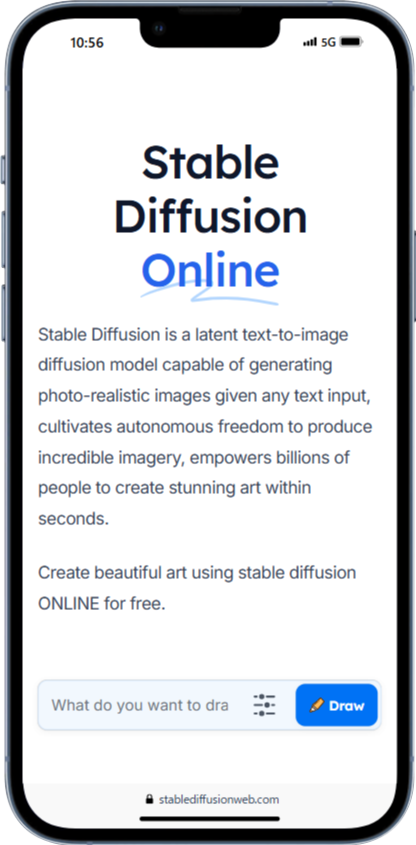

- Stable Diffusion Online

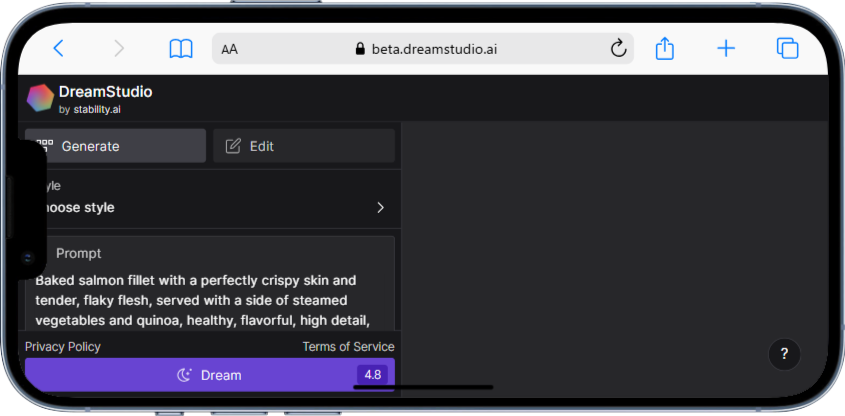

- DreamStudio

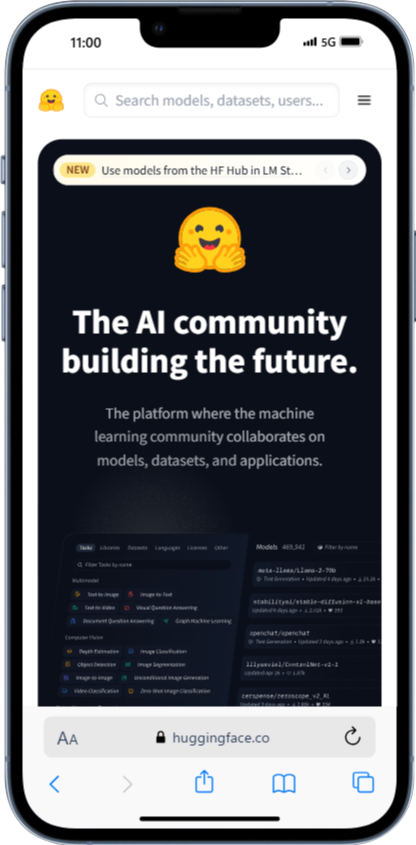

- Hugging Face

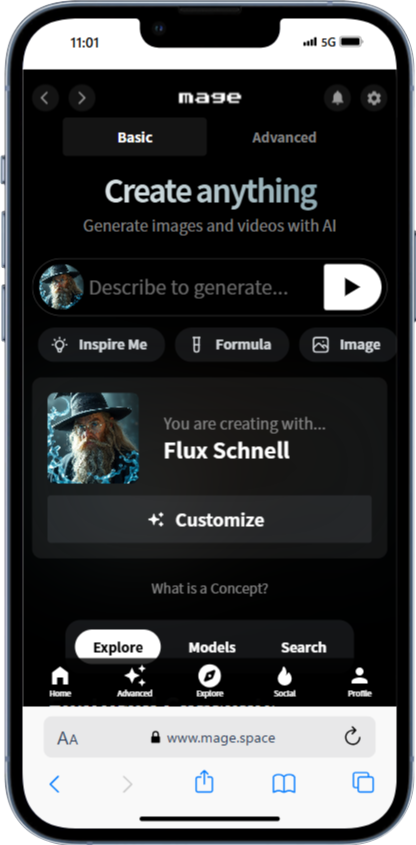

- Mage.space

Stable Diffusion Onlineは、ブラウザ上で動作するので、スマホからもアクセスできます。画面上部の入力欄にプロンプトを入力し、「Draw」ボタンをタップするだけで画像が生成されます。無料版では画像に透かしが入るので注意が必要です。

DreamStudioもスマホのブラウザから利用可能なサービスの一つで、アカウント登録後、画面中央の「Prompt」に指示を入力して画像を生成します。画面下部のスライダーで画像サイズや生成数を調整も可能です。初回は無料クレジットがもらえるので、気軽に試せるでしょう。

Hugging Faceは、多くのAIモデルを試せるプラットフォームです。スマホからアクセスし、「Stable Diffusion」で検索すると、さまざまなバージョンが見つかります。使いたいモデルを選び、プロンプトを入力して「Run」をタップすれば、画像が生成されます。他のサービスより少し手順は多いですが、多くのモデルを試せる点が魅力です。

Mage.spaceは、シンプルな操作が特徴のサービスです。スマホのブラウザからアクセスして画面中央の入力欄にプロンプトを入力、右側の矢印アイコンをタップするだけで画像生成が始まります。無料版でも高品質な画像が生成できるので、初心者の方におすすめです。

なお、弊社のStable Diffusion導入支援サービスについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

【Webブラウザ編】Stable Diffusionの使い方4選!

Stable Diffusionは2025年7月11日時点で7つのブラウザ版があります。

- Clipdrop

- Hugging Face

- Dream Studio

- Mage.space

- Stable Diffusion Online

- Fotographer.ai

- romptn Image Generator

まずは最も有名なClipdropの使い方から説明します。

Clipdropでの使い方基礎

Clipdropは3つの方法で画像を生成できます。

- Stable Diffusion XL

- Reimagine XL

- Stable Doodle

まずは王道のプロンプト記述で画像を生成する「Stable Diffusion XL」からお伝えします。

Stable Diffusion XL

Stable Diffusion XLはプロンプト(指示)を出して、AI画像を生成する方法です。指示出しが細かくできる方法のため、生成画像の出来にこだわりたい方におすすめ。対応している指示言語は英語のみでしたが、2023年11月17日より「Japanese Stable Diffusion XL」として日本語対応版もリリースされました。

ただし、2023年11月21日から有料化されたため、現在は無料版の利用ができません。ブラウザ版を使いたい方は、1ヶ月または1年の有料課金が必要です。

Reimagine XL

Reimagine XLは画像をアップロードして、類似した画像をAIで生成する方法です。3つの方法の中では、最も手軽なため初心者におすすめの手法です。

フリー画像サイトで取得した画像、ご自身の手元にある写真、オリジナルで描いた絵をアップロードすると、Stable Diffusionが自動で変換してくれます。

ただしStable Diffusion XLやStable Doodleとは違い、細かい指定ができません。AIが生成した画像を出力するだけなので、こだわりたい方には不向きです。

Stable Doodle

Stable DoodleはStable Diffusion XLより直感的な手法です。スケッチしたラフ絵を元に、ご自身が描いた絵の内容をプロンプトで説明し、AIで生成させます。生成する際もピクセルアート、3D、写真、ファンタジーなど複数の描き方から選べます。

※Stable DoodleはStable Diffusion XLと同じく、すでに有料化されてしまっています。

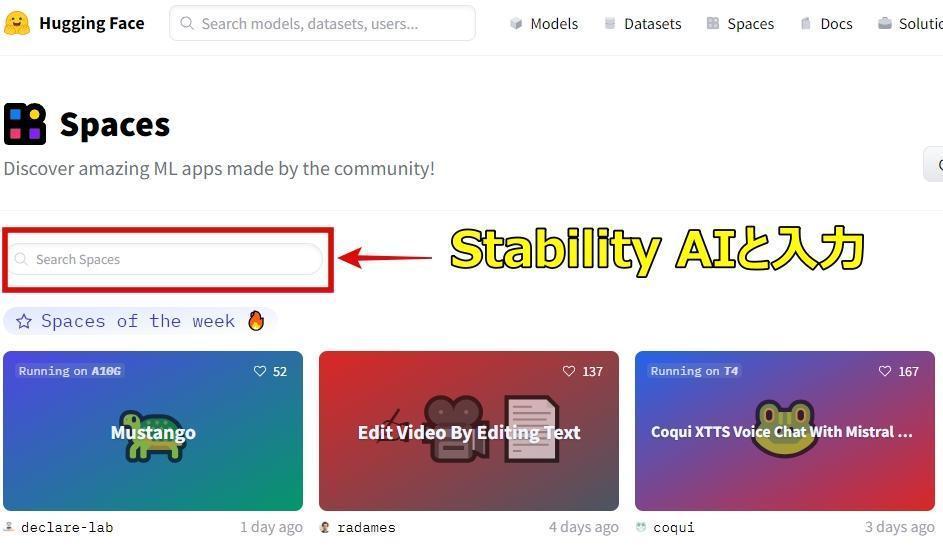

Hugging Faceでの使い方基礎

Hugging Faceの使い方は簡単です。

- Hugging Face(https://huggingface.co/spaces)にアクセス

- 検索窓に「Stability AI」と入力

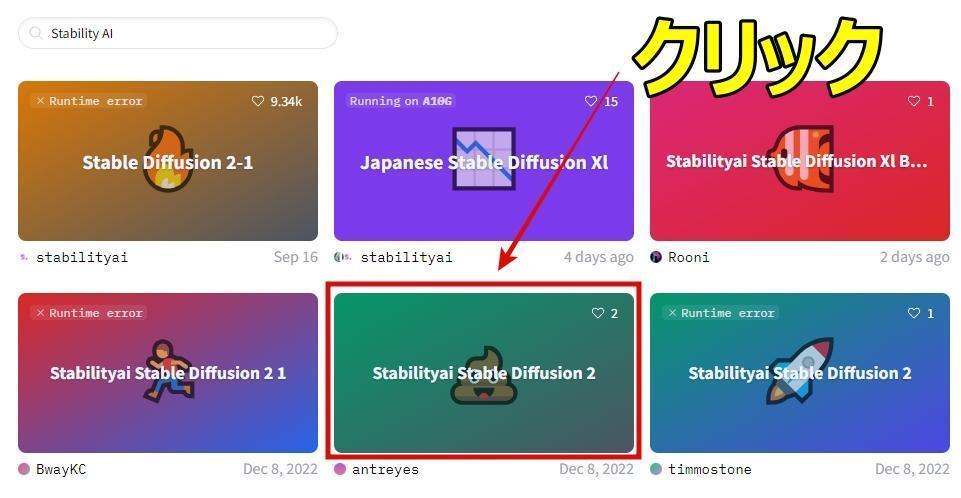

- 「stable-diffusion-2」を探す

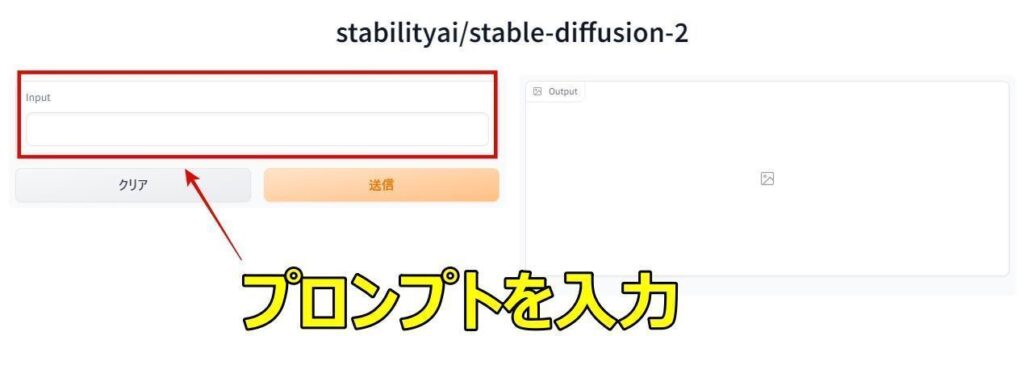

- Inputの箇所にプロンプトを英語で記述

- 送信ボタンを押す

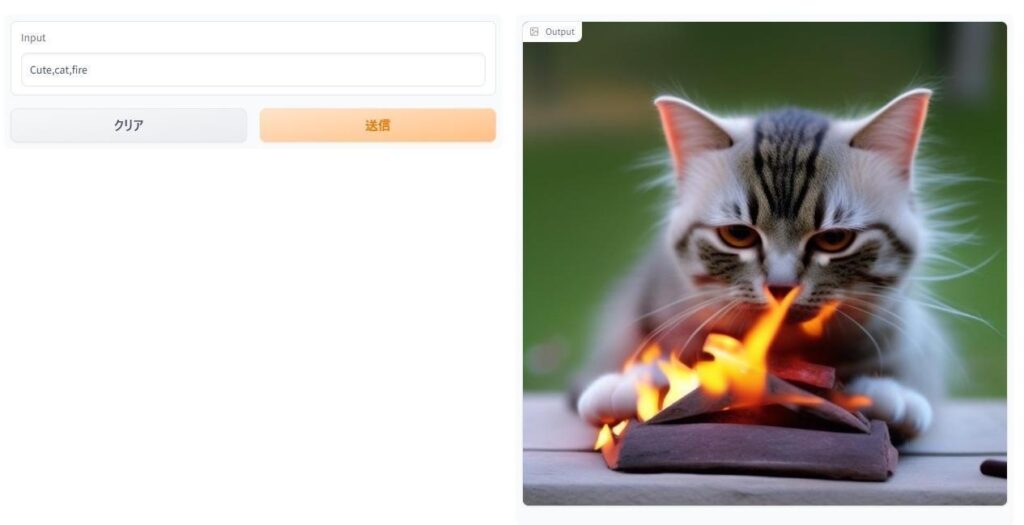

上記手順で画像が自動で生成されます。実際に上記手順に従い、画像を自動生成する流れを示します。詳しい利用方法は画像を使いながらご説明します。

1:Hugging Faceのトップページを開き、検索窓にStability AIと入力

2:stable-diffusion-2のアイキャッチをクリック

3:Inputの箇所にプロンプトを英語で記述

4:プロンプトを送信したら自動で画像が生成される

Dream Studioでの使い方基礎

DreamStudioはStable Diffusionのオープンβ版として公開されたサービスです。

使い方も簡単で、以下の手順を踏んでください。

- DreamStudioにアカウントを作ってログイン

- 画像生成のスタイルを選択

- プロンプトを入力

- ネガティブプロンプトを入力

- イメージ画像をアップロード

- 解像度の調整

- 生成枚数や大きさなど微調整

- 所持クレジットを消費して画像を生成

複雑なように見えますが、一連の手順自体は簡素です。一度操作に慣れれば、簡単に感じられるでしょう。ここからは、分かりやすいように画像を用いて利用方法をご紹介します。

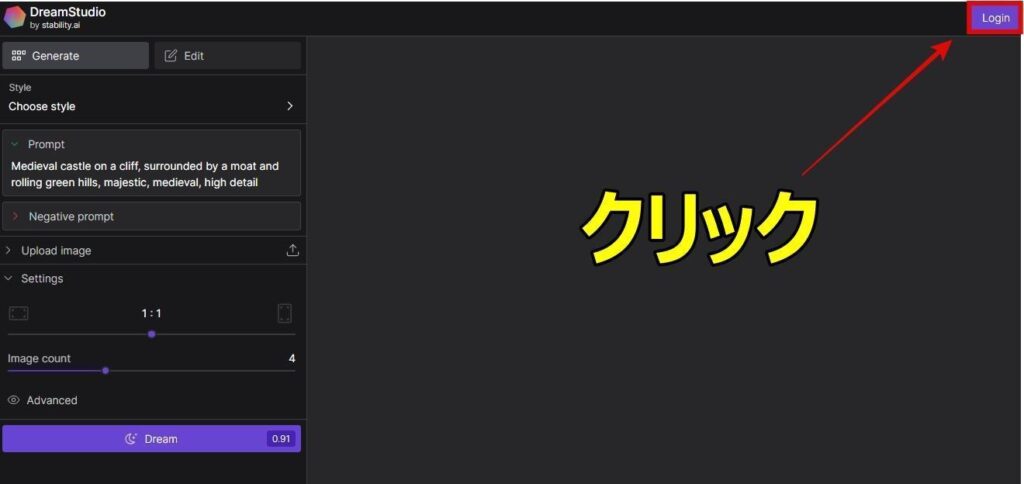

1:DreamStudioトップページに遷移

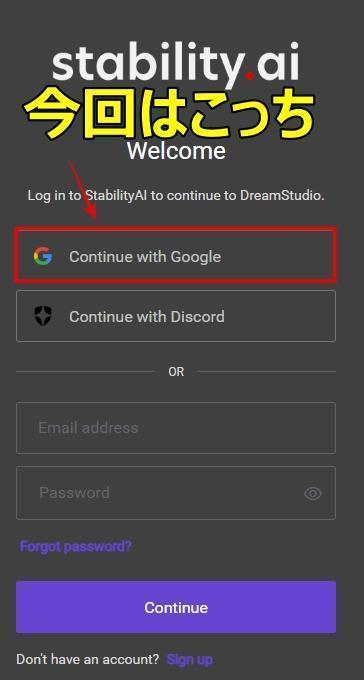

2:アカウント作成

Googleアカウント、Discord、新規作成から選びましょう。

筆者はGoogleアカウントでログインしました。

3:画像生成を開始

無事にログインすると、画面右上に「25」と「アカウントマーク」が出ます。

「25」という数字はクレジットです。

DreamStudioは画像生成する度に、一定のクレジット数を消費していくシステム。ゼロになれば画像が生成できません。

Mage.spaceでの使い方基礎

Mage.spaceもStable Diffusionをオンライン上で使えるサービスの一つです。使い方もシンプルで、以下の手順を踏めば、すぐに画像が生成できます。

- 「https://www.mage.space/」へアクセス

- 「create anything」の下にプロンプトを記述

- 「→」マークを押せば画像生成開始

Mage.spaceも無料版、有料版の2つがあります。有料版は月額15ドルになりますが、切り替えるとモデル数も136に増えます。

Fotographer.ai

Fotographer.aiは広告クリエイターやEC事業者などの業務に関わる人向けにサイト内やマーケティングに使用する商品の画像を生成できるAIサイトです。

Fotographer.aiでも画像生成が可能であり、長いプロンプトを書かずとも自動で高品質な画像が出力されます。また、簡単な操作でLoRAの生成も可能。数枚の画像をAIが自動学習して、画像生成に使うことができます。

Stable Diffusion Online

Stable Diffusion OnlineはStable DiffusionをWebブラウザで使うことができるサービスです。

無料でも使うことができますが、生成した画像にウォーターマークが入ってしまいます。また、モデルの変更もできません。自由度は低いですが、手軽にStable Diffusionを使ってみたい・Stable Diffusionをはじめて使うからどんなもんなのか試してみたい、という方にStable Diffusion Onlineはおすすめです。

年間支払いだと以下の金額です。

月額でこちら。

romptn Image Generator

「romptn Image Generator」はなんと、登録不要・完全無料で何回でもStable Diffusionによる画像生成が楽しめるサービスです。こちらの使い方は超簡単で、以下のとおりプロンプト・ネガティブプロンプト・スタイルの3項目を指定するだけで画像が生成できちゃいます。

- romptnのImage Generatorのページにアクセス

- プロンプト(必須)とネガティブプロンプト(任意)を入力

- 「アニメ」か「リアル」のスタイルを選択

- 「無料で画像を生成する」をクリックして1分ほど待つ

ちなみに、生成できる画像はどんな感じなのかというと……

このように、かなりのクオリティ。以下の簡単設定だけで、萌えイラストが生成できちゃいました。

- プロンプト:A girl with pink twintail is dancing in a city

- ネガティブプロンプト:bad face , worst quality

- 「アニメ」スタイルを選択

こちらのromptn Image Generatorは、初めてStable Diffusionに触れてみる方におすすめです。

【ローカル編】Stable Diffusionの使い方

ここではGoogle Colabで Stable Diffusionを使う方法やダウンロード方法を解説します。まずはStable Diffusionの動作に必要な環境から、みていきましょう!

Stable Diffusionを動かすのに必要なPCのスペック

Stable DiffusionをGoogle Colab上で動かすには、以下の環境が必要です。

- Pythonのバージョン

→Python 3.8.5以上 - 使用ディスク量

→50.8 MB - RAMの使用量

→8~16GB

したがって、今回使用したプロセッサはGoogleColabProのGPU:T4となります。

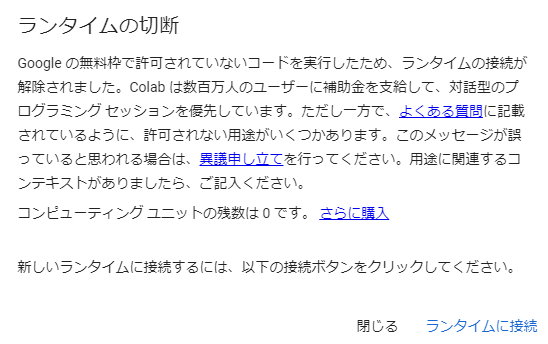

ちなみに「同じT4のGPUなら無料版でも使えるのでは?」と試してみたのですが、下記のようなエラーが出て動きませんでした。

GoogleColabでStable Diffusionを使う場合はColab Pro以上でないと動作しないようです。※4.※5

初期設定

まず、最新のColabだとtorchのバージョンが高く、Stable Diffusionが動かないため下記コマンドでtorchのバージョンを下げます。

!pip install -q torch==2.0.0+cu118 torchvision==0.15.1+cu118 torchaudio==2.0.1+cu118 torchtext==0.15.1 torchdata==0.6.0 --extra-index-url https://download.pytorch.org/whl/cu118 -U次に、Gitからソースコードをダウンロードし、そのディレクトリに移動します。

!git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

%cd /content/stable-diffusion-webuiCheckpointモデルのダウンロード

今回はCivitaiの中から、「DivineEleganceMix」というモデルをお借りしました。wgetコマンドで指定のディレクトリにモデルをダウンロードします。

!wget https://civitai.com/api/download/models/238656 -O /content/stable-diffusion-webui/models/Stable-diffusion/dem.safetensorsコマンドの最後にある「dem.safetensors」の「dem」の部分には任意の名前を入力します。

Loraのダウンロード

使用したLoRaは同じくCivitaiから「8bitdiffuser 64x | a perfect pixel art model」です。最初にLoRaを格納するディレクトリを作成したあと、ファイルをダウンロードします。Chackpointと同じく「8bit.safetensors」の「8bit」の部分は任意で大丈夫です。

%mkdir -p /content/stable-diffusion-webui/models/Lora/

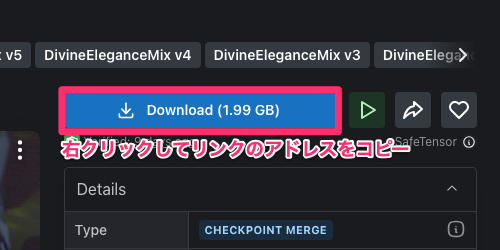

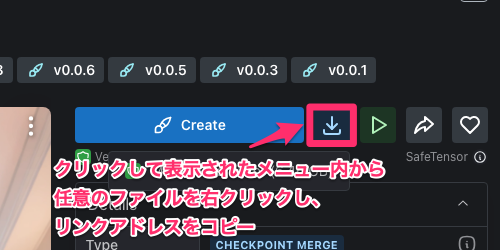

!wget https://civitai.com/api/download/models/231819 -O /content/stable-diffusion-webui/models/Lora/8bit.safetensorsモデルやLoraをダウンロードするリンクの取得方法

CivitaiからモデルやLoraをダウンロードする際に、ログインが必要になるケースがあります。

その場合、Colabから直接ダウンロードできないのでアカウントを作成後、ダウンロードしたファイルをColab上にアップロードするか、ログインが必要のないものを選択するようにしてください。

ログインが必要のないモデル/Loraはダウンロードのリンクを右クリックし、表示されたメニューから「リンクアドレスをコピー」をクリックすればOKです。

Downloadではなく、「Create」と表示されている場合はその右のダウンロードボタンをクリックしたあと、表示されるメニュー内でリンクアドレスのコピーを行ってください。

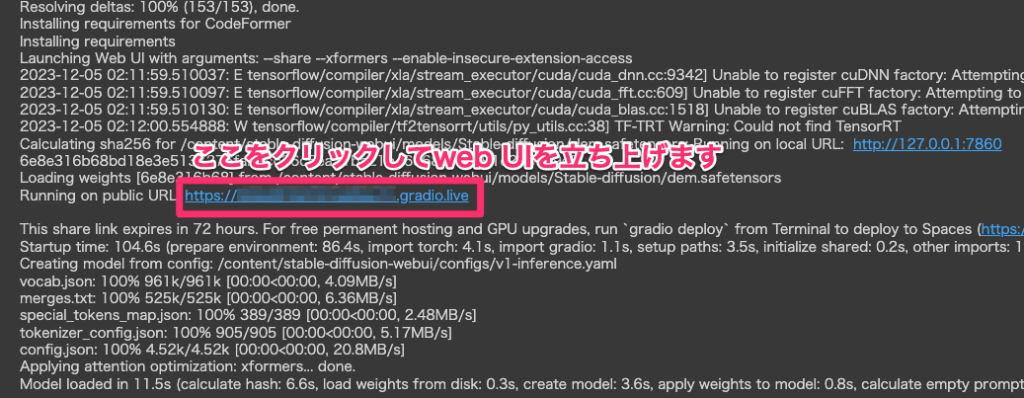

Stable Diffusionの起動

では下記コマンドを実行してStable Diffusionを起動します。

!python launch.py --share --xformers --enable-insecure-extension-access正常に起動できれば下の方に表示されている「Running on public URL:」のあとに記載されているURLをクリックすると、ブラウザが立ち上がりStable Diffusion web UIへアクセスできます。

では実際にStable Diffusionを使っていきましょう!

【API編】Stable Diffusion 3の使い方

APIでStable Diffusion 3を使えるようになったので、APIを使って実装をしていきたいと思います。コードはStability AIに掲載されているgoogle colaboratoryのコードを使っていきます。

また、使用する際にはAPIキーが必要になるので、Stability AIにログイン後にAPIキーを作成しておきましょう。リンク先に飛ぶと「Create API Key」が表示されるはずなので、そちらをクリックすればOKです。

基本的には掲載されているコードを実行していくだけでOKです。「Connect to the Stability API」で自身のAPIを入力しておくようにしましょう。

【2025年2月追記】

「Stable Diffusion web UI」も便利

「Stable Diffusion web UI」とは、Webブラウザを通して無料でStable Diffusionを利用できるツールです。Stable Diffusionをより手軽に・直感的に使えるように開発されており、使いやすさに定評があります。

AUTOMATIC1111版とForge版の2種類あり、どちらもそれぞれの特徴を持っています。

Stable Diffusion web UIはローカル環境でも実行可能ですが、高いPCスペックが必要なため、まずはクラウド環境で利用するのがおすすめです。どちらの環境で実行する場合も、GitHubで公開されているソースコードをインストールする必要があります。

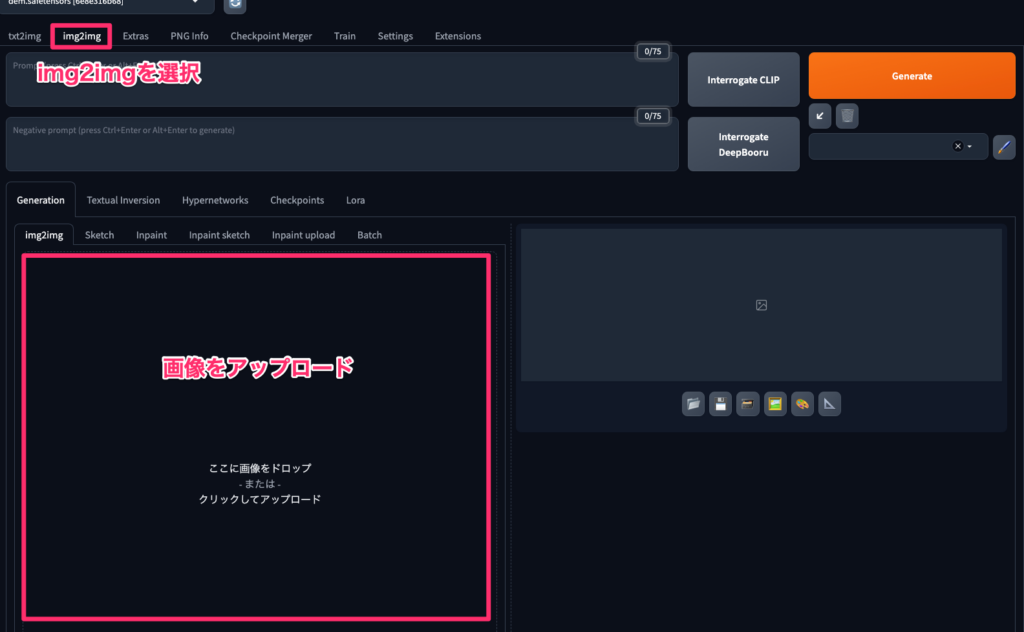

Stable Diffusion web UIには、txt2img(テキストを用いて画像を生成する方法)と、img2img(画像を読み込んで新しい画像を生成する方法)の2つの機能があります。より直感的に画像生成を行いたいユーザーや、特定の画像イメージが決まっているユーザーにはimg2imgの利用がおすすめです。

サンプリング回数やCFGスケールなど、画像クオリティに関わる設定も日本語に対応しているため、英語が苦手なユーザーでも自由に好みの画像へと調整できます。

なお、Stable Diffusion web UIについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusionを使う時のテクニック・コツ

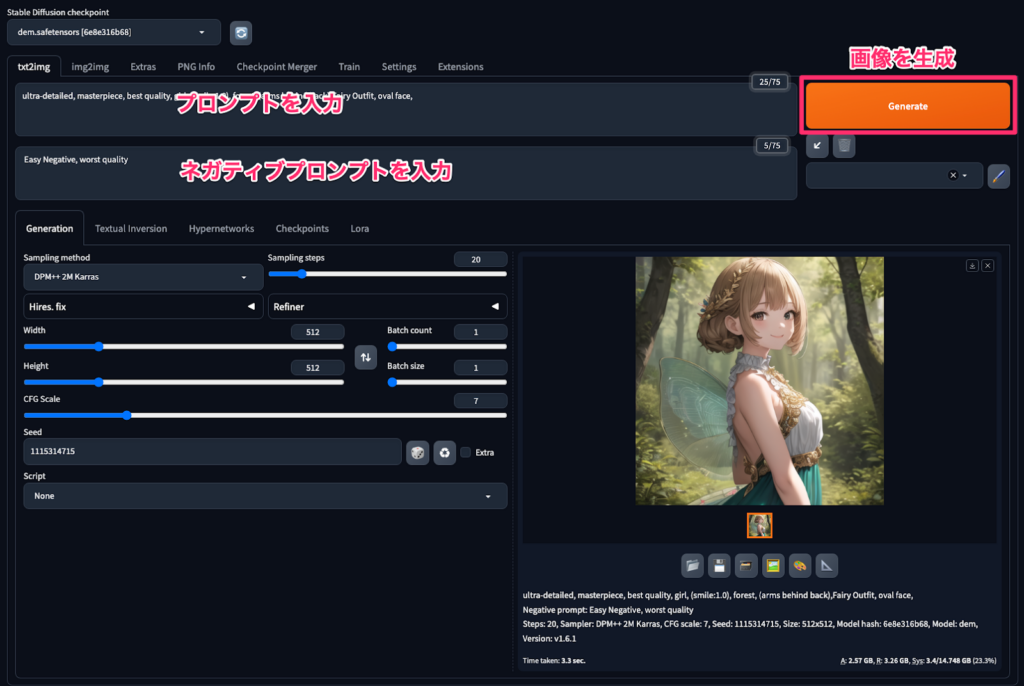

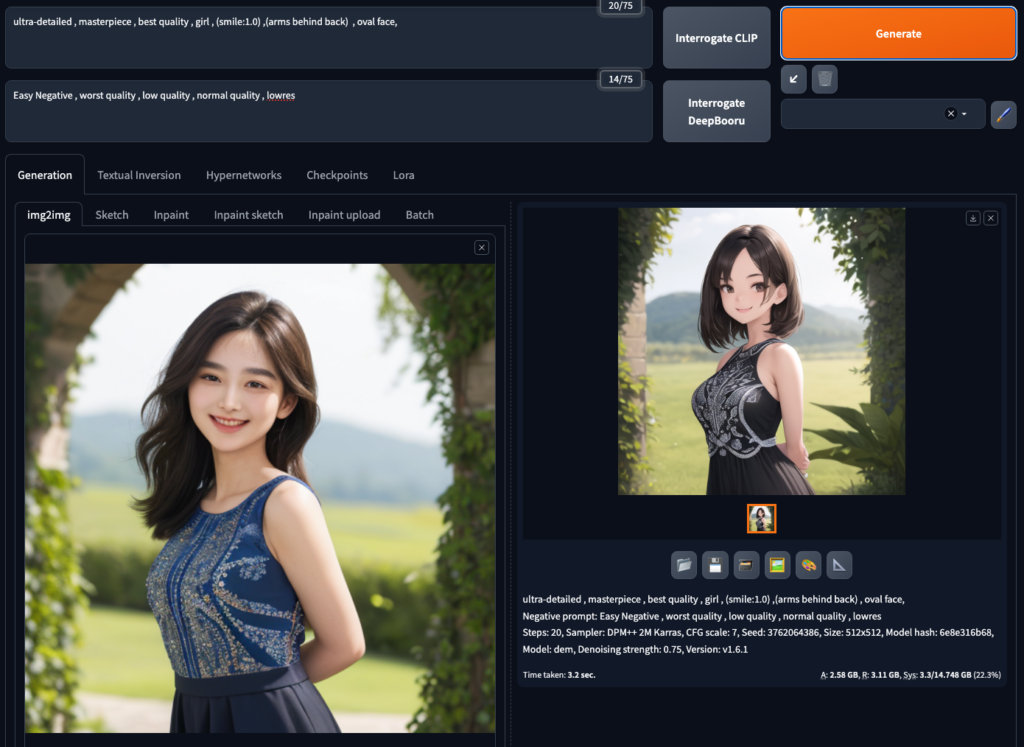

問題なくStable Diffusion web UIが起動したら下記のようになっていると思います。基本的な使い方としては、「Prompt」にプロンプトを、「Negative prompt」にネガティブプロンプトを入力します。

複数のプロンプトを入力する際はコンマで区切るのを忘れないようにしましょう。

最後に右の「Generate」ボタンをクリックして画像を生成します。

優先させたい内容から順に記入する

入力するプロンプトの順番は決まったものはありませんが、一般的には下記の順番で入力することが多いとされています。

- 画質など全体に関わる要素

- 人物に関する要素

- 髪型、服装などの外観

- 画像の構図やシーン

ただ、Stable Diffusionは入力されたプロンプトの順番に処理していきます。もし、優先度が高めの指示があれば一番最初に入力しておきましょう。

重要箇所は括弧とコロンで強調する

プロンプト内の要素を()でくくり、コロンでの後に数字を指定する事により、その要素を強調できます。

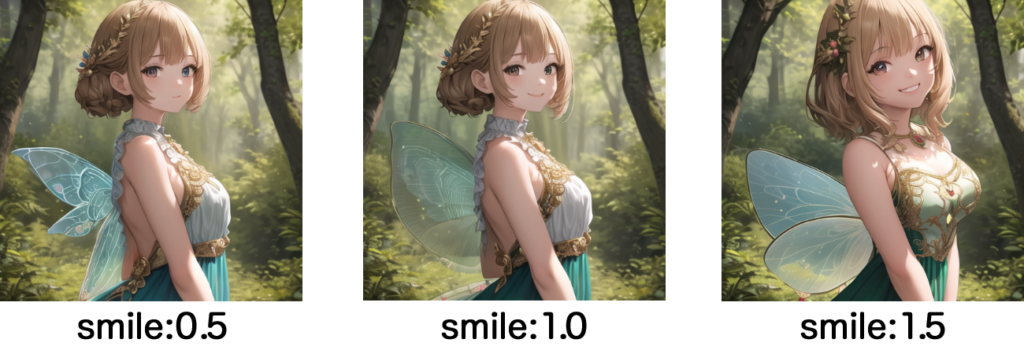

例として、smile要素の数字を変えて生成された画像を比較してみましょう。

1.0をベースに、0.5に下げたものは笑顔がなく、1.5に上げたものは笑顔が強調されていますね。

同じモデルを使用したのですが、値を変えるとキャラクターに若干の変化があるところも注意が必要です。

単語を75個以内に抑える

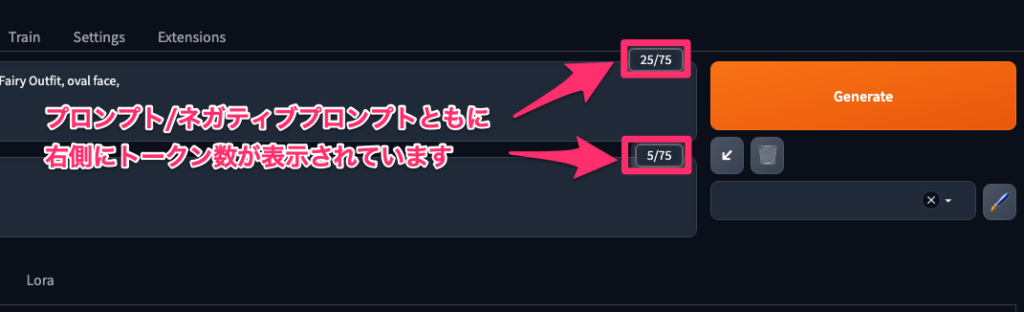

Stable Diffusionのプロンプトに入力するトークン数は75個を超えても入力できるようになっていますが、その分精度が落ちると言われていますので、75個以内に収めるようにしましょう。

入力したトークン数は入力フォームの右側に表示されているので確認しておきましょう。

ネガティブプロンプトで除きたい要素を指定する

ネガティブプロンプトとは大きく分けて「品質に関わるもの」と「生成したくないもの」の2つにわけられます。例えば、低品質を避ける「low quality」やピンボケ対策の「out of focus」などは品質に関わるものになります。

生成したくないものには指の欠損を意味する「missing fingers」や意図しない切り取りを防ぐ「cropped」などが挙げられます。プロンプトとネガティブプロンプトを組み合わせることによって、理想の画像を生成できるのでいろいろ試してみてください。

モデル&Loraは生成したい画像に合わせる

Stable Diffusionにはアニメ調のものからリアル調のものまで様々なモデルを利用できます。同じプロンプトを入力しても、モデルによって生成される画像がガラッと変わるので目的に応じたモデルを探してください。

下の画像は先程と同じプロンプトで違うモデルを選択して生成したものです。

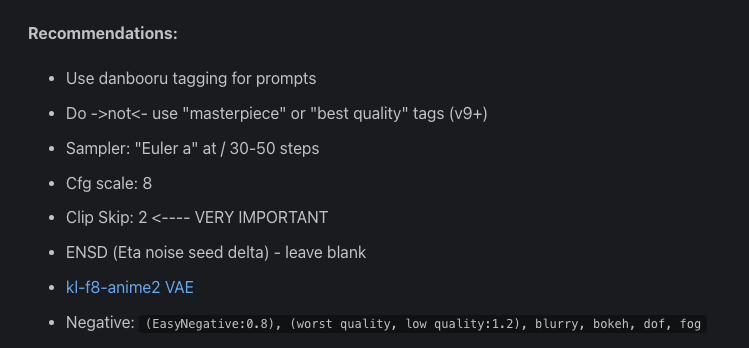

さらに、モデルごとに推奨されるプロンプト/ネガティブプロンプトや設定が存在します。

例えば今回使用したDivineEleganceMixには下記のような記述がありました。

プロンプトだけでなく、おすすめのサンプラーなど、詳細に書かれていますね。利用しているモデルのサンプルのような画像を生成したい場合は推奨の設定を反映させるようにしましょう。

また、Loraという追加学習ができるパッケージを使い学習させることで、より柔軟に画像を生成できます。

Loraを利用するには、指定ディレクトリにLoraのファイルを設置したあと、web UIの「Lora」のタブをクリックします。正常にファイルが設置されていれば、表示されているLoraを選択するとプロンプトに自動で入力されるので、あとはGenerateボタンを押すだけです。

今回は8bitとkimonoというLoraを使ってみました。

8bitはドット絵みたいになる予定だったのですが、プロンプトをいじっていないので微妙にしか反映されていませんね。kimonoはキャラクターの雰囲気はそのままで少し着物っぽい感じになったかな? という仕上がりになりました。

用途にあったモデルやLoraを選択するのは大切ですが、それ以上にプロンプトや設定もしっかり勉強しないといけないようです。

なお、モデルやLoraを利用する際にはそれぞれライセンスがあるので、商用利用をしたいと考えている方は使用するモデルのライセンスを必ず確認しましょう。

特に、Loraに関しては既存のアニメっぽくするようなものもあり、Lora自体は利用フリーでも商用利用不可などが記載されている場合がありますのでご注意ください。

画像入力での生成機能「img2img」も駆使する

Stable Diffusionはテキストから画像を生成するだけでなく、画像から画像を生成できます。

画像から画像を生成・・・? 文字にするとよくわからないので実際に試してみましょう!

使い方は上部のタブより「img2img」を選択し、画像をアップロードしたあと、プロンプトを入力してGenerateするだけ。簡単ですね!

今回はリアル風の画像をアニメ風に再生成してもらいましょう!

生成結果はこちら!

構図や服装の雰囲気まで完璧ですね!

img2imgは、「ゼロから何かを生成するより「手元にある素材を使って新たなものを創り出す」という使い方があっているようです。

Stable Diffusionのメリットとデメリット

最後に、Stable Diffusionを使う際のメリット・デメリットを解説します。わかりやすくするために、同じく画像生成AIとして有名な「Midjourney」と比較してみましょう。

ざっくり比較すると

- Midjourney:プロンプトのみで、直感的にクオリティの高い画像生成ができる

- Stable diffusion:細かい設定で、より精度の高い画像生成ができる

このようなイメージです。

Stable Diffusionのメリット

具体的なメリットとしては、以下のようなものが挙げられます。

- 基本的に無料で利用できる

- ローカル環境で実行できるため、処理速度が速い

- 細かい設定が可能で、より自由度の高い画像生成が可能

- 利用者が多いため、呪文集やモデル一覧などが多く紹介されている

Stable Diffusionのデメリット

デメリットは以下のとおりです。

- 使いこなすには、ある程度の知識や経験が必要

- 初心者には難しいと感じられる可能性がある

Midjourneyを使うためには課金も必要になるので、それも含めて判断が必要かもしれません。どちらにもメリット・デメリットがあるので、用途によって使い分けるようにしましょう。

なお、Stable Diffusionを応用した動画生成AIについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusionの活用事例

Stable Diffusionで生成された画像は商用利用が可能です。そのため、生成した画像を商用利用できるので、いくつか活用例を考えてみます。

使用するのはStable Diffusion 3をAPIで動かします。

ブランドロゴの作成

まずはブランドロゴの作成です。

商用利用する上で、多くの方がStable Diffusionで生成した画像をブランドロゴに活用しようと考えるのではないでしょうか?

プロンプトにモデルコンセプトとなる指示を入力して、画像を生成するだけです。今回は「create a brand logo using the letters AI.」とプロンプトに入力しています。

和訳はAIという文字を使ってロゴを作ってください、です。

ネガティブプロンプトは特に入力する必要はないので「None」にしています。

いくつか例として画像を生成してみます。

インテリアのイメージ画像

次にインテリアのイメージ画像です。理想のインテリアをプロンプトに入力します。

まずは理想のインテリアを考えていきます。

今回は「Interior images with a modern feel,The room has sofas, plants, and paintings」と入力しています。モダンな雰囲気のインテリア画像、室内にはソファと観葉植物、絵画があるという意味です。

アパレル商品のアイデア画像の作成

その他にもアパレル商品のアイデア画像も作ることができます。

例えば、「Apparel products, T-shirts, up-and-coming abstract painting on the front, big logo on the back」和訳は「アパレル商品、Tシャツ、表面には新進気鋭の抽象画、背面にはビッグロゴ」です。

作られたTシャツをみて思いましたが、正直販売されていてもわからないくらいのクオリティだと思います。

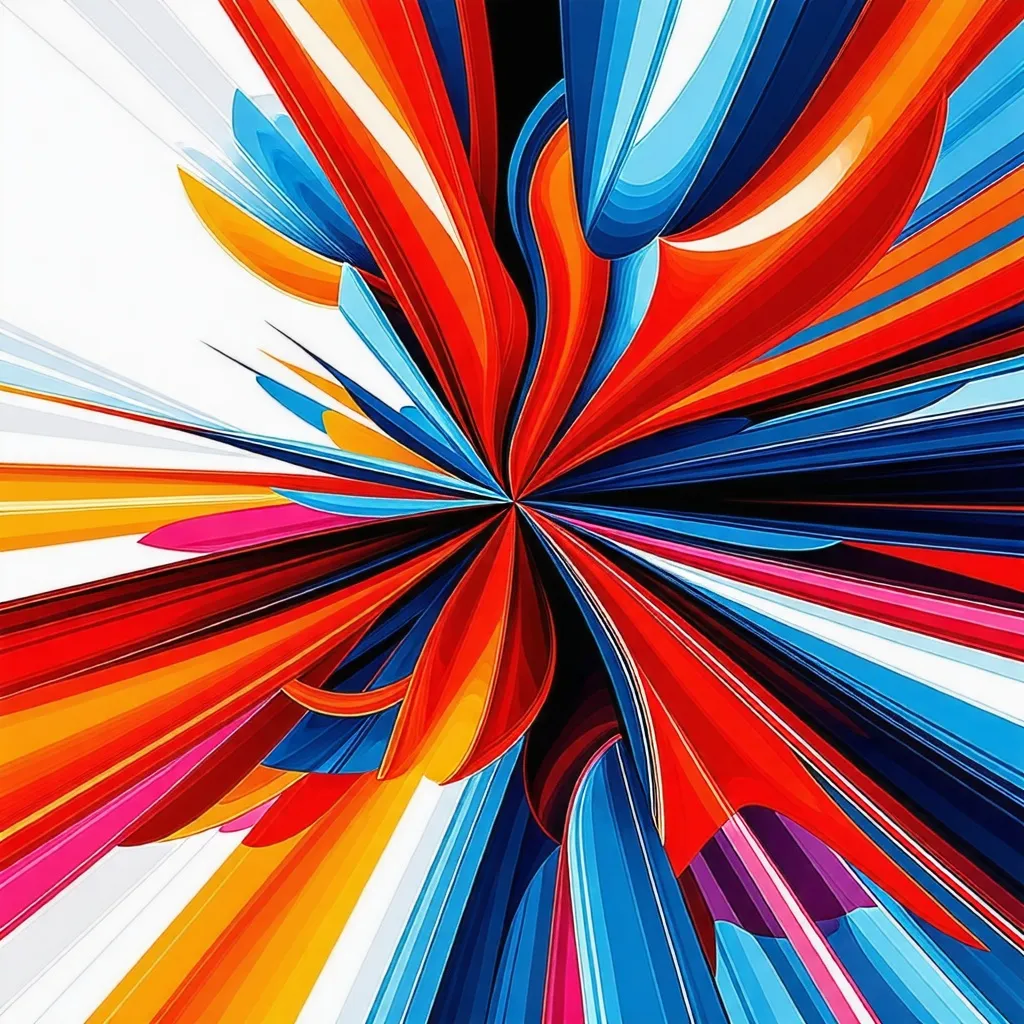

アートのアイデア生成

最後はアートのアイデアを形にします。

「Art design, up-and-coming design, only 3 colors, abstract」和訳は「アートのデザイン、新進気鋭のデザイン、色は3色のみ、抽象画」です。

アートのアイデアも正直素人からしてみれば十分な出来栄えだと思います。

これが商品として並んでいても誰かが書いたんだろうな、と錯覚しそうなクオリティです…!

Stable Diffusionを利用する際の注意点

Stable Diffusionを利用する際には、以下の3つに注意する必要があります。

- 著作権や肖像権を侵害するリスク

- 同じプロンプトで同じ画像が生成されるとは限らない

- プロンプトスキルがないと低品質な画像になる

1つずつ詳しく解説します。

著作権や肖像権を侵害するリスク

Stable Diffusionは、インターネット上の膨大な画像データを学習して画像を生成します。そのため、意図せず既存の著作物や人物の肖像に類似または酷似した画像が生成される可能性があり、著作権や肖像権の侵害に繋がる恐れがあります。

生成された画像を公開・利用する前には、類似する既存の画像が存在しないか、権利者の許諾が必要ないかなどを十分に確認しましょう。特に、Stable Diffusionは無料・有料問わず商用利用が可能なので、商用利用する場合は権利関係をクリアにしておくことが重要です。

同じプロンプトで同じ画像が生成されるとは限らない

Stable Diffusionは、同じプロンプトを入力しても毎回完全に同じ画像が生成されるとは限りません。これは、画像生成の過程でランダムな要素(Seed値)が加わるためです。そのため、イメージ通りの画像を生成するには、プロンプトを調整したり、生成された複数の画像から最適なものを選択したりするなどの試行錯誤が必要になります。

ただし、Civitaiなどで配布されているプロが作成した高品質なモデルを活用することで、一貫した画像生成も可能です。

プロンプトスキルがないと低品質な画像になる

Stable Diffusionで高品質な画像を生成するには、プロンプト(画像の指示文)の記述が重要です。プロンプトに具体的な要素や指示を適切に含めることで、イメージ通りの画像を生成しやすくなります。

しかし、プロンプトの記述には慣れが必要であり、スキルがないと意図しない低品質な画像が生成されることがあります。また、画像生成に適したプロンプトやサービスごとに適したプロンプトなども存在します。

プロンプトの記述方法を学習したり、他の人が作成したプロンプトを参考にしたりしながら、スキルアップを目指しましょう。

記事内でご紹介したテクニック・コツもぜひ参考にしてください。

Stable Diffusionのよくある質問(FAQ)

最後に、Stable Diffusionに関するよくある質問にお答えしていきます。記事本文内でもご紹介している内容の復習になりますが、疑問に思ったことがある場合に活用してください!

Stable Diffusionは、テキストから画像を生成できるAIモデルです。与えられたプロンプト(指示文)に基づいて、高品質な画像を生成することができます。

なお、Stable Diffusionで使えるCivitaiについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusionを使いこなそう!

Stable Diffusionは革新的な技術であり、初めて使う人でも直感的に利用できる優れた画像生成AIです。まずお試しで使いたい方は無料のブラウザ版から利用を始めて、慣れてきたりゲーミングPCのようなハイスペックパソコンを持つ方はローカル環境に移行するという使い方でもよいでしょう。

著作権の侵害や商用利用の有無など、トラブルに発展しそうな点については注意する必要がありますが、正しく利用すれば新しいアイディアや好みの画像を簡単に作ることができます。

生成AIツールはさまざまありますが、画像生成AIの王道といっても過言ではない、Stable Diffusionを活用して、自分好みの生成画像を作ってみてはいかがでしょうか。

最後に

いかがだったでしょうか?

Stable Diffusionを自社プロダクトやサービスに活用する際の具体的なイメージが湧いた方は、ぜひ導入を検討してみてください。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。

➡︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。